导读:

由于环境中静态障碍物和动态障碍物的约束,机器人在密集且交互复杂的人群中导航,往往面临碰撞与延迟等安全与效率问题。举个简单的例子,商城和车站中的送餐机器人往往在人流量较大时就会停在原地无法运作,因为它不具备在拥挤人群中穿行的能力。

为应对上述挑战,研究者提出一套基于图结构的全新方案,将人、机器人及各类障碍物在时空维度上进行异质化建模,构建出名为"异质时空图"(st-graph)的统一表达框架。基于此结构,运用深度强化学习训练导航策略,并通过注意力机制与循环网络,动态捕捉场景变化,关注关键交互因素,从而显著提升对碰撞的规避能力。

多轮仿真与真实实验表明,该方法在复杂导航任务中不仅成功率和效率优于SOTA方法,而且在改变人群密度和障碍物数量时也能保持良好的零样本泛化能力。同时,本研究在大量实际环境中进行验证,结果证明其在安全性和整体表现方面均达到了新的水平。该方法的实时和部署使得服务机器人即便是在"上班早高峰"这样的拥挤场景中也能够顺利的执行任务。

©️【深蓝AI】编译

论⽂题目:HEIGHT: HEterogeneous Interaction GrapH Transformer for Robot Navigation in Crowded and Constrained Environments

论文作者:Shuijing Liu, Haochen Xia, Fatemeh Cheraghi Pouria, Kaiwen Hong, Neeloy Chakraborty, and Katherine Driggs-Campbell

论文地址:https://arxiv.org/abs/2411.12150

1.引入

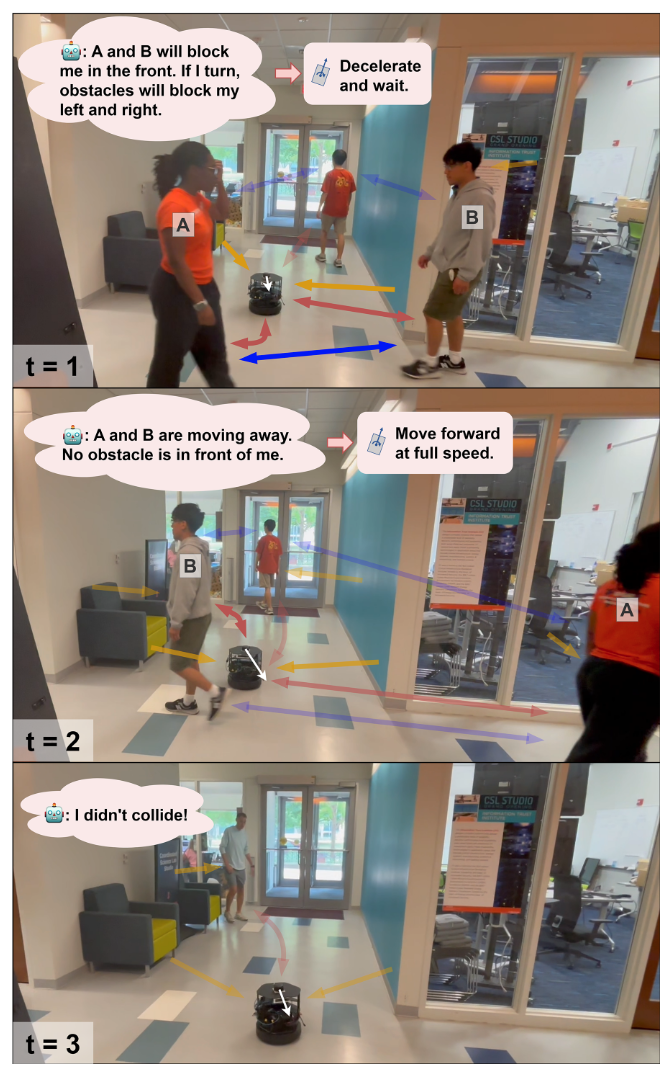

随着机器人在以人为中心的环境中应用的日益普及,如最后一公里配送和家庭机器人等,机器人能够在人群中安全导航变得越来越重要。例如,图1展示了一个导航场景,其中包含了大量微妙的互动:障碍物对路径的影响是单向的(即对机器人和人类的路径有影响),而人类和机器人之间的互动则是相互作用的。在这些互动中,人类可能会以不同的方式反应于其他人类和机器人。为了完成导航任务,机器人直接参与到近距离的某些互动中,同时又受到其他互动的间接影响。这些互动是异质的、动态的,并且很难推测出来,这使得在这种环境中进行导航变得十分具有挑战性。

为了应对这些挑战,过去的研究探索了多种机器人群体导航方法。然而,这些方法通常存在以下两种局限:一是它们假设机器人在没有障碍物的开放空间中移动,而现实世界中障碍物是很常见的;二是它们没有区分不同类型的互动,导致机器人难以采取适应性策略,避免与人类和障碍物的碰撞。

**本研究的目标是让机器人能够在导航时不与人类和障碍物发生碰撞。为了解决这个问题,本研究提出了一个框架,利用了在拥挤和受限环境中互动的异质性。**首先,本研究将环境分为人类和障碍物的表示,并将它们分别处理后输入到基于强化学习(RL)的导航流程中。然后,本研究将场景分解为异质的时空图(st-graph),通过不同类型的边来表示机器人、人类和障碍物之间的不同互动,正如图1中不同颜色的箭头所示。最后,本研究将这个异质时空图转换为一个名为HEIGHT(HEterogeneous Interaction GrapH Transformer)的机器人策略网络,包含多个模块来参数化各种时空互动。具体来说,本研究使用两个独立的多头注意力网络来处理机器人与人类(RH)以及人类与人类(HH)之间的互动。通过注意力网络,机器人可以更多地关注重要的互动,从而在人数增多、图变得更加复杂的情况下,保持较低的碰撞率。此外,本研究还使用多层感知机(MLP)来建模单向的障碍物-代理互动,并采用递归网络来捕捉场景的时间演变。面对快速变化的场景(图1下方),HEIGHT能够通过时空捕捉不同组件之间的异质互动,从而使机器人避免碰撞并高效地接近目标。

这篇文章扩展了本研究之前关于注意力图网络的贡献。尽管本研究之前的工作集中在开放空间中的群体导航,但这篇文章引入了静态障碍物和约束,导致了场景表示和网络架构的重大修改。为配合这些方法的变化,本研究进行了新的仿真和硬件实验,并增加了新的基准比较。总的来说,这篇文章的主要贡献如下:

-

本研究提出了一种拥挤和受限环境的输入表示,区别对待人类和障碍物。这种分离的场景表示使得本研究能够在框架的其他部分注入更多结构。

-

本研究提出了一种结构化的图表示,称为异质时空图(st-graph),用于有效地建模所有代理和实体之间的配对互动。

-

从异质时空图中,本研究采用一种原则性的方法推导出HEIGHT,一个基于变换器的机器人导航策略网络,具有不同的模块来推理所有类型的时空互动。

-

仿真实验中,在密集人群和障碍物的情况下,本研究的方法在未见过的障碍物布局中超越了之前的最先进方法。此外,本研究的方法在不同的人类和障碍物密度的分布外环境中表现出了更好的泛化能力。

-

本研究成功地将机器人策略从低保真度仿真环境转移到具有挑战性的真实世界拥挤环境中,且无需进行微调。

▲图1|机器人避障情况分类©️【深蓝AI】编译

▲图2|机器人避障情况分类©️【深蓝AI】编译

2.具体方法与实现

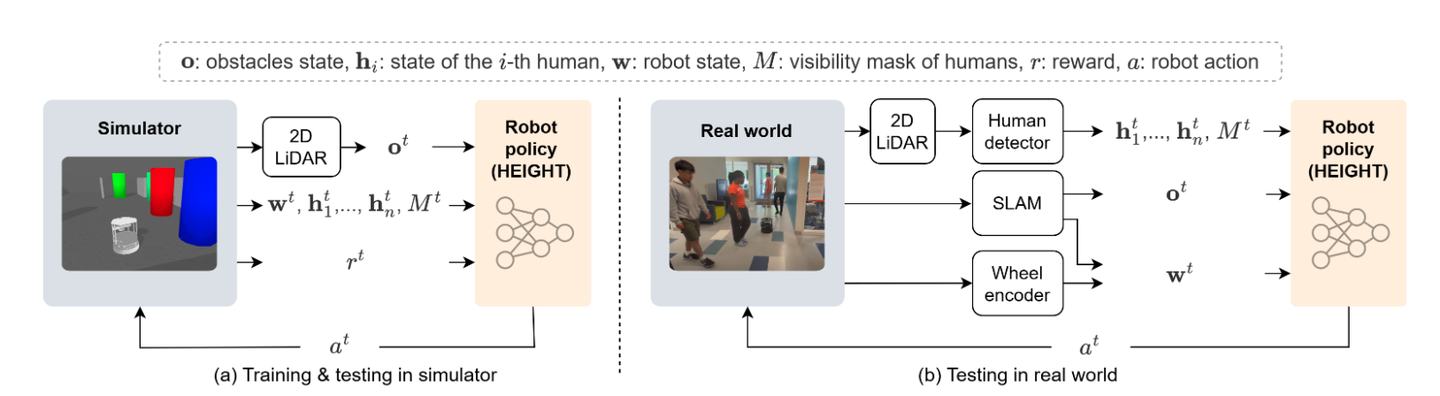

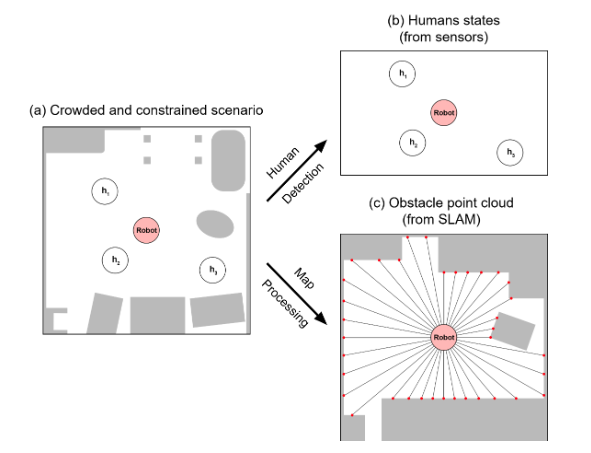

图2所示为本文的核心pipeline,首先(a)在训练和测试的每个时间步,仿真器提供一个奖励和以下环境观察:障碍物点云、机器人状态、以及人类状态和掩码。这些观察作为输入传递给HEIGHT,HEIGHT输出一个机器人动作,以最大化未来期望回报。仿真器执行所有代理的动作,循环继续。随后(b)现实世界中的测试循环与仿真器类似,唯一不同的是用于获取观察的感知模块不同,并且没有奖励。可以看到本文的核心是一个Sim2Real的过程,在仿真器中进行训练,随后在真实环境中实现实施和部署。下面笔者将对本文的各个细分模块进行介绍。

▲图3|核心网络架构图©️【深蓝AI】编译

2.1 异质时空图

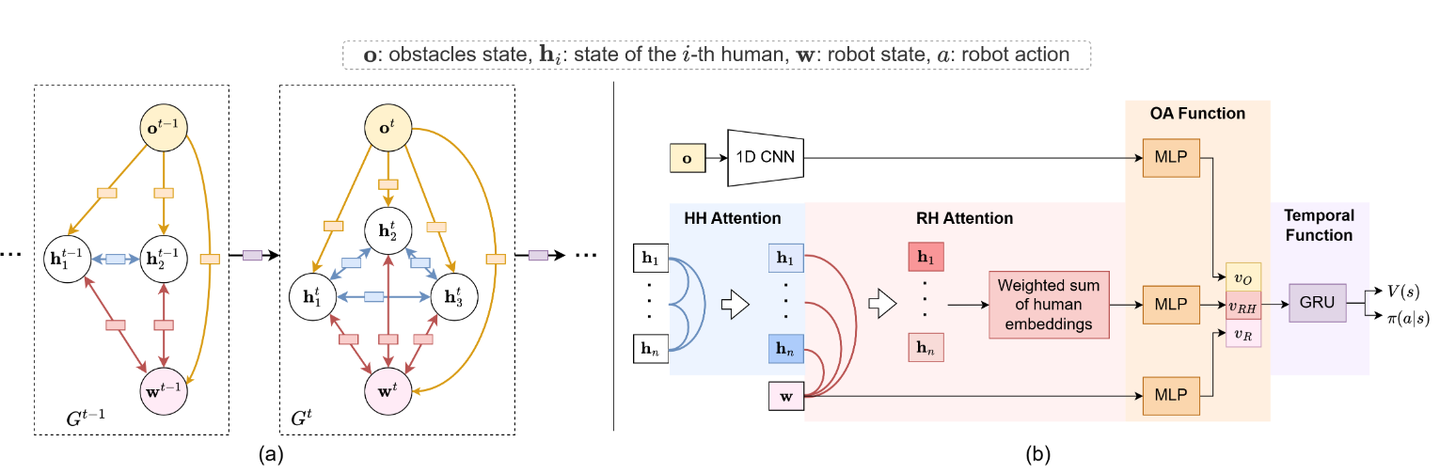

代理和实体之间微妙而高度动态的互动是使群体导航变得困难的重要因素。为了以结构化的方式建模这些互动,本研究将导航场景公式化为一个异质时空图。在图3a中,在每个时间,本研究的异质时空图由一组节点

和一组边

组成。节点包括检测到的人类

和机器人

。此外,障碍物节点

代表所有障碍物的点云。在每个时间,连接不同节点的空间边表示节点之间的空间互动。不同的空间互动对机器人决策的影响不同。具体来说,虽然本研究可以控制机器人,但无法控制人类,因此机器人与人类(RH)之间的互动有直接影响,而人类与人类(HH)之间的互动对机器人动作的影响是间接的。例如,作为间接影响,如果人类 A 强行让人类 B 转向机器人的前方,那么机器人必须根据 A 和 B 之间的互动做出反应。此外,由于代理是动态的,而障碍物是静态的,代理之间的互动是相互的,而静态障碍物对代理的影响是单向的。因此,本研究将空间边分为三种类型:人类与人类边(HH,图3中的蓝色)、障碍物-代理边(OA,橙色)和机器人-人类边(RH,红色)。这三种边允许本研究将空间互动分解为 HH、OA 和 RH 函数。每个函数由一个具有可学习参数的神经网络来参数化。

▲图4|环境人体与障碍物分离图示©️【深蓝AI】编译

与以往忽略某些边的工作相比,本研究的方法允许机器人推理所有在拥挤和受限环境中存在的空间互动。由于所有代理的运动会导致每个人类的可见性动态变化,节点集和边集

以及互动函数的参数可能相应地发生变化。为此,本研究使用图3(a)中紫色框所示的另一个函数,将不同时间步的图

融合起来。这个时间函数连接相邻时间步的图,从而克服了反应性策略的短视性,并使机器人能够进行长期决策。

为了减少参数的数量,图3(a)中相同类型的边共享相同的函数参数。这个参数共享对于图的可扩展性非常重要,因为当人类数量变化时,参数的数量保持不变。

2.2 HEIGHT架构

在图3b中,本研究从异质时空图中推导出了本研究的网络架构。本研究将 HH 和 RH 函数表示为具有注意力机制的前馈网络,分别称为和

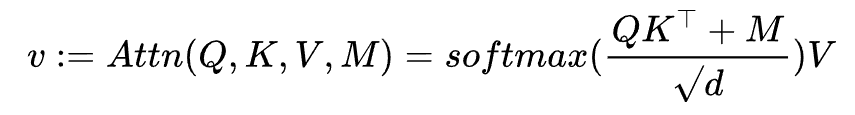

。本研究将 OA 函数表示为一个带有连接的多层感知机(MLP),将时间函数表示为门控递归单元(GRU)。本研究使用 W 和 f 来表示可训练的权重和全连接层。代理之间的注意力:注意力模块为所有连接到机器人或人类节点的边分配权重,使得节点可以关注重要的边或互动。这两个注意力网络类似于带有填充掩码的缩放点积注意力,它使用查询 Q 和键 K 来计算注意力得分,并将归一化的得分应用于值 V,从而得到加权值 v。

其中 d 是查询和键的维度,作为缩放因子。掩码 M 用于处理每个时间步检测到的人类数量变化,正如本研究将在下文中扩展的那样。人类-人类注意力:为了学习每个 HH 边对机器人在时间 t 的决策的重要性,本研究首先使用一个 HH 注意力网络,按人类之间的自注意力对每个观察到的人类进行加权。在 HH 注意力中,当前的人类状态被拼接并通过具有权重

、

和

的线性层传递,以获得

、

和

其中

其中是 HH 注意力的注意力大小。

其中 、

、 和

和 分别是第 i 个人类的查询嵌入、键嵌入和值嵌入。该过程用于指示每个人类的可见性,使得机器人可以对检测到的每个人进行"注意",这个过程可以提升机器人对于环境中人群的感知能力,同时更契合本文对人和环境进行分离的主题。

分别是第 i 个人类的查询嵌入、键嵌入和值嵌入。该过程用于指示每个人类的可见性,使得机器人可以对检测到的每个人进行"注意",这个过程可以提升机器人对于环境中人群的感知能力,同时更契合本文对人和环境进行分离的主题。

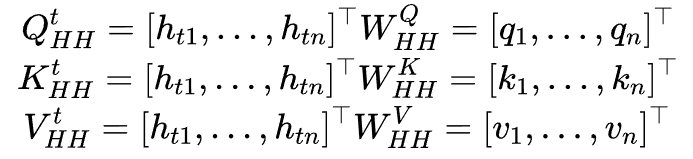

2.3 训练过程

本研究在仿真器中使用近端策略优化(PPO)训练整个网络,如图2(a)所示。在每个时间步 t,仿真器提供所有构成 st 的状态信息,这些信息被输入到 HEIGHT 网络中。网络输出状态 V(st) 的估计值和机器人动作 π(at|st) 的对数概率,二者用于计算 PPO 损失并更新网络中的参数。在训练过程中,机器人从动作分布 π(at|st) 中采样动作。在测试过程中,机器人选择具有最高概率的动作 at。机器人动作 at 被输入到仿真器中,以计算下一个状态 st+1,然后循环继续进行。没有任何监督学习,本研究的方法不受专家演示性能的限制。然而,为了提高低训练数据效率这一强化学习固有问题,HEIGHT也可以通过模仿学习和强化学习的结合进行训练,本文主要的训练环境和真实环境如图5所示。通过以上的一种结构化和原则性的方法来设计机器人策略网络,用于在受限环境中的群体导航可以更好的提升机器人在拥挤环境中的导航避障性能。通过将复杂的场景分解为独立的组件,本研究将复杂问题拆解为更小的函数,这些函数用于学习相应的函数参数。通过结合上述所有组件,端到端可训练的 HEIGHT 使得机器人能够对所有配对互动进行时空推理,从而实现更好的导航性能。

▲图5|Sim2Real训练环境与实际环境展示©️【深蓝AI】编译

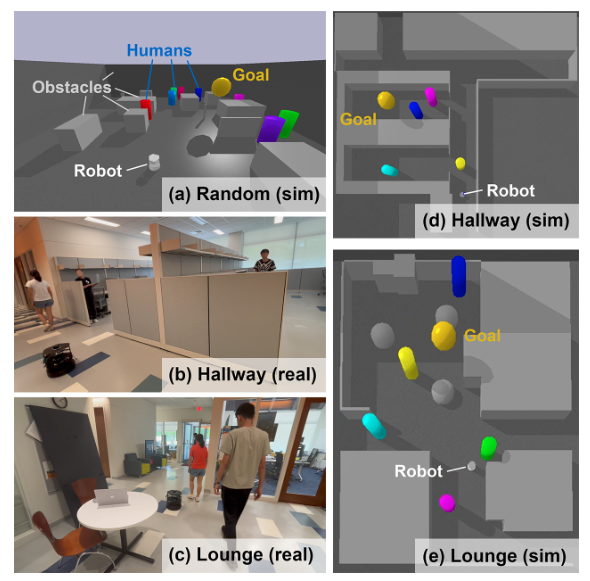

3.实验

本文作为一篇TRO的文章,在实验部分设计的非常精细,同时做了非常充分的对比实验以及仿真真实实验,体现了本文极大地工作量,首先图6所示为本文的数值实验,从结果不难看出本文方法的优异性,能够在多个环境中取得不错的效果,均领先于当前的SOTA。

▲图6|数值实验©️【深蓝AI】编译

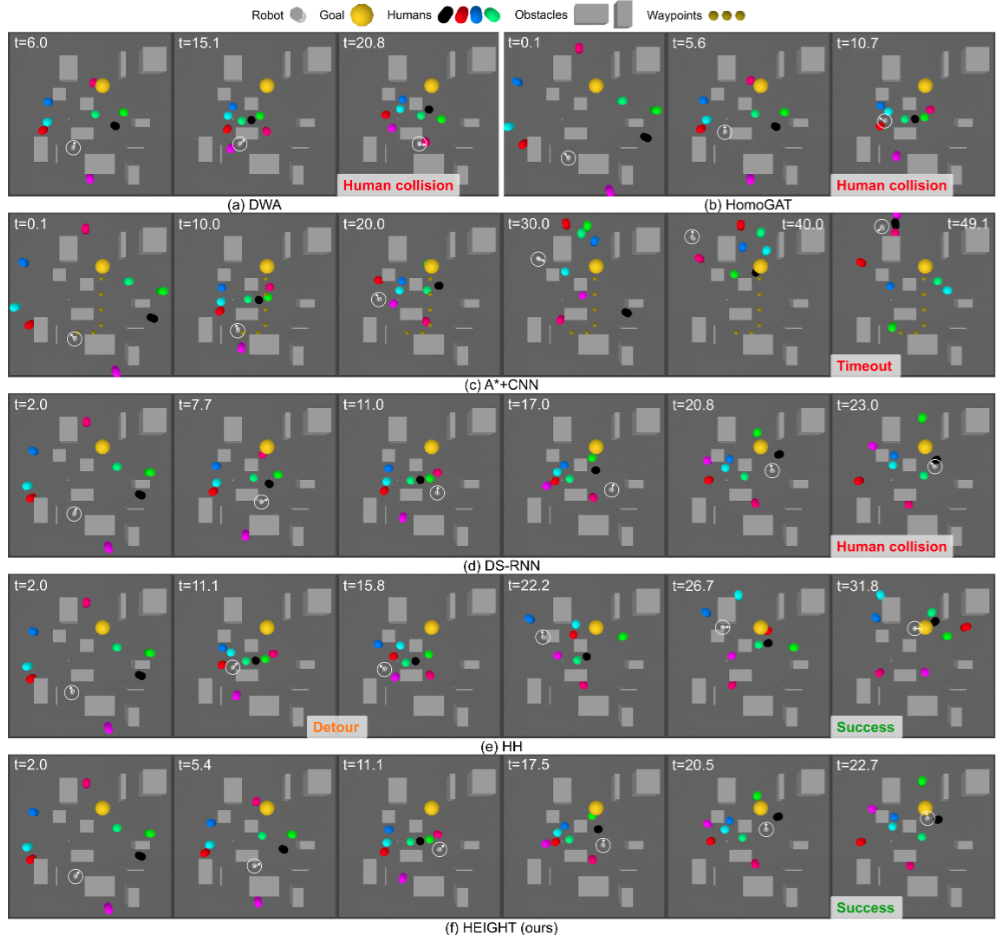

接下来映入眼帘的是避障路径规划的模拟实验,可以看到作者进行了大量的case study并且于当前的方法进行了非常多的对比,值得关注的是机器人与人的碰撞(标记为Human collision)以及机器人运动的时间(在左上角体现)。可以看到本文方法在避障时间上用时最短,同时避免了所有的人体碰撞

▲图7|避障路径规划模拟实验©️【深蓝AI】编译

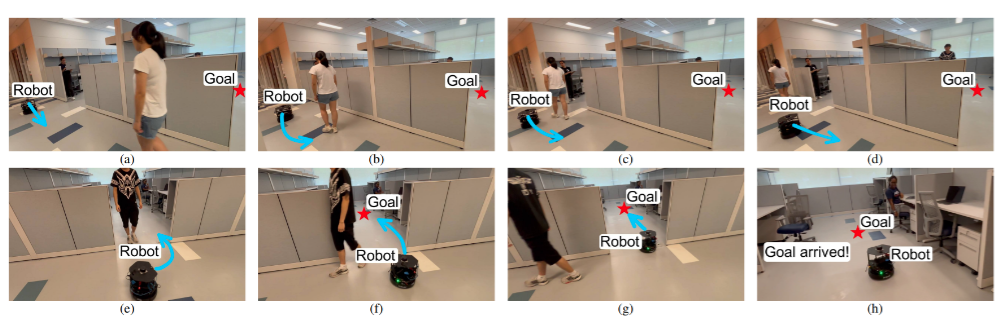

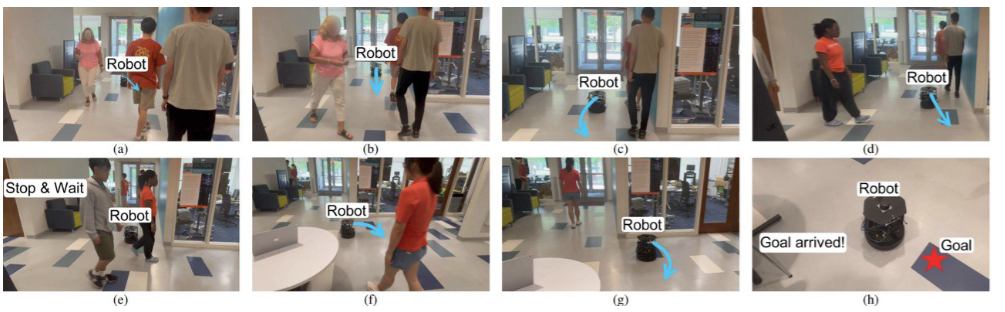

随后作者在真实机器人平台进行了算法部署,并且在办公室和大厅两个场景进了真实的机器人避障实验,办公室场景是比较典型的结构化场景,在这个场景中机器人的路径受到限制,一般只有狭窄的走廊能够用于避障,从图中可见机器人在这样的环境中,即便面对川流不息的人群,也能够实现非常准确的避障和导航。大厅则是比较开放的场景,这个场景中机器人往往有多条路径能够选择,但是多样的选择也导致了机器人的迂回问题,有时候机器人会绕一大圈,为了避开障碍物,但是从图中能够看到,本文算法非常好的解决了这个问题,机器人在开放的环境中也选择了一条非常高效的路径,最终导航到了目的地。

▲图8|真实环境机器人避障实验©️【深蓝AI】编译

总结

在本文中,作者提出了HEIGHT,一个用于动态和受限环境下自主机器人导航的新型结构化图网络架构。作者的方法利用了受限群体导航问题的图形化特性和可分解性,提出了以下两个关键创新。首先,作者将人类和障碍物的表示分别进行拆分和处理。这使得机器人能够有效地推理人类和障碍物的不同几何形状和动态特性,提升其在复杂环境中的导航能力。其次,作者提出了一种异质时空图(st-graph),用以捕捉机器人、人类和障碍物之间的多种互动类型。将场景分解为异质时空图有助于指导HEIGHT网络的设计,采用注意力机制。注意力机制使机器人能够推理每种配对互动的相对重要性,从而在导航过程中实现自适应和敏捷的决策。

作者的仿真实验表明,HEIGHT模型在碰撞避免和导航效率方面优于传统的基于模型的方法和其他基于学习的方法。HEIGHT模型在不同人类和障碍物密度的环境中也表现出了更好的泛化能力。在真实世界的环境中,HEIGHT能够无缝地从仿真转移到日常室内导航场景中,无需额外训练,展示了其鲁棒性和克服仿真与现实之间差距的能力。

作者的研究表明,推理微妙的时空互动是实现平稳人机交互的关键步骤。此外,作者的工作强调了揭示复杂问题内在结构的重要性,并将这些结构注入学习框架中,以一种有原则的方式解决问题。