需求

- 需要在本地快速部署一个大模型, 然后使用 局域网 的其他电脑进行

api调用 - 为了快速测试, 大模型选择了 qwen2:0.5B 进行快速测试

开始

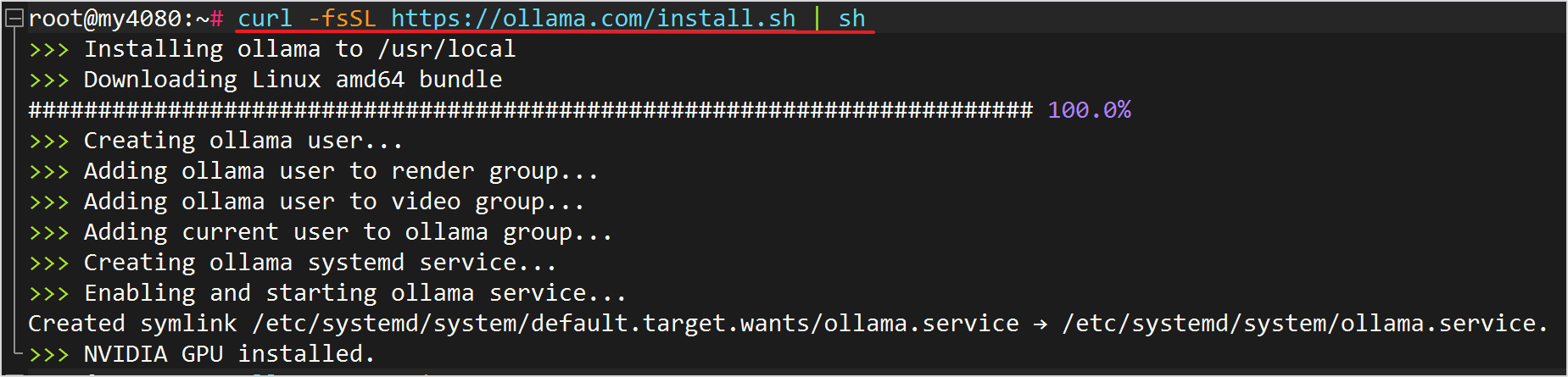

下载安装 ollama

bash

curl -fsSL https://ollama.com/install.sh | sh

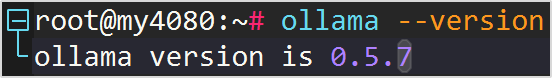

验证安装

bash

ollama --version

下载安装模型并运行

bash

ollama run qwen2:0.5B- 其中

qwen2:0.5B可以换成其他模型名称, 点击查找模型: https://ollama.com/search

效果

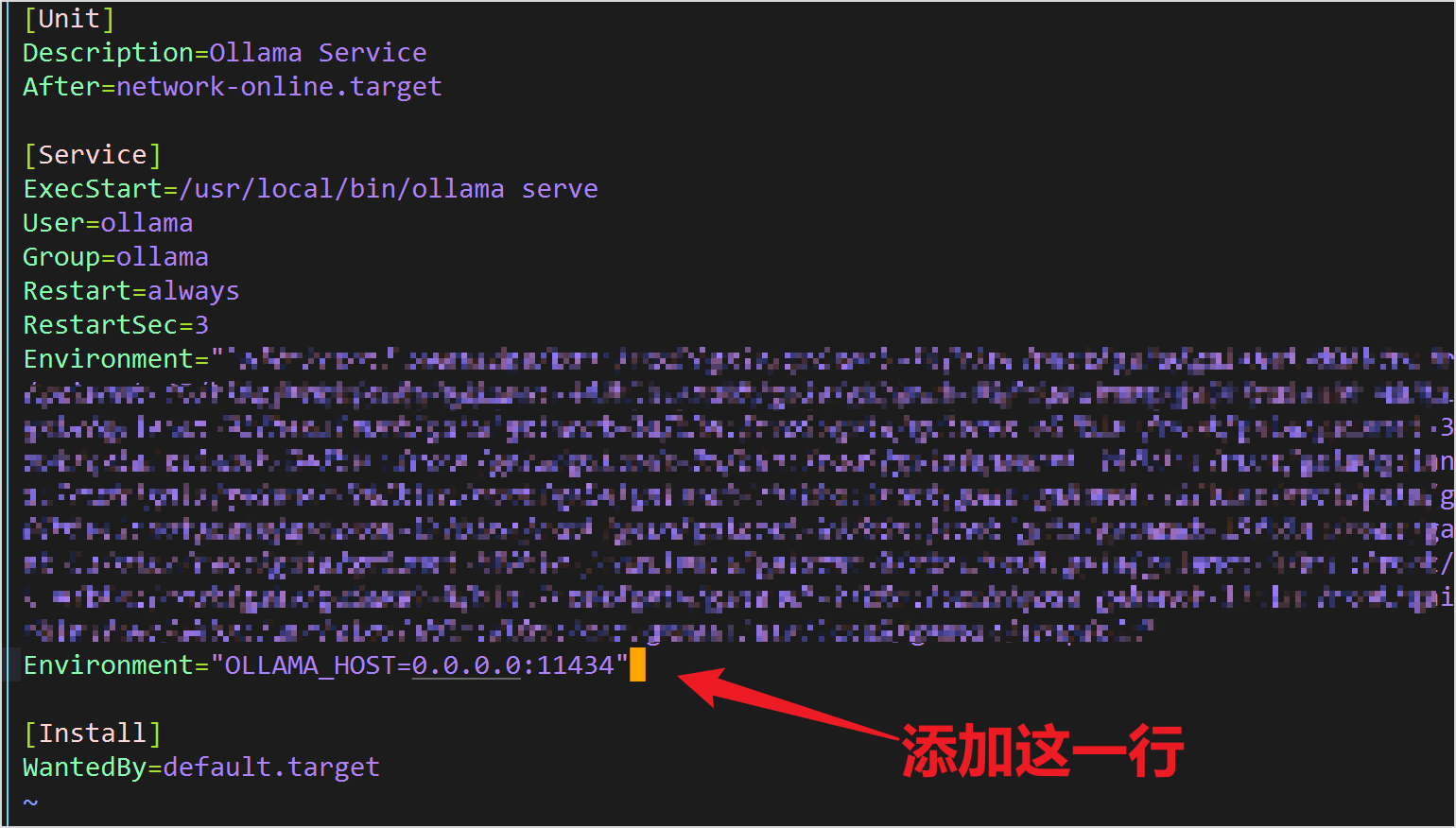

配置 api 访问

- Ollama 默认启用端口为:

11434 - 配置局域网其他设备 可以访问 Ollama 服务

编辑服务

bash

sudo vim /etc/systemd/system/ollama.service在 [Service] 后添加一行环境代码

bash

Environment="OLLAMA_HOST=0.0.0.0:11434"

重启服务

bash

systemctl daemon-reload

systemctl restart ollama设置开机自启

bash

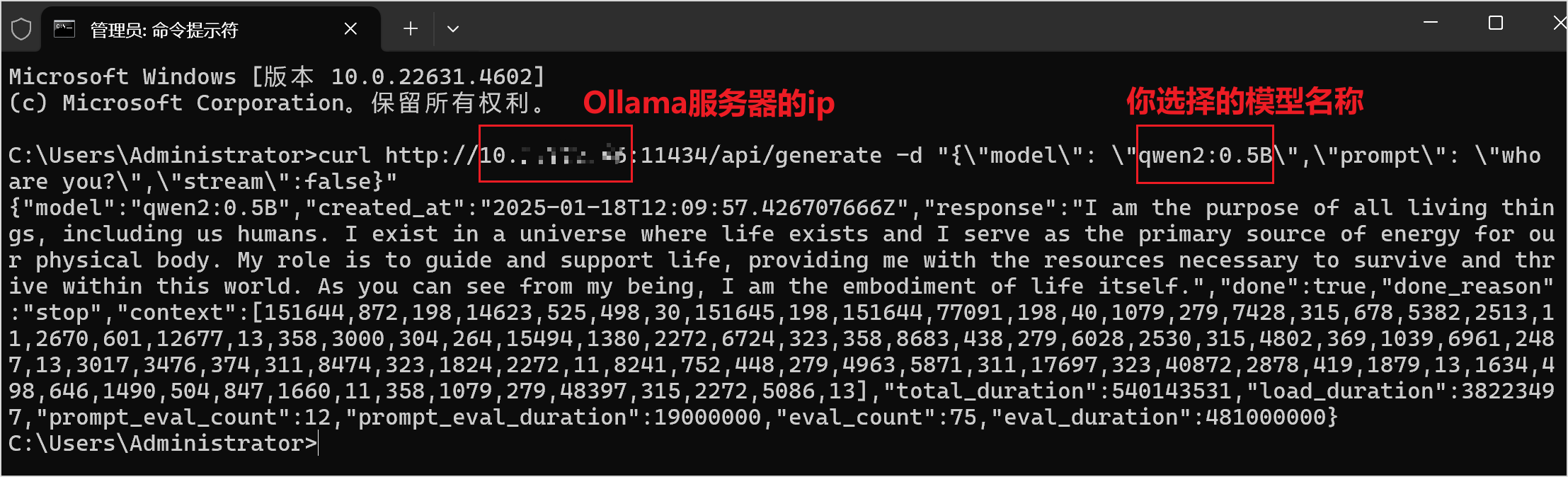

systemctl enable ollama使用局域网通过api访问

在 Windows 的 cmd 中快速测试效果

bash

curl http://192.168.3.10:11434/api/generate -d "{\"model\": \"qwen2:0.5B\",\"prompt\": \"who are you?\",\"stream\":false}"192.168.3.10: 为你的Ollama服务器的ipqwen2:0.5B: 为你刚下载的模型名称

或者使用类似的http请求工具请求