随着人工智能技术的飞速发展,本地部署大型语言模型(LLM)已成为许多技术爱好者的热门选择。本地部署不仅能够保护隐私,还能提供更灵活的使用体验。本文将详细介绍如何在 Mac mini M2(24GB 内存)上部署 DeepSeek-R1:14B 模型,并通过 Ollama 和 Chatbox 进行交互。同时,我们也会对比使用 Open-WebUI 的体验,帮助你选择最适合自己的工具。

一、环境准备

硬件要求

- 设备:Mac mini M2,24GB 内存。

- 存储空间:至少需要 50GB 的可用空间,建议预留更多空间以避免磁盘空间不足。

软件要求

- 操作系统:macOS Monterey 或更高版本。

- Ollama:用于运行和管理 DeepSeek 模型的本地引擎。

- Chatbox:轻量级的图形界面工具,用于与模型进行交互。

- Docker(可选):如果需要使用 Open-WebUI,需要安装 Docker。

二、安装Ollama

Ollama 是一个轻量级的本地 AI 模型管理工具,支持多种语言模型的运行和管理。以下是安装步骤:

1、安装 Ollama

访问 Ollama 官方网站https://ollama.com/,下载适用于 macOS 的安装包。下载完成后,点击安装包使行安装

2、启动 Ollama 服务

安装完成后,运行以下命令启动 Ollama 服务:

ollama serve验证 Ollama 是否运行正常

在浏览器中访问 http://127.0.0.1:11434,如果看到 Ollama 的欢迎页面,说明服务已成功启动。

三、下载并运行DeepSeek-R1:14B 模型

DeepSeek-R1:14B 是一个功能强大的语言模型,适用于多种自然语言处理任务。以下是下载和运行模型的步骤:

https://ollama.com/library/deepseek-r1:14b

1、下载模型

在终端中运行以下命令下载 DeepSeek-R1:14B 模型:

ollama pull deepseek-r1:14b2、验证模型是否下载成功

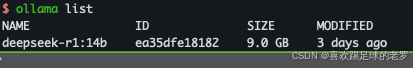

下载完成后,运行以下命令检查模型是否正确安装:

ollama list

如果看到 deepseek-r1:14b 出现在已安装模型列表中,说明模型已成功下载。

3、运行模型

使用以下命令启动模型并进入交互模式:

ollama run deepseek-r1:14b效果如下

四、安装并配置 chatbox

Chatbox 是一个轻量级的图形界面工具,支持与 Ollama 管理的模型进行交互。以下是安装和配置步骤:

安装 Chatbox

访问 Chatbox 官方网站,下载适用于 macOS 的安装包并安装。https://chatboxai.app/zh#download

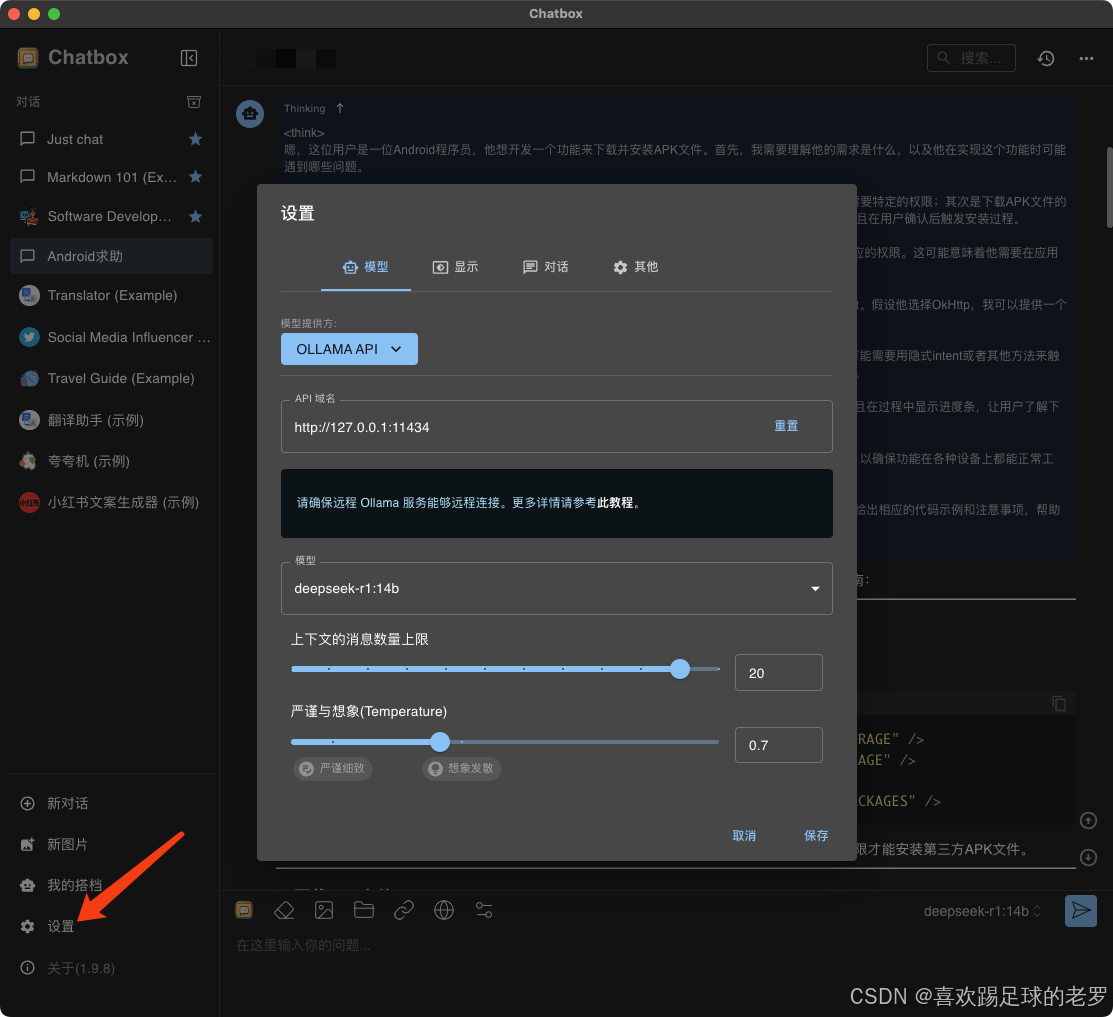

配置 Chatbox

- 打开 Chatbox 应用程序,进入设置页面:

- API 地址:设置为 http://127.0.0.1:11434。(模型提供方,选中OLLAMA API后,域名会自动填写,可选的模型也会自动列出来)

- 模型选择:选择 deepseek-r1:14b。

开始使用

配置完成后,你可以通过 Chatbox 的界面输入问题,并与 DeepSeek-R1:14B 模型进行交互。

五、体验与对比:Chatbox vs. Open-WebUI

在本地部署过程中,我们还尝试了 Open-WebUI,一个基于 Web 的交互界面。以下是两者的主要对比:

| 特性 | Chatbox | Open-WebUI |

|---|---|---|

| 优点 | - 轻量级 :安装和配置简单,占用资源少。 - 易用性高 :图形界面直观,适合新手快速上手。 - 响应速度快:本地运行,无需额外的网络延迟。 | - 功能丰富 :支持多种模型,提供更复杂的交互功能。 - 灵活性高:可以通过浏览器访问,支持多设备使用。 |

| 缺点 | - 功能有限:主要专注于与模型的交互,扩展功能较少。 | - 配置复杂 :需要安装 Docker,并进行额外的配置。 - 资源占用高:运行时可能需要更多内存和存储空间。 |

| 适用场景 | - 适合快速部署和简单使用,对资源占用敏感的用户。 | - 适合需要复杂交互功能、多设备访问的用户。 |

PS:安装与启动open-webui的命令

docker run -d -p 3110:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main通过http://localhost:3110/ ,访问open-webui

第一次访问要注册用户

六、总结

通过 Ollama 和 Chatbox,你可以在 Mac mini M2 上轻松部署并使用 DeepSeek-R1:14B 模型。整个过程简单高效,且不需要复杂的配置。无论你是技术新手还是有一定经验的开发者,都可以快速上手并享受本地 AI 模型带来的便利。

希望本文能帮助你顺利完成部署,开启智能对话的新体验!如果你在部署过程中遇到任何问题,欢迎随时留言交流。