有在离谱。

高分论文因为没有引用先前的研究而被 ICLR 拒稿了?!

于是作者提起上诉,审稿主席们推翻之前的决定,最终论文被接收并选为 Spotlight。

本以为这场闹剧就这么结束了。

没想到,诶,还牵出更离谱的事儿。

该论文的作者举报,所谓「先前的研究」本身有实验结果矛盾,甚至还涉嫌抄袭他们的成果,拿他们的论文当大模型语料用 Claude 生成论文等不当行为。但却被 COLM 2024 接收。

基于以上原因,他们拒绝引用该论文。

其实啊,这事儿他们之前争论过,如今又被热心网友扒了出来,双方作者又透露了更多细节。

来来来,速来吃个瓜。

因为没有引用研究而被拒稿

首先来看看这篇 ICLR 2025 Spotlight 论文说了啥。

他们确定了在 Scaling Law 范式中强模型崩溃现象的存在,即由于训练语料库中的合成数据而导致的严重性能下降,并且研究了模型大小的影响。

即便只有 1% 的合成数据,也会导致模型崩溃,换句话就是,训练集越来越大,也不能提高性能。

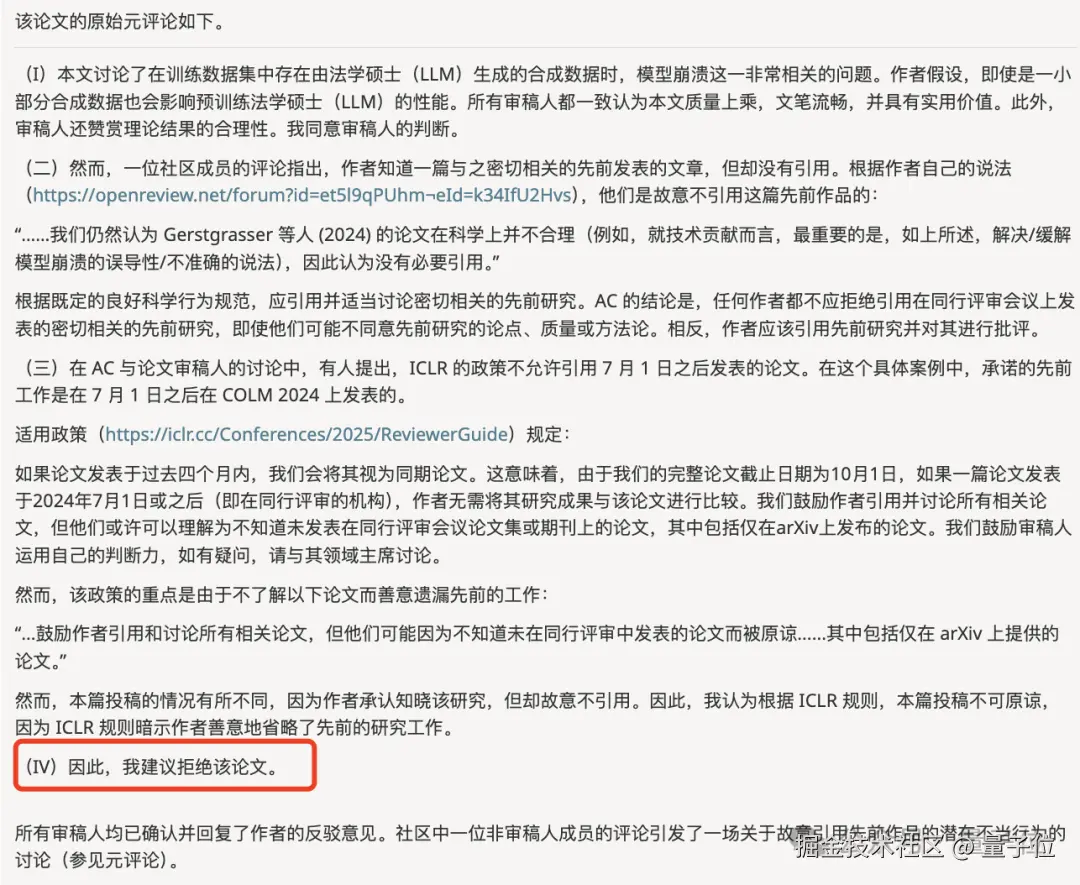

由于这篇论文「质量上乘,文笔流畅,并具有实用价值,以及理论结果的合理性」,审稿组一致给出积极的评价。

然而就在讨论期间,有人发布了条公开评论,他们故意没有引用一篇与他们这个成果密切相关的文章:

Is Model Collapse Inevitable? Breaking the Curse of Recursion by Accumulating Real and Synthetic Data

该论文最初发表于 2024 年 10 月的 COLM 2024。

评论的这个人 Rylan Schaeffer 正好是这个篇论文的共同一作。

在这篇长文中,他主要强调了三点:

1、与他们及先前的研究结论完全矛盾,此前他们表明,即使真实数据的比例消失,模型崩溃也可以被避免。

2、里面的实验设置和结果引用的是他们的论文,但都没有引用。

3、作者是故意没有引用的。

而按照 ICLR 的要求,根据既定的良好科学行为规范,应引用并适当讨论密切相关的先前研究(发表于 2024 年 7 月 1 日之前)。

但要是不知道相关成果的话可以另说,但关键是作者知道这一研究,但是故意不引用。

对此,作者进行了一一回应。当中表示,他们中间有过交流,但是对方的技术贡献比较薄弱,结论还存在误导 / 不准确。

还有个关键点是,这篇 COLM 2024 论文发表于去年 10 月,而 ICLR 审稿要求相关论文要是在 2024 年 7 月 1 日之后其实可以无需引用。

对于这种「不当行为」,评审 AC 就觉得,任何作者都不应拒绝引用在同行评审会议上发表的密切相关的先前研究,即使他们可能不同意先前研究的论点、质量或方法论。而且,还应该就先前研究进行批评。

基于这样的逻辑,AC 建议拒稿。

不过在专家组讨论之后,还是一致投票决定作者无需引用该 COLM 论文。

由于被拒的主要原因是缺少引用,且该论文在其他方面获得了积极评价,因此该论文被接受。

并且被选为 Spotlight。

模型崩溃到底谁成果?

本来这是去年的瓜,这周末突然被一热心网友翻了出来。

然后又炸出 ICLR 的原作者,抛出了更多细节:我们拒绝引用该论文,因为该论文作者存在严重的不当行为。

比如抄袭他们之前的工作,并且将他们的论文塞进大模型,让 AI 生成另一篇论文,违反 IRB 等。

因为在公开论坛 OpenReview 上讲不太合适,但他们上诉时已经提供了详细的证据。

并且,这也不是第一次说明他们的不当行为了。

早在去年 7 月,他们就有过一次争论。

起因是合成数据导致模型崩溃这一发现登上了 Nature,结果引发了不小的热议。

被指抄袭的那个人 Rylan Schaeffer 就说了一嘴,你们要是想了解模型崩溃,可以看看我们 COLM 2024 的论文。

然后这个高分论文的纽约大学教授 Julia Kempe 就站出来说明了他们的各种行为。

包括不限于,他们给「我们」看到的初始版本,没有对一些此前关键研究进行充分讨论。

他们的结论存在误导,其理论基于「我们」工作的一个微不足道的推论。

符号公式啥的也十分相似。。。

甚至于说,「我们」的实验还被喂给大模型投喂以生成他们的论文。

而他们只是提前预料到了「我们」后续的论文。该论文表明,人类反馈可以挽救模型崩塌的问题。

而在 Rylan Schaeffer 这边,他们的核心观点在于,他们抱怨的不是「没有被引用」这件事情,而是说选择性地省略了之前的研究,从而制造了一种误导性的说法,即任何数量的合成数据都可能有害。

并且在今年 3 月,他还为此发表了篇立场文章:模型崩溃并不意味着你的想法。

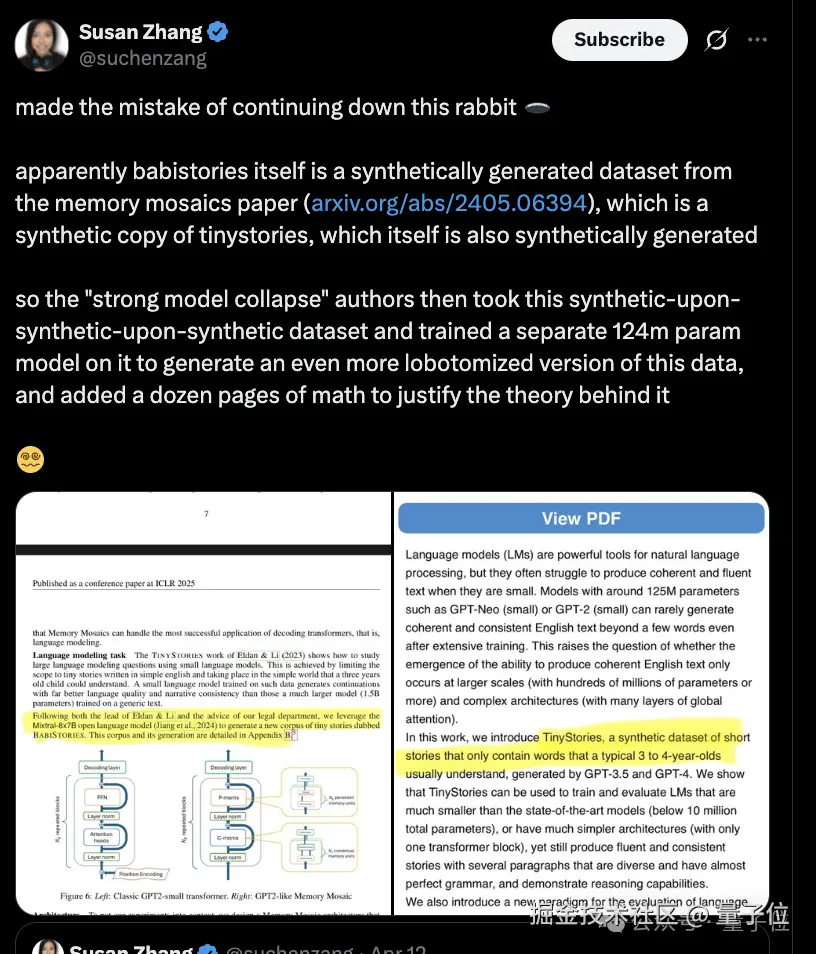

谷歌的科学家也表达了类似的想法:

如果论文的结论涉及合成数据的问题,也许首先要看他们是如何生成这些数据的。

而 "强模型崩溃" 的作者就把相当于将之前合成再合成的数据集拿过来再训练出一个模型,并添加了十几页的数学来证明其背后的理论依据。

至于孰对孰错,还是再让子弹飞一会儿。

对于这件事儿,你怎么看呢?

参考链接:

[1]openreview.net/forum?id=et...

[2]x.com/RylanSchaef...

[3]x.com/suchenzang/...

[4]arxiv.org/abs/2503.03...

一键三连**「点赞」「转发」「小心心」**

欢迎在评论区留下你的想法!

--- 完 ---