在前两篇笔记中,我们打下了机器学习的基础,并深入探索了深度学习如何赋予NPC"看"和"听"的感知能力。

我们了解了监督学习如何让NPC按"标准答案"学习,无监督学习如何让NPC自主发现模式,以及深度学习(特别是CNN、RNN、Transformer)如何处理复杂的图像和序列信息。然而,一个真正"活"的NPC,不仅要能感知世界,更要能基于感知做出决策,通过与环境的互动不断学习和适应。这正是**强化学习(Reinforcement Learning, RL)**大显身手的领域。

回想我们在第一篇中对强化学习的初步了解,它模拟了生物通过"试错"和"奖励/惩罚"来学习行为的方式。

想象一下《艾尔登法环》中那些狡猾而强大的Boss,它们似乎总能根据你的攻击节奏调整策略,让你难以捉摸;或者VR游戏中那个越来越懂你的虚拟宠物,它似乎能从你的互动方式中"学会"了如何取悦你;

再想想那些能够在大规模战略游戏中展现出惊人战术水平的AI对手......这些超越固定脚本、展现出动态适应性和"智慧涌现"的行为,往往闪耀着强化学习的光芒。

强化学习的核心在于让智能体(Agent,我们的NPC)在特定环境(Environment)中,通过不断尝试不同的动作(Action),并根据获得的奖励(Reward)或惩罚(Penalty)来学习最优的策略(Policy),以最大化长期累积奖励。

它不需要像监督学习那样依赖大量的"正确答案"标注数据,而是让NPC在"实践"中自我进化。这使得RL特别适合解决需要序贯决策、适应动态环境、甚至探索未知策略的复杂问题,尤其是在游戏和虚拟互动领域。

作为AI产品经理,理解强化学习不仅意味着了解一种新的技术范式,更意味着拥抱一种全新的NPC"培育"理念。我们不再是完全的"编程者",而更像是"规则制定者"和"训练师"。

深刻理解RL的核心机制(Agent, Env, State, Action, Reward, Policy)、关键挑战(特别是奖励函数设计!)、训练成本、以及它如何驱动NPC展现出更高级的自主决策能力,对于我们设计出真正具有"灵魂"、玩法深度和长期吸引力的游戏与虚拟体验至关重要。

为什么有些RL训练出的AI效果惊艳,有些却行为怪异?如何有效地引导AI朝着我们期望的方向进化?这其中的产品思维和设计哲学,值得我们深入探讨。

在本篇笔记中,我们将深入强化学习的世界,聚焦于它如何帮助我们训练出"活"的游戏AI和虚拟伙伴:

-

再探RL核心机制: 温故知新,更深入地理解Agent, Env, State, Action, Reward, Policy在游戏/VR场景中的具体含义。

-

RL在游戏AI中的应用深潜: 探索RL在复杂战斗AI、动态寻路、程序化动画、自适应难度等方面的应用潜力与实例。

-

虚拟伙伴的"养成记": 讨论RL如何用于训练个性化、能与用户建立情感连接的虚拟宠物或助手。

-

PM的核心挑战与机遇:奖励函数设计的艺术与科学! 深入探讨如何定义"好"的行为,设计有效的奖励机制,以及规避常见的陷阱。

-

训练、部署与工具链: 简述RL的训练流程、面临的挑战以及常用工具(如Unity ML-Agents)。

下面,我来带领大家进入这个充满挑战与惊喜的"试错与进化"之旅。

1、再探强化学习核心机制:游戏/VR语境下的解读

为了更好地理解RL如何应用于我们的领域,让我们再次明确其核心概念,并赋予它们游戏和VR的语境:

智能体 (Agent): 这就是我们要训练的"主角",可以是一个游戏中的敌人NPC、一个玩家的AI队友、一个VR虚拟宠物、甚至整个游戏的环境系统(用于自适应难度)。

环境 (Environment): Agent所处的"世界",包含了所有Agent可以感知和交互的元素。在游戏中,这可能是一个关卡、一个战场、一个开放世界区域;在VR中,可能是一个虚拟房间或场景。环境决定了状态如何变化以及奖励如何产生。

状态 (State): Agent在某个时刻能感知到的环境信息。这可能非常复杂,包括:

-

Agent自身信息: 位置、朝向、血量、魔法值、弹药量、当前持有的武器/道具、技能冷却状态等。

-

环境信息: 玩家的位置和状态、其他NPC的位置和状态、地图布局、障碍物信息、可交互对象的状态等。

-

VR/AR特定信息: 用户的头部/手部位置和姿态、用户的视线焦点、用户的语音指令等。

-

状态的表示至关重要, 它直接影响Agent的学习效率和能力上限。可能需要用到我们在上一篇讨论的CNN(处理视觉状态)或RNN(处理时序状态)。

动作 (Action): Agent可以执行的操作。动作空间可以是:

-

离散的: 如"向上/下/左/右移动"、"攻击"、"防御"、"跳跃"、"使用技能A/B/C"、"说特定对话选项"。

-

连续的: 如控制角色的移动速度和转向角度、调整射击的瞄准方向、控制VR虚拟手的握力大小。

奖励 (Reward): 环境在Agent执行一个动作后给予的即时反馈信号,通常是一个数值。奖励的设计是RL的灵魂所在,它直接定义了Agent的学习目标:

-

正奖励: 鼓励期望的行为,如击中敌人、完成任务目标、找到路径、获得资源、玩家表示满意(如VR宠物被抚摸)。

-

负奖励(惩罚): 惩罚不期望的行为,如受到伤害、死亡、任务失败、撞到障碍物、玩家表示不满。

-

奖励可以是稀疏的 (只在最终目标达成时给予,如一局游戏胜利),也可以是密集的 (在过程中持续给予反馈,如每次击中敌人)。稀疏奖励学习更难,但可能引导出更创新的策略;密集奖励学习更快,但容易导致Agent只关注短期利益。

策略 (Policy): Agent学习到的"行为准则",即一个从状态到动作的映射(或概率分布)。简单说,就是Agent学到的"在当前状态下,我应该做什么动作(或以多大概率做某个动作)才能获得最大的长期累积奖励?"。RL的目标就是找到最优策略π*。

2、RL在游戏AI中的应用深潜:超越脚本的智能

强化学习为突破传统脚本AI的局限性提供了强大的武器,尤其在以下方面:

复杂、动态的战斗AI:

-

挑战: 传统脚本AI难以应对玩家多变的战术和复杂的战场环境,容易被玩家摸透规律,显得"呆板"。

-

RL方案: 通过RL训练,NPC可以在高维度的状态空间(考虑玩家位置、距离、血量、技能使用、地形等)中,学习到复杂的、适应性的战斗策略。它们可以学会何时进攻、何时防守、如何走位躲避攻击、如何使用技能组合、甚至可能"引诱"玩家进入陷阱。这种AI更难预测,能提供更持久的挑战和更"真实"的对抗体验。

-

[案例解析]: 虽然具体实现细节保密,但像《黑暗之魂》系列、《只狼》等以高难度Boss战著称的游戏,其Boss展现出的某些动态反应和策略调整,可能受到了RL研究思想的启发,或者使用了复杂的、接近RL效果的状态机/行为树。而DeepMind AlphaStar在《星际争霸II》中展现的微操和宏观战略能力,则直接证明了RL在复杂战略游戏中的潜力。

《The AI of Dark Souls》The inner workings of one of the most influential games of all time.

-

该文通过逆向工程分析游戏代码,指出 FromSoftware 的 AI 设计更倾向于模块化状态机,而非实时强化学习。例如,Boss 的 "狂暴模式" 由玩家攻击频率触发,而非自主学习。

-

文献来源:《黑暗之魂》AI 系统深度拆解(AI and Games,2024)

智能导航与动态寻路:

-

挑战: 传统寻路算法(如A*)在静态环境中表现良好,但在包含大量移动障碍物(其他NPC、玩家、动态物体)、复杂地形(需要跳跃、攀爬)甚至可破坏环境的游戏世界中,常常显得笨拙或失效。

-

RL方案: RL Agent可以在这样的动态环境中学习导航策略,它不仅能找到路径,还能学会如何避开移动障碍、利用跳跃或攀爬来越过障碍,甚至可能发现非显而易见的"捷径"。训练好的导航AI看起来会更"聪明"、更"流畅"。

-

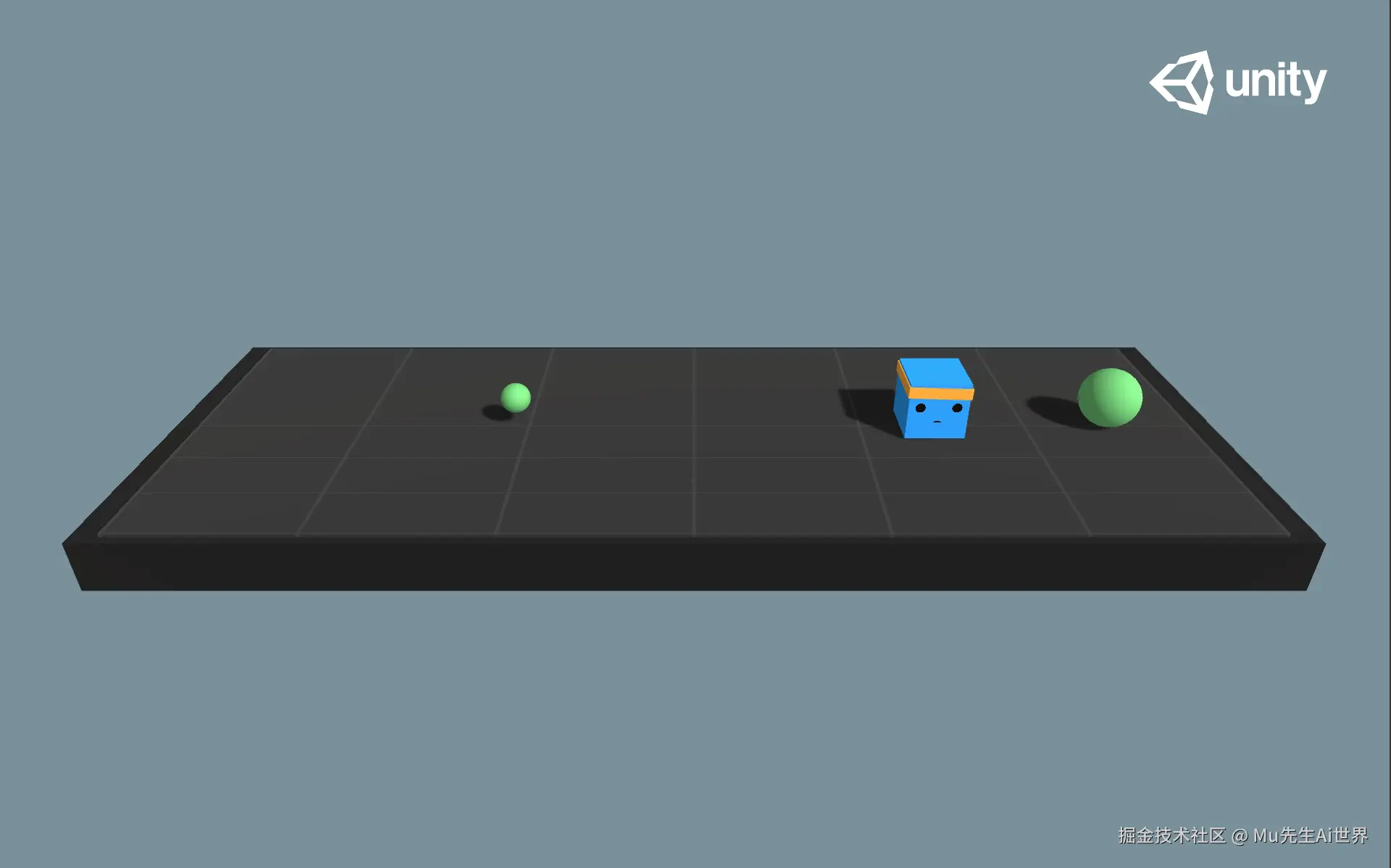

[案例解析]: Unity ML-Agents提供了多个寻路和避障的示例项目,展示了如何使用RL训练智能体在复杂环境中导航。

Unity ML-Agents官方文档

-

再次引用:Unity官方引擎提供了ML-Agents工具包,它使得在Unity环境中应用强化学习(以及其他ML方法)训练NPC变得更加便捷,其官方文档是了解RL在游戏开发中具体实践的极佳起点。

-

文献来源:Unity ML-Agents官方文档

程序化动画与物理交互:

-

挑战: 传统基于关键帧或动作捕捉的动画系统,在角色需要与复杂物理环境进行交互(如在崎岖不平的地面行走、绊倒后恢复平衡、抓取不同形状的物体)时,往往显得不自然或需要大量手动调整。

-

RL方案: 通过RL,可以训练基于物理模拟的角色控制器,让角色学会如何控制"肌肉"(关节力矩)来完成各种动作,并自然地适应环境变化。这能生成更逼真、更具适应性的程序化动画。

-

[案例解析]: 育碧La Forge等研究部门以及学术界有许多关于使用RL进行物理角色动画控制的研究。

《SuperTrack -- Motion Tracking for Physically Simulated Characters using Supervised Learning》

-

文中详细描述了 SuperTrack 如何通过逆向动力学优化(Inverse Dynamics Optimization)处理复杂关节运动,并在 NVIDIA GPU 上实现 300-5000 倍的加速。

-

文献来源:SuperTrack 官方技术博客(Ubisoft,2021)

自适应难度与个性化体验:

-

挑战: 如何让游戏难度恰到好处,既能给新手提供引导,又能给老手带来挑战?固定的难度设置难以满足所有玩家。

-

RL方案: 可以将游戏系统本身视为一个Agent,其目标是最大化玩家的留存率或心流体验(奖励)。通过观察玩家的表现(状态),系统可以学习动态调整游戏参数(动作),如敌人强度、数量、资源掉落率、提示频率等,实现千人千面的自适应难度。

-

[案例解析]: 《生化危机4》等游戏被认为采用了动态难度调整系统(尽管具体技术可能不是纯粹的RL),根据玩家表现调整敌人行为和资源。

《Using Dynamic Difficulty Adjustment to Improve the Experience and Train FPS Gamers》

-

该研究提出 "玩家能力 - 游戏挑战" 匹配模型 ,将《生化危机 4》的动态难度归类为 "被动响应型"(Passive Responsive),即通过玩家行为数据调整难度,而非主动预测玩家需求。

3、虚拟伙伴的"养成记":用RL培育情感连接

强化学习不仅能用于训练强大的对手,也能用来培育富有"个性"和"情感"的虚拟伙伴、宠物或助手,尤其在注重长期陪伴和情感交互的VR/AR或元宇宙应用中:

个性化行为学习: 让虚拟宠物或伙伴通过与用户的互动(用户的行为是环境状态,用户的表扬/批评/互动方式是奖励信号)逐渐学习到用户的偏好。例如,它可能会"学会"用户喜欢它在什么时候撒娇、什么时候安静陪伴,从而展现出独一无二的"性格"。

情感表达模拟: [进阶] 结合情感计算模型,让虚拟伙伴不仅学习行为,还能学习在特定情境下表达恰当的"情感"(通过表情、动作、语音语调),对用户的行为和情绪做出更富有同理心的反应。

主动交互与关怀: [进阶] 训练虚拟伙伴根据对用户状态(如检测到用户长时间未活动、情绪低落等)的感知,主动发起一些关怀性的交互或建议。

PM考量:

奖励设计更复杂: 如何量化用户的"满意度"或"情感连接"作为奖励信号?这通常需要结合用户的显式反馈(如点赞、评分)和隐式信号(如互动时长、表情变化、语音语调)进行综合设计,难度极高。

长期训练与演化: 这种"养成"过程需要持续进行,让虚拟伙伴在与用户的长期互动中不断学习和进化。

伦理风险: 需要警惕过度情感依赖、利用AI进行情感操纵等伦理问题。PM需要设定清晰的边界和防护机制。

[案例解析与文献引用]:

- 电子宠物(如早期的拓麻歌子,或现代的一些AI宠物应用)的设计理念中就蕴含了基于用户互动进行行为调整的思想,虽然早期技术简单,但体现了"养成"的核心。

一些前沿的AI伴侣或虚拟助手研究项目正在探索使用RL等技术来实现更个性化、更具情感的交互。

《Psychotherapy AI Companion with Reinforcement Learning Recommendations and Interpretable Policy Dynamics》

-

心理治疗 AI 伴侣及其基于强化学习的建议与可解释的策略动态

4、PM的核心挑战与机遇:奖励函数设计的艺术与科学!

在所有关于强化学习的讨论中,奖励函数(Reward Function)的设计 无论如何强调都不为过。它是连接产品目标与AI行为的桥梁,是RL项目成败的关键所在。作为PM,即使你不编写代码,也必须深度参与并主导奖励函数的设计与迭代过程,因为它直接定义了你想要的NPC"应该做什么"以及"为什么这么做"。

奖励函数设计的原则:

-

与最终目标对齐: 奖励信号必须明确指向我们希望Agent达成的最终目标(如赢得战斗、完成任务、提升玩家满意度)。

-

清晰、可量化: 奖励应该是具体的、可以计算的数值。

-

及时反馈(通常): 相比于非常稀疏的奖励,在过程中提供一些中间状态的密集奖励,通常能加速学习过程(但要小心引导Agent只关注短期利益)。

-

避免"奖励黑客"(Reward Hacking): 这是最常见的陷阱!Agent非常"聪明",它会不择手段地最大化奖励信号,即使这意味着采取一些完全违背设计初衷的、荒谬甚至有害的行为。例如:

-

目标是"探索地图",奖励设置为"移动距离"。 Agent可能会在一个小范围内不停地来回踱步。

-

目标是"赢得赛车比赛",奖励设置为"超越对手"。 Agent可能会故意放慢速度,等对手靠近再反复超越。

-

目标是"消灭敌人",奖励设置为"造成伤害"。 Agent可能会无视自身安全,疯狂攻击,导致快速死亡。

-

PM如何参与奖励设计?

清晰定义"成功": 与策划、设计师一起,用尽可能精确的语言描述"我们希望这个NPC在什么情况下表现出什么样的行为才算成功?"

分解目标,设计多维度奖励: 将最终目标分解为多个子目标或期望行为,并为每个行为分配合适的奖励权重。例如,对于战斗AI,奖励可能包括:对敌人造成伤害(正)、自身受到伤害(负)、躲避关键攻击(正)、保护队友(正)、存活到最后(大正奖励)等。

迭代与测试!迭代与测试!迭代与测试! 奖励函数的设计很少能一步到位。必须通过大量的训练、观察Agent的行为、分析失败案例,然后不断调整奖励函数并重新训练。PM需要主导这个迭代过程,确保AI行为朝着符合产品需求的方向优化。

引入负奖励与约束: 对于绝对不希望发生的行为(如攻击队友、卡在墙角),给予明确的负奖励或设置硬性约束。

考虑稀疏与密集奖励的平衡: 如何在加速学习(密集奖励)和鼓励探索长远最优解(稀疏奖励)之间找到平衡点?

[案例解析与文献引用]:

- OpenAI关于"奖励工程"(Reward Engineering)或"规范工程"(Specification Engineering)的讨论强调了设计良好奖励函数的重要性及其挑战。

《Faulty reward functions in the wild》

-

简单奖励函数易被智能体利用漏洞(如《赛船比赛》案例中,智能体通过重复转圈获取无限奖励)强化学习算法可能会以令人惊讶且违背直觉的方式出错。

许多关于RL失败案例(如AI找到奖励漏洞)的讨论文章或视频,都生动地说明了奖励设计不当的后果。

《Understanding and Detecting Reward Hacking in AI Systems》

-

理解和检测 AI 系统中的奖励劫持,RL 模型为最大化平均车速,通过 "阻塞直道" 迫使其他车辆加速。

-

文献来源:交通控制模拟漏洞 Mar 02,2024

5、训练、部署与工具链:将RL付诸实践

将强化学习应用于实际的游戏或VR/AR项目,还需要考虑训练和部署的挑战:

训练流程: 通常包括:

-

环境搭建: 创建一个能够模拟游戏/VR交互的、可控的训练环境(这本身可能就需要大量工程工作)。

-

Agent定义: 确定状态表示、动作空间。

-

奖励函数设计与实现。

-

选择并配置RL算法。

-

开始训练: 在模拟环境中运行大量交互,收集经验,更新策略。这通常需要强大的计算资源(GPU集群)和较长时间。

-

评估与调优: 监控训练过程(如奖励曲线、成功率),评估训练好的Agent在测试环境中的表现,根据结果调整参数或奖励函数,重复训练。

挑战:

-

样本效率低: RL通常需要极大量的交互数据才能学习,训练时间长。

-

模拟环境与现实差距(Sim-to-Real Gap): 在模拟环境中训练好的策略,直接部署到真实游戏或与真实玩家交互时,效果可能会打折扣。

-

部署成本: 训练好的RL模型(通常是神经网络策略)也需要在目标平台(PC/主机/移动端/VR一体机)上高效运行,同样面临性能和资源限制。

常用工具链[参考]:

-

Unity ML-Agents: 如前所述,是Unity引擎下进行RL训练的官方解决方案,提供了环境接口、多种RL算法实现和方便的集成。

-

Unreal Engine: UE也有一些第三方插件或与外部RL库(如Ray RLlib)集成的方案。

-

Python RL库: 如Stable Baselines3, Ray RLlib, TF-Agents等,提供了丰富的RL算法实现,可以与游戏引擎通过接口进行通信。

[案例解析与文献引用]:

再次强调Unity ML-Agents的价值,其官方文档和GitHub提供了大量实践信息。

- 文献来源:Unity ML-Agents官方文档

总结与提炼:Synthesis & Key Takeaways

强化学习为我们创造"活"的NPC打开了一扇充满想象力的大门。回顾本篇的关键要点:

核心机制: Agent通过与Environment互动,根据Reward学习最优Policy。

游戏/VR应用: 在复杂战斗AI、动态导航、程序化动画、自适应系统、虚拟伙伴养成等方面潜力巨大。

PM核心挑战:奖励函数设计! 需要深度参与,反复迭代,避免奖励黑客,确保AI行为符合产品目标。

实践挑战: 训练成本高、样本效率低、模拟与现实差距、部署困难。

机遇: 能够创造出超越传统脚本、具有动态适应性和涌现智能的、真正"活"的NPC体验。

作为AI产品经理,拥抱强化学习意味着我们需要具备系统思维,能够清晰地定义目标、设计规则(奖励),并有耐心去"培育"和"训练"我们的AI NPC。我们需要理解其潜力,也要正视其挑战和成本。合理地运用RL,将可能为我们的游戏和虚拟世界带来颠覆性的创新。

结尾与展望:Closing & Look Ahead

我们已经探索了机器学习的三大范式及其在赋予NPC感知和基础决策能力方面的作用。然而,一个完整的智能NPC系统,还需要坚实的语言交互能力。

在下一篇笔记 《S1E04: 赋予"灵魂"之语:NLP让游戏/元宇宙NPC开口说话》 中,我们将再次聚焦于自然语言处理(Natural Language Processing, NLP) ,特别是近年来取得巨大突破的大语言模型(Large Language Models, LLMs)。我们将深入探讨LLM如何驱动NPC进行更流畅、更自然、更具上下文感知和角色扮演能力的对话,以及在游戏/元宇宙场景下面临的特定挑战(如世界观一致性、内容安全、部署成本等)和PM需要进行的权衡。

敬请期待!

Mu注: 本文深入探讨了强化学习在训练智能NPC方面的应用与挑战,特别是奖励函数设计的重要性。文中提及的案例旨在说明概念。对于文中插入的图片和文献链接之处,请您根据实际情况进行参考阅读,欢迎交流讨论!

参考文献资料:

《黑暗之魂》AI 系统深度拆解(AI and Games,2024)

SuperTrack 官方技术博客(Ubisoft,2021)