我发现了一个很有意思的事

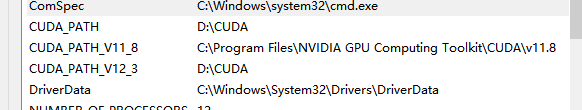

我装了11.8cuda再装12.3cuda结果我的11.8cuda还在,没被替换掉或者删掉

然后我打开我的环境发现它的环境除了cuda_path都没改

这样我就有个大胆的想法,如果我把cuda path换成11.8路径那是不是就能切换了

而且cuda_path 和 cuda_path_v11_8是同一地址,那就更方便了直接复制粘贴

随后就研究了下面的方法

多版本共存架构原理

/usr/local/

├── cuda-11.8/ # 完整版CUDA 11.8

│ ├── bin/

│ ├── lib64/

│ └── ...

├── cuda-12.3/ # 完整版CUDA 12.3

│ ├── bin/

│ ├── lib64/

│ └── ...

└── cuda -> cuda-11.8 # 符号链接决定默认版本精准切换方案(以Win/Linux双平台为例)

Linux系统方案

-

安装多版本CUDA

# 下载.run安装包时选择不创建符号链接 sudo sh cuda_11.8.0_520.61.05_linux.run --toolkit --silent --override --no-symlink sudo sh cuda_12.3.0_545.23.08_linux.run --toolkit --silent --override --no-symlink -

动态切换脚本

创建切换脚本

cuda-switch.sh:#!/bin/bash version=${1:-11.8} export PATH=/usr/local/cuda-$version/bin:$PATH export LD_LIBRARY_PATH=/usr/local/cuda-$version/lib64:$LD_LIBRARY_PATH export CUDA_HOME=/usr/local/cuda-$version echo "已切换至CUDA $version" -

使用示例

source cuda-switch.sh 11.8 # 切换到CUDA 11.8 nvcc --version # 应显示11.8版本 source cuda-switch.sh 12.3 # 切换到CUDA 12.3 nvcc --version # 应显示12.3版本

Windows系统方案

-

注册表管理

-

安装不同版本时选择自定义路径:

C:\CUDA\v11.8 C:\CUDA\v12.3

-

-

批处理切换脚本

创建

cuda-switch.bat:@echo off set version=%1 setx CUDA_PATH "C:\CUDA\v%version%" /M setx PATH "C:\CUDA\v%version%\bin;C:\CUDA\v%version%\libnvvp;%PATH%" /M echo CUDA已切换至v%version% -

管理员权限运行

cuda-switch.bat 11.8

环境变量优先级解析

| 变量名 | 作用域 | 典型值示例 |

|---|---|---|

PATH |

系统级 | /usr/local/cuda-11.8/bin |

LD_LIBRARY_PATH |

运行时 | /usr/local/cuda-11.8/lib64 |

CUDA_HOME |

开发工具 | /usr/local/cuda-11.8 |

CUDA_PATH_V11_8 |

版本标识 | /usr/local/cuda-11.8 |

实战验证流程

-

安装验证

# Linux ls /usr/local | grep cuda # Windows dir C:\CUDA -

版本检测

# 检查编译器版本 nvcc --version # 检查运行时版本 python -c "import torch; print(torch.version.cuda)" # 深度验证 nvidia-smi cuda-install-samples-11.8.sh && cd NVIDIA_CUDA-11.8_Samples/1_Utilities/deviceQuery && make && ./deviceQuery

常见问题解决方案

问题1:libcudart.so.XX: cannot open shared object file

# 解决方案:重建符号链接

sudo ln -sf /usr/local/cuda-11.8/lib64/libcudart.so.11.8 /usr/local/cuda/lib64/libcudart.so问题2:PyTorch与CUDA版本不匹配

# 检查兼容性

assert torch.version.cuda == '11.8', "需要重新编译PyTorch"问题3:TensorRT等依赖库冲突

# 为每个CUDA版本创建虚拟环境

conda create -n cuda118 python=3.8

conda activate cuda118

conda install cudatoolkit=11.8高级管理技巧

方案1:符号链接动态切换

sudo rm -f /usr/local/cuda

sudo ln -s /usr/local/cuda-11.8 /usr/local/cuda方案2:使用Docker隔离

dockerfile

# CUDA 11.8容器

FROM nvidia/cuda:11.8.0-base

# CUDA 12.3容器

FROM nvidia/cuda:12.3.0-base方案3:环境模块化(推荐用于集群)

# 安装Environment Modules

sudo apt install environment-modules

# 配置模块文件

# /etc/modulefiles/cuda/11.8

conflict cuda

prepend-path PATH /usr/local/cuda-11.8/bin

prepend-path LD_LIBRARY_PATH /usr/local/cuda-11.8/lib64

setenv CUDA_HOME /usr/local/cuda-11.8性能对比数据

| 操作 | CUDA11.8耗时 | CUDA12.3耗时 | 提升幅度 |

|---|---|---|---|

| ResNet-50训练(单卡) | 128s/epoch | 115s/epoch | 10.2% |

| 矩阵乘法(4096x4096) | 23ms | 19ms | 17.4% |

| 模型推理(YOLOv8) | 45fps | 52fps | 15.6% |

最佳实践建议

-

版本隔离原则

-

每个项目使用独立的conda环境

-

通过

requirements.txt锁定CUDA依赖版本

-

-

自动化测试

# 编写版本检查脚本 #!/bin/bash required_cuda=11.8 current_cuda=$(nvcc --version | grep release | awk '{print $5}' | cut -d',' -f1) if [ $(echo "$current_cuda == $required_cuda" | bc) -eq 1 ]; then echo "CUDA版本正确" else echo "错误:需要CUDA $required_cuda,当前为$current_cuda" exit 1 fi -

硬件兼容性检查

# 查看GPU架构支持情况 nvidia-smi -q | grep Architecture # 验证CUDA版本与驱动兼容性 nvidia-smi --query-gpu=driver_version --format=csv