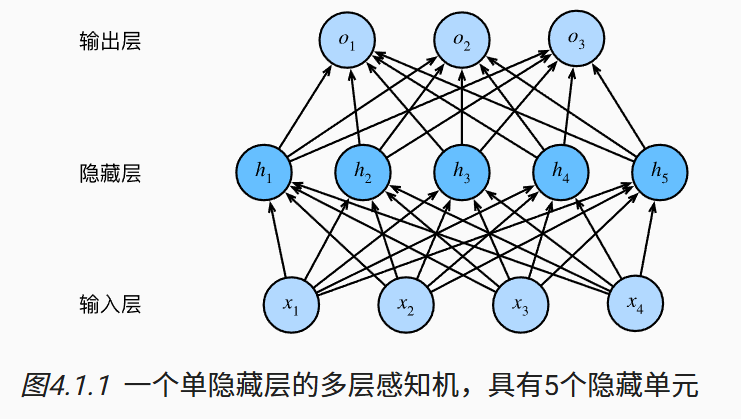

多层感知机(multilayer perceptron, MLP)

4.1.1 隐藏层

MLP 中的隐藏层和输出层都是全连接层.

4.1.2 激活函数

ReLU函数: ReLU ( x ) = max ( x , 0 ) \operatorname{ReLU}(x) = \max(x, 0) ReLU(x)=max(x,0)

sigmoid函数: sigmoid ( x ) = 1 1 + exp ( − x ) \operatorname{sigmoid}(x) = \frac{1}{1 + \exp(-x)} sigmoid(x)=1+exp(−x)1

tanh函数: tanh ( x ) = 1 − exp ( − 2 x ) 1 + exp ( − 2 x ) \operatorname{tanh}(x) = \frac{1 - \exp(-2x)}{1 + \exp(-2x)} tanh(x)=1+exp(−2x)1−exp(−2x)

学习来源:

https://zh-v2.d2l.ai/chapter_multilayer-perceptrons/mlp.html#id2