在开发 .NET 应用时,我偶然遇到使用 StackExchange.Redis 作为 Redis 客户端时出现的超时问题。经查验,这些问题往往不是 Redis 服务器本身出了故障,而是客户端侧的配置和资源管理不当所致。尤其是当应用运行在高并发环境下,比如 ASP.NET Core 服务中使用 Kestrel 服务器时,超时异常如 RedisTimeoutException 或 Timeout performing GET 会频繁出现,让人头疼不已。

通过多次排查和优化,我发现这些问题的根源大多指向 .NET 的线程池(ThreadPool)管理机制,包括线程饥饿(thread starvation)、线程窃取(thread theft)和线程池阻塞等现象。本文将从 StackExchange.Redis 的超时问题入手,逐步深入探讨这些线程池相关的挑战,提供详细的分析、代码示例和优化建议。希望能帮助大家在实际项目中避开这些坑。

StackExchange.Redis 超时问题的常见表现与初步诊断

StackExchange.Redis 是一个高效的 .NET Redis 客户端,支持异步操作和多路复用,但它对底层线程资源的依赖很强。一旦超时发生,异常消息通常会携带丰富的诊断信息,例如:

Timeout performing GET MyKey (5000ms), inst: 1, qs: 10, in: 1024, mgr: 8 of 10 available, IOCP: (Busy=5,Free=995,Min=4,Max=1000), WORKER: (Busy=3,Free=997,Min=4,Max=1000)这里,qs 表示等待响应的请求数,in 是输入缓冲区字节数,mgr 是专用线程池状态,IOCP 和 WORKER 则反映了 .NET 全局线程池的忙碌情况。如果 qs 值持续增长,或者忙碌线程数(Busy)接近或超过最小线程数(Min),很可能就是线程池问题在作祟。根据 StackExchange.Redis 的官方文档,超时往往源于网络绑定、CPU 负载或线程池饱和。

在我的项目中,一个典型的场景是:在高并发请求下,应用突然出现批量超时。起初,我怀疑是 Redis 服务器负载过高,但通过监控发现服务器端响应正常,问题出在客户端。进一步检查日志,发现线程池的忙碌线程数激增,这让我意识到需要深入了解 .NET 的线程池管理。

.NET 线程池的管理机制

.NET 的线程池是 CLR(Common Language Runtime)提供的一个共享线程资源池,用于处理异步任务、I/O 操作和定时器回调等。它分为两种线程:Worker Threads(用于 CPU 密集型任务)和 IOCP Threads(I/O Completion Port Threads,用于异步 I/O 操作)。线程池的设计目标是高效复用线程,避免开发者手动创建线程带来的开销。

线程池的动态调整算法

线程池的大小不是固定的,而是动态调整的。默认最小线程数(MinThreads)通常与 CPU 核心数相关,例如在 4 核机器上,Min 为 4,Max 为 1023。CLR 会根据负载自动增长或收缩线程:

- 增长机制:当任务队列中有待处理项时,每 500ms 添加一个新线程,直到达到 MaxThreads。

- 收缩机制:空闲线程超过一定时间(约 15 秒)后被销毁,降到 MinThreads。

这种算法在大多数场景下工作良好,但有一个明显的延迟:从最小线程数到增长需要时间。如果突发高负载,初始线程不足会导致任务排队,形成"饥饿"状态。

你可以通过 C# 代码查询当前线程池状态:

using System;

using System.Threading;

class ThreadPoolMonitor

{

static void Main()

{

ThreadPool.GetMinThreads(out int workerMin, out int iocpMin);

ThreadPool.GetMaxThreads(out int workerMax, out int iocpMax);

Console.WriteLine($"最小 Worker Threads: {workerMin}, IOCP Threads: {iocpMin}");

Console.WriteLine($"最大 Worker Threads: {workerMax}, IOCP Threads: {iocpMax}");

}

}在 StackExchange.Redis 中,异步命令如 StringGetAsync 会依赖 IOCP 线程处理网络读取。如果 IOCP 线程忙碌,响应回调就会延迟,导致超时。

StackExchange.Redis 对线程池的依赖

从 2.0 版本开始,StackExchange.Redis 引入了专用线程池(SocketManager),用于处理大多数异步完成操作。这减少了对全局线程池的依赖,但如果专用线程池饱和(mgr 显示 busy 高),工作仍会溢出到全局线程池。专用线程池大小固定,适合常见负载,但在大规模应用中可能不足。

例如,在一个连接中,Redis 的读取循环需要专用线程从服务器拉取数据。如果这个线程被阻塞或窃取,整个连接就会卡住。

线程饥饿:资源耗尽的罪魁祸首

线程饥饿是指线程池可用线程被完全占用,无法及时分配给新任务,导致任务在队列中等待过久。为什么会出现饥饿?主要成因包括:

-

负载突发:高并发时,初始 MinThreads 太小,无法立即应对。CLR 的 500ms 增长延迟会放大问题。

-

同步阻塞异步 :在异步代码中使用

Task.Result或Thread.Sleep会阻塞线程池线程,使其无法复用。例如:var task = db.StringGetAsync("key");

var value = task.Result; // 这会阻塞当前线程

这种操作在高负载下会快速耗尽线程,导致饥饿。

- I/O 操作密集:Redis 的网络 I/O 需要 IOCP 线程。如果 Min IOCP 太小,突发读取会排队。

在 StackExchange.Redis 中,饥饿表现为 busy IOCP 或 WORKER 高于 Min,qs 值增加。在很多项目中,通过调高 MinThreads 可以有效解决类似问题。

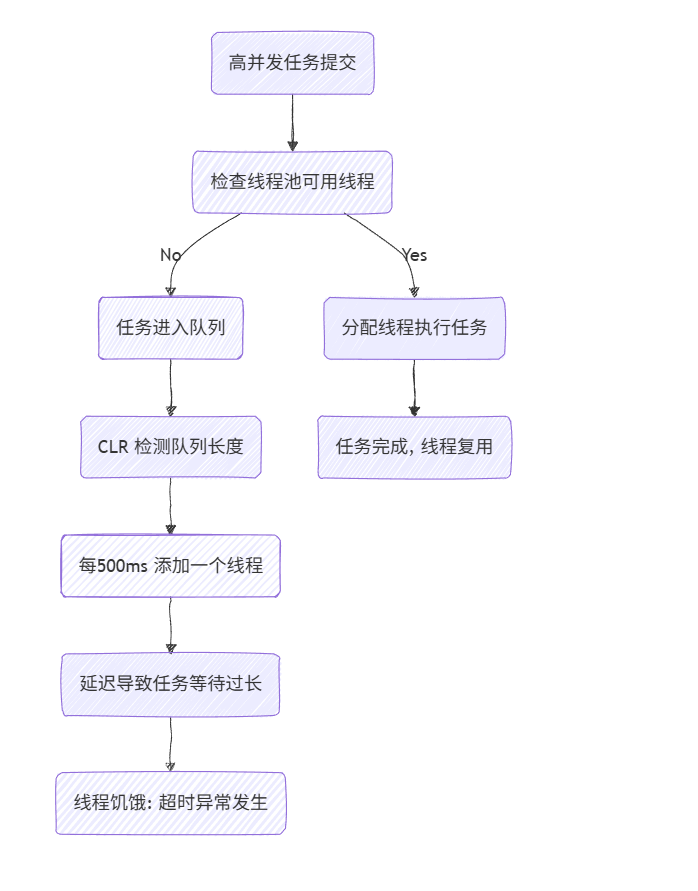

线程饥饿的流程图

为了更直观地理解线程饥饿的过程,我绘制了一个简单的流程图:

这个图展示了从任务提交到饥饿的链条。如果延迟积累,Redis 操作就会超时。

线程窃取:专用线程的劫持

线程窃取是 StackExchange.Redis 特有的问题,指读取循环线程被其他逻辑"劫持",导致数据读取中断。官方文档中,如果异常的 rs 参数显示 "CompletePendingMessage*",很可能就是窃取在作祟。

为什么会出现线程窃取?

- SynchronizationContext 的影响:在 ASP.NET Core 中,异步延续可能在当前线程(读取线程)上同步执行,导致窃取。

- 用户代码占用:回调中执行长操作,会劫持读取线程。

解决方案:启用 preventthreadtheft 标志,将完成操作队列到线程池。

ConnectionMultiplexer.SetFeatureFlag("preventthreadtheft", true);

var conn = ConnectionMultiplexer.Connect("localhost");这能有效避免窃取,但需注意潜在的线程池压力增加。

窃取与饥饿的交互

窃取往往与饥饿结合:饥饿时,系统更倾向复用现有线程,包括专用读取线程,进一步恶化问题。在 Linux 环境下,这种交互更明显,而 Windows 可能不那么敏感。

线程池阻塞:综合影响与优化策略

线程池阻塞是饥饿和窃取的综合表现,导致整个池无法响应新任务。在 Redis 场景下,阻塞会造成级联超时:一个大请求阻塞连接,后续小请求全军覆没。

阻塞的深层影响

- 性能下降:响应时间从毫秒级飙升到秒级。

- 应用崩溃:极端情况下,队列无限增长,导致 OOM。

- 诊断难度:需监控忙碌线程数和队列长度。

我从一个朋友那边了解到,他的线程池阻塞源于同步日志记录,使用信号量保护缓冲区导致。

优化策略与代码实践

-

调整线程池配置:启动时设置 MinThreads。

ThreadPool.SetMinThreads(200, 200); // Worker 和 IOCP 均设为200

但别过度:高值增加上下文切换开销。

-

使用连接池:维护多个 ConnectionMultiplexer,分散负载。

private static readonly List<ConnectionMultiplexer> _redisPool = new List<ConnectionMultiplexer>();

public static ConnectionMultiplexer GetAvailableConnection()

{

// 逻辑:创建或返回负载低的连接

if (_redisPool.Count < 5)

{

_redisPool.Add(ConnectionMultiplexer.Connect("localhost"));

}

return _redisPool[0]; // 简化示例

} -

监控与重试:集成 Polly 重试超时操作。

-

避免慢命令:使用 Redis SLOWLOG 检查并优化。

-

专用线程池自定义:对于极端场景,自定义 SocketManager。

在我的一个微服务项目中,通过这些优化,超时率从 5% 降到 0.1%。

案例研究:生产环境中的排查

拿一个真实案例来说:在 Azure 上部署的 .NET Core 应用,使用 StackExchange.Redis 缓存用户数据。高峰期超时频发。排查步骤:

- 检查异常:qs 高,busy IOCP 超过 Min。

- 监控线程池:发现饥饿。

- 优化:设 MinThreads 200,启用 preventthreadtheft。

- 结果:问题解决,但内存使用增加 20%。

在某些场景下,同步等待导致 PhysicalBridge 阻塞,解决方案是全异步化。

结语:线程池管理的平衡艺术

从 StackExchange.Redis 超时问题出发,我们看到了 .NET 线程池管理的复杂性。线程饥饿、窃取和阻塞不是孤立问题,而是相互交织的。优化需要从配置、代码和监控多角度入手。记住,线程池是共享资源,过度依赖会放大风险。 建议在项目初期就规划好异步模式,并定期进行负载测试。