目录

[6.1 间隔与支持向量](#6.1 间隔与支持向量)

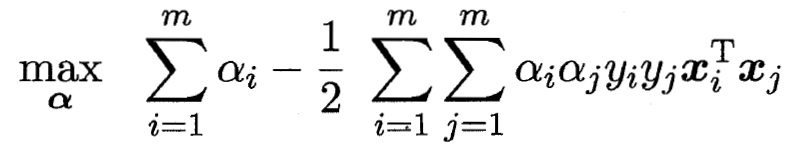

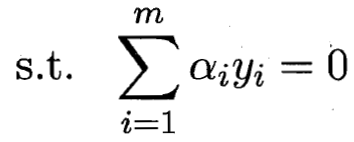

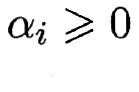

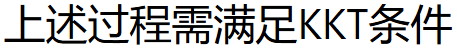

[6.2 对偶问题](#6.2 对偶问题)

[6.2.1 拉格朗日&KKT](#6.2.1 拉格朗日&KKT)

[6.2.2 SMO (Sequential Minimal Optimization)求解](#6.2.2 SMO (Sequential Minimal Optimization)求解)

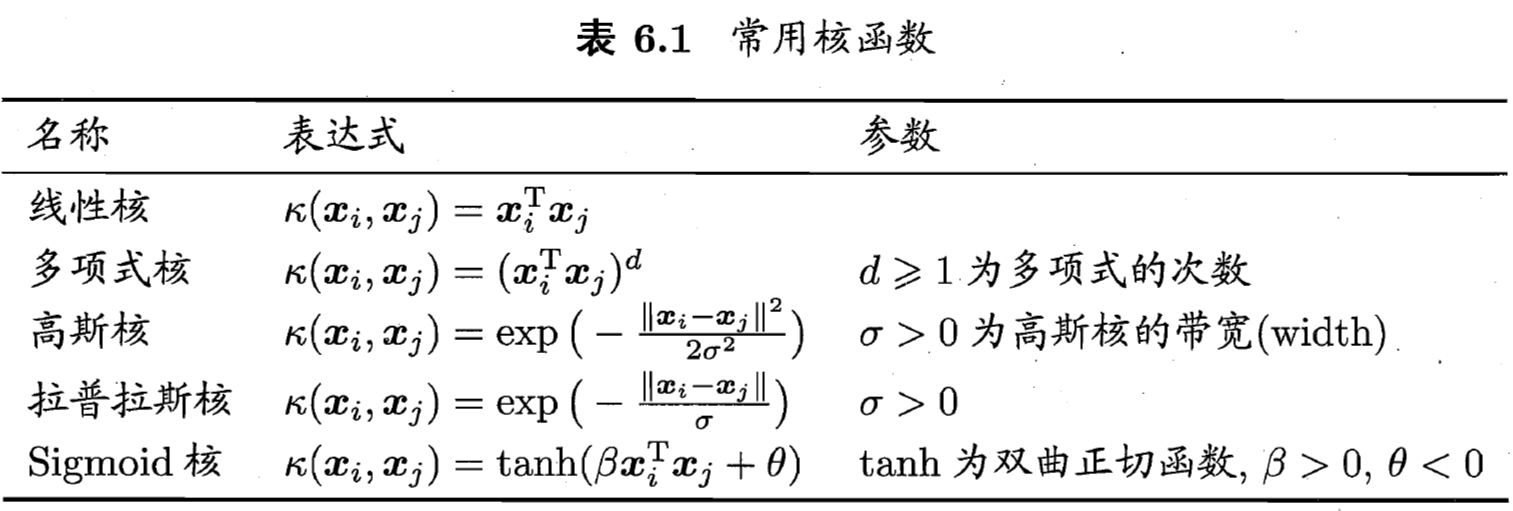

[6.3 核函数](#6.3 核函数)

[6.3.1 引入核函数的作用](#6.3.1 引入核函数的作用)

[6.3.2 核函数的性质](#6.3.2 核函数的性质)

[6.4 软间隔与正则化](#6.4 软间隔与正则化)

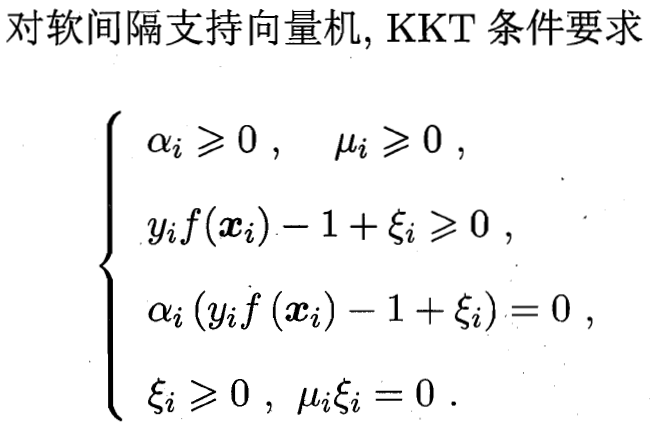

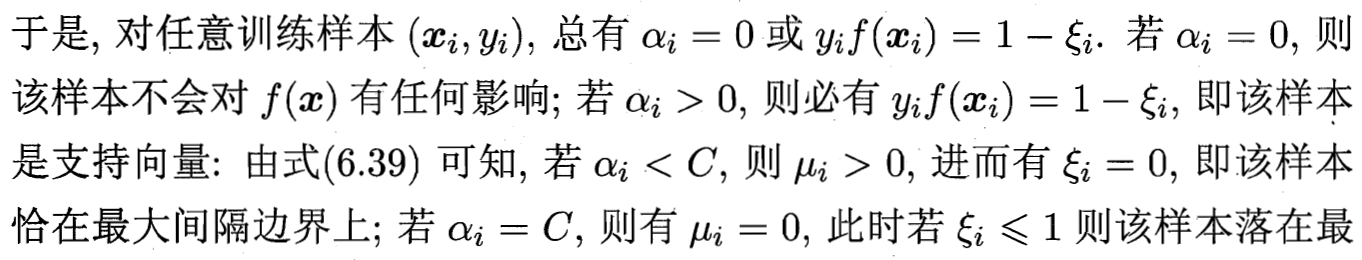

[6.4.1 对偶求解&KKT条件分析](#6.4.1 对偶求解&KKT条件分析)

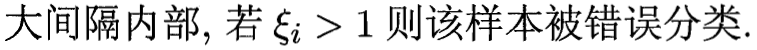

[6.4.2 正则化结构分析与推广](#6.4.2 正则化结构分析与推广)

[6.5 支持向量回归SVR](#6.5 支持向量回归SVR)

[6.6 核方法](#6.6 核方法)

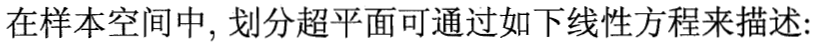

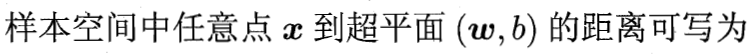

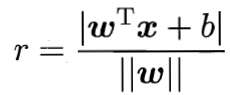

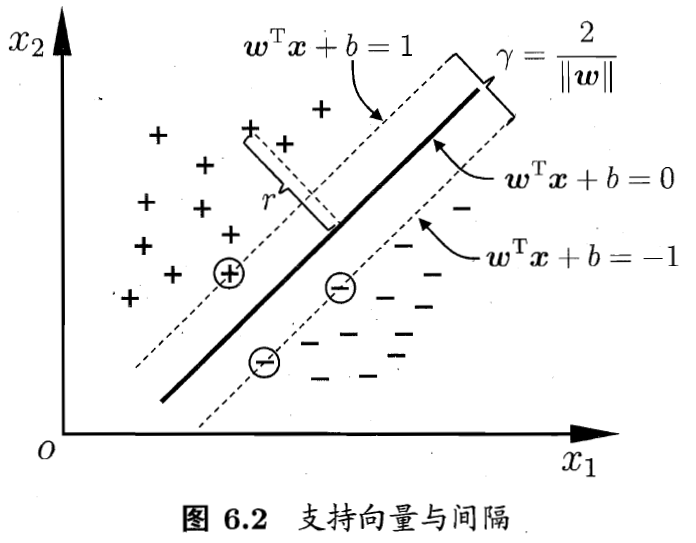

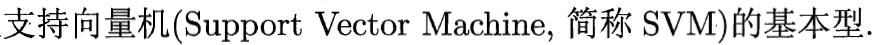

6.1 间隔与支持向量

6.2 对偶问题

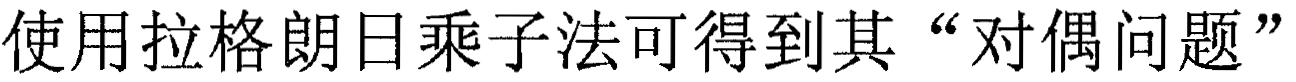

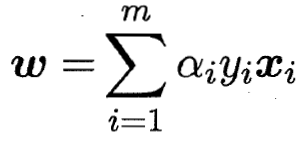

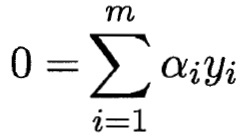

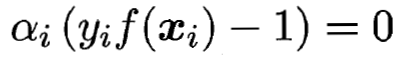

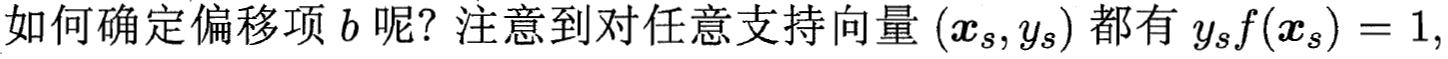

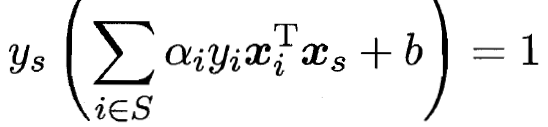

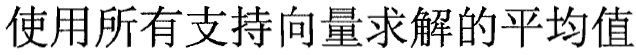

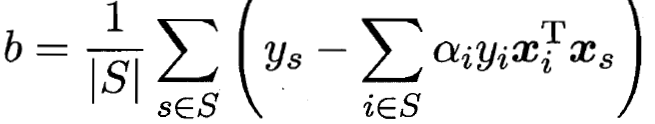

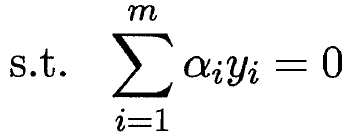

6.2.1 拉格朗日&KKT

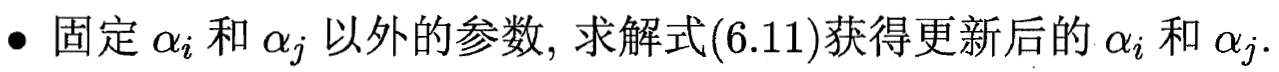

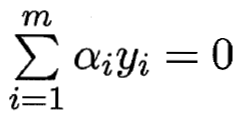

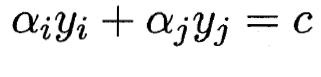

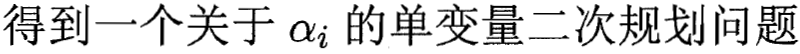

6.2.2 SMO (Sequential Minimal Optimization)求解

6.3 核函数

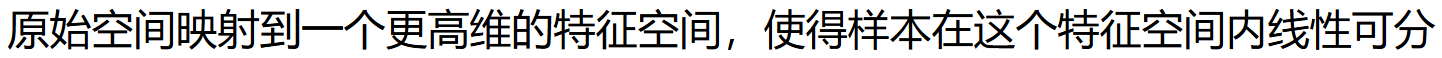

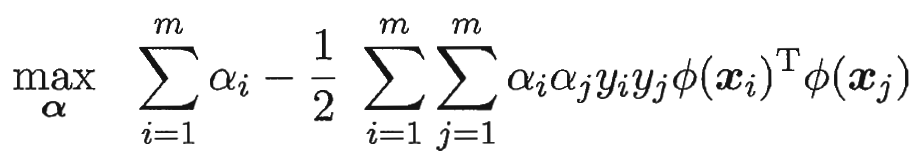

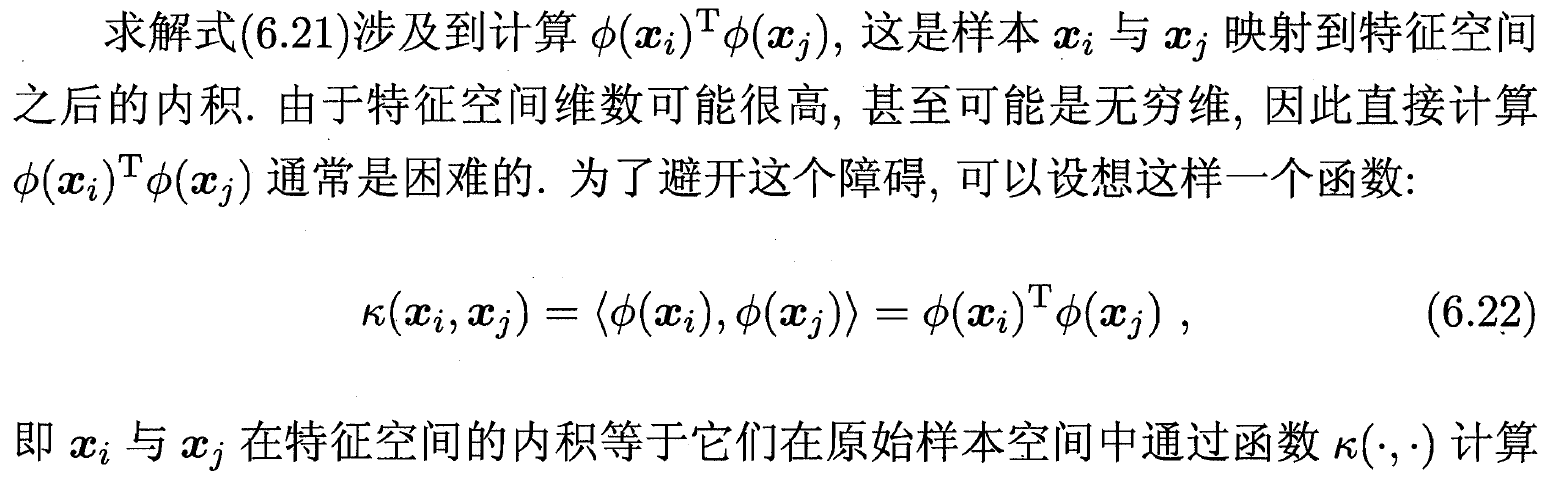

6.3.1 引入核函数的作用

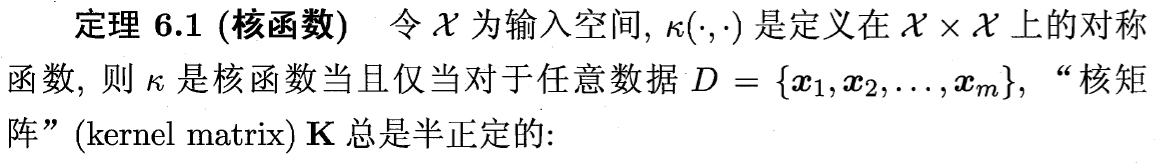

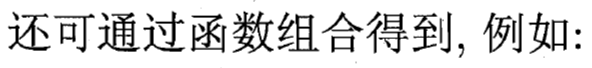

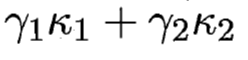

6.3.2 核函数的性质

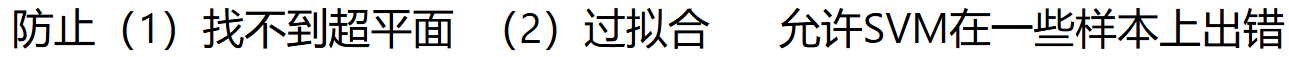

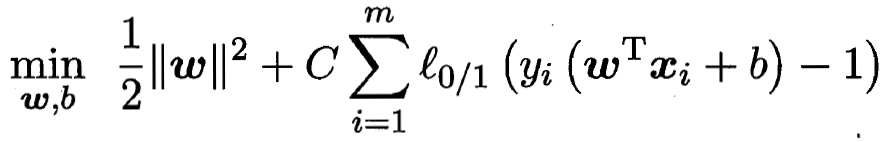

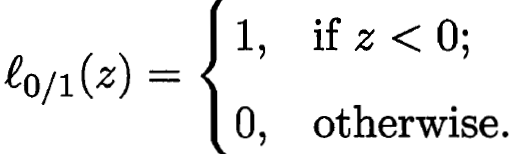

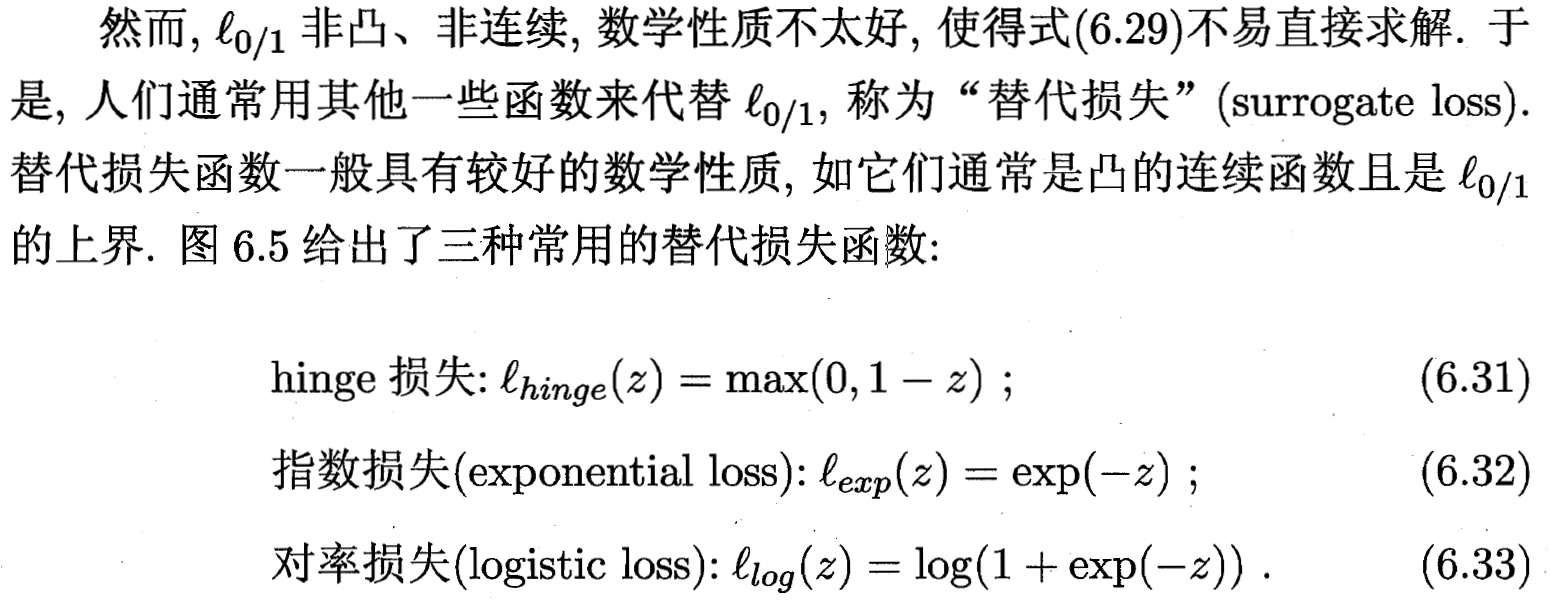

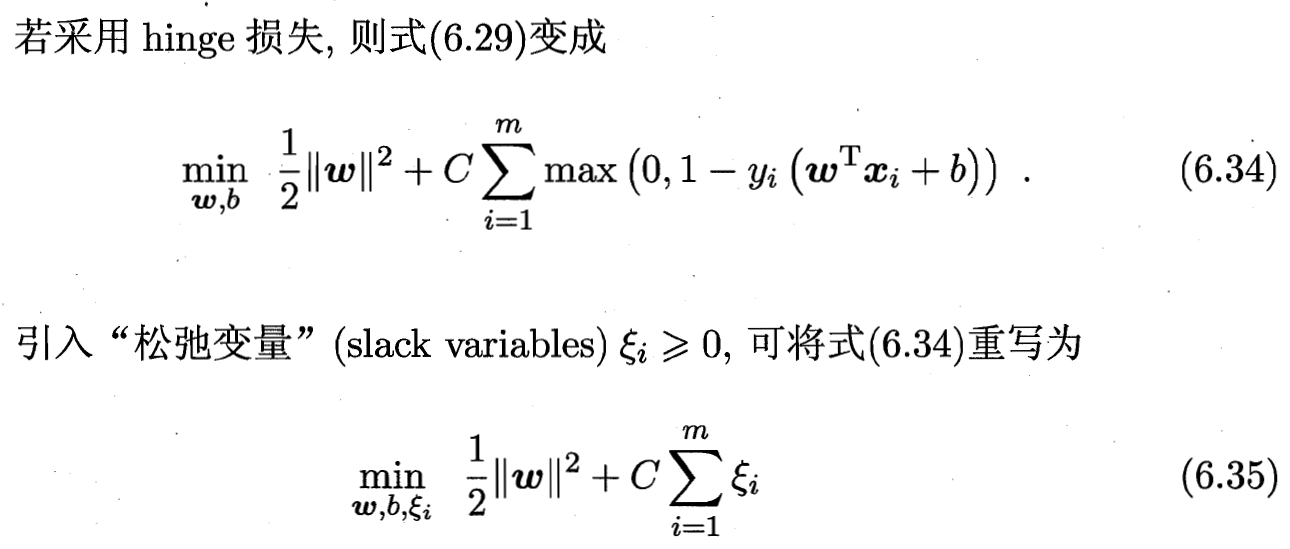

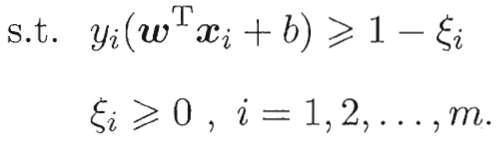

6.4 软间隔与正则化

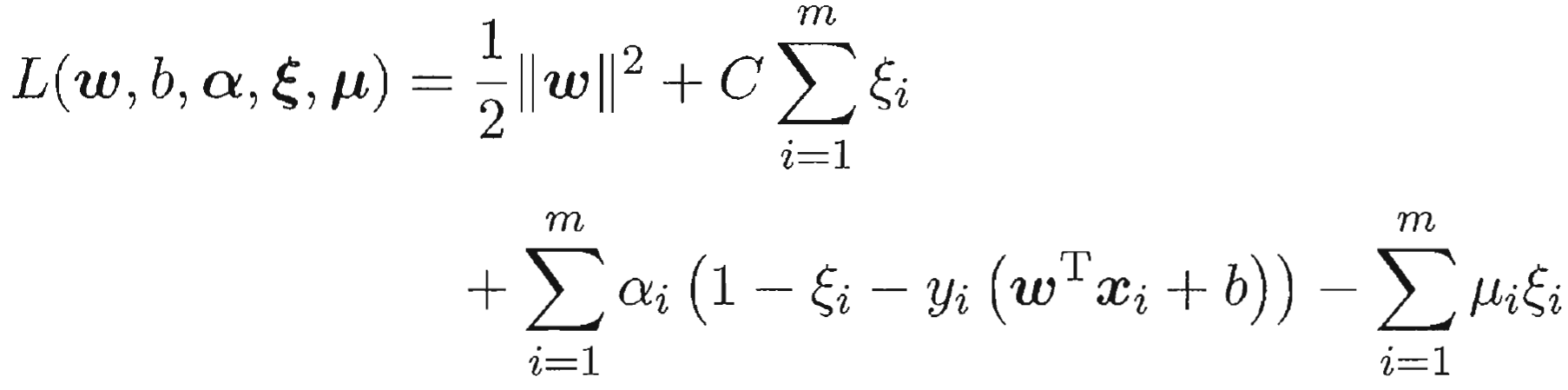

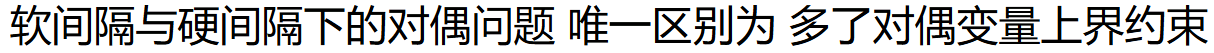

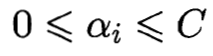

6.4.1 对偶求解&KKT条件分析

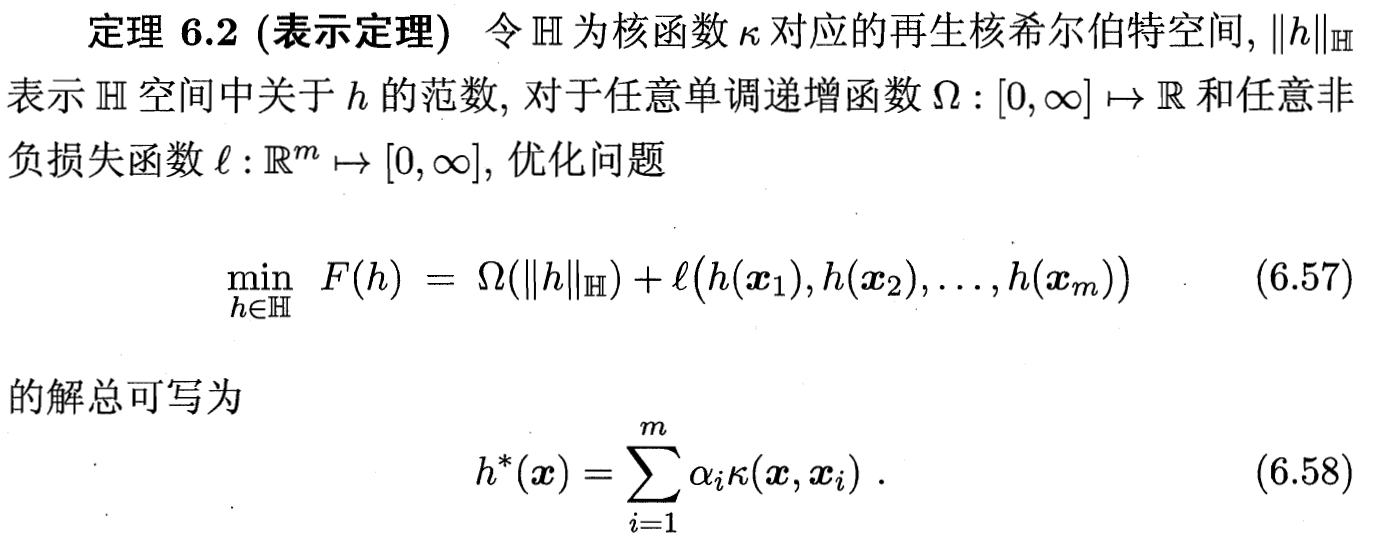

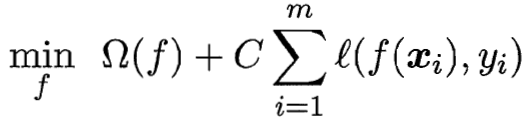

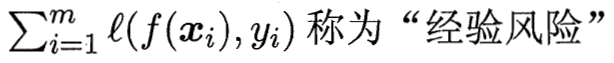

6.4.2 正则化结构分析与推广

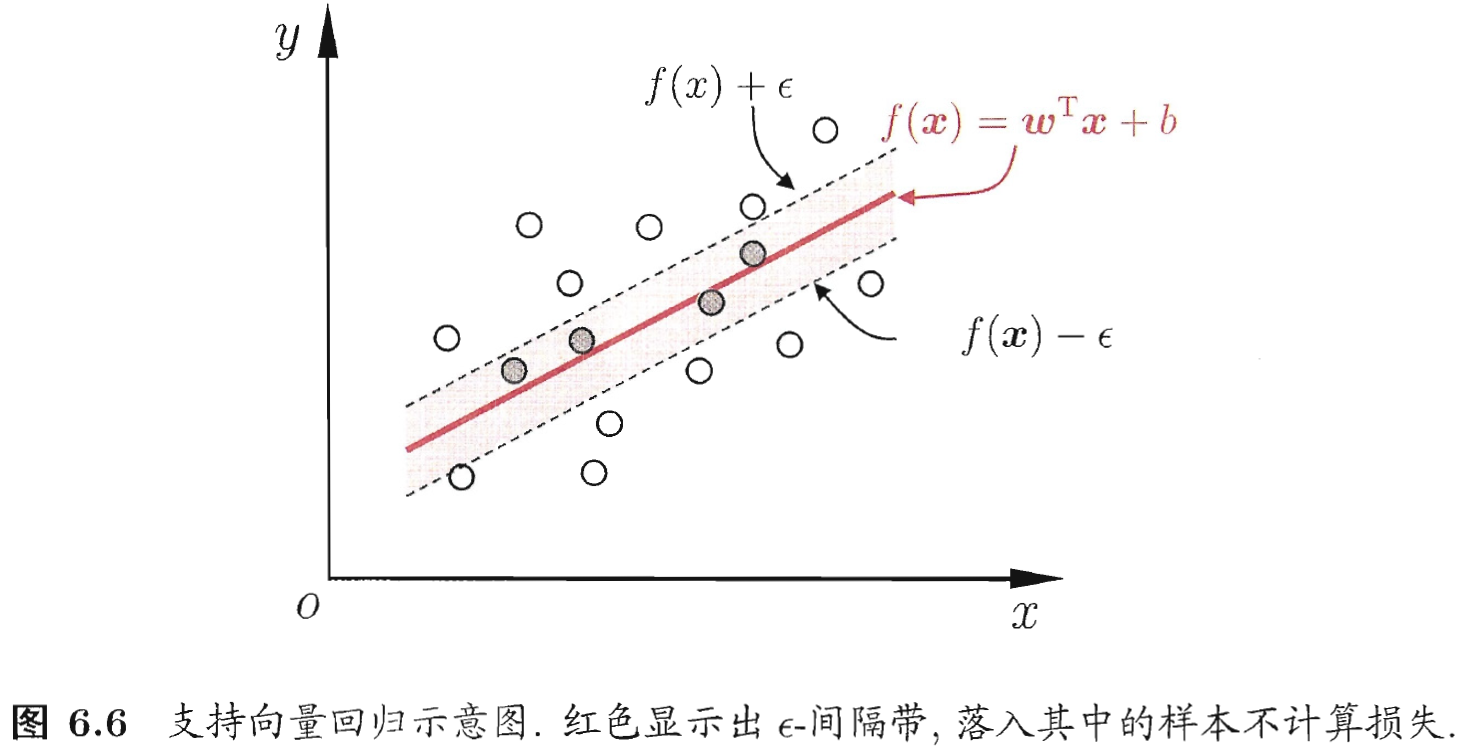

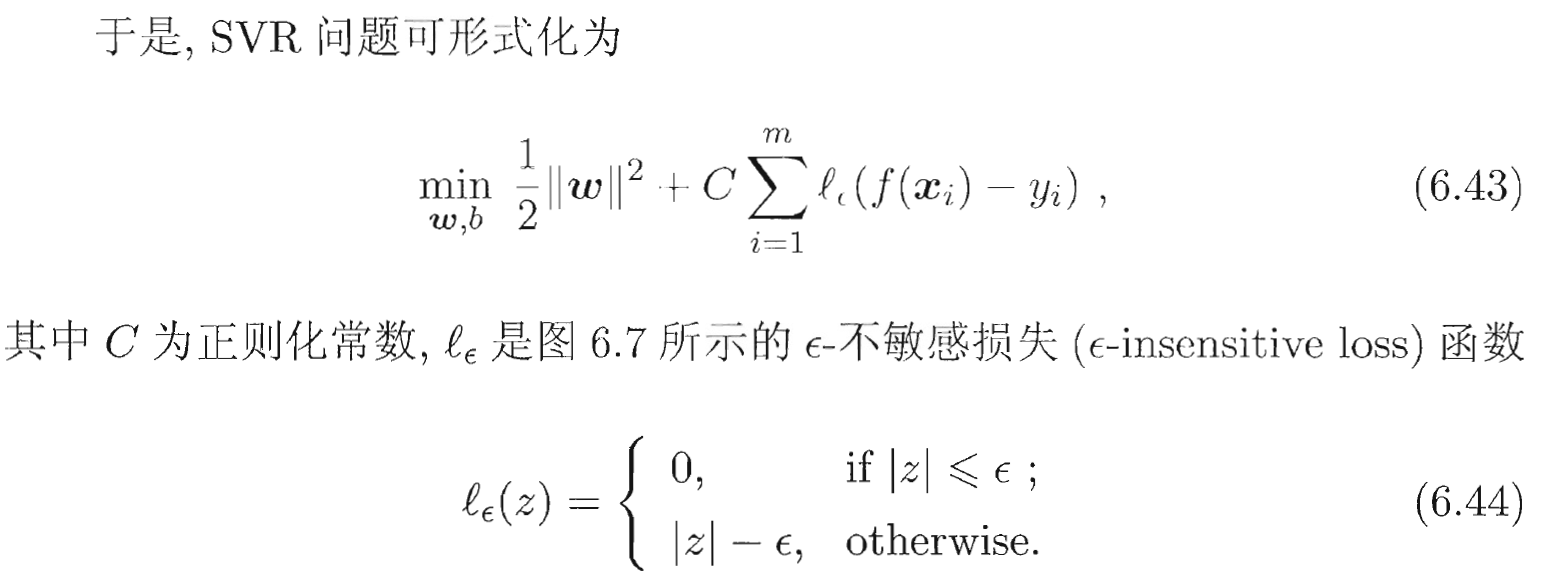

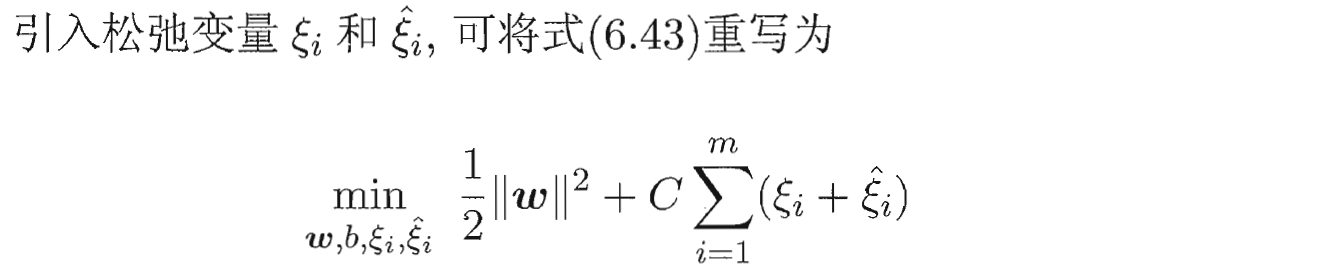

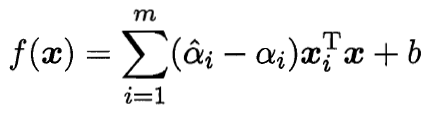

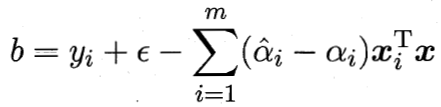

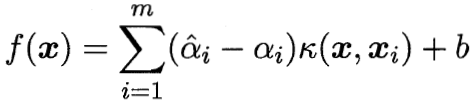

6.5 支持向量回归SVR

SVR的实现可参考这篇

【机器学习】支持向量回归(SVR)从入门到实战:原理、实现与优化指南-CSDN博客

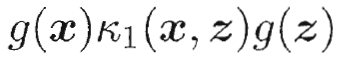

6.6 核方法