Qwen3-Coder: Agentic Coding in the World

Qwen3-Coder:迈向 Agentic 编程新时代

今天,我们正式发布 Qwen3-Coder ------ 迄今为止我们最具"Agentic"(智能代理式)的代码大模型。虽然 Qwen3-Coder 拥有多个不同参数规模的版本,但我们首先推出最强大的变体:Qwen3-Coder-480B-A35B-Instruct 。这是一个 4800 亿参数的专家混合(MoE)模型,其中激活参数为 350 亿。该模型原生支持 256K token 的上下文长度 ,通过 extrapolation(外推方法)可扩展至 100 万 tokens ,在代码生成与智能代理任务上都展现出卓越性能。

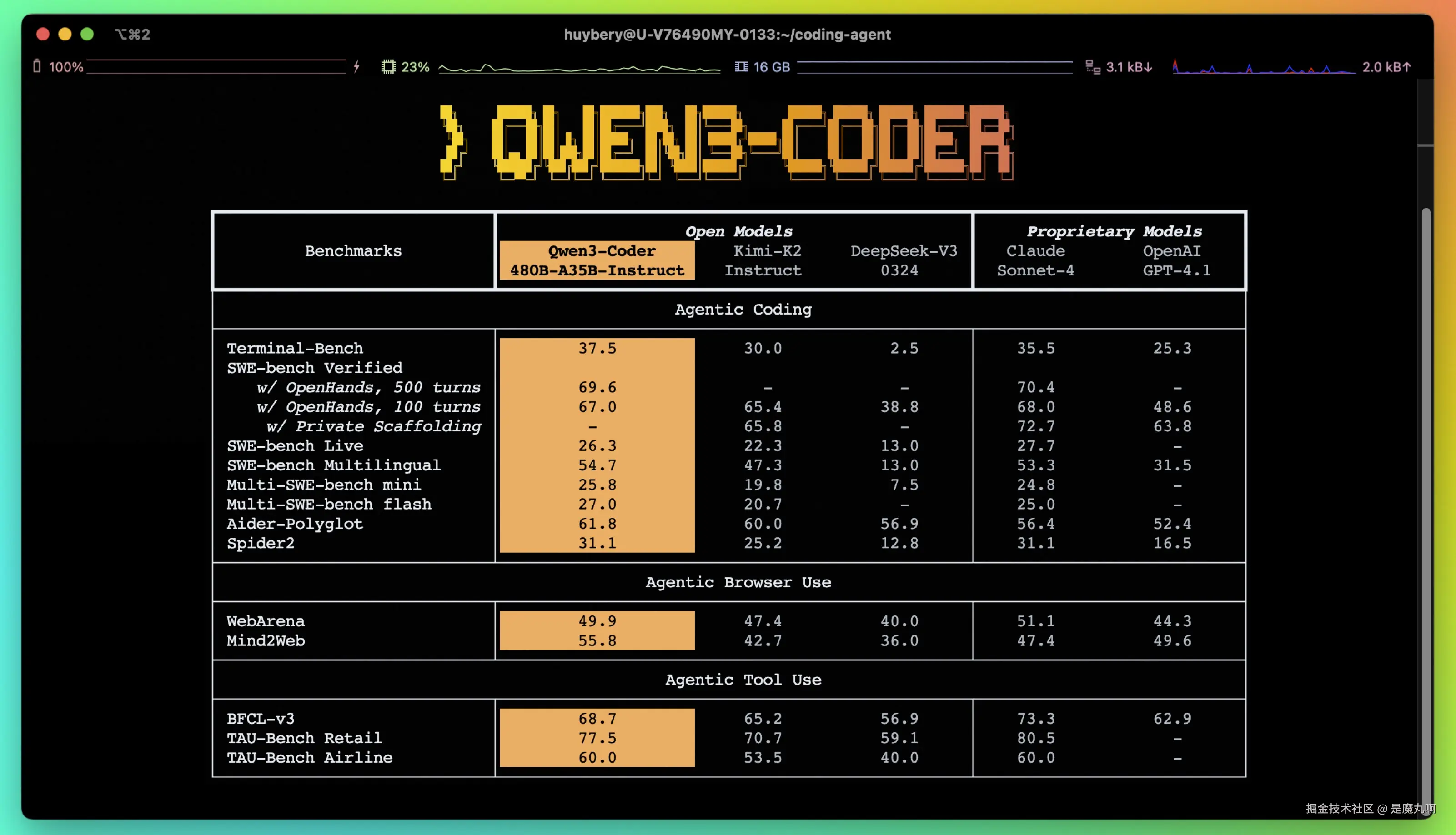

在 Agentic 编程、Agentic 浏览器使用与 Agentic 工具调用等任务中,Qwen3-Coder-480B-A35B-Instruct 在开源模型中达到了新的 SOTA 水平,整体能力可媲美 Claude Sonnet 4。

同步发布:Qwen Code 命令行工具

与此同时,我们也开源了一个用于 Agentic 编程的命令行工具 ------ Qwen Code 。该工具基于 Gemini Code 项目分支而来,经过 prompt 定制与函数调用协议适配,使 Qwen3-Coder 在 Agentic 编程任务中释放全部潜力。Qwen3-Coder 可与社区中最优秀的开发工具无缝协作。作为一个基础模型,我们希望它能"无处不在",真正实现 Agentic Coding in the World。

训练策略

预训练阶段

在预训练方面仍有巨大的潜力可挖,我们从多个维度扩展了 Qwen3-Coder 的能力:

- Token 规模扩展:使用 7.5 万亿 tokens(其中代码数据占比 70%),在强化代码能力的同时保留了通用能力与数学能力。

- 上下文扩展:原生支持 256K 上下文,结合 YaRN 技术可扩展至 1M tokens,适用于大规模代码库与动态数据(如 Pull Request),为 Agentic 编程赋能。

- 合成数据扩展:借助 Qwen2.5-Coder 清洗与重写噪声数据,显著提升整体数据质量。

微调与后训练

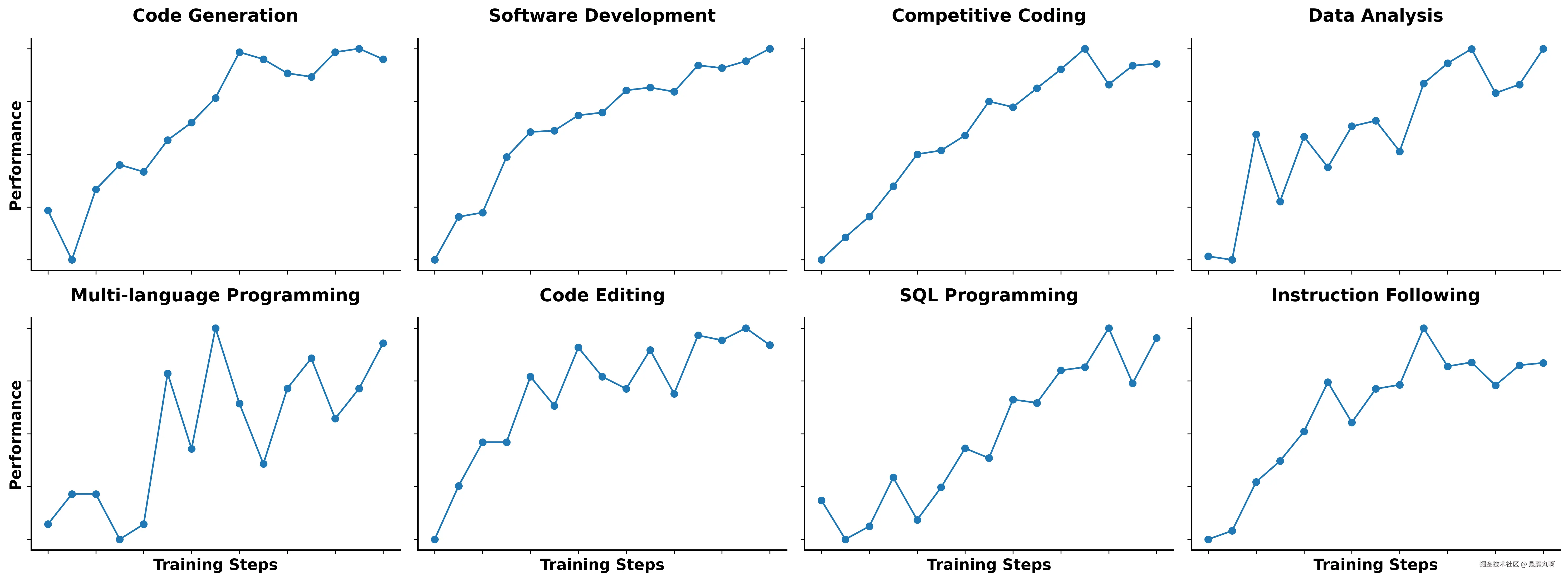

强化学习扩展:代码任务------"难以生成、易于验证"

不同于当前主流社区将精力集中在"竞赛级代码生成",我们认为所有代码任务天生就适合执行驱动的大规模强化学习(Code RL) 。

我们大幅扩展了在真实世界代码任务上的 Code RL 训练,通过自动扩展测试用例来生成高质量训练样本,有效提升了模型的执行成功率,并带动其他任务的性能提升。

这些结果坚定了我们继续探索"难生成、易验证"任务作为 RL 土壤的信心。

长视野强化学习:Agent RL

在如 SWE-Bench 等真实的软件工程任务中,模型需要与环境进行多轮交互:规划、调用工具、接收反馈、做出决策。

为此,我们在后训练阶段引入了 长视野强化学习(Agent RL) ,鼓励模型通过工具多轮交互来完成复杂任务。

Agent RL 的关键挑战是"环境扩展性"。我们基于阿里云搭建了可支持 2万个并发环境 的可扩展系统,为大规模 RL 提供反馈支持与评估能力。

Qwen3-Coder 由此在 SWE-Bench Verified 上取得了开源模型的 SOTA 成绩,且无需在测试阶段进行额外 scaling。

用 Qwen3-Coder 编写代码

Qwen Code 工具

Qwen Code 是为研究目的设计的 CLI 工具,基于 Gemini CLI,增强了解析器与工具支持。

确保你已经安装了 Node.js 20 及以上版本:

arduino

curl -qL https://www.npmjs.com/install.sh | sh安装 Qwen Code:

css

npm i -g @qwen-code/qwen-code也可以从源码安装:

bash

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code && npm install && npm install -gQwen Code 支持通过 OpenAI SDK 调用大模型。你可以配置环境变量,或在 .env 文件中设置:

ini

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"然后,愉快地开始编程吧:

qwen与 Claude Code 联用

除了 Qwen Code,你也可以通过 Claude Code 使用 Qwen3-Coder。只需在阿里云 Model Studio 获取 API Key 并安装 Claude Code:

bash

npm install -g @anthropic-ai/claude-code我们提供两种接入方式:

方式 1:Claude Code 代理 API 配置

bash

export ANTHROPIC_BASE_URL=https://dashscope-intl.aliyuncs.com/api/v2/apps/claude-code-proxy

export ANTHROPIC_AUTH_TOKEN=your-dashscope-apikey即可用 Claude Code 体验 Qwen3-Coder。

方式 2:claude-code-router 自定义后端模型

安装路由器与配置插件:

bash

npm install -g @musistudio/claude-code-router

npm install -g @dashscope-js/claude-code-config然后执行配置命令:

ccr-dashscope这将自动生成配置文件与插件目录。你也可以手动修改位于 ~/.claude-code-router/ 的文件。之后,使用:

css

ccr code即可用 Qwen3-Coder 编码。

与 Cline 联动

若你使用 Cline,可以在配置中:

-

设置 API Provider 为 "OpenAI Compatible"

-

填写 DashScope 提供的 API Key

-

勾选 "Use custom base URL",填写:

arduinohttps://dashscope-intl.aliyuncs.com/compatible-mode/v1 -

模型名称填写

qwen3-coder-plus

API 使用示例

你可以通过阿里云 Model Studio 的 Qwen API 直接使用 Qwen3-Coder:

ini

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

prompt = "Help me create a web page for an online bookstore."

completion = client.chat.completions.create(

model="qwen3-coder-plus",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": prompt}

],

)

print(completion.choices[0].message.content.strip())后续计划

我们仍在持续优化 Qwen Coding Agent,希望它能承担更复杂繁琐的软件工程任务,从而释放人类生产力。

后续还将发布更多参数规模的 Qwen3-Coder 模型,在保证性能的同时降低部署成本。

我们也在积极探索一个激动人心的问题:Coding Agent 能否自我进化?

附:Qwen 3‑Code vs Kimi‑K2 ------ 核心规格与能力全景对比

| 维度 | Qwen 3‑Code (480B‑A35B‑Instruct) | Kimi‑K2 (Instruct) |

|---|---|---|

| 发布日期 | 2025‑07‑22 | 2025‑07‑11 |

| 定位 | 专攻 Agentic Coding(代码补全 + 自动规划 + 工具调用) | 通用 LLM,强化代码与长链式 Agent 能力 |

| 架构 | MoE 480 B 总参,激活 35 B,62 层,GQA‑96/8 | MoE 1 T 总参,激活 32 B,61 层,MLA 注意力 |

| 上下文窗口 | 原生 256 K,可 YaRN 扩展至 1 M tokens | 128 K(部分资料写 130 K) |

| 训练数据 | 7.5 T tokens(70 % 代码) + 大规模 Code RL & Agent RL | 15.5 T tokens;MuOnClip 优化器稳定训练超大 MoE |

| 许可证 | Apache‑2.0 | Modified MIT(大规模商用需署名) |

| 权重获取 | GitHub / HF / ModelScope,FP8 & BF16 | GitHub / HF,Block‑FP8 |

| 官方 API 计费 | DashScope:0‑32 K <math xmlns="http://www.w3.org/1998/Math/MathML"> 1 / M ; 32 ‑ 128 K 1/M;32‑128 K </math>1/M;32‑128 K 1.8/M;输出 $5/9/15/60/M | Moonshot:输入 <math xmlns="http://www.w3.org/1998/Math/MathML"> 1 / M ,输出 1/M,输出 </math>1/M,输出 3/M;OpenRouter $1.5/M |

| 典型硬件需求 | 推理 ≥ 8×A100 80G(BF16);量化后 2×H100 亦可 | 推理 16×H200;4‑bit 量化需 ≥ 1 TB RAM |

| 配套 CLI / 工具 | Qwen Code(Gemini‑CLI fork,npm 包) | 官方脚本 + vLLM / SGLang 部署指引 |

| 生态兼容 | OpenAI/Anthropic 兼容端点;Transformers、vLLM、Ollama、llama.cpp | OpenAI/Anthropic 兼容 API;vLLM、SGLang、TensorRT‑LLM |

评测对比

| 评测集 (指标) | Qwen 3‑Code 480B‑A35B | Kimi‑K2 Instruct |

|---|---|---|

| Terminal‑Bench (Acc) | 37.5 | 30.0 |

| SWE‑bench Verified · OpenHands 500 turns (Pass@1) | 69.6 | 65.4 |

| SWE‑bench Verified · OpenHands 100 turns (Pass@1) | 67.0 | 65.8 |

| SWE‑bench Live (Pass@1) | 26.3 | 22.3 |

| SWE‑bench Multilingual (Pass@1) | 54.7 | 47.3 |

| Multi‑SWE‑bench mini (Pass@1) | 25.8 | 19.8 |

| Multi‑SWE‑bench flash (Pass@1) | 27.0 | 20.7 |

| Aider‑Polyglot (Acc) | 61.8 | 60.0 |

| Spider2 (Acc) | 31.1 | 25.2 |

| WebArena (Score) | 49.9 | 47.4 |

| Mind2Web (Score) | 55.8 | 42.7 |

| BFCL‑v3 (Acc) | 68.7 | 65.2 |

| TAU‑Bench Retail (Acc) | 77.5 | 70.7 |

| TAU‑Bench Airline (Acc) | 60.0 | 53.5 |

性能

| 指标 | Qwen 3‑Code‑480B‑A35B | Kimi‑K2‑Instruct |

|---|---|---|

| 单序列吞吐(Tok/s,4 × A100,FP8) | 60--70 t/s | 49.8 t/s(API 平均) |

| 批量吞吐(batch = 32,总吞吐) | ≈ 1 400 t/s(4 × H100) | ≈ 7.2 t/s(1 × H200,vLLM) |

| 首 token 延迟(TTFT) | ≈ 0.25 s(4 × H100) | ≈ 0.53 s(API) |

| 最低推荐部署配置 | 4 × A100 80 G(FP8,TP4) | 16 × H200(FP8,TP16) |

| 推理显存需求(FP8) | ≈ 30 GB / 卡 | > 140 GB / 卡(H200) |

| 本地低比特量化吞吐(4-bit) | 24 t/s(M3 Ultra) | ~5 t/s(24 GB GPU,1.8-bit) |