OmniGen2 是北京人工智能研究院(BAAI)于 2025 年 6 月 16 日发布的开源多模态生成模型,旨在为多种生成任务提供统一的解决方案,包括文本到图像生成、图像编辑和上下文生成。与 OmniGen v1 不同,OmniGen2 为文本和图像模态设计了两条独立的解码路径,采用了非共享参数和分离的图像分词器。这一设计使得 OmniGen2 能够在现有的多模态理解模型基础上进行构建,而无需重新适应 VAE 输入,从而保留了原有的文本生成能力。其核心创新在于双路径架构和自我反思机制,成为当前开源多模态模型的新标杆。相关论文成果为「OmniGen2: Exploration to Advanced Multimodal Generation」。

使用云平台: OpenBayes

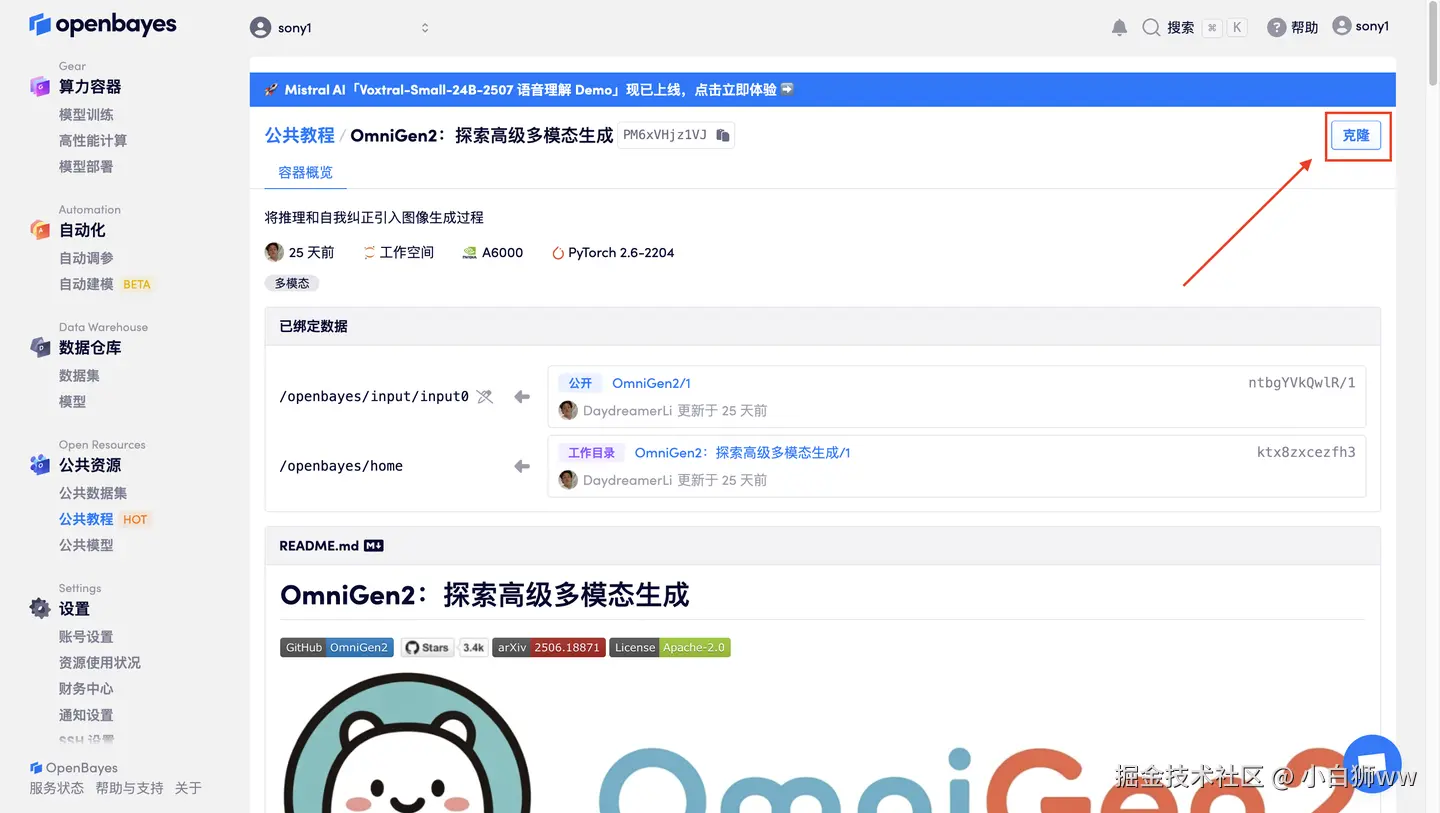

首先点击「公共教程」,在公共教程中找到「OmniGen2:探索高级多模态生成」,单击打开。

页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

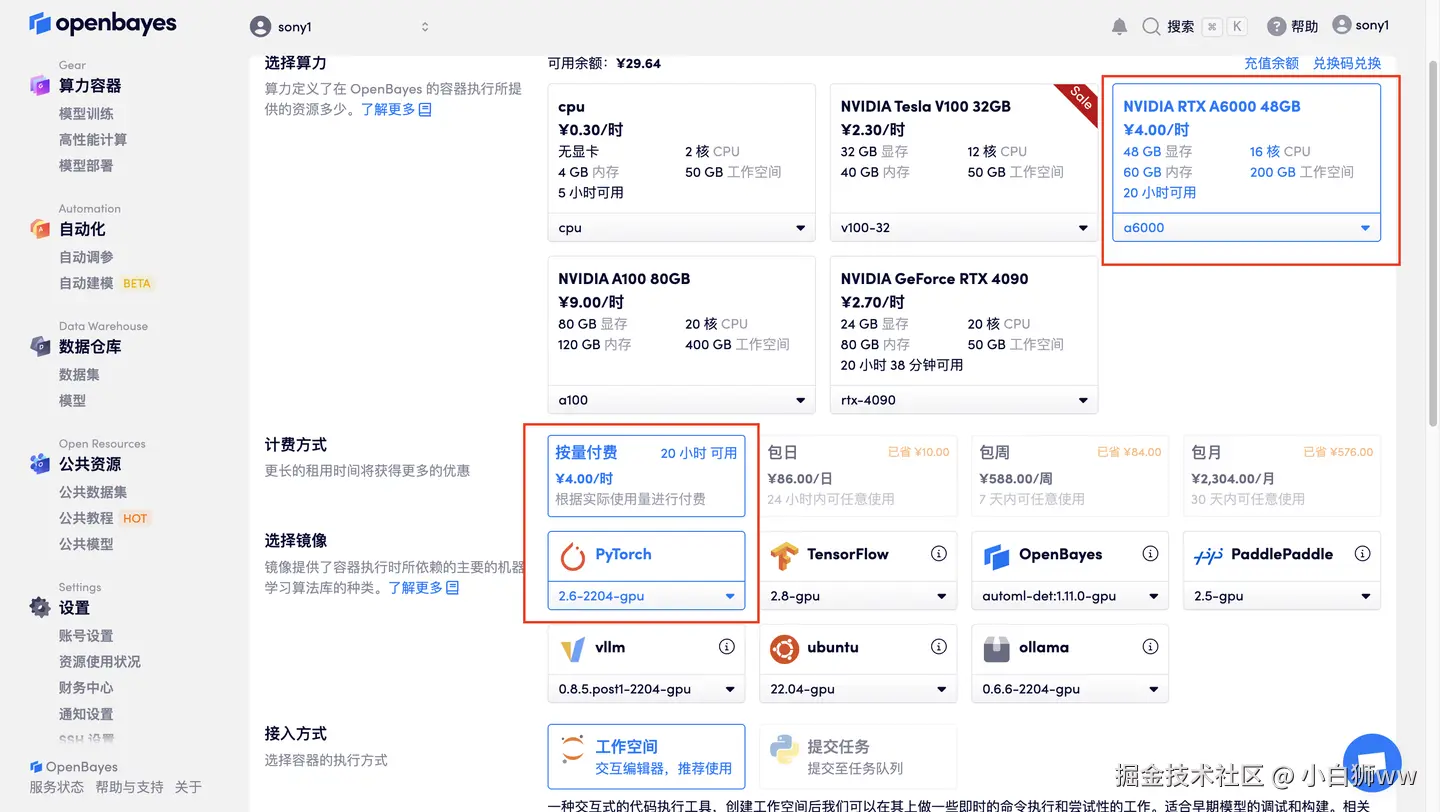

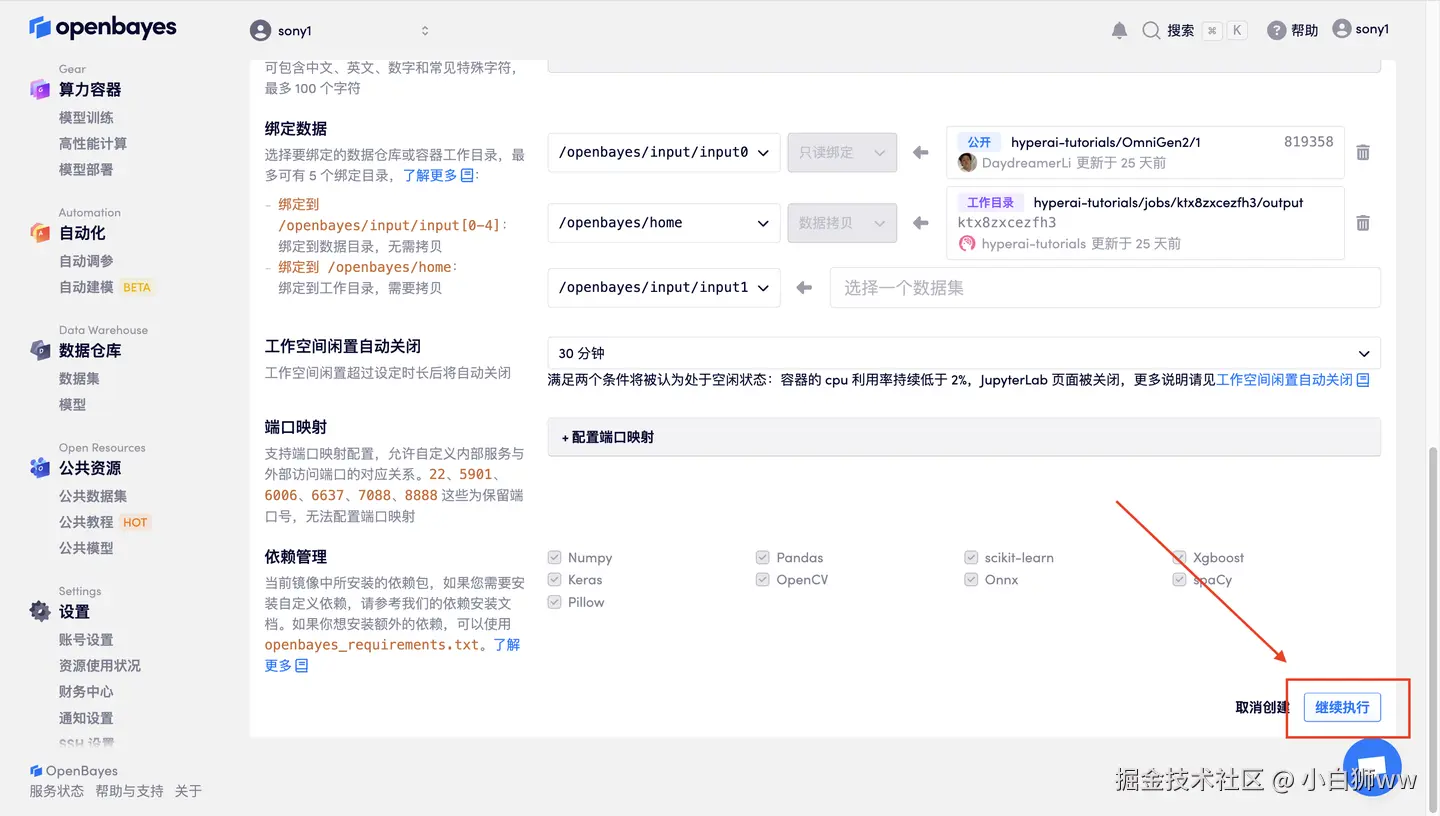

在当前页面中看到的算力资源均可以在平台一键选择使用。平台会默认选配好原教程所使用的算力资源、镜像版本,不需要再进行手动选择。点击「继续执行」,等待分配资源。

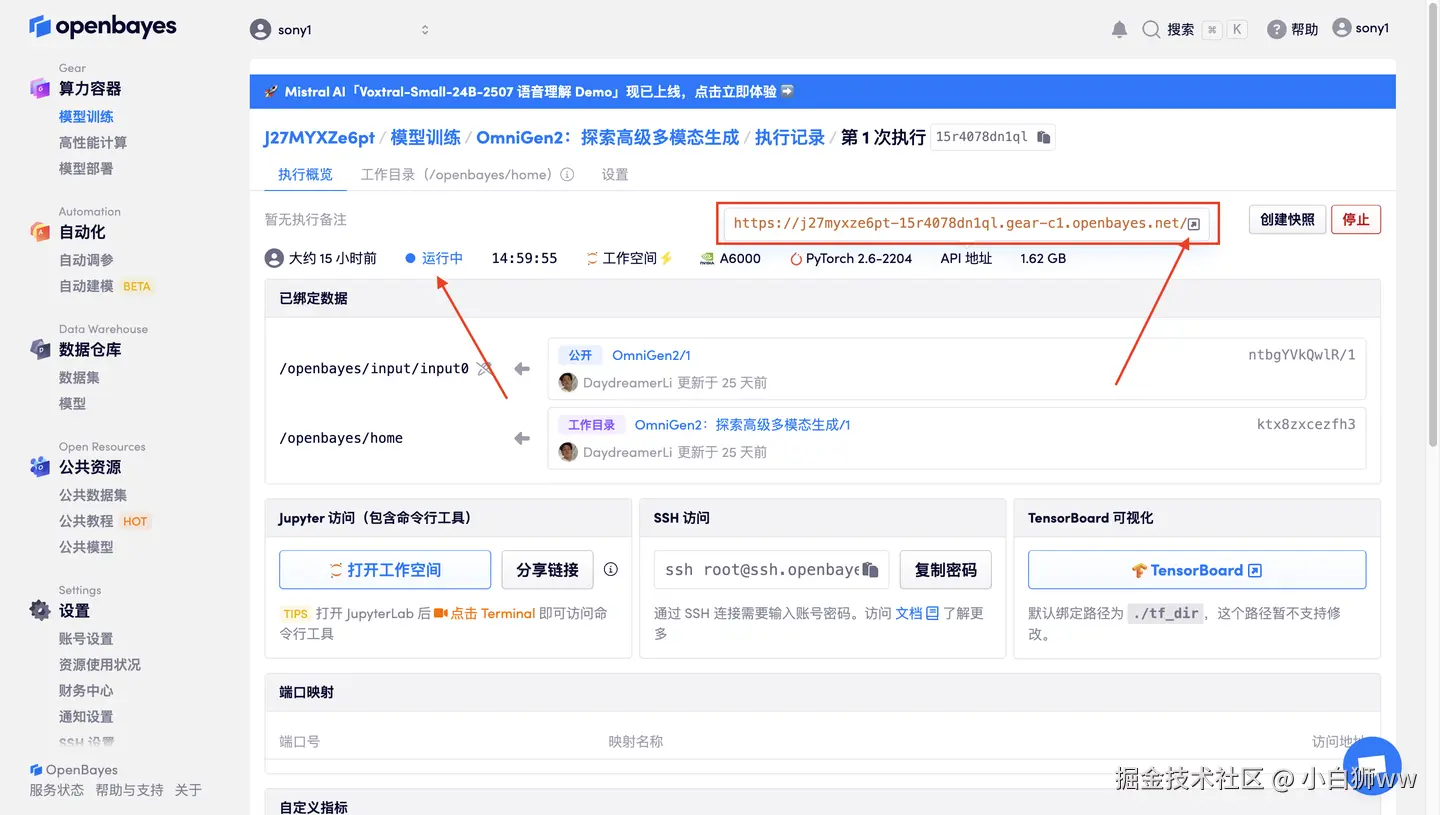

数据和代码都已经同步完成了。容器状态显示为「运行中」后,点击「 API 地址」,即可进入界面。若显示「Bad Gateway」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

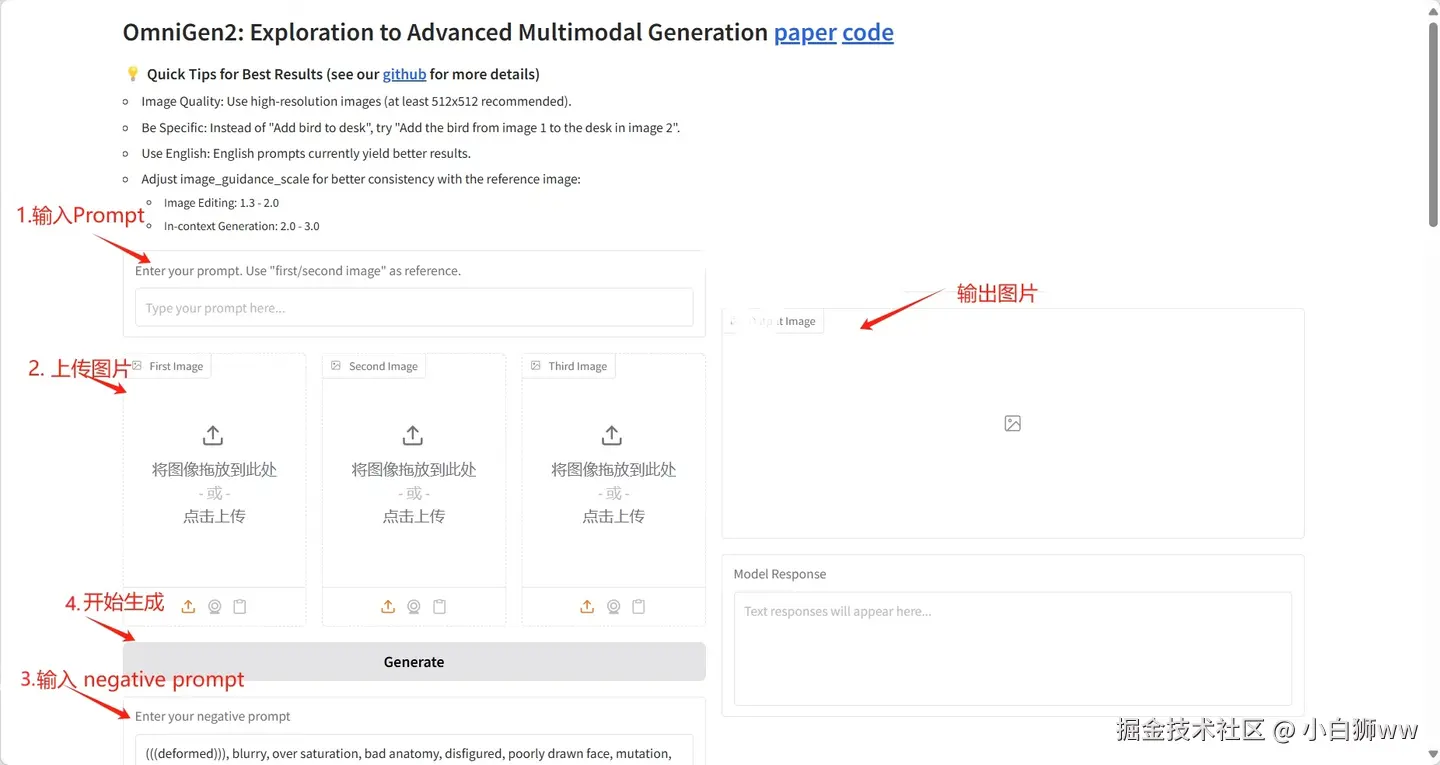

具体参数:

- Height:高度

- Width:宽度

- Text Guidance Scale:文本引导尺度

- Image Guidance Scale:图像引导尺度

- CFG Range Start: 范围起始

- CFG Range End:范围结束

- Scheduler:调度器

- Inference Steps:推理步骤

- Number of images per prompt:每条提示的图像数量

- Seed:种子

- max_input_image_side_length:最大输入图像边长

- max_pixels:最大像素

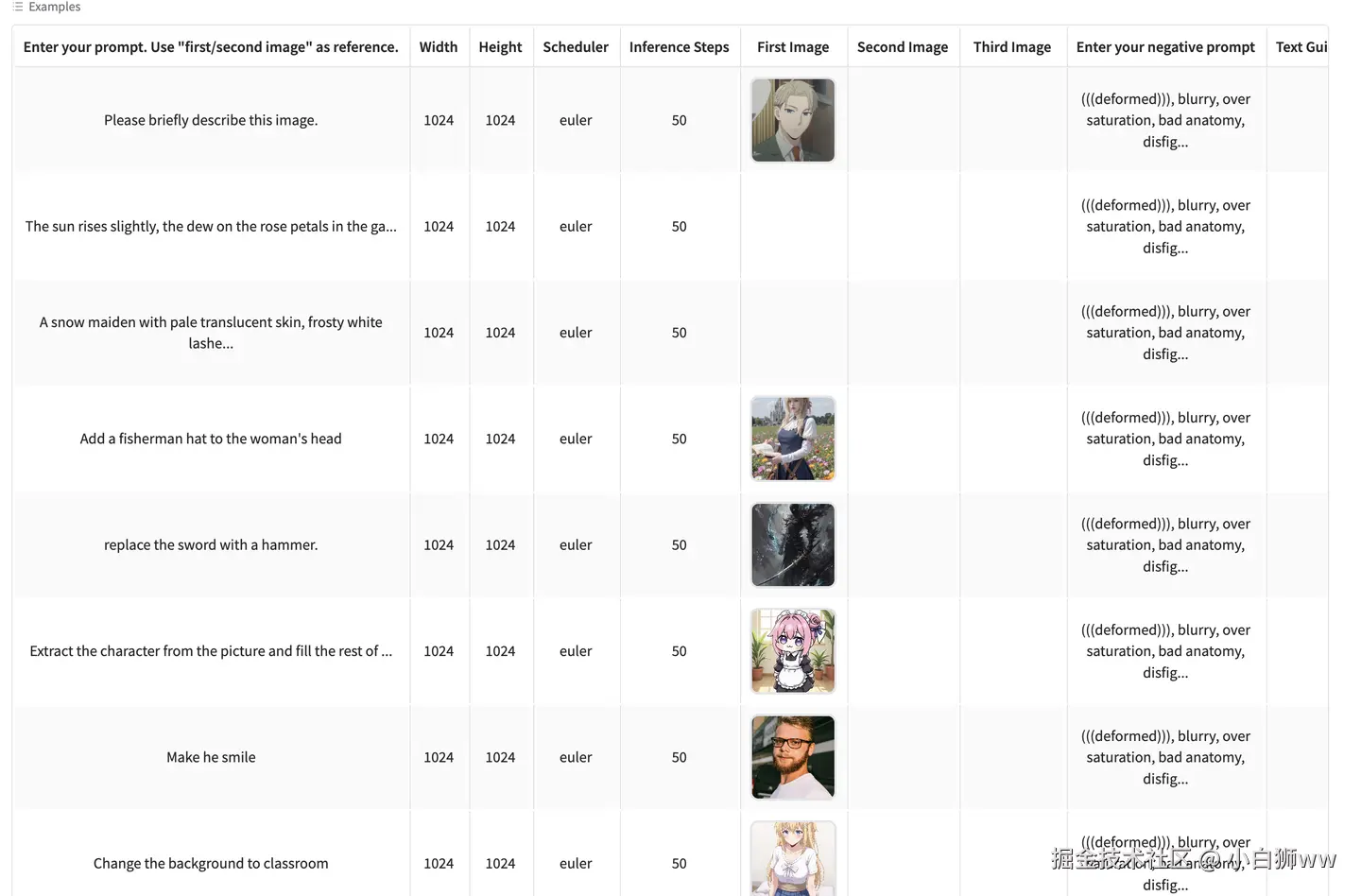

官方在这里给出了很多案例,大家可以自行尝试。

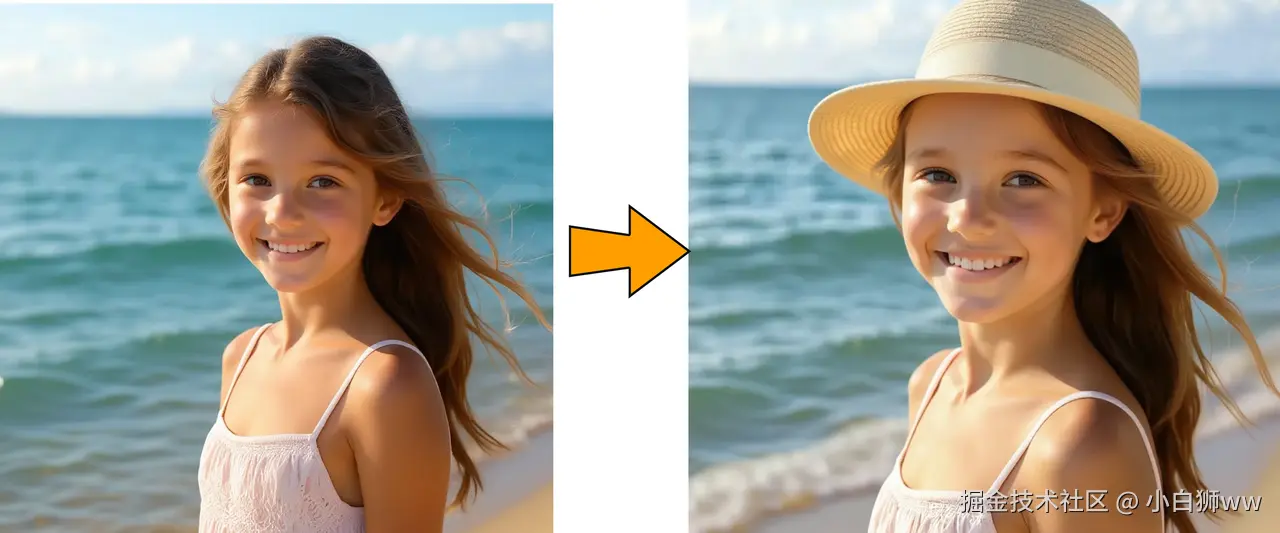

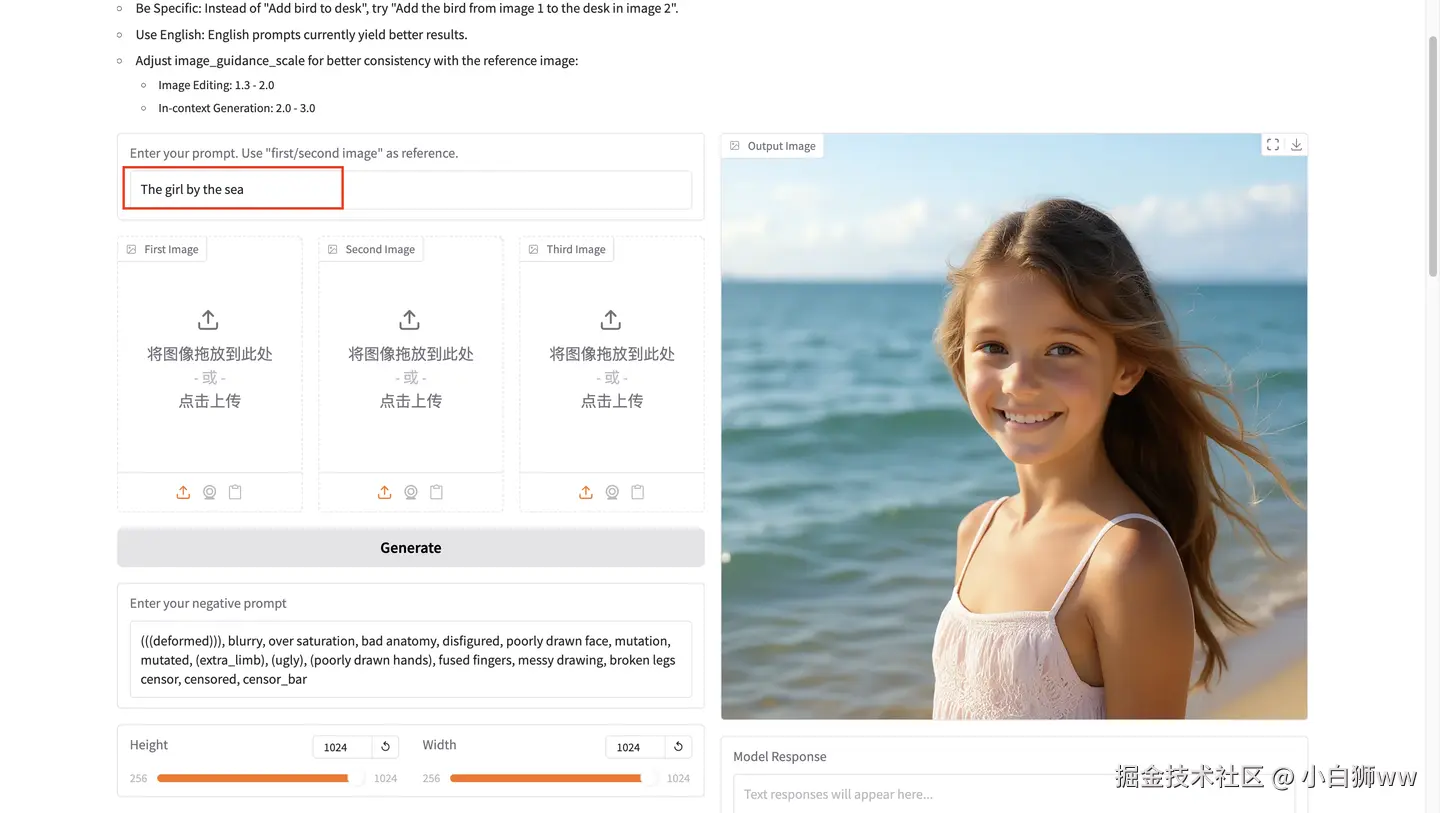

我们首先使用文本生成图片功能,输入 prompt「The girl by the sea」后点击「Generate」,可以看到它快速生成了一张在海边的女孩。

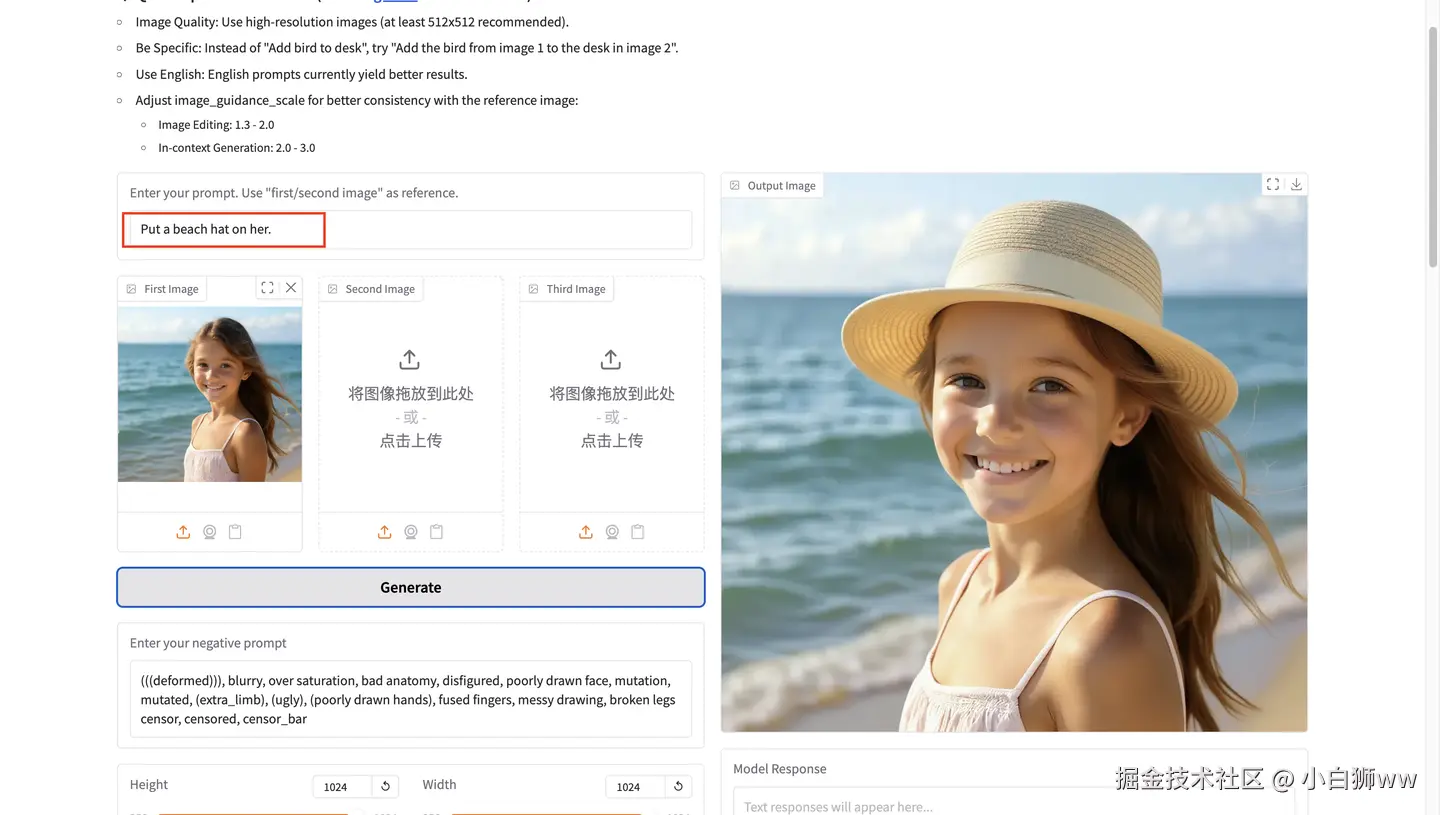

接下来可以保存图片,进行图片编辑,输入 prompt「Put a hat on her.」后点击「Generate」,可以看给女孩戴了一顶帽子。