Claude Code是Anthropic公司在2025年5月正式发布的一款全新AI编码工具,一经问世立刻成为AI Coding的现象级产品。在产品设计上,Claude Code追求极致的灵活性和定制性。它采用了底层、无固定范式(unopinionated)的设计理念,为用户提供近乎原始的模型访问权限,不强制任何特定的工作流程。这种强大的风格让开发者可以根据自己的习惯和需求,灵活定制和自动化各种开发环节。此外,Claude Code还支持自定义命令、结构化工作流,并内置了如CLAUDE.md说明书、MCP服务器扩展等特色功能,极大提升了开发效率。

但Claude Code的显著痛点,就是它目前只能调用Anthropic自家的Claude模型 。即使用户尝试修改base url,试图连接到其他AI模型服务,最终也只能用Claude模型,无法像市面上的很多AI开发工具那样,灵活切换不同厂商的模型。其根本原因在于,Claude的API格式和主流的OpenAI API格式完全不同,不仅参数结构不一样,请求路径也有明显差异。

回顾这几年的AI模型API的"格式大战",OpenAI无疑是目前的最大赢家。如今,几乎95%的AI厂商都选择了OpenAI的API格式作为行业标准,大家都在争做"OpenAI Compatible",方便开发者无缝切换和集成。哪怕像Gemini这样曾经坚持自有格式的巨头,最终也不得不在用户的强烈呼声下,给自己的API加上了OpenAI兼容层。但Anthropic却始终坚持独立路线,Claude的API格式独树一帜,这在Claude Code推出之前,似乎还只是小众开发者圈里的"个性"选择。

然而,Claude Code的出现让这个问题变得更加突出。随着开发者对AI工具的集成需求越来越高,Claude Code的"只支持Claude模型"显得格外局限。尤其是在当前AI生态里,大家都习惯了"一个API打天下"的开发模式,Claude Code的封闭性无疑让部分用户感到不便,甚至有些"与时代脱节"的味道。

接下来,我们具体看看Claude API和OpenAI API在格式上的主要区别,这也是导致Claude Code难以兼容其他模型的技术根源。

I. Claude 格式 Vs OpenAI 格式差异分析

常见的OpenAI请求路径:api.302.ai/v1/chat/completions

常见的Claude请求路径:api.302.ai/v1/messages

常见的OpenAI的请求格式

常见的Claude请求格式

差异分析: 参数结构:虽然两者都使用JSON格式,但Claude在基本请求中明确包含了max_tokens参数,而OpenAI通常将此类参数作为可选项。

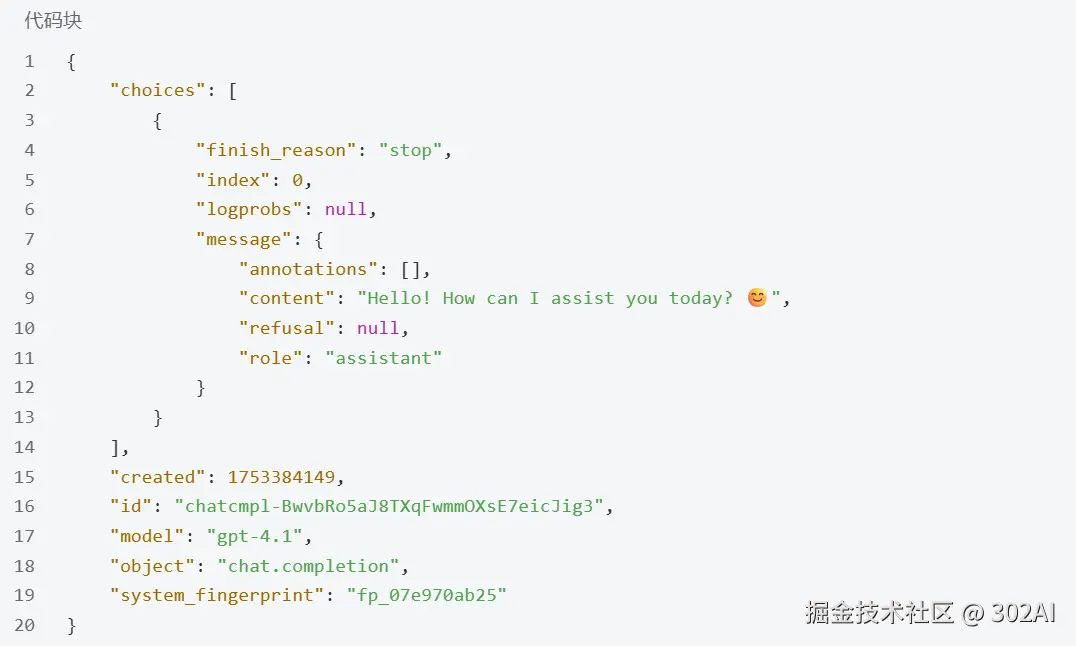

常见的OpenAI的返回格式

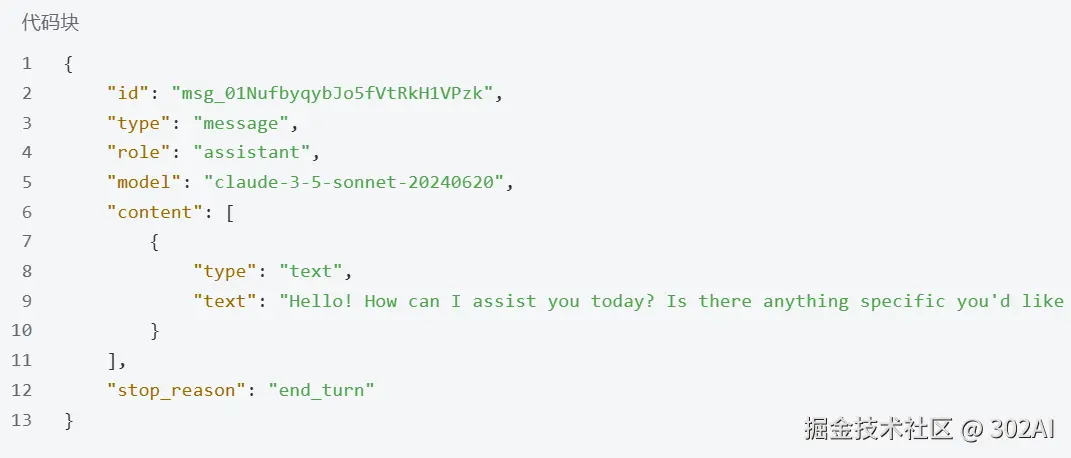

常见的Claude返回格式

响应格式的差异才是核心:

- 结构层次:OpenAI的响应包含一个choices数组,而Claude直接在顶层提供content数组。

- 内容表示:OpenAI将回复内容放在choices[0].message.content中,而Claude则使用content数组,每个元素都有type和text字段。

- 元数据差异:OpenAI返回created、id、model等元数据,Claude也提供类似信息但结构和命名不同。

- 停止原因标识:OpenAI使用finish_reason,Claude则使用stop_reason来表示模型停止生成的原因。

以上只是列举了简单的请求体,对于复杂的功能例如流式相应、函数调用和系统提示词等等,都有很大的不同,所以两家API是完全不兼容。

II. 从 OpenAI Compatible API 到 Claude Compatible API

随着Claude Code的影响力持续提升,越来越多的开发者希望能在Claude Code里调用更多模型,应用层的需求开始"倒逼"模型厂商做出改变。近期,部分模型公司已经不再满足于只做OpenAI Compatible,而是主动推出了Claude Compatible的API格式,专门用来兼容Claude Code。例如,Moonshot的K2模型和最新的Qwen-Coder都已经开始支持Claude的API接口,让开发者可以直接在Claude Code中无缝调用这些新模型。

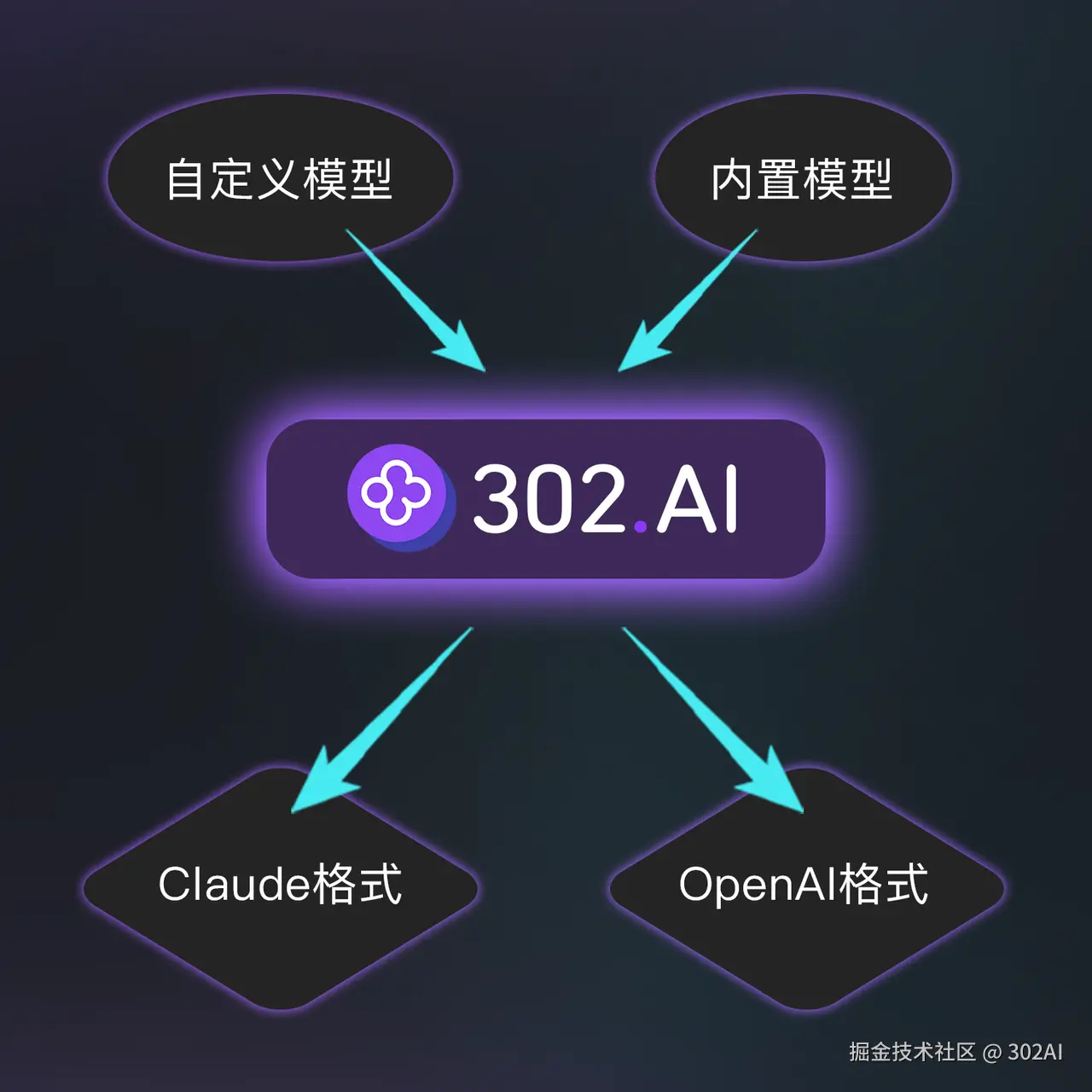

而现在,302.AI已经实现了让任意模型都Claude Compatible!

从技术本质上来看,所谓的"Claude Compatible"与"OpenAI Compatible"之间的区别,主要只是API请求的JSON格式和参数结构的不同,而并不涉及模型本身的内容或能力。因此,理论上完全可以通过一层中转代码,把不同格式的API请求进行自动转换,让同一个模型既能支持OpenAI的调用,也能支持Claude的调用。

对于302.AI这样的模型中转平台来说,承担这种"格式翻译器"的角色是非常合适的 。平台只需在接收到API请求后,根据请求的格式自动进行解析和重组,然后把请求转发给后端实际的模型,再将模型返回的结果转换为前端所需的格式即可。302.AI正是基于这种思路,上线了"任意模型Claude Compatible"功能。现在,所有接入302.AI的模型,无论原生API是OpenAI Compatible还是其他格式,都可以通过Claude Compatible的API方式进行调用。这不仅让Claude Code等只支持Claude格式的应用瞬间拥有了海量的模型选择,也让开发者在不同AI工具之间切换和集成变得前所未有的简单和高效。这一技术创新,极大推动了AI生态的开放与互联,为企业和个人用户带来了更多选择和便利。

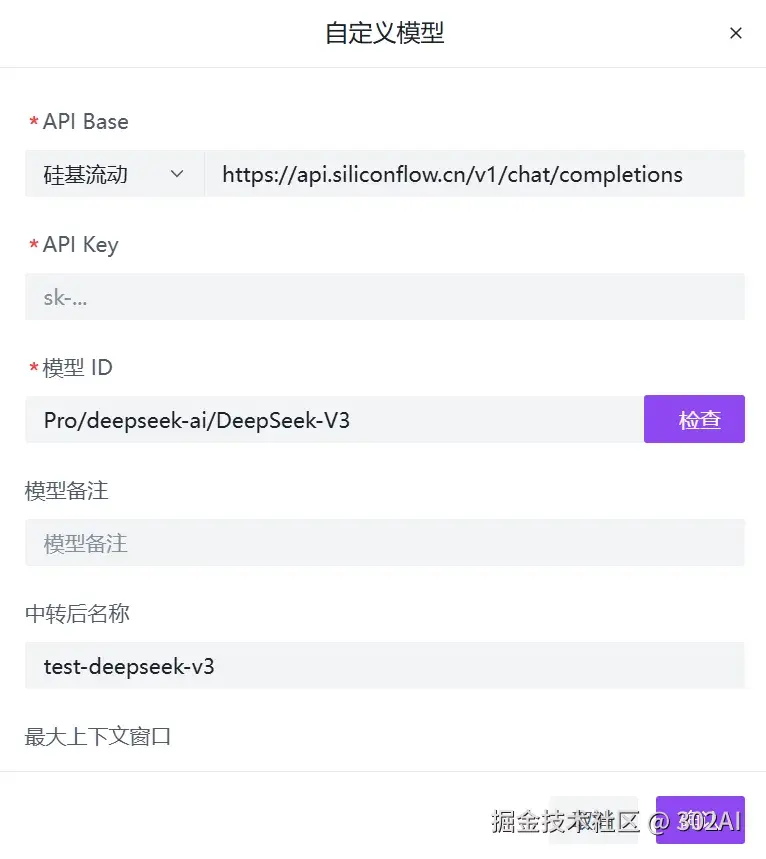

302.AI的这一创新功能不仅覆盖了平台自身售卖的全部模型,更进一步支持了"自定义模型"能力。用户可以利用自定义API功能,将任何第三方模型------无论其底层API格式如何------轻松接入302.AI平台。302.AI会作为中转层,自动完成API协议的解析和格式转换,将这些模型统一封装为Claude Compatible格式进行调用。

III. 如何在 Claude Code 上使用 302.AI 的内置模型

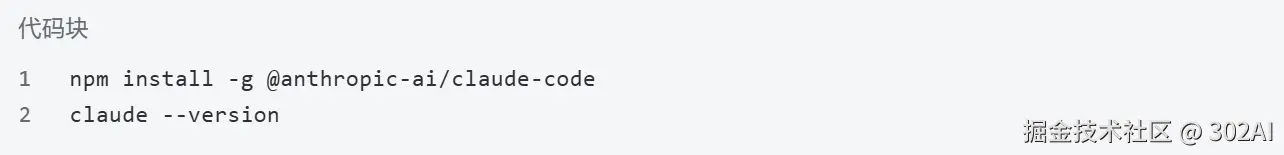

1.安装 Claude Code

2.创建 settings.json 配置文件

Windows环境:创建 settings.json 配置文件

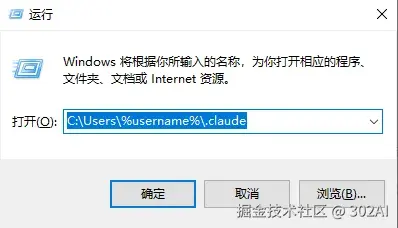

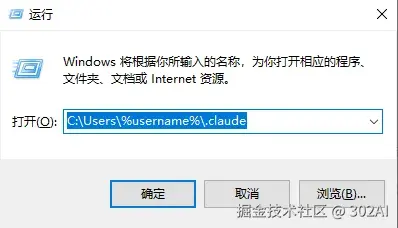

需要进入到当前用户的 .claude 目录下, 可以通过 cmd 进入 C:\Users%username%.claude

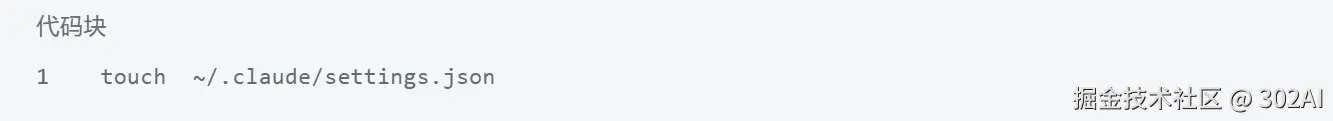

Linux/Mac环境:创建 settings.json 配置文件 (这里可以直接使用 vi 命令)

3.配置 settings.json 文件

Windows环境:使用文本编辑器打开文件可以使用 vscode/记事本 编辑

Linux/Mac环境:编辑 settings.json 配置文件

编辑以下内容:

ANTHROPIC_AUTH_TOKEN 填写在后台获取以sk-开头的APIKEY;

ANTHROPIC_MODEL 填写需要使用的模型名称。目前我们支持了所有模型使用claude格式进行调用。例如需要调用gemini-2.5-pro,只需将上上面的kimi-k2-0711-preview替换为gemini-2.5-pro即可。

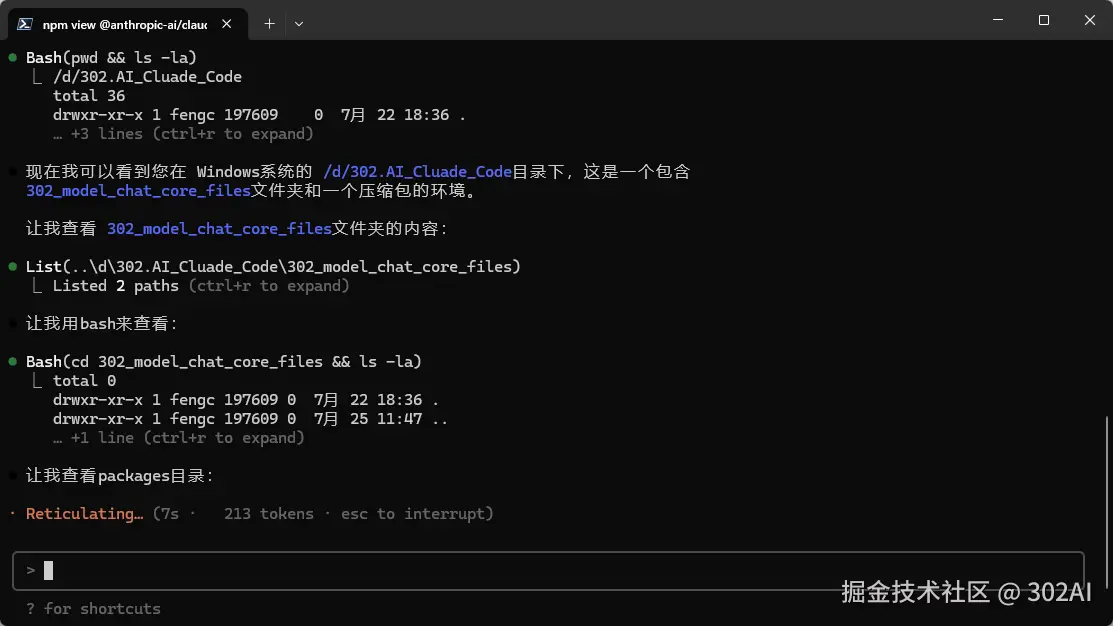

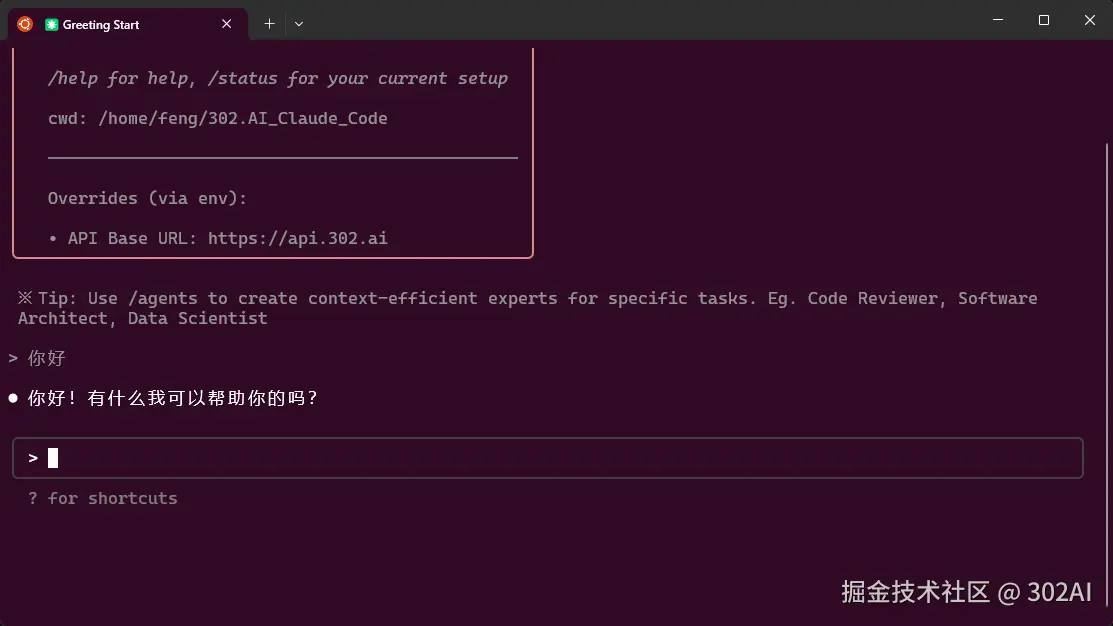

完成上述操作后,切换到您的项目文件启动claude即可使用。

IV. 如何在Claude Code上使用自定义模型

*使用自定义模型需要创建一个支持自定义模型中转的APIKEY,(需要一定的服务器成本)

1.进入302.AI后台,在左侧边栏打开自定义模型板块

2.添加自定义模型,以硅基流动为例

3.创建API KEY,打开自定义模型中转功能

4.创建 settings.json 配置文件

Windows环境:创建 settings.json 配置文件

需要进入到当前用户的 .claude 目录下, 可以通过 cmd 进入 C:\Users%username%.claude

Linux/Mac环境:创建 settings.json 配置文件 (这里可以直接使用 vi 命令)

5.配置 settings.json 文件

Windows环境:使用文本编辑器打开文件可以使用 vscode/记事本 编辑

Linux/Mac环境:编辑 settings.json 配置文件

编辑以下内容,填写之前获取到API KEY

完成上述操作后,切换到您的项目文件启动claude即可使用。

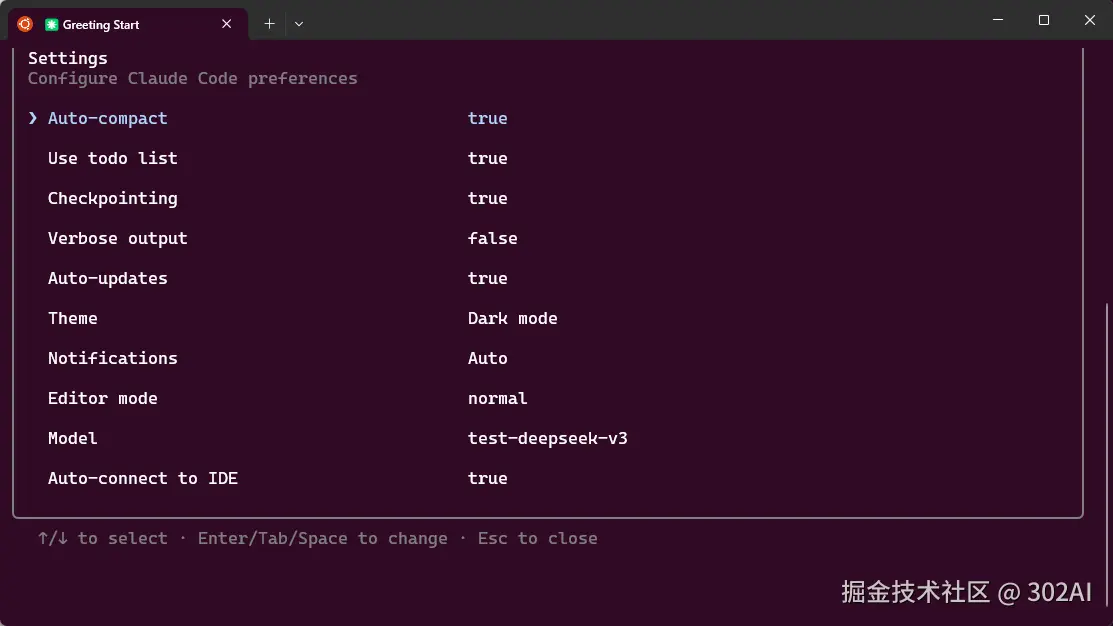

通过·/config也可以看到现在使用的模型为中转模型test-deepseek-v3