当今计算机科学领域,尤其是数据科学、人工智能和深度学习的蓬勃发展,出现了众多工具与框架,用以简化开发过程、提升效率、促进算法的实现。理解这些工具的本质及相互关系,是深入掌握现代机器学习技术的前提。其中,**conda、anaconda、pip、torch、pytorch、tensorflow**在科学计算和机器学习生态中分别扮演怎样的角色?彼此之间有何联系与区别?在实际项目和研发流程中,如何合理选择并有效利用?

1. 软件包管理器与环境管理器:conda与pip的功能与区别

1.1 软件包管理器的定义与作用

软件包管理器是程序开发和运维中的基础工具,负责安装、升级、配置以及卸载计算机程序包(软件库或模块),确保依赖关系的协调和版本兼容性。它使得用户无需手动管理庞杂的依赖项,提高了开发效率和系统稳定性。具体到Python生态,常用的软件包管理器主要有pip和conda。

1.2 pip的起源及功能

pip是Python官方推荐的包管理器,最初目的是简化Python包的安装流程。它基于PyPI(Python Package Index)作为中央仓库,允许用户通过简单的命令安装、更新、卸载Python包。pip适用于纯Python库的管理,或者只涉及Python语言的包。

pip的优势在于轻量、快速,且与Python本身紧密集成,但它仅限于Python环境,无法管理非Python的依赖库(如C++编写的动态链接库、系统级工具等)。这在涉及复杂依赖或者跨语言集成时,成为了其局限。

1.3 conda的出现与功能拓展

conda起源于Anaconda公司开发的开源跨平台包管理与环境管理工具。它不仅管理Python包,更支持管理非Python软件包及其依赖库。通过创建隔离的环境,conda保证不同项目的库版本和运行环境互不干扰,避免因依赖冲突导致的问题。

此外,conda具备跨平台兼容性,支持Windows、Linux和macOS系统,适合多语言项目,特别是在数据科学与机器学习领域,对系统库和GPU驱动等硬件依赖也能有效管理。

1.4 pip与conda的区别与协同

两者功能上有交叉,均可安装Python包,但原理和覆盖范围不同:

-

包来源与生态 :

pip依赖PyPI;conda使用自己的仓库(如Anaconda仓库、Conda-Forge),包多样且含二进制组件。 -

环境管理 :

conda内置环境管理;pip仅管理包,不管理环境,需借助venv等工具。 -

非Python依赖 :

conda可安装C/C++库、编译器等;pip不行。 -

兼容性处理 :

conda更善于解决复杂依赖冲突。

在实践中,常见方案是以conda创建环境,利用其管理系统级依赖,再用pip安装某些conda仓库无覆盖的包。

2. Anaconda:集成的科学计算发行版

2.1 Anaconda的定义与构成

Anaconda 是一个基于 conda 的开源 Python 和 R 数据科学发行版。其核心目标是为数据分析、统计建模、机器学习研究以及科学计算领域的用户提供一个"一站式"的开发环境。Anaconda 集成了众多主流且高性能的科学计算库和工具,包含了:

-

Python 解释器:作为主要编程语言,支持丰富的数据处理与算法实现。

-

conda 包管理器和环境管理器:用于管理软件包依赖关系及构建隔离运行环境,保障不同项目的环境独立性与兼容性。

-

超过1500个预编译的库和工具:涵盖诸如NumPy、Pandas、SciPy、Matplotlib、scikit-learn等数据处理与分析库,还有TensorFlow、PyTorch等深度学习框架。这些库都经过二进制编译,用户无需手动编译,极大地简化了安装过程。

-

跨平台支持:Anaconda 可运行于 Windows、Linux、macOS 等主流操作系统,保证科研人员和开发者在不同平台间高效迁移。

Anaconda 的设计理念在于避免用户在面对复杂依赖关系时进行繁琐的手动配置。其通过集成众多科学计算工具,极大降低了环境搭建的门槛,提升了使用体验。例如,安装一个包含完整数据分析环境的Anaconda,用户只需下载单个安装包,无需逐个安装Python库或其依赖,显著节约时间。

此外,Anaconda 内置了丰富的图形界面工具(如 Anaconda Navigator),使得即便不熟悉命令行操作的用户,也能方便地管理环境和软件包。基于此,Anaconda 已成为数据科学和机器学习领域内最广泛使用的发行版之一。

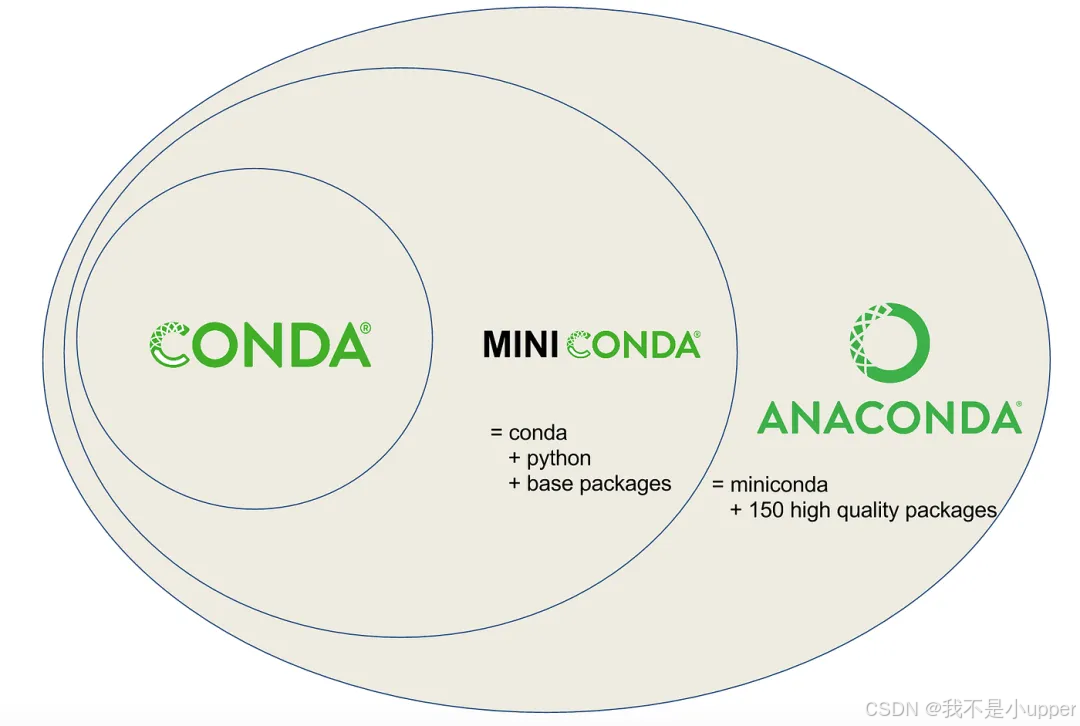

2.2 与 Miniconda 的区别

Miniconda 是 Anaconda 的一个精简版本,只包含 Python 解释器和 conda 包管理器本身,不预装其他科学计算库。用户通过 Miniconda 可以根据具体需求,自行选择并安装所需的库和工具。

二者的主要区别包括:

-

安装包体积:Anaconda 全量安装包通常超过 3GB,而 Miniconda 仅几十兆,适合空间有限或只需部分库的用户。

-

包预装数量:Anaconda 预装了大量常用库,适合快速搭建完整的科学计算环境;Miniconda 提供极简基础,适合对环境大小和灵活性有较高要求的用户。

-

灵活性:Miniconda 允许用户定制个性化环境,更适合高级用户和生产环境,避免了不必要的包冗余。

-

更新速度:由于体积小,Miniconda 的基础环境更新更快,用户也能更及时安装最新版本的库。

选择 Anaconda 还是 Miniconda,取决于用户对环境完整性、定制化和资源限制的权衡。对初学者和快速试验而言,Anaconda 更加便捷;对专业用户或生产环境,Miniconda 提供更高的灵活度和精细控制。

2.3 Anaconda生态的拓展价值

Anaconda 生态不仅限于基础科学计算库的集成,更包含多样的辅助工具,如:

-

Jupyter Notebook:交互式计算环境,支持代码、文本、图像及可视化的融合,是数据科学分析和教学的核心工具。

-

Spyder IDE:一个专为科学计算设计的集成开发环境,带有强大的调试和代码编辑功能。

-

R语言及其包管理支持:为统计建模和可视化提供多语言支持,满足跨领域需求。

-

Anaconda Cloud:在线存储和共享环境配置及包管理,促进团队协作。

这种生态系统的构建,使科研人员能够专注于算法设计、数据分析和实验,不必为环境配置分心。极大降低了入门门槛,推动数据科学和深度学习技术在学术研究与工业应用中的普及和发展。

Anaconda 还鼓励社区贡献,定期更新和优化预装包版本,保障兼容性与性能,同时扩展对新兴技术的支持。这种持续的生态演进,确保用户能够及时利用最先进的工具链,适应快速变化的科研需求。

3. 深度学习框架:Torch、PyTorch、TensorFlow的技术背景与功能定位

3.1 深度学习框架的发展脉络

深度学习框架承担着连接硬件计算资源与算法模型的桥梁作用。它们提供张量操作、自动微分、神经网络构建模块、训练优化算法以及硬件加速支持,极大简化了神经网络的设计与实现。随着深度学习理论和应用的飞速发展,框架从最初的实验性工具逐步发展为成熟的工业级平台。

这一过程经历了从手工编码反向传播算法,到图计算和自动微分的普及,再到支持分布式训练、多硬件加速、跨平台部署的全面进化。框架的成熟提升了研究效率和模型复杂度,使得复杂网络结构和大规模数据集的处理成为可能。

3.2 Torch的起源与设计理念

Torch 最早由 Facebook AI Research(FAIR)实验室于2002年推出,是基于 Lua 语言的科学计算库。它聚焦于高性能的张量计算和灵活的神经网络模块。Torch 以动态计算图和模块化设计著称,强调易用性和速度。

其技术核心包括:

-

高效的张量运算:提供多维数组的高性能操作,底层调用 C/C++ 和 CUDA 实现。

-

动态计算图:支持运行时构建和修改计算图,便于调试和灵活模型设计。

-

模块化神经网络组件:提供预定义的层、激活函数和优化算法,降低复杂模型构建难度。

尽管 Torch 的设计思想前瞻,但因 Lua 语言生态较小,用户群有限,影响了其广泛传播和应用。Torch 对深度学习框架发展贡献了动态图思想和模块化设计,为后续 PyTorch 的诞生奠定了基础。

3.3 PyTorch的兴起与技术特点

2016年,Facebook 发布 PyTorch,将 Torch 的优势迁移至 Python 语言生态。Python 在数据科学领域的广泛应用为 PyTorch 带来了庞大用户基础和丰富的第三方库资源。

PyTorch 的核心技术特点包括:

-

动态图(Eager Execution)机制:模型定义和执行即时发生,代码逻辑顺序执行,便于调试和动态网络设计。

-

强大的自动微分系统(Autograd):通过记录张量操作历史,自动计算梯度,简化训练过程。

-

模块化神经网络库(torch.nn):封装各种层、损失函数和优化算法,支持快速搭建复杂模型。

-

GPU加速与分布式训练支持:通过 CUDA 和 NCCL 等底层库,实现高效并行计算。

-

丰富的生态系统:包含 torchvision、torchaudio、torchtext 等扩展库,支持计算机视觉、语音和自然语言处理。

动态图设计使 PyTorch 在模型开发和调试过程中极具优势,能够快速迭代和试验创新算法。用户无需预定义完整计算图,即可执行条件分支、循环等复杂控制流程,极大拓展模型设计自由度。

这对于学术研究尤为重要,加快了实验速度和模型验证效率。工业界也逐渐采用 PyTorch,尤其是在需要灵活模型结构调整的场景中。

PyTorch的动态图机制如何推动了深度学习模型从理论到实验再到应用的转化速度?这种即时执行对研究创新意味着什么?

3.4 TensorFlow的技术体系与应用场景

Google Brain 团队于2015年发布 TensorFlow,旨在构建一款灵活且高效的机器学习计算框架。TensorFlow 采用数据流图模型,将计算操作抽象为图节点,数据流通过边连接,执行时可针对图整体进行优化。

主要技术特征:

-

静态计算图(Graph Mode):在执行前先构建完整计算图,允许图优化(如操作融合、内存复用),提高执行效率和资源利用。

-

动态图(Eager Execution)支持:2018年后引入,兼顾灵活性和易用性,适合调试和研究。

-

跨平台部署:支持 CPU、GPU、TPU,支持移动端(TensorFlow Lite)、Web 端(TensorFlow.js)和服务器端部署。

-

分布式训练框架:支持多节点、多GPU协同训练,满足大规模数据和模型训练需求。

-

丰富的生态系统和工具链:包括 TensorBoard(可视化)、TensorFlow Serving(模型部署)、TensorFlow Hub(模型共享)、TFX(生产流水线)等。

TensorFlow 设计兼顾了研究和生产的双重需求,支持从小规模实验到大规模工业应用的全流程。其静态图优化在生产环境中显著提升了模型推理效率,减少延迟,降低资源消耗。

为什么 TensorFlow 的静态图在某些部署场景中优于动态图?其图优化机制如何转化为实际性能优势?

4. 软件包管理与深度学习框架的结合使用

4.1 安装与环境配置的挑战

深度学习框架依赖复杂的计算库(如CUDA、cuDNN、MKL),其版本不兼容常导致安装失败或性能损失。conda通过管理环境隔离和依赖协调,极大简化了配置过程。

例如,安装带GPU支持的PyTorch时,必须匹配正确版本的CUDA Toolkit。conda提供预编译的二进制包,减少用户手动配置难度。

4.2 pip与conda在框架安装中的配合策略

虽然conda能安装许多框架和依赖,但部分最新版本或实验版本常通过pip发布。合理结合使用可获得最佳灵活性。

用户往往先用conda创建环境、安装基础依赖,再用pip安装特定版本框架。此时,需注意版本兼容与环境完整性,避免冲突。

4.3 如何通过Anaconda快速构建深度学习环境?

Anaconda为用户预配置了科学计算所需库,结合conda的环境管理,可以一键安装并切换不同的框架版本,极大提升工作效率。利用Anaconda Navigator图形界面,非专业用户也能快速完成环境搭建。

5. 深度学习框架内部结构及运算原理比较

5.1 张量计算的本质

无论PyTorch还是TensorFlow,核心均是张量(多维数组)的高效计算。张量计算涵盖了线性代数运算、广播机制、内存布局优化和硬件加速接口。

两者均支持GPU计算,通过调用底层库(如cuBLAS、cuDNN)提升速度。

5.2 自动微分机制的差异

自动微分(Autograd)是深度学习框架的基石。PyTorch采用动态图机制,执行时即时构建计算图,方便调试。TensorFlow传统静态图先构建计算图,后执行,这带来优化空间。

动态图设计更灵活,适合研究;静态图适合部署优化。

5.3 计算图的优化与执行

TensorFlow的静态图便于图优化,如操作融合、常量折叠、内存复用等,从而提升推理效率和节省资源。PyTorch近年来引入JIT编译(TorchScript)支持静态图执行,增强性能。

两者针对不同应用场景均提供优化手段,反映了框架设计哲学的差异。

6. 工具选择的策略与实践指导

6.1 如何选择合适的软件包管理器?

如果项目仅涉及Python包,且依赖较简单,pip即可满足。若涉及跨语言依赖、高性能库,或需管理多环境,conda更为合适。需要注意环境隔离,避免包冲突。

6.2 如何在不同框架间做选择?

PyTorch以灵活性和易用性著称,适合快速实验和学术研究。TensorFlow功能全面,适合大规模工业应用和分布式训练。选择依据包括项目需求、团队技术栈、部署平台。

6.3 安全性与性能考虑

环境管理必须关注包的安全性,避免来源不明软件包。更新策略应兼顾稳定性和性能提升。合理选择底层依赖库版本,提升GPU计算效率。

7. 总结

本文从软件包管理器conda与pip的功能差异出发,解析了Anaconda作为集成科学计算平台的定位,继而深入探讨了深度学习领域的关键框架:Torch、PyTorch及TensorFlow的技术特点与应用场景。两种软件包管理方案如何结合,如何安装、配置复杂的深度学习环境成为讨论重点。通过对框架内部计算原理、自动微分机制及图计算优化的剖析,展现了当代深度学习工具链的核心技术基础。最后结合实践选择策略与未来趋势展望,提供了全面的认知体系,助力科研与工业应用的高效推进。