目录

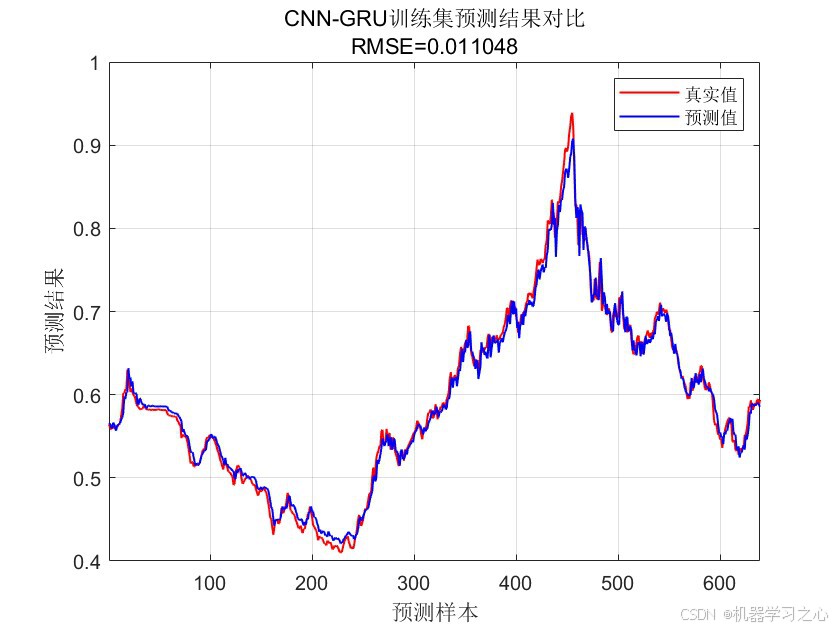

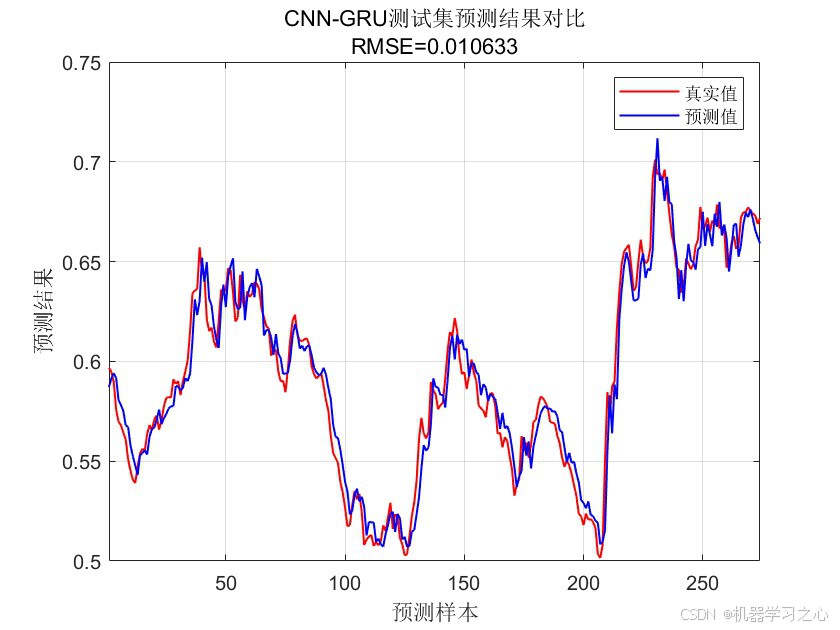

预测效果

CNN-GRU卷积神经网络结合门控循环单元是一种结合了卷积神经网络(CNN)和门控循环单元(GRU)的深度学习模型,广泛应用于时间序列预测:

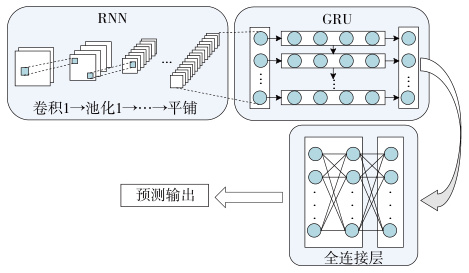

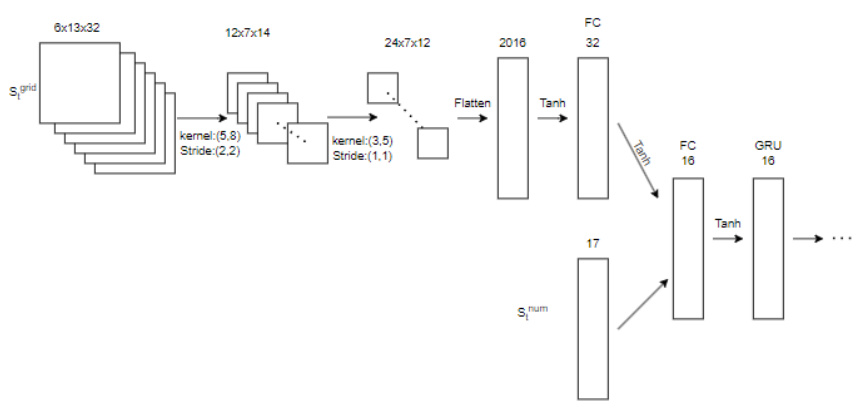

1. CNN-GRU的基本原理

CNN-GRU模型结合了CNN和GRU的优势,分别负责不同的任务:

- CNN(卷积神经网络) :主要用于提取输入数据的局部特征。CNN通过卷积层和池化层提取图像、信号或时间序列数据的局部特征,具有强大的特征提取能力。

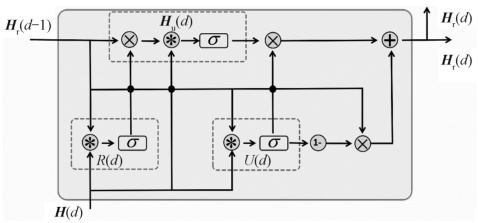

- GRU(门控循环单元) :用于处理序列数据,解决传统RNN中的梯度消失和梯度爆炸问题。GRU通过更新门和重置门控制信息流,能够有效捕捉序列数据中的长期依赖关系。

2. 应用场景

CNN-GRU模型在多个领域有广泛应用,包括交通预测、风电功率预测、股价预测等。

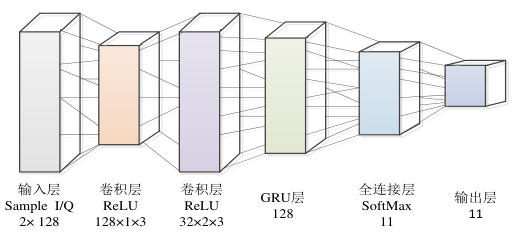

3. 模型结构与实现

CNN-GRU模型通常包括以下结构:

- 输入层:接收原始数据(如时间序列等)。

- 卷积层:提取局部特征。

- 池化层:降低特征维度,保留重要信息。

- GRU层:处理序列数据,捕捉长期依赖关系。

- 全连接层:输出最终结果。

4. 优势与挑战

- 优势:CNN-GRU结合了CNN的局部特征提取能力和GRU的序列处理能力,能够有效处理复杂数据,提高预测精度和模型性能。

- 挑战:模型训练复杂,需要大量数据和计算资源,且对超参数敏感。

5. 相关研究与实现

多个研究和论文详细探讨了CNN-GRU模型的实现和应用,例如:

- Matlab实现:多个研究使用Matlab实现CNN-GRU模型,用于时间序列预测。

6. 未来发展方向

- 融合注意力机制:结合注意力机制(Attention)可以进一步提升模型性能。

- 轻量化模型 :优化模型结构,减少计算资源消耗,适用于边缘设备和实时应用。

结论

CNN-GRU是一种强大的深度学习模型,结合了CNN和GRU的优,具有良好的扩展性和应用潜力。随着技术的不断发展,CNN-GRU模型将在更多领域发挥重要作用。

代码设计

matlab

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

%% 导入数据(时间序列的单列数据)

data = xlsread('数据集.xlsx');

[h1,l1]=data_process(data,24); %步长为24,采用前24个时刻的温度预测第25个时刻的温度

res = [h1,l1];

num_samples = size(res,1); %样本个数

% 训练集和测试集划分

outdim = 1; % 最后一列为输出

num_size = 0.7; % 训练集占数据集比例

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

%% 数据平铺

for i = 1:size(P_train,2)

trainD{i,:} = (reshape(p_train(:,i),size(p_train,1),1,1));

end

for i = 1:size(p_test,2)

testD{i,:} = (reshape(p_test(:,i),size(p_test,1),1,1));

end

targetD = t_train;

targetD_test = t_test;

numFeatures = size(p_train,1);