I. 引言

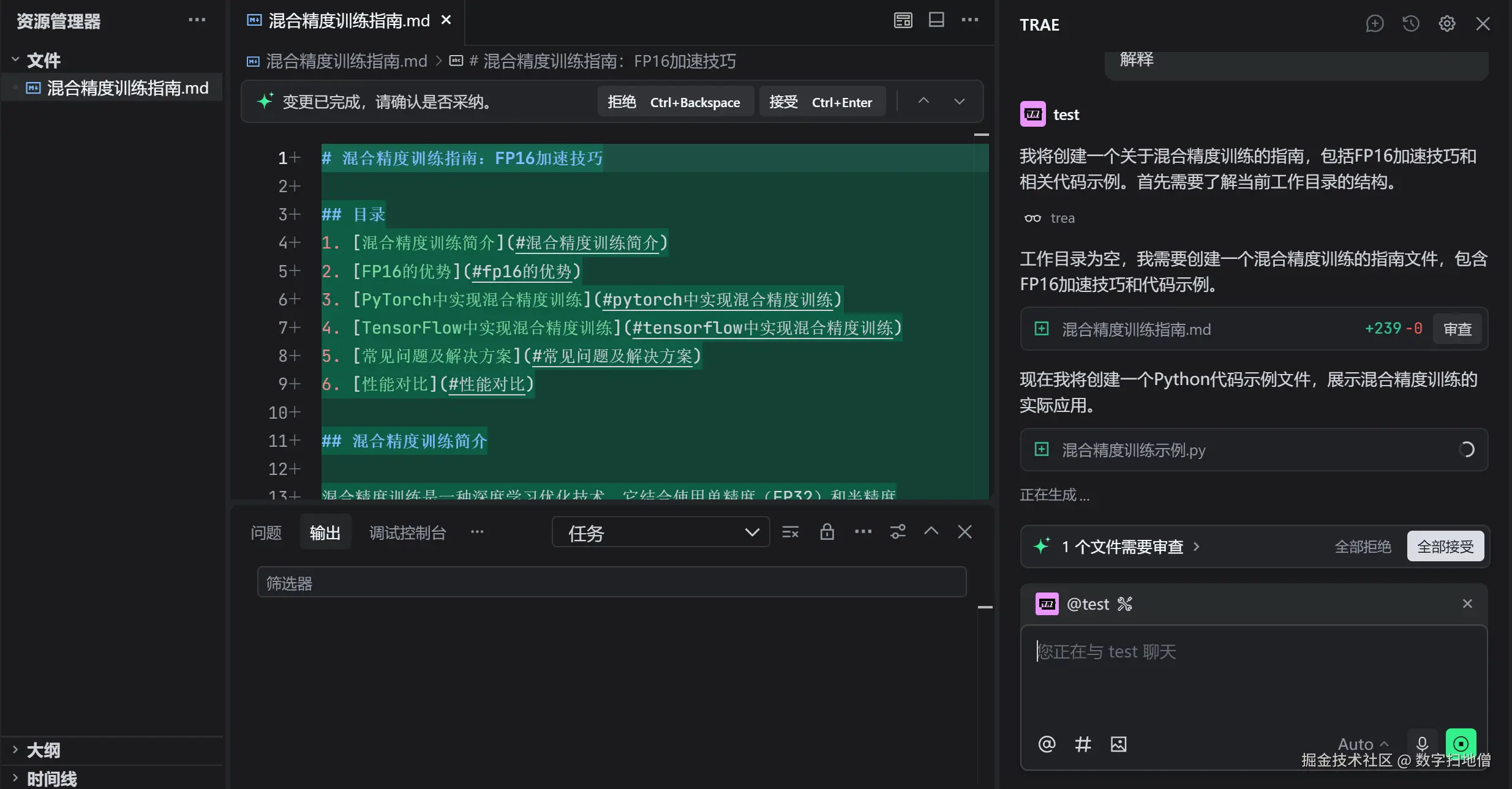

混合精度训练是现代深度学习优化中的一项关键技术,它通过结合 FP32 和 FP16 两种精度格式,在加速训练过程的同时减少内存占用。本文将深入探讨混合精度训练的原理、优势与挑战,并通过实际代码示例展示如何在深度学习项目中有效应用这一技术。

混合精度训练是现代深度学习优化中的一项关键技术,它通过结合 FP32 和 FP16 两种精度格式,在加速训练过程的同时减少内存占用。本文将深入探讨混合精度训练的原理、优势与挑战,并通过实际代码示例展示如何在深度学习项目中有效应用这一技术。

II. 混合精度训练基础

混合精度训练利用 FP16(16 位浮点数)和 FP32(32 位浮点数)的组合,实现训练效率和精度的平衡。

2.1 混合精度训练的核心概念

混合精度训练中,不同计算任务根据其对精度的敏感程度选择 FP16 或 FP32 进行处理,关键概念如下:

| 概念 | 解释 |

|---|---|

| FP16 计算 | 对于梯度计算等对精度要求较低的部分使用 FP16 加速计算。 |

| FP32 主副本 | 维持 FP32 格式的主副本参数,用于累积梯度和参数更新,保证关键计算的精度。 |

| 损失缩放 | 通过放大损失值来避免 FP16 梯度下溢,常见的方法包括静态损失缩放和动态损失缩放。 |

2.2 混合精度训练的优势

采用混合精度训练可以带来显著的性能提升,具体优势如下:

| 优势 | 详细解释 |

|---|---|

| 训练速度提升 | FP16 的计算和内存操作速度更快,相比纯 FP32 训练可实现约 2 倍的加速效果。 |

| 内存占用减少 | FP16 参数和梯度占用的内存是 FP32 的一半,能够训练更大规模的模型或使用更大批次。 |

| 功耗降低 | 减少内存占用和数据传输量,降低 GPU 的功耗,提高能效比。 |

2.3 混合精度训练的挑战

尽管优势明显,混合精度训练也面临一些挑战,需要合理应对:

| 挑战 | 详细解释 |

|---|---|

| 梯度下溢 | FP16 的动态范围有限(约 1e-7 到 1e4),可能导致梯度值过小而无法有效更新参数。 |

| 数值不稳定 | 某些计算(如 softmax 或归一化层)在 FP16 中可能出现数值不稳定现象。 |

| 软件兼容性 | 并非所有深度学习框架和硬件都完美支持混合精度训练,可能存在兼容性问题。 |

2.4 混合精度训练基础总结(mermaid)

III. 混合精度训练的实现机制

为克服 FP16 的局限性并充分发挥其优势,混合精度训练采用了一系列巧妙的实现机制。

3.1 模型参数与梯度管理

在训练过程中,模型参数和梯度分别采用不同的精度格式进行管理:

python

# 模型参数与梯度管理示例(伪代码)

import tensorflow as tf

# 创建 FP32 主副本参数

master_weights = [tf.Variable(tf.cast(w, tf.float32)) for w in fp16_model.trainable_variables]

# 前向传播使用 FP16

with tf.GradientTape() as tape:

y_pred = fp16_model(X, training=True)

loss = loss_fn(y_true, y_pred)

# 计算 FP16 梯度

fp16_gradients = tape.gradient(loss, fp16_model.trainable_variables)

# 将 FP16 梯度转换为 FP32

fp32_gradients = [tf.cast(grad, tf.float32) for grad in fp16_gradients]

# 使用 FP32 主副本参数和梯度更新模型

optimizer.apply_gradients(zip(fp32_gradients, master_weights))

# 将 FP32 主副本参数更新同步回 FP16 模型

for fp16_var, master_var in zip(fp16_model.trainable_variables, master_weights):

fp16_var.assign(tf.cast(master_var, tf.float16))3.2 损失缩放技术

为解决梯度下溢问题,混合精度训练中引入了损失缩放技术:

静态损失缩放

python

# 静态损失缩放示例

loss_scale = 2**15 # 固定缩放因子

with tf.GradientTape() as tape:

y_pred = model(X, training=True)

loss = loss_fn(y_true, y_pred)

scaled_loss = loss * loss_scale # 放大损失值

scaled_gradients = tape.gradient(scaled_loss, model.trainable_variables)

gradients = [grad / loss_scale for grad in scaled_gradients] # 恢复原始梯度尺度| 优点 | 缺点 |

|---|---|

| 实现简单 | 需要手动调参,缩放因子过大可能导致梯度溢出,过小则无法有效解决下溢。 |

动态损失缩放

动态损失缩放根据梯度是否溢出自动调整缩放因子:

python

# 动态损失缩放示例

loss_scale = 2**15 # 初始缩放因子

increment_period = 2000 # 梯度未溢出时增加缩放因子的间隔步数

multiplier = 2.0 # 缩放因子增加倍数

decrement_period = 1 # 梯度溢出时减少缩放因子的间隔步数

divisor = 2.0 # 缩放因子减少倍数

with tf.GradientTape() as tape:

y_pred = model(X, training=True)

loss = loss_fn(y_true, y_pred)

scaled_loss = loss * loss_scale

scaled_gradients = tape.gradient(scaled_loss, model.trainable_variables)

gradients = [grad / loss_scale for grad in scaled_gradients]

# 检测梯度溢出

def has_overflow(grads):

for grad in grads:

if tf.reduce_any(tf.math.is_inf(grad)) or tf.reduce_any(tf.math.is_nan(grad)):

return True

return False

if has_overflow(gradients):

# 梯度溢出,减少缩放因子

loss_scale = loss_scale / divisor

else:

# 梯度未溢出,定期增加缩放因子

if global_step % increment_period == 0:

loss_scale = loss_scale * multiplier| 优点 | 缺点 |

|---|---|

| 自动调整缩放因子,平衡溢出风险和下溢处理效果。 | 实现相对复杂,需维护额外状态并增加计算开销。 |

3.3 混合精度训练的实现机制总结(mermaid)

IV. 深度学习框架中的混合精度支持

主流深度学习框架均提供了对混合精度训练的良好支持,大大简化了开发者的实现工作。

4.1 Tensorflow 中的混合精度 API

Tensorflow 提供了便捷的混合精度训练 API,支持自动混合精度和自定义混合精度两种模式。

自动混合精度

自动混合精度通过 tf.keras.mixed_precision 模块实现:

python

# 自动混合精度示例

tf.keras.mixed_precision.set_global_policy('mixed_float16')

# 构建模型

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation='relu', input_shape=(20,)),

tf.keras.layers.Dense(32, activation='relu'),

tf.keras.layers.Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=10, batch_size=32)| 特性 | 说明 |

|---|---|

| 自动转换 | Tensorflow 自动将计算图中适合的部分转换为 FP16,保留关键部分为 FP32。 |

| 支持现有模型 | 无需修改模型代码,直接通过设置策略启用混合精度。 |

自定义混合精度

对于需要精细控制的场景,可使用自定义训练循环实现混合精度:

python

# 自定义混合精度训练循环示例

optimizer = tf.keras.optimizers.Adam()

loss_fn = tf.keras.losses.BinaryCrossentropy()

# 创建 FP32 主副本参数

master_weights = [tf.Variable(tf.cast(w, tf.float32)) for w in fp16_model.trainable_variables]

for epoch in range(epochs):

for X_batch, y_batch in dataset:

with tf.GradientTape() as tape:

y_pred = fp16_model(X_batch, training=True)

loss = loss_fn(y_batch, y_pred)

# 计算 FP16 梯度并转换为 FP32

fp16_gradients = tape.gradient(loss, fp16_model.trainable_variables)

fp32_gradients = [tf.cast(grad, tf.float32) for grad in fp16_gradients]

# 更新 FP32 主副本参数

optimizer.apply_gradients(zip(fp32_gradients, master_weights))

# 同步 FP32 参数回 FP16 模型

for fp16_var, master_var in zip(fp16_model.trainable_variables, master_weights):

fp16_var.assign(tf.cast(master_var, tf.float16))4.2 PyTorch 中的混合精度支持

PyTorch 提供了 torch.cuda.amp 模块支持混合精度训练,包括自动混合精度和自定义控制两种方式。

自动混合精度

python

# PyTorch 自动混合精度示例

scaler = torch.cuda.amp.GradScaler() # 创建梯度缩放器

model = MyModel().cuda()

optimizer = torch.optim.Adam(model.parameters())

for epoch in range(epochs):

for X_batch, y_batch in dataloader:

optimizer.zero_grad()

with torch.cuda.amp.autocast(): # 自动将计算转换为 FP16

y_pred = model(X_batch)

loss = loss_fn(y_pred, y_batch)

scaler.scale(loss).backward() # 缩放损失并反向传播

# 在梯度缩放器监控下更新参数

scaler.step(optimizer)

scaler.update()| 特性 | 说明 |

|---|---|

| 自动转换 | 使用 autocast 上下文管理器自动将计算转换为 FP16。 |

| 梯度缩放 | 通过 GradScaler 自动处理梯度缩放,支持动态调整缩放因子。 |

自定义混合精度

对于特定层或计算需要强制使用 FP32,可通过 custom_fwd 和 custom_bwd 装饰器实现:

python

# PyTorch 自定义混合精度示例

class CustomLayer(torch.autograd.Function):

@staticmethod

@torch.cuda.amp.custom_fwd

def forward(ctx, input):

# 前向传播使用 FP32

input = input.float()

ctx.save_for_backward(input)

return input

@staticmethod

@torch.cuda.amp.custom_bwd

def backward(ctx, grad_output):

# 反向传播转换为 FP16

input, = ctx.saved_tensors

grad_output = grad_output.half()

# 自定义反向传播逻辑

return grad_output

# 在模型中使用自定义层

class MyModel(nn.Module):

def __init__(self):

super().__init__()

self.custom_layer = CustomLayer()

def forward(self, x):

x = self.custom_layer.apply(x)

# 其他层

return x4.3 混合精度训练框架支持总结(mermaid)

V. 混合精度训练的实践案例

通过实际案例展示混合精度训练的应用过程和效果。

5.1 案例背景

使用深度卷积神经网络(CNN)进行图像分类任务,数据集为 CIFAR-10,模型结构如下表所示:

| 层类型 | 参数 |

|---|---|

| 输入层 | 32x32x3 彩色图像 |

| 卷积层 1 | 32 个 3x3 卷积核,ReLU 激活函数 |

| 最大池化层 | 2x2 窗口 |

| 卷积层 2 | 64 个 3x3 卷积核,ReLU 激活函数 |

| 最大池化层 | 2x2 窗口 |

| 全连接层 1 | 128 个神经元,ReLU 激活函数 |

| 输出层 | 10 个神经元,Softmax 激活函数 |

5.2 混合精度训练配置

模型和优化器配置

python

# 模型配置

model = tf.keras.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 启用混合精度

tf.keras.mixed_precision.set_global_policy('mixed_float16')

# 优化器配置

optimizer = tf.keras.optimizers.Adam()损失函数和回调函数

python

# 损失函数

loss_fn = tf.keras.losses.SparseCategoricalCrossentropy()

# 回调函数用于监控训练过程

callbacks = [

tf.keras.callbacks.TensorBoard(log_dir='./logs'),

tf.keras.callbacks.EarlyStopping(patience=3, monitor='val_loss')

]5.3 训练过程与结果分析

训练过程

在 CIFAR-10 数据集上进行 50 个 epoch 的训练,批量大小为 128。

| 训练阶段 | 描述 |

|---|---|

| 前 10 个 epoch | 模型逐渐学习数据特征,训练和验证准确率稳步提升。 |

| 10-30 个 epoch | 准确率提升速度放缓,模型开始拟合更复杂的模式。 |

| 30-50 个 epoch | 验证准确率出现轻微波动,由于早停回调,在验证损失不再下降时停止训练。 |

训练结果对比

| 指标 | FP32 训练 | 混合精度训练 | 提升比例 |

|---|---|---|---|

| 单步训练时间 | 0.32s | 0.18s | 43.75% |

| GPU 内存占用 | 4.8GB | 3.1GB | 35.4% |

| 最终验证准确率 | 82.3% | 82.5% | 0.2% |

| 图表 | 说明 |

|---|---|

| 吞吐量对比 | 混合精度训练的样本/秒处理速率显著高于 FP32 训练。 |

| 内存占用变化 | 混合精度训练的内存占用曲线明显低于 FP32 训练,允许更大批量或更大模型。 |

| 准确率收敛曲线 | 两种方法的准确率收敛趋势相似,混合精度训练在后期略胜一筹。 |

5.4 混合精度训练实践案例总结(mermaid)

VI. 混合精度训练的优化策略

为进一步提升混合精度训练的效果和稳定性,可采用以下优化策略。

6.1 损失函数调整

对于某些对数值稳定性敏感的损失函数(如 softmax),建议保持 FP32 精度计算:

python

# 保持损失函数为 FP32 精度

with tf.keras.mixed_precision.Policy('float32'):

def custom_loss(y_true, y_pred):

return tf.keras.losses.sparse_categorical_crossentropy(y_true, y_pred)6.2 梯度累积

在使用较大损失缩放因子时,梯度过大使参数更新不稳定,可采用梯度累积技术缓解:

python

# 梯度累积示例

accumulation_steps = 4

optimizer = tf.keras.optimizers.Adam()

for epoch in range(epochs):

for step, (X_batch, y_batch) in enumerate(dataset):

with tf.GradientTape() as tape:

y_pred = model(X_batch, training=True)

loss = loss_fn(y_batch, y_pred)

scaled_loss = loss * loss_scale

scaled_gradients = tape.gradient(scaled_loss, model.trainable_variables)

if (step + 1) % accumulation_steps == 0:

# 每 accumulation_steps 步累积梯度并更新参数

gradients = [grad / loss_scale / accumulation_steps for grad in scaled_gradients]

optimizer.apply_gradients(zip(gradients, model.trainable_variables))6.3 网络架构适配

部分网络层(如归一化层)对精度敏感,建议保持 FP32 精度:

python

# 保持 Batch Normalization 层为 FP32

class MyModel(tf.keras.Model):

def __init__(self):

super().__init__()

self.bn = tf.keras.layers.BatchNormalization(dtype='float32')

def call(self, x):

x = self.bn(x)

# 其他层

return x6.4 混合精度训练优化策略总结(mermaid)

VII. 混合精度训练的注意事项与最佳实践

在实际应用混合精度训练时,需要注意一些关键事项以确保训练过程顺利和结果可靠。

7.1 硬件兼容性

混合精度训练对硬件有一定要求,主要兼容 NVIDIA Volta 架构及以后的 GPU(如 V100、A100、RTX 20 系列及以上)。

| GPU 架构 | 是否支持 TensorFloat-32 (TF32) | FP16 性能优势 |

|---|---|---|

| Volta (V100) | 否 | 是 |

| Turing (RTX 20 系列) | 否 | 是 |

| Ampere (A100、RTX 30 系列) | 是 | 是 |

7.2 软件环境要求

确保深度学习框架版本支持混合精度训练。例如:

- Tensorflow 2.0 及以上版本

- PyTorch 1.6 及以上版本

7.3 混合精度训练的最佳实践

7.3.1 逐步迁移

建议按照以下步骤逐步迁移模型到混合精度训练:

- 基准 FP32 训练:首先使用 FP32 完整训练模型,记录基准性能指标。

- 启用自动混合精度:切换到自动混合精度模式,观察训练是否稳定,验证指标是否与 FP32 接近。

- 自定义调整:根据需要对特定层或计算进行自定义精度控制,优化数值稳定性和性能。

- 调优损失缩放:如果出现梯度溢出,调整损失缩放策略(从较小的缩放因子开始,逐步增大)。

7.3.2 监控与调试

在整个训练过程中,密切监控以下指标:

| 监控指标 | 正常范围 | 异常表现及应对措施 |

|---|---|---|

| 梯度值 | 与 FP32 训练相当,无大量 INF/NAN | 出现大量溢出时,减小损失缩放因子,检查模型初始化。 |

| 损失值 | 稳定下降,验证损失曲线合理 | 损失停滞或上升时,检查学习率和数据管道。 |

| GPU 利用率 | 接近 100% | 利用率低时,检查批量大小和数据管道瓶颈。 |

7.4 混合精度训练注意事项总结(mermaid)

VIII. 混合精度训练的未来发展方向

随着深度学习技术的不断进步,混合精度训练也在持续演进。

8.1 硬件支持增强

未来 GPU 和专用 AI 芯片将进一步优化 FP16 和 BF16(Brain Floating Point 16)的支持,提升计算效率和内存带宽。

8.2 自动混合精度的智能化

深度学习框架将集成更智能的自动混合精度算法,能够自动识别并调整需要 FP32 精度的计算部分,减少人工干预。

8.3 与量化技术的融合

混合精度训练与量化技术相结合,进一步压缩模型大小并提升推理速度,适用于边缘设备部署。

8.4 混合精度训练的标准化

随着技术成熟,混合精度训练的相关标准和最佳实践将逐渐形成,促进跨框架和跨硬件平台的兼容性。