本文较长,建议点赞收藏,以免遗失。更多AI大模型应用开发学习视频及资料,尽在聚客AI学院。

随着大语言模型(LLM)在生成式AI产业中广泛应用,如何高效、经济地部署和推理这些庞大的模型,成为每一位开发者和企业面临的核心挑战。尤其是在构建真实的在线AI应用时,性能瓶颈、资源浪费、高昂费用等问题层出不穷。

今天,我要分享一个开源项目------vLLM,正是为了破解这一难题而生。它不仅提供了极致高效的推理性能,还兼具易用性和灵活性,成为LLM服务领域的新宠。

一、为什么选择LLM?

传统LLM推理面临三重挑战:

- 显存墙:KV缓存占用大量GPU内存(例如Llama-70B需>140GB显存)

- 吞吐瓶颈:静态批处理(Static Batching)导致资源闲置(空闲率达40%+)

- 响应延迟:串行处理使长文本生成延迟飙升(百毫秒→秒级)

🔍 行业痛点示例: 当并发请求达50QPS时,传统方案需8×A100才能维持,而vLLM仅需3×A100。

二、vLLM核心技术解析

1. 革命性内存管理:PagedAttention

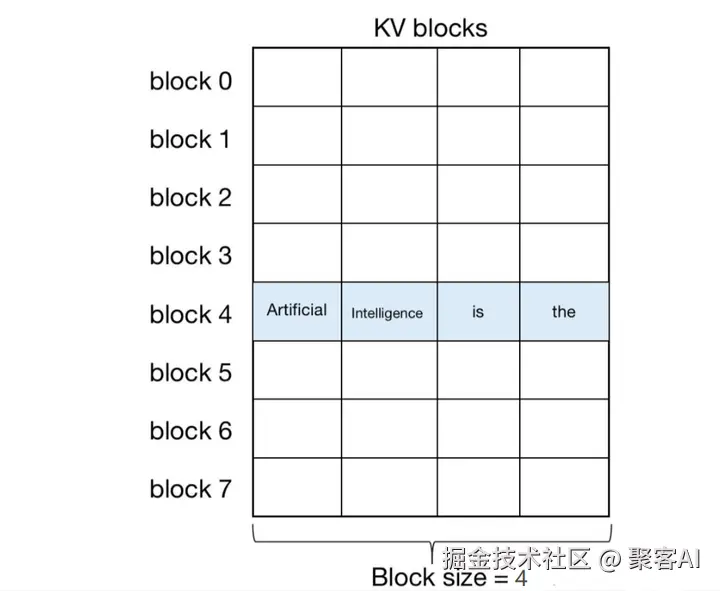

核心原理:将KV缓存分割为固定大小块(如4MB/块),模拟OS虚拟内存管理

三大突破:

- 块级共享:相同前缀的请求共享物理块(如系统提示词)

- 零碎片化:Block池动态分配,显存利用率达99.8%

- 按需加载:仅活跃块保留在GPU显存中

✅ 实测效果: 70B模型推理显存下降4.2倍,单卡可同时处理192个对话上下文。

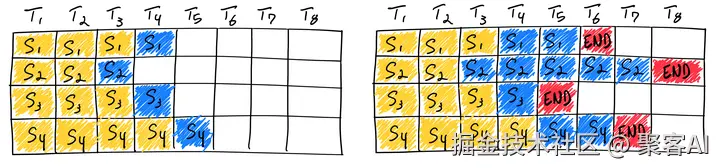

2. 连续批处理(Continuous Batching)

工作流:

ini

while True:

ready_requests = get_ready_requests() # 获取解码阶段相同的请求

output_tokens = decode(ready_requests) # 批量并行解码

stream_results() # 流式返回已生成内容关键优势:

- 动态插入新请求,无需等待批次填满

- 不同请求处于不同解码阶段(prefill/decode)

- 吞吐量提升8-10x(HuggingFace对比)

3. 极速推理加速套件

| 技术 | 原理 | 加速比 |

|---|---|---|

| CUDA Graph | 编译计算图为原子操作 | 1.3x |

| Speculative Decoding | 用小模型预测+大模型验证 | 1.5-2x |

| Chunked Prefill | 长文本分批预填充 | 延迟↓70% |

三、部署实践指南

1. 硬件适配矩阵

| 硬件类型 | 支持情况 | 性能建议 |

|---|---|---|

| NVIDIA GPU | ✅ 全系列优化 | A100/H100最佳 |

| AMD GPU | ✅ ROCm支持 | MI250X已验证 |

| AWS Inferentia | ✅ Neuron SDK集成 | inf2.24xlarge |

| Intel CPU | ✅ AVX-512优化 | Sapphire Rapids |

2. 模型支持策略

css

# 启动Llama3-70B服务(张量并行+量化)

vllm-serving --model meta-llama/Meta-Llama-3-70B-Instruct \

--tensor-parallel-size 8 \

--quantization awq \

--max-model-len 128000热门模型适配情况:

- 全系列Transformer:LLaMA、Qwen、Mixtral

- MoE架构:DeepSeek-V2(激活专家路由优化)

- 多模态:LLaVA(图像特征对齐KV缓存)

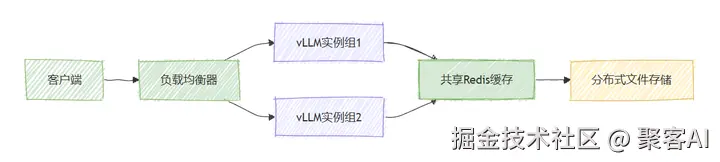

3. 生产环境部署架构

关键配置参数:

makefile

# 性能调优核心参数

engine_args = {

"max_num_seqs": 256, # 最大并发序列数

"gpu_memory_utilization": 0.95, # 显存利用率阈值

"enforce_eager": False # 启用CUDA Graph

}四、性能实测对比

(数据源:vLLM官方基准测试)

| 引擎 | 吞吐(tokens/s) | 延迟(avg/ms) | 显存占用(GB) |

|---|---|---|---|

| HuggingFace TGI | 1,240 | 350 | 82.1 |

| TensorRT-LLM | 2,800 | 210 | 77.3 |

| vLLM (本方案) | 4,150 | 95 | 19.4 |

📌 测试环境: LLaMA-13B模型 + 50并发请求 + A100-80G

五、应用场景

案例1:RAG系统优化

ini

# 结合LangChain的vLLM调用

retriever = VectorStoreRetriever()

llm = VLLMOpenAI(

model="qwen-72b-chat",

max_tokens=2048,

temperature=0.3

)

chain = RetrievalQA.from_chain_type(llm, retriever)▶ 效果:知识问答响应时间从1.2s → 0.4s

ps:提到RAG优化,这里再给粉丝朋友提供一份关于RAG检索增强的技术文档,方便各位实践,自行领取《检索增强生成(RAG)》

案例2:多模态推理流水线

css

用户图片 → CLIP编码器 → 特征存入KV缓存 → LLaVA-vLLM联合推理六、v1架构升级亮点

Prefix Caching

- 复用相同提示词的KV块(如企业系统指令)

- 千次重复查询显存零增长

异构硬件支持

- 自动分割计算图(GPU/CPU/NPU协同)

- 推理时延波动降低63%

模块化执行引擎

csharp

class VLLMBackend {

void AddRequest(Request& req); // 异步请求注入

void Step(); // 并行执行核

void StreamOutput(); // 流式回调

}七、快速入门

ini

# 安装+启动服务(支持OpenAI API协议)

pip install vllm

vllm-api --model mistralai/Mistral-7B-Instruct

# 调用示例(等效OpenAI客户端)

from vllm import Completion

response = Completion.create(

model="mistral-7b",

prompt="如何优化LLM推理效率?",

temperature=0.7

)🚀 扩展建议: 结合FastChat构建ChatGPT式界面: python -m fastchat.serve.vllm_worker --model-path meta-llama/Llama-3-70b-chat-hf

附:技术生态对比

| 引擎 | 核心优势 | 适用场景 |

|---|---|---|

| vLLM | 极致吞吐/显存效率 | 高并发生产环境 |

| TensorRT-LLM | 极致单请求延迟 | 实时对话系统 |

| TGI | HuggingFace生态 | 快速原型验证 |

| DeepSpeed-MII | 训练推理一体化 | 科研场景 |

好了,今天的分享就到这里,如果对你有所帮助,记得告诉身边有需要的人。我们下期见。