在深度学习领域,将训练好的模型部署为REST API服务是一种常见的实践。通过REST API,模型可以被各种客户端(如Web应用、移动应用)调用,从而实现模型的广泛应用。Trae框架提供了强大的模型部署功能,支持将模型快速部署为REST API服务。本文将详细介绍如何使用Trae框架将深度学习模型部署为REST API服务,并通过实例展示整个部署过程。

I. 模型服务化的重要性

将深度学习模型部署为服务化接口,可以极大地提高模型的可用性和灵活性。模型服务化允许模型在不同的应用场景中被高效调用,同时也可以方便地进行扩展和维护。

(一)为什么需要模型服务化?

- 提高可用性:通过REST API,模型可以被各种客户端调用,无需直接访问模型代码。

- 便于扩展:服务化接口可以方便地进行水平扩展,以应对高并发请求。

- 简化部署:将模型封装为服务可以简化部署流程,减少依赖项的管理复杂度。

(二)模型服务化的主要方法

- 本地部署:在本地服务器上部署模型服务。

- 云部署:在云平台上部署模型服务,如AWS、Azure、Google Cloud等。

- 容器化部署:使用Docker等容器技术部署模型服务,便于管理和迁移。

在本文中,我们将重点介绍如何使用Trae框架将模型部署为REST API服务,并通过Flask框架实现本地部署。

(三)Mermaid总结

II. Trae模型部署

Trae框架提供了简单易用的模型部署功能,支持将训练好的模型快速部署为REST API服务。在本节中,我们将详细介绍如何使用Trae框架进行模型部署。

Trae框架提供了简单易用的模型部署功能,支持将训练好的模型快速部署为REST API服务。在本节中,我们将详细介绍如何使用Trae框架进行模型部署。

(一)安装Trae和Flask

在开始之前,我们需要安装Trae和Flask。Flask是一个轻量级的Python Web框架,适合用于部署REST API服务。

bash

pip install trae flask(二)定义模型

我们将定义一个简单的卷积神经网络(CNN)作为图像分类模型。

python

import trae as t

class SimpleCNN(t.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = t.Conv2d(1, 10, kernel_size=5)

self.relu1 = t.ReLU()

self.conv2 = t.Conv2d(10, 20, kernel_size=5)

self.relu2 = t.ReLU()

self.fc1 = t.Linear(320, 50)

self.fc2 = t.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = t.max_pool2d(x, 2)

x = self.conv2(x)

x = self.relu2(x)

x = t.max_pool2d(x, 2)

x = x.view(-1, 320)

x = self.fc1(x)

x = self.fc2(x)

return x(三)训练模型

我们将训练一个完整的浮点模型,作为后续部署的基础。

python

# 定义模型

model = SimpleCNN()

# 定义损失函数和优化器

criterion = t.CrossEntropyLoss()

optimizer = t.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(10):

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")(四)保存模型

我们将训练好的模型保存为文件,以便后续加载和部署。

python

# 保存模型

t.save(model.state_dict(), 'simple_model.pth')(五)Mermaid总结

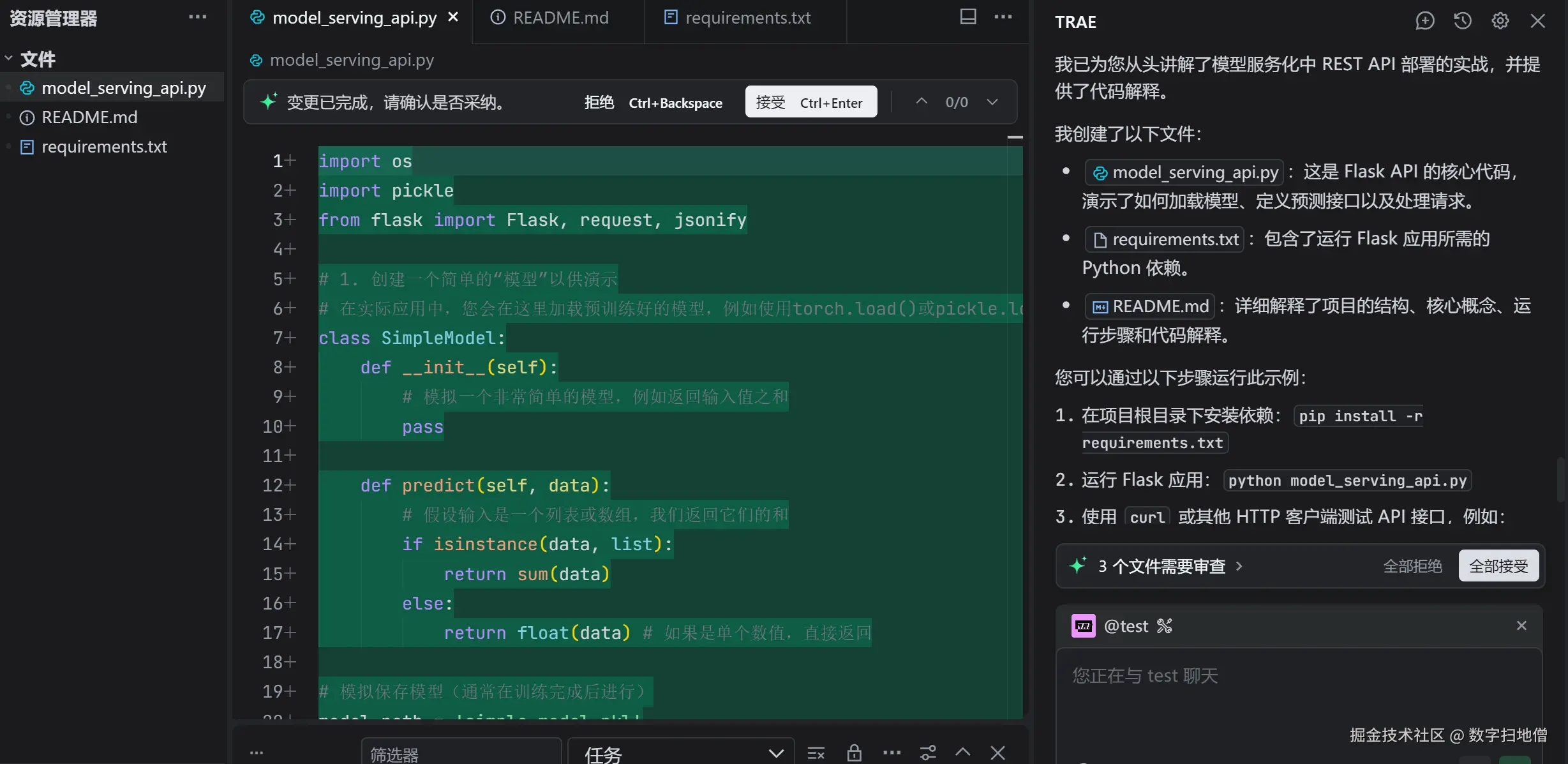

III. REST API部署

在本节中,我们将使用Flask框架将训练好的模型部署为REST API服务。我们将通过Flask创建一个简单的Web服务器,并定义一个API接口,用于接收输入数据并返回模型的预测结果。

(一)创建Flask应用

我们将创建一个Flask应用,并定义一个API接口。

python

from flask import Flask, request, jsonify

import trae as t

app = Flask(__name__)

# 加载模型

model = SimpleCNN()

model.load_state_dict(t.load('simple_model.pth'))

model.eval()

# 定义API接口

@app.route('/predict', methods=['POST'])

def predict():

# 获取输入数据

data = request.json['data']

data = t.tensor(data, dtype=t.float32)

# 进行预测

output = model(data)

_, predicted = t.max(output, 1)

# 返回预测结果

return jsonify({'prediction': predicted.item()})

if __name__ == '__main__':

app.run(debug=True)(二)代码解释

-

创建Flask应用:

- 使用

Flask创建一个简单的Web服务器。

- 使用

-

加载模型:

- 使用

t.load加载保存的模型参数,并将模型设置为评估模式。

- 使用

-

定义API接口:

- 使用

@app.route定义一个POST接口/predict。 - 从请求中获取输入数据,并将其转换为Tensor。

- 使用模型进行预测,并返回预测结果。

- 使用

-

运行Flask应用:

- 使用

app.run启动Flask服务器。

- 使用

(三)测试API接口

我们将使用Postman或curl测试API接口。

bash

curl -X POST -H "Content-Type: application/json" -d '{"data": [[0.1, 0.2, 0.3]]}' http://localhost:5000/predict(四)Mermaid总结

IV. 实战案例:部署图像分类模型

在本节中,我们将通过一个实战案例来展示如何使用Trae框架和Flask将图像分类模型部署为REST API服务。我们将使用一个简单的卷积神经网络(CNN)作为示例,并通过Flask框架实现本地部署。

(一)数据准备

我们将使用MNIST数据集作为示例。MNIST是一个手写数字识别数据集,包含60,000个训练样本和10,000个测试样本。

python

import trae as t

from trae.datasets import MNIST

# 加载数据集

train_dataset = MNIST(root='./data', train=True, download=True, transform=t.ToTensor())

test_dataset = MNIST(root='./data', train=False, download=True, transform=t.ToTensor())

train_loader = t.DataLoader(train_dataset, batch_size=64, shuffle=True)

test_loader = t.DataLoader(test_dataset, batch_size=1000, shuffle=False)(二)定义模型

我们将定义一个简单的卷积神经网络(CNN)作为图像分类模型。

python

class SimpleCNN(t.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = t.Conv2d(1, 10, kernel_size=5)

self.relu1 = t.ReLU()

self.conv2 = t.Conv2d(10, 20, kernel_size=5)

self.relu2 = t.ReLU()

self.fc1 = t.Linear(320, 50)

self.fc2 = t.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = t.max_pool2d(x, 2)

x = self.conv2(x)

x = self.relu2(x)

x = t.max_pool2d(x, 2)

x = x.view(-1, 320)

x = self.fc1(x)

x = self.fc2(x)

return x(三)训练模型

我们将训练一个完整的浮点模型,作为后续部署的基础。

python

# 定义模型

model = SimpleCNN()

# 定义损失函数和优化器

criterion = t.CrossEntropyLoss()

optimizer = t.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(10):

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")(四)保存模型

我们将训练好的模型保存为文件,以便后续加载和部署。

python

# 保存模型

t.save(model.state_dict(), 'simple_model.pth')(五)部署模型

我们将使用Flask框架将模型部署为REST API服务。

python

from flask import Flask, request, jsonify

import trae as t

app = Flask(__name__)

# 加载模型

model = SimpleCNN()

model.load_state_dict(t.load('simple_model.pth'))

model.eval()

# 定义API接口

@app.route('/predict', methods=['POST'])

def predict():

# 获取输入数据

data = request.json['data']

data = t.tensor(data, dtype=t.float32)

# 进行预测

output = model(data)

_, predicted = t.max(output, 1)

# 返回预测结果

return jsonify({'prediction': predicted.item()})

if __name__ == '__main__':

app.run(debug=True)(六)测试API接口

我们将使用Postman或curl测试API接口。

bash

curl -X POST -H "Content-Type: application/json" -d '{"data": [[0.1, 0.2, 0.3]]}' http://localhost:5000/predict(七)Mermaid总结

V. 性能优化

为了提高模型服务的性能,我们可以采取一些优化措施,如模型量化、剪枝和缓存机制。这些优化措施可以显著减少模型的计算量和内存占用,从而提高服务的响应速度和吞吐量。

(一)模型量化

模型量化是一种通过将模型的权重和激活函数从浮点数转换为低精度表示(如8位整数)来减少模型大小和计算复杂度的技术。

python

# 使用Trae进行模型量化

quantized_model = t.quantize(model)(二)模型剪枝

模型剪枝是一种通过移除模型中不重要的参数来减少模型大小的技术。

python

# 使用Trae进行模型剪枝

pruned_model = t.prune(model, prune_ratio=0.5)(三)缓存机制

缓存机制可以减少重复计算,提高服务的响应速度。

python

from flask import Flask, request, jsonify

from functools import lru_cache

app = Flask(__name__)

# 加载模型

model = SimpleCNN()

model.load_state_dict(t.load('simple_model.pth'))

model.eval()

# 使用缓存机制

@lru_cache(maxsize=128)

def cached_predict(data):

data = t.tensor(data, dtype=t.float32)

output = model(data)

_, predicted = t.max(output, 1)

return predicted.item()

# 定义API接口

@app.route('/predict', methods=['POST'])

def predict():

# 获取输入数据

data = request.json['data']

# 进行预测

prediction = cached_predict(tuple(data))

# 返回预测结果

return jsonify({'prediction': prediction})

if __name__ == '__main__':

app.run(debug=True)(四)Mermaid总结

VI. 安全加固

为了确保模型服务的安全性,我们需要采取一些安全加固措施,如输入验证、身份验证和授权。

(一)输入验证

输入验证可以防止恶意输入数据对模型服务造成威胁。

python

from flask import Flask, request, jsonify

from werkzeug.exceptions import BadRequest

app = Flask(__name__)

# 加载模型

model = SimpleCNN()

model.load_state_dict(t.load('simple_model.pth'))

model.eval()

# 定义输入验证

def validate_input(data):

if not isinstance(data, list) or len(data) == 0:

raise BadRequest("Invalid input data")

for item in data:

if not isinstance(item, list) or len(item) != 28 * 28:

raise BadRequest("Invalid input data")

# 定义API接口

@app.route('/predict', methods=['POST'])

def predict():

# 获取输入数据

data = request.json.get('data')

validate_input(data)

data = t.tensor(data, dtype=t.float32)

# 进行预测

output = model(data)

_, predicted = t.max(output, 1)

# 返回预测结果

return jsonify({'prediction': predicted.item()})

if __name__ == '__main__':

app.run(debug=True)(二)身份验证和授权

身份验证和授权可以防止未经授权的访问对模型服务造成威胁。

python

from flask import Flask, request, jsonify

from functools import wraps

import jwt

app = Flask(__name__)

# 加载模型

model = SimpleCNN()

model.load_state_dict(t.load('simple_model.pth'))

model.eval()

# 定义身份验证装饰器

def token_required(f):

@wraps(f)

def decorated(*args, **kwargs):

token = request.headers.get('Authorization')

if not token:

return jsonify({'message': 'Token is missing'}), 403

try:

data = jwt.decode(token, 'your_secret_key', algorithms=['HS256'])

except:

return jsonify({'message': 'Token is invalid'}), 403

return f(*args, **kwargs)

return decorated

# 定义API接口

@app.route('/predict', methods=['POST'])

@token_required

def predict():

# 获取输入数据

data = request.json.get('data')

validate_input(data)

data = t.tensor(data, dtype=t.float32)

# 进行预测

output = model(data)

_, predicted = t.max(output, 1)

# 返回预测结果

return jsonify({'prediction': predicted.item()})

if __name__ == '__main__':

app.run(debug=True)