作为一名还算合格的 Apple 开发秃头码农,宝子们曾经在 Cursor、VSCode、Trae 等多个智能 IDE 中流连忘返,寻求安慰。

小伙伴们多么希望 Xcode 也可以借助 AI 之力乘风而上!这次,宝子们要美梦成真了。我们国行版的中文 mac 系统无需任何改 ID、换区、破解打补丁之类的繁琐操作,即可让 Xcode 原生支持 AI Coding Intelligence:

在本篇博文中,您将学到如下内容:

-

- 系统要求

-

- 启用步骤

-

- 搭建本地大模型环境

-

- 在 Xcode 中使用 AI Coding Intelligence

-

- 扩展

无需等待,让我们马上开始 Xcode AI Coding 的乘风破浪之旅吧! Let's go!!!;)

1. 系统要求

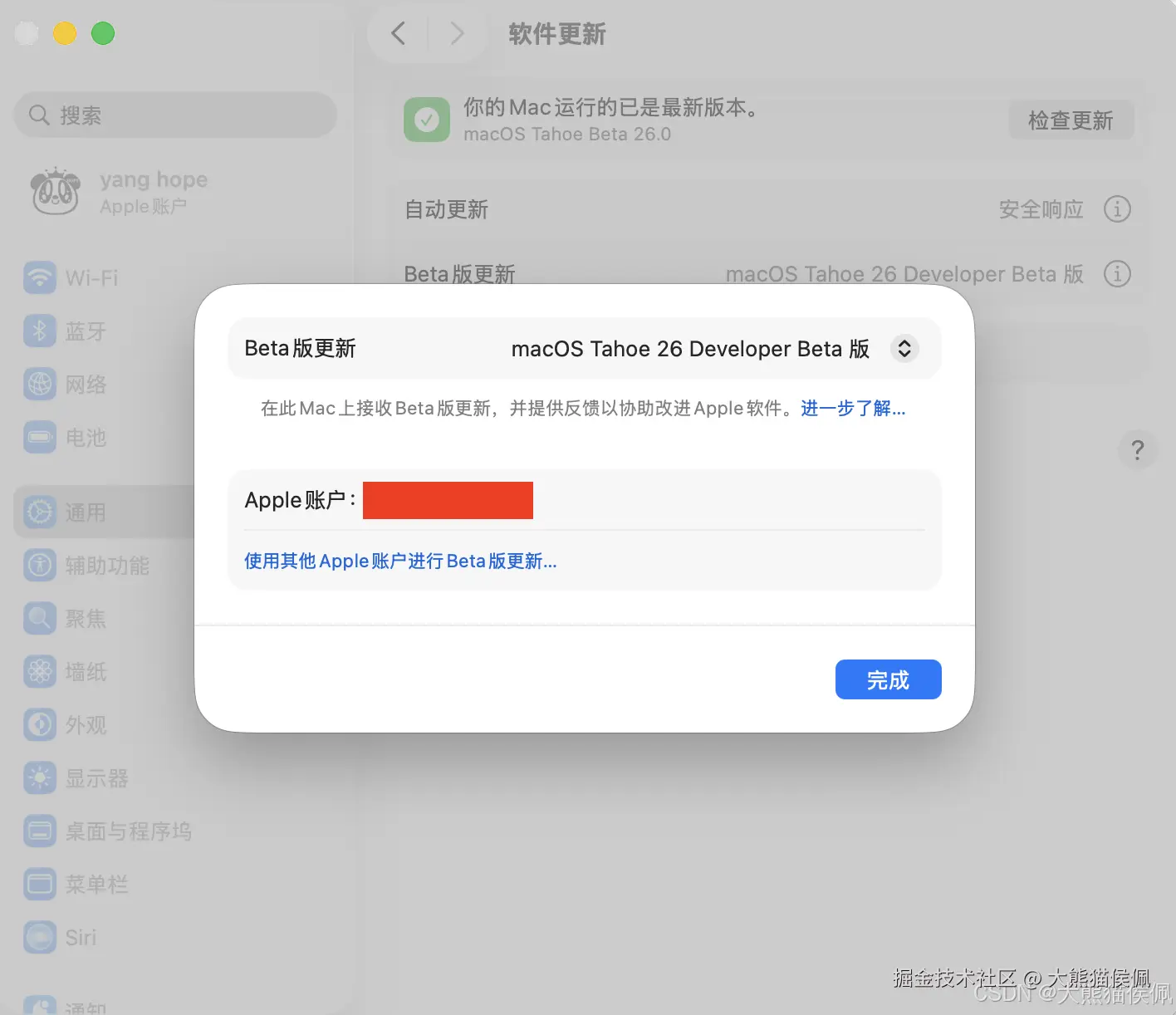

首先,macOS 需要 26.0(Tahoe)Developer beta 版,至于具体是 beta 第几版,不甚明了,反正我用的是 beta 6 版本。

Xcode 本身则需要 26.0 beta6 或以上版本,beta5 版本未做验证,情况不明。

至于 Mac 硬件的配置自然是越强越好,毕竟到时候内存太小放不下大模型,宝子们岂不又会急的多挠掉几千根头发。

2. 启用步骤

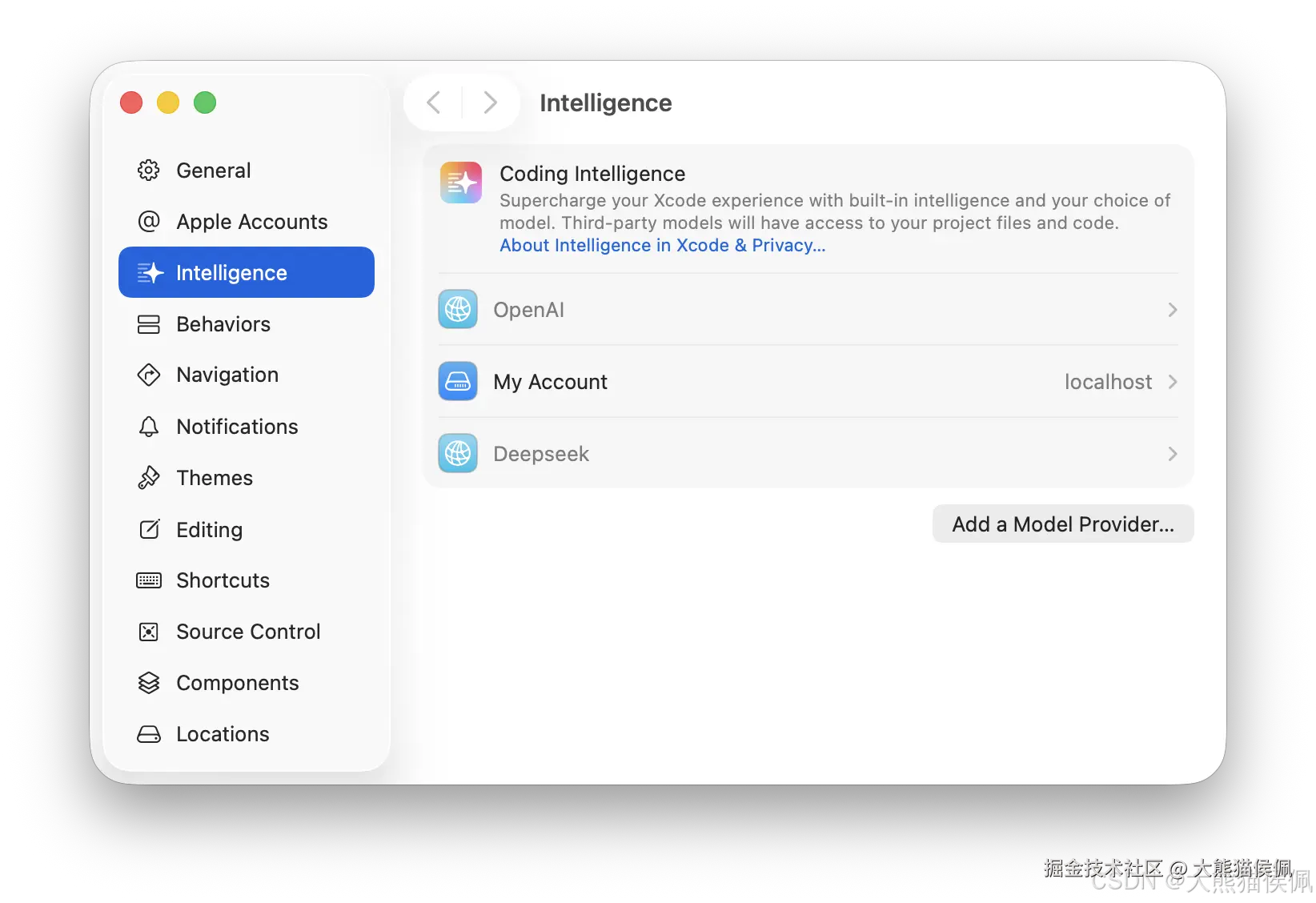

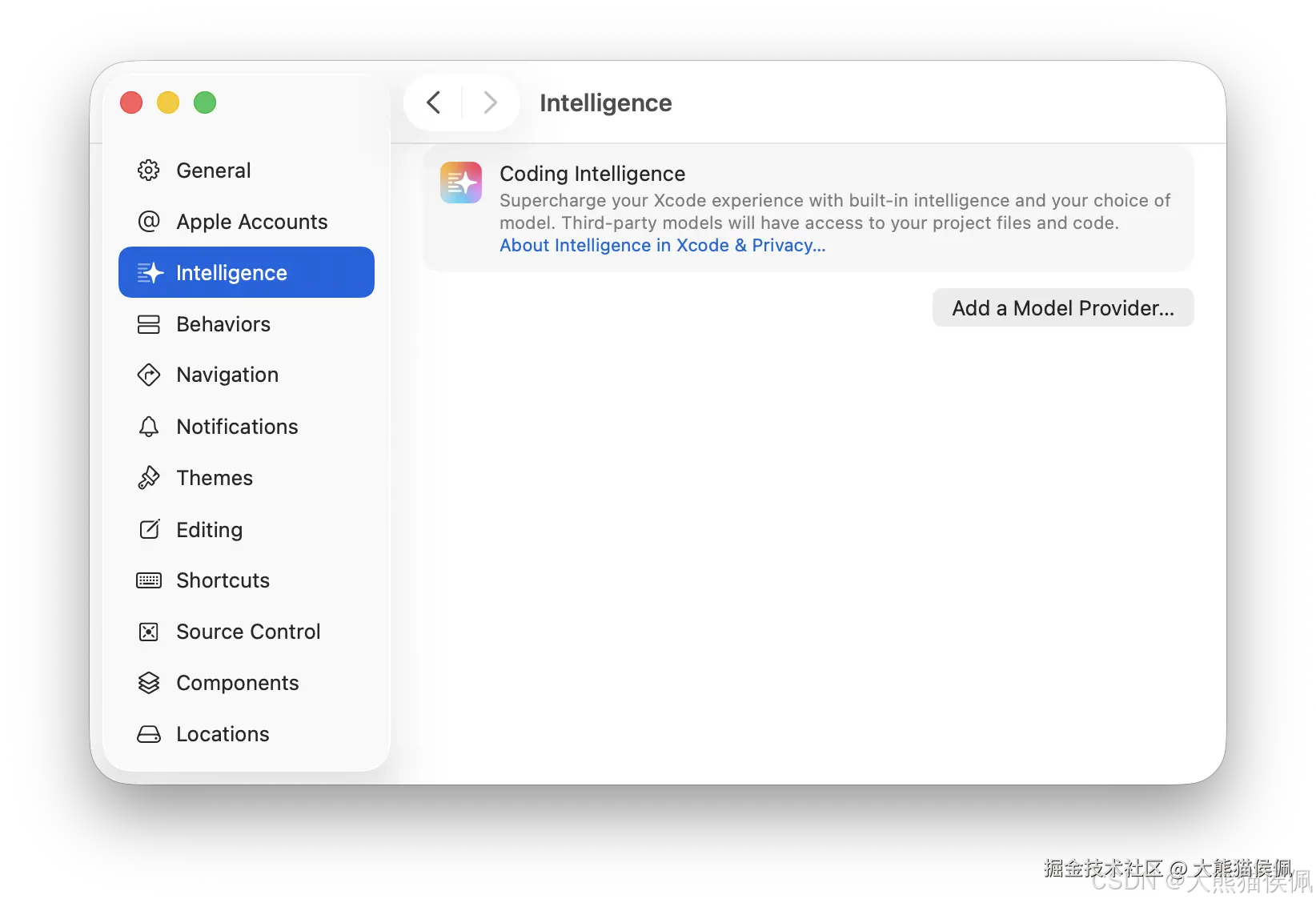

运行 Xcode,从全局菜单打开设置页面,进入 Intelligence 选项卡:

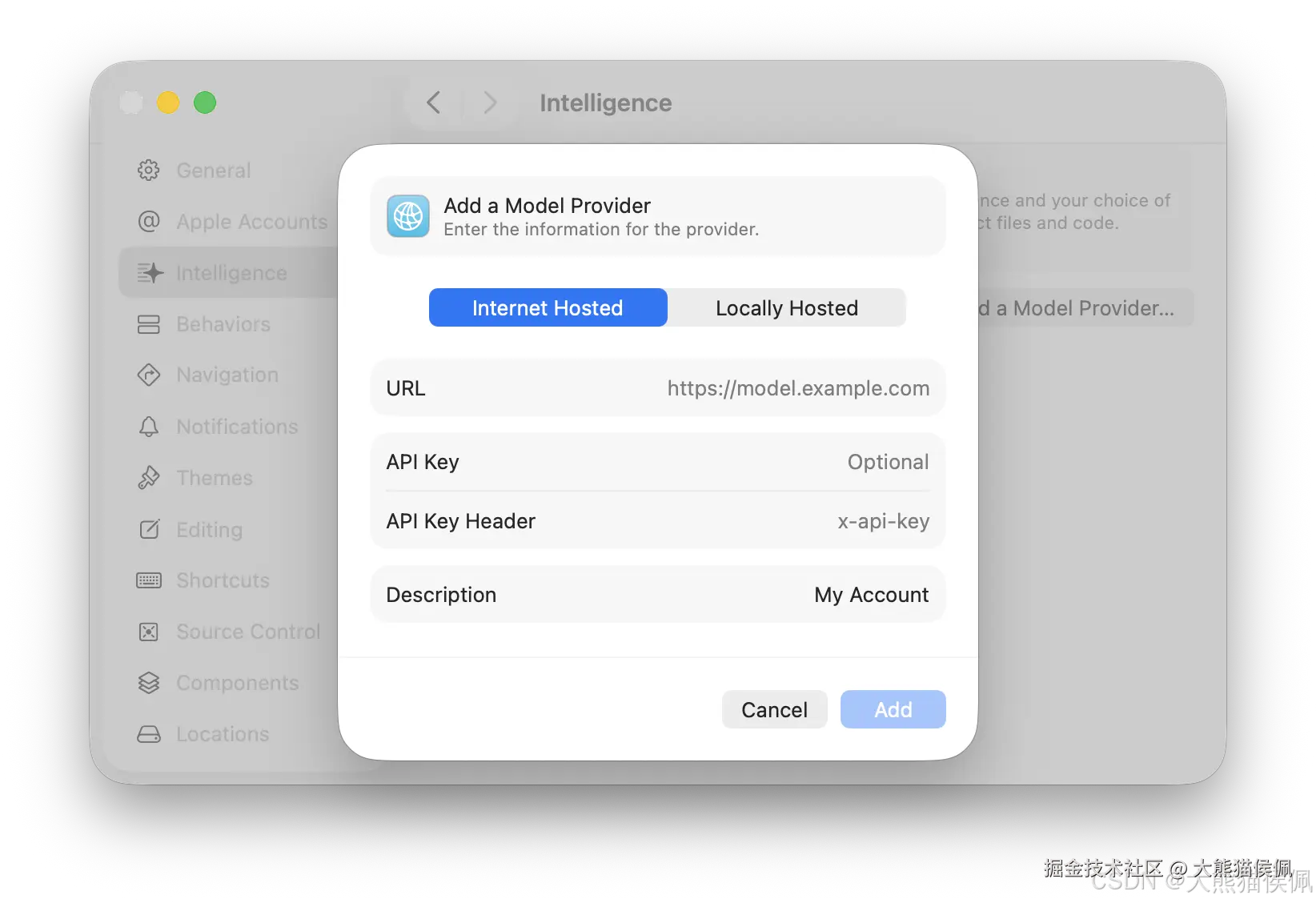

点击添加大模型提供者(Add a Model Provider )按钮,即可恣意选择我们心仪的大模型啦:

因为"国行" macOS 系统本身默认不会嵌入 Apple 官方本地的大模型,所以我们只有两种选择:远端大模型(比如 OpenAI 的 GPT)或者本地自己的大模型。

3. 搭建本地大模型环境

用本地大模型的好处是完全免费,而且如果你电脑性能强劲(内存+芯片)的话,token 生成速度也是杠杠的。

要想在 macOS 中搭建本地 AI 大模型调用环境有很多种方式。这里,我们使用的是 Ollama。

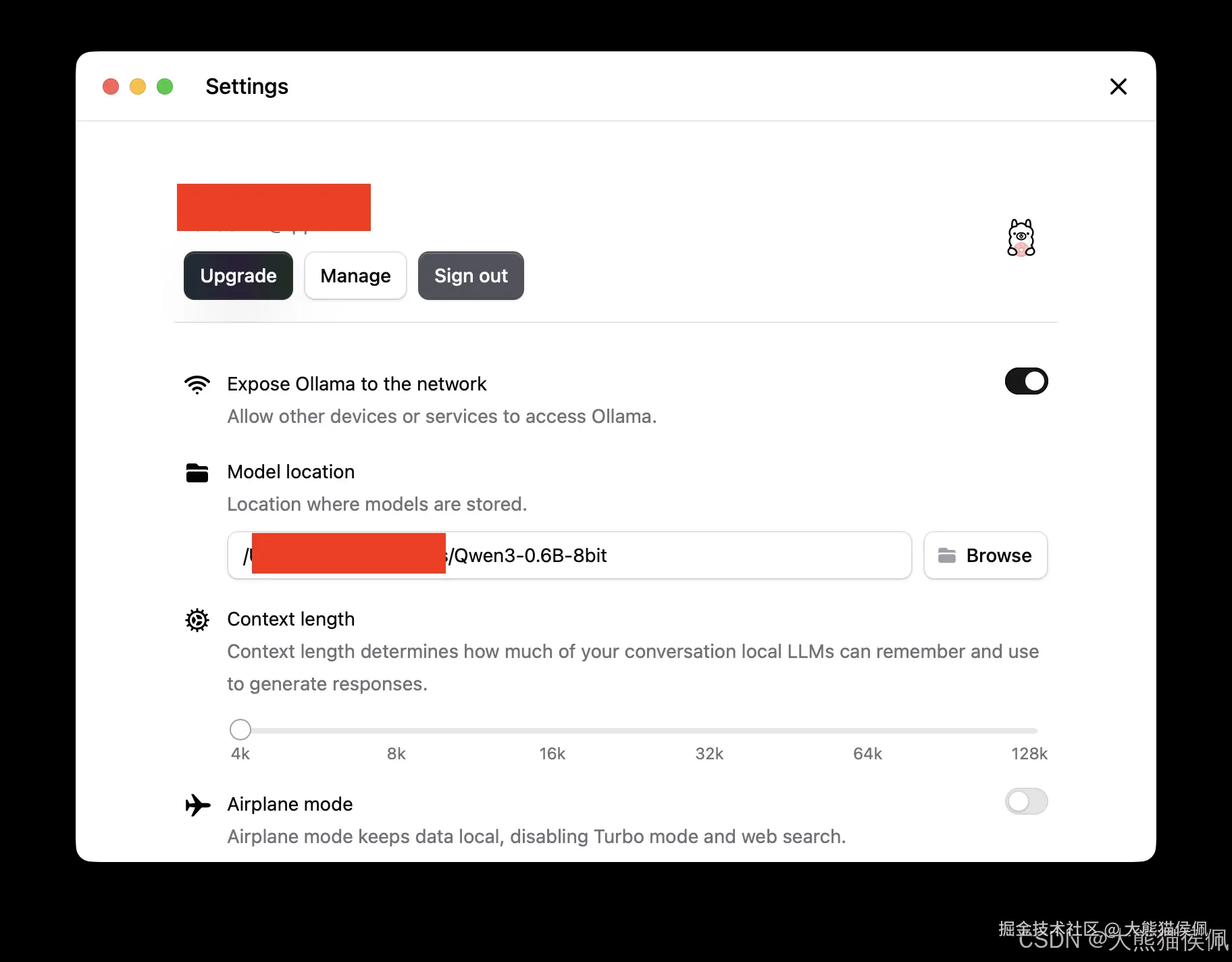

安装 Ollama 之后,打开设置窗口,我们可以登录账号并且选择大模型的本地存放路径:

如上图所示,我们还可以调整大模型上下文的长度以满足实际需求。

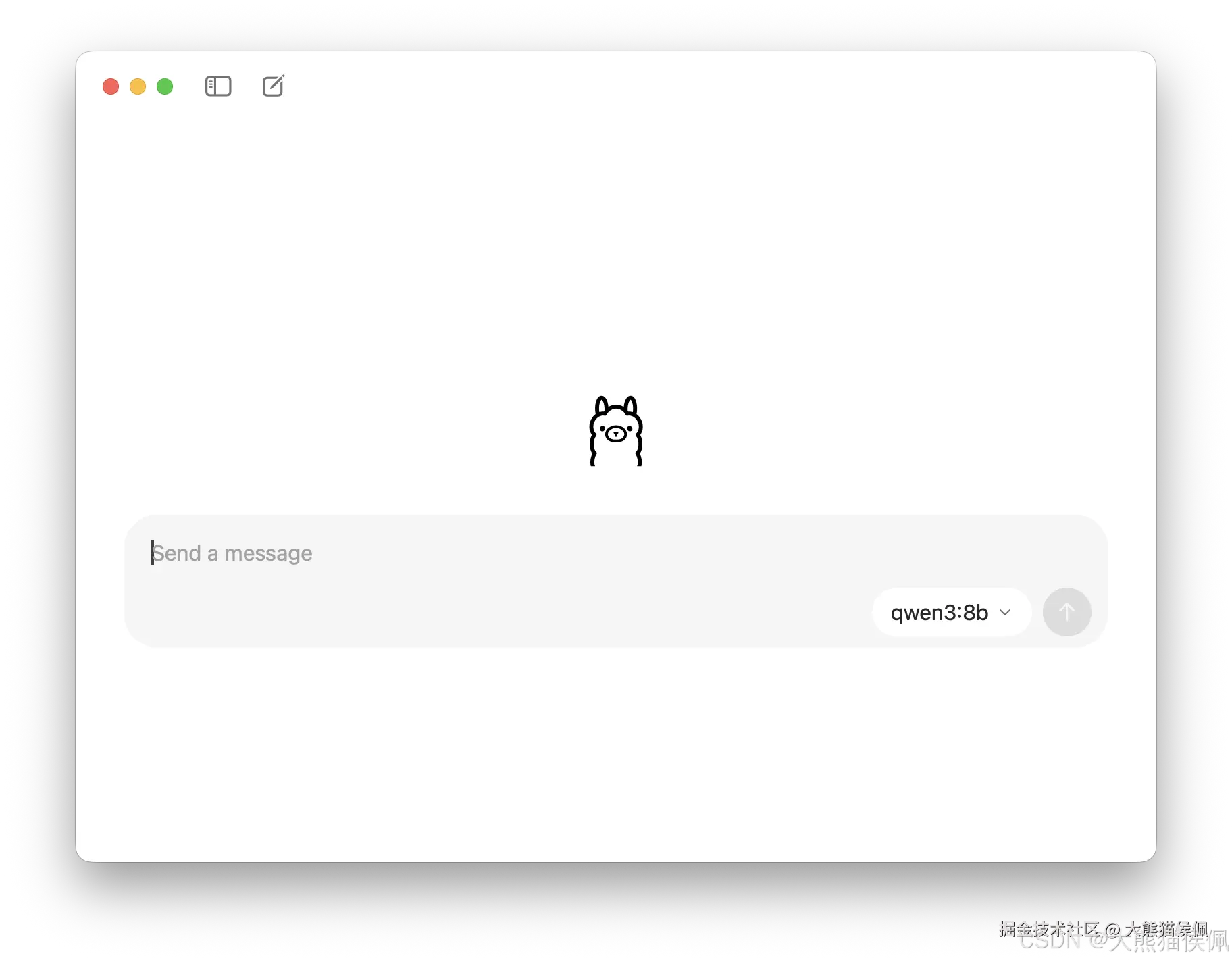

接下来,打开 Ollama,可以看到熟悉的聊天窗口环境:

我们此时可以在多种大模型中任性选择,在第一次使用(调用)之前 Ollama 会自动为我们下载大模型的对应文件:

注意,参数越多的大模型体积也会越大,比如 OpenAI 最新的开源大模型 gpt-oss:20b 体积大约为 12 GB 左右。

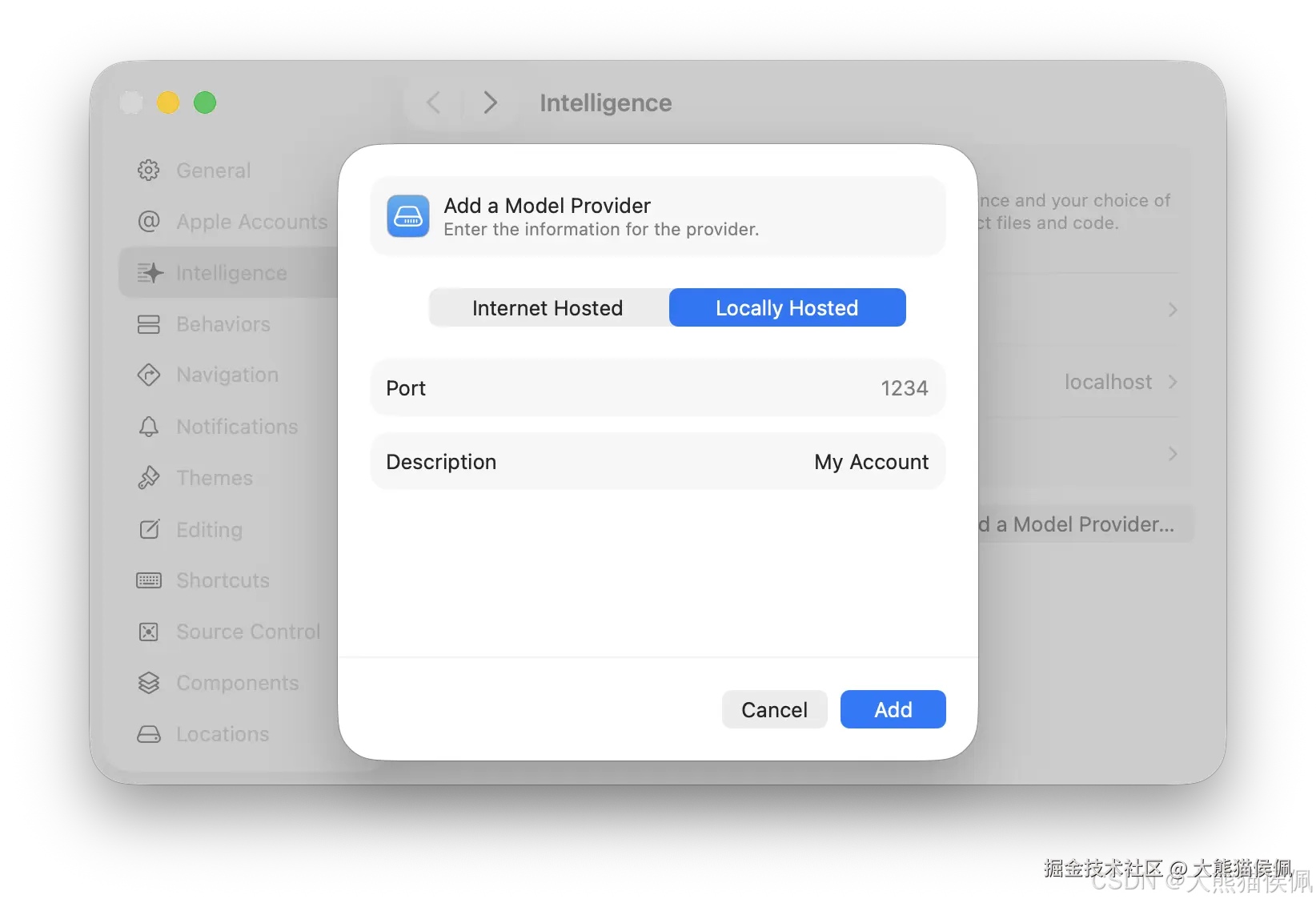

Ollama 运行后会默认创建本地 API 调用地址:

所以,我们需要在 Xcode 中配置正确的端口号:

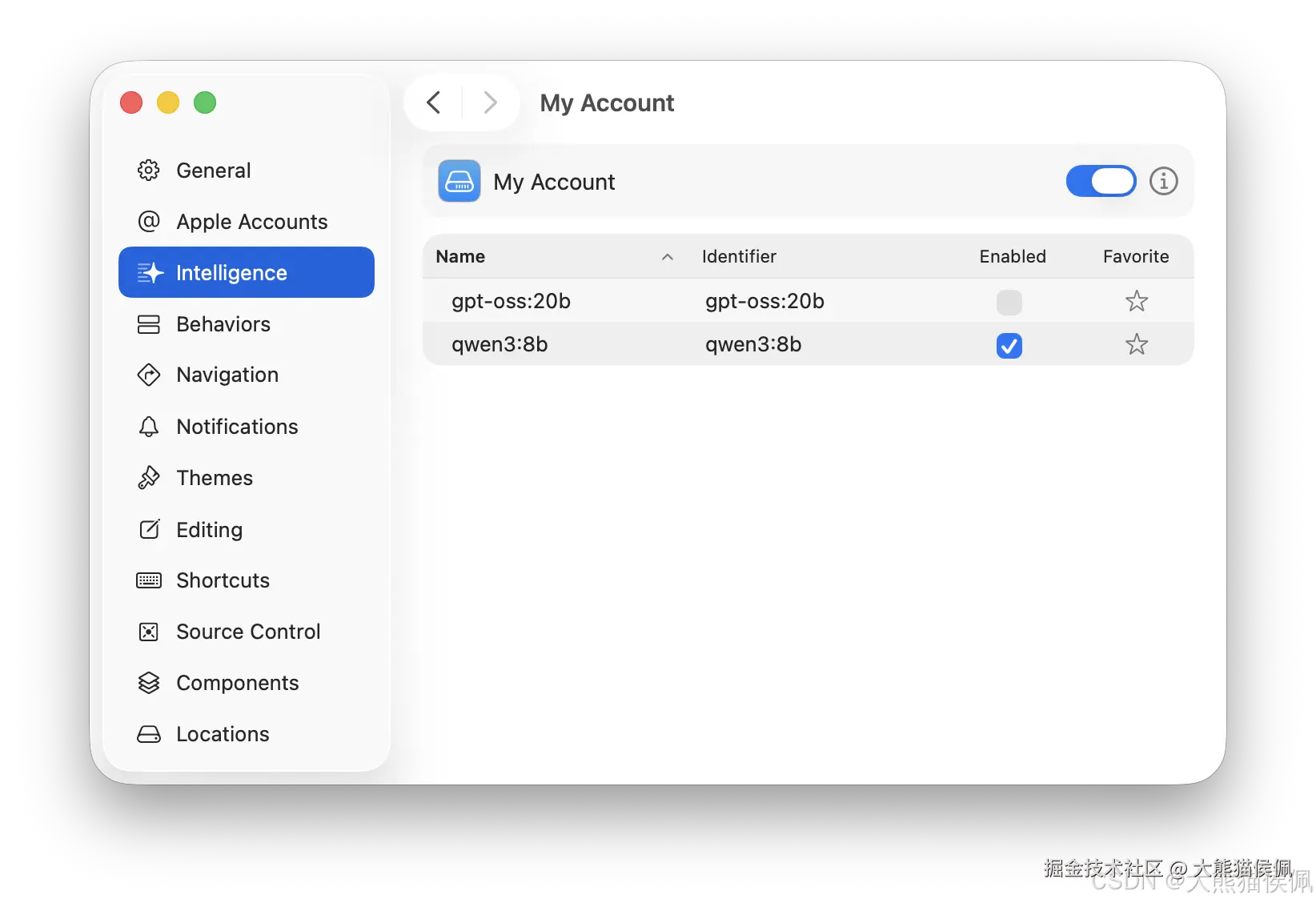

在 Xcode 连接上 Ollama 之后,如果 Ollama 中包含了多个大模型,我们可以进一步选择所需的大模型:

4. 在 Xcode 中使用 AI Coding Intelligence

在大模型配置完毕之后,在 Xcode 使用起来简直轻松的不要不要的。

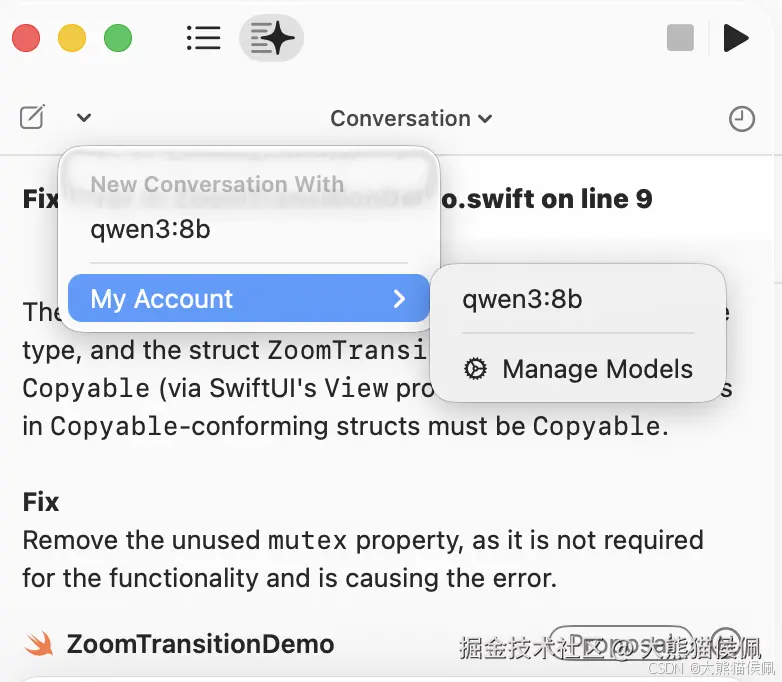

首先,我们可以选择想要沟通的大模型类型:

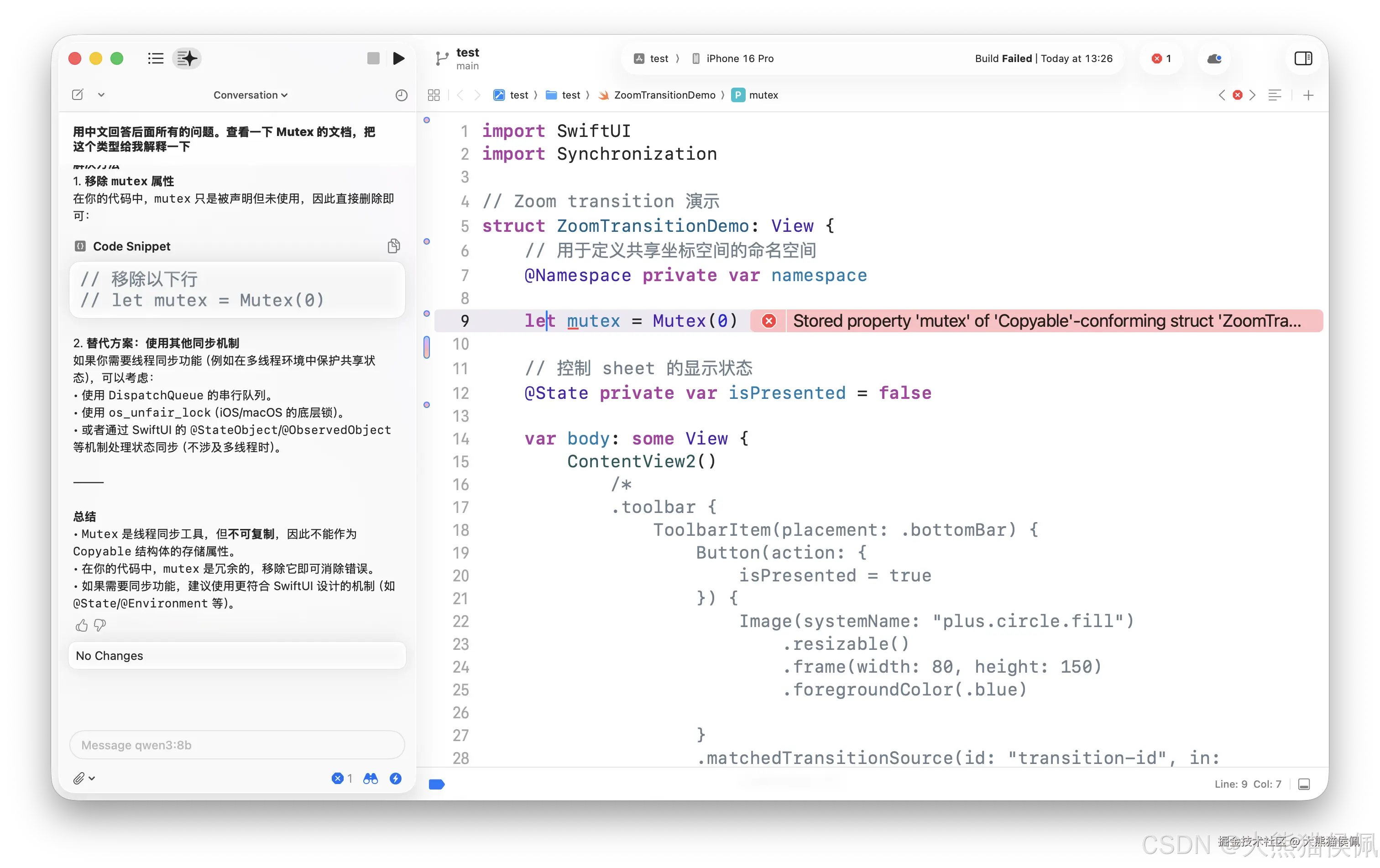

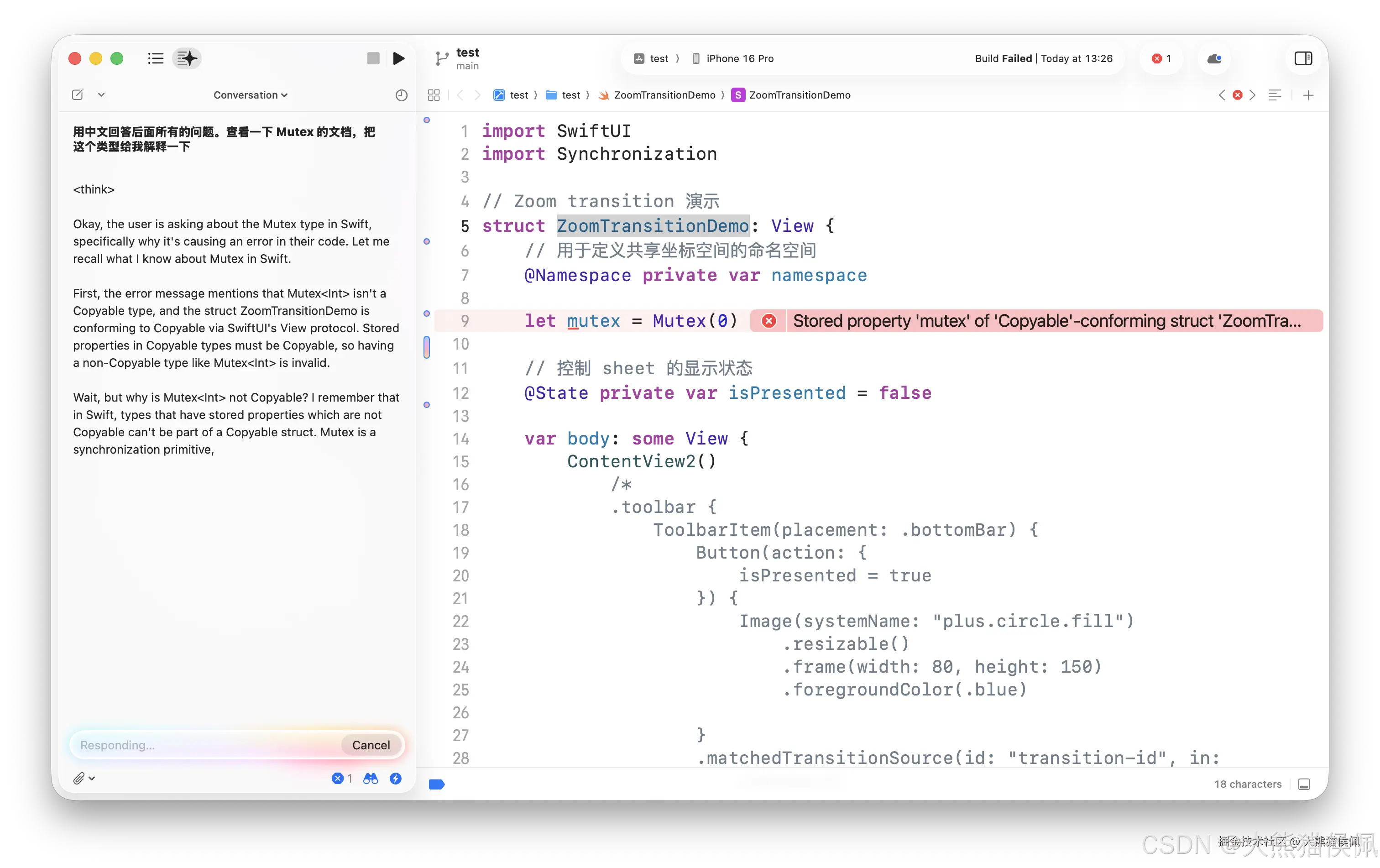

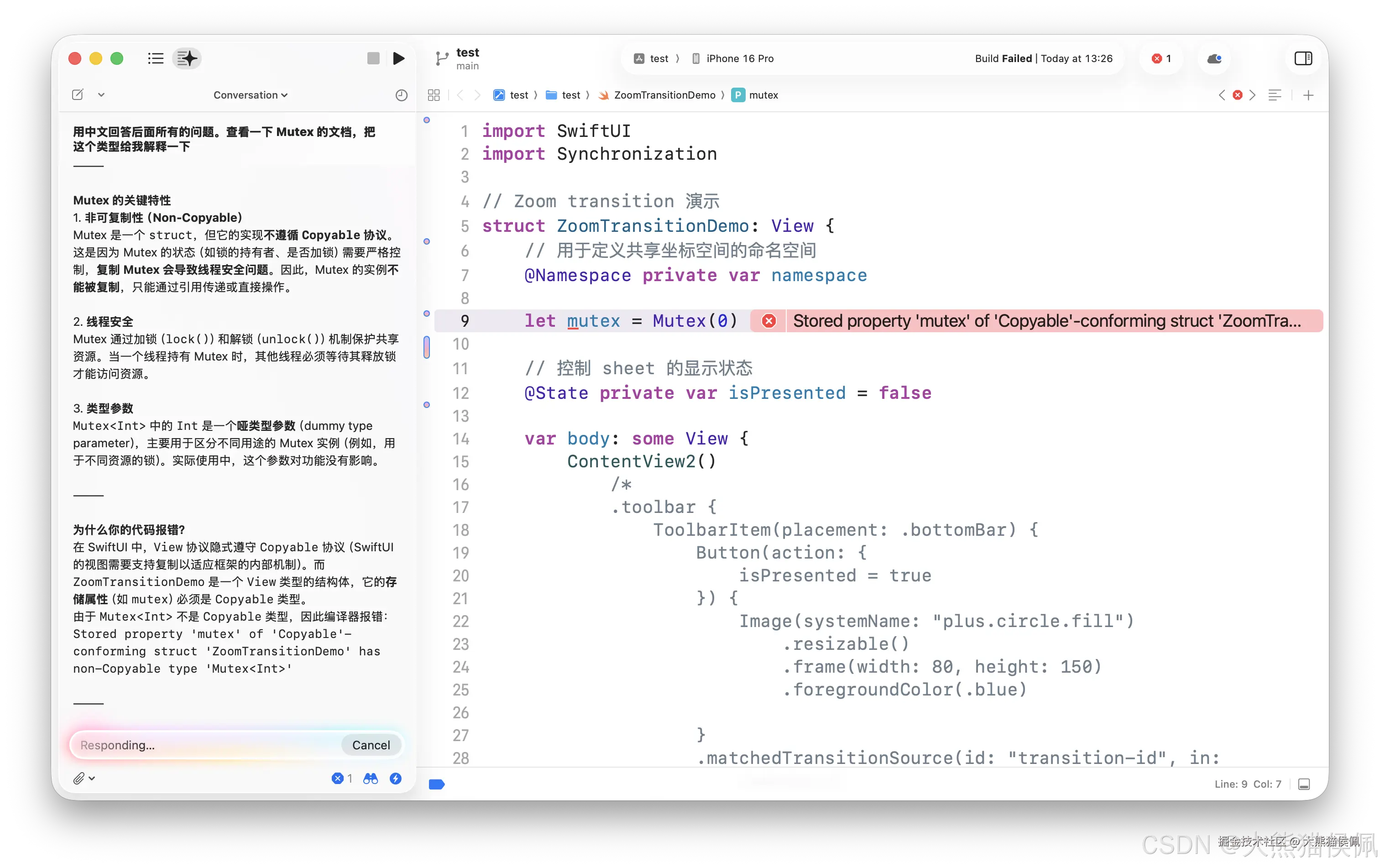

接下来的使用就和 Cursor 之类的 AI 辅助撸码 IDE 差不多了。比如,在 Xcode 里我们可以让 AI 解释一段代码的功能:

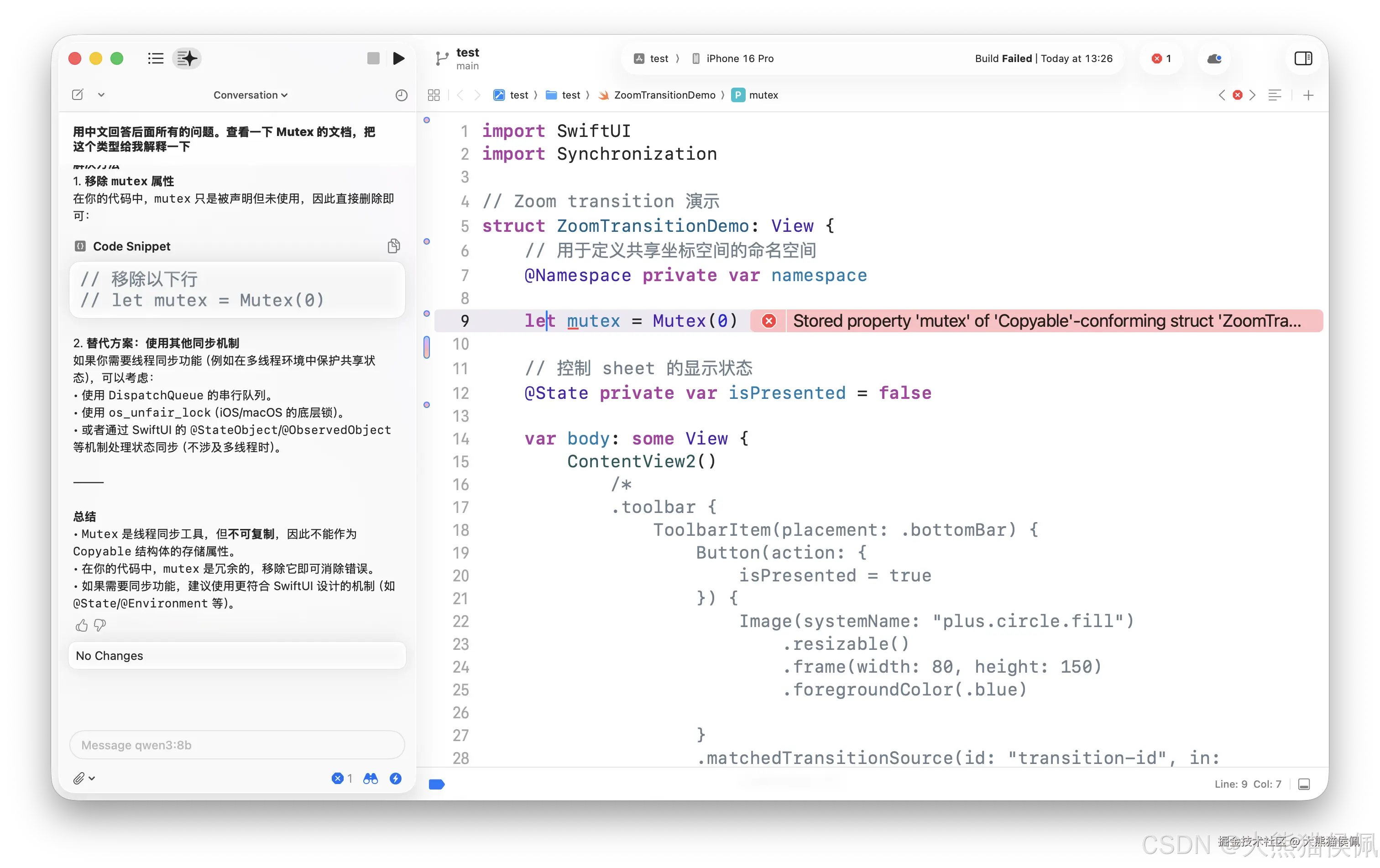

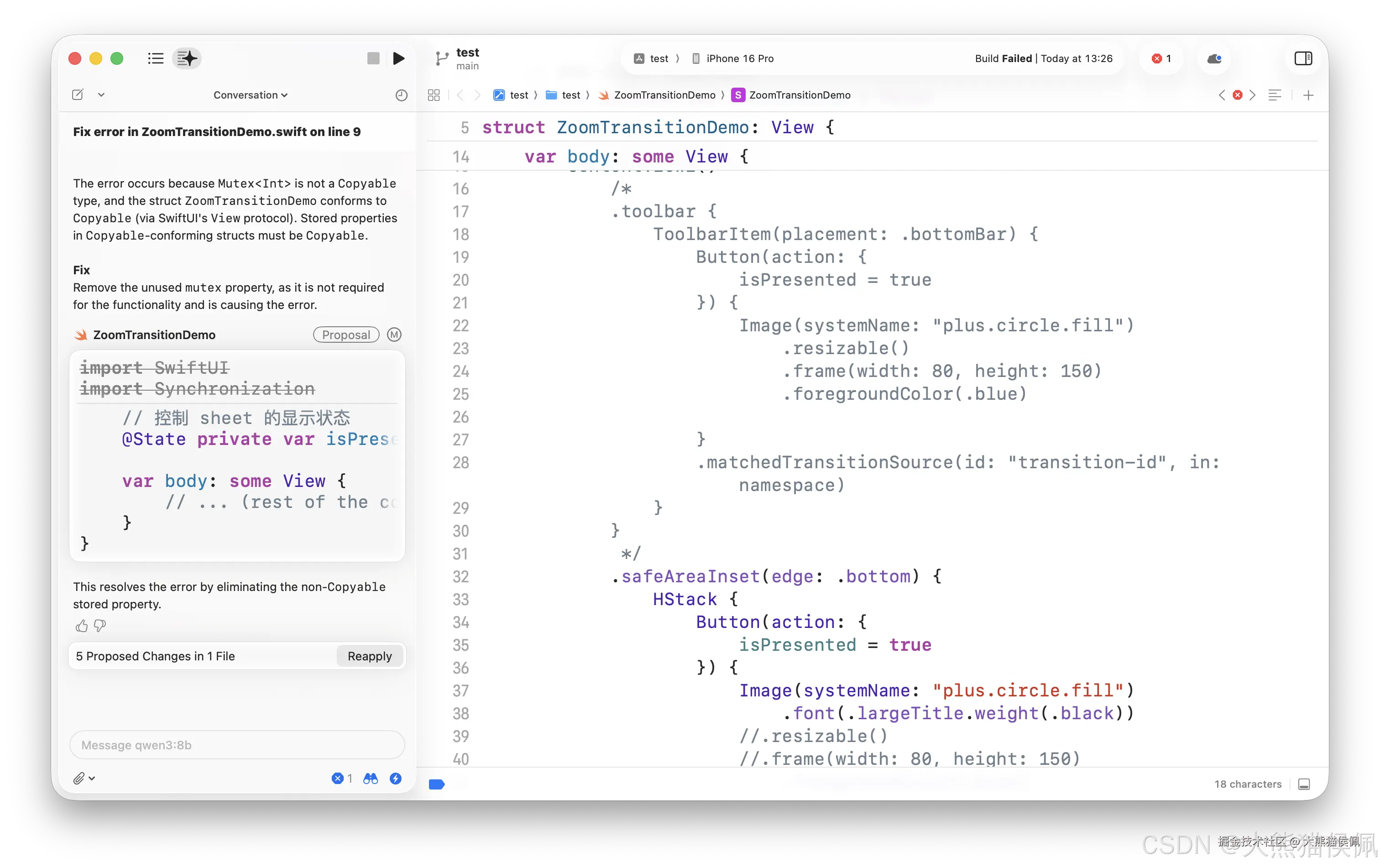

或者让 AI 提供问题的解决方案:

甚至干脆让它直接动手为我们撸码来排忧解难:

5. 扩展

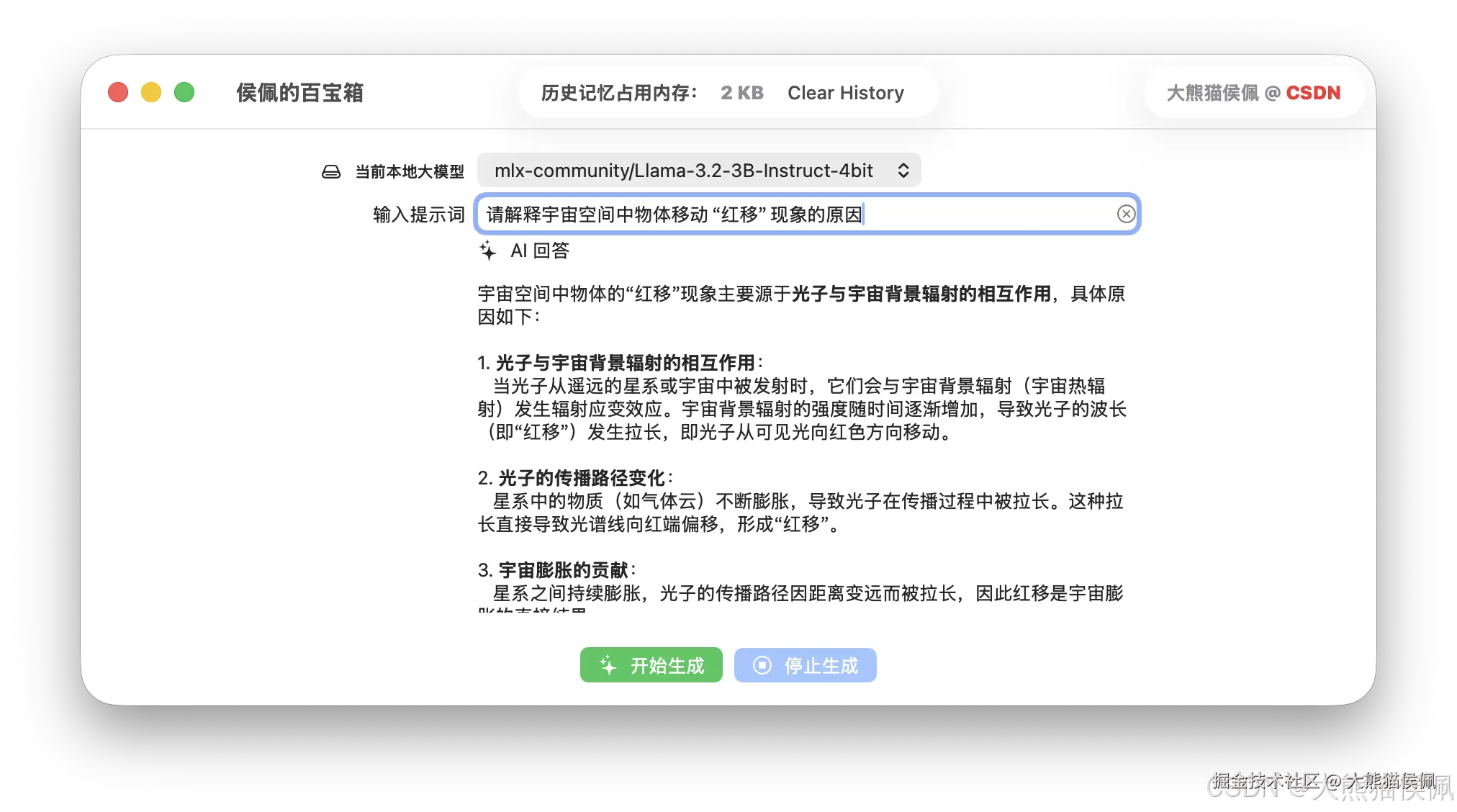

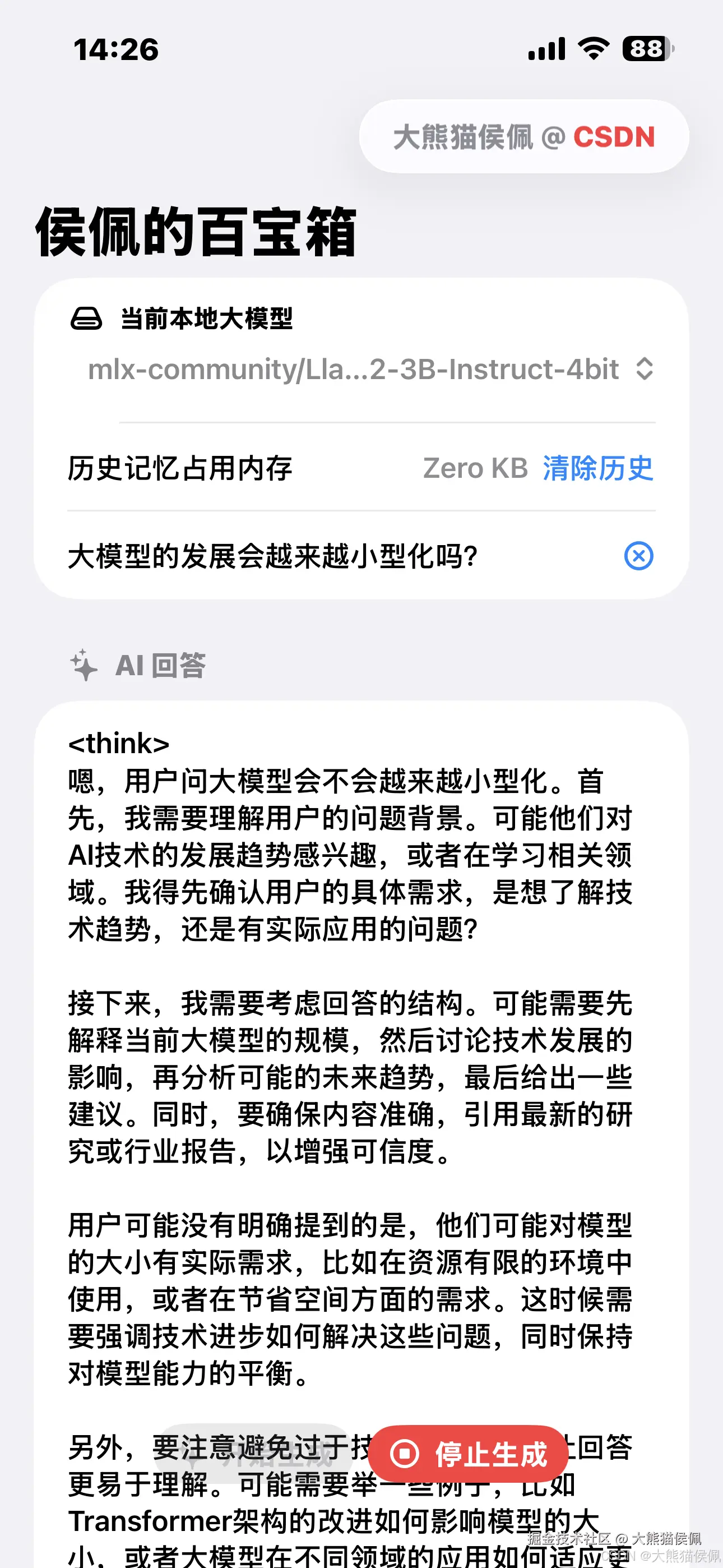

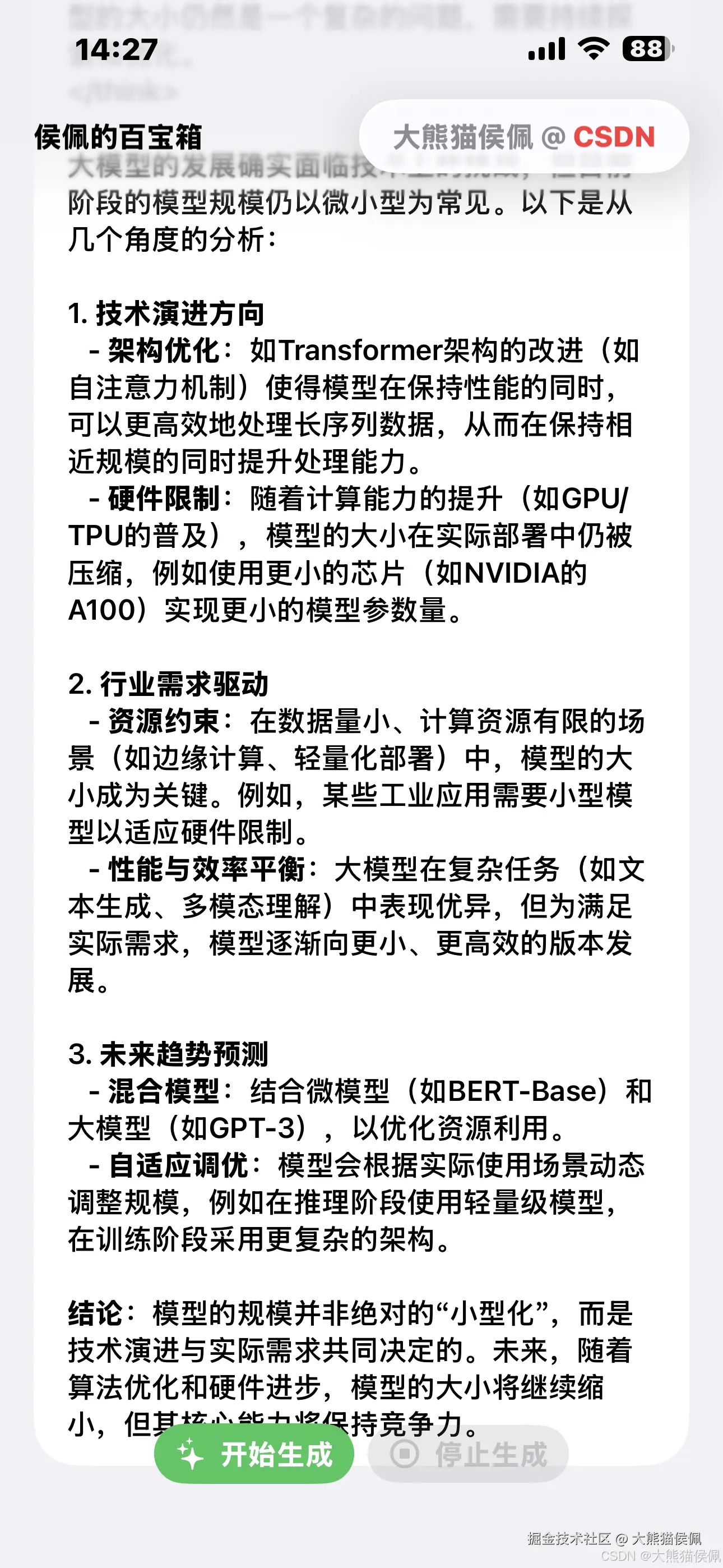

现在,在 mac 或 iPhone 上本地嵌入大模型已成为一种趋势,大模型一个维度也在向小型化、浓缩化蓬勃发展着:

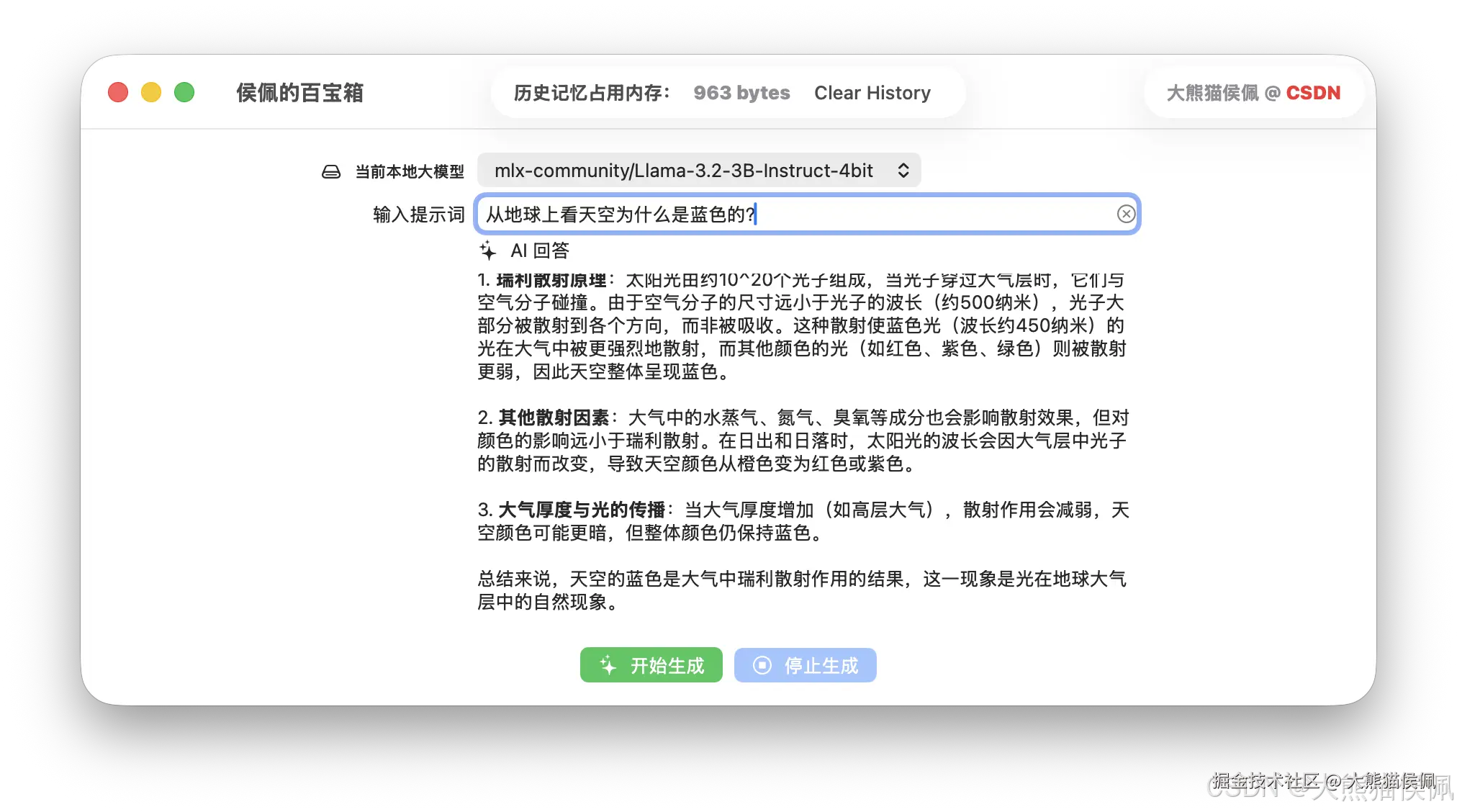

比如,在上面我编写的 APP 中用仅仅 0.6B 的"小"模型(700MB不到)就在 mac 上较好的回答了用户的问题。

同样的"小模型",在 iPhone 对应的 App 中运行起来也是如鱼得水,怡然自得:

看到这里,小伙伴们有没有一丢丢的心动呢?

心动不如行动,是时候操练起来了哦!棒棒哒!💯

感谢宝子们的观看,再会啦!8-)