文章目录

- 自动混合精度示例

-

- 典型的混合精度训练

- 处理未缩放梯度

- 处理缩放梯度

- 处理多个模型、损失函数和优化器

- [多 GPU 工作环境下的注意事项](#多 GPU 工作环境下的注意事项)

- 自动混合精度与自定义自动求导函数

-

- 支持多输入或自动转换操作的功能

- [需要特定 `dtype` 的函数](#需要特定

dtype的函数)

- 自动微分机制

-

- 自动微分如何编码历史记录

- 不可微函数的梯度计算

- 局部禁用梯度计算

-

- [设置 `requires_grad`](#设置

requires_grad) - 梯度模式

- 默认模式(梯度模式)

- 无梯度模式

- 推理模式

- [评估模式 (`nn.Module.eval()`)](#评估模式 (

nn.Module.eval()))

- [设置 `requires_grad`](#设置

- 自动求导中的原地操作

- 多线程自动求导

-

- [CPU 并发处理](#CPU 并发处理)

- 非确定性行为

- 图保留机制

- Autograd节点的线程安全性

- C++钩子的线程安全性问题

- 复数自动求导

- 张量保存的钩子函数

- 反向钩子执行机制

-

- 特定钩子何时会被触发

- 不同钩子的触发顺序

- 特殊钩子

- [当张量被原地修改时 Tensor hooks 的行为表现](#当张量被原地修改时 Tensor hooks 的行为表现)

- 广播语义

- CPU线程与TorchScript推理

- [CUDA 语义](#CUDA 语义)

-

- [Ampere(及后续)设备上的 TensorFloat-32 (TF32)](#Ampere(及后续)设备上的 TensorFloat-32 (TF32))

- [FP16 GEMM中的降低精度计算](#FP16 GEMM中的降低精度计算)

- [BF16 GEMM中的降低精度缩减](#BF16 GEMM中的降低精度缩减)

- [FP16 GEMM 中的全 FP16 累加](#FP16 GEMM 中的全 FP16 累加)

- 异步执行

-

- [CUDA 流](#CUDA 流)

- 反向传播的流语义

-

- [BC 说明:在默认流上使用梯度](#BC 说明:在默认流上使用梯度)

- 内存管理

-

- [使用 `PYTORCH_CUDA_ALLOC_CONF` 优化内存占用](#使用

PYTORCH_CUDA_ALLOC_CONF优化内存占用)

- [使用 `PYTORCH_CUDA_ALLOC_CONF` 优化内存占用](#使用

- 为CUDA使用自定义内存分配器

- 在同一程序中混合使用不同的CUDA系统分配器

- [cuBLAS 工作空间](#cuBLAS 工作空间)

- [cuFFT 计划缓存](#cuFFT 计划缓存)

- 即时编译

- 最佳实践

- [CUDA 图](#CUDA 图)

- 分布式数据并行

-

- 示例

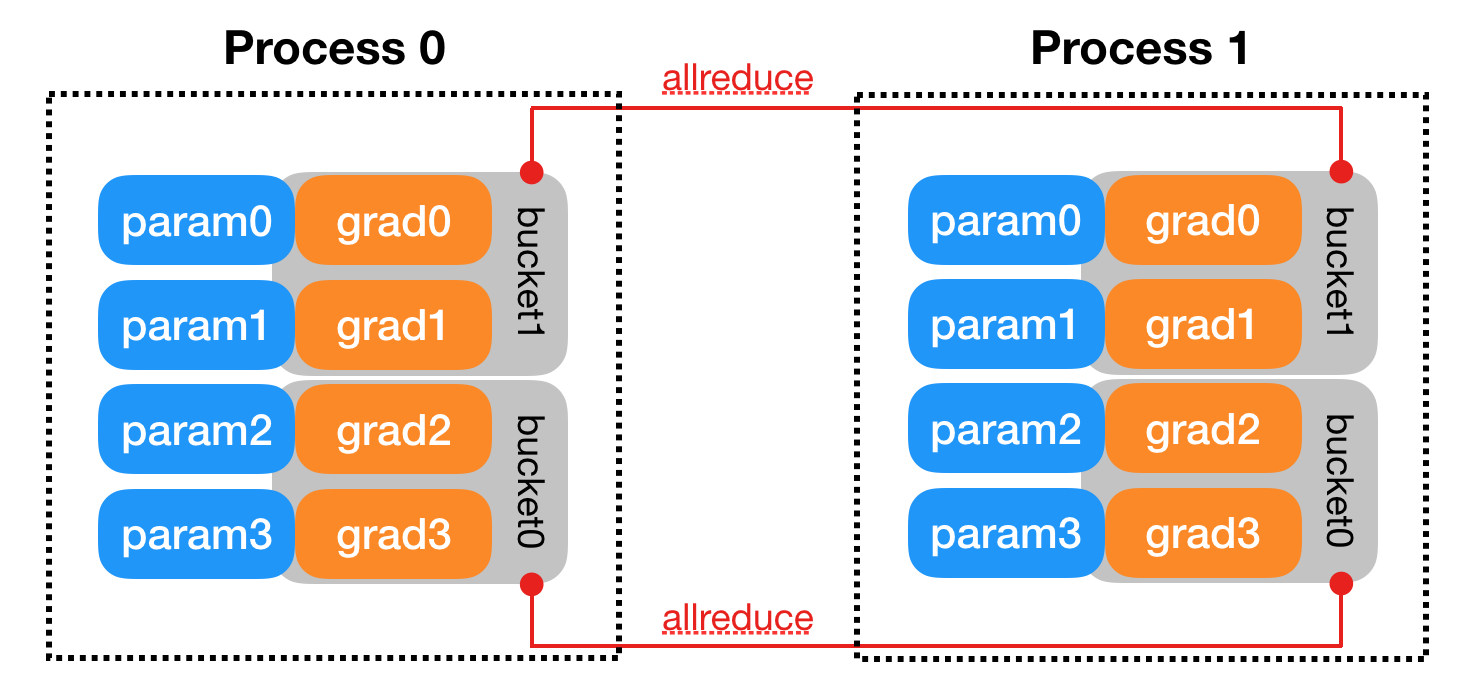

- 内部设计

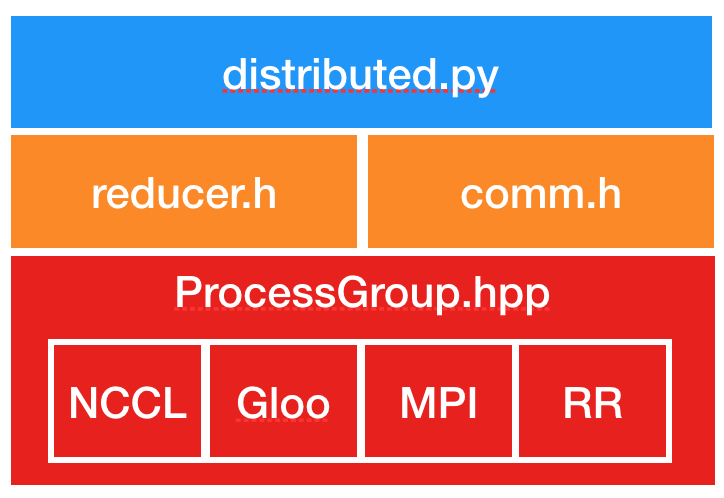

- 实现

-

- 进程组

- 分布式数据并行 (DistributedDataParallel)

- [TorchDynamo DDPOptimizer(分布式数据并行优化器)](#TorchDynamo DDPOptimizer(分布式数据并行优化器))

- [扩展 PyTorch](#扩展 PyTorch)

-

- 添加新运算符

- 扩展 [`torch.autograd`](https://pytorch.org/docs/stable/autograd.html#module-torch.autograd "torch.autograd"))

-

- 何时使用自定义函数

- 何时不应使用

- 使用方法

- 示例

- 合并或分离 [`forward()`](https://pytorch.org/docs/stable/generated/torch.autograd.Function.forward.html#torch.autograd.Function.forward "torch.autograd.Function.forward") 与 `setup_context()` 与

setup_context()) - 前向模式自动微分

- [`torch.func`](https://pytorch.org/docs/stable/func.api.html#module-torch.func "torch.func") 转换和/或 [`torch.vmap()`](https://pytorch.org/docs/stable/generated/torch.vmap.html#torch.vmap "torch.vmap") 转换和/或

torch.vmap())

- 扩展 [`torch.nn`](https://pytorch.org/docs/stable/nn.html#module-torch.nn "torch.nn"))

- 扩展 [`torch`](https://pytorch.org/docs/stable/torch.html#module-torch "torch") Python API Python API)

-

- 扩展 [`torch`](https://pytorch.org/docs/stable/torch.html#module-torch "torch") 实现类 `Tensor` 类型 实现类

Tensor类型) - [继承 `torch.Tensor` 类](#继承

torch.Tensor类) - 扩展 [`torch`](https://pytorch.org/docs/stable/torch.html#module-torch "torch") 的 `Tensor` 包装类型 的

Tensor包装类型) - 对定义了`torch_function`的多种类型进行操作

- [PyTorch API 覆盖测试范围](#PyTorch API 覆盖测试范围)

- 扩展 [`torch`](https://pytorch.org/docs/stable/torch.html#module-torch "torch") 实现类 `Tensor` 类型 实现类

- 扩展 [`torch`](https://pytorch.org/docs/stable/torch.html#module-torch "torch") 原生 API 原生 API)

-

- [`torch_dispatch` 调用约定](#

__torch_dispatch__调用约定)

- [`torch_dispatch` 调用约定](#

- 通过模式扩展所有 [`torch`](https://pytorch.org/docs/stable/torch.html#module-torch "torch") API API)

- [使用 autograd.Function 扩展 torch.func](#使用 autograd.Function 扩展 torch.func)

-

- 基础用法

- [`torch.vmap()` 支持](#

torch.vmap()支持) -

- 自动生成vmap规则

- [定义 vmap 静态方法](#定义 vmap 静态方法)

- [`torch.func.jvp()` 支持](#

torch.func.jvp()支持)

- 常见问题解答

-

- [我的模型报错"cuda runtime error(2): out of memory"](#我的模型报错"cuda runtime error(2): out of memory")

- 我的GPU内存未正确释放

- 我的内存不足异常处理程序无法分配内存

- 我的数据加载工作进程返回相同的随机数

- 我的循环神经网络在数据并行环境下无法正常工作

- [FSDP 说明文档](#FSDP 说明文档)

- [英特尔 GPU 入门指南](#英特尔 GPU 入门指南)

-

- 硬件要求

-

- [英特尔数据中心 GPU](#英特尔数据中心 GPU)

- [英特尔客户端 GPU](#英特尔客户端 GPU)

- 软件前提条件

- 安装

- [检查 Intel GPU 的可用性](#检查 Intel GPU 的可用性)

- 最小代码改动

- 示例

-

- 推理示例

-

- 使用FP32进行推理

- 使用AMP进行推理

- [使用 `torch.compile` 进行推理](#使用

torch.compile进行推理)

- 训练示例

-

- [使用 FP32 进行训练](#使用 FP32 进行训练)

- [使用 AMP 进行训练](#使用 AMP 进行训练)

- [使用 `torch.compile` 进行训练](#使用

torch.compile进行训练)

- 梯度检验机制

-

- 符号约定与背景信息

- 默认反向模式梯度检查行为

- 快速反向模式梯度检查

- [Gradgradcheck 实现](#Gradgradcheck 实现)

- [HIP (ROCm) 语义说明](#HIP (ROCm) 语义说明)

-

- [HIP 接口复用 CUDA 接口](#HIP 接口复用 CUDA 接口)

- [检查 HIP 支持](#检查 HIP 支持)

- [ROCm 上的 TensorFloat-32 (TF32)](#ROCm 上的 TensorFloat-32 (TF32))

- 内存管理

- [hipBLAS 工作空间](#hipBLAS 工作空间)

- [hipFFT/rocFFT 计划缓存](#hipFFT/rocFFT 计划缓存)

- [torch.distributed 后端支持](#torch.distributed 后端支持)

- [C++中CUDA API到HIP API的映射](#C++中CUDA API到HIP API的映射)

- 请参阅CUDA语义文档

- 启用内核断言

- 大规模部署特性

-

- 全集群算子性能分析

- [API 使用日志记录](#API 使用日志记录)

- 为保存的TorchScript模型附加元数据

- 构建环境注意事项

- 常见扩展点

- [LibTorch 稳定ABI](#LibTorch 稳定ABI)

-

- [如何使用基于堆栈的 API](#如何使用基于堆栈的 API)

- 模块

- [MPS 后端](#MPS 后端)

- 多进程最佳实践

-

- 多进程中的CUDA

- 最佳实践与技巧

- 多进程中的CPU问题

-

- [CPU 超配](#CPU 超配)

- [避免 CPU 过载](#避免 CPU 过载)

- 数值精度

-

- 批处理计算或切片计算

- 极值问题

- 线性代数 (`torch.linalg`)

- [Nvidia Ampere(及后续)设备上的TensorFloat-32(TF32)](#Nvidia Ampere(及后续)设备上的TensorFloat-32(TF32))

- [FP16与BF16 GEMM运算的降低精度累加](#FP16与BF16 GEMM运算的降低精度累加)

- 针对FP16和BF16在缩放点积注意力(SDPA)中的降低精度优化

- [AMD Instinct MI200 设备上降低精度的 FP16 和 BF16 GEMM 及卷积运算](#AMD Instinct MI200 设备上降低精度的 FP16 和 BF16 GEMM 及卷积运算)

- 可复现性

-

- 控制随机性来源

-

- [PyTorch 随机数生成器](#PyTorch 随机数生成器)

- Python

- 其他库中的随机数生成器

- CUDA卷积性能基准测试

- 避免使用非确定性算法

-

- [CUDA 卷积确定性](#CUDA 卷积确定性)

- [CUDA RNN 与 LSTM](#CUDA RNN 与 LSTM)

- 填充未初始化内存

- DataLoader

- 序列化语义

-

- 张量的保存与加载

- 保存和加载张量会保留视图关系

- [保存和加载 torch.nn.Modules](#保存和加载 torch.nn.Modules)

自动混合精度示例

https://pytorch.org/docs/stable/notes/amp_examples.html

通常来说,"自动混合精度训练"指的是同时使用 torch.autocast 和 torch.amp.GradScaler 进行训练。

torch.autocast 实例能够为选定区域启用自动类型转换功能。自动类型转换会智能选择操作的计算精度,在保持准确性的同时提升性能。

torch.amp.GradScaler 实例则帮助便捷地执行梯度缩放步骤。梯度缩放通过最小化梯度下溢(underflow)问题,可以改善使用 float16 梯度(在CUDA和XPU设备上默认使用)的神经网络收敛性,具体原理参见此处。

torch.autocast 和 torch.amp.GradScaler 是模块化设计的。在以下示例中,每个组件都按照其官方文档建议的方式使用。

(本文示例仅作演示用途,可运行的完整教程请参阅自动混合精度实践指南)

典型的混合精度训练

python

# Creates model and optimizer in default precision

model = Net().cuda()

optimizer = optim.SGD(model.parameters(),

...)

# Creates a GradScaler once at the beginning of training.

scaler = GradScaler()

for epoch in epochs:

for input, target in data:

optimizer.zero_grad()

# Runs the forward pass with autocasting.

with autocast(device_type='cuda', dtype=torch.float16):

output = model(input)

loss = loss_fn(output, target)

# Scales loss. Calls backward() on scaled loss to create scaled gradients.

# Backward passes under autocast are not recommended.

# Backward ops run in the same dtype autocast chose for corresponding forward ops.

scaler.scale(loss).backward()

# scaler.step() first unscales the gradients of the optimizer's assigned params.

# If these gradients do not contain infs or NaNs, optimizer.step() is then called, # otherwise, optimizer.step() is skipped.

scaler.step(optimizer)

# Updates the scale for next iteration.

scaler.update()处理未缩放梯度

通过scaler.scale(loss).backward()生成的所有梯度都经过缩放。若您需要在backward()和scaler.step(optimizer)之间修改或检查参数的.grad属性,应当先对其进行反缩放处理。例如,梯度裁剪操作会调整一组梯度,使其全局范数(参见torch.nn.utils.clip_grad_norm_())或最大幅度(参见torch.nn.utils.clip_grad_value_())小于等于用户设定的阈值。如果尝试在未反缩放 的情况下进行裁剪,梯度的范数/最大幅度也会保持缩放状态,这将导致您设定的阈值(本应针对未缩放梯度)失效。

scaler.unscale_(optimizer)方法可对optimizer所分配参数的梯度进行反缩放。如果您的模型包含其他被分配给不同优化器(例如optimizer2)的参数,可以单独调用scaler.unscale_(optimizer2)来反缩放这些参数的梯度。

梯度裁剪

在裁剪之前调用 scaler.unscale_(optimizer) 可以像往常一样对未缩放的梯度进行裁剪:

python

scaler = GradScaler()

for epoch in epochs:

for input, target in data:

optimizer.zero_grad()

with autocast(device_type='cuda', dtype=torch.float16):

output = model(input)

loss = loss_fn(output, target)

scaler.scale(loss).backward()

# Unscales the gradients of optimizer's assigned params in-place

scaler.unscale_(optimizer)

# Since the gradients of optimizer's assigned params are unscaled, clips as usual:

torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm)

# optimizer's gradients are already unscaled, so scaler.step does not unscale them, # although it still skips optimizer.step() if the gradients contain infs or NaNs.

scaler.step(optimizer)

# Updates the scale for next iteration.

scaler.update()scaler 记录显示当前迭代中已对优化器调用了 scaler.unscale_(optimizer),因此 scaler.step(optimizer) 知道无需在(内部)调用 optimizer.step() 之前重复反缩放梯度。

警告:每个优化器在每次 step 调用期间,仅应在所有关联参数的梯度累积完成后调用一次 unscale_。若在两次 step 之间对同一优化器重复调用 unscale_,将触发 RuntimeError。

处理缩放梯度

梯度累积

梯度累积会在一个有效批次(大小为 batch_per_iter * iters_to_accumulate,如果是分布式训练则乘以 * num_procs)上累加梯度。缩放因子应针对有效批次进行校准,这意味着:

- 在有效批次粒度上进行 inf/NaN 检查

- 如果发现梯度包含 inf/NaN 则跳过该步骤

- 缩放因子的更新也应在有效批次粒度上完成

此外,在累积某个有效批次的梯度时,梯度应保持缩放状态,且缩放因子必须保持不变。如果在累积完成前对梯度取消缩放(或改变了缩放因子),下一次反向传播会将缩放后的梯度与未缩放的梯度(或以不同因子缩放的梯度)相加,导致无法恢复累积的未缩放梯度。因此,step 操作必须应用这些条件。

若需对梯度执行 unscale_ 操作(例如为了实现未缩放梯度的裁剪),请在调用 step 前立即调用 unscale_,且确保所有待执行 step 的(已缩放)梯度已完成累积。另外,仅在完整处理完一个有效批次并调用 step 的迭代结束时,才调用 update。

python

scaler = GradScaler()

for epoch in epochs:

for i, (input, target) in enumerate(data):

with autocast(device_type='cuda', dtype=torch.float16):

output = model(input)

loss = loss_fn(output, target)

loss = loss / iters_to_accumulate

# Accumulates scaled gradients.

scaler.scale(loss).backward()

if (i + 1) % iters_to_accumulate == 0:

# may unscale_ here if desired (e.g., to allow clipping unscaled gradients)

scaler.step(optimizer)

scaler.update()

optimizer.zero_grad()梯度惩罚

常见的梯度惩罚实现会使用 torch.autograd.grad() 生成梯度,将这些梯度组合成惩罚值,然后将惩罚值添加到损失函数中。

以下是一个未进行梯度缩放或自动混合精度的普通 L2 惩罚示例:

python

for epoch in epochs:

for input, target in data:

optimizer.zero_grad()

output = model(input)

loss = loss_fn(output, target)

# Creates gradients

grad_params = torch.autograd.grad(outputs=loss,

inputs=model.parameters(),

create_graph=True)

# Computes the penalty term and adds it to the loss

grad_norm = 0

for grad in grad_params:

grad_norm += grad.pow(2).sum()

grad_norm = grad_norm.sqrt()

loss = loss + grad_norm

loss.backward()

# clip gradients here, if desired

optimizer.step()为了实现带有梯度缩放的梯度惩罚,传递给 torch.autograd.grad() 的 outputs 张量需要进行缩放处理。这样得到的梯度也会被缩放,因此在合并生成惩罚值之前需要先进行反缩放操作。

此外,惩罚项的计算属于前向传播过程,因此应当放在 autocast 上下文环境中执行。

以下是相同 L2 惩罚项的实现示例:

python

scaler = GradScaler()

for epoch in epochs:

for input, target in data:

optimizer.zero_grad()

with autocast(device_type='cuda', dtype=torch.float16):

output = model(input)

loss = loss_fn(output, target)

# Scales the loss for autograd.grad's backward pass, producing scaled_grad_params

scaled_grad_params = torch.autograd.grad(outputs=scaler.scale(loss), inputs=model.parameters(), create_graph=True)

# Creates unscaled grad_params before computing the penalty. scaled_grad_params are # not owned by any optimizer, so ordinary division is used instead of scaler.unscale_:

inv_scale = 1./scaler.get_scale()

grad_params = [p * inv_scale for p in scaled_grad_params]

# Computes the penalty term and adds it to the loss

with autocast(device_type='cuda', dtype=torch.float16):

grad_norm = 0

for grad in grad_params:

grad_norm += grad.pow(2).sum()

grad_norm = grad_norm.sqrt()

loss = loss + grad_norm

# Applies scaling to the backward call as usual.

# Accumulates leaf gradients that are correctly scaled.

scaler.scale(loss).backward()

# may unscale_ here if desired (e.g., to allow clipping unscaled gradients)

# step() and update() proceed as usual.

scaler.step(optimizer)

scaler.update()处理多个模型、损失函数和优化器

如果网络包含多个损失函数,必须对每个损失函数单独调用 scaler.scale。

如果网络包含多个优化器,可以单独对任意优化器调用 scaler.unscale_,但必须对每个优化器单独调用 scaler.step。

需要注意的是,scaler.update 只需在所有优化器完成当前迭代的 step 操作后调用一次。

python

scaler = torch.amp.GradScaler()

for epoch in epochs:

for input, target in data:

optimizer0.zero_grad()

optimizer1.zero_grad()

with autocast(device_type='cuda', dtype=torch.float16):

output0 = model0(input)

output1 = model1(input)

loss0 = loss_fn(2 * output0 + 3 * output1, target)

loss1 = loss_fn(3 * output0 - 5 * output1, target)

# (retain_graph here is unrelated to amp, it's present because in this

# example, both backward() calls share some sections of graph.)

scaler.scale(loss0).backward(retain_graph=True)

scaler.scale(loss1).backward()

# You can choose which optimizers receive explicit unscaling, if you # want to inspect or modify the gradients of the params they own.

scaler.unscale_(optimizer0)

scaler.step(optimizer0)

scaler.step(optimizer1)

scaler.update()每个优化器都会检查其梯度是否存在无穷大/NaN值,并独立决定是否跳过当前步骤。这可能导致一个优化器跳过步骤,而另一个优化器继续执行。由于跳步情况很少发生(每几百次迭代才出现一次),因此不会影响模型收敛。如果您在给多优化器模型添加梯度缩放后观察到收敛效果不佳,请提交错误报告。

多 GPU 工作环境下的注意事项

此处描述的问题仅影响 autocast 功能,GradScaler 的使用方式保持不变。

单进程中的DataParallel

即使 torch.nn.DataParallel 会生成线程在每个设备上运行前向传播,自动转换状态也会在每个线程中传递,因此以下代码可以正常工作:

python

model = MyModel()

dp_model = nn.DataParallel(model)

# Sets autocast in the main thread

with autocast(device_type='cuda', dtype=torch.float16):

# dp_model's internal threads will autocast.

output = dp_model(input)

# loss_fn also autocast

loss = loss_fn(output)分布式数据并行:每个进程对应一个GPU

torch.nn.parallel.DistributedDataParallel的文档建议,每个进程使用一个GPU以获得最佳性能。在这种情况下,DistributedDataParallel不会在内部生成线程,因此autocast和GradScaler的使用不受影响。

每个进程使用多块GPU的DistributedDataParallel

torch.nn.parallel.DistributedDataParallel 可能会像 torch.nn.DataParallel 那样,为每个设备启动一个侧线程来运行前向传播。解决方法相同:在模型的forward方法中应用autocast,确保侧线程中启用了该功能。

自动混合精度与自定义自动求导函数

如果您的网络使用了自定义自动求导函数(torch.autograd.Function的子类),在以下情况下需要进行修改以确保与自动混合精度兼容:

- 函数接收多个浮点类型的张量输入

- 函数内部包含任何可自动混合精度的操作(参见自动混合精度操作参考)

- 函数需要特定的

dtype(例如,当函数封装了仅针对特定dtype编译的CUDA扩展时)

对于所有情况,如果您正在导入该函数且无法修改其定义,一个安全的备选方案是:在出现错误的使用点禁用自动混合精度,并强制使用float32(或所需dtype)执行。

python

with autocast(device_type='cuda', dtype=torch.float16):

...

with autocast(device_type='cuda', dtype=torch.float16, enabled=False):

output = imported_function(input1.float(), input2.float())如果你是函数的作者(或能修改其定义),更好的解决方案是使用 torch.amp.custom_fwd() 和 torch.amp.custom_bwd() 装饰器,如下文相关案例所示。

支持多输入或自动转换操作的功能

对 forward 和 backward 分别应用 custom_fwd 和 custom_bwd(无需参数)。这能确保 forward 在当前自动转换状态下执行,而 backward 则与 forward 保持相同的自动转换状态(可避免类型不匹配错误):

python

class MyMM(torch.autograd.Function):

@staticmethod

@custom_fwd

def forward(ctx, a, b):

ctx.save_for_backward(a, b)

return a.mm(b)

@staticmethod

@custom_bwd

def backward(ctx, grad):

a, b = ctx.saved_tensors

return grad.mm(b.t()), a.t().mm(grad)现在可以随时随地调用 MyMM,无需禁用自动类型转换或手动转换输入:

python

mymm = MyMM.apply

with autocast(device_type='cuda', dtype=torch.float16):

output = mymm(input1, input2)需要特定 dtype 的函数

考虑一个需要 torch.float32 输入的自定义函数。

对 forward 应用 custom_fwd(device_type='cuda', cast_inputs=torch.float32),

对 backward 应用 custom_bwd(device_type='cuda')。

如果 forward 在启用自动混合精度(autocast)的区域中运行,这些装饰器会将浮点张量输入转换为参数 device_type 指定的设备(本例中为 CUDA)上的 float32 类型,并在 forward 和 backward 期间局部禁用自动混合精度。

python

class MyFloat32Func(torch.autograd.Function):

@staticmethod

@custom_fwd(device_type='cuda', cast_inputs=torch.float32)

def forward(ctx, input):

ctx.save_for_backward(input)

...

return fwd_output

@staticmethod

@custom_bwd(device_type='cuda')

def backward(ctx, grad):

...现在可以随处调用 MyFloat32Func,无需手动禁用自动类型转换或转换输入参数:

python

func = MyFloat32Func.apply

with autocast(device_type='cuda', dtype=torch.float16):

# func will run in float32, regardless of the surrounding autocast state

output = func(input)自动微分机制

https://pytorch.org/docs/stable/notes/autograd.html

本说明将概述自动微分(autograd)的工作原理及其操作记录方式。虽然并非必须完全理解这些内容,但我们建议您熟悉它,因为这将帮助您编写更高效、更简洁的程序,并有助于调试工作。

自动微分如何编码历史记录

Autograd 是一个反向自动微分系统。从概念上讲,当您执行运算时,autograd 会记录一个运算图,保存所有创建数据的操作,形成一个有向无环图。这个图的叶子节点是输入张量,根节点是输出张量。通过从根节点到叶子节点追踪这个图,您可以利用链式法则自动计算梯度。

在内部,autograd 将这个图表示为 Function 对象(实际上是表达式)组成的图,可以通过 apply() 方法来计算图的求值结果。在计算前向传播时,autograd 会同时执行请求的计算,并构建一个表示梯度计算函数的图(每个 torch.Tensor 的 .grad_fn 属性就是这个图的入口点)。前向传播完成后,我们会在反向传播中评估这个图以计算梯度。

需要注意的是,这个图在每次迭代时都会从头开始重新创建。正是这一点使得我们可以使用任意的 Python 控制流语句,在每次迭代时改变图的整体形状和大小。您不需要在启动训练前编码所有可能的路径------运行的内容就是您要微分的对象。

保存的张量

某些操作需要在正向传播过程中保存中间结果,以便执行反向传播。例如,函数 x↦x² 会保存输入 x 来计算梯度。

当定义自定义 Python Function 时,你可以使用 save_for_backward() 在正向传播期间保存张量,并通过 saved_tensors 在反向传播期间检索它们。更多信息请参阅 扩展 PyTorch。

对于 PyTorch 内置的操作(如 torch.pow()),系统会根据需要自动保存张量。出于学习或调试目的,你可以通过查找以 _saved 前缀开头的属性,来探索特定 grad_fn 保存了哪些张量。

python

x = torch.randn(5, requires_grad=True)

y = x.pow(2)

print(x.equal(y.grad_fn._saved_self)) # True

print(x is y.grad_fn._saved_self) # True在前面的代码中,y.grad_fn._saved_self 指向与 x 相同的 Tensor 对象。

但情况并非总是如此。例如:

python

x = torch.randn(5, requires_grad=True)

y = x.exp()

print(y.equal(y.grad_fn._saved_result)) # True

print(y is y.grad_fn._saved_result) # False在底层实现中,为了防止引用循环,PyTorch 会在保存时对张量进行打包 操作,并在读取时将其解包 为另一个张量。此时,通过访问 y.grad_fn._saved_result 获取的张量与 y 属于不同的张量对象(但它们仍共享相同的存储空间)。

一个张量是否会被打包成不同的张量对象,取决于它是否是其自身 grad_fn 的输出------这是一个可能变动的实现细节,用户不应依赖该行为。

您可以通过保存张量的钩子函数来控制 PyTorch 的打包/解包行为。

不可微函数的梯度计算

使用自动微分进行梯度计算时,仅当每个基本函数都可微时才有效。但实际应用中许多函数并不满足这一特性(例如 relu 或 sqrt 在 0 点处)。为了降低不可微函数的影响,我们按以下优先级规则定义基本操作的梯度:

1、若函数当前点可微且梯度存在,则直接采用该梯度。

2、若函数(至少局部)是凸的,采用最小范数的次梯度(即最速下降方向)。

3、若函数(至少局部)是凹的,考虑 -f(x) 并采用最小范数的超梯度(应用上一条规则)。

4、若函数有定义,通过连续性定义当前点的梯度(注意此处可能得到 inf,例如 sqrt(0))。若存在多个可能值,则任选其一。

5、若函数无定义(例如 sqrt(-1)、log(-1) 或输入为 NaN 时的大多数函数),则梯度值可任意选取(也可能报错但不保证)。多数函数会使用 NaN 作为梯度,但出于性能考虑,某些函数会采用其他值(如 log(-1))。

6、若函数是非确定性映射(即不符合数学函数定义),则标记为不可微。这将导致在非 no_grad 环境下对需要梯度的张量使用时,反向传播阶段会报错。

局部禁用梯度计算

Python 提供了多种机制来局部禁用梯度计算:

要禁用整个代码块的梯度计算,可以使用上下文管理器,例如无梯度模式(no-grad mode)和推理模式(inference mode)。对于更细粒度地排除子图参与梯度计算,可以设置张量的 requires_grad 字段。

下文除了讨论上述机制外,还会介绍评估模式(nn.Module.eval())。虽然该方法并非用于禁用梯度计算,但由于其名称,常被与前三种机制混淆。

设置 requires_grad

requires_grad 是一个标志位,默认值为 false,除非被包装在 nn.Parameter 中。它允许精细控制哪些子图参与梯度计算,并在前向传播和反向传播中均生效:

- 前向传播期间:只有当操作的至少一个输入张量需要梯度时,该操作才会被记录到反向计算图中。

- 反向传播期间 (调用

.backward()):只有requires_grad=True的叶子张量才会将梯度累积到它们的.grad字段中。

需特别注意:虽然每个张量都有此标志位,但设置它仅对叶子张量有意义 (即没有 grad_fn 的张量,例如 nn.Module 的参数)。非叶子张量(具有 grad_fn 的张量)已关联反向计算图,其梯度会作为中间结果用于计算需要梯度的叶子张量。因此,所有非叶子张量会自动设置为 require_grad=True。

设置 requires_grad 是控制模型哪些部分参与梯度计算的主要方式。例如,在模型微调时冻结预训练模型的部分参数:

1、冻结参数 :对不希望更新的参数直接调用 .requires_grad_(False)。如上所述,使用这些参数作为输入的计算不会被记录在前向传播中,因此它们不会出现在反向计算图中,自然也不会在反向传播时更新 .grad 字段。

2、模块级设置 :由于此操作非常常见,requires_grad 也可以通过 nn.Module.requires_grad_() 在模块级别设置。对模块调用此方法时,会作用于该模块的所有参数(默认情况下这些参数的 requires_grad=True)。

梯度模式

除了设置 requires_grad 外,还可以通过 Python 选择三种梯度模式,这些模式会影响 PyTorch 内部 autograd 处理计算的方式:默认模式(梯度模式)、无梯度模式和推理模式。所有模式都可以通过上下文管理器和装饰器进行切换。

| 模式 | 不记录操作到反向计算图中 | 跳过额外的 autograd 跟踪开销 | 在该模式下创建的张量后续可用于梯度模式 | 示例场景 |

|---|---|---|---|---|

| 默认模式 | ✓ | 前向传播 | ||

| 无梯度模式 | ✓ | ✓ | 优化器参数更新 | |

| 推理模式 | ✓ | ✓ | 数据处理、模型评估 |

默认模式(梯度模式)

"默认模式"是指当没有启用其他模式(如无梯度模式和推理模式)时,我们隐式处于的模式。为了与"无梯度模式"形成对比,默认模式有时也被称为"梯度模式"。

关于默认模式最重要的一点是:这是唯一能让requires_grad生效的模式。在其他两种模式下,requires_grad都会被强制设为False。

无梯度模式

在无梯度模式下,计算过程会表现得好像所有输入都不需要梯度。换句话说,即使存在require_grad=True的输入,无梯度模式下的计算也不会被记录到反向图中。

当你需要执行不应被autograd记录的操作,但又希望稍后在梯度模式下使用这些计算的输出时,可以启用无梯度模式。这个上下文管理器能方便地禁用代码块或函数的梯度计算,而无需临时将张量设置为requires_grad=False后再改回True。

例如,在编写优化器时,无梯度模式可能非常有用:执行训练更新时,你希望就地更新参数而不被autograd记录。同时你还打算在下一个前向传播中使用更新后的参数进行梯度模式下的计算。

torch.nn.init中的实现也依赖无梯度模式来初始化参数,从而避免就地更新初始化参数时被autograd跟踪。

推理模式

推理模式是无梯度模式的极端版本。与无梯度模式类似,推理模式下的计算不会被记录到反向图中,但启用推理模式能让PyTorch进一步加速模型运行。这种运行时优化带来一个缺点:在推理模式下创建的张量,退出该模式后将无法用于需要被autograd记录的计算中。

当满足以下两个条件时,建议启用推理模式:

1、执行的计算不需要与autograd交互

2、不计划将推理模式下创建的张量用于后续需要被autograd记录的任何计算

推荐在不需要autograd追踪的代码部分尝试推理模式(例如数据处理和模型评估)。如果该模式能直接适用于你的使用场景,这将带来免费的性能提升。若启用后出现错误,请检查是否在退出推理模式后,将推理模式下创建的张量用于了需要被autograd记录的计算。如果确实无法避免这种情况,可以随时切换回无梯度模式。

有关推理模式的详细说明,请参阅:推理模式

推理模式的实现细节参见:RFC-0011-InferenceMode

评估模式 (nn.Module.eval())

评估模式并非局部禁用梯度计算的机制。此处之所以提及,是因为它有时会被误认为是这样的机制。

从功能上讲,module.eval()(或等效的module.train(False))与无梯度模式和推理模式完全正交。model.eval()如何影响模型,完全取决于模型中使用的具体模块以及这些模块是否定义了训练模式下的特定行为。

如果模型依赖于某些模块(例如 torch.nn.Dropout 和 torch.nn.BatchNorm2d),而这些模块的行为可能因训练模式而异(例如为了避免在验证数据上更新批归一化的运行统计量),则需要自行调用 model.eval() 和 model.train()。

建议在训练时始终使用 model.train(),在评估模型(验证/测试)时始终使用 model.eval(),即使不确定模型是否存在训练模式下的特定行为。因为所使用的模块可能会更新,从而在训练和评估模式下表现出不同的行为。

自动求导中的原地操作

在自动求导系统中支持原地操作是一个复杂的问题,大多数情况下我们建议避免使用。自动求导通过积极的缓冲区释放和重用机制实现了高效运行,真正能通过原地操作显著降低内存占用的场景非常罕见。除非面临严重的内存压力,否则您可能永远不需要使用原地操作。

限制原地操作适用性的主要原因有两点:

1、原地操作可能会覆盖计算梯度所需的值。

2、每个原地操作都需要重写计算图实现。非原地版本只需分配新对象并保留旧图的引用,而原地操作需要将所有输入的创建者更改为代表该操作的Function。当多个张量共享同一存储空间时(例如通过索引或转置创建),这一过程会变得棘手。如果被修改输入的存储空间被其他任何Tensor引用,原地函数将报错。

原地操作的正确性检查

每个张量都维护一个版本计数器,每当它在任何操作中被标记为"脏数据"时,该计数器就会递增。当Function保存任何张量用于反向传播时,其所属Tensor的版本计数器也会被保存。一旦访问self.saved_tensors,系统就会检查当前版本号,如果该值大于保存的值,就会引发错误。这样可以确保:如果您使用了原地操作函数且没有看到任何错误,就能确定计算得到的梯度是正确的。

多线程自动求导

自动求导引擎负责运行所有必要的反向操作以完成反向传播计算。本节将详细介绍如何在线程环境中高效利用该引擎。(此内容仅适用于 PyTorch 1.6+ 版本,早期版本的行为有所不同。)

用户可以通过多线程代码(例如 Hogwild 训练)来训练模型,且不会阻塞并发的反向计算。示例代码如下:

python

# Define a train function to be used in different threads

def train_fn():

x = torch.ones(5, 5, requires_grad=True)

# forward

y = (x + 3) * (x + 4) * 0.5

# backward

y.sum().backward()

# potential optimizer update

# User write their own threading code to drive the train_fn

threads = []

for _ in range(10):

p = threading.Thread(target=train_fn, args=())

p.start()

threads.append(p)

for p in threads:

p.join()请注意以下用户需要了解的行为特性:

CPU 并发处理

当你在 CPU 上通过 Python 或 C++ API 在多个线程中运行 backward() 或 grad() 时,预期会看到额外的并发效果,而不是在执行过程中按特定顺序串行化所有反向传播调用(这是 PyTorch 1.6 版本之前的行为)。

非确定性行为

当从多个线程并发调用backward()且存在共享输入时(例如Hogwild CPU训练场景),可能会出现非确定性结果。这是因为参数会自动在线程间共享,导致多个线程在梯度累积过程中可能同时访问并尝试累加同一个.grad属性。从技术上讲,这种操作并不安全,可能引发竞态条件,最终导致计算结果无效。

开发含共享参数的多线程模型时,开发者必须充分考虑线程模型的设计,并充分理解上述潜在问题。

作为替代方案,可以使用函数式API torch.autograd.grad()来计算梯度,而非直接调用backward(),从而避免非确定性行为的发生。

图保留机制

当自动微分计算图的部分内容在线程间共享时(例如,先在单线程中运行前向传播的第一部分,然后在多线程中运行第二部分),图的第一部分会被共享。

这种情况下,不同线程对同一计算图执行grad()或backward()时,可能会出现一个线程正在动态销毁计算图,而另一个线程因此崩溃的问题。

Autograd会向用户报错------类似于未设置retain_graph=True时两次调用backward()的情况,并提示用户应当使用retain_graph=True参数。

Autograd节点的线程安全性

由于Autograd允许调用线程驱动其反向执行以实现潜在并行化,我们必须确保CPU上共享部分或整个GraphTask的并行backward()调用具有线程安全性。

自定义Python的autograd.Function由于GIL的存在自动具备线程安全性。对于内置的C++ Autograd节点(如AccumulateGrad、CopySlices)和自定义的autograd::Function,Autograd引擎会使用线程互斥锁来确保可能涉及状态读写操作的autograd节点的线程安全。

C++钩子的线程安全性问题

Autograd依赖于用户自行编写线程安全的C++钩子。若需在多线程环境中正确应用钩子,您需要编写适当的线程锁定代码来确保钩子的线程安全性。

复数自动求导

简而言之:

-

当你使用PyTorch对任意定义域和/或值域为复数的函数f(z)进行微分时,梯度计算会假设该函数是一个更大的实值损失函数g(input)=L的一部分。

计算得到的梯度是∂L/∂z*(注意z的共轭),其负方向正是梯度下降算法中所使用的最陡下降方向。因此,现有优化器可以直接用于复数参数。

-

这一约定与TensorFlow的复数微分约定一致,但不同于JAX(后者计算∂L/∂z)。

-

如果你的函数是从实数到实数,但内部使用了复数运算,此处的约定无关紧要:你得到的结果与仅使用实数运算实现时完全相同。

若想了解数学细节,或想知道如何在PyTorch中定义复数导数,请继续阅读。

什么是复导数?

复可微性的数学定义采用了导数的极限定义,并将其推广到复数运算中。考虑一个函数 f: ℂ → ℂ,

f ( z = x + y j ) = u ( x , y ) + v ( x , y ) j f(z=x+yj)=u(x,y)+v(x,y)j f(z=x+yj)=u(x,y)+v(x,y)j

其中,u 和 v 是二元实值函数,j 是虚数单位。

根据导数的定义,我们可以写出:

f′(z) = \lim_{h \to 0, h \in C} \frac{f(z+h) - f(z)}{h}

f′(z) = h→0,h∈Climhf(z+h)−f(z)

为了使该极限存在,不仅 u 和 v 必须是实可微的,而且 f 还必须满足 柯西-黎曼方程。换句话说,对于实部和虚部步长(h)计算的极限必须相等。这是一个更为严格的条件。

复可微函数通常被称为全纯函数。它们具有良好的性质,具备实可微函数的所有优点,但在优化领域几乎没有实际用途。对于优化问题,研究界通常只使用实值目标函数,因为复数不属于任何有序域,因此复数值的损失函数没有实际意义。

此外,现实中也没有任何有意义的实值目标函数能满足柯西-黎曼方程。因此,全纯函数的理论无法用于优化,大多数人转而使用 Wirtinger 微积分。

维廷格微积分登场...

我们拥有如此优秀的复可微理论和全纯函数理论,却因为许多常用函数并非全纯而无法使用。数学家们该怎么办呢?维廷格观察到,即使函数f(z)不是全纯的,也可以将其重写为二元函数f(z,z*),后者总是全纯的。这是因为z的实部和虚部都可以用z和z*表示:

Re(z)=z+z∗2Im(z)=z−z∗2j\begin{aligned}

\mathrm{Re}(z) &= \frac {z + z^}{2} \\

\mathrm{Im}(z) &= \frac {z - z^ }{2j}\end{aligned}

Re(z)Im(z)=2z+z∗=2jz−z∗

维廷格微积分建议转而研究f(z,z*),只要f是实可微的,这个函数就保证是全纯的(另一种理解方式是坐标系变换,从f(x,y)转换到f(z,z*))。这个函数具有偏导数∂/∂z和∂/∂z*。我们可以通过链式法则建立这些偏导数与z的实部和虚部偏导数之间的关系。

∂∂x=∂z∂x∗∂∂z+∂z∗∂x∗∂∂z∗=∂∂z+∂∂z∗∂∂y=∂z∂y∗∂∂z+∂z∗∂y∗∂∂z∗=1j∗(∂∂z−∂∂z∗)\begin{aligned

\frac{\partial }{\partial x} &= \frac{\partial z}{\partial x} * \frac{\partial }{\partial z} + \frac{\partial z^}{\partial x} * \frac{\partial }{\partial z^ } \\

&= \frac{\partial }{\partial z} + \frac{\partial }{\partial z^} \\

\\

\frac{\partial }{\partial y} &= \frac{\partial z}{\partial y} * \frac{\partial }{\partial z} + \frac{\partial z^ }{\partial y} * \frac{\partial }{\partial z^} \\

&= 1j * \left(\frac{\partial }{\partial z} - \frac{\partial }{\partial z^ }\right)\end{aligned}

∂x∂∂y∂=∂x∂z∗∂z∂+∂x∂z∗∗∂z∗∂=∂z∂+∂z∗∂=∂y∂z∗∂z∂+∂y∂z∗∗∂z∗∂=1j∗(∂z∂−∂z∗∂)

从上述方程中,我们得到:

∂∂z=1/2∗(∂∂x−1j∗∂∂y)∂∂z∗=1/2∗(∂∂x+1j∗∂∂y)\begin{aligned

\frac{\partial }{\partial z} &= 1/2 * \left(\frac{\partial }{\partial x} - 1j * \frac{\partial }{\partial y}\right) \\

\frac{\partial }{\partial z^*} &= 1/2 * \left(\frac{\partial }{\partial x} + 1j * \frac{\partial }{\partial y}\right)

\end{aligned}

∂z∂∂z∗∂=1/2∗(∂x∂−1j∗∂y∂)=1/2∗(∂x∂+1j∗∂y∂)

这正是你在维基百科上能找到的维廷格微积分的经典定义。

这一转变带来了许多美妙的结果:

- 首先,柯西-黎曼方程简化为∂f/∂z* = 0(也就是说,函数f可以完全用z表示,无需参考z*)。

- 另一个重要(且有些反直觉)的结果是,当我们对实值损失进行优化时,变量更新应采取的步骤由∂Loss/∂z*给出(而不是∂Loss/∂z),这一点我们稍后会看到。

更多阅读资料,请查看:https://arxiv.org/pdf/0906.4835.pdf

Wirtinger微积分在优化中有何作用?

音频等领域的研究人员通常使用梯度下降法来优化具有复变量的实值损失函数。通常,他们会将实部和虚部视为可单独更新的独立通道。对于步长α/2和损失函数L,我们可以在ℝ²空间中写出以下方程:

xn+1=xn−(α/2)∗∂L∂xyn+1=yn−(α/2)∗∂L∂y\begin{aligned}

x_{n+1} &= x_n - (\alpha/2) * \frac{\partial L}{\partial x} \\

y_{n+1} &= y_n - (\alpha/2) * \frac{\partial L}{\partial y}

\end{aligned}

xn+1yn+1=xn−(α/2)∗∂x∂L=yn−(α/2)∗∂y∂L

这些方程如何转换到复数空间ℂ?

zn+1=xn−(α/2)∗∂L∂x+1j∗(yn−(α/2)∗∂L∂y)=zn−α∗1/2∗(∂L∂x+j∂L∂y)=zn−α∗∂L∂z∗\begin{aligned}

z_{n+1} &= x_n - (\alpha/2) * \frac{\partial L}{\partial x} + 1j * (y_n - (\alpha/2) * \frac{\partial L}{\partial y}) \\

&= z_n - \alpha * 1/2 * \left(\frac{\partial L}{\partial x} + j \frac{\partial L}{\partial y}\right) \\

&= z_n - \alpha * \frac{\partial L}{\partial z^*}

\end{aligned}

zn+1=xn−(α/2)∗∂x∂L+1j∗(yn−(α/2)∗∂y∂L)=zn−α∗1/2∗(∂x∂L+j∂y∂L)=zn−α∗∂z∗∂L

这里发生了非常有趣的现象:Wirtinger微积分告诉我们,可以将上述复变量更新公式简化为仅涉及共轭Wirtinger导数∂L/∂z*,从而直接得到优化过程中采用的步长。

由于共轭Wirtinger导数能准确给出实值损失函数所需的更新步长,PyTorch在对实值损失函数进行微分时,会直接返回这个导数。

PyTorch如何计算共轭Wirtinger导数?

通常,我们的导数公式将grad_output作为输入,表示我们已经计算过的Vector-Jacobian乘积,即∂L/∂s*,其中L是整个计算过程的损失函数(产生实数损失),s是我们函数的输出。这里的目标是计算∂L/∂z*,其中z是函数的输入。事实证明,在实数损失的情况下,我们仅需要计算∂L/∂s*,尽管链式法则表明我们还需要访问∂L/∂s。如果你想跳过这个推导过程,可以直接查看本节最后一个公式,然后跳到下一节。

让我们继续处理定义为f(z) = f(x+yj) = u(x,y) + v(x,y)j的函数f: ℂ → ℂ。如上所述,autograd的梯度约定围绕实数损失函数的优化展开,因此假设f是更大的实数损失函数g的一部分。使用链式法则,我们可以写出:

(1) ∂L/∂z* = (∂L/∂u) * (∂u/∂z*) + (∂L/∂v) * (∂v/∂z*)

现在,利用Wirtinger导数的定义,我们可以写出:

∂L/∂s = 1/2 * (∂L/∂u - ∂L/∂v j)

∂L/∂s* = 1/2 * (∂L/∂u + ∂L/∂v j)

这里需要注意的是,由于u和v是实函数,且根据我们假设f是实数损失函数的一部分,L也是实数,因此有:

(2) (∂L/∂s)* = ∂L/∂s*

即,∂L/∂s等于grad_output的共轭。

通过解上述方程求∂L/∂u和∂L/∂v,我们得到:

(3) ∂L/∂u = ∂L/∂s + ∂L/∂s*

∂L/∂v = 1j * (∂L/∂s - ∂L/∂s*)

将(3)代入(1),我们得到:

∂L/∂z* = (∂L/∂s + ∂L/∂s*) * (∂u/∂z*) + 1j * (∂L/∂s - ∂L/∂s*) * (∂v/∂z*)

= ∂L/∂s * (∂u/∂z* + ∂v/∂z* j) + ∂L/∂s* * (∂u/∂z* - ∂v/∂z* j)

= ∂L/∂s * ∂(u + vj)/∂z* + ∂L/∂s* * ∂(u + vj)/∂z

= ∂L/∂s * ∂s/∂z* + ∂L/∂s* * ∂s*/∂z*

利用(2),我们得到:

(4) ∂L/∂z* = (∂L/∂s*)* * (∂s/∂z*) + ∂L/∂s* * (∂s/∂z)*

= (grad_output)* * (∂s/∂z*) + grad_output * (∂s/∂z)*

最后一个公式对于编写自定义梯度非常重要,因为它将我们的导数公式分解为一个更简单且易于手动计算的表达式。

如何为复杂函数编写自定义导数公式?

上述方框中的方程给出了所有复杂函数导数的通用公式。但我们仍需计算 ∂s/∂z 和 ∂s/∂z*。有两种方法可以实现:

- 第一种方法是直接使用Wirtinger导数的定义,通过∂s/∂x和∂s/∂y(可按常规方式计算)来求解∂s/∂z和∂s/∂z*。

- 第二种方法是采用变量替换技巧,将f(z)改写为二元函数f(z, z*),并将z和z视为独立变量来计算共轭Wirtinger导数。这种方法通常更简便:例如当函数是解析函数时,只会用到z(此时∂s/∂z为零)。

以函数f(z = x + yj) = c * z = c * (x + yj)为例(其中c∈ℝ):

使用第一种方法计算Wirtinger导数:

∂s/∂z = 1/2 * (∂s/∂x - ∂s/∂y j)

= 1/2 * (c - (c * 1j) * 1j)

= c

∂s/∂z* = 1/2 * (∂s/∂x + ∂s/∂y j)

= 1/2 * (c + (c * 1j) * 1j)

= 0根据公式(4),当grad_output = 1.0(PyTorch中对标量输出调用backward()时的默认梯度输出值)时,可得:

∂L/∂z* = 1 * 0 + 1 * c = c

使用第二种方法计算Wirtinger导数,直接得到:

∂s/∂z = ∂(cz)/∂z = c

∂s/∂z = ∂(cz)/∂z = 0

再次应用公式(4)可得∂L/∂z* = c。显然第二种方法计算量更小,更适合快速求解。

(注:所有数学公式和代码块保持原样,术语如"Wirtinger导数"、"PyTorch"等未翻译,符合核心翻译原则)

跨域函数如何处理?

有些函数会将复数输入映射到实数输出,或者反过来。这些函数构成了(4)的特殊情况,我们可以通过链式法则推导出:

对于函数 f: ℂ → ℝ,得到:

∂L/∂z∗ = 2 * grad_output * ∂s/∂z∗

∂L/∂z∗ = 2 * grad_output * ∂s/∂z∗

- 对于函数 f: ℝ → ℂ,得到:

∂L/∂z∗ = 2 * Re(grad_output∗ * ∂s/∂z∗)

∂L/∂z∗ = 2 * Re(grad_output∗ * ∂s/∂z∗)

张量保存的钩子函数

您可以通过定义一对 pack_hook / unpack_hook 钩子函数来控制已保存张量的打包/解包方式。pack_hook 函数应接收一个张量作为唯一参数,但可以返回任意 Python 对象(例如另一个张量、元组,甚至是包含文件名的字符串)。unpack_hook 函数以 pack_hook 的输出作为唯一参数,并应返回一个用于反向传播的张量。unpack_hook 返回的张量只需与输入 pack_hook 的张量内容相同即可,特别地,所有与自动微分相关的元数据都可以忽略,因为在解包过程中会被覆盖。

以下是一个钩子函数对的示例:

python

class SelfDeletingTempFile():

def __init__(self):

self.name = os.path.join(tmp_dir, str(uuid.uuid4()))

def __del__(self):

os.remove(self.name)

def pack_hook(tensor):

temp_file = SelfDeletingTempFile()

torch.save(tensor, temp_file.name)

return temp_file

def unpack_hook(temp_file):

return torch.load(temp_file.name)请注意,unpack_hook 不应删除临时文件,因为它可能会被多次调用:只要返回的 SelfDeletingTempFile 对象存在,临时文件就应该保持有效。在上面的示例中,我们通过在不再需要时(即 SelfDeletingTempFile 对象被删除时)关闭临时文件来防止文件泄漏。

注意:我们保证 pack_hook 只会被调用一次,但 unpack_hook 可能会根据反向传播的需要被多次调用,并且我们期望它每次返回相同的数据。

警告:禁止对任何函数的输入执行原地操作,因为这可能导致意外的副作用。如果修改了 pack hook 的输入,PyTorch 会抛出错误,但不会捕获修改 unpack hook 输入的情况。

为保存的张量注册钩子

您可以通过在 SavedTensor 对象上调用 register_hooks() 方法来注册一对钩子。这些对象会作为 grad_fn 的属性暴露出来,并以 _raw_saved_ 前缀开头。

python

x = torch.randn(5, requires_grad=True)

y = x.pow(2)

y.grad_fn._raw_saved_self.register_hooks(pack_hook, unpack_hook)当注册张量对时,会立即调用 pack_hook 方法。

每次需要访问已保存的张量时(无论是通过 y.grad_fn._saved_self 还是在反向传播过程中),都会调用 unpack_hook 方法。

警告:如果在保存的张量被释放后(即调用 backward 之后)仍持有对 SavedTensor 的引用,则禁止调用其 register_hooks() 方法。

大多数情况下 PyTorch 会抛出错误,但在某些情况下可能无法检测到,从而导致未定义行为。

为保存的张量注册默认钩子

或者,你可以使用上下文管理器 saved_tensors_hooks 来注册一对钩子,这些钩子将应用于在该上下文中创建的所有保存的张量。

示例:

python

# Only save on disk tensors that have size >= 1000

SAVE_ON_DISK_THRESHOLD = 1000

def pack_hook(x):

if x.numel() < SAVE_ON_DISK_THRESHOLD:

return x

temp_file = SelfDeletingTempFile()

torch.save(tensor, temp_file.name)

return temp_file

def unpack_hook(tensor_or_sctf):

if isinstance(tensor_or_sctf, torch.Tensor):

return tensor_or_sctf

return torch.load(tensor_or_sctf.name)

class Model(nn.Module):

def forward(self, x):

with torch.autograd.graph.saved_tensors_hooks(pack_hook, unpack_hook):

# ... compute output

output = x

return output

model = Model()

net = nn.DataParallel(model)使用此上下文管理器定义的钩子是线程局部的。

因此,以下代码不会产生预期效果,因为这些钩子不会通过DataParallel传递。

python

# Example what NOT to do

net = nn.DataParallel(model)

with torch.autograd.graph.saved_tensors_hooks(pack_hook, unpack_hook):

output = net(input)请注意,使用这些钩子会禁用所有旨在减少张量对象创建的优化措施。例如:

python

with torch.autograd.graph.saved_tensors_hooks(lambda x: x, lambda x: x):

x = torch.randn(5, requires_grad=True)

y = x * x在没有钩子的情况下,x、y.grad_fn._saved_self 和 y.grad_fn._saved_other 都指向同一个张量对象。

使用钩子后,PyTorch 会将 x 打包和解包成两个新的张量对象,

这些新对象与原始 x 共享相同的存储空间(不执行复制操作)。

反向钩子执行机制

本节将讨论不同类型钩子的触发条件与非触发场景,并阐述它们的执行顺序。涵盖的钩子类型包括:

1、通过 torch.Tensor.register_hook() 注册到 Tensor 的反向钩子

2、通过 torch.Tensor.register_post_accumulate_grad_hook() 注册到 Tensor 的梯度累加后钩子

3、通过 torch.autograd.graph.Node.register_hook() 注册到 Node 的后置钩子

4、通过 torch.autograd.graph.Node.register_prehook() 注册到 Node 的前置钩子

特定钩子何时会被触发

通过 torch.Tensor.register_hook() 注册到张量的钩子,会在计算该张量的梯度时执行。(注意:这并不要求执行张量的 grad_fn。例如,如果张量作为 torch.autograd.grad() 的 inputs 参数的一部分传递,该张量的 grad_fn 可能不会执行,但注册到该张量的钩子始终会执行。)

通过 torch.Tensor.register_post_accumulate_grad_hook() 注册到张量的钩子,会在该张量的梯度累积完成后执行,即张量的 grad 字段已被设置。而通过 torch.Tensor.register_hook() 注册的钩子在梯度计算过程中运行,通过 torch.Tensor.register_post_accumulate_grad_hook() 注册的钩子仅在反向传播结束时由 autograd 更新张量的 grad 字段后触发。因此,后累积梯度钩子只能注册到叶子张量。在非叶子张量上通过 torch.Tensor.register_post_accumulate_grad_hook() 注册钩子会报错,即使调用 backward(retain_graph=True) 也是如此。

通过 torch.autograd.graph.Node.register_hook() 或 torch.autograd.graph.Node.register_prehook() 注册到 torch.autograd.graph.Node 的钩子,仅在注册的 Node 被执行时才会触发。

特定 Node 是否执行可能取决于反向传播是通过 torch.autograd.grad() 还是 torch.autograd.backward() 调用的。具体来说,当你对传递给 torch.autograd.grad() 或 torch.autograd.backward() 的 inputs 参数中的张量对应的 Node 注册钩子时,应注意这些差异。

如果使用 torch.autograd.backward(),无论是否指定了 inputs 参数,上述所有钩子都会执行。这是因为 .backward() 会执行所有 Node,即使它们对应于作为输入指定的张量。(注意:这种对作为 inputs 传递的张量对应的额外 Node 的执行通常是不必要的,但仍会执行。此行为可能会更改,不应依赖它。)

另一方面,如果使用 torch.autograd.grad(),注册到传递给 input 的张量对应的 Node 的反向钩子可能不会执行,因为这些 Node 不会被执行,除非有其他输入依赖于该 Node 的梯度结果。

不同钩子的触发顺序

事件发生的顺序如下:

1、注册到 Tensor 的钩子首先执行

2、如果 Node 被执行,则注册到 Node 的 pre-hooks 执行

3、对于设置了 retain_grad 的 Tensor,其 .grad 字段会被更新

4、Node 执行(需遵守上述规则)

5、对于已累积 .grad 的叶子 Tensor,执行 post-accumulate-grad 钩子

6、如果 Node 被执行,则注册到 Node 的 post-hooks 执行

若同一 Tensor 或 Node 上注册了多个同类型钩子,

它们将按注册顺序依次执行。

后执行的钩子可以观察到先前钩子对梯度所做的修改。

特殊钩子

torch.autograd.graph.register_multi_grad_hook() 是通过注册到张量的钩子实现的。每个独立的张量钩子会按照上述定义的张量钩子顺序触发,当最后一个张量梯度计算完成后,注册的多梯度钩子就会被调用。

torch.nn.modules.module.register_module_full_backward_hook() 则是通过注册到节点的钩子实现的。在前向计算过程中,钩子会被注册到与模块输入输出对应的 grad_fn 上。由于一个模块可能接收多个输入并返回多个输出,系统会先在模块输入前应用一个虚拟的自定义 autograd Function,并在模块输出前对前向计算的返回结果进行处理,以确保这些张量共享同一个 grad_fn,从而能够将我们的钩子附加到该节点上。

当张量被原地修改时 Tensor hooks 的行为表现

通常情况下,注册在张量上的钩子会接收到输出相对于该张量的梯度,此时张量的取值是反向计算时的当前值。

然而,如果你先给张量注册钩子,然后对该张量进行原地修改,那么:

- 在原地修改前注册的钩子同样会接收到输出相对于该张量的梯度

- 但此时张量的取值会采用原地修改前的值

若你希望保持第一种情况的行为特性,应在完成所有原地修改操作后再给张量注册钩子。

示例说明:

python

t = torch.tensor(1., requires_grad=True).sin()

t.cos_()

t.register_hook(fn)

t.backward()此外,了解以下底层机制会很有帮助:当钩子注册到张量时,它们实际上会永久绑定到该张量的grad_fn。因此,如果该张量随后被原地修改,即使张量现在有了新的grad_fn,之前注册的钩子仍会与旧的grad_fn保持关联。例如,当自动微分引擎在计算图中执行到该张量的旧grad_fn时,这些钩子仍会被触发。

广播语义

许多PyTorch操作支持NumPy的广播语义。详情请参阅https://numpy.org/doc/stable/user/basics.broadcasting.html。

简而言之,如果一个PyTorch操作支持广播,那么它的张量参数可以自动扩展为相同大小(无需复制数据)。

通用语义

两个张量在满足以下规则时可进行"广播"操作:

- 每个张量至少有一个维度

- 从尾部维度开始迭代维度大小时,维度大小必须满足以下条件之一:

- 相等

- 其中一个为1

- 其中一个维度不存在

例如:

python

>>> x=torch.empty(5,7,3)

>>> y=torch.empty(5,7,3)

# same shapes are always broadcastable (i.e. the above rules always hold)

>>> x=torch.empty((0,))

>>> y=torch.empty(2,2)

# x and y are not broadcastable, because x does not have at least 1 dimension

# can line up trailing dimensions

>>> x=torch.empty(5,3,4,1)

>>> y=torch.empty( 3,1,1)

# x and y are broadcastable.

# 1st trailing dimension: both have size 1

# 2nd trailing dimension: y has size 1

# 3rd trailing dimension: x size == y size

# 4th trailing dimension: y dimension doesn't exist

# but:

>>> x=torch.empty(5,2,4,1)

>>> y=torch.empty( 3,1,1)

# x and y are not broadcastable, because in the 3rd trailing dimension 2 != 3如果两个张量 x 和 y 是"可广播的",则结果张量的大小按以下方式计算:

- 如果

x和y的维度数不相等,则在维度较少的张量前面补 1,使它们的维度长度相等。 - 然后,对于每个维度大小,结果维度大小是

x和y在该维度上的最大值。

例如:

python

# can line up trailing dimensions to make reading easier

>>> x=torch.empty(5,1,4,1)

>>> y=torch.empty( 3,1,1)

>>> (x+y).size()

torch.Size([5, 3, 4, 1])

# but not necessary:

>>> x=torch.empty(1)

>>> y=torch.empty(3,1,7)

>>> (x+y).size()

torch.Size([3, 1, 7])

>>> x=torch.empty(5,2,4,1)

>>> y=torch.empty(3,1,1)

>>> (x+y).size()

RuntimeError: The size of tensor a (2) must match the size of tensor b (3) at non-singleton dimension 1原地操作语义

一个复杂之处在于,原地操作不允许参与广播的原地张量改变形状。

例如:

python

>>> x=torch.empty(5,3,4,1)

>>> y=torch.empty(3,1,1)

>>> (x.add_(y)).size()

torch.Size([5, 3, 4, 1])

# but:

>>> x=torch.empty(1,3,1)

>>> y=torch.empty(3,1,7)

>>> (x.add_(y)).size()

RuntimeError: The expanded size of the tensor (1) must match the existing size (7) at non-singleton dimension 2.向后兼容性

PyTorch 的早期版本允许某些逐点函数在不同形状的张量上执行,只要每个张量的元素数量相同即可。这种情况下,逐点操作会通过将每个张量视为一维形式来完成。现在 PyTorch 已支持广播机制,这种"一维"逐点操作行为被视为已弃用,当张量不可广播但元素数量相同时,会生成 Python 警告。

需要注意的是,广播机制的引入可能导致向后不兼容的情况,即当两个张量形状不同但可广播且元素数量相同时。

例如:

python

>>> torch.add(torch.ones(4,1), torch.randn(4)) 之前会生成一个大小为 torch.Size([4,1]) 的张量,但现在会生成大小为 torch.Size([4,4]) 的张量。

为了帮助识别代码中可能因广播机制引入的向后不兼容情况,你可以将 torch.utils.backcompat.broadcast_warning.enabled 设为 True,这样在出现此类情况时会生成 Python 警告。

例如:

python

>>> torch.utils.backcompat.broadcast_warning.enabled=True

>>> torch.add(torch.ones(4,1), torch.ones(4))

__main__:1: UserWarning: self and other do not have the same shape, but are broadcastable, and have the same number of elements.

Changing behavior in a backwards incompatible manner to broadcasting rather than viewing as 1-dimensional.CPU线程与TorchScript推理

PyTorch支持在TorchScript模型推理过程中使用多个CPU线程。下图展示了一个典型应用中可能存在的不同层级并行机制:

一个或多个推理线程会在给定输入上执行模型的前向传播。每个推理线程会调用JIT解释器,该解释器会逐个内联执行模型的操作。模型可以通过fork TorchScript原语来启动异步任务。同时分叉多个操作会产生并行执行的任务。fork操作符会返回一个Future对象,可用于后续同步操作,例如:

python

@torch.jit.script

def compute_z(x):

return torch.mm(x, self.w_z)

@torch.jit.script

def forward(x):

# launch compute_z asynchronously:

fut = torch.jit._fork(compute_z, x)

# execute the next operation in parallel to compute_z:

y = torch.mm(x, self.w_y)

# wait for the result of compute_z:

z = torch.jit._wait(fut)

return y + zPyTorch 使用单个线程池来处理操作间并行(inter-op parallelism),该线程池由应用程序进程内派生的所有推理任务共享。

除了操作间并行外,PyTorch 还可以在操作内部(intra-op parallelism)利用多线程。这在许多场景下非常有用,包括对大张量进行逐元素操作、卷积运算、GEMM(通用矩阵乘法)、嵌入查找等操作。

构建选项

PyTorch 使用内部 ATen 库来实现算子操作。此外,PyTorch 还可以通过集成外部库(如 MKL 和 MKL-DNN)来加速 CPU 计算。

ATen、MKL 和 MKL-DNN 支持操作内并行,并依赖以下并行库实现该功能:

OpenMP 因其易用性和对基于循环的并行等特性的支持,长期以来被众多库广泛采用。

TBB 在外部库中使用较少,但它针对并发环境进行了优化。PyTorch 的 TBB 后端能确保应用中所有算子共享同一个进程内独立线程池。

根据具体场景,开发者可选择更适合自身应用的并行库。

PyTorch 允许在构建时通过以下选项指定 ATen 及其他库使用的并行后端:

| 库 | 构建选项 | 可选值 | 说明 |

|---|---|---|---|

| ATen | ATEN_THREADING |

OMP(默认), TBB |

|

| MKL | MKL_THREADING |

(同上) | 需启用 BLAS=MKL 使用 MKL |

| MKL-DNN | MKLDNN_CPU_RUNTIME |

(同上) | 需启用 USE_MKLDNN=1 使用 MKL-DNN |

建议不要在同一个构建中混用 OpenMP 和 TBB。

上表中所有 TBB 选项需设置 USE_TBB=1(默认关闭)。OpenMP 并行需单独设置 USE_OPENMP=1(默认开启)。

运行时 API

以下API用于控制线程设置:

| 并行类型 | 设置项 | 备注 |

|---|---|---|

| 操作间并行 | at::set_num_interop_threads, at::get_num_interop_threads (C++) set_num_interop_threads, get_num_interop_threads (Python, torch 模块) |

默认线程数:CPU核心数 |

| 操作内并行 | at::set_num_threads, at::get_num_threads (C++) set_num_threads, get_num_threads (Python, torch 模块) 环境变量: OMP_NUM_THREADS 和 MKL_NUM_THREADS |

对于操作内并行设置,at::set_num_threads和torch.set_num_threads的优先级始终高于环境变量,其中MKL_NUM_THREADS变量的优先级高于OMP_NUM_THREADS。

调整线程数量

以下简单脚本展示了矩阵乘法运行时间如何随线程数量变化:

python

import timeit

runtimes = []

threads = [1] + [t for t in range(2, 49, 2)]

for t in threads:

torch.set_num_threads(t)

r = timeit.timeit(setup = "import torch; x = torch.randn(1024, 1024); y = torch.randn(1024, 1024)", stmt="torch.mm(x, y)", number=100)

runtimes.append(r)

# ... plotting (threads, runtimes) ...在一台配备24个物理CPU核心(Xeon E5-2680处理器,基于MKL和OpenMP构建)的系统上运行该脚本,得到以下运行时间结果:

调整内部操作线程和跨操作线程数量时需考虑以下因素:

- 选择线程数量时需避免过度订阅(使用过多线程会导致性能下降)。例如,在使用大型应用线程池或高度依赖跨操作并行的应用中,可以考虑禁用内部操作并行(例如通过调用

set_num_threads(1)); - 典型应用中可能需要在延迟(处理推理请求的时间)和吞吐量(单位时间内完成的工作量)之间进行权衡。调整线程数量是优化这种权衡的有效手段。例如,在延迟敏感型应用中,可以增加内部操作线程数以加速单个请求处理。但需注意,操作的并行实现可能带来额外开销,这会增加单个请求的工作量从而降低整体吞吐量。

警告:OpenMP不保证应用会使用单一进程内内部操作线程池。相反,两个不同的应用线程或跨操作线程可能使用不同的OpenMP线程池执行内部操作。这可能导致应用使用大量线程。在OpenMP环境下,需要特别注意线程数量调优以避免多线程应用中的过度订阅问题。

注意:预编译的PyTorch版本默认启用OpenMP支持。

注意:parallel_info工具可打印线程配置信息用于调试。在Python中也可通过调用torch.__config__.parallel_info()获取类似输出。

CUDA 语义

https://pytorch.org/docs/stable/notes/cuda.html

torch.cuda 用于设置和运行 CUDA 操作。它会跟踪当前选定的 GPU,默认情况下所有分配的 CUDA 张量都会在该设备上创建。可以通过 torch.cuda.device 上下文管理器来更改所选设备。

不过,一旦张量分配完成后,无论当前选定哪个设备,都可以对其进行操作,结果始终会放在与张量相同的设备上。

默认情况下不允许跨 GPU 操作,除了 copy_() 和其他具有复制功能的方法,如 to() 和 cuda()。除非启用了点对点内存访问,否则尝试在不同设备上的张量上启动操作都会引发错误。

下面是一个展示此行为的小示例:

python

cuda = torch.device('cuda') # Default CUDA device

cuda0 = torch.device('cuda:0')

cuda2 = torch.device('cuda:2') # GPU 2 (these are 0-indexed)

x = torch.tensor([1., 2.], device=cuda0)

# x.device is device(type='cuda', index=0)

y = torch.tensor([1., 2.]).cuda()

# y.device is device(type='cuda', index=0)

with torch.cuda.device(1):

# allocates a tensor on GPU 1

a = torch.tensor([1., 2.], device=cuda)

# transfers a tensor from CPU to GPU 1

b = torch.tensor([1., 2.]).cuda()

# a.device and b.device are device(type='cuda', index=1)

# You can also use ``Tensor.to`` to transfer a tensor:

b2 = torch.tensor([1., 2.]).to(device=cuda)

# b.device and b2.device are device(type='cuda', index=1)

c = a + b

# c.device is device(type='cuda', index=1)

z = x + y

# z.device is device(type='cuda', index=0)

# even within a context, you can specify the device

# (or give a GPU index to the .cuda call)

d = torch.randn(2, device=cuda2)

e = torch.randn(2).to(cuda2)

f = torch.randn(2).cuda(cuda2)

# d.device, e.device, and f.device are all device(type='cuda', index=2)Ampere(及后续)设备上的 TensorFloat-32 (TF32)

从 PyTorch 1.7 开始,新增了一个名为 allow_tf32 的标志。该标志在 PyTorch 1.7 至 1.11 版本中默认为 True,而在 PyTorch 1.12 及更高版本中默认为 False。此标志控制 PyTorch 是否允许在内部使用 TensorFloat-32 (TF32) 张量核心(自 Ampere 架构起在 NVIDIA GPU 上提供)来计算矩阵乘法(包括批量矩阵乘法)和卷积运算。

TF32 张量核心的设计目标是通过将输入数据舍入为 10 位尾数,并以 FP32 精度累加结果(同时保持 FP32 的动态范围),从而在 torch.float32 张量的矩阵乘法和卷积运算上实现更佳性能。

矩阵乘法和卷积运算的控制是独立的,其对应标志可通过以下方式访问:

python

# The flag below controls whether to allow TF32 on matmul. This flag defaults to False

# in PyTorch 1.12 and later.

torch.backends.cuda.matmul.allow_tf32 = True

# The flag below controls whether to allow TF32 on cuDNN. This flag defaults to True.

torch.backends.cudnn.allow_tf32 = True可以通过 set_float_32_matmul_precision() 更广泛地设置矩阵乘法的精度(不仅限于 CUDA)。

请注意,除了矩阵乘法和卷积运算本身外,内部使用矩阵乘法或卷积的函数和 nn 模块也会受到影响。这些包括 nn.Linear、nn.Conv*、cdist、tensordot、仿射网格和网格采样、自适应对数 softmax、GRU 和 LSTM。

要了解精度和速度的情况,请参阅下面的示例代码和基准测试数据(基于 A100):

python

a_full = torch.randn(10240, 10240, dtype=torch.double, device='cuda')

b_full = torch.randn(10240, 10240, dtype=torch.double, device='cuda')

ab_full = a_full @ b_full

mean = ab_full.abs().mean() # 80.7277

a = a_full.float()

b = b_full.float()

# Do matmul at TF32 mode.

torch.backends.cuda.matmul.allow_tf32 = True

ab_tf32 = a @ b # takes 0.016s on GA100

error = (ab_tf32 - ab_full).abs().max() # 0.1747

relative_error = error / mean # 0.0022

# Do matmul with TF32 disabled.

torch.backends.cuda.matmul.allow_tf32 = False

ab_fp32 = a @ b # takes 0.11s on GA100

error = (ab_fp32 - ab_full).abs().max() # 0.0031

relative_error = error / mean # 0.000039从上述示例可以看出,启用TF32后,A100上的速度提升了约7倍,但与双精度相比的相对误差大约增加了2个数量级。需要注意的是,TF32与单精度速度的具体比例取决于硬件代际,因为不同代际或不同型号之间可能存在以下特性差异:

- 内存带宽与计算能力的比例

- TF32与FP32矩阵乘法吞吐量的比例

如果需要完整的FP32精度,用户可以通过以下方式禁用TF32:

python

torch.backends.cuda.matmul.allow_tf32 = False

torch.backends.cudnn.allow_tf32 = False要在 C++ 中关闭 TF32 标志,可以执行以下操作:

at::globalContext().setAllowTF32CuBLAS(false);

at::globalContext().setAllowTF32CuDNN(false);有关TF32的更多信息,请参阅:

FP16 GEMM中的降低精度计算

(不同于专为硬件设计的全FP16累加方案------该方案在FP16累加时比FP32累加具有更高吞吐量,详见全FP16累加章节)

fp16 GEMM运算可能会采用部分中间结果的降低精度计算(例如使用fp16而非fp32)。这种选择性降低精度的方法能在特定工作负载(尤其是k维度较大的情况)和GPU架构上实现更高性能,但代价是数值精度降低和潜在的溢出风险。

V100显卡上的基准测试数据示例如下:

yaml

[--------------------------- bench_gemm_transformer --------------------------]

[ m , k , n ] | allow_fp16_reduc=True | allow_fp16_reduc=False

1 threads: ---------------------------------------------------

[4096, 4048, 4096] | 1634.6 | 1639.8

[4096, 4056, 4096] | 1670.8 | 1661.9

[4096, 4080, 4096] | 1664.2 | 1658.3

[4096, 4096, 4096] | 1639.4 | 1651.0

[4096, 4104, 4096] | 1677.4 | 1674.9

[4096, 4128, 4096] | 1655.7 | 1646.0

[4096, 4144, 4096] | 1796.8 | 2519.6

[4096, 5096, 4096] | 2094.6 | 3190.0

[4096, 5104, 4096] | 2144.0 | 2663.5

[4096, 5112, 4096] | 2149.1 | 2766.9

[4096, 5120, 4096] | 2142.8 | 2631.0

[4096, 9728, 4096] | 3875.1 | 5779.8

[4096, 16384, 4096] | 6182.9 | 9656.5

(times in microseconds).如果需要完全精度缩减,用户可以通过以下方式禁用 fp16 GEMM 中的缩减精度缩减:

python

torch.backends.cuda.matmul.allow_fp16_reduced_precision_reduction = False要在 C++ 中切换降低精度缩减标志,可以这样做

c

at::globalContext().setAllowFP16ReductionCuBLAS(false);BF16 GEMM中的降低精度缩减

BFloat16 GEMM也存在类似的标志(如上所述)。

请注意,对于BF16,此开关默认设置为True。如果在您的工作负载中观察到数值不稳定性,可以将其设为False。

如果不希望使用降低精度缩减,用户可以通过以下方式在bf16 GEMM中禁用该功能:

python

torch.backends.cuda.matmul.allow_bf16_reduced_precision_reduction = False要在 C++ 中切换降低精度的缩减标志,可以这样做

c

at::globalContext().setAllowBF16ReductionCuBLAS(true);FP16 GEMM 中的全 FP16 累加

某些 GPU 在执行 全部 FP16 GEMM 累加时性能会提升,但代价是数值精度降低和溢出概率增加。

请注意,此设置仅对计算能力 7.0(Volta)或更高版本的 GPU 有效。

可通过以下方式启用该行为:

python

torch.backends.cuda.matmul.allow_fp16_accumulation = True在 C++ 中切换降低精度缩减标志,可以通过以下方式实现:

at::globalContext().setAllowFP16AccumulationCuBLAS(true);异步执行

默认情况下,GPU操作是异步的。当调用使用GPU的函数时,操作会被加入队列到特定设备,但不一定会立即执行。这让我们可以并行执行更多计算,包括CPU或其他GPU上的操作。

通常来说,异步计算对调用者是不可见的,因为:(1) 每个设备会按照操作入队顺序执行;(2) PyTorch在CPU与GPU之间或两个GPU之间复制数据时,会自动执行必要的同步。因此,计算过程的表现就像所有操作都是同步执行的。

你可以通过设置环境变量CUDA_LAUNCH_BLOCKING=1来强制同步计算。这在GPU发生错误时很有用(异步执行时,这类错误要到操作实际执行后才会报告,因此堆栈追踪不会显示错误请求的位置)。

异步计算的一个影响是:未同步的时间测量是不准确的。要获得精确测量,应该在测量前调用torch.cuda.synchronize(),或者使用torch.cuda.Event来记录时间,如下所示:

python

start_event = torch.cuda.Event(enable_timing=True)

end_event = torch.cuda.Event(enable_timing=True)

start_event.record()

# Run some things here

end_event.record()

torch.cuda.synchronize() # Wait for the events to be recorded!

elapsed_time_ms = start_event.elapsed_time(end_event)作为例外情况,某些函数如 to() 和 copy_() 提供了显式的 non_blocking 参数,允许调用者在不需要同步时绕过该机制。

另一个例外是 CUDA 流,具体说明如下。

CUDA 流

CUDA 流是属于特定设备的线性执行序列。通常您不需要显式创建流:默认情况下,每个设备会使用自己的"默认"流。

同一流内的操作会按照创建顺序串行执行,但不同流中的操作可以以任意相对顺序并发执行,除非使用了显式同步函数(例如 synchronize() 或 wait_stream())。例如,以下代码是错误的:

python

cuda = torch.device('cuda')

s = torch.cuda.Stream() # Create a new stream.

A = torch.empty((100, 100), device=cuda).normal_(0.0, 1.0)

with torch.cuda.stream(s):

# sum() may start execution before normal_() finishes!

B = torch.sum(A)当"当前流"是默认流时,PyTorch会自动执行必要的数据同步操作(如上文所述)。但在使用非默认流时,用户需自行确保正确的同步。以下是修正后的示例代码:

python

cuda = torch.device('cuda')

s = torch.cuda.Stream() # Create a new stream.

A = torch.empty((100, 100), device=cuda).normal_(0.0, 1.0)

s.wait_stream(torch.cuda.default_stream(cuda)) # NEW!

with torch.cuda.stream(s):

B = torch.sum(A)

A.record_stream(s) # NEW!新增了两项功能。调用 torch.cuda.Stream.wait_stream() 可以确保在侧流上开始运行 sum(A) 之前,normal_() 的执行已经完成。torch.Tensor.record_stream()(详见文档)则确保在 sum(A) 完成之前不会释放张量 A 的内存。你也可以稍后通过 torch.cuda.default_stream(cuda).wait_stream(s) 手动等待流(注意立即等待没有意义,这会阻止该流与默认流上的其他工作并行执行)。关于何时使用这两种方法,请参阅 torch.Tensor.record_stream() 的文档说明。

需要注意的是,即使没有读取依赖关系(如此例所示),这种同步操作也是必要的。

python

cuda = torch.device('cuda')

s = torch.cuda.Stream() # Create a new stream.

A = torch.empty((100, 100), device=cuda)

s.wait_stream(torch.cuda.default_stream(cuda)) # STILL REQUIRED!

with torch.cuda.stream(s):

A.normal_(0.0, 1.0)

A.record_stream(s)尽管对 s 的计算不会读取 A 的内容且 A 没有其他用途,但仍然需要进行同步操作。这是因为 A 可能对应由 CUDA 缓存分配器重新分配的内存,其中可能包含来自旧(已释放)内存的待处理操作。

反向传播的流语义

每个反向CUDA操作都运行在其对应前向操作所使用的同一流上。如果前向传播在不同流上并行运行独立操作,这种设计有助于反向传播利用相同的并行性。

反向调用相对于周围操作的流语义与其他任何调用相同。反向传播会插入内部同步以确保这一点,即使反向操作如上一段所述运行在多个流上。更具体地说,当调用以下函数时:

autograd.backward、autograd.grad或

tensor.backward,并可选地提供CUDA张量作为初始梯度( 例如autograd.backward(..., grad_tensors=initial_grads)、 autograd.grad(..., grad_outputs=initial_grads)或

tensor.backward(..., gradient=initial_grad)),以下三个操作:

1、可选地填充初始梯度

2、调用反向传播

3、使用梯度

它们之间的流语义关系与任何操作组相同。

python

s = torch.cuda.Stream()

# Safe, grads are used in the same stream context as backward()

with torch.cuda.stream(s):

loss.backward()

use grads

# Unsafe

with torch.cuda.stream(s):

loss.backward()

use grads

# Safe, with synchronization

with torch.cuda.stream(s):

loss.backward()

torch.cuda.current_stream().wait_stream(s)

use grads

# Safe, populating initial grad and invoking backward are in the same stream context

with torch.cuda.stream(s):

loss.backward(gradient=torch.ones_like(loss))

# Unsafe, populating initial_grad and invoking backward are in different stream contexts, # without synchronization

initial_grad = torch.ones_like(loss)

with torch.cuda.stream(s):

loss.backward(gradient=initial_grad)

# Safe, with synchronization

initial_grad = torch.ones_like(loss)

s.wait_stream(torch.cuda.current_stream())

with torch.cuda.stream(s):

initial_grad.record_stream(s)

loss.backward(gradient=initial_grad)BC 说明:在默认流上使用梯度

在 PyTorch 的早期版本(1.9 及之前)中,自动梯度引擎总是将默认流与所有反向操作同步,因此以下模式:

python

with torch.cuda.stream(s):

loss.backward()

use grads只要use grads发生在默认流上就是安全的。

在当前版本的PyTorch中,这种模式不再安全。如果backward()和use grads处于不同的流上下文中,你必须同步这些流:

python

with torch.cuda.stream(s):

loss.backward()

torch.cuda.current_stream().wait_stream(s)

use grads即使启用了 use grads 选项,也会使用默认流。

内存管理

PyTorch 使用缓存内存分配器来加速内存分配。这种机制无需设备同步即可实现快速内存释放。但分配器管理的未使用内存仍会在 nvidia-smi 中显示为已占用。您可以通过 memory_allocated() 和 max_memory_allocated() 监控张量占用的内存,使用 memory_reserved() 和 max_memory_reserved() 监控缓存分配器管理的总内存量。调用 empty_cache() 会释放 PyTorch 中所有未使用的缓存内存,供其他 GPU 应用程序使用。但已分配给张量的 GPU 内存不会被释放,因此不会增加 PyTorch 可用的 GPU 内存总量。

要深入了解 CUDA 内存随时间的使用情况,理解 CUDA 内存使用 文档介绍了捕获和可视化内存使用轨迹的工具。

对于高级用户,我们通过 memory_stats() 提供更全面的内存基准测试功能。此外,通过 memory_snapshot() 可以捕获内存分配器状态的完整快照,帮助您理解代码产生的底层内存分配模式。

使用 PYTORCH_CUDA_ALLOC_CONF 优化内存占用

缓存分配器的使用可能会干扰 cuda-memcheck 等内存检查工具。若需通过 cuda-memcheck 调试内存错误,可在环境中设置 PYTORCH_NO_CUDA_MEMORY_CACHING=1 来禁用缓存。

缓存分配器的行为可通过环境变量 PYTORCH_CUDA_ALLOC_CONF 控制,其格式为:

PYTORCH_CUDA_ALLOC_CONF=<选项>:<值>,<选项2>:<值2>...

可用选项包括:

backend:选择底层分配器实现。当前有效选项为:native:使用 PyTorch 原生实现cudaMallocAsync:使用 CUDA 内置异步分配器(需 CUDA 11.4 或更高版本)

默认值为native。此设置对进程使用的所有设备生效,无法按设备单独指定。

max_split_size_mb:阻止原生分配器拆分超过此大小(MB)的内存块,可减少碎片化并帮助临界工作负载避免内存耗尽。性能开销从"零"到"显著"不等,具体取决于分配模式。默认值为无限制(允许拆分所有块)。建议通过memory_stats()和memory_summary()方法进行调优。此选项应作为因"内存不足"而中止且显示大量非活动拆分块的工作负载的最后手段。仅对backend:native有效。roundup_power2_divisions:将请求的分配大小舍入到最近的 2 次幂分频值,以提升内存块利用率。

原生 CUDACachingAllocator 默认以 512 字节块大小的倍数向上取整,这对小尺寸效果良好,但对相邻大分配可能效率低下(导致块复用率降低)。

此选项支持将分配大小舍入到最近的 2 次幂分频值。例如:1200 的分配大小在 4 分频时会舍入为 1280(介于 1024-2048 之间的分频值为 1024/1280/1536/1792)。

可指定单一全局值或键值对数组(如[256:1,512:2,1024:4,>:8]表示:<256MB 用 1 分频,256-512MB 用 2 分频等)。仅对backend:native有效。max_non_split_rounding_mb:允许非拆分块更大范围的复用(例如 1024MB 缓存块可复用于 512MB 请求)。默认仅允许 20MB 舍入范围(512MB 块只能服务 512-532MB 请求),设为 1024 时将扩展至 512-1536MB 范围,减少 cudaMalloc 调用延迟。garbage_collection_threshold:主动回收未使用的 GPU 内存以避免触发昂贵的同步全回收操作(release_cached_blocks),这对延迟敏感的 GPU 应用(如服务器)尤为重要。

设置阈值(如 0.8)后,当 GPU 内存使用超过阈值(总内存的 80%)时将启动回收,优先释放老旧未用块。阈值需在 0.0-1.0 之间。仅对backend:native有效。expandable_segments(实验性,默认 False):设为 True 时,分配器会创建可扩展的 CUDA 分配段,适用于分配大小频繁变化的场景(如动态批量大小)。

传统方式对大分配(>2MB)直接调用 cudaMalloc,而此模式改为创建可扩展段(每流一个),通过动态扩展减少内存碎片。当批量从 N 增至 N+1 时,新分配会整齐填入扩展段,避免产生大量不可用内存碎片。pinned_use_cuda_host_register:布尔标志,决定是否使用 CUDA API 的 cudaHostRegister 函数(而非默认的 cudaHostAlloc)分配固定内存。

设为 True 时,先通过常规 malloc 分配内存,再调用 cudaHostRegister 前映射内存页,可减少锁定时长。pinned_num_register_threads:仅在 pinned_use_cuda_host_register=True 时有效。默认使用单线程映射内存页,此选项允许使用多线程并行化页映射操作以缩短固定内存分配时间。基准测试建议值为 8。pinned_use_background_threads:布尔标志,启用后台线程处理事件,避免快速分配路径中的事件查询/处理慢路径。默认禁用。

注意:CUDA 内存管理 API 报告的某些统计信息仅适用于 backend:native,对 backend:cudaMallocAsync 无意义。详见各函数的文档说明。

为CUDA使用自定义内存分配器

在C/C++中可以将分配器定义为简单的函数,并将其编译为共享库。以下代码展示了一个基础分配器,仅用于追踪所有内存操作。

c

#include <sys/types.h>

#include <cuda_runtime_api.h>

#include <iostream>

// Compile with g++ alloc.cc -o alloc.so -I/usr/local/cuda/include -shared -fPIC

extern "C" {

void* my_malloc(ssize_t size, int device, cudaStream_t stream) {

void *ptr;

cudaMalloc(&ptr, size);

std::cout<<"alloc "<<ptr<<size<<std::endl;

return ptr;

}

void my_free(void* ptr, ssize_t size, int device, cudaStream_t stream) {

std::cout<<"free "<<ptr<< " "<<stream<<std::endl;

cudaFree(ptr);

}

}在 Python 中可以通过 torch.cuda.memory.CUDAPluggableAllocator 使用该功能。

用户需要自行提供 .so 文件的路径,以及符合上述签名的 alloc/free 函数名称。

python

import torch

# Load the allocator

new_alloc = torch.cuda.memory.CUDAPluggableAllocator(

'alloc.so', 'my_malloc', 'my_free')

# Swap the current allocator

torch.cuda.memory.change_current_allocator(new_alloc)

# This will allocate memory in the device using the new allocator

b = torch.zeros(10, device='cuda')

python

import torch

# Do an initial memory allocator

b = torch.zeros(10, device='cuda')

# Load the allocator

new_alloc = torch.cuda.memory.CUDAPluggableAllocator(

'alloc.so', 'my_malloc', 'my_free')

# This will error since the current allocator was already instantiated

torch.cuda.memory.change_current_allocator(new_alloc)在同一程序中混合使用不同的CUDA系统分配器

根据您的使用场景,change_current_allocator()可能并非理想选择,因为它会替换整个程序的CUDA分配器(类似于设置PYTORCH_CUDA_ALLOC_CONF=backend:cudaMallocAsync)。例如,如果替换的分配器不具备缓存机制,您将失去PyTorch的CUDACachingAllocator的所有优势。作为替代方案,您可以通过torch.cuda.MemPool选择性地标记PyTorch代码区域来使用自定义分配器。

这样可以在同一个PyTorch程序中同时使用多个CUDA系统分配器,同时保留CUDACachingAllocator的大部分优势(如缓存功能)。

通过torch.cuda.MemPool,您可以利用支持以下特性的自定义分配器:

- 使用

ncclMemAlloc分配器为all-reduce操作分配输出缓冲区,可启用NVLink Switch Reductions(NVLS)。

这能减少GPU资源(SM和复制引擎)上重叠计算与通信内核的竞争,特别适用于张量并行工作负载。 - 对于基于Grace CPU的系统,使用

cuMemCreate为all-gather操作分配主机输出缓冲区,并指定CU_MEM_LOCATION_TYPE_HOST_NUMA,可启用基于扩展GPU内存(EGM)的从源GPU到目标CPU的内存传输。

由于传输通过NVLink进行(而非带宽受限的网卡链路),这会加速all-gather操作,进而加快模型检查点保存速度。 - 如果您正在构建模型,且不希望初期考虑内存密集型模块(如嵌入表)的最佳内存位置,或者某个模块对性能不敏感且无法放入GPU,可以直接使用

cudaMallocManaged以CPU为首选位置分配该模块,先让模型运行起来。

注意:虽然cudaMallocManaged通过CUDA统一虚拟内存(UVM)提供了便捷的自动内存管理,但不建议用于深度学习工作负载。

对于能放入GPU内存的深度学习任务,显式内存放置方案始终优于UVM,因为前者没有页面错误且访问模式可预测。

当GPU内存饱和时,UVM必须执行代价高昂的双重传输:先将页面驱逐到CPU,再载入新页面。

以下代码展示了封装在torch.cuda.memory.CUDAPluggableAllocator中的ncclMemAlloc实现。

python

import os

import torch

import torch.distributed as dist

from torch.cuda.memory import CUDAPluggableAllocator

from torch.distributed.distributed_c10d import _get_default_group

from torch.utils import cpp_extension

# create allocator

nccl_allocator_source = """

#include <nccl.h>

#include <iostream>

extern "C" {

void* nccl_alloc_plug(size_t size, int device, void* stream) {

std::cout << "Using ncclMemAlloc" << std::endl;

void* ptr;

ncclResult_t err = ncclMemAlloc(&ptr, size);

return ptr;

}

void nccl_free_plug(void* ptr, size_t size, int device, void* stream) {

std::cout << "Using ncclMemFree" << std::endl;

ncclResult_t err = ncclMemFree(ptr);

}

}

"""

nccl_allocator_libname = "nccl_allocator"

nccl_allocator = torch.utils.cpp_extension.load_inline(

name=nccl_allocator_libname, cpp_sources=nccl_allocator_source, with_cuda=True, extra_ldflags=["-lnccl"], verbose=True, is_python_module=False, build_directory="./", )

allocator = CUDAPluggableAllocator(

f"./{nccl_allocator_libname}.so", "nccl_alloc_plug", "nccl_free_plug"

).allocator()

# setup distributed

rank = int(os.getenv("RANK"))

local_rank = int(os.getenv("LOCAL_RANK"))

world_size = int(os.getenv("WORLD_SIZE"))

torch.cuda.set_device(local_rank)

dist.init_process_group(backend="nccl")

device = torch.device(f"cuda:{local_rank}")

default_pg = _get_default_group()

backend = default_pg._get_backend(device)

# Note: for convenience, ProcessGroupNCCL backend provides

# the ncclMemAlloc allocator as backend.mem_allocator

allocator = backend.mem_allocator现在你可以通过将这个分配器传递给 torch.cuda.MemPool 来定义一个新的内存池:

python

pool = torch.cuda.MemPool(allocator)然后可以使用 torch.cuda.use_mem_pool 上下文管理器将该内存池用于张量分配:

python

with torch.cuda.use_mem_pool(pool):

# tensor gets allocated with ncclMemAlloc passed in the pool

tensor = torch.arange(1024 * 1024 * 2, device=device)

print(f"tensor ptr on rank {rank} is {hex(tensor.data_ptr())}")

# register user buffers using ncclCommRegister (called under the hood)

backend.register_mem_pool(pool)

# Collective uses Zero Copy NVLS

dist.all_reduce(tensor[0:4])

torch.cuda.synchronize()

print(tensor[0:4])注意上面示例中register_mem_pool的用法。这是NVLS规约操作所需的额外步骤,用户需要将缓冲区注册到NCCL。用户可以通过类似的deregister_mem_pool调用来注销缓冲区。

要回收内存,用户首先需要确保没有操作正在使用该内存池。当所有张量都不再持有该内存池的引用时,在删除内存池时会自动调用empty_cache(),从而将所有内存返还给系统。

del tensor, del pool以下 torch.cuda.MemPool.use_count() 和 torch.cuda.MemPool.snapshot() API 可用于调试目的:

python

pool = torch.cuda.MemPool(allocator)

# pool's use count should be 1 at this point as MemPool object

# holds a reference

assert pool.use_count() == 1

nelem_1mb = 1024 * 1024 // 4

with torch.cuda.use_mem_pool(pool):

out_0 = torch.randn(nelem_1mb, device="cuda")

# pool's use count should be 2 at this point as use_mem_pool

# holds a reference

assert pool.use_count() == 2

# pool's use count should be back to 1 at this point as use_mem_pool

# released its reference

assert pool.use_count() == 1

with torch.cuda.use_mem_pool(pool):

# pool should have 1 segment since we made a small allocation (1 MB)

# above and so the CUDACachingAllocator packed it into a 2 MB buffer

assert len(pool.snapshot()) == 1

out_1 = torch.randn(nelem_1mb, device="cuda")

# pool should still have 1 segment since we made another small allocation

# (1 MB) that got packed into the existing 2 MB buffer

assert len(pool.snapshot()) == 1

out_2 = torch.randn(nelem_1mb, device="cuda")

# pool now should have 2 segments since the CUDACachingAllocator had

# to make a new 2 MB buffer to accomodate out_2

assert len(pool.snapshot()) == 2注意:

torch.cuda.MemPool会持有内存池的引用。当使用torch.cuda.use_mem_pool上下文管理器时,它也会获取对内存池的另一个引用。在退出上下文管理器时,它会释放该引用。

此后,理想情况下应仅剩张量持有对内存池的引用。当张量释放其引用后,内存池的使用计数将为1,表示只有torch.cuda.MemPool对象仍持有引用。只有到那时,在调用内存池的析构函数del时,内存池持有的内存才能被释放回系统。torch.cuda.MemPool目前不支持 CUDACachingAllocator 的expandable_segments模式。- NCCL 对缓冲区有特定要求,以确保其与 NVLS 归约操作兼容。

在动态工作负载中,这些要求可能会被破坏。例如,CUDACachingAllocator 发送给 NCCL 的缓冲区可能会被分割,从而导致未正确对齐。在这种情况下,NCCL 可以使用备用算法代替 NVLS。 - 像

ncclMemAlloc这样的分配器由于对齐要求(CU_MULTICAST_GRANULARITY_RECOMMENDED、CU_MULTICAST_GRANULARITY_MINIMUM),可能会分配比请求更多的内存,从而导致工作负载耗尽内存。

cuBLAS 工作空间

对于每个 cuBLAS 句柄与 CUDA 流的组合,当该组合执行需要工作空间的 cuBLAS 内核时,系统会分配一个 cuBLAS 工作空间。为了避免重复分配,这些工作空间不会被释放,除非显式调用 torch._C._cuda_clearCublasWorkspaces() 方法。

每个分配的工作空间大小可通过环境变量 CUBLAS_WORKSPACE_CONFIG 指定,格式为 :[SIZE]:[COUNT]。例如,默认配置 CUBLAS_WORKSPACE_CONFIG=:4096:2:16:8 表示总空间大小为 2 * 4096 + 8 * 16 KiB。若需强制禁用 cuBLAS 工作空间,可设置为 CUBLAS_WORKSPACE_CONFIG=:0:0。

cuFFT 计划缓存

针对每个 CUDA 设备,系统会使用一个 LRU 缓存来存储 cuFFT 计划,以加速在相同几何形状和配置的 CUDA 张量上重复运行 FFT 方法(例如 torch.fft.fft())。由于某些 cuFFT 计划可能会分配 GPU 内存,这些缓存设有最大容量限制。

您可以通过以下 API 控制和查询当前设备的缓存属性:

torch.backends.cuda.cufft_plan_cache.max_size提供缓存的容量(在 CUDA 10 及更新版本中默认为 4096,旧版 CUDA 中默认为 1023)。直接设置该值可修改容量。torch.backends.cuda.cufft_plan_cache.size提供当前缓存中驻留的计划数量。torch.backends.cuda.cufft_plan_cache.clear()用于清空缓存。

要控制和查询非默认设备的计划缓存,您可以通过 torch.device 对象或设备索引来访问 torch.backends.cuda.cufft_plan_cache 对象,并获取上述任一属性。

例如,要将设备 1 的缓存容量设置为 10,可执行:

torch.backends.cuda.cufft_plan_cache[1].max_size = 10。

即时编译

PyTorch 会对某些操作(如 torch.special.zeta)在 CUDA 张量上执行时进行即时编译。这种编译可能非常耗时(根据硬件和软件配置,最长可达数秒),并且单个算子可能触发多次编译------因为许多 PyTorch 算子实际上会从多个内核中选择执行,每个内核都需要根据输入类型编译一次。该编译过程每个进程仅发生一次,若启用内核缓存则全局仅需编译一次。

默认情况下,PyTorch 会在以下路径创建内核缓存:

- 若定义了

XDG_CACHE_HOME环境变量:$XDG_CACHE_HOME/torch/kernels - 未定义时:

$HOME/.cache/torch/kernels

(注意:Windows 系统暂不支持内核缓存功能)

可通过两个环境变量直接控制缓存行为:

- 设置

USE_PYTORCH_KERNEL_CACHE=0将禁用缓存 - 设置

PYTORCH_KERNEL_CACHE_PATH可指定自定义缓存路径替代默认位置

最佳实践

设备无关代码

由于PyTorch的结构特性,你可能需要显式编写设备无关(CPU或GPU)的代码。

例如,创建一个新张量作为循环神经网络的初始隐藏状态时就需要这种处理。

第一步是确定是否应该使用GPU。常见的做法是利用Python的argparse模块读取用户参数,并通过结合is_available()方法设置一个禁用CUDA的标志。在下述代码中,args.device会生成一个torch.device对象,该对象可用于将张量移至CPU或CUDA。

python

import argparse

import torch

parser = argparse.ArgumentParser(description='PyTorch Example')

parser.add_argument('--disable-cuda', action='store_true', help='Disable CUDA')

args = parser.parse_args()

args.device = None

if not args.disable_cuda and torch.cuda.is_available():

args.device = torch.device('cuda')

else:

args.device = torch.device('cpu')注意:在评估特定环境中CUDA的可用性时(通过is_available()),PyTorch的默认行为是调用CUDA Runtime API方法cudaGetDeviceCount。由于该调用会反过来初始化CUDA Driver API(通过cuInit),如果尚未初始化,那么后续运行过is_available()的进程fork将会因CUDA初始化错误而失败。

您可以在导入执行is_available()的PyTorch模块之前(或直接执行该函数之前),在环境中设置PYTORCH_NVML_BASED_CUDA_CHECK=1,以指示is_available()尝试基于NVML的评估(nvmlDeviceGetCount_v2)。如果基于NVML的评估成功(即NVML的发现/初始化未失败),is_available()调用将不会影响后续的进程fork。

如果NVML发现/初始化失败,is_available()将回退到标准的CUDA Runtime API评估,此时上述fork限制将适用。

需要注意的是,基于NVML的CUDA可用性评估提供的保证比默认的CUDA Runtime API方法(要求CUDA初始化成功)更弱。

在某些情况下,基于NVML的检查可能成功,但后续的CUDA初始化会失败。

现在我们有了args.device,可以用它在目标设备上创建张量。

x = torch.empty((8, 42), device=args.device)

net = Network().to(device=args.device)这可用于多种场景来生成与设备无关的代码。以下是使用数据加载器时的示例:

python

cuda0 = torch.device('cuda:0') # CUDA GPU 0

for i, x in enumerate(train_loader):

x = x.to(cuda0)在系统上使用多个GPU时,可以通过CUDA_VISIBLE_DEVICES环境变量来控制PyTorch可用的GPU设备。如前所述,要手动指定张量创建在哪个GPU上,最佳实践是使用torch.cuda.device上下文管理器。

print("Outside device is 0") # On device 0 (default in most scenarios)

with torch.cuda.device(1):

print("Inside device is 1") # On device 1

print("Outside device is still 0") # On device 0如果你有一个张量,并希望在同一设备上创建相同类型的新张量,可以使用 torch.Tensor.new_* 方法(参见 torch.Tensor)。

虽然前面提到的 torch.* 工厂函数(创建操作)依赖于当前 GPU 上下文和传入的属性参数,但 torch.Tensor.new_* 方法会保留张量的设备和其他属性。

在编写需要在前向传播过程中内部创建新张量的模块时,这是推荐的做法。

python

cuda = torch.device('cuda')

x_cpu = torch.empty(2)

x_gpu = torch.empty(2, device=cuda)

x_cpu_long = torch.empty(2, dtype=torch.int64)

y_cpu = x_cpu.new_full([3, 2], fill_value=0.3)

print(y_cpu)

tensor([[ 0.3000, 0.3000], [ 0.3000, 0.3000], [ 0.3000, 0.3000]])

y_gpu = x_gpu.new_full([3, 2], fill_value=-5)

print(y_gpu)

tensor([[-5.0000, -5.0000], [-5.0000, -5.0000], [-5.0000, -5.0000]], device='cuda:0')

y_cpu_long = x_cpu_long.new_tensor([[1, 2, 3]])

print(y_cpu_long)

tensor([[ 1, 2, 3]])如果你想创建一个与另一个张量类型和大小相同的张量,并用全1或全0填充,可以使用便捷的辅助函数 ones_like() 或 zeros_like()(这些函数还会保留张量的 torch.device 和 torch.dtype 属性)。

x_cpu = torch.empty(2, 3)

x_gpu = torch.empty(2, 3)

y_cpu = torch.ones_like(x_cpu)

y_gpu = torch.zeros_like(x_gpu)使用固定内存缓冲区

警告:这是高级技巧。过度使用固定内存可能导致内存不足时出现严重问题,且需注意固定操作通常开销较大。

当数据从固定(页锁定)内存传输时,主机到GPU的复制速度会显著提升。CPU张量和存储对象提供了 pin_memory() 方法,该方法会返回数据存放在固定内存区域的对象副本。

此外,固定张量或存储后,可启用异步GPU复制。只需在调用 to() 或 cuda() 时附加参数 non_blocking=True,即可实现数据传输与计算的重叠执行。

通过向 DataLoader 构造函数传递 pin_memory=True 参数,可使返回的批次数据直接存放在固定内存中。

使用 nn.parallel.DistributedDataParallel 替代 multiprocessing 或 nn.DataParallel

对于涉及批量输入和多 GPU 的大多数用例,默认应使用 DistributedDataParallel 来利用多个 GPU。

使用 CUDA 模型配合 multiprocessing 存在重大注意事项:除非严格满足数据处理要求,否则程序很可能出现错误或未定义行为。

建议使用 DistributedDataParallel 而非 DataParallel 进行多 GPU 训练,即使只有单个节点。

DistributedDataParallel 与 DataParallel 的区别在于:前者采用多进程方式为每个 GPU 创建独立进程,而后者使用多线程。通过多进程机制,每个 GPU 拥有专属进程,从而避免了 Python 解释器 GIL 带来的性能开销。

若使用 DistributedDataParallel,可通过 torch.distributed.launch 工具启动程序,详见第三方后端。

CUDA 图

CUDA 图是对 CUDA 流及其依赖流所执行工作(主要是内核及其参数)的记录。关于 CUDA 底层 API 的基本原理和详细信息,请参阅 CUDA 图入门指南 和 CUDA C 编程指南中的图章节。

PyTorch 支持通过流捕获来构建 CUDA 图,该功能将 CUDA 流置于捕获模式。在捕获流中提交的 CUDA 工作实际上不会在 GPU 上运行,而是会被记录到图中。

捕获完成后,可以启动该图来多次运行 GPU 工作。每次重放都会使用相同的参数执行相同的内核。对于指针参数,这意味着使用相同的内存地址。通过在每次重放前用新数据(例如来自新批次的数据)填充输入内存,可以在新数据上重新运行相同的工作。

为什么选择CUDA Graphs?

重放图(graph replay)通过牺牲典型即时执行(eager execution)的动态灵活性,换取了显著降低的CPU开销。由于图的参数和内核是固定的,重放过程会跳过所有参数设置和内核调度的层级,包括Python、C++和CUDA驱动的开销。

在底层实现中,重放通过单次调用cudaGraphLaunch将整个图的工作提交给GPU。重放中的内核在GPU上的执行也会稍快一些,但消除CPU开销才是主要优势。

如果您的整个或部分网络符合图安全条件(通常意味着静态形状和静态控制流,但需参见其他限制条件),并且您怀疑其运行时至少部分受限于CPU性能,那么应该尝试使用CUDA Graphs。

PyTorch API

警告:此API处于测试阶段,未来版本可能会有变更。

PyTorch通过原始的torch.cuda.CUDAGraph类以及两个便捷封装器torch.cuda.graph和torch.cuda.make_graphed_callables来暴露图计算功能。

torch.cuda.graph是一个简单通用的上下文管理器,用于捕获其上下文中的CUDA操作。在捕获前,需要通过运行几次即时模式的迭代来预热待捕获的工作负载。预热必须在侧流(side stream)上进行。

由于图在每次重放时都会读写相同的内存地址,因此必须保持对输入输出数据张量的长期引用。要在新输入数据上运行图,需将新数据复制到捕获的输入张量中,重放图计算,然后从捕获的输出张量中读取新结果。示例:

python

g = torch.cuda.CUDAGraph()

# Placeholder input used for capture

static_input = torch.empty((5,), device="cuda")

# Warmup before capture

s = torch.cuda.Stream()

s.wait_stream(torch.cuda.current_stream())

with torch.cuda.stream(s):

for _ in range(3):

static_output = static_input * 2

torch.cuda.current_stream().wait_stream(s)

# Captures the graph

# To allow capture, automatically sets a side stream as the current stream in the context

with torch.cuda.graph(g):

static_output = static_input * 2

# Fills the graph's input memory with new data to compute on static_input.copy_(torch.full((5,), 3, device="cuda"))

g.replay()

# static_output holds the results

print(static_output) # full of 3 * 2 = 6

# Fills the graph's input memory with more data to compute on static_input.copy_(torch.full((5,), 4, device="cuda"))

g.replay()

print(static_output) # full of 4 * 2 = 8请参考以下实际应用和高级模式:

全网络捕获、[与 torch.cuda.amp 配合使用](#与 torch.cuda.amp 配合使用) 以及 多流捕获

make_graphed_callables 功能更为复杂。

该方法支持 Python 函数和 torch.nn.Module 模块,会为每个传入的函数或模块分别创建前向传播和后向传播的计算图。具体实现可参阅:

约束条件

一组操作如果满足以下所有约束条件,则被视为可捕获的。

这些约束适用于 torch.cuda.graph 上下文中的所有工作,以及传递给 torch.cuda.make_graphed_callables() 的任何可调用对象的前向和反向传播过程中的所有工作。

违反以下任何一条都可能导致运行时错误:

- 捕获操作必须在非默认流上进行。(仅在使用原始方法

CUDAGraph.capture_begin和CUDAGraph.capture_end时需要注意,graph和make_graphed_callables()会自动为你设置一个侧流。) - 禁止执行会同步 CPU 和 GPU 的操作(例如

.item()调用)。 - 允许执行 CUDA 随机数生成(RNG)操作。如果在图中使用多个

torch.Generator实例,必须在图捕获前通过CUDAGraph.register_generator_state注册这些实例。

避免在捕获过程中使用Generator.get_state和Generator.set_state,而应使用Generator.graphsafe_set_state和Generator.graphsafe_get_state来安全地管理生成器状态,以确保在 CUDA 图上下文中正确执行 RNG 操作和生成器管理。

违反以下任何一条可能导致静默数值错误或未定义行为:

- 在同一进程中,同一时间只能进行一次捕获操作。

- 捕获过程中,该进程(任何线程)不得运行非捕获的 CUDA 工作。

- CPU 工作不会被捕获。如果捕获的操作包含 CPU 工作,重放时会忽略这部分工作。

- 每次重放都会读取和写入相同的(虚拟)内存地址。

- 禁止基于 CPU 或 GPU 数据的动态控制流。

- 禁止使用动态形状。图假设捕获的操作序列中的每个张量在每次重放时具有相同的大小和布局。

- 允许在捕获中使用多流,但存在限制条件。

非约束条件

- 一旦捕获完成,该计算图可以在任何流上重放执行。

全网捕获

如果您的整个网络流量可被捕获,您就能捕获并重放完整的网络交互过程:

python

***

N, D_in, H, D_out = 640, 4096, 2048, 1024

model = torch.nn.Sequential(torch.nn.Linear(D_in, H), torch.nn.Dropout(p=0.2), torch.nn.Linear(H, D_out), torch.nn.Dropout(p=0.1)).cuda()

loss_fn = torch.nn.MSELoss()

optimizer = torch.optim.SGD(model.parameters(), lr=0.1)

# Placeholders used for capture

static_input = torch.randn(N, D_in, device='cuda')

static_target = torch.randn(N, D_out, device='cuda')

# warmup

# Uses static_input and static_target here for convenience, # but in a real setting, because the warmup includes optimizer.step()

# you must use a few batches of real data.

s = torch.cuda.Stream()

s.wait_stream(torch.cuda.current_stream())

with torch.cuda.stream(s):

for i in range(3):

optimizer.zero_grad(set_to_none=True)

y_pred = model(static_input)

loss = loss_fn(y_pred, static_target)

loss.backward()

optimizer.step()

torch.cuda.current_stream().wait_stream(s)

# capture

g = torch.cuda.CUDAGraph()

# Sets grads to None before capture, so backward() will create

# .grad attributes with allocations from the graph's private pool

optimizer.zero_grad(set_to_none=True)

with torch.cuda.graph(g):

static_y_pred = model(static_input)

static_loss = loss_fn(static_y_pred, static_target)

static_loss.backward()

optimizer.step()

real_inputs = [torch.rand_like(static_input) for _ in range(10)]

real_targets = [torch.rand_like(static_target) for _ in range(10)]

for data, target in zip(real_inputs, real_targets):

# Fills the graph's input memory with new data to compute on static_input.copy_(data)

static_target.copy_(target)

# replay() includes forward, backward, and step.

# You don't even need to call optimizer.zero_grad() between iterations

# because the captured backward refills static .grad tensors in place.

g.replay()

# Params have been updated. static_y_pred, static_loss, and .grad

# attributes hold values from computing on this iteration's data.部分网络捕获

如果您的网络中有部分内容不适合进行捕获(例如由于动态控制流、动态形状、CPU同步或关键CPU端逻辑),可以对这些不安全部分保持即时执行模式,同时使用torch.cuda.make_graphed_callables()仅对可安全捕获的部分进行图化处理。

默认情况下,make_graphed_callables()返回的可调用对象支持自动微分,可以直接在训练循环中替代原始函数或nn.Module。

make_graphed_callables()内部会创建CUDAGraph对象,执行预热迭代,并根据需要维护静态输入输出。因此(与torch.cuda.graph不同),您无需手动处理这些操作。

在以下示例中,数据相关的动态控制流导致网络无法端到端捕获,但通过make_graphed_callables(),我们依然可以将可图化的部分捕获并运行:

python

N, D_in, H, D_out = 640, 4096, 2048, 1024

module1 = torch.nn.Linear(D_in, H).cuda()

module2 = torch.nn.Linear(H, D_out).cuda()

module3 = torch.nn.Linear(H, D_out).cuda()

loss_fn = torch.nn.MSELoss()

optimizer = torch.optim.SGD( chain(module1.parameters(), module2.parameters(), module3.parameters()), lr=0.1)

# Sample inputs used for capture

# requires_grad state of sample inputs must match

# requires_grad state of real inputs each callable will see.

x = torch.randn(N, D_in, device='cuda')

h = torch.randn(N, H, device='cuda', requires_grad=True)

module1 = torch.cuda.make_graphed_callables(module1, (x,))

module2 = torch.cuda.make_graphed_callables(module2, (h,))

module3 = torch.cuda.make_graphed_callables(module3, (h,))

real_inputs = [torch.rand_like(x) for _ in range(10)]

real_targets = [torch.randn(N, D_out, device="cuda") for _ in range(10)]

for data, target in zip(real_inputs, real_targets):

optimizer.zero_grad(set_to_none=True)

tmp = module1(data) # forward ops run as a graph

if tmp.sum().item() > 0:

tmp = module2(tmp) # forward ops run as a graph

else:

tmp = module3(tmp) # forward ops run as a graph

loss = loss_fn(tmp, target)

# module2's or module3's (whichever was chosen) backward ops,

# as well as module1's backward ops, run as graphs

loss.backward()

optimizer.step()与 torch.cuda.amp 配合使用

对于常规优化器,GradScaler.step 会同步 CPU 与 GPU 的操作,这在捕获过程中是被禁止的。为避免错误,可以采用以下两种方案:

1、使用部分网络捕获功能

2、若前向传播、损失计算和反向传播是捕获安全的,则捕获这三个阶段但不捕获优化器步骤

python

# warmup

# In a real setting, use a few batches of real data.

s = torch.cuda.Stream()

s.wait_stream(torch.cuda.current_stream())

with torch.cuda.stream(s):

for i in range(3):

optimizer.zero_grad(set_to_none=True)

with torch.cuda.amp.autocast():

y_pred = model(static_input)

loss = loss_fn(y_pred, static_target)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

torch.cuda.current_stream().wait_stream(s)

# capture

g = torch.cuda.CUDAGraph()

optimizer.zero_grad(set_to_none=True)

with torch.cuda.graph(g):

with torch.cuda.amp.autocast():

static_y_pred = model(static_input)

static_loss = loss_fn(static_y_pred, static_target)

scaler.scale(static_loss).backward()

# don't capture scaler.step(optimizer) or scaler.update()

real_inputs = [torch.rand_like(static_input) for _ in range(10)]

real_targets = [torch.rand_like(static_target) for _ in range(10)]

for data, target in zip(real_inputs, real_targets):

static_input.copy_(data)

static_target.copy_(target)

g.replay()

# Runs scaler.step and scaler.update eagerly

scaler.step(optimizer)

scaler.update()多流使用方式

捕获模式会自动传播到与捕获流同步的所有流。在捕获过程中,您可以通过向不同流发起调用来展现并行性,但整个流依赖关系图必须在捕获开始后从初始捕获流分支出,并在捕获结束前重新汇合到初始流。

python

with torch.cuda.graph(g):

# at context manager entrance, torch.cuda.current_stream()

# is the initial capturing stream

# INCORRECT (does not branch out from or rejoin initial stream)

with torch.cuda.stream(s):

cuda_work()

# CORRECT:

# branches out from initial stream

s.wait_stream(torch.cuda.current_stream())

with torch.cuda.stream(s):

cuda_work()

# rejoins initial stream before capture ends

torch.cuda.current_stream().wait_stream(s)注意:为避免使用 nsight systems 或 nvprof 查看回放的高级用户产生混淆:

与即时执行不同,在捕获过程中,图会将非平凡的流 DAG 视为提示而非命令。

在回放期间,图可能会将独立操作重新组织到不同的流上,或以不同的顺序将它们加入队列(同时仍遵循原始 DAG 的整体依赖关系)。

与 DistributedDataParallel 配合使用

NCCL < 2.9.6 版本

NCCL 2.9.6 之前的版本不支持在计算图中捕获集合通信操作。

此时必须使用部分网络捕获方案,该方案会将所有reduce操作推迟到反向计算图的非图化部分执行。

在使用DDP包装网络之前,需先对可图化的网络部分调用 make_graphed_callables() 方法。

(注:保留所有代码块、链接和术语的原始格式,技术术语如NCCL、DDP、allreduces等未翻译,被动语态已转换为主动语态,长句进行了合理拆分)

NCCL >= 2.9.6

NCCL 2.9.6 或更高版本支持在计算图中执行集合操作。采用完整反向传播捕获的方法是可行的,但需要三个设置步骤:

1、禁用 DDP 的内部异步错误处理:

python

os.environ["NCCL_ASYNC_ERROR_HANDLING"] = "0"

torch.distributed.init_process_group(...)2、在实现完全反向捕获之前,必须在侧流上下文中构建DDP:

python

with torch.cuda.stream(s):

model = DistributedDataParallel(model)3、在开始捕获之前,您的预热过程必须至少运行11次启用DDP的即时模式迭代。

图内存管理

每次重放时,捕获的计算图都会操作相同的虚拟地址。如果PyTorch释放了这些内存,后续重放可能会触发非法内存访问。如果PyTorch将这些内存重新分配给新的张量,重放过程可能会破坏这些张量所持有的值。因此,计算图使用的虚拟地址必须在多次重放期间被保留。

PyTorch缓存分配器通过检测捕获过程,并从图专属的内存池中分配内存来实现这一目标。该私有内存池会一直存活,直到其对应的CUDAGraph对象及捕获期间创建的所有张量超出作用域。

私有内存池由系统自动维护。默认情况下,分配器会为每次捕获创建独立的私有内存池。这种保守策略确保了多个计算图的重放过程不会互相破坏数据值,但有时可能会造成不必要的内存浪费。

跨捕获共享内存

为了节省私有内存池中的内存占用,torch.cuda.graph 和 torch.cuda.make_graphed_callables() 提供了让不同捕获共享同一私有内存池的可选功能。当满足以下条件时,多个计算图共享私有内存池是安全的:

1、这些计算图总是按照捕获时的顺序回放

2、这些计算图永远不会并发回放

torch.cuda.graph 的 pool 参数用于指定使用特定的私有内存池,通过该参数可以实现跨计算图的内存共享,如下所示:

python

g1 = torch.cuda.CUDAGraph()

g2 = torch.cuda.CUDAGraph()

# (create static inputs for g1 and g2, run warmups of their workloads...)

# Captures g1

with torch.cuda.graph(g1):

static_out_1 = g1_workload(static_in_1)

# Captures g2, hinting that g2 may share a memory pool with g1

with torch.cuda.graph(g2, pool=g1.pool()):

static_out_2 = g2_workload(static_in_2)

static_in_1.copy_(real_data_1)

static_in_2.copy_(real_data_2)

g1.replay()

g2.replay()使用 torch.cuda.make_graphed_callables() 时,若需对多个可调用对象进行图捕获且已知它们总是按相同顺序运行(且永不并发),则应按实际工作负载中的执行顺序将它们作为元组传入。此时 make_graphed_callables() 会使用共享的私有内存池来捕获它们的计算图。

若实际工作负载中可调用对象的执行顺序可能变化或存在并发执行的情况,则禁止将它们作为元组一次性传入 make_graphed_callables()。此时必须为每个可调用对象单独调用 make_graphed_callables()。

分布式数据并行

https://pytorch.org/docs/stable/notes/ddp.html

警告:torch.nn.parallel.DistributedDataParallel 的实现会随时间演进。本文档基于 v1.4 版本的状态编写。

torch.nn.parallel.DistributedDataParallel (DDP) 透明地执行分布式数据并行训练。本文将说明其工作原理并揭示实现细节。

示例