基于Ray与Dask的AI Agent大规模数据并行计算优化

引言

在现代人工智能应用中,AI Agent面临的数据量呈指数级增长。从社交媒体数据、传感器数据,到企业业务日志,大规模数据处理已成为AI系统性能瓶颈。单线程处理往往无法满足实时性与效率需求,因此并行计算优化成为关键手段。本文将探讨AI Agent如何在大规模数据处理场景下,通过并行计算技术提升处理效率,同时结合Python代码示例进行实战演示。

并行计算基础

并行计算概述

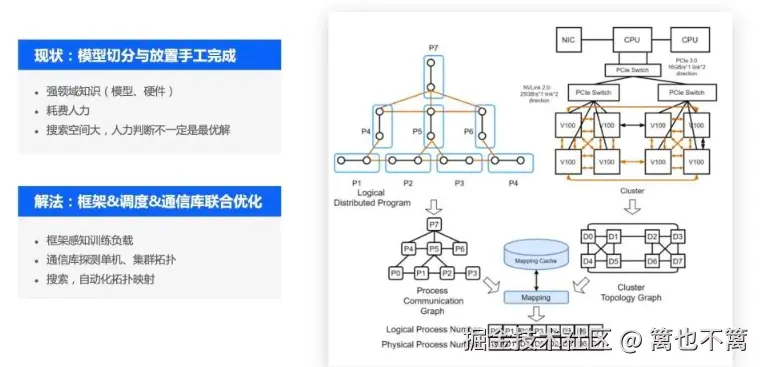

并行计算是指将计算任务划分为多个子任务,同时在多个处理单元上执行,以加速整体计算过程。根据并行粒度,主要可分为:

- 数据并行:将数据集分块,多个计算节点同时处理不同的数据块。

- 任务并行:将不同任务分配到不同节点,适合工作流型任务。

- 管道并行:将计算任务按顺序拆分成阶段,每个阶段在不同节点同时执行。

在AI Agent的数据处理场景中,数据并行最为常用,因为大规模数据通常可以天然切分。

Python并行计算工具

Python提供了多种并行计算方式,常用的包括:

- 多线程(threading):适合I/O密集型任务。

- 多进程(multiprocessing):适合CPU密集型任务。

- 并行计算框架:如Dask、Ray、PySpark,适合分布式大规模数据处理。

下面以multiprocessing和Ray为例进行演示。

AI Agent数据处理任务示例

数据场景

假设AI Agent需要处理一个包含1亿条用户行为记录的日志数据,目标是统计每个用户的行为次数。传统单线程处理会非常耗时。

单线程实现示例

python

import pandas as pd

import numpy as np

import time

# 模拟大规模数据

N = 10**7

data = pd.DataFrame({

'user_id': np.random.randint(0, 100000, N),

'action': np.random.choice(['click', 'view', 'purchase'], N)

})

start_time = time.time()

result = data.groupby('user_id').size()

end_time = time.time()

print("单线程处理耗时:", end_time - start_time, "秒")说明:单线程处理1千万条数据可能耗时数秒甚至数十秒,随着数据规模增加,性能下降明显。

多进程优化

使用multiprocessing将数据分块并行计算:

python

from multiprocessing import Pool, cpu_count

def process_chunk(chunk):

return chunk.groupby('user_id').size()

# 分块

num_chunks = cpu_count()

chunks = np.array_split(data, num_chunks)

start_time = time.time()

with Pool(num_chunks) as pool:

results = pool.map(process_chunk, chunks)

# 合并结果

final_result = pd.concat(results).groupby(level=0).sum()

end_time = time.time()

print("多进程处理耗时:", end_time - start_time, "秒")优化效果:多核CPU充分利用,可以显著降低处理时间,实现线性加速。

分布式优化:Ray示例

当单机资源有限时,AI Agent可利用分布式框架Ray进行优化:

python

import ray

ray.init()

@ray.remote

def process_remote(chunk):

return chunk.groupby('user_id').size()

# 数据分块

chunks = np.array_split(data, num_chunks)

futures = [process_remote.remote(chunk) for chunk in chunks]

# 获取结果

results = ray.get(futures)

final_result = pd.concat(results).groupby(level=0).sum()特点:

- 可扩展到多台机器。

- 任务调度自动化,无需手动管理进程。

- 支持异步任务,适合AI Agent实时处理需求。

并行优化策略

数据分块策略

- 等大小分块:每个进程处理相同数量的数据。适合计算量均衡的任务。

- 按用户划分:每个进程处理特定用户ID范围的数据,减少分组计算合并开销。

内存优化

- 使用

dask.dataframe或pandas的categorical类型减少内存占用。 - 分块加载大文件,避免一次性读取超大数据。

异步计算

AI Agent可在等待数据的同时,处理前一批数据,实现流水线式处理,进一步降低延迟。

高级并行计算优化

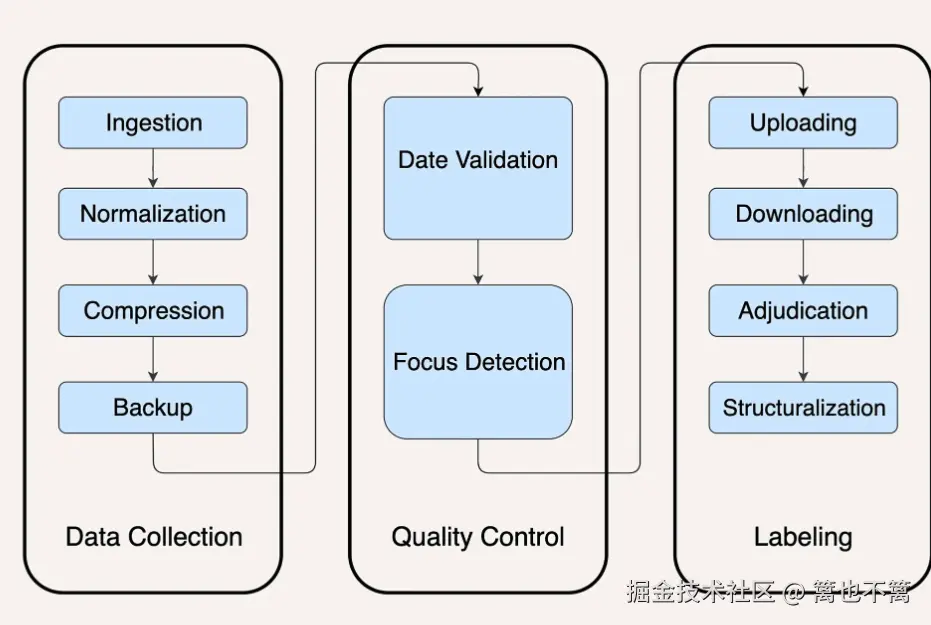

增量计算与流式处理

在大规模数据场景中,AI Agent不可能一次性处理所有数据,尤其是数据持续生成的情况(如日志、传感器数据、交易数据)。此时可以采用增量计算与流式处理策略:

- 增量计算:只对新增数据进行处理,减少重复计算。

- 流式处理:将数据分批送入Agent,每批数据独立计算并累积结果。

使用Python的pandas和dask可以实现流式分块处理:

python

import dask.dataframe as dd

# 使用Dask读取大文件(按块读取)

df = dd.read_csv('user_logs_*.csv')

# 分组统计,每块并行处理

result = df.groupby('user_id').size().compute()优势:

- 支持TB级数据处理。

- 自动并行,Dask会根据CPU核心数动态调度任务。

- 内存占用低,适合资源有限的机器。

GPU加速

对于包含复杂计算或深度学习特征提取的任务,GPU加速可以极大提升AI Agent处理能力。常用工具包括cuDF(GPU版Pandas)、Rapids、PyTorch或TensorFlow。

示例:使用cuDF加速分组统计:

python

import cudf

import cupy as cp

# 将数据加载到GPU

gdf = cudf.DataFrame.from_pandas(data)

# GPU并行分组统计

gpu_result = gdf.groupby('user_id').size()特点:

- 利用GPU数千核心实现数据并行。

- 对于数亿条记录可在几秒内完成计算。

- 可与AI模型特征计算无缝衔接,Agent整体性能提升显著。

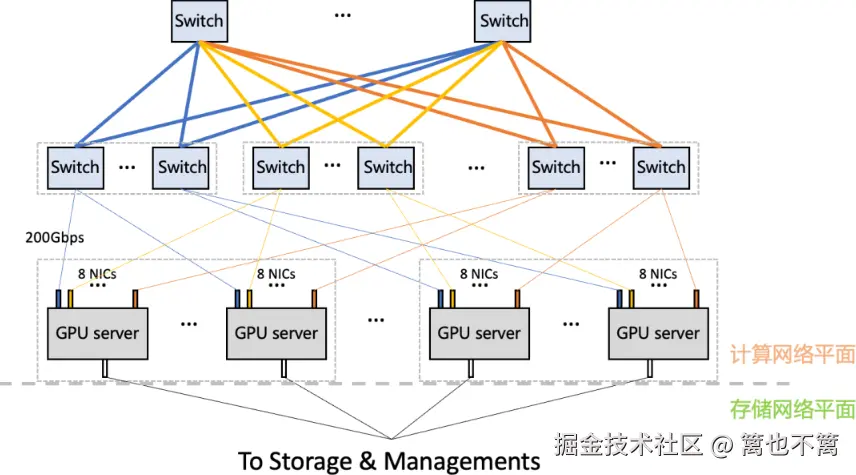

异构计算

在实际应用中,AI Agent可以结合CPU、GPU和TPU进行异构计算:

- CPU:负责数据预处理、IO和简单统计。

- GPU/TPU:执行深度学习推理、矩阵运算和特征提取。

- 分布式节点:处理超大规模数据的聚合计算。

Python示例(结合Ray和GPU计算):

python

import ray

import cudf

ray.init()

@ray.remote(num_gpus=1)

def process_gpu(chunk):

gdf = cudf.DataFrame.from_pandas(chunk)

return gdf.groupby('user_id').size()

chunks = np.array_split(data, cpu_count())

futures = [process_gpu.remote(chunk) for chunk in chunks]

results = ray.get(futures)

final_result = cudf.concat(results).groupby('user_id').sum()这种方式可以让AI Agent灵活调度资源,实现CPU/GPU异构并行处理。

动态负载均衡

在多任务并行场景下,部分任务可能执行时间较长,导致其他任务等待,降低整体效率。AI Agent可使用动态负载均衡:

- 任务分配按实时负载调整,而非静态分块。

- 可通过Ray、Dask的调度器自动实现,或自定义队列机制。

示例:使用Ray的动态任务调度

python

import ray

ray.init()

@ray.remote

def process_task(chunk):

return chunk.groupby('user_id').size()

task_queue = np.array_split(data, 20)

results = []

while task_queue:

chunk = task_queue.pop(0)

future = process_task.remote(chunk)

results.append(future)

final_result = pd.concat(ray.get(results)).groupby('user_id').sum()通过队列方式,长任务不会阻塞其他计算,整体效率提升。

并行计算与AI模型结合

在大规模数据处理场景中,AI Agent不仅需要统计或聚合数据,还需要进行模型预测或特征工程。并行计算可以与模型推理结合:

python

import torch

from torch import nn

import ray

ray.init()

# 模拟简单预测模型

model = nn.Linear(10, 1).cuda()

@ray.remote(num_gpus=1)

def predict_chunk(chunk):

x = torch.tensor(chunk.values).float().cuda()

return model(x).cpu().detach().numpy()

chunks = np.array_split(feature_data, 10)

futures = [predict_chunk.remote(chunk) for chunk in chunks]

predictions = ray.get(futures)优势:

- 模型推理并行化,充分利用GPU资源。

- 支持AI Agent在大规模数据中进行实时预测与决策。

总结

本文系统介绍了AI Agent在大规模数据处理中的并行计算优化方法:

- 单机多进程并行可显著提升CPU利用率。

- **分布式框架(如Ray)**支持跨机器扩展,实现更大规模数据处理。

- 合理的数据划分与内存管理是提升性能的关键。

通过以上优化策略,AI Agent不仅可以处理海量数据,还能在实时性要求较高的场景中表现优异,为智能决策与数据分析提供坚实基础。