说明

服务器版本:CentOS10

Ollama版本:v0.11.6

下载模型

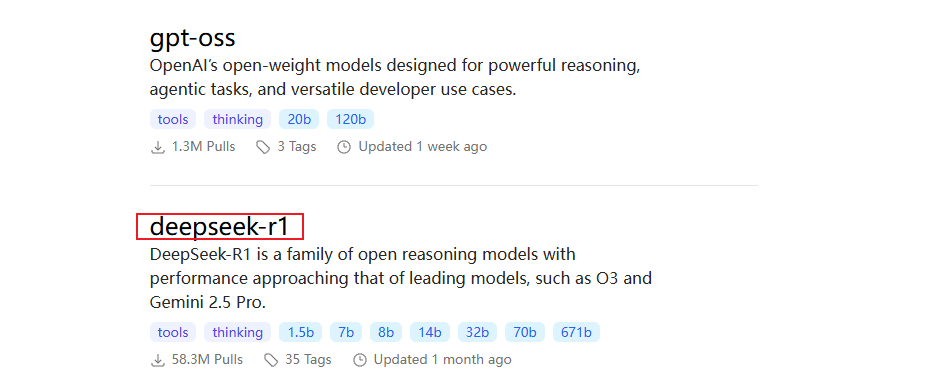

访问ollama官网

官网地址:Ollama Search 搜索需要的模型,这里以deepseek-r1为例

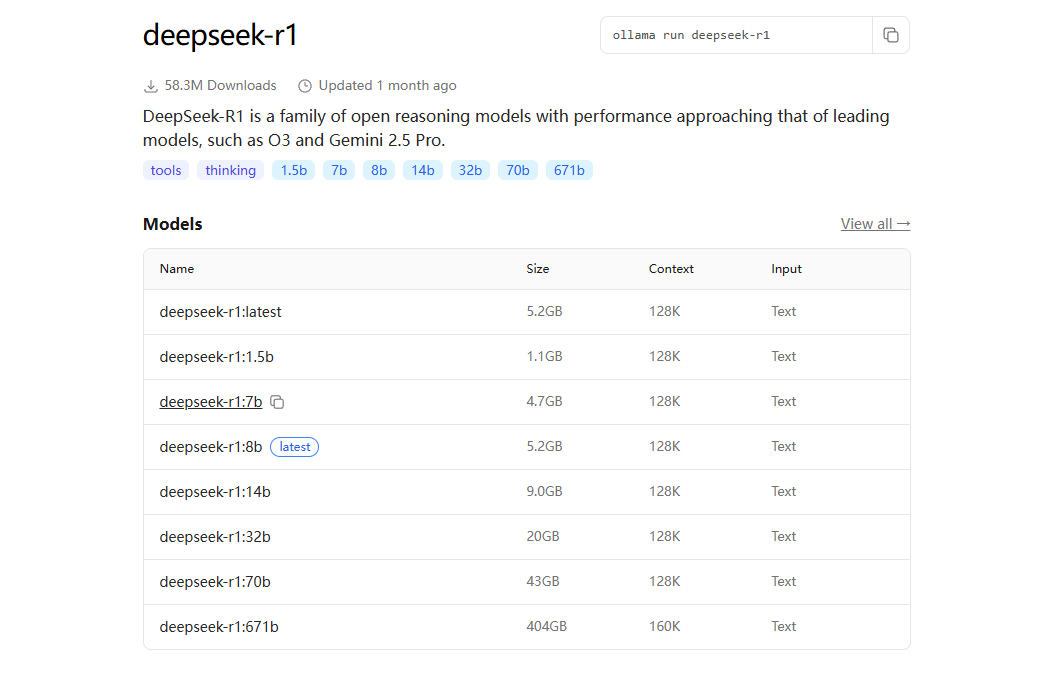

选择需要的模型版本

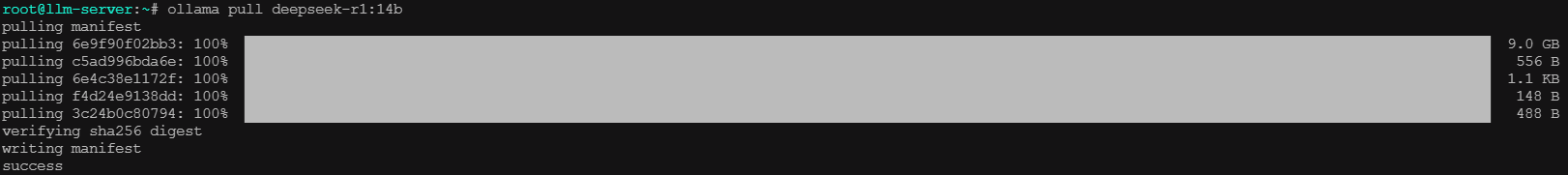

下载模型

这里以deepseek-r1:14b为例,下载速度取决于个人网速快慢

ollama pull deepseek-r1:14b

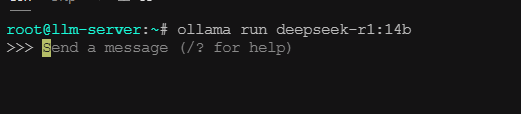

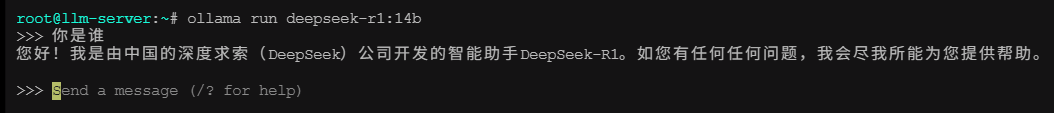

启动模型

等到模型下载完成后,启动模型

ollama run deepseek-r1:14b

模型启动之后可以直接在控制台和模型进行交互

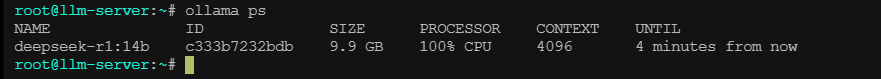

查看运行中的模型

ollama ps

ollama 常用命令

查看已下载的模型

ollama list查看运行中的模型

ollama ps停止运行中的模型

ollama stop <model-name>

# 例如

ollama stop deepseek-r1:14b删除下载的模型

ollama rm <model-name>

# 例如

ollama rm deepseer-r1:14b其他命令

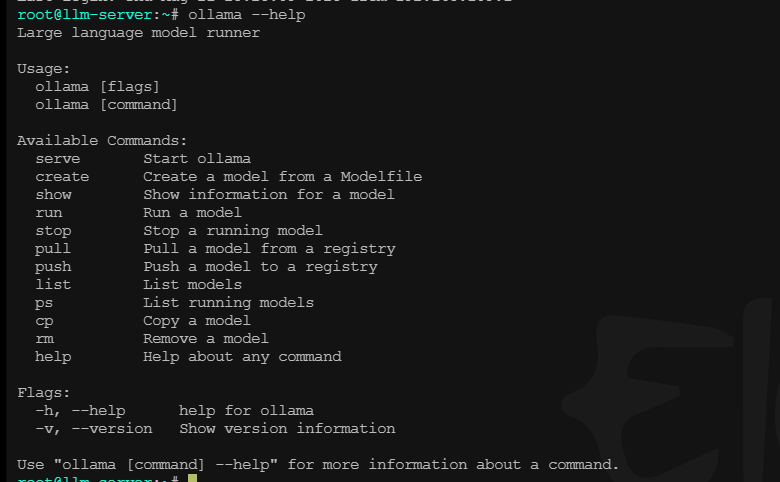

使用ollama --help可以查看所有提供的命令,以及如何使用

ollama --help

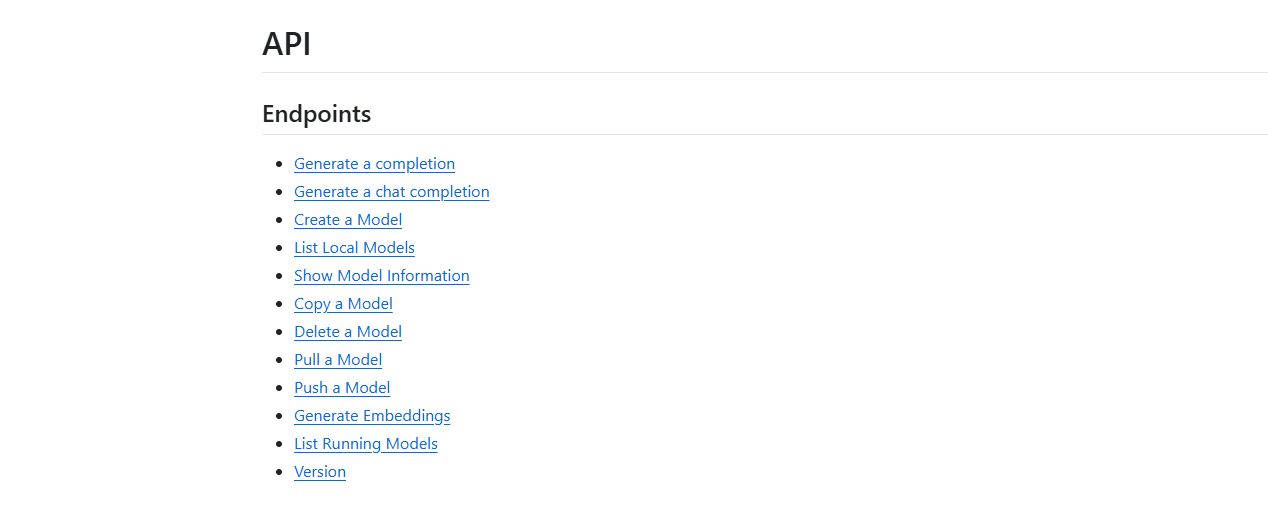

Ollama API

生成聊天内容

POST /api/chat调用示例

curl http://localhost:11434/api/chat -d '{

"model": "deepseek-r1:14b",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

]

}'响应示例

接口是流式输出,以下仅展示一条数据的结构

{

"model": "deepseek-r1:7b",

"created_at": "2025-08-23T15:04:12.341768822Z",

"message": {

"role": "assistant",

"content": ""

},

"done": false

}其他API

想要查看ollama提供的api,可以查看github文档,文档中有详细的说明

https://github.com/ollama/ollama/blob/main/docs/api.md