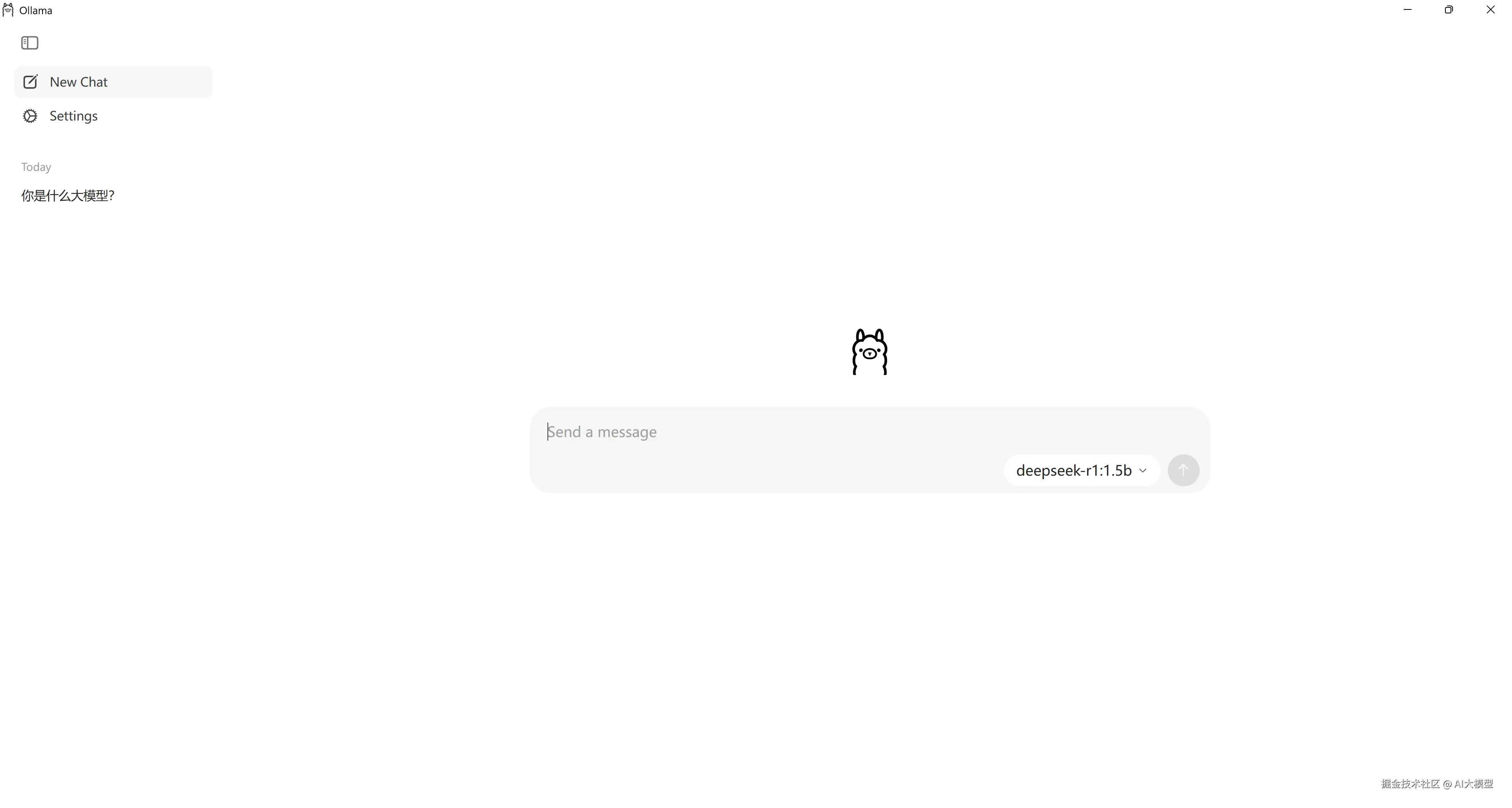

Ollama 终于提供 UI 界面了,再也不用在命令窗口中使用了,如下图所示:

什么是Ollama?

Ollama 是一个开源的大型语言模型服务工具。它的主要作用是帮助用户快速在本地运行大模型,简化了在 Docker 容器内部署和管理大语言模型(LLM)的过程。

PS:Ollama 就是大模型届的"Docker",使用它可以低成本使用大模型(无需调用费用),并且因为是本地部署的大模型,所以不会存在数据隐私问题。

优点分析

Ollama 优点如下:

- 易于使用:提供了简单的 API 和类似 ChatGPT 的聊天界面,即使是没有经验的用户也能轻松上手,无需开发即可直接与模型进行交互。

- 轻量级:代码简洁,运行时占用资源少,能够在本地高效运行,不需要大量的计算资源。

- 可扩展:支持多种模型架构,并易于添加新模型或更新现有模型,还支持热加载模型文件,无需重新启动即可切换不同的模型,具有较高的灵活性。

- 预构建模型库:包含一系列预先训练好的大型语言模型,可用于各种任务,如文本生成、翻译、问答等,方便在本地运行大型语言模型。

Ollama 官网:ollama.com/

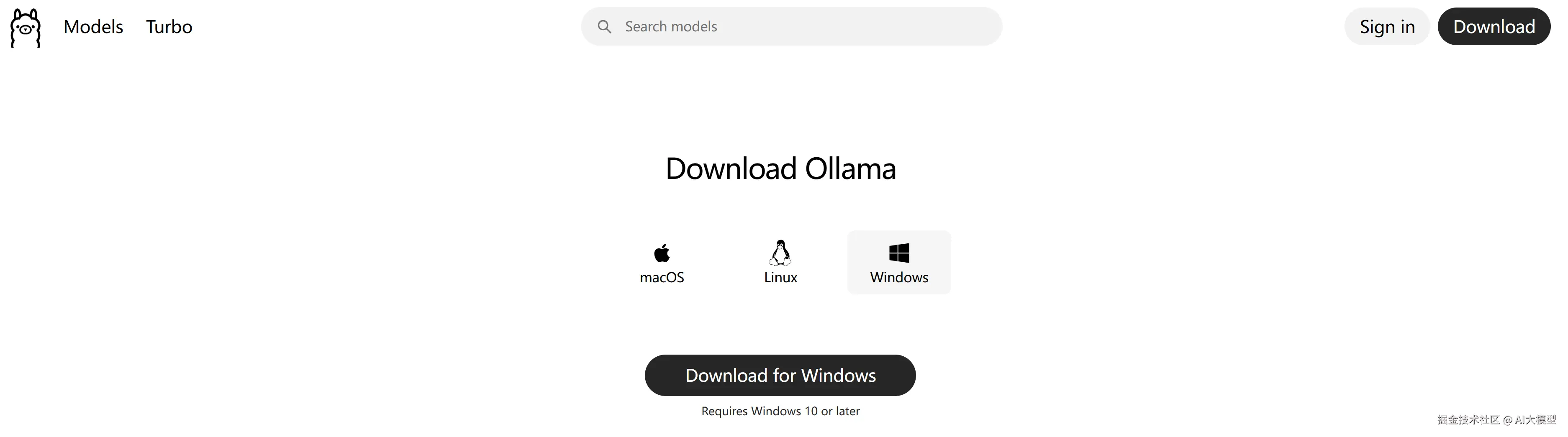

下载并安装Ollama

下载地址:ollama.com/

下载完成之后,双击安装包,一直下一步安装完成即可。

安装大语言模型

支持大模型列表:ollama.com/search

安装并运行 DeepSeek 大模型的命令如下:

ollama run deepseek

等待一段时间 DeepSeek 就安装并启动了。

Ollama调用

Ollama 调用也很简单,通过以下三步就能实现:

- 添加本地大模型依赖

xml

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

<version>1.0.0</version>

</dependency>- 配置本地大模型

yaml

spring:

ai:

ollama:

base-url: http://localhost:11434

chat:

model: deepseek-r1:1.5b- 编写代码进行调用

typescript

@Autowired

private OllamaChatModel ollamaChatModel;

@GetMapping("/chat")

public String simpleChat(String msg) {

return ollamaChatModel.call(msg);

}小结

Ollama 作为使用最简单的本地大模型部署工具,因为使用比较简单,所以行业使用率也很高,但你知道 Ollama 有哪些不足吗?欢迎评论区留言讨论。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。