前言

随着机器离线和本地工作的大型语言模型 (LLMS) 的需求不断增长,像 Ollama 这样的平台它可以轻松地将开源模型直接下载到我们的的硬件上,从而简化流程,直接调用Llama 3、Gemma 3 和 DeepSeek R1 等模型而无需依赖外部 API 调用。

Ollama 简介

Ollama 是一款功能强大的开源工具,旨在简化在机器上运行大型语言模型的过程。Ollama 将模型、它们的权重、配置和依赖项打包到一个易于分发的包中。这是一个简化的过程,用于运行各种 LLMS,而无需依赖项和框架的痛苦。

Ollama 具有命令行界面 (CLI) 和 API,因此可以轻松访问以直接使用和编程方式集成到应用程序中。它的主要功能是为这些模型提供服务,以便您可以通过简单的界面查询它们。

Ollama 的可用模型列表越来越多,你可以轻松下载和运行这些模型。这些范围包括非常流行的开源模型,具有各种大小和功能,例如 Llama 3、Mistral、Gemma 等。它们的功能各不相同,有些倾向于一般文本生成和对话,有些更适合高度专业化的用例,如代码生成、摘要,甚至多模态输入处理(例如文本和图像)。

这些功能取决于您选择的模型,在 Ollama 中,你可以尝试不同的模型来为你的项目选择最佳选项。你可以从 Ollama GitHub 存储库或 Ollama 模型搜索页面获取可用模型及其参数的列表。

在计算机上设置 Ollama

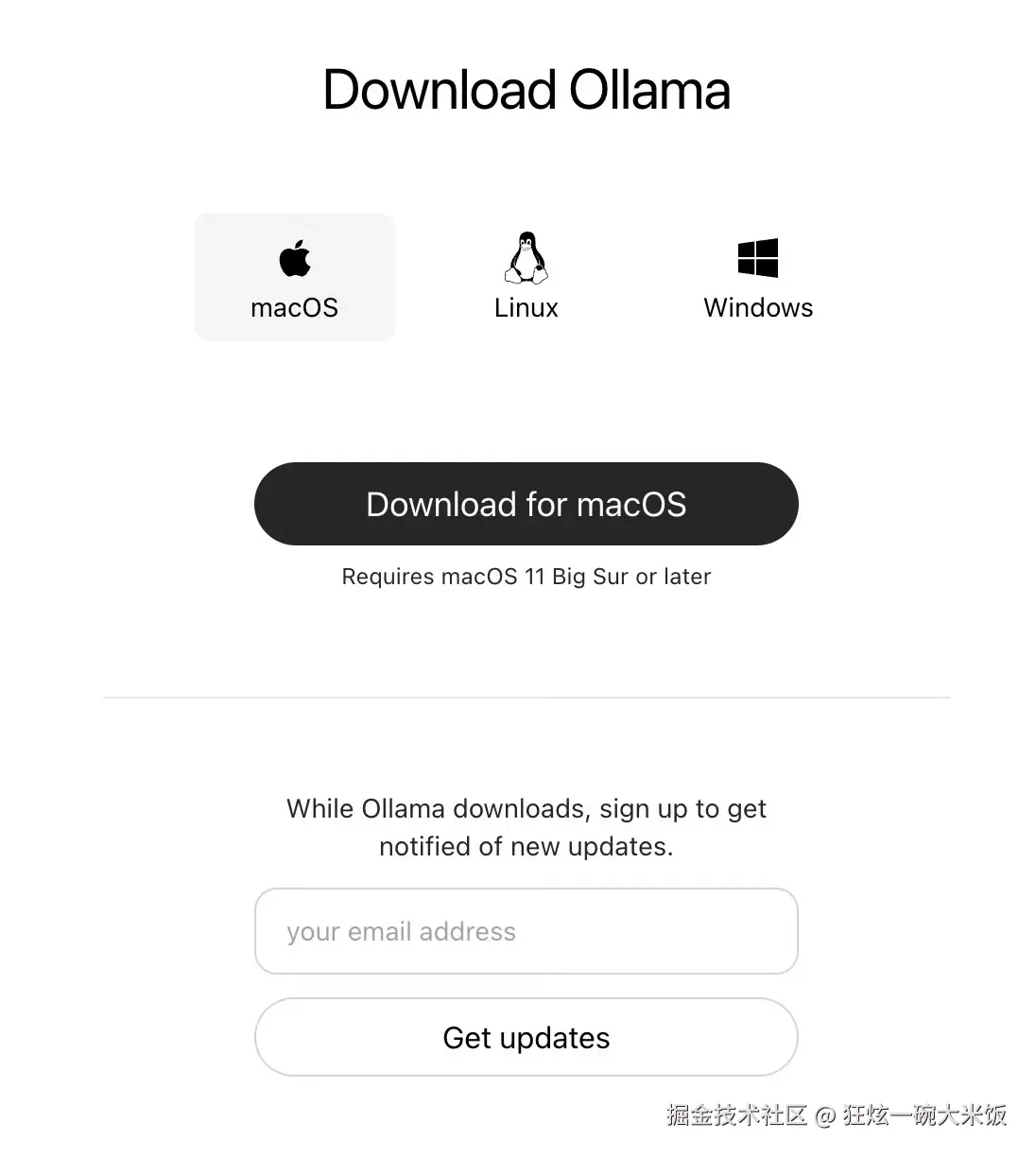

首先,下载 Ollama 安装程序应用程序。转到 Ollama 网站并下载适用于您的作系统的安装程序,如下所示:

在下一个屏幕上,我们可以在下载应用程序之前选择我们的作系统。下载应用程序后,将其安装在您的计算机上。安装 Ollama 后,它将作为后台服务在您的计算机上运行。与它交互的主要方式是通过命令行。

在下一个屏幕上,我们可以在下载应用程序之前选择我们的作系统。下载应用程序后,将其安装在您的计算机上。安装 Ollama 后,它将作为后台服务在您的计算机上运行。与它交互的主要方式是通过命令行。

从 Ollama 库中提取模型

当你的应用程序启动并运行时,转到 Ollama 搜索页面以查找要下载的模型。每个型号都可以有不同的变体(例如,q4KM、q6_K、f16 等),这会影响尺寸和性能。通常,较大的文件意味着更多的参数和更好的性能,但会占用更多的磁盘空间和内存。较小的硬件被压缩分布以节省空间并在低端硬件上运行得更快,但有时会以牺牲准确性或功能为代价。

模型文件往往约为 1 GB 到 50 GB,具体取决于模型和量化。理想情况下,您需要大量的磁盘空间和一台速度相当快的机器,具有足够的 RAM(至少 8 GB,最好是 16 GB+)才能舒适地运行大型模型。

xml

以下命令会将 LLM 下载到您的计算机上:

ollama pull <model_name>

ollama pull llama3.2如果要查看已下载的 LLMS,可以运行以下命令列出它们:

ollama list从本地计算机运行模型

最后一步是通过命令行运行模型。每个模型在其页面上都有有关如何运行模型的说明。例如,我们可以使用以下命令来运行 llama3。2 在我们的机器上:

arduino

ollama run llama3.2运行 LLM 后,你会看到熟悉的聊天提示,你可以在其中与 LLM 交谈,就像我们熟悉的聊天提示一样,比如 ChatGPT、Claude 等。

总结

Ollama 等工具和更高效的开源模型的开发表明,本地模型在人工智能未来中的重要性日益增长。它们对于创建更加私密和易于管理的人工智能至关重要,使用户及其数据更容易访问其强大的能力。使用本地模型进行构建是一项很好的投资,可以创建一个我们拥有一个分布式、注重隐私的人工智能世界。