本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

- 数据安全:数据不出本地,无泄露风险。

- 零成本运行:核心组件(Ollama, Cherry Studio, 开源模型)免费。

- 控制权:可自由选择和更换本地模型。

本地部署对硬件有一定要求。建议至少拥有16GB内存和一块支持CUDA(NVIDIA)或Metal(Apple Silicon)的显卡,以获得流畅的体验。CPU也可以运行,但速度会慢很多。

Ollama本地部署

Ollama是一个极简的本地大模型运行框架,能让您一键启动并管理本地模型。

下载 Ollama

官网:ollama.com/

LLM问答模型:

生成自然语言的答案。deepseek-r1:1.5b配置要求不高,但生成效果不怎么样,这里只是用来测试知识库。安装其它模型可以去ollama 官网看看。

ollama pull deepseek-r1:1.5bEmbedding模型:

Embedding模型负责将文本转换为向量,构建知识库。

bash

ollama pull shaw/dmeta-embedding-zh:latest启动 Ollama

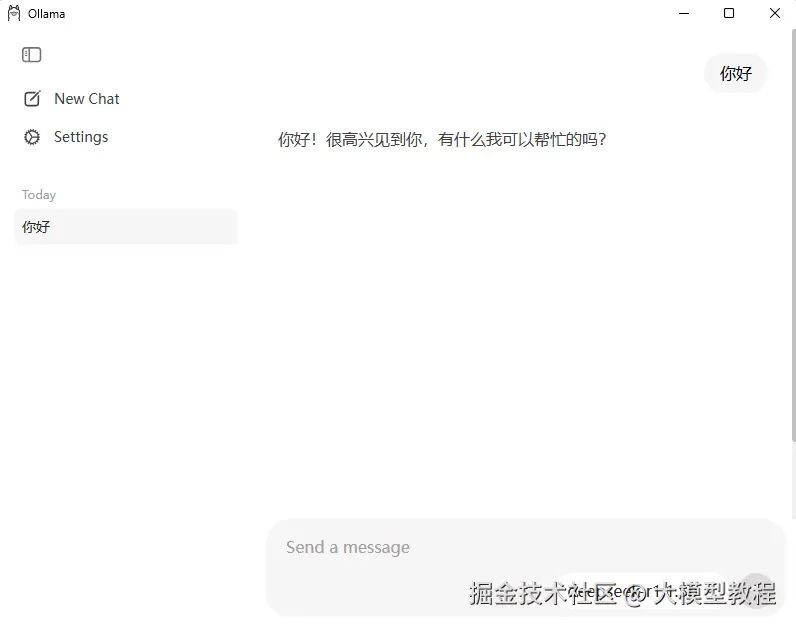

ollama 也有 chat 窗口,如果只是问答的话可以用。

ollama listollama psCherry Studio

Cherry Studio 是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的全能 AI 助手平台。

下载安装

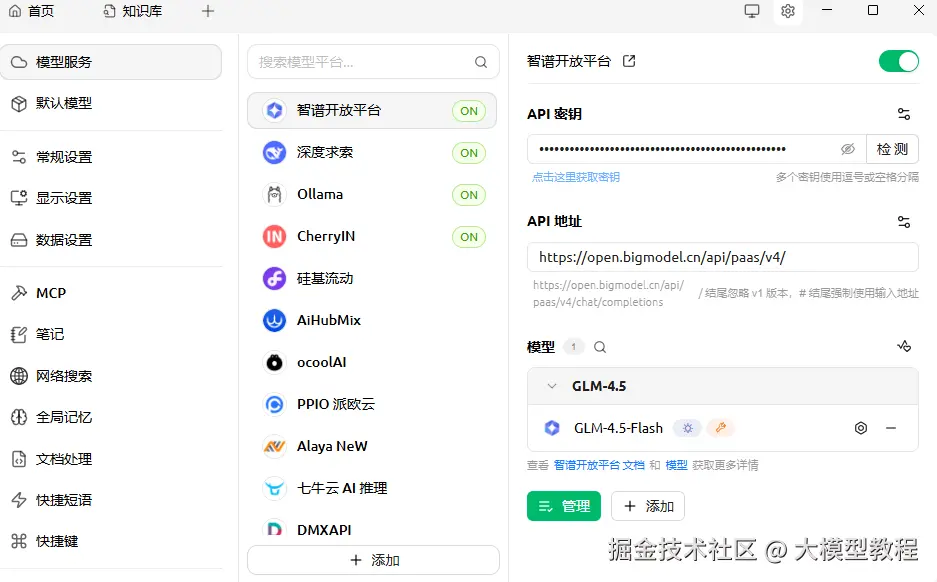

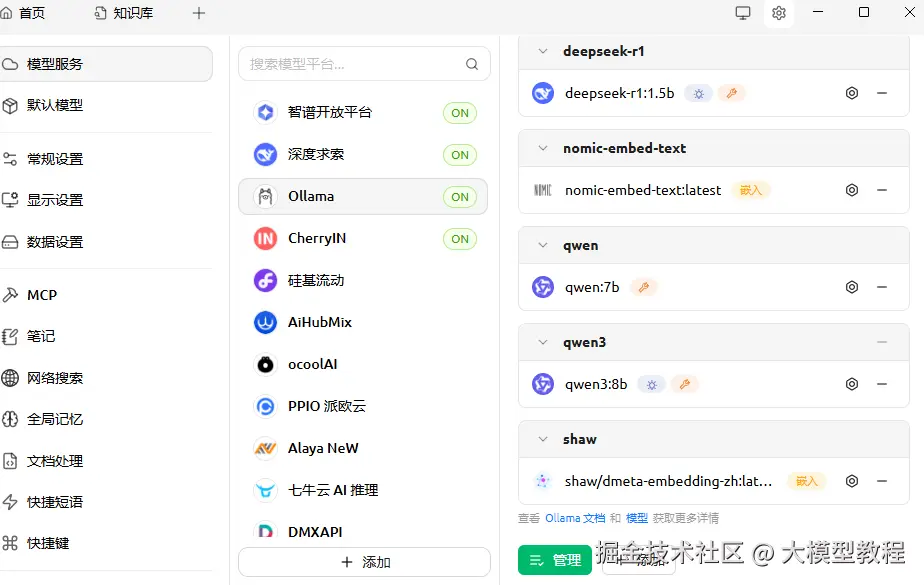

配置模型服务:

点击右上角的设置图表,选择"模型服务"

arduino

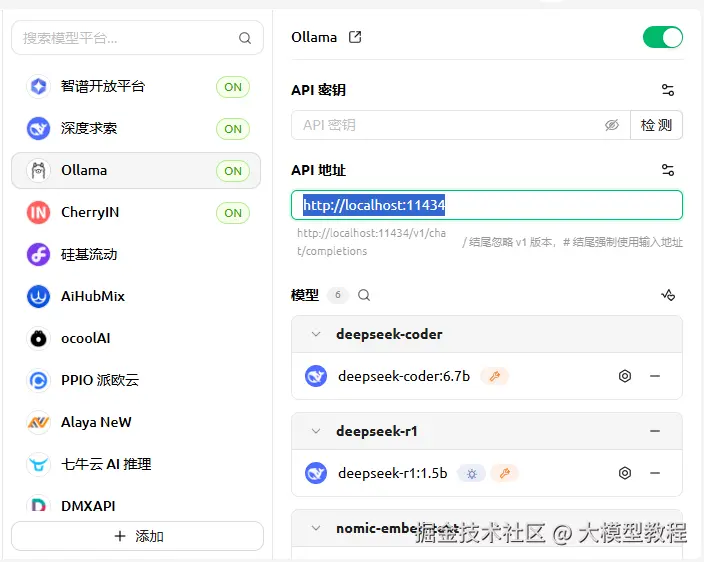

http://localhost:11434

找到 Ollama,在 API地址栏中(默认就行)

在 Ollama 开启的状态下,点击下面的管理,点一下需要用到的模型。

将刚刚拉取的 shaw/dmeta-embedding-zh:latest 和 deepseek-r1:1.5b 添加到模型列表中。

创建知识库

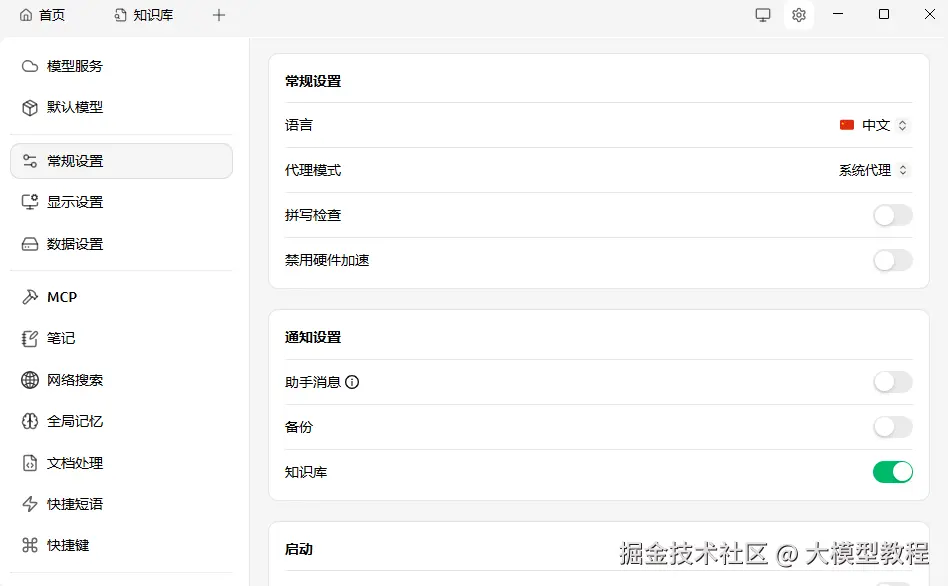

设置中,选择常规设置,打开知识库。

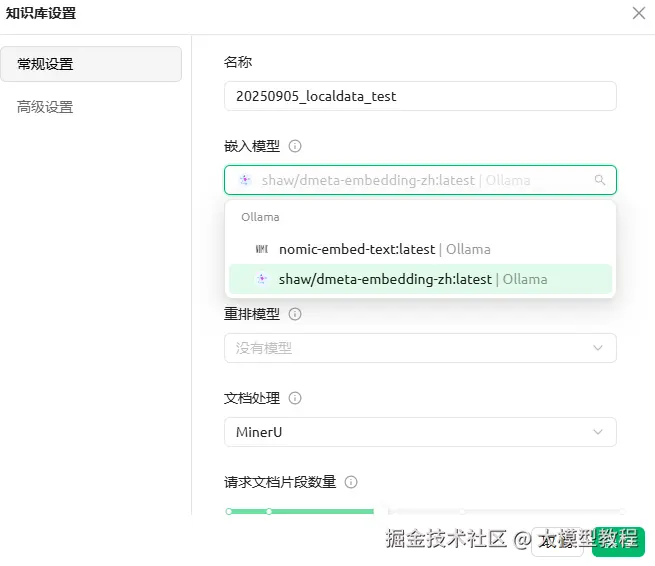

点击首页旁边的"+",选择知识库,然后点击"添加",输入知识库名称。

点击设置图标

选择嵌入模型shaw/dmeta-embedding-zh:latest

回到知识库的界面上传文件,也可以通过"笔记"自己输入内容,添加目录和网址等。Cherry Studio会自动在后台进行文本分块和向量化处理。处理完成后,文件会显示绿色对勾。

官方文档

使用示例

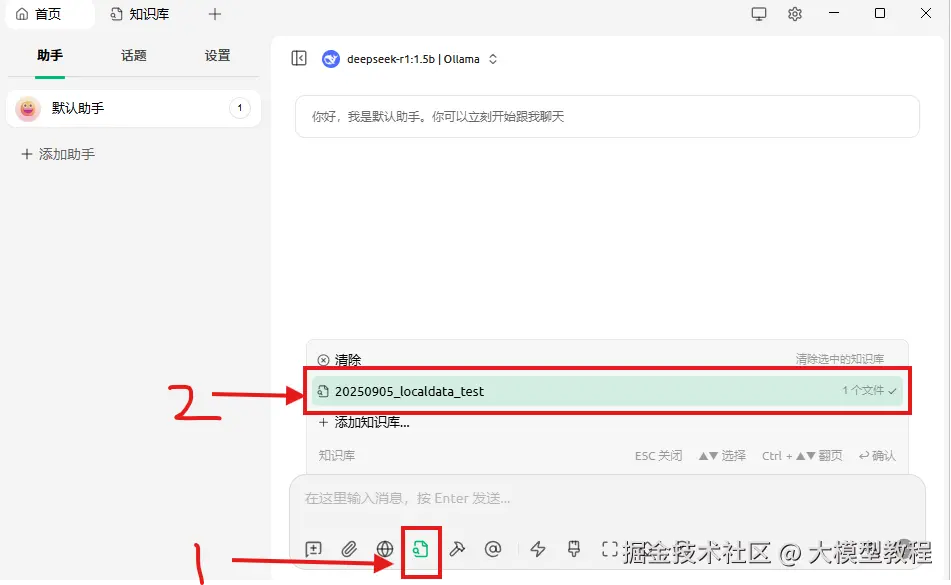

在聊天窗口中选中添加的知识库

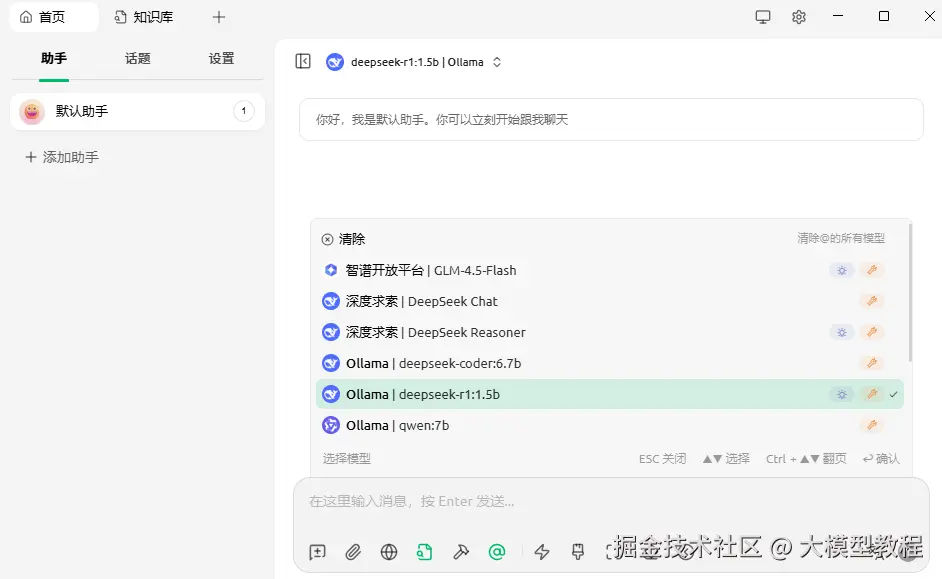

点击"@"图标,选择大模型

deepseek-r1:1.5b不太行。

此外,如果本地大模型带不动,可以考虑使用线上的大模型搭配本地的知识库。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。