战胜黑盒:用于对抗样本防御的屏障区

摘要 对抗性机器学习防御主要集中于缓解静态的白盒攻击。然而,此类防御在自适应的黑盒对手下是否鲁棒仍然是一个悬而未决的问题。在本文中,我们特别关注黑盒威胁模型,并做出以下贡献:首先,我们开发了一种增强的自适应黑盒攻击,实验表明其比 Papernot 等人提出的原始自适应黑盒攻击有效性提高 ≥30%\geq 30\%≥30%。作为我们的第二个贡献,我们使用我们的新攻击测试了 10 种近期提出的防御方法,并提出了我们自己的黑盒防御(屏障区)。我们表明,基于屏障区的防御在最先进的防御基础上提供了显著的安全改进。对于我们研究的数据集,这种改进包括针对黑盒边界攻击、迁移攻击和我们新的自适应黑盒攻击,鲁棒准确率大于 85%85\%85%。为了完整性,我们通过在两个数据集(CIFAR-10 和 Fashion-MNIST)上使用三种对抗模型(14 种不同的黑盒攻击)对其他 10 种防御进行广泛实验来验证我们的主张。

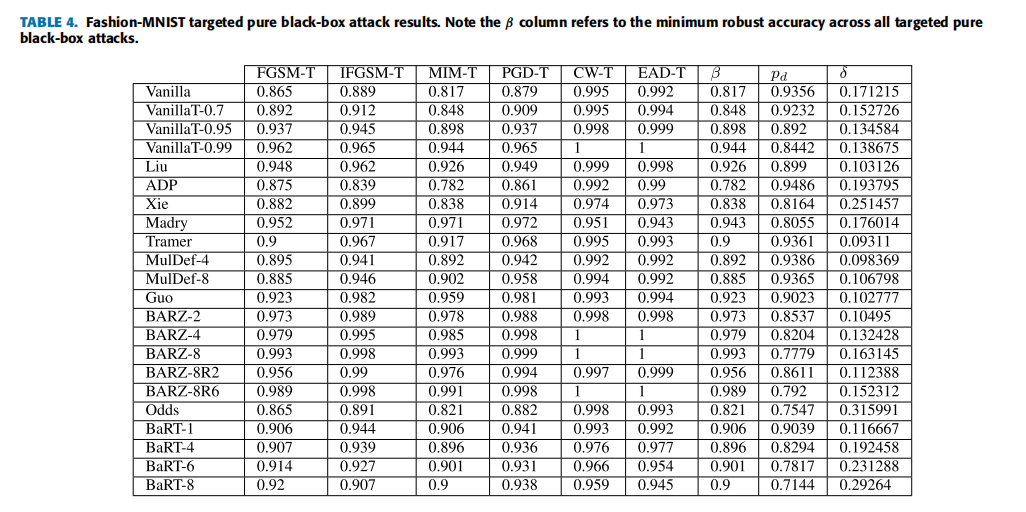

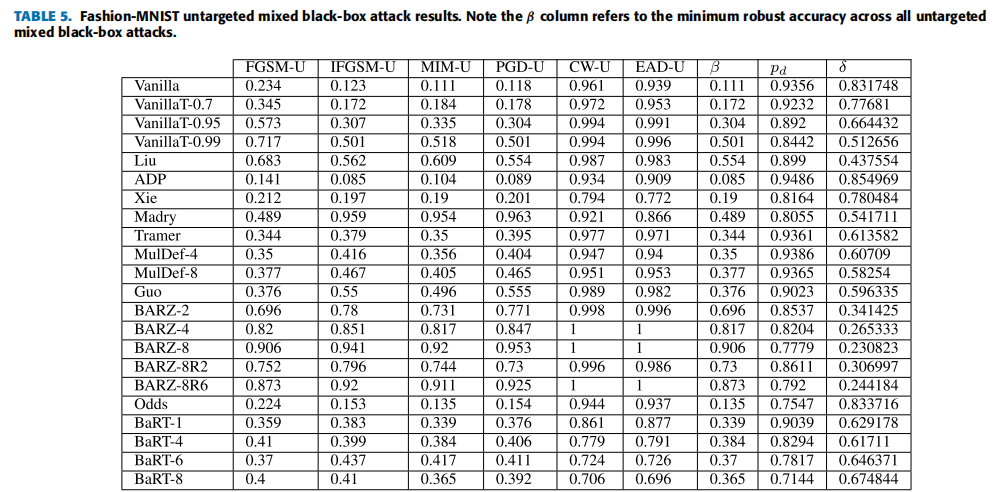

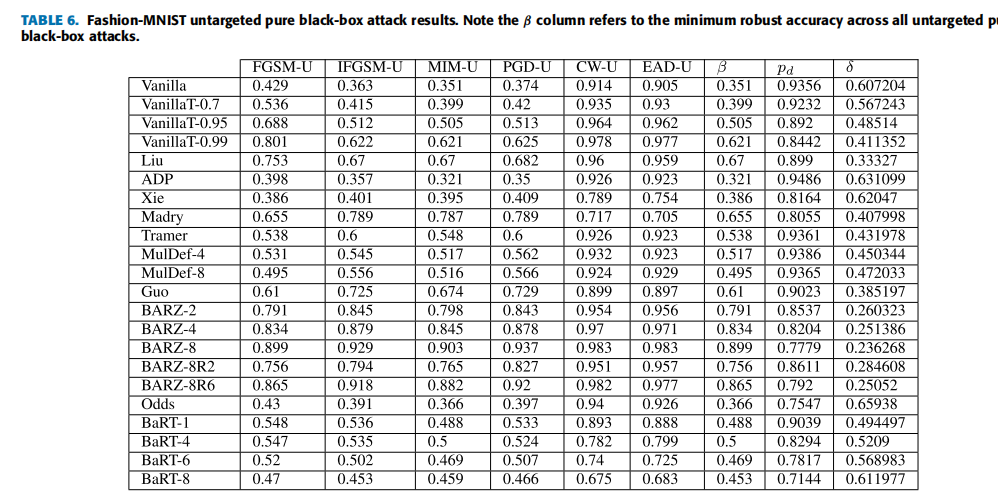

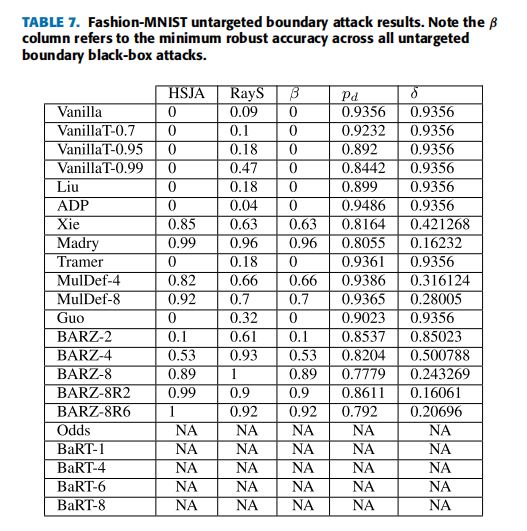

索引术语 对抗性机器学习,对抗样本,对抗防御,黑盒攻击,安全,深度学习。

I 引言

基于卷积神经网络 (CNN) 的应用有很多,例如图像分类 [1], [2], 目标检测 [3], [4], 语义分割 [5] 和视觉概念发现 [6]。然而,众所周知,CNN 对添加到良性输入图像 xxx 上的微小扰动 η\etaη 高度敏感。如 [7], [8] 所示,通过向原始图像添加视觉上难以察觉的扰动,可以创建对抗样本 x′x'x′,即 x′=x+ηx' = x + \etax′=x+η。这些对抗样本会被 CNN 以高置信度错误分类。因此,保护 CNN 免受此类攻击是一项极其重要的任务。

通常,对抗性机器学习攻击可分为白盒攻击或黑盒攻击。这种分类取决于运行攻击需要多少关于分类器的信息。大多数文献都集中在白盒攻击 [9]-[11] 上,即分类器/防御参数是已知的。同样,大多数防御措施的设计目标也是挫败白盒攻击 [12]-[24]。在本文中,我们关注黑盒攻击,其中分类器参数是隐藏的或假定为保密的。这种类型的对手代表了比白盒攻击者更实用的威胁模型 [25]。这部分是因为对手无法访问分类器参数,但仍然能够成功创建对抗样本 [25, 26]。尽管没有防御参数,黑盒对手仍然可以查询防御,能够访问 X\mathcal{X}X(防御的训练数据集),或者构建一个合成模型来协助他们创建对抗样本。通过黑盒对抗视角分析防御,我们通过向社区提供新的攻击和防御视角来帮助完善安全图景。具体来说,我们做出以下贡献:

-

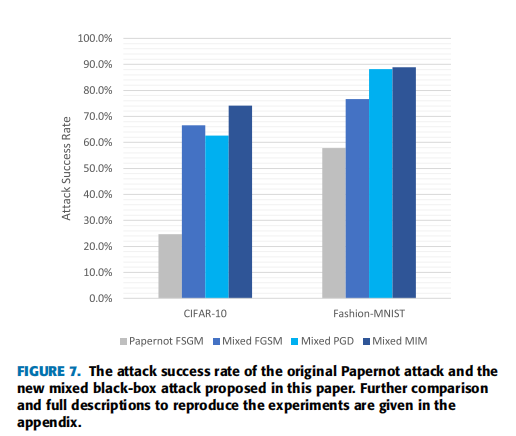

混合黑盒攻击 :我们通过扩展攻击者可用的数据量并更改最终攻击生成方法 ϕ\phiϕ,开发了 Papernot 黑盒攻击 [26] 的增强版本。这些更改显著提高了攻击成功率,即在 CIFAR-10 和 Fashion-MNIST 上改进 >30%>30\%>30%。

-

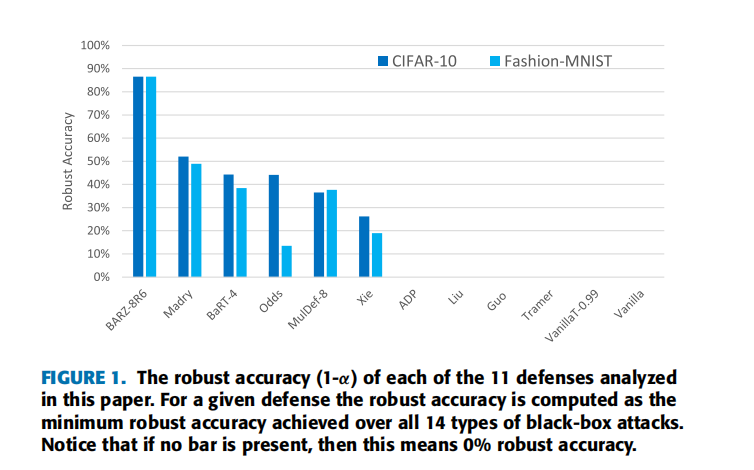

屏障区防御:我们开发了一种基于屏障区的新颖防御------命名为 BARZ。我们展示了基于屏障区的防御可以优于本文中研究的所有其他 10 种近期防御。这些防御包括 Madry 的对抗训练 [27]、随机变换轰炸 [22] 和集成多样性 [24] 等。我们结果的概要显示在图 1 中,其中我们展示了每种防御在所有 14 种黑盒攻击下的最低鲁棒准确率。

-

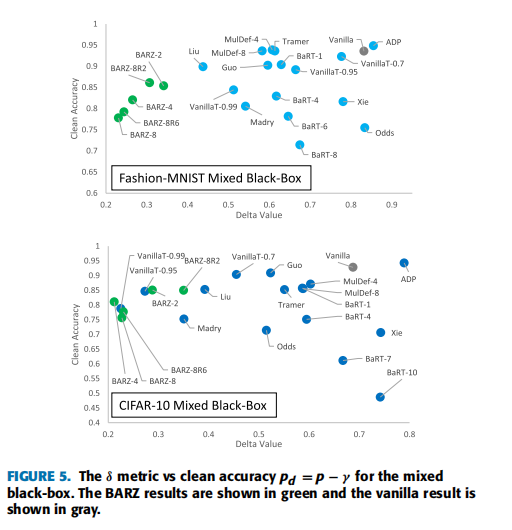

δ\deltaδ 度量(次要贡献) :在对抗性机器学习中,每种防御都有两个不同的值需要考虑。这些值是防御的成本(干净准确率的下降)和鲁棒性/安全性(在对抗数据上的性能)。我们提出了一种直观的方法,以 δ\deltaδ 度量的形式来帮助衡量鲁棒性和成本之间的权衡。

附录 A 比较防御

图 1 显示了 BARZ 防御的鲁棒准确率(定义为 1−α1-\alpha1−α,其中 α\alphaα 是 14 种黑盒攻击中最佳攻击的成功率)与文献中其他 10 种近期防御的比较。文献将攻击成功率 α\alphaα 定义为被防御错误分类的对抗样本的比例。在这里,精确定义 对抗样本 一词也很重要。简而言之,对抗样本是干净图像,在其未被篡改的形式下能被分类器正确识别,并且攻击者进一步向其添加了对抗性噪声。

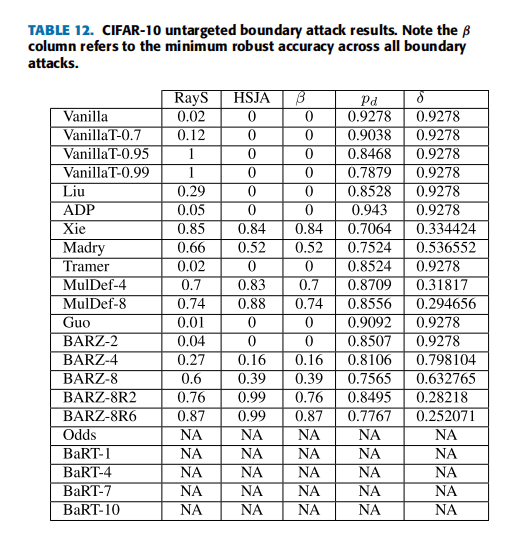

因此,仅使用攻击成功率 α\alphaα 并不能给出完整的图景(即图 1 中仅显示了 α\alphaα)。攻击成功率 α\alphaα 仅对应于防御分类器能够正确标记的原始图像的比例。本质上,对于任何给定的防御 ddd,α\alphaα 取决于防御的干净准确率 pdp_dpd,而不是最先进的或可实现的最佳干净准确率 ppp。这里 ppp 特指在没有任何防御的情况下,在干净图像上测量的准确率,即干净准确率。当存在防御时,我们将防御对应的干净准确率表示为 pdp_dpd。因此,为了完成图 1 的故事,我们需要了解防御本身在多大程度上导致原始方案(vanilla scheme)的干净准确率从 ppp 降低到 pdp_dpd。

沿着 (a) 鲁棒准确率 1−α1-\alpha1−α(攻击者击败防御的能力)和 (b) 防御本身的干净准确率 pdp_dpd(没有对抗存在时)这两个独立的指标比较防御会导致模糊性。不清楚哪个指标被认为更重要,或者什么组合是"最好的"。表 1 的第一行描述了非恶意环境(即没有对手),并显示了原始方案(vanilla scheme)的准确率 ppp,这是我们目前能达到的最佳水平,以及防御的准确率 pdp_dpd,如上所述,它小于 ppp。对于恶意环境,原始方案无法实现任何准确率,因为 α=0\alpha=0α=0(参见图 2 中的黑盒边界攻击)。这种攻击总是可以成功地将正确分类的图像转换为被原始方案错误分类的对抗样本。在存在对手的情况下,防御进行正确/准确分类的概率等于表 1 右下角的 pd⋅(1−α)p_d\cdot(1-\alpha)pd⋅(1−α),因为如果没有对手存在,防御会正确标记 pdp_dpd 比例的图像,而如果存在对手,这些图像中有 α\alphaα 比例被成功攻击。

为了避免任何模糊性,我们将两个指标 pdp_dpd 和 1−α1-\alpha1−α 组合成一个单一的 'δ\deltaδ-metric':我们将 δ\deltaδ 定义为从非恶意环境中原始方案的干净准确率 ppp(左上角)到恶意环境中防御的准确率 pd⋅(1−α)p_d\cdot(1-\alpha)pd⋅(1−α)(右下角)的准确率下降:

δ=p−pd⋅(1−α).\delta=p-p_d\cdot(1-\alpha).δ=p−pd⋅(1−α).

当我们分析非恶意环境时,我们只关心防御的干净准确率------因为我们不假设任何攻击。这就得到了图 2,其中 yyy 轴对应于非恶意环境中防御的准确率 pdp_dpd,x 轴对应于恶意环境中防御的准确率------也就是说,x 轴表示从非恶意环境中原始方案的干净准确率到恶意环境中防御的准确率的下降 δ\deltaδ(抵抗对抗样本的代价)。我们注意到 x 轴和 y 轴可以直接映射到干净防御准确率 pdp_dpd 和鲁棒准确率 1−α1-\alpha1−α 本身,我们本可以在图中将它们报告为 x 轴和 y 轴。但这在视觉上无法清晰地说明哪种组合 (pd,1−α)(p_d, 1-\alpha)(pd,1−α) 在图 2. 边界攻击的 δ 度量与干净准确率 pd 的关系。BARZ 结果以绿色显示,原始方案(vanilla)结果以灰色显示。

恶意环境中是最好的。我们更倾向于绘制 δ 度量,因为这直接对应于恶意环境中防御分类器的(下降的)准确率。

在实践中,评估防御时,我们不仅考虑恶意环境中防御的准确率 p−δp -\deltap−δ,还考虑非恶意环境中防御的准确率,即表 1 右上角的 pdp_dpd。从纯机器学习的角度来看,我们希望一个防御不会对 ppp 影响"太大"------换句话说,下降 γ=p−pd\gamma = p -p_dγ=p−pd 应该很小,仅限于几个百分点。然而,安全性通常不是免费的,为了最小化 δ\deltaδ,我们可能需要牺牲远不止几个百分点。这意味着我们需要研究最小化 δ\deltaδ 和可接受的 pdp_dpd 之间的权衡。本文提出了这样一项研究,我们的防御 BARZ 旨在最小化 δ\deltaδ,尽管在非恶意环境中从 ppp 到 pd=p−γp_d = p -\gammapd=p−γ 可能存在显著的下降 γ\gammaγ。事实证明,这导致 BARZ 的鲁棒准确率优于其他防御,如图 1 和图 2 所示。

B. 大纲

论文的其余部分组织如下:在第二部分,我们讨论黑盒对手,为什么我们关注某些攻击以及我们新的混合黑盒攻击。在第三部分,我们讨论我们研究的防御、其背后的安全原理以及为什么我们选择这些防御进行分析。在第四部分,我们介绍屏障区防御背后安全原理的数学直觉。我们在第四部分还讨论了屏障区在实践中如何实现,并展示了它们的经验证明。在第五部分,我们解释了如何简洁地分析防御的效率。我们在第六部分给出了所有 11 种防御和 14 种攻击的实验结果。最后,我们在第七部分提供结论性意见。

II. 攻击

对抗性机器学习中白盒和黑盒攻击的一般设置如下 [28]:我们假设一个训练好的分类器 fff 和一个正确识别的样本 xxx,其类别标签为 yyy。对手的目标是通过某种量 η\etaη 修改 xxx,使得 f(x+η)f (x + \eta)f(x+η) 产生类别标签 y^\hat{y}y^。在非目标攻击的情况下,只要 y^≠y\hat{y} \neq yy^=y,攻击就被认为是成功的。在目标攻击的情况下,只有当 y^≠y\hat{y} \neq yy^=y 且 y^=t\hat{y} = ty^=t 时攻击才成功,其中 ttt 是对手指定的目标类别标签。对于非目标攻击和目标攻击,通常 η\etaη 的大小是有限的 [8],以便人类仍然可以视觉识别图像。

白盒攻击和黑盒攻击的区别在于如何获得 η\etaη。在白盒攻击中,η\etaη 可以通过在分类器上进行反向传播来计算,或者通过将攻击表述为一个优化问题 [7], [11], [29] 来计算,该问题考虑了分类器的训练参数。白盒对手可以访问训练参数,这些参数可用于计算梯度------本质上,白盒对手可以访问梯度预言机(当被查询时,它会输出梯度信息)。

另一方面,黑盒攻击在生成 η\etaη 时无法访问分类器的参数,必须依赖其他信息。黑盒对手可能可以访问分类器本身,查询时返回一个分数向量或分数最大化的标签------我们称之为黑盒预言机。除了黑盒预言机,黑盒对手还可能拥有用于训练分类器的训练数据的信息。

从加密的角度来看,白盒对手严格强于黑盒对手,并且也可以访问黑盒预言机。然而,我们常常忘记,白盒对手所知的分类器参数不仅可以用来计算梯度预言机,还可以用来计算黑盒预言机。这是因为我们通常认为梯度信息会导致更强大的攻击,因此,我们可能不需要考虑黑盒攻击。一个对仅使用梯度预言机的白盒攻击表现出鲁棒性的防御,并不总是意味着对黑盒攻击也具有鲁棒性。梯度掩蔽使得防御可能给全副武装的白盒对手一种错误的安全感 [10],因为它只挫败基于梯度预言机的白盒攻击。这表明还需要单独测试无梯度攻击,例如黑盒攻击。

在本文中,我们关注利用自适应攻击 [26] 的黑盒对手。一个自然的问题是,为什么我们关注自适应的黑盒类型攻击?我们这样做是出于以下原因:

- 文献中对已发布防御的最新白盒攻击已经进行了广泛研究 [9]-[11]。防御论文中对黑盒攻击的关注程度显著较少。通过关注黑盒攻击,我们力求完善安全图景。这个完整的安全图景意味着我们当前分析的防御不仅有其自身出版物中的白盒攻击结果,还有(如本文报道的)自适应黑盒攻击结果。未来的防御可以在本文开发的安全概念和我们的实验基础上,进行他们自己的分析。这个完成的安全谱系将我们引向下一点。

- 通过完善安全图景(包括黑盒攻击),我们允许读者比较防御结果。这种比较是可行的,因为对每种防御使用了相同的对抗模型、数据集和攻击。这与自适应的白盒攻击完全不同,自适应的白盒攻击可能需要对每种攻击使用不同的对抗模型和不同的安全假设。例如,在 [9] 中,为了破解一个检测器防御(The Odds are Odd),必须使用自定义的目标函数才能在自适应的白盒攻击中实现高攻击成功率。或者,对集成模型防御(ADP [24])创建自适应的白盒攻击则大不相同。唯一的要求是增加简单的基于梯度的白盒攻击中使用的迭代次数,以使攻击具有自适应性和有效性。虽然我们例子中的两种自适应攻击都是白盒攻击,但后者(对 ADP 的自适应白盒攻击)在技术上只需要能够对模型进行反向传播。正如 [30] 中指出的,在不同的对抗模型下比较两种防御的鲁棒性是不合适的。

黑盒攻击变体

-

纯黑盒攻击 [10, 31, 32, 33]对手仅 被给予一个训练数据集 X0\mathcal{X}_{0}X0 的知识。

-

基于预言机的黑盒攻击 [26]

攻击者无法访问原始训练数据集,但可以生成一个与训练数据相似的合成数据集 S0S_{0}S0。对手可以自适应地生成合成数据并查询防御 O\mathcal{O}O 以获取该数据的类别标签。然后使用合成数据集 S0S_{0}S0 来训练合成模型。重要的是要注意,对手无法访问整个原始训练数据集 X0\mathcal{X}_{0}X0。

在本文中,我们提出了这种攻击的一个新版本,我们称之为混合黑盒攻击 。在这种攻击中,对手被给予整个 原始训练数据集、生成合成数据的能力以及查询防御以标记数据的权限。我们攻击中的对手还有多种不同的对抗生成方法 ϕ\phiϕ 可供选择来创建对抗样本。这样,对手可以训练一个其行为更精确地反映防御的合成模型。简而言之,攻击者使合成模型适应防御。重要的是要注意,此攻击的早期版本 [26] 不允许完全访问训练数据集 X0\mathcal{X}_{0}X0,并且对抗生成方法 ϕ\phiϕ 固定为快速梯度符号法 (FGSM)。

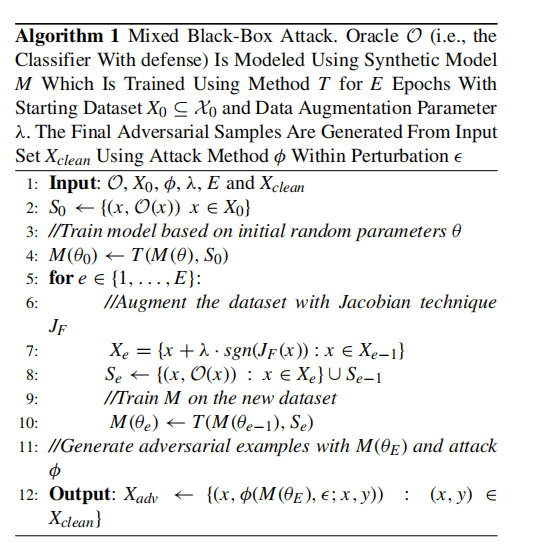

实验上,我们表明混合黑盒攻击优于 Papernot 提出的原始攻击。我们的实验还表明,与边界攻击和纯黑盒攻击 [10, 25, 31, 32, 33, 34] 相比,混合黑盒攻击对某些类型的随机化防御效果更好。混合黑盒攻击的伪代码在算法 1 中给出,并在第 II-B 节中解释。

- 边界黑盒攻击 [35]

在这种类型的攻击中,对手具有对分类器的查询权限,并且一次只生成一个样本。攻击的主要思想是尝试使用二分搜索方法和边界点上的梯度近似来找到类别区域之间的边界。

- 基于分数的黑盒攻击

在文献中,这些攻击也被称为基于零阶优化的黑盒攻击 [36]。对手自适应地查询防御,以基于无导数优化方法逼近给定输入的梯度。这种近似的梯度允许对手直接处理防御的分类器。这方面的另一种攻击称为 SimBA(简单黑盒攻击)[37]。与所有先前提到的攻击不同,这种攻击需要分数向量 f(x)f(x)f(x) 来发起攻击,而不仅仅是使用硬标签。

在上面列举的黑盒攻击类型中,我们分析中唯一不考虑的是基于分数的黑盒攻击。就像白盒攻击容易受到梯度掩蔽的影响一样,基于分数的黑盒攻击可以被一种掩蔽所中和 [30]。这意味着防御可能看起来对基于分数的黑盒攻击是安全的,而实际上并未提供真正的黑盒安全性。此外,已经注意到基于决策(硬标签)的黑盒攻击代表了更实用的对抗模型 [25]。因此,我们稍微将范围集中在其他三种黑盒变体上。

我们实现了纯黑盒攻击和混合黑盒攻击。在这两种类型的攻击中,对抗样本是使用六种不同的方法从合成模型生成的:FGSM [8], BIM [38], MIM [39], PGD [27], C&W [11] 和 EAD [40]。我们还考虑了边界黑盒攻击。这里我们实现了原始边界攻击、Hop Skip Jump 攻击 (HSJA) [25],以及新提出的射线搜索攻击 (RayS) [34]。总的来说,这些攻击代表了十四种生成黑盒对抗样本的不同方式。

攻击成功率

对于分类器 CCC,我们将 X(C)\mathcal{X}(C)X(C) 定义为由训练数据集 X0\mathcal{X}_0X0 中能被 CCC 正确分类的图像标签对 (xi,yi)(x_i,y_i)(xi,yi) 组成的集合,即,

X(C)={(xi,yi)∈X0 : C(xi)=yi}.\mathcal{X}(C)=\{(x_i,y_i)\in\mathcal{X}_0\ :\ C(x_i)=y_i\}.X(C)={(xi,yi)∈X0 : C(xi)=yi}.

我们说 X(C)\mathcal{X}(C)X(C) 代表关于分类器 CCC 的干净图像集合。

我们通过允许分类器 CCC 输出一个"不知道"符号 ⊥\perp⊥ 来扩展对分类器 CCC 的描述。如果 CCC 在输入 xxx 上计算一个分数向量 f(x)f(x)f(x),而分数没有明确偏向任何标签,则可能发生这种情况。稍后我们也将 ⊥\perp⊥ 解释为"对抗性"符号,表明它可能是一个对抗样本。

我们定义分类器 CCC 相对于特定对抗样本生成技术 ϕ\phiϕ 的攻击成功率 α\alphaα 为

α(C,ϕ)=1−1∣X(C)∣∑(xi,yi)∈X(C)Pr[C(ϕ(xi,yi))∈[yi,⊥]].\alpha(C,\phi)=1-\frac{1}{|\mathcal{X}(C)|}\sum_{(x_i,y_i)\in\mathcal{X}(C)} \Pr[C(\phi(x_i,y_i))\in[y_i,\perp]].α(C,ϕ)=1−∣X(C)∣1(xi,yi)∈X(C)∑Pr[C(ϕ(xi,yi))∈[yi,⊥]].

这里,概率是关于 ϕ\phiϕ 和 CCC 使用的随机抛币。攻击成功率反映了对抗样本成功的情况,意味着 CCC 将预测一个合法标签,即 ≠⊥\neq\perp=⊥,并且不等于正确的类别标签,即 ≠yi\neq y_i=yi。

我们注意到 ϕ\phiϕ 是使用黑盒对手可用的信息单独训练/建模/生成的。这些信息可能包括集合 X0\mathcal{X}_0X0 和集合 X(C)\mathcal{X}(C)X(C),并基于这些集合生成一个自生成的合成模型 M(θ)M(\theta)M(θ),其中 θ\thetaθ 表示合成模型的参数。隐含地,ϕ\phiϕ 包含一个扰动参数 ϵ\epsilonϵ,指示对抗样本 ϕ(xi,yi)\phi(x_i,y_i)ϕ(xi,yi) 可能与原始图像 xix_ixi 不同的程度。

攻击成功率估计了 CCC 的干净图像中可以成功生成对抗样本的比例。成功意味着 C(ϕ(xi,yi))≠yiC(\phi(x_i,y_i))\neq y_iC(ϕ(xi,yi))=yi,即对抗样本 ϕ(xi,yi)\phi(x_i,y_i)ϕ(xi,yi) 被错误分类到一个不正确的标签,即使它接近原始图像 xix_ixi(相对于扰动参数 ϵ\epsilonϵ)。这里我们考虑所谓的非目标攻击,其中对手只对错误分类到某个其他合法但错误的标签感兴趣。(对于目标攻击,如果分类器将其标记为对手指定的目标类别标签,则对抗样本被定义为成功。)在实践中,我们通过取一个子集 Xclean⊆X(C)X_{clean}\subseteq\mathcal{X}(C)Xclean⊆X(C) 并计算成功的对抗样本 ϕ(x,y),(x,y)∈Xclean\phi(x,y), (x,y)\in X_{clean}ϕ(x,y),(x,y)∈Xclean 的比例来估计 α(C,ϕ)\alpha(C,\phi)α(C,ϕ)。

以上内容适用于混合黑盒攻击,参见算法 1,如下所述。通过预言机 O\mathcal{O}O,我们表示对手可以访问的带有防御的分类器。攻击者从某个起始数据 X0⊆X0X_0\subseteq\mathcal{X}0X0⊆X0 开始,通常,我们假设对防御者最坏的情况,即对手使用所有训练数据 X0=X0X_0=\mathcal{X}0X0=X0 作为起点。使用数据增强递归生成增强数据集 SeS_eSe,其中使用对预言机 O\mathcal{O}O 的查询来查找标签。某种训练方法 TTT(基于机器学习的数学优化)基于 SeS_eSe 和初始参数 θe−1\theta{e-1}θe−1 学习模型 MMM 的新参数 θe\theta_eθe。最终的合成模型 M(θE)M(\theta_E)M(θE) 可以通过使用白盒攻击方法 ϕ\phiϕ 进行攻击(这是可能的,因为黑盒对手知道参数 θE\theta_EθE,因此,可以获取其合成模型 M(θE)M(\theta_E)M(θE) 的梯度预言机)。在最后一步,为 XcleanX{clean}Xclean 生成对抗样本,我们可以计算这些样本成功的比例------这估计了 α(C,ϕ(M(θE),ϵ;⋅))\alpha(C,\phi(M(\theta_E),\epsilon;\cdot))α(C,ϕ(M(θE),ϵ;⋅))。

III 防御

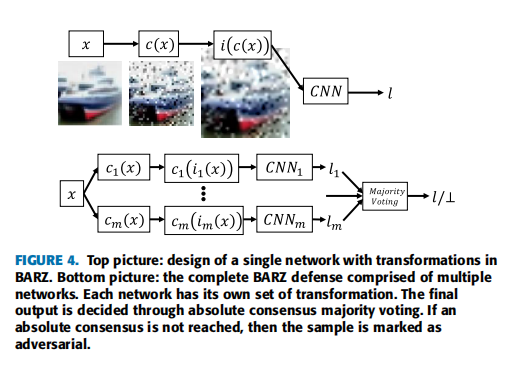

对抗性防御领域正在迅速扩展,几乎每个月都会发布多篇防御论文。1 检查每一个提出的防御超出了本文的范围。相反,我们将分析集中在十种近期的、相关的和/或流行的防御上。在本节中,我们描述了相关的防御、它们共同的安全要素以及我们选择它们进行比较的原因。我们考虑的相关防御是:随机变换轰炸 (BaRT) [22], The Odds are Odd (Odds) [23], 集成多样性 (ADP) [24], Madry 的对抗训练 (Madry) [27], 基于多模型的防御 (Mul-Def) [21], 使用输入变换对抗对抗图像 (Guo) [20], 集成对抗训练:攻击与防御 (Tramer) [14], 混合架构 (Liu) [33], 通过随机化减轻对抗效应 (Xie) [18], 阈值网络(本文开发的基本概念验证防御)和屏障区 (BARZ),本文提出的主要技术。通常,对抗性防御可以根据几种基本的防御机制进行划分。我们注意到这种划分类型在其他防御论文中也很常见 [41]。虽然我们这里提供的分类定义绝不是绝对的,但它们为我们提供了一种更好地理解和分析该领域的方法。

-

多模型 - 防御使用多个分类器进行预测。分类器输出可以通过平均(即 ADP)、从选择中随机挑选一个分类器 (Mul-Def) 或通过多数投票(混合架构)来组合。

-

图像变换 - 防御在分类之前应用图像变换。在某些情况下,变换可能是随机化的(Xie 和 BaRT)或固定的(Guo)。

-

对抗训练 - 分类器被训练以正确识别对抗样本及其正确标签。Madry, Mul-Def 和 Tramer 都使用对抗训练。

-

对抗检测 - 如果样本被认为被对抗性操纵,则防御输出空标签。Odds 采用对抗检测机制,我们在本文中作为概念验证防御考虑的原始阈值网络也是如此。

-

随机化 - 防御在预测期间采用某种形式的随机化,攻击者事先不知道。BaRT 和 Xie 都在运行时对输入应用随机图像变换。

A. 随机变换轰炸 (BaRT)

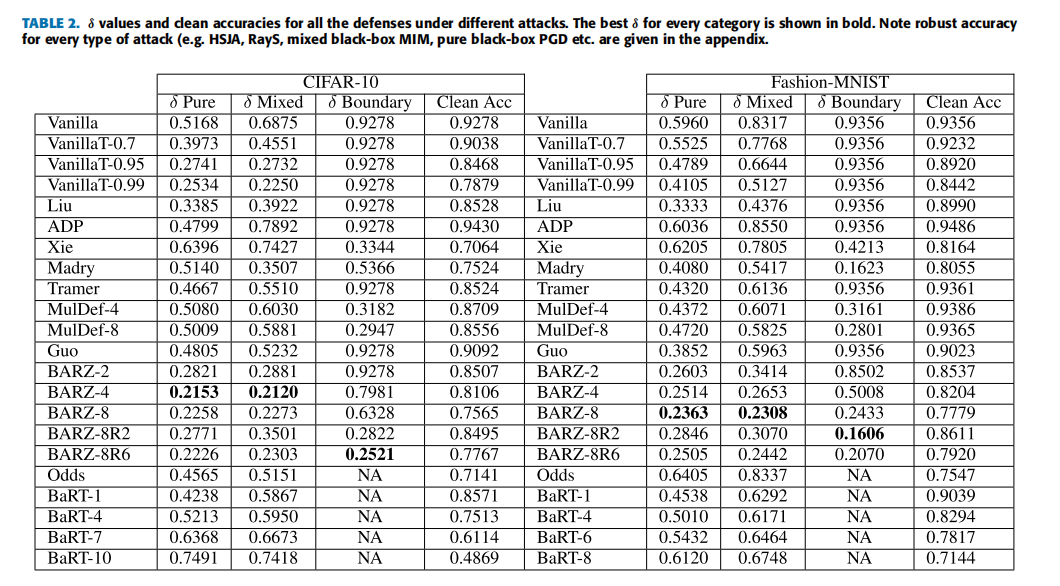

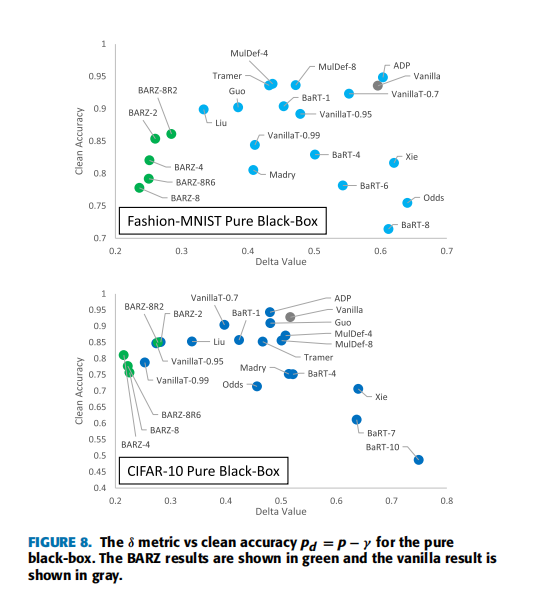

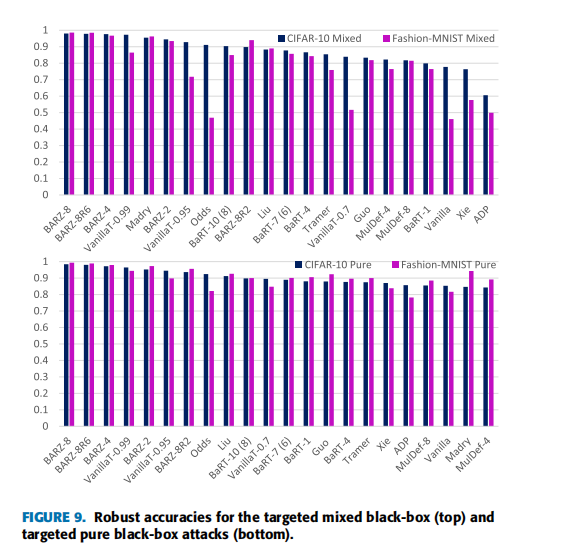

22\] 提出的随机变换轰炸 (BaRT) 是一种在分类前对输入 xxx 应用一组图像变换 i1,...,iri_1, \\ldots, i_ri1,...,ir 的防御。BaRT 采用十种类型的图像变换:JPEG 压缩、图像漩涡、噪声注入、傅里叶变换扰动、缩放、色彩空间变化、直方图均衡化、灰度变换和去噪操作。对于每个输入 xxx,变换的数量、变换的顺序以及变换中的参数在运行时随机选择。 **我们选择它的原因:** 由于我们提出的防御 (BARZ) 也使用图像变换,BaRT 是一个自然的比较对象。在构建防御时,BaRT 在多个图像变换上训练单个网络。相比之下,我们的防御训练多个网络,每个网络都有自己的较小图像变换集。比较这两种构建基于图像变换的防御的不同方式是很有意义的。 ### B. THE ODDS ARE ODD (ODDS) The Odds are Odd 首先在 \[23\] 中作为检测对抗样本的统计测试被引入。该测试背后的概念基于一个简单的观察:干净样本和对抗样本在 logits 层 I(⋅)I(\\cdot)I(⋅) 中具有不同的值。这里我们将 logits 层定义为 soft-max 层之前的层。当给定一个输入 xxx 时,该测试通过创建输入的多个副本,每个副本都添加了随机噪声 x\^1,...,x\^p\\hat{x}_1, \\ldots, \\hat{x}_px\^1,...,x\^p 来工作。统计测试使用 I(x\^1),...,I(x\^p)I(\\hat{x}_1), \\ldots, I(\\hat{x}_p)I(x\^1),...,I(x\^p) 作为输入来区分对抗样本和干净样本。 **我们选择它的原因:** 在黑盒设置中,对抗检测是使防御更强的一种可能方式,因为攻击者必须产生一个错误的类别标签并避免防御将输入标记为对抗性(⊥\\perp⊥)。在本文提出的防御 (BARZ) 中,我们也通过使用带有多个分类器的阈值投票方法来进行检测。由于通过检测实现安全性正是 Odds 试图实现的目标,因此将统计检测方法与基于投票的检测防御(如 BARZ)进行比较是有意义的。 ### C. 通过促进集成多样性提高对抗鲁棒性 (ADP) 在防御中使用多个分类器是一个直接的概念,基于打破一个分类器集成比打破单个分类器更困难的观点。在 \[24\] 中,他们通过专门训练一个分类器集成来进一步推进这一概念,以避免大多数分类器同时错误分类一个对抗样本的情况。在这种防御中,安全性是在训练期间实现的,其中使用了自适应多样性促进 (ADP) 正则化器。ADP 正则化器推动每个集成分类器的非最大预测相互正交。 **我们选择它的原因:** ADP 使用没有图像变换或对抗训练的集成分类器。而 BARZ 则使用带有图像变换的多个分类器。如果有可能在没有图像变换的集成中实现黑盒鲁棒性(例如,仅通过像 ADP 中的特殊训练),这将否定在黑盒防御中对特殊图像变换的需求。因此,测试 ADP 并将其与 BARZ 进行比较具有重要的黑盒安全意义。 ### D. MADRY 的对抗训练 (MADRY) Madry 的对抗训练 \[27\] 是一种广泛使用的防御,具有明确的安全目标。由于 CNN 会错误分类对抗样本,\[27\] 的作者提出生成对抗样本,随后在训练期间学习正确分类它们。通常,对抗训练可以分解为两个步骤。第一步,对于给定的干净数据集和分类器,防御者使用白盒对抗攻击 ϕ\\phiϕ 推导出对抗数据集。第二步,使用对抗样本和原始干净标签训练分类器。这两个步骤在训练期间重复多次,以创建一个鲁棒的对抗训练分类器。 **我们选择它的原因:** Madry 的对抗训练因其直观的设计和鲁棒的结果而成为最常被接受的对抗性机器学习防御之一。虽然 Madry 对抗训练所基于的安全原理与 BARZ 没有直接重叠,但它仍然是一个需要比较的防御标准。 #### *基于多模型的防御 (MUL-DEF)* 在 \[21\] 中,他们提出了一种针对白盒攻击的防御,基于多个网络,每个网络具有*相同* 的架构。\[21\] 的作者基于一种专门的训练技术开发了他们的防御。他们首先从一个在干净数据集 X\\mathcal{X}X 上训练的分类器 C1C_1C1 开始。对 C1C_1C1 进行白盒攻击 ϕC\\phi_CϕC 以生成一组对抗样本 S1\\mathcal{S}_1S1。从原始数据集和对抗样本形成一个新的训练集:X∪S1\\mathcal{X} \\cup \\mathcal{S}_1X∪S1。这个新集用于训练下一个分类器 C2C_2C2。重复这个过程,使得分类器 CjC_jCj 在 X∪S1∪...∪Sj−1\\mathcal{X} \\cup \\mathcal{S}_1 \\cup \\ldots \\cup \\mathcal{S}_{j-1}X∪S1∪...∪Sj−1 上训练。在预测期间,最终输出从分类器 C2,...,CmC_2, \\ldots , C_mC2,...,Cm 中随机选择,其中 mmm 是 Mul-Def 中特殊训练的分类器的数量。 **我们选择它的原因:** Mul-Def 与 BARZ 有重叠的安全概念。两者在防御中都使用多个模型,并且都试图创建不同的分类器(Mul-Def 通过特殊训练,BARZ 通过在变换数据上训练)。在 BARZ 的随机化形式中,使用模型输出的随机子集,类似于 Mul-Def。两种防御之间的主要区别是 Mul-Def 没有在模型之间实现任何投票,也没有实现任何对抗检测。如果一个集成防御可以避免实施检测,这将明显提高防御的干净准确率。这是因为不完美的检测方法会将一些干净样本标记为对抗性(误报)。由于它们相似的安全概念,将 Mul-Def 与 BARZ 进行比较是合乎逻辑的。 #### *F. 使用输入变换对抗对抗图像 (GUO)* 在 \[20\] 中,设计者为单个分类器选择一组可能的图像变换,并保持所选图像变换的选择为秘密。这种防御 (Guo) 中的主要安全思想是,图像变换将足够扭曲对抗性噪声,使其不再导致分类器错误分类对抗样本。 **我们选择它的原因:** 虽然我们没有直接测试原始的 Guo 图像变换,但 Guo 防御背后的安全概念与 BARZ 中的单个网络相同。本质上,Guo 防御中的安全原理(单个网络和图像变换)是当分类器数量 m=1m = 1m=1 时 BARZ 的特例。由于 Guo 防御已经被提出,如果 BARZ-1(即 Guo 防御)已经提供了实质性的安全性,那么提出 BARZ 将是多余的。因此,有必要对 Guo 防御进行实验。 #### *G. 集成对抗训练:攻击与防御 (TRAMER)* \[14\] 的作者提出了另一种类型的对抗训练方法。在这种防御中,通过使用多种不同的攻击方法攻击多个网络来生成对抗样本。之后,设计者使用生成的对抗样本训练一个新的网络。\[14\] 的作者认为,这种对抗训练可以使对抗训练的网络对(纯)黑盒攻击更加鲁棒,因为它使用来自不同来源(即预训练网络)的对抗样本进行训练。 **我们选择它的原因:** Tramer 防御具有与 BARZ 平行的自然安全概念。两种防御都依赖多个模型。在 BARZ 中,这些模型用于共识投票,在 Tramer 防御中,它们被间接依赖(用于生成新的对抗样本)。两种防御在设计时都考虑了黑盒对手。因此,在考虑黑盒威胁模型时,Tramer 防御是一个自然的选择进行测试。 #### *H. 混合架构 (LIU)* 在 \[33\] 中,作者研究了 ImageNet 数据集上不同架构的 CNN 之间的可迁移性。他们发现对抗样本并不总是在不同架构之间迁移,即被 C1C_1C1 错误分类的对抗样本并不总是被 C2C_2C2 错误分类。基于这项研究,可以提出一个由不同 CNN C1,...,CmC_1, \\ldots , C_mC1,...,Cm 组成的防御,每个 CNN 具有不同的结构。 **我们选择它的原因:** 虽然 \[33\] 中没有直接提出,但混合架构防御的可行性问题源于 \[33\] 的结果。由于 BARZ 使用多个模型,如果模型的架构是混合的,会对鲁棒性产生显著影响吗?通过测试混合架构防御 (Liu),我们尝试凭经验回答这个问题。 #### *I. 通过随机化减轻对抗效应 (XIE)* 在 \[18\] 中,开发了一种使用单个分类器的防御,其中在运行时对输入 xxx 应用随机图像变换 iri_rir。与 BaRT 或 BARZ 不同,这种方法不需要在不同的图像变换 i1,...,ipi_1, \\ldots , i_pi1,...,ip 上重新训练分类器。 **我们选择它的原因:** Xie 防御像 BARZ 一样使用图像变换。因此,这种防御提出了一个独特的竞争概念:通过随机化实现安全性,而无需昂贵的重新训练。在黑盒对手下,是否可以在不重新训练的情况下获得这种鲁棒性,这就是我们在本文中研究 Xie 防御的原因。 #### *J. 阈值网络 (VANILLAT)* 阈值网络是本文演示的一种简单防御,用于强调创建鲁棒屏障区的挑战性。阈值网络是一种检测型防御,它使用原始分类器 CCC 和阈值 ttt。如果来自分类器 CCC 的最高概率 ppp 低于阈值 ttt,则样本被标记为对抗性:⊥\\perp⊥。 **我们选择它的原因:** 当考虑屏障区防御时,第一直觉可能是简单地阈值化一个原始分类器可能有效。这意味着可以在没有多个分类器或图像变换的情况下实现鲁棒性。我们开发阈值网络防御是为了 ### K. Mahmood 等人:战胜黑盒:用于对抗样本防御的屏障区 凭经验证明单个分类器的屏障区是不足够的。 #### IV. 屏障区防御 (BARZ) 有这么多不同种类的防御,一个自然的问题是为什么我们提出另一个?简短的答案是,因为我们分析的所有当前防御都没有在对*所有*类型的黑盒攻击中表现良好,并且没有提供安全性和干净准确率之间的灵活权衡。例如,像 Madry 这样的对抗训练网络对纯黑盒攻击表现不佳(在 CIFAR-10 上鲁棒准确率低于 65% \[27\])。像 Xie 和 Mul-Def 这样的随机化防御对边界攻击效果很好,但在混合黑盒攻击下会失败,混合黑盒攻击可以适应随机化(我们在第六节展示了这方面的结果)。如果我们想增加它们的安全性,目前还不清楚干净准确率会受到多大影响。同样,如果我们想要更高的干净准确率,而不完全放弃防御,如何实现这一点也不明显。在 BARZ 中,通过添加更多网络,安全性和干净准确率之间的这种权衡是透明的。BARZ 也是唯一一种在所有类型的黑盒攻击(纯、混合和边界)中表现良好的防御之一。 我们在第六节提供了完整的实验结果来支持这些说法,并在附录中对每种防御相对于黑盒攻击进行了单独分析。我们的主要重点是创建一个防御,以弥补其他提出方法的不足。我们努力创建一个高保真度的防御 (BARZ),在安全性和干净准确率之间提供灵活性。 #### A. 屏障区的安全原理 BARZ 防御基于屏障区的概念。屏障区是类别之间的区域,如果输入落入该区域,则被标记为对抗性。对于任何新的防御,第一个问题是为什么它是有效的,或者在这种情况下,为什么屏障区能提供安全性?这里我们给出这个概念背后的数学直觉。 假设我们有 mmm 个分类器 CjC_jCj,对应的攻击成功率为 αj=α(Cj,θj)\\alpha_j = \\alpha(C_j, \\theta_j)αj=α(Cj,θj),其中对抗样本生成技术 θj\\theta_jθj 特定于分类器 CjC_jCj。让我们构建一个新的分类器 CCC,它使用每个 CjC_jCj 来预测一个标签并输出多数决策。如果多个标签具有相同的多数票,则 CCC 输出 ⊥\\perp⊥,表示它不知道如何分配标签。要输出合法标签,CCC 需要有一个明确的多数票,该票不被多个标签共享。 考虑一个针对 CCC 调整的对抗样本生成技术 ϕ\\phiϕ。将投票 VkV_kVk 定义为 Vk(xi,yi)=∣{1≤j≤m:Cj(ϕ(xi,yi))=k}∣V_k(x_i, y_i) = \|\\{1 \\leq j \\leq m : C_j(\\phi(x_i, y_i)) = k\\}\|Vk(xi,yi)=∣{1≤j≤m:Cj(ϕ(xi,yi))=k}∣ (为简单起见,假设算法 CjC_jCj 和 ϕ\\phiϕ 是确定性的)。仅当 Vyi\>VkV_{y_i} \> V_kVyi\>Vk 对于所有标签 k≠yik \\neq y_ik=yi 成立时,分类器 CCC 才会输出正确的标签 yiy_iyi。对抗样本 ϕ(xi,yi)\\phi(x_i, y_i)ϕ(xi,yi) 是成功的,如果输出一个不同于 yiy_iyi 和 ⊥\\perp⊥ 的标签。也就是说,存在一个标签 y\^∉{yi,⊥}\\hat{y} \\notin \\{y_i, \\perp\\}y\^∈/{yi,⊥},使得对于所有合法标签 k≠y\^k \\neq \\hat{y}k=y\^,有 Vy\^\>VkV_{\\hat{y}} \> V_kVy\^\>Vk。 这表明差异 A(yi,k)=Vyi−VkA(y_i, k) = V_{y_i} - V_kA(yi,k)=Vyi−Vk 代表了在分类器 CCC 中选择 yiy_iyi 而不是 kkk 的"优势"。通过使用符号 A(.,.)A(.,.)A(.,.) 并转换我们对成功对抗样本的表征,我们得到攻击成功率 α=α(C,ϕ)\\alpha = \\alpha(C, \\phi)α=α(C,ϕ) 等于 KaTeX parse error: Expected '\\right', got '\\end' at position 187: ...hat{y}, k) \> 0 \\̲e̲n̲d̲{vmatrix} , \\ta... 其中 KKK 是所有合法类别标签连同 ⊥\\perp⊥ 的集合。 这确立了在输出由多数决定时,对多个标准分类器成功攻击的条件。我们现在演示 BARZ 中的两个安全原理如何增加攻击条件的难度。 1. 绝对共识多数投票 在 BARZ 中,我们不使用简单的多数投票,而是使用绝对共识多数投票。这意味着如果所有分类器不同意相同的标签,则样本被解释为对抗性/可疑,标记为 ⊥\\perp⊥,并且攻击失败。我们可以看到,这特别地将 (1) 中的阈值 \>0\> 0\>0 更改为 ≥m\\geq m≥m 以进行成功攻击。请注意,虽然阈值现在更高,但成功攻击的基本条件,优势 A(y\^,k)A(\\hat{y}, k)A(y\^,k),在值上没有改变。我们的下一个安全原理处理基本条件。 2. 输入变换 在 BARZ 中,每个分类器 CjC_jCj 实现自己独特的秘密输入线性变换 ψj\\psi_jψj。重要的是要注意,在本小节中,我们抽象地讨论秘密变换 ϕj\\phi_jϕj,而不指定变换的具体类型。从理论上讲,这使我们能够开发对手攻击成功率的数学公式,而不假设变换的类型。然而,对于实验和防御实现,图像变换很重要,我们在第四-B 节进一步讨论其选择。一旦应用了秘密输入线性变换 ψj\\psi_jψj,就会执行分类器 Cj′C_j'Cj′: Cj′=Cj′∘ψj.C_j' = C_j' \\circ \\psi_j.Cj′=Cj′∘ψj. 个体变换的原因是为了进一步增加制作对抗样本 ϕ(xi,yi)\\phi(x_i, y_i)ϕ(xi,yi) 的难度。文献中已经表明,原始分类器具有高可迁移性 \[33\]。因此,使用没有变换的标准原始分类器(对于所有 kkk,ψk\\psi_kψk 是恒等函数)不会显著提高安全性,原因如下:如果 Cj′(ϕ(xi,yi))=y\^≠yi,C_j'(\\phi(x_i, y_i)) = \\hat{y} \\neq y_i,Cj′(ϕ(xi,yi))=y\^=yi, 那么由于可迁移性,所有标准原始分类器 Ck′C_k'Ck′ 输出相同的错误标签 y\^\\hat{y}y\^ 的概率很高。 *** ** * ** ***  这意味着使用原始分类器的绝对共识多数投票会产生高攻击成功率 α\\alphaα。参见 (1) 中绝对共识多数投票 ≥m\\geq m≥m 的必要条件。 我们可以将 ϕ(xi,yi)\\phi(x_i, y_i)ϕ(xi,yi) 重写为相应的干净图像和噪声:ϕ(xi,yi)=xi+ηi\\phi(x_i, y_i) = x_i + \\eta_iϕ(xi,yi)=xi+ηi。在这种公式下,我们可以重新表述(通过使用 ψj\\psi_jψj 的线性)基本条件 A(y\^,k)A(\\hat{y}, k)A(y\^,k) 为 ∣\[1≤j≤m:Cj′(ϕ(xi,yi))=y\^\]∣−∣\[1≤j≤m:Cj′(ϕ(xi,yi))=k\]∣=∣\[1≤j≤m:Cj′(ψ(xi)+ψj(ηi))=y\^\]∣−∣\[1≤j≤m:Cj′(ψ(xi)+ψj(ηi))=k\]∣\|\[1 \\leq j \\leq m : C_j'(\\phi(x_i, y_i)) = \\hat{y}\]\| - \|\[1 \\leq j \\leq m : C_j'(\\phi(x_i, y_i)) = k\]\| = \|\[1 \\leq j \\leq m : C_j'(\\psi(x_i) + \\psi_j(\\eta_i)) = \\hat{y}\]\| - \|\[1 \\leq j \\leq m : C_j'(\\psi(x_i) + \\psi_j(\\eta_i)) = k\]\|∣\[1≤j≤m:Cj′(ϕ(xi,yi))=y\^\]∣−∣\[1≤j≤m:Cj′(ϕ(xi,yi))=k\]∣=∣\[1≤j≤m:Cj′(ψ(xi)+ψj(ηi))=y\^\]∣−∣\[1≤j≤m:Cj′(ψ(xi)+ψj(ηi))=k\]∣ (2) 从 (2) 可以得出几个重要的结论。虽然变换 ψj\\psi_jψj 在分类器之间变化,但对手制作的噪声 ηi\\eta_iηi 并不改变。本质上,对于单个样本 xix_ixi,对手必须生成对变换集 ψ1,...,ψm\\psi_1, \\ldots, \\psi_mψ1,...,ψm 不变的噪声 ηi\\eta_iηi。具体来说,成功攻击的条件现在是:对于某个 y\^∉\[yi,⊥\]\\hat{y} \\notin \[y_i, \\perp\]y\^∈/\[yi,⊥\],有 Cj′(ψ(xi)+ψj(ηi))=y\^,...,Cm′(ψ(xi)+ψm(ηi))=y\^C_j'(\\psi(x_i) + \\psi_j(\\eta_i)) = \\hat{y}, \\ldots, C_m'(\\psi(x_i) + \\psi_m(\\eta_i)) = \\hat{y}Cj′(ψ(xi)+ψj(ηi))=y\^,...,Cm′(ψ(xi)+ψm(ηi))=y\^。也就是说,噪声 ψj(ηi)\\psi_j(\\eta_i)ψj(ηi) 必须欺骗分类器 CjC_jCj,对于所有 jjj 同时成立,而对手只能构造一个噪声值 ηi\\eta_iηi。 当我们将 (2) 与绝对共识多数投票结合时,对手的最终攻击成功率可以简洁地写为: ∣(xi,yi)∈X(C)∃y\^∈X(yi,⊥)∀j=1mCj′(ψ(xi)+ψj(ηi))=y\^∣⋅∣X(C)∣\\left\| \\frac{(x_i, y_i) \\in X(C)}{\\exists_{\\hat{y} \\in X(y_i, \\perp)} \\forall_{j=1}\^m C_j'(\\psi(x_i) + \\psi_j(\\eta_i)) = \\hat{y}} \\right\| \\cdot \|X(C)\| ∃y\^∈X(yi,⊥)∀j=1mCj′(ψ(xi)+ψj(ηi))=y\^(xi,yi)∈X(C) ⋅∣X(C)∣ 在原始的多分类器攻击公式 (1) 中,只需要多数分类器将对抗样本 ϕ(xi,yi)\\phi(x_i, y_i)ϕ(xi,yi) 错误分类到一个标签 y\^\\hat{y}y\^,使得对于任何 k≠y\^k \\neq \\hat{y}k=y\^,有 A(y\^,k)\>0A(\\hat{y}, k) \> 0A(y\^,k)\>0。在 BARZ 防御下,很明显,新条件要求*所有*分类器和每个变换都被绕过。 B. 实现屏障区 在实践中,屏障区迫使对手添加大于一定幅度的噪声 η\\etaη 以克服屏障区。因为如果噪声对人类视觉可见,攻击就会失败,所以对手在 η\\etaη 的幅度上受到限制。在许多情况下,这意味着对手可能无法克服屏障区,因此无法欺骗分类器。屏障区在图 3 的理论图和实际实验结果中都有显示。自然的问题是如何在分类器中实现屏障区?在本小节中,我们讨论可用于创建屏障区的不同技术。 1. 多分类器 屏障区可以通过使用多个分类器来创建。这种方法的一个简单方法是简单地使用不同架构的 CNN。然而,我们表明仅使用不同的架构并不能产生安全性。具体来说,我们在结果中通过使用一个 VGG16 和一个 ResNet56 进行多数投票(我们将其表示为 Liu 防御)来测试这种防御。文献 \[33\] 中也显示了这一点。架构防御不能产生安全性的其他例子包括 ADP 和 Mul-Def(我们在本文中测试了这些)。为了打破网络之间的可迁移性,我们为每个分类器引入秘密图像变换。我们由多个分类器(每个都有其自己的变换)组成的防御如图 4 所示。每个 CNN 有两个简单的独特秘密图像变换,如图 4 所示。第一个是固定的线性变换 c(x)=Ax+bc(x) = Ax + bc(x)=Ax+b,其中 AAA 是一个矩阵,bbb 是一个向量。 在线性变换之后,在将图像输入 CNN 之前,对图像应用调整大小操作 iii。对应于 ccc 和 iii 的 CNN 在干净数据 {i(c(x))}\\{i(c(x))\\}{i(c(x))} 上训练。使用多个 CNN,每个都有自己的调整大小操作以及 AAA 和 bbb 组件,如图 4 所示。 从 \[22\] 我们知道,对抗样本对图像变换敏感,这些变换要么扭曲图像中像素的值,要么改变像素的原始空间位置。重要的是要注意,在本文中,我们通过实验确定图像调整大小和线性变换可以减少可迁移性。然而,可能还有其他图像变换也可以实现这一目标。 2. 图像变换防御 在处理安全中的图像变换时,会出现几个简单的问题。例如,能否只使用一个带有图像变换的网络而不重新训练?我们使用 Xie 的防御测试了这个概念(并且我们显示在混合黑盒攻击下它的表现比 BARZ 差)。 能否只使用一个带有图像变换和重新训练的网络工作?本质上,我们测试了一个单一网络,带有一组变换 (Guo) 和一个在多个随机变换上重新训练的单一网络 (BaRT)。这两种防御在混合黑盒攻击下的表现都比 BARZ 差。 另一个有效的问题是,能否仅采用对抗样本的检测?我们通过以下方式测试这个假设:我们使用一个原始网络和一个置信度阈值,即任何低于某个置信度分数的样本都被标记为对抗性。我们还测试了采用自己对抗检测方法的 Odds 防御。在第六节中,我们显示无论是阈值化还是 Odds 防御都无法超越 BARZ。 重要的是要注意,可能进一步结合其他防御技术,如对抗训练、随机化一些图像变换或任何数量的其他技术。然而,本文的目标并非详尽测试所有可能的防御组合。目标也不是测试文献中的每一种防御。这项工作的目标是提供一个针对黑盒对手的防御框架,该框架在干净准确率和安全性之间提供清晰的权衡。 #### C. 屏障区图 在图 3 中,我们展示了来自 CIFAR-10 的单个图像的各种防御的屏障区图。这些图基于最初在 \[33\] 中提出的决策区域图。在我们的图中,2D 网格上的每个点对应图像 I′I'I′ 的类别标签。绿色表示 I′I'I′ 已被正确分类,而红色和蓝色区域表示不正确的类别标签。灰色表示已分配空(对抗性)类别标签。图像 I′I'I′ 由原始图像 III 生成: I′=I+x⋅g+y⋅r.I' = I + x \\cdot g + y \\cdot r.I′=I+x⋅g+y⋅r. 这里 ggg 表示损失函数相对于 III 的梯度。在 (3) 中,rrr 表示一个归一化的随机矩阵,它与 III 正交(注意 ggg 也被归一化)。变量 xxx 和 yyy 表示每个矩阵的幅度,由 2D 图中的坐标确定。 本质上,该图可以按以下意义解释:原点是没有添加对抗性扰动或随机噪声的原始图像的分类。当我们沿着 x 轴正向移动时,梯度矩阵 xxx 的幅度增加。仅沿 x 轴正向移动相当于 FGSM 攻击,其中通过添加损失函数的梯度(相对于输入)来修改图像。如果我们仅沿 y 轴移动,随机噪声矩阵 yyy 的幅度增加。这相当于向图像添加随机噪声。沿正 x 轴和 y 轴的任何方向移动意味着我们正在向原始图像 III 添加对抗性扰动和随机噪声。离原点越远,xxx 和 yyy 的幅度越大,因此应用于创建 I′I'I′ 的失真越大。 在防御使用多个网络 mmm 的情况下,每个网络 iii 将具有不同的梯度矩阵 gig_{i}gi。为了补偿这一点,我们在归一化之前将各个梯度矩阵平均在一起以得到 ggg。重要的是要注意,虽然图 3 中显示的图提供了屏障区概念的经验证明,但它们不能用于在实践中攻击 BARZ 防御。在创建图时,我们知道每个单独网络 iii 的各个梯度矩阵 gig_{i}gi。对于黑盒对手,只知道防御的最终输出 O(x)\\mathcal{O}(x)O(x)。无法获得各个网络的输出。因此,据我们所知,在黑盒对抗模型下,不可能精确估计各个梯度 gig_{i}gi 来构建屏障区图。  *** ** * ** *** #### V. 衡量防御性能 通常,在构建防御时,有两个主要方面需要考虑。第一个方面是安全性。在对抗性机器学习领域,安全性由鲁棒准确率表示。构建防御时,第二个要考虑的方面是成本。在对抗性机器学习中,这种成本通常以干净准确率下降 γ\\gammaγ 的形式出现。在理想情况下,安全性是免费的,即 γ=0\\gamma = 0γ=0。在对抗性机器学习中,有充分证据表明鲁棒性(安全性)不是免费的。干净准确率和鲁棒性之间存在固有的权衡 \[42, 43\]。在这种情况下,自然的问题是,如果总是产生成本,我们如何判断一个防御? 在本文中,我们通过使用一个考虑鲁棒性和干净准确率两者的度量来回答这个问题,以衡量这种权衡。我们引入 δ\\deltaδ-metric 来正确理解以下两者的综合影响: 1. 从原始干净准确率 ppp 到防御的干净准确率 pd=p−γ p_d = p - \\gamma pd=p−γ (4) 的下降 γ\\gammaγ。这里,干净准确率 ppp 对应于非恶意环境中没有防御策略的原始方案(vanilla scheme)。类似地,干净准确率 pdp_dpd 代表在没有对手的非恶意环境中测量的防御准确率。 2. 攻击者对防御的成功率 α\\alphaα。如果防御将对抗性操纵的图像识别为对抗样本,则它输出对抗性标签 ⊥\\perp⊥,并且攻击不被认为是成功的。在定义 α\\alphaα 时,我们将自己限制在那些防御(在其原始未受攻击形式下)能正确分类其正确标签的图像上的对抗样本。然后,攻击者的成功率被定义为操纵这些图像的对抗样本的比例,使得防御产生不同于正确标签和对抗性标签 ⊥\\perp⊥ 的标签。为完整起见,文献将鲁棒准确率或防御成功率定义为 1−α1 - \\alpha1−α。(我们注意到大多数防御无法将对抗性操纵的图像识别为对抗样本,并且没有可能输出对抗性标签。) 在存在对手的情况下,防御的正确分类是以下之一:图像(可能在对抗性操纵之后)被其正确标签识别(意味着攻击无效)。或者,对抗性操纵的图像被给予对抗性标签 ⊥\\perp⊥(如果防御提供这种可能性)。 在存在对手的情况下,防御进行正确/准确分类的概率等于 (p−γ)(1−α)(p - \\gamma)(1 - \\alpha)(p−γ)(1−α)(因为如果没有对手存在,防御会正确标记 p−γp - \\gammap−γ 比例的图像,而如果存在对手,这些图像中有 α\\alphaα 比例被成功攻击)。换句话说,(p−γ)(1−α)(p - \\gamma)(1 - \\alpha)(p−γ)(1−α) 是存在对手时(恶意环境中)防御的准确率。从没有防御的非恶意环境到有防御的恶意环境,准确率下降了 δ=p−(p−γ)(1−α)=γ+(p−γ)α.\\delta = p - (p - \\gamma)(1 - \\alpha) = \\gamma + (p - \\gamma)\\alpha.δ=p−(p−γ)(1−α)=γ+(p−γ)α. (5) δ\\deltaδ 可用于衡量不同防御的有效性,越小越好。如果两种防御提供大致相同的 δ\\deltaδ,那么考虑它们的 (γ,α)(\\gamma, \\alpha)(γ,α) 对并选择具有较小 α\\alphaα 或较小 γ\\gammaγ 的防御是有意义的。 从纯 ML 的角度来看,为了使防御在非恶意环境中表现良好,我们希望 γ\\gammaγ 非常小,或者等价地,pdp_dpd 接近 ppp。从纯安全的角度来看,为了使防御在恶意环境中表现良好,我们希望 δ\\deltaδ 小。因此,为了正确比较防御,我们关注元组 (δ=γ+(p−γ)α,pd=p−γ)(\\delta = \\gamma + (p - \\gamma)\\alpha, p_d = p - \\gamma)(δ=γ+(p−γ)α,pd=p−γ),其中 α\\alphaα 对应于文献中已知最佳攻击的最佳攻击成功率。请注意,原始方案(vanilla scheme)也可以在恶意环境中考虑,这将对应于某个 (δvan,pd=p)(\\delta_{van}, p_d = p)(δvan,pd=p)。显然,导致 δ≥δvan\\delta \\geq \\delta_{van}δ≥δvan 的防御并不比根本不实施防御(即普通原始方案)有所改进。 在理想情况下,当攻击总是失败 (α=0\\alpha = 0α=0) 并且使用防御没有成本 (γ=0\\gamma = 0γ=0) 时,δ=0\\delta = 0δ=0。由于对抗性攻击,α\>0\\alpha \> 0α\>0,因此,这种情况不会发生。因此,我们寻找具有最小 δ\\deltaδ 的防御,例如,一个同时具有低 α\\alphaα 和低 γ\\gammaγ 的防御。如果两种防御具有相似的 δ\\deltaδ 值,我们可以简单地考虑具有更好干净准确率的那一种,这正是我们在本文中所做的。重要的是要注意,δ\\deltaδ 度量仅仅是理解鲁棒性和干净准确率之间权衡的一种方式。它绝不是确定性的或唯一的方法。在本文中,我们专注于使用 δ\\deltaδ 度量来衡量防御,因为它能够简洁地捕获两组信息,α\\alphaα(安全性)和 γ\\gammaγ(成本)。对于那些对其他度量感兴趣的人,我们在附录的图表和表格中分别提供了本文涵盖的所有攻击和防御的所有准确率测量结果。 ### VI 实验结果 在本节中,我们提供实验结果以显示 BARZ 防御的有效性。我们还展示了我们的混合黑盒攻击带来的改进。我们在两个流行数据集 Fashion-MNIST \[44\] 和 CIFAR-10 \[45\] 上进行了实验。与文献中报道的其他结果不同,对于每种防御,只要可能,我们都使用相同的网络架构构建它。我们将防御应用于相同的数据集,并在同一组攻击下运行每种防御。这使我们能够提供前所未有的自适应黑盒攻击结果比较。我们还在 Github 上提供了与我们实验相关的代码:https://github.com/MetaMain/BARZ。 #### A. 混合黑盒攻击 如第三部分所述,我们的混合黑盒攻击是 Papernot 攻击的扩展。原始论文 \[26\] 仅使用单一方法进行实验来生成    对抗样本,即快速梯度符号法 (FGSM)。我们在图 7 中比较了 Papernot 攻击和混合黑盒攻击的结果,针对 CIFAR-10 使用 ∥l∥∞\\\|l\\\|_{\\infty}∥l∥∞ 范数,最大扰动 ϵ=0.05\\epsilon = 0.05ϵ=0.05,针对 Fashion-MNIST 使用 ϵ=0.1\\epsilon = 0.1ϵ=0.1。攻击成功率使用测试集中的 1000 个样本进行测量。总体而言,通过向对手提供更多数据,对原始网络(vanilla network)的非目标攻击成功率在 CIFAR-10 上可以提高 49.4%,在 Fashion-MNIST 上可以提高 31.1%。这些结果的更多实验细节在附录中给出。有些人可能反对具有训练数据访问权限的对手的实用性。然而,作为防御设计者,我们希望考虑最强大的可能硬标签黑盒对手。因此,混合黑盒攻击显然对于防御验证是必要的。 ### B. 纯黑盒和边界攻击 除了混合黑盒攻击,我们还考虑了纯黑盒攻击和边界攻击。这些攻击中的每一种都可以根据对抗样本的生成方式进一步分类。对于纯黑盒攻击和混合黑盒攻击(本文提出),我们使用六种不同的对抗生成方法(FGSM, IFGSM, PGD, MIM, C\&W 和 EAD)。对于纯黑盒攻击,我们使用相同的生成方法集(但与攻击结合使用的模型不是自适应训练的)。对于边界攻击,我们考虑 HSJA 和 RayS。总的来说,这代表了四种类型的黑盒攻击和 14 种生成对抗样本的不同方式。对于 CIFAR-10,我们允许的最大扰动是 ϵ=0.05\\epsilon = 0.05ϵ=0.05,对于 Fashion-MNIST,最大扰动是 ϵ=0.1\\epsilon = 0.1ϵ=0.1。对于 RayS,我们允许每个样本 10,000 次查询,对于 HSJA,我们使用可变查询风格的攻击(我们在附录中详细解释)。注意在表 2 中,某些攻击不适用于某些防御。这只发生在对 2 种防御(BaRT 和 Odds)的边界攻击上。这是由于边界攻击运行时不可并行化预测的计算复杂性问题。我们在附录中完整解释了这一点,并提供了所有攻击的精确攻击细节。 ### C. 防御 我们实验了 11 种防御(BARZ, 原始阈值化, Guo, Liu, ADP, Xie, Madry, Tramer, Mul-Def, BaRT 和 Odds)。在网络架构方面,我们在 CIFAR-10 防御中使用 ResNet56 \[46\],在 Fashion-MNIST 防御中使用 VGG16 \[47\]。重要的是要注意,这里报告的结果并不总是与文献结果完全相同。这是由于架构和数据集的差异。例如,BaRT 的作者从未发布过其防御的 CIFAR-10 版本,因此我们的 BaRT 实现将具有与他们为 ImageNet 报告的不同的准确率。同样,Madry 最初的 CIFAR-10 防御是使用 Wide ResNet 训练的,而我们使用 ResNet56V2。我们为每种防御(尽可能)使用相同的基础架构和相同的数据集,以使我们的比较尽可能有效。由于篇幅有限,我们无法在这里描述每种防御的完整实现细节。我们鼓励感兴趣的读者查看附录以获取更多细节。   1. BARZ 和阈值化防御 在本文中,我们实验了 BARZ 以及一种我们称之为原始阈值化(vanilla thresholding)的简单防御。一个常见的误解是,仅仅通过阈值化原始分类器的输出(即,如果网络对其预测不自信,则将样本标记为对抗性),那么所有黑盒攻击都可以被缓解。我们提供了 70%、95% 和 99% 阈值化网络的结果,以表明情况并非如此。 对于 BARZ,我们通过图像变换实现屏障区。具体来说,每个网络都有一个从映射 c(x)=Ax+bc(x) = Ax + bc(x)=Ax+b 中选择的图像变换。我们在附录中解释了如何根据数据集选择随机化的 AAA 和 bbb。我们可以将图像变换 cj(x)c_j(x)cj(x) 视为添加到构成第 jjj 个 CNN 的层上的额外随机固定层。我们测试了三种这样的设计:一种带有 8 个网络 (BARZ-8),每个网络使用不同的图像调整大小操作,从 32 调整到 32, 40, 48, 64, 72, 80, 96, 104。第二种带有 4 个网络 (BARZ-4),是 8 个网络中使用图像调整大小操作从 32 调整到 32, 48, 72, 96 的子集。第三种带有 2 个网络 (BARZ-2),是 8 个网络中使用图像调整大小操作从 32 调整到 32 和 104 的子集。 我们还考虑了 BARZ 的随机化版本,我们将其表示为 BARZ-xRy。在这个版本中,使用 yyy 个网络(从 xxx 个网络中选择)的子集对样本进行绝对多数投票。例如,在 BARZ-8R2 中,每次提交样本时,随机选择八个网络中的两个来对样本进行分类。 D. 实验分析 我们论文的主要结果在表 2 中给出,针对 CIFAR-10 和 Fashion-MNIST,鲁棒准确率在图 6 中直观显示。我们根据防御最弱的攻击(即具有最低鲁棒准确率的攻击)计算每种防御的 δ 度量。例如,如果 BARZ-8 防御对 RayS 的鲁棒准确率为 60% (60% 的对抗样本没有欺骗防御),对 HSJA 的鲁棒准确率为 39%,则使用 HSJA 计算 BARZ-8 边界 δ\\deltaδ 度量。纯黑盒攻击、混合黑盒攻击和边界攻击对手的最坏情况 δ\\deltaδ 度量结果在图 5、8 和 2 中直观显示。 在性能方面,我们提出的防御 (BARZ) 在 CIFAR-10 和 Fashion-MNIST 上都优于所有其他防御。在 CIFAR-10 上,BARZ-4 在 δ\\deltaδ 混合和 δ\\deltaδ 纯方面提供了安全性和准确率之间的最佳权衡,而 BARZ-8 具有最佳的鲁棒准确率(混合为 92.6%,纯为 92.8%)。对于边界攻击,BARZ-8R6 也为 CIFAR-10 提供了最佳权衡以及最佳的鲁棒准确率 (87%)。同样,对于 Fashion-MNIST,BARZ-8 在混合和纯黑盒攻击中具有最低的 δ\\deltaδ。对于 Fashion-MNIST,BARZ-8 还具有最佳的纯和混合鲁棒准确率,分别为 90.6% 和 89.9%。对于 Fashion-MNIST 的边界攻击,我们可以看到 BARZ-8R2 提供了最佳权衡,但 Madry 提供了稍好的鲁棒准确率(Madry 为 96%,BARZ-8R2 为 92%)。对于那些对传统鲁棒准确率测量感兴趣的人,我们在图 1 中给出了总体结果。该图显示了每种防御在所有黑盒攻击中的最低鲁棒准确率。我们只能在本节中总结主要结果。在附录中,我们深入比较了 11 种防御的结果。 ### VII 结论 在本文中,我们通过提供一种新的黑盒攻击和一种基于屏障区的新型黑盒防御,推动了对抗性机器学习领域的发展。我们的新攻击通过实验证明比原始的 Papernot 攻击更强。它还在 Xie 和 Mul-Def 等防御上优于边界攻击和纯黑盒攻击。其次,也是最重要的,我们开发了一种新的基于屏障区的防御。我们的防御在纯、混合和基于边界的黑盒攻击下优于我们测试的所有其他 10 种防御方法。在比较本文测试的所有黑盒攻击和数据集时,我们最佳的防御配置为 CIFAR-10 和 Fashion-MNIST 提供了超过 85% 的鲁棒准确率,与次佳防御相比提高了超过 30%。总体而言,我们开发了第一种屏障区防御 (BARZ),并通过实验证明其对 14 种不同类型的黑盒攻击具有鲁棒性。 ### 附录 A 实验防御结果 在本节中,我们提供补充实验结果,包括 * *目标和非目标混合黑盒攻击*, * *目标和非目标纯黑盒攻击*,以及 * *边界攻击 -- 非目标 HopSkipJump \[25\] 和 RayS \[34\]*。 我们在**十种不同的防御策略**上运行这些攻击,包括随机变换轰炸 (BaRT) \[22\], The Odds are Odd (Odds) \[23\], 集成多样性 (ADP) \[24\], Madry 的对抗训练 (Madry) \[27\], 基于多模型的防御 (Mul-Def) \[21\], 使用输入变换对抗对抗图像 (Guo) \[20\], 集成对抗训练:攻击与防御 (Tramer) \[14\], 混合架构 (Liu) \[33\], 通过随机化减轻对抗效应 (Xie) \[18\], 阈值网络(本文开发的基本概念验证防御)和屏障区 (BARZ),使用 CIFAR-10 \[45\] 和 Fashion-MNIST \[44\] 数据集。对抗样本生成是通过在合成模型(从纯黑盒或混合黑盒攻击获得的模型)上运行白盒攻击来完成的。用于对抗样本生成的六种白盒攻击是 FGSM \[8\], BIM \[38\], MIM \[39\], PGD \[27\], C\&W \[11\] 和 EAD \[40\]。我们还测试了防御在边界黑盒攻击(Hop Skip Jump \[25\] 和 RayS \[34\])下的表现。 我们首先讨论防御在本文黑盒攻击下的鲁棒性开始本节。 #### A. 防御的鲁棒性 图 6 和图 9 代表了防御在 Fashion-MNIST 和 CIFAR-10 数据集上不同黑盒攻击下的鲁棒准确率。对于目标攻击,图 10 显示了防御在两个维度上的表现,干净准确率与 delta (δ\\deltaδ) 的关系。我们从这些图中得出以下主要观察结果。 1. 混合黑盒攻击比纯黑盒攻击更强,非目标攻击比目标攻击更强大。与纯黑盒攻击相比,混合黑盒攻击被提供了更多关于目标模型的信息(原始训练   数据和查询目标模型以标记生成的合成数据的权限);因此混合黑盒攻击应该比纯黑盒攻击更强。因为目标攻击可以被视为比非目标攻击有更多约束的优化问题,目标攻击应该比非目标攻击花费更多精力运行,因此威力较小。 2) 目标纯黑盒攻击似乎不是一个强大的攻击模型。这得到了以下事实的支持:原始方案(根本不实施任何防御)已经提供了非常好的鲁棒性(即,它已经对目标纯黑盒攻击具有很高的防御准确率)。因此,几乎所有考虑的防御在这种威胁模型下都提供了良好的鲁棒性和干净准确率。这解释了为什么防御在目标纯黑盒攻击的图中相对接近,如图 10 所示。 3) 如上所述和讨论,混合黑盒攻击比纯黑盒攻击更强。这解释了为什么一部分考虑的防御对于目标混合黑盒攻击仍然可以显著改进原始方案,如图 10 所示。 4) 对于非目标边界攻击,有许多防御具有 0% 的鲁棒准确率。因此,我们在图 6 中没有看到这些防御的条形图,例如 Vanilla, VanillaT-0.7 等具有 0% 的鲁棒准确率。 5) 从图 5、8、2、6、9 和 10 中得出最有趣和最重要的观察结果如下: a) 存在一组防御,它们享有高鲁棒性和干净准确率,即防御位于左上角,具有小的 delta 值和高干净准确率,并且 b) BARZ 防御在任何上述场景中都属于该组。 这些观察结果表明,与所有场景中的其他防御相比,BARZ 系列提供了良好的鲁棒性和干净准确率。 我们在接下来的章节中为 Fashion-MNIST 和 CIFAR-10 提供更详细的攻击和防御结果。请注意,接下来两节中的所有详细结果已在图 5、8、2、6、9 和 10 中可视化,其中对这些详细结果的最重要讨论和观察已总结 above。 B. FASHION-MNIST:攻击与防御 Fashion-MNIST 的结果在表 3、4、5、6 和 7 中描述。回顾 δ\\deltaδ 度量的公式: δ=γ+(p−γ)α=p−(p−γ)(1−α)=p−pd⋅β,\\delta = \\gamma + (p - \\gamma)\\alpha = p - (p - \\gamma)(1 - \\alpha) = p - p_d \\cdot \\beta,δ=γ+(p−γ)α=p−(p−γ)(1−α)=p−pd⋅β, 其中 ppp 是原始分类器(即根本没有防御且没有任何对抗存在)的干净准确率,γ\\gammaγ 是干净准确率的下降,即 γ=p−pd\\gamma = p - p_dγ=p−pd,pdp_dpd 代表没有攻击者时防御的干净准确率,α\\alphaα 是攻击者对防御的成功率,β\\betaβ 是鲁棒准确率或防御成功率(也称为防御准确率),等于 1−α1 - \\alpha1−α。 δ\\deltaδ 可用于衡量不同防御的有效性,越小越好。如果两种防御提供大致相同的 δ\\deltaδ,那么考虑它们的 (γ,α)(\\gamma, \\alpha)(γ,α) 对并选择具有较小 α\\alphaα 或较小 γ\\gammaγ 的防御是有意义的。   对于 Fashion-MNIST 和 CIFAR-10,p=0.9356p = 0.9356p=0.9356 和 0.92780.92780.9278,分别。δ\\deltaδ 的值是通过组合原始分类器的 ppp 和所考虑防御的 pdp_dpd, 并通过查看在给定防御上实施的所有攻击中最佳攻击(这对应于特定集合的最大攻击成功率 α\\alphaα 考虑的攻击,类似地,这对应于各种防御成功率 β\\betaβ 的最小值)来计算的。例如, 表 3 中 BARZ-8 的 δ\\deltaδ 度量计算如下: 我们代入 p=0.9356p = 0.9356p=0.9356, pd=0.7779p_d = 0.7779pd=0.7779, 以及所有(当前已知的)目标混合黑盒攻击中的最小 β=0.986\\beta = 0.986β=0.986(在这种情况下对应于 FGSM-T 攻击) 代入公式 (Eq. 6) 求 δ\\deltaδ。这导致 δ=0.168591\\delta = 0.168591δ=0.168591。 讨论:我们从 上述表格中得出以下观察结果: 1. BARZ 系列在任何攻击场景中实现了最小的 δ\\deltaδ。 图 5、8、2 和 10 反映了这一事实。 2. 许多防御(如 Guo, Liu, ADP, Tramer)具有非常高的干净准确率(即,接近原始分类器的干净准确率),但具有非常大的 δ\\deltaδ。如果我们仔细观察图 6 和 9 或表 3、5、6 和 7 中呈现的结果,我们可以看到它们容易受到黑盒攻击。换句话说,它们不提供安全性。 3. 通过结合干净准确率的下降 γ\\gammaγ 和鲁棒准确率 β\\betaβ 的增加,δ\\deltaδ 度量可以   用于理解防御在存在攻击者时的表现。为了进行更详细的评估,我们需要分别查看攻击成功率 α\\alphaα(或等效地,鲁棒准确率 β\\betaβ)和防御的干净准确率 pdp_dpd。 4. 从表 3、4、5 和 6 我们得出结论,混合黑盒攻击比纯黑盒攻击更有效,非目标黑盒攻击比目标攻击更强。查看表 7,边界攻击比混合和纯黑盒攻击强得多。 5. BARZ 可以通过调整防御中分类器的数量来实现防御者准确率 pdp_dpd 和攻击者成功率 α\\alphaα 的不同组合。 6. BARZ-RZ, Madry 和 MulDef 对边界攻击具有最小的 δ\\deltaδ 值。对于 BARZ 和 MulDef 防御,原因是对于给定的输入 xxx,对于每次评估,这些防御引入了一些随机性。因此,输出类别标签可能会改变。这强烈影响了边界攻击的效率,边界攻击需要准确估计许多图像的梯度(并且由于引入的随机性,这些估计变得不那么准确)。  讨论:我们从上述表格中得出以下观察结果(与 Fashion-MNIST 相同,但第 6 项略有不同): 1. BARZ 系列在任何攻击场景中实现了最小的 δ\\deltaδ。图 5、8、2 和 10 反映了这一事实。 2. 许多防御(如 Guo, Liu, ADP, Tramer)具有非常高的干净准确率(即,接近原始分类器的干净准确率),但具有非常大的 δ\\deltaδ。如果我们仔细观察图 6 和 9 或表 8、10、11 和 12 中呈现的结果,我们可以看到它们容易受到黑盒攻击。换句话说,它们不提供安全性。 3. 通过结合干净准确率的下降 γ\\gammaγ 和鲁棒准确率 β\\betaβ 的增加,δ\\deltaδ 度量可用于理解防御在存在攻击者时的表现。为了进行更详细的评估,我们需要分别查看攻击成功率 α\\alphaα(或等效地,鲁棒准确率 β\\betaβ)和防御的干净准确率 pdp_dpd。 4. 从表 8、9、10 和 11 我们得出结论,混合黑盒攻击比纯黑盒攻击更有效,非目标黑盒攻击比目标攻击更强。查看表 12,边界攻击比混合和纯黑盒攻击强得多。 5. BARZ 可以通过调整防御中分类器的数量来实现防御者准确率 pdp_dpd 和攻击者成功率 α\\alphaα 的不同组合。 6. BARZ-8R6/2, Xie 和 MulDef 对边界攻击具有最小的 δ\\deltaδ 值。原因是对于给定的输入 xxx,对于每次评估,这些防御引入了一些随机性。因此,输出类别标签可能会改变。这强烈影响了边界攻击的效率,边界攻击需要准确估计许多图像的梯度(并且由于引入的随机性,这些估计变得不那么准确)。 附录 B 实验攻击结果 正如我们在论文正文中提到的,混合黑盒攻击可以被认为是 Papernot 攻击的扩展。在本节中,我们提供使用 CIFAR-10 数据集的实验证据来支持我们的主张。在图 11 中,我们显示了攻击成功率作为训练数据函数的图形表示。图的 x 轴是攻击开始时用于构建合成模型的训练数据百分比。图的 y 轴是攻击对原始(未防御)模型的攻击成功率。 对于这个实验,我们固定了几个变量以进行比较。我们使用 FGSM 攻击在合成模型上生成对抗样本,ϵ=0.05\\epsilon = 0.05ϵ=0.05。我们将攻击中的迭代次数固定为 N=4N = 4N=4,λ=0.1\\lambda = 0.1λ=0.1,适用于所有实验。在 Papernot 对 MNIST 分类器的原始攻击中,使用了原始训练数据的 0.3%。我们显示,随着训练数据量(以及随后的查询)的增加,攻击成功率会增加。当训练数据百分比达到 100% 时,我们就得到了我们称之为混合黑盒攻击的攻击。这代表了攻击成功率的显著增加。在我们的 CIFAR-10 实验中,我们显示它从 24.7% 增加到 66.6%,攻击成功率提高了 41.9%。 在某些防御上,混合黑盒攻击也优于其他攻击。例如,考虑随机化的 Xie 防御。CIFAR-10 在非目标边界攻击下的鲁棒准确率为 85%。然而,在非目标混合黑盒攻击下,鲁棒准确率最低,仅为 26.2%。同样,混合黑盒攻击在 MulDef-4 和 MulDef-8 上优于边界攻击(尽管纯黑盒攻击在这里以微弱的 1% 优势最强)。如果我们考虑 Fashion-MNIST,我们也可以看到混合黑盒攻击在其上优于其他攻击的防御。在 Fashion-MNIST 上,Xie、MulDef 和 Madry 防御在混合黑盒攻击下获得最低的鲁棒准确率。 总结我们这里分析的目的是双重的。首先,通过我们的实验,我们表明当条件相同时,混合黑盒攻击明显优于原始的 Papernot 攻击。其次,我们显示混合黑盒攻击是对某些防御最有效的攻击。需要明确的是,我们*并不* 声称拥有普遍最强的黑盒攻击。我们仅仅表明,由于不同的防御采用不同的防御技术,某些黑盒攻击将比其他攻击更有效。因此,必须测试广泛的黑盒攻击(如本文所做)。在这个要测试的攻击范围中,混合黑盒攻击显然对于防御验证是必要的。   ### 附录 C 对抗攻击描述 D. 纯和混合黑盒攻击 正如我们在主论文中提到的,混合黑盒攻击是 Papernot \[26\] 提出的原始攻击的扩展。这里我们将 ggg 表示为来自 \[26\] 的基于预言机的黑盒攻击的合成网络。 攻击者使用一个预言机 O\\mathcal{O}O,它代表对目标模型 fff 的黑盒访问权限。这种情况下的预言机访问为查询 xxx 提供一个类别标签 F(f(x))F(f (x))F(f(x))(而不是分数向量 f(x)f (x)f(x))。最初,攻击者拥有部分训练数据集 XXX,即,他们知道 D={(x,F(f(x))):x∈X0}D = \\{(x, F(f (x))) : x \\in X_0\\}D={(x,F(f(x))):x∈X0},其中 X0⊆XX_0 \\subseteq XX0⊆X。请注意,对于单次迭代 N=1N = 1N=1 将攻击简化为不需要任何预言机访问 O\\mathcal{O}O 来构建合成模型的算法;这种简化的算法用于纯黑盒攻击 \[10\], \[33\], \[48\]。 在混合黑盒攻击中,我们假设算法 1 中最有能力的黑盒对手可以访问整个训练数据集 X0=XX_0 = XX0=X(注意这排除了用于评估攻击成功率的测试数据)。 为了构建合成网络,攻击者先验地选择一个替代架构 GGG,需要为其训练合成模型参数 θg\\theta_gθg。攻击者使用 DDD 中已知的图像-标签对,使用训练方法 MMM(例如,Adam \[49\])训练 θg\\theta_gθg。在每次迭代中,使用以下数据增强技术将已知数据加倍   技术:对于当前数据集 DDD 中的每个图像 xxx,对目标模型的黑盒访问给出标签 l=O(x)l = \\mathcal{O}(x)l=O(x)。 评估/计算合成网络分数向量 ggg 相对于其参数 θg\\theta_gθg 对于图像 xxx 的 Jacobian 矩阵。将 Jacobian 矩阵中对应于类别标签 lll 的列的符号乘以一个(小)常数 λ\\lambdaλ------这构成了一个向量,将其添加到 xxx。这为每个 xxx 产生一个新图像,这导致 DDD 加倍。经过 NNN 次迭代后,算法输出最终增强数据集 DDD 的训练参数 θg\\theta_gθg。 E. 对抗样本生成 在合成模型训练之后,需要从合成模型创建对抗样本来攻击防御。因此,任何白盒攻击都可以在合成模型上运行以创建对抗样本。然后对手可以检查这个例子是否欺骗了防御。重申一下,在本文中,我们关注黑盒对手,因此直接在任何防御上运行白盒攻击不在我们的对抗模型范围内。我们简要介绍以下我们用于对抗样本生成的常用白盒攻击: 快速梯度符号法 (FGSM) -- \[8\]: 计算 x′=x+ϵ×sign(∇xL(x,l;θ))x' = x + \\epsilon \\times sign(\\nabla_x L(x, l; \\theta))x′=x+ϵ×sign(∇xL(x,l;θ)),其中 LLL 是模型 fff 的损失函数(例如,交叉熵)。 基本迭代方法 (BIM) -- \[38\]: xi′=clipx,ϵ(xi−1′+ϵr×sign(∇xi−1′L(xi−1′,l;θ)))x'_{i} = clip_{x,\\epsilon}(x'_{i-1} + \\frac{\\epsilon}{r} \\times sign(\\nabla_{x'_{i-1}} L(x'_{i-1}, l; \\theta)))xi′=clipx,ϵ(xi−1′+rϵ×sign(∇xi−1′L(xi−1′,l;θ))),其中 x0′=xx'_{0} = xx0′=x, rrr 是迭代次数,clipclipclip 是裁剪操作。  动量迭代方法 (MIM) -- \[39\]: 这是 BIM 的一个变体,使用动量技巧创建梯度 gig_igi,即 xi′=clipx,ϵ(xi−1′+ϵ2×sign(gi))x_i' = \\text{clip}_{x, \\epsilon} (x_{i-1}' + \\frac{\\epsilon}{2} \\times \\text{sign}(g_i))xi′=clipx,ϵ(xi−1′+2ϵ×sign(gi))。 投影梯度下降 (PGD) -- \[27\]: 这也是 BIM 的一个变体,其中裁剪操作被投影操作替换。 Carlini and Wagner 攻击 (C\&W) -- \[11\]: 我们定义 x′(ω)=12(tanhω+1)x'(\\omega) = \\frac{1}{2}(\\tanh \\omega + 1)x′(ω)=21(tanhω+1) 和 g(x)=max(max(si:i≠l)−si,−κ)g(x) = \\max(\\max(s_i : i \\neq l) - s_i, -\\kappa)g(x)=max(max(si:i=l)−si,−κ),其中 f(x)=(s1,s2,...)f(x) = (s_1, s_2, \\ldots)f(x)=(s1,s2,...) 是分类器 fff 输入 xxx 的分数向量,κ\\kappaκ 控制对抗样本的置信度。对手构建以下目标函数来寻找对抗噪声。 minω∥x′(ω)−x∥22+cf(x′(ω)),\\min_{\\omega} \\\| x'(\\omega) - x \\\|_2\^2 + c f(x'(\\omega)),ωmin∥x′(ω)−x∥22+cf(x′(ω)), 其中 ccc 是通过修改的二分搜索选择的常数。 弹性网络攻击 (EAD) -- \[40\]: 这是 C\&W 攻击的变体,具有以下目标函数。 minω∥x′(ω)−x∥22+β∥x′(ω)−x∥1+cf(x′(ω)).\\min_{\\omega} \\\| x'(\\omega) - x \\\|_2\^2 + \\beta \\\| x'(\\omega) - x \\\|_1 + c f(x'(\\omega)).ωmin∥x′(ω)−x∥22+β∥x′(ω)−x∥1+cf(x′(ω)). 附录 D 实验实现细节和杂项 F. BARZ 的实现 在 BARZ 中,我们使用的图像变换由调整大小操作 i(x)i(x)i(x) 和线性变换 c(x)=Ax+bc(x) = Ax + bc(x)=Ax+b 组成。在 CNN 实现中,可以将 i(c(x))i(c(x))i(c(x)) 视为 CNN 架构本身中的一个额外层。我们将此额外层称为保护层。在 BARZ 中,保护层中的输入图像 xxx 被线性变换为图像 i(c(x))i(c(x))i(c(x)),然后才进入相应的 CNN 网络。 对于 BARZ 中每个保护层使用的调整大小操作 i(⋅)i(\\cdot)i(⋅),我们选择大于图像数据原始尺寸的尺寸。我们这样做是为了防止图像缩小会造成信息丢失(这会损害 BARZ 的干净准确率)。在我们的实验中,我们使用具有 2、4 和 8 个保护层的 BARZ。每个保护层都有自己的调整大小操作 i(⋅)i(\\cdot)i(⋅)。当使用 8 个保护层时,我们使用从 32 调整到 32, 40, 48, 64, 72, 80, 96, 104 的图像调整大小操作。每个保护层将由于每个层实现的调整大小量的不同而彼此区分。这将导致保护层之间的可迁移性降低,因此我们期望看到更宽的屏障区,从而降低攻击者的成功率。当使用 4 个保护层时,我们使用 BARZ 中 8 个网络的 4 个保护层的副本,这些副本对应于从 32 调整到 32, 48, 72, 96 的图像调整大小操作。当使用 2 个保护层时,我们使用 BARZ 中 8 个网络的 2 个保护层的副本,这些副本对应于从 32 调整到 32 和 104 的图像调整大小操作。 对于每个保护层,线性变换 c(x)=Ax+bc(x) = Ax + bc(x)=Ax+b 是从某个统计分布中随机选择的(该分布是公共知识,因此对手知道)。统计分布的设计取决于所考虑数据集的复杂性(在我们的案例中,我们实验了 Fashion-MNIST 和 CIFAR-10)。对于 CIFAR-10,我们将矩阵 AiA_iAi 视为单位矩阵(这也使得 AAA 在 c(x)c(x)c(x) 的向量表示中成为单位矩阵),并且我们对每个矩阵 bib_ibi 使用相同的矩阵 bbb,即, b′=b1=b2=b3.b' = b_1 = b_2 = b_3.b′=b1=b2=b3. 这意味着我们在像素的红色、蓝色和绿色值中使用相同的随机偏移。做出这个设计决定的原因是因为对于 CIFAR-10,我们发现完全随机的 AAA 会导致干净准确率大幅下降,即使网络被训练来学习这种失真。因此,对于像 CIFAR-10 这样具有高空间复杂度的数据集,我们不随机选择 AAA。我们选择 AAA 为单位矩阵。同样对于 b′b'b′,我们只随机生成 35% 的矩阵值,其余保留为 0。对于随机生成的值,我们从 −0.5-0.5−0.5 到 0.50.50.5 的均匀分布中选择它们。 对于空间复杂度较低的数据集,如 Fashion-MNIST,我们将矩阵 A′=A1=A2=A3A' = A_1 = A_2 = A_3A′=A1=A2=A3 和 b′=b1=b2=b3b' = b_1 = b_2 = b_3b′=b1=b2=b3 等同起来,并选择 A′A'A′ 和 b′b'b′ 作为随机矩阵:A′A'A′ 和 b′b'b′ 的值从高斯分布中选择,μ=0\\mu = 0μ=0 和 σ=0.1\\sigma = 0.1σ=0.1。 G. 攻击和防御参数 为了实现黑盒攻击,我们首先运行算法 1,该算法训练合成网络 ggg。接下来,从测试数据(在我们的设置中,每个数据集有 10,000 个样本)中,我们选择被防御正确识别的前 1000 个样本。对于这 1000 个样本中的每一个,我们运行某种白盒攻击以产生 1000 个对抗样本。攻击者的成功率是改变 lll 到期望的新随机选择的 l′l'l′(在目标攻击中)或任何其他标签 l′≠⊥l' \\neq \\perpl′=⊥(在非目标攻击中)的对抗样本的比例。 用于与我们的合成模型结合使用的对抗生成技术(白盒攻击)的参数,适用于混合黑盒攻击和纯黑盒攻击,可以在表 13 中找到。对于所有攻击,我们使用 ∣∣l∣∣∞\|\|l\|\|_{\\infty}∣∣l∣∣∞ 范数,除了 Carlini and Wagner 攻击。仅对于 Carlini and Wagner 攻击,∣∣l∣∣2\|\|l\|\|_2∣∣l∣∣2 实现(由作者提供)具有足够快的运行时间以适应我们当前的硬件设置(以测试 10 种防御和 2 个数据集)。未来的工作可能包括如果 Carlini and Wagner 攻击的有效 ∣∣l∣∣∞\|\|l\|\|_{\\infty}∣∣l∣∣∞ 实现将来可用,则尝试混合黑盒攻击。   我们实验的精确设置在图 14、15 和 16 中给出。表 14 详细说明了算法 1 中的训练方法 TTT。对于评估的数据集 Fashion-MNIST 和 CIFAR-10,没有数据增强,我们在表 15 中列举了训练数据量 ∣A0∣\|A_0\|∣A0∣ 以及参数 λ\\lambdaλ 和 NNN(λ=0.1\\lambda = 0.1λ=0.1 和 N=6N = 6N=6 取自 \[26\] 的基于预言机的黑盒攻击论文;注意大小为 10,000 的测试数据集是标准实践;所有剩余数据用于训练,并且攻击者可以完全访问)。 表 16 描述了不同数据集的合成网络 ggg 的 CNN 网络架构 GGG;该结构有几层(不要与 BARZ 中的"保护层"混淆,保护层是图像变换加上整个 CNN)。对手试图攻击 BARZ,并将首先学习一个具有对应于表 16 的架构 GGG 的合成网络 ggg。请注意,图像变换是保密的,因此攻击者最多只能训练一个合成原始网络。当然,攻击者确实知道 BARZ 中图像变换所取自的集合,并且可能尝试为每个可能的图像变换学习一个合成 CNN,并对这些 CNN 输出的标签进行某种多数投票(如 BARZ)。然而,存在指数级多的变换,使得这种攻击不可行。 H. 边界攻击计算复杂性和目标边界攻击 在论文正文中,我们提到 The Odds are Odd (Odds) 和随机变换轰炸 (BART) 都不适用于边界攻击。对于纯黑盒和混合黑盒攻击,我们可以使用 GPU 或多个 CPU(在图像变换的情况下)高效地并行化许多样本的评估。然而,边界攻击需要按顺序进行大量评估(例如 10,000 次查询),因此我们无法利用前面提到的并行性。这导致这些防御的边界攻击运行时间在我们的标准实现上达到数周量级。这些攻击不适用于我们当前的设置(28 核 CPU 机器和 2 个 Titan V GPU)。 还值得注意的是,在本文中我们不直接考虑目标边界攻击。尽管我们确实为一些其他黑盒目标攻击提供了实验细节,但在本文中我们的主要焦点是非目标攻击。由于我们已经在本文中提出了 12 种目标攻击(6 种混合黑盒和 6 种纯黑盒类型),我们将目标边界攻击作为潜在的未来工作。 #### I. 未来工作 有几个有希望的未来工作方向。从安全角度来看,我们的论文已经证明了图像变换对黑盒鲁棒性的有效性。我们实验了一组我们发现对创建屏障区有效的图像变换。然而,据我们所知,尚未对单一和固定组合图像变换的可迁移性进行大规模研究。确定哪些图像变换能够扭曲对抗性噪声同时保持鲁棒性,将使该领域更接近于建立一组图像变换作为安全原语。 在机器学习方面,通过引入新颖的架构,可能会提高 BARZ 防御的干净准确率。具体来说,Big Transfer 模型 \[50\] 是一类 CNN,在 CIFAR-10 和 CIFAR-100 等数据集上显示出卓越的性能。使用这些新架构可能是提高 BARZ 防御干净准确率的一种可能方式。 在攻击者方面,在这项工作中,我们只考虑对错误分类(无论是目标还是非目标)感兴趣的对手。攻击者从一个干净的样本开始,并特别试图避免样本被标记为正确标签或标记为对抗性标签。据我们所知,尚未广泛研究可能被视为这个问题的逆问题的工作,即攻击者试图用被标记为对抗性的合法样本来淹没系统。虽然这本身就是一个有趣的问题,但它超出了我们当前工作的范围。这可能是未来的防御设计者想要考虑并尝试缓解的问题。 最后,从攻击者方面来看,自适应黑盒攻击仍然可以进行优化。在我们的论文中,我们通过实验发现了一个简单的 CNN 架构,它既易于训练,又能产生高度可迁移的对抗样本。然而,仍然有可能优化攻击中的架构,以潜在地提高攻击成功率。此外,随着白盒攻击的不断改进,可能可以用更强大的技术替换自适应黑盒攻击中的 MIM 对抗生成方法。