阿里 Wan2.1 在 Windows 系统的部署实践笔记(更新版)

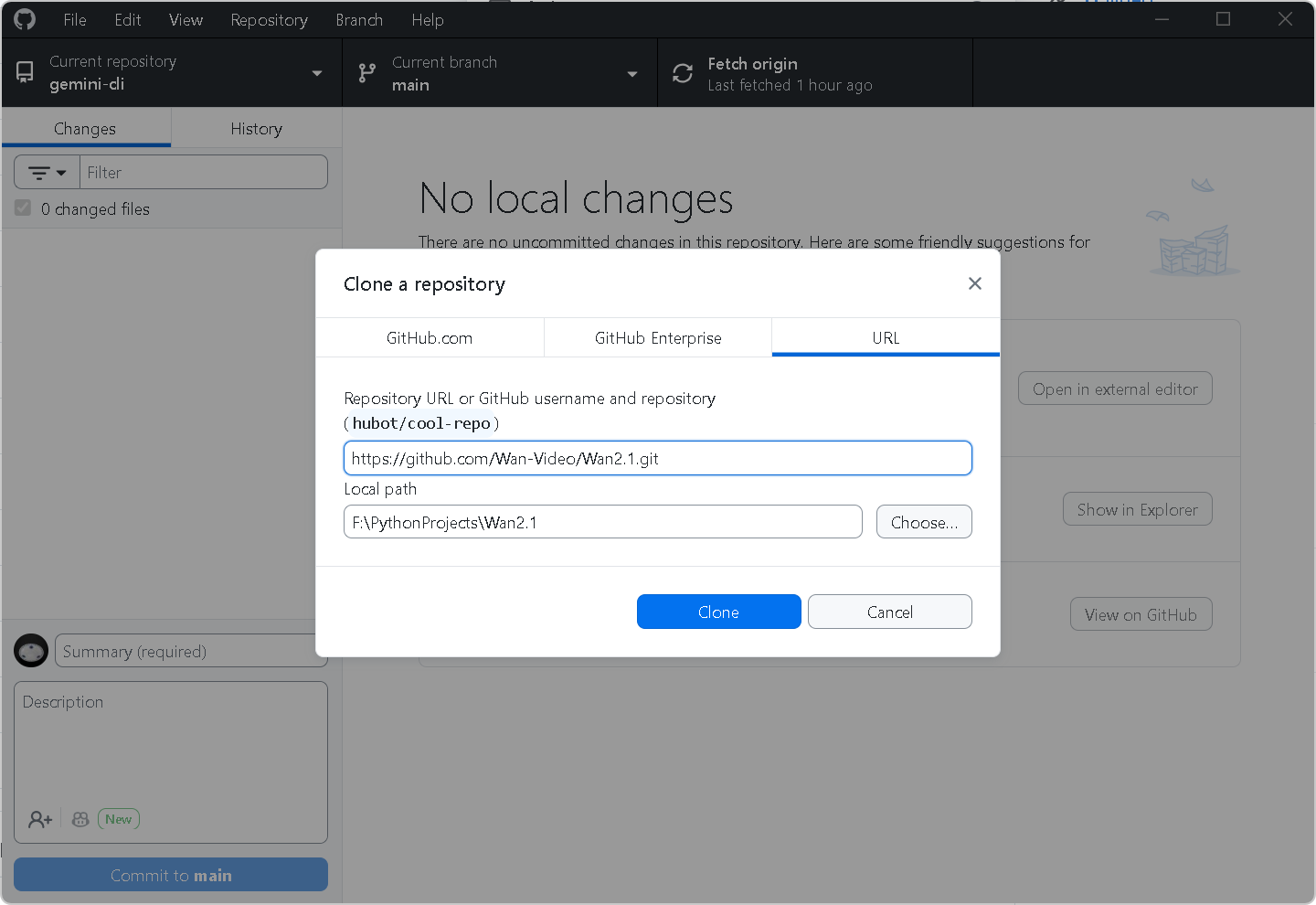

一、克隆仓库

-

项目地址 :https://github.com/Wan-Video/Wan2.1.git

https://github.com/Wan-Video/Wan2.1.git -

克隆方式:使用 GitHub Desktop (较为稳定和快速)克隆仓库到本地

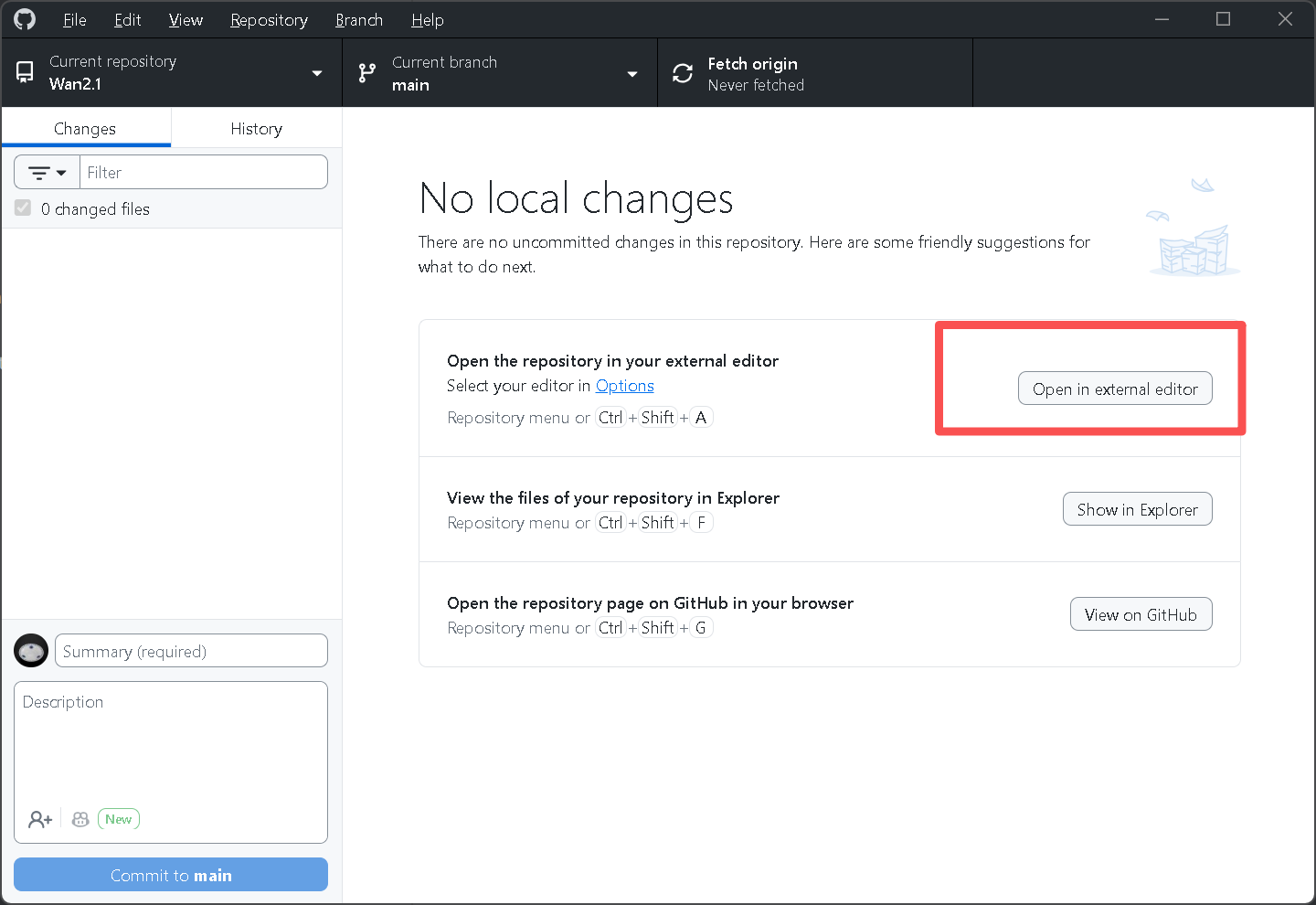

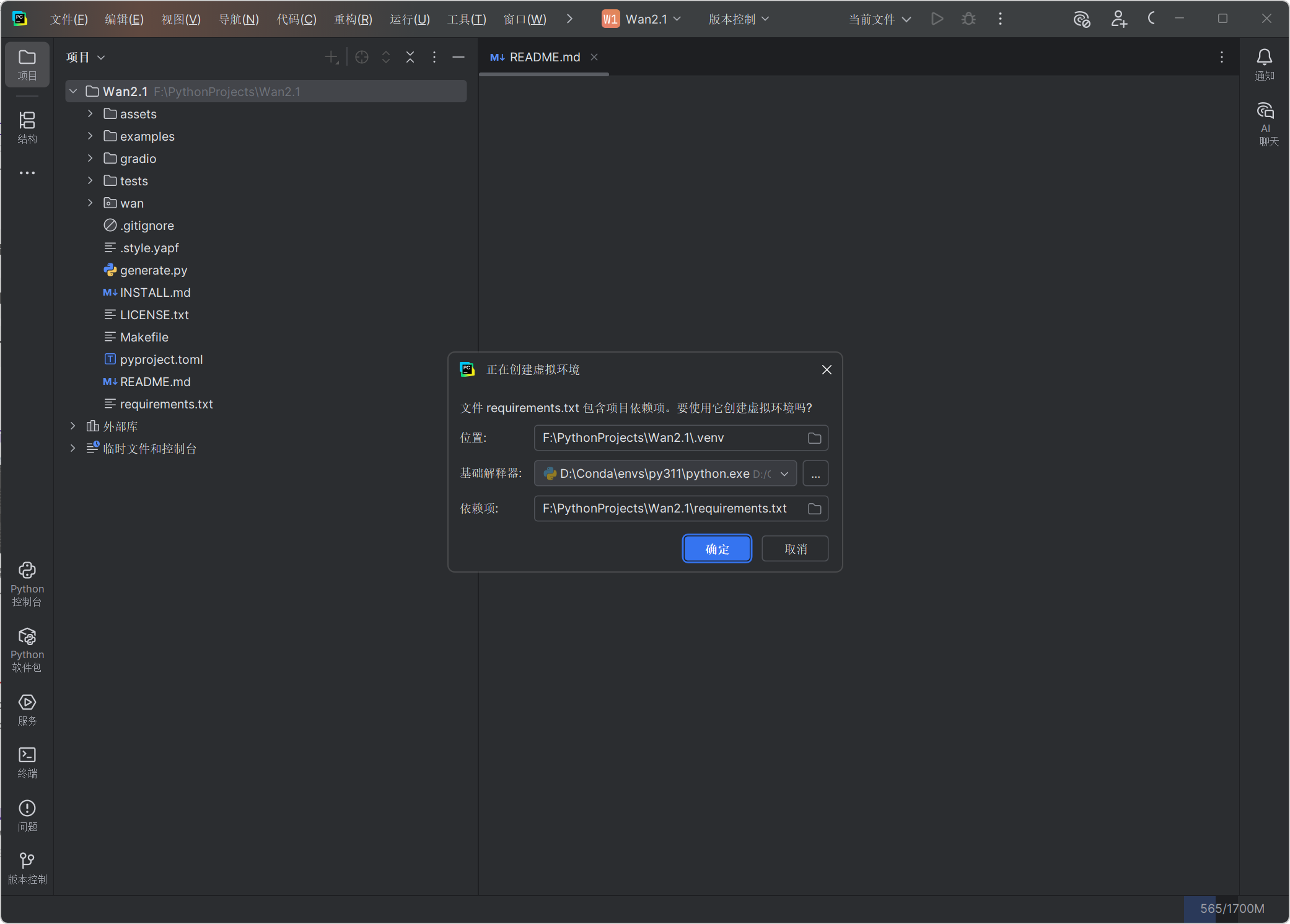

二、创建虚拟环境

Python 多版本环境治理理念驱动的系统架构设计------三维治理、四级隔离、五项自治 原则(路径治理升级修订 V 2.0 版)-CSDN博客

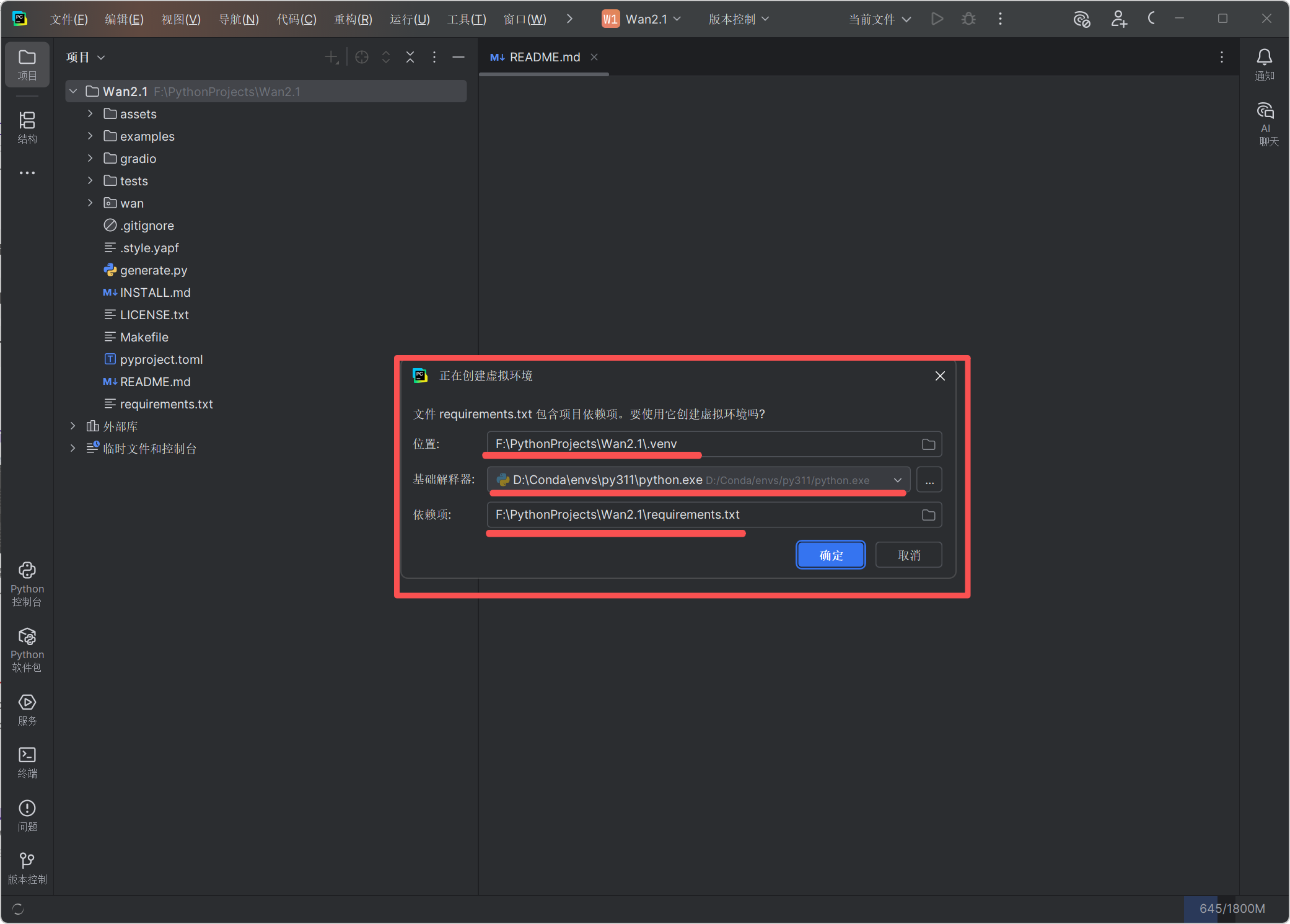

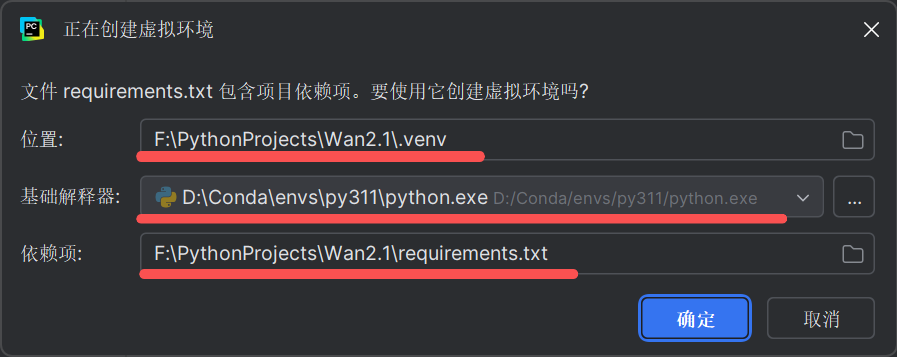

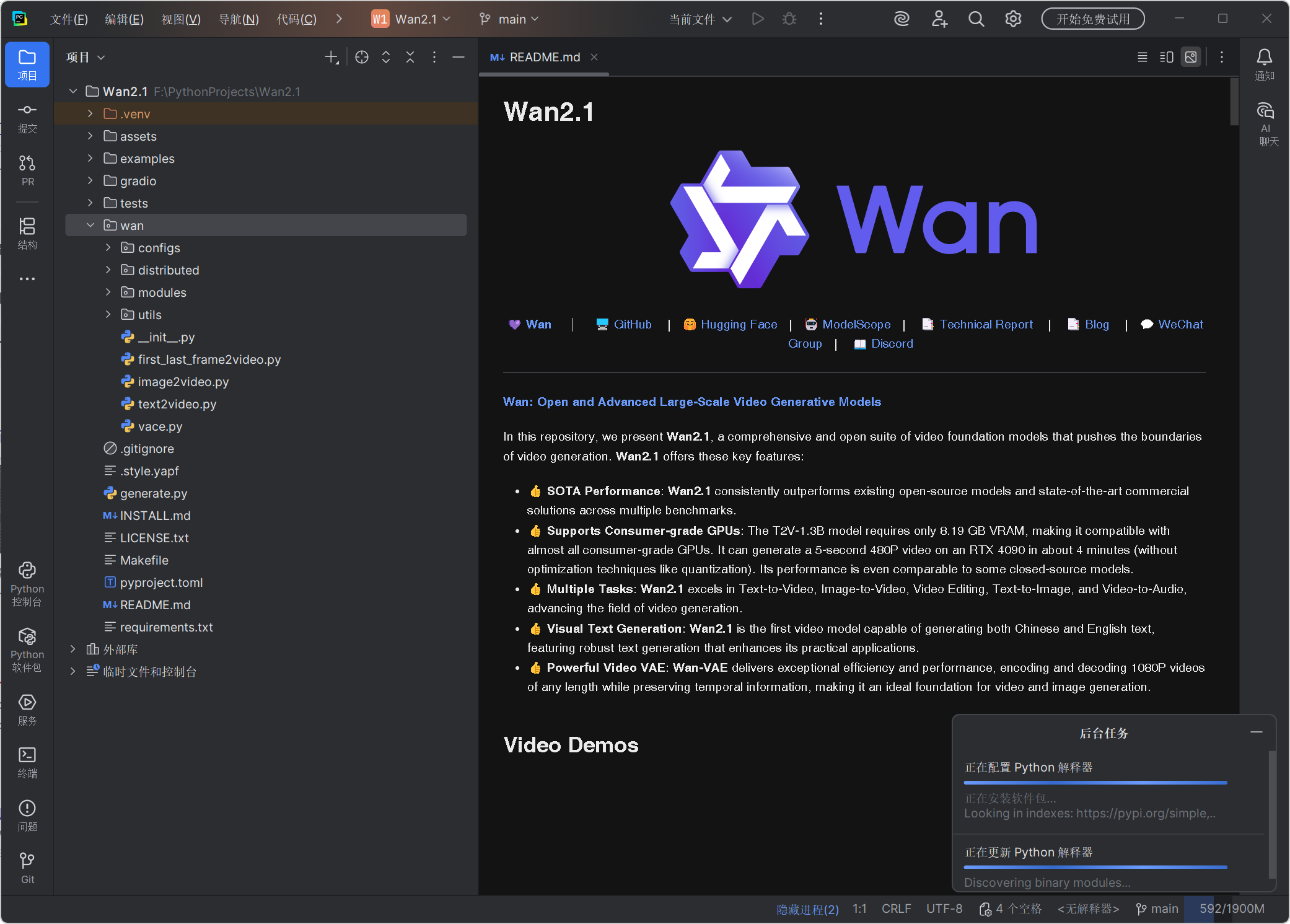

- 用 PyCharm 打开项目文件夹

- PyCharm 会自动识别项目中的requirements.txt

- 按照弹窗引导,配置基础 Python 解释器,由 PyCharm 自动创建

.venv虚拟环境

三、调整依赖配置

修改 requirements.txt 文件,注释掉torch及相关项(后续将单独安装适配 Windows 的版本)

注释以下项:

# 第 1 行 torch>=2.4.0

# 第 2 行 torchvision>=0.19.0

# 第 14 行 flash_attn原因说明:

第 1 行 和 第 2 行,直接安装会安装 torch 的 CPU 版,无法启用 CUDA 加速。如需 CUDA 的 GPU 加速,需使用 PyTorch 官网的命令安装。

对于稳定的 PyTorch 的 CUDA GPU 支持,请参见以下博客:

PyTorch 的 CUDA GPU 支持 · 安装五条铁律(最新版 2025 修订)(适用于所有用户)_pytorch 2.7.1支持的cudnn-CSDN博客

第 14 行 ,因为 pypi 仓库目前还没有直接适配 Windows 的 flash-attn 版本,直接安装会导致失败,并且 flash-attn 的安装依赖项之一是 torch ,所以等 torch 安装完成并验证成功后,再行安装flash-attn 的 .whl 文件。

修改后的 requirements.txt 文件

注释后的 requirements.txt 文件内容:

# torch>=2.4.0

# torchvision>=0.19.0

opencv-python>=4.9.0.80

diffusers>=0.31.0

transformers>=4.49.0

tokenizers>=0.20.3

accelerate>=1.1.1

tqdm

imageio

easydict

ftfy

dashscope

imageio-ffmpeg

# flash_attn

gradio>=5.0.0

numpy>=1.23.5,<2修改完成后,先不安装,待 PyTorch 安装完成后再行安装。

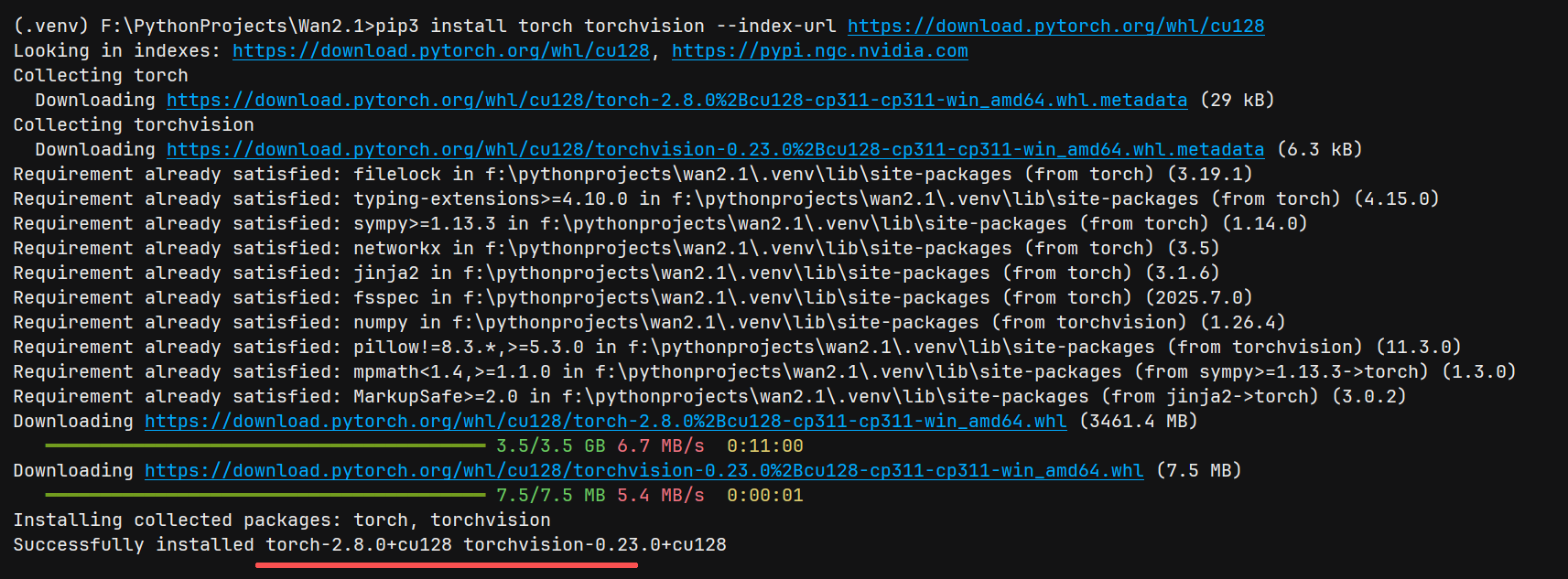

四、安装 PyTorch

-

安装命令 (以 CUDA 12.8 为例):

pip3 install torch torchvision --index-url https://download.pytorch.org/whl/cu128

-

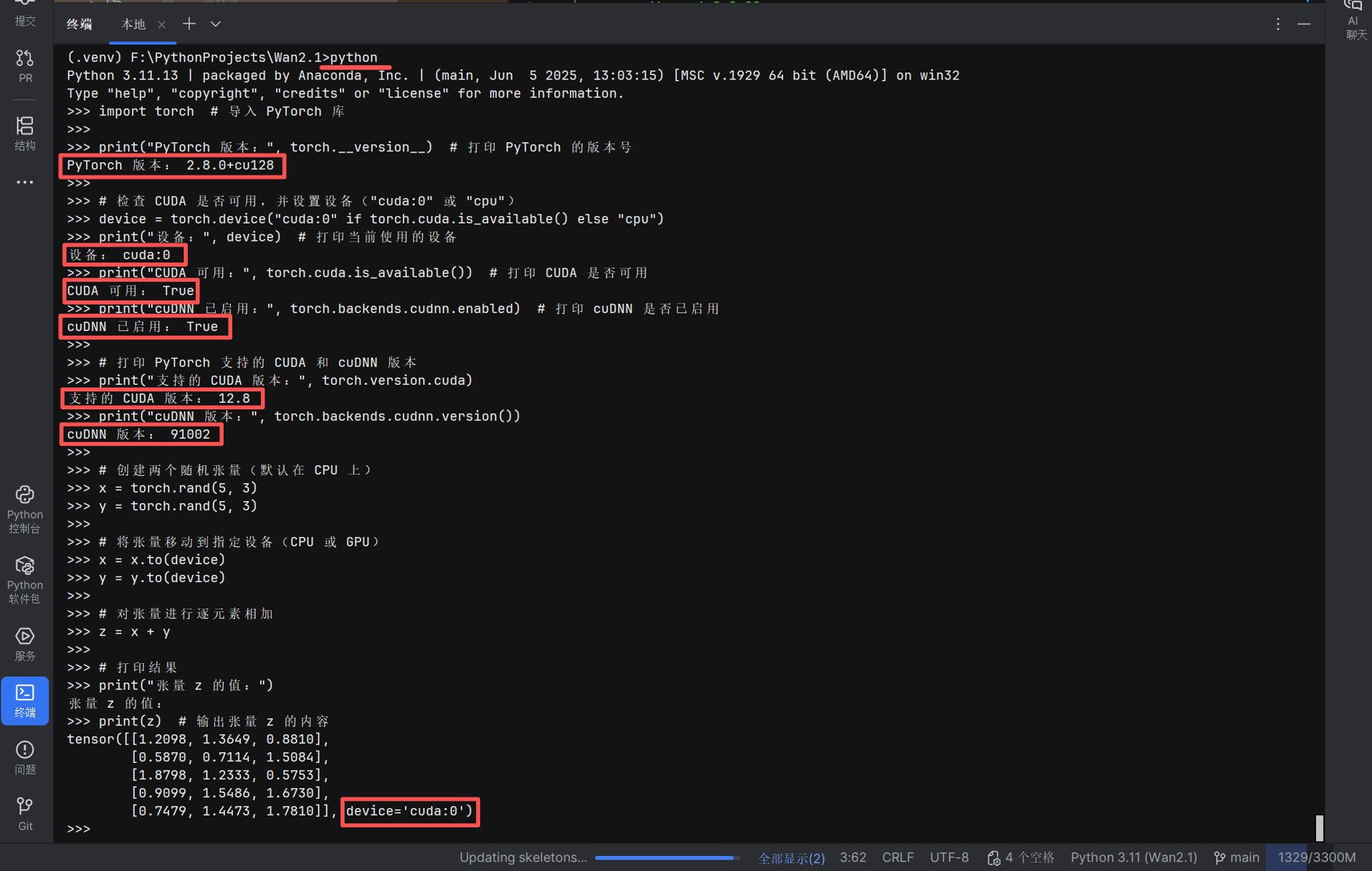

验证安装 :

进入 Python 环境并运行:

python粘贴以下全部脚本内容并按 回车 键。

import torch # 导入 PyTorch 库 print("PyTorch 版本:", torch.__version__) # 打印 PyTorch 的版本号 # 检查 CUDA 是否可用,并设置设备("cuda:0" 或 "cpu") device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu") print("设备:", device) # 打印当前使用的设备 print("CUDA 可用:", torch.cuda.is_available()) # 打印 CUDA 是否可用 print("cuDNN 已启用:", torch.backends.cudnn.enabled) # 打印 cuDNN 是否已启用 # 打印 PyTorch 支持的 CUDA 和 cuDNN 版本 print("支持的 CUDA 版本:", torch.version.cuda) print("cuDNN 版本:", torch.backends.cudnn.version()) # 创建两个随机张量(默认在 CPU 上) x = torch.rand(5, 3) y = torch.rand(5, 3) # 将张量移动到指定设备(CPU 或 GPU) x = x.to(device) y = y.to(device) # 对张量进行逐元素相加 z = x + y # 打印结果 print("张量 z 的值:") print(z) # 输出张量 z 的内容

注意确认 验证输出的 细节

注意确认 验证输出的 细节

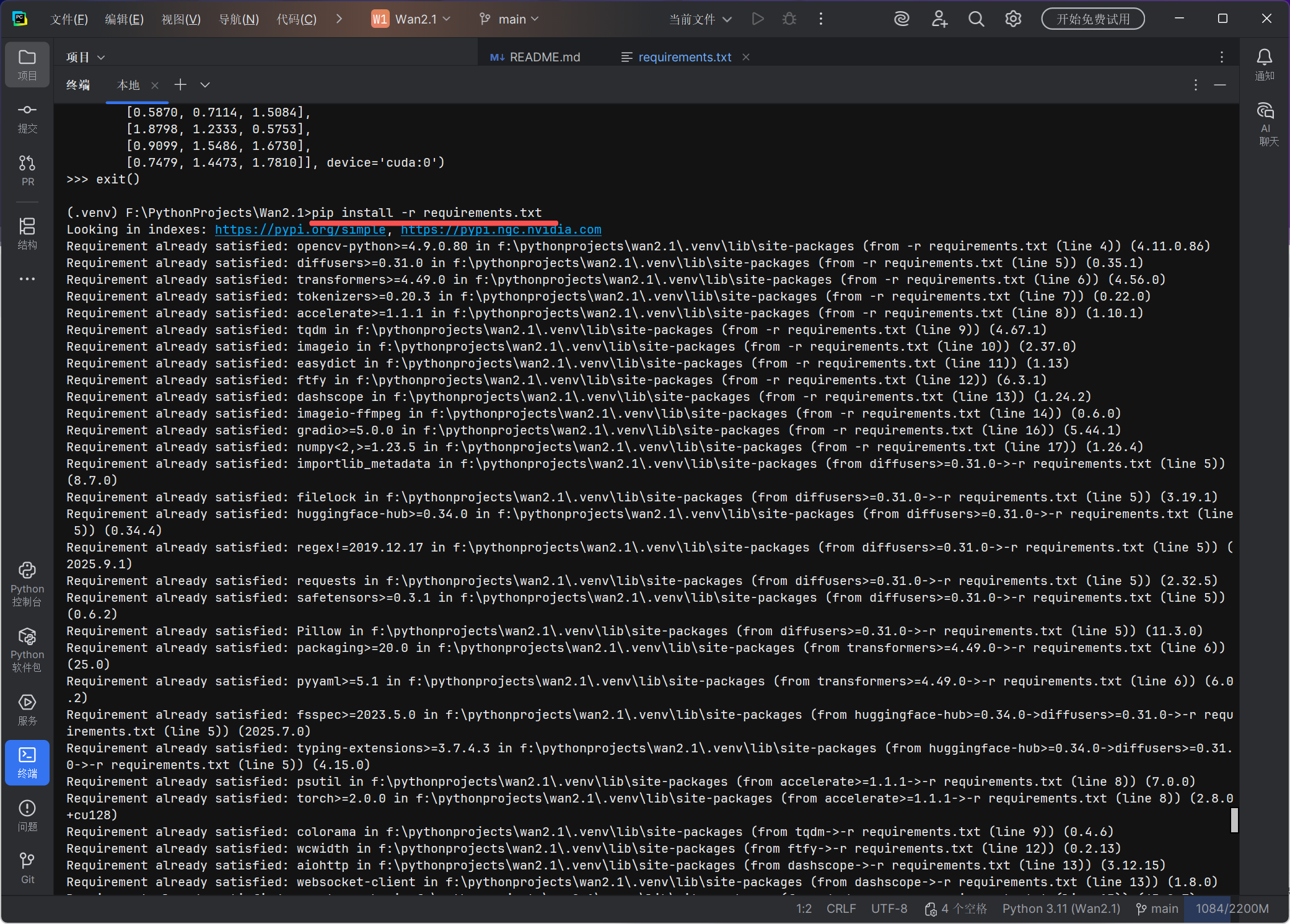

五、安装项目依赖

安装修改过后的 requirements.txt 文件:

pip install -r requirements.txt

requirements.txt 文件修改过后安装基本不会有什么问题。

安装完成后请进行下一步。

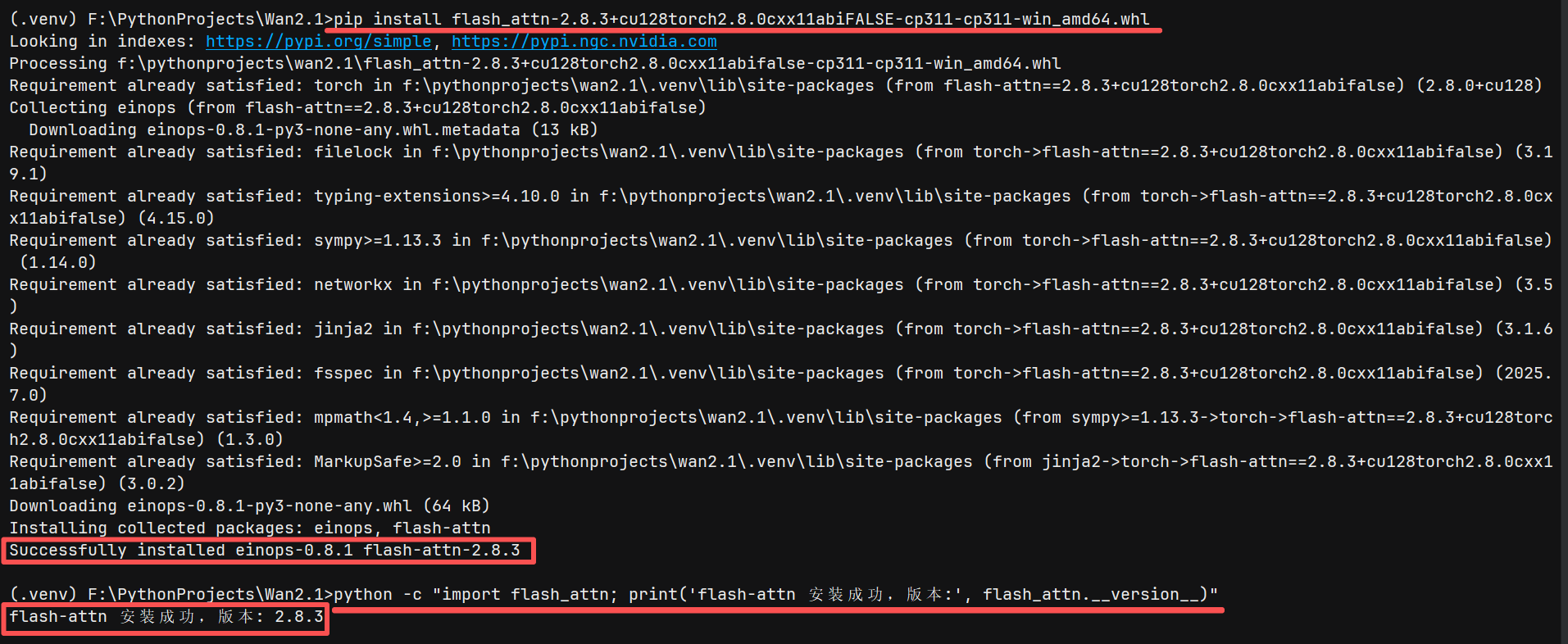

六、安装 flash-attn

-

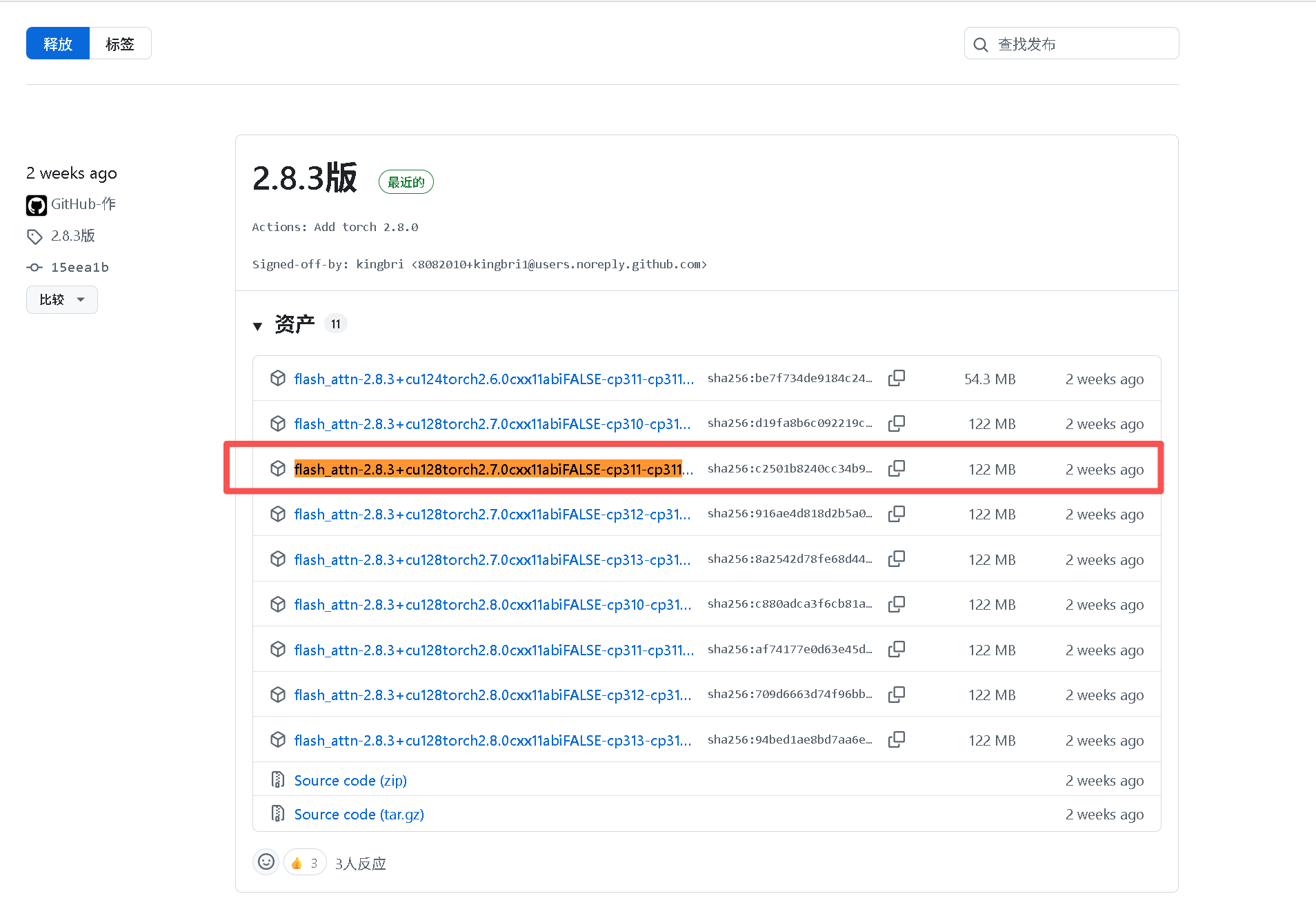

下载预编译包 :

从https://github.com/kingbri1/flash-attention/releases下载适用于 Windows、CUDA 12.8 和对应 Python 版本的.whl文件(例如flash_attn-2.8.3+cu128torch2.8.0cxx11abiFALSE-cp311-cp311-win_amd64.whl),并移动到项目文件夹内,避免因文件名和路径过长导致的安装失败。# 文件名: flash_attn-2.8.3+cu128torch2.8.0cxx11abiFALSE-cp311-cp311-win_amd64.whl说明:flash-attn 版本号:2.8.3 ;适配 CUDA 12.8 版;适配torch 2.8.0 版;适用于python 3.11 版。这些版本号需一一对应。

-

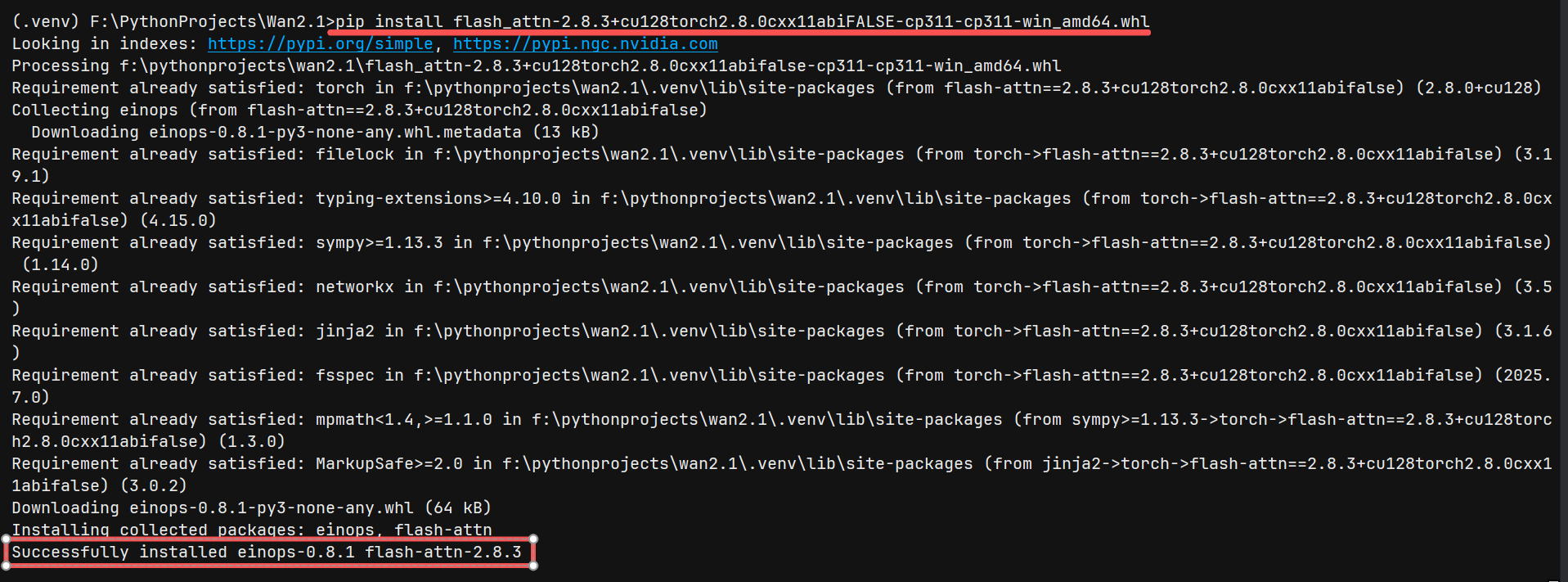

安装命令 :

pip install flash_attn-2.8.3+cu128torch2.8.0cxx11abiFALSE-cp311-cp311-win_amd64.whl命令说明:

# .whl文件在当前目录 pip install 下载的.whl文件 # .whl文件不在当前目录 pip install 下载的.whl文件"完整路径+完整文件名.whl" # 比如:.whl 在 "E:\Downloads\flash_attn-2.8.3+cu128torch2.8.0cxx11abiFALSE-cp311-cp311-win_amd64.whl",则安装命令为(不过路径和文件名过长容易导致安装失败): pip install "E:\Downloads\flash_attn-2.8.3+cu128torch2.8.0cxx11abiFALSE-cp311-cp311-win_amd64.whl"

或者使用自动从文件源下载并执行安装的命令:

pip install https://github.com/kingbri1/flash-attention/releases/download/v2.8.3/flash_attn-2.8.3+cu128torch2.8.0cxx11abiFALSE-cp311-cp311-win_amd64.whl

-

验证安装 :

python -c "import flash_attn; print('flash-attn 安装成功,版本:', flash_attn.__version__)"

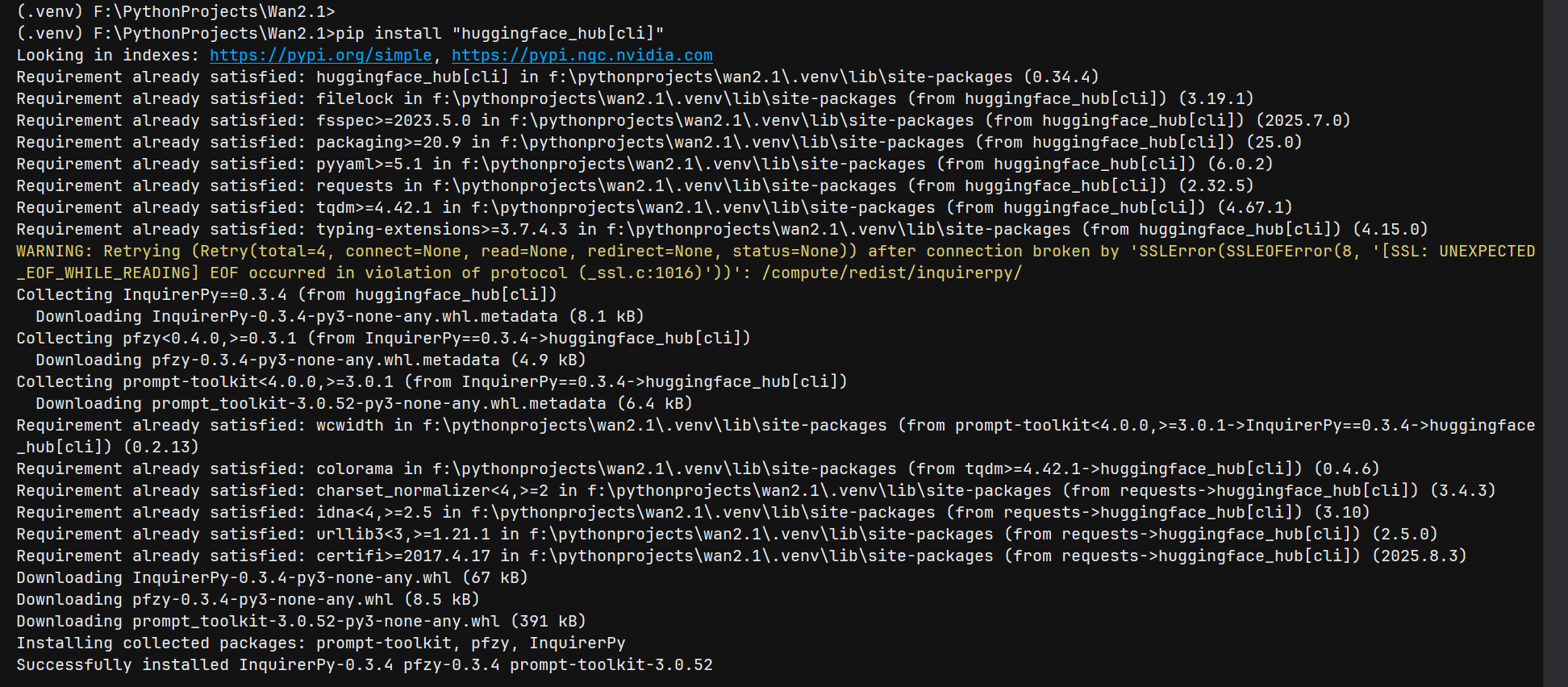

七、下载模型文件

-

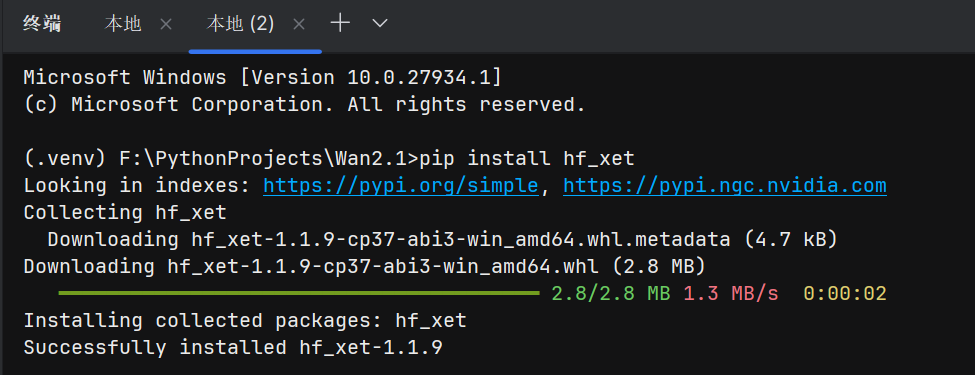

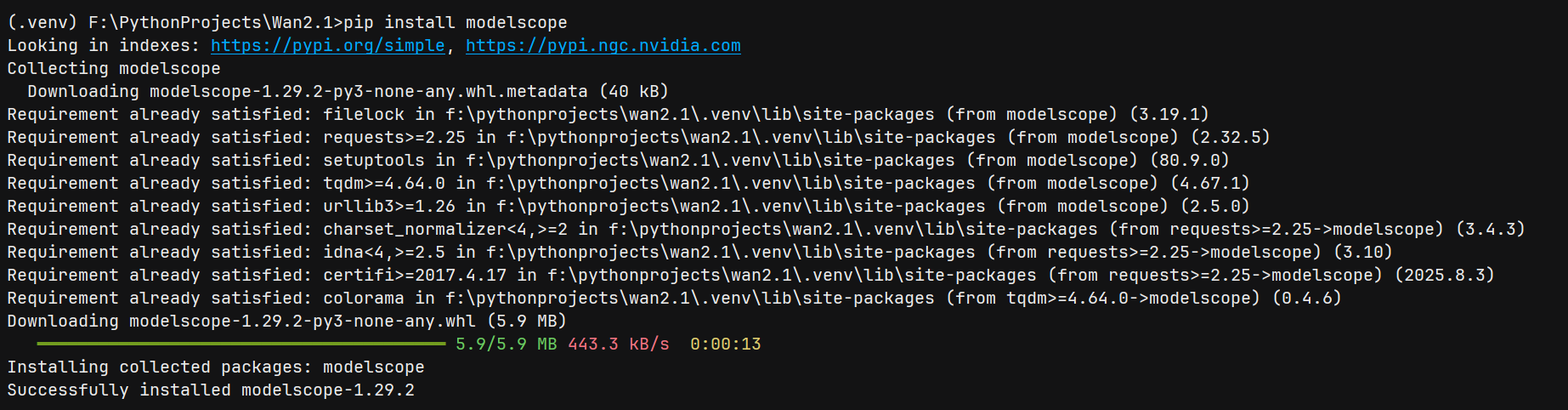

安装下载工具:

pip install "huggingface_hub[cli]" pip install hf_xet # 解决Xet Storage存储的性能优化依赖 pip install modelscope

说明:

hf_xet是用于优化 Xet Storage 存储的下载性能,若未安装会提示警告并降级为普通 HTTP 下载,建议安装以提升大文件下载速度。

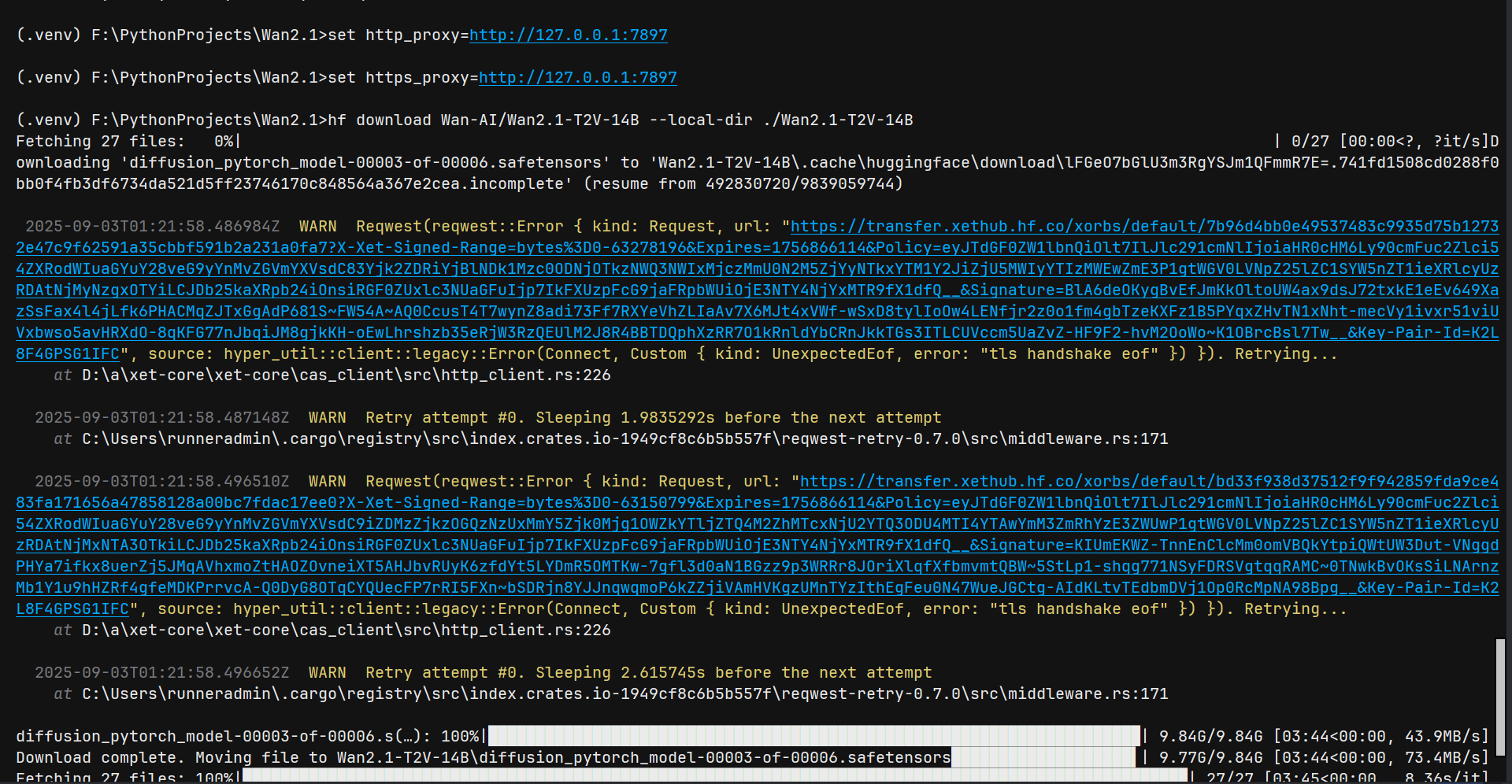

通过 Hugging Face 下载:

hf download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

注意:下载过程中可能会显示进度条和文件下载信息,属于正常现象。若遇到网络问题可中断后重新执行命令,支持断点续传。

-

或通过 ModelScope 下载:

modelscope download Wan-AI/Wan2.1-T2V-14B --local_dir ./Wan2.1-T2V-14B

八、运行测试

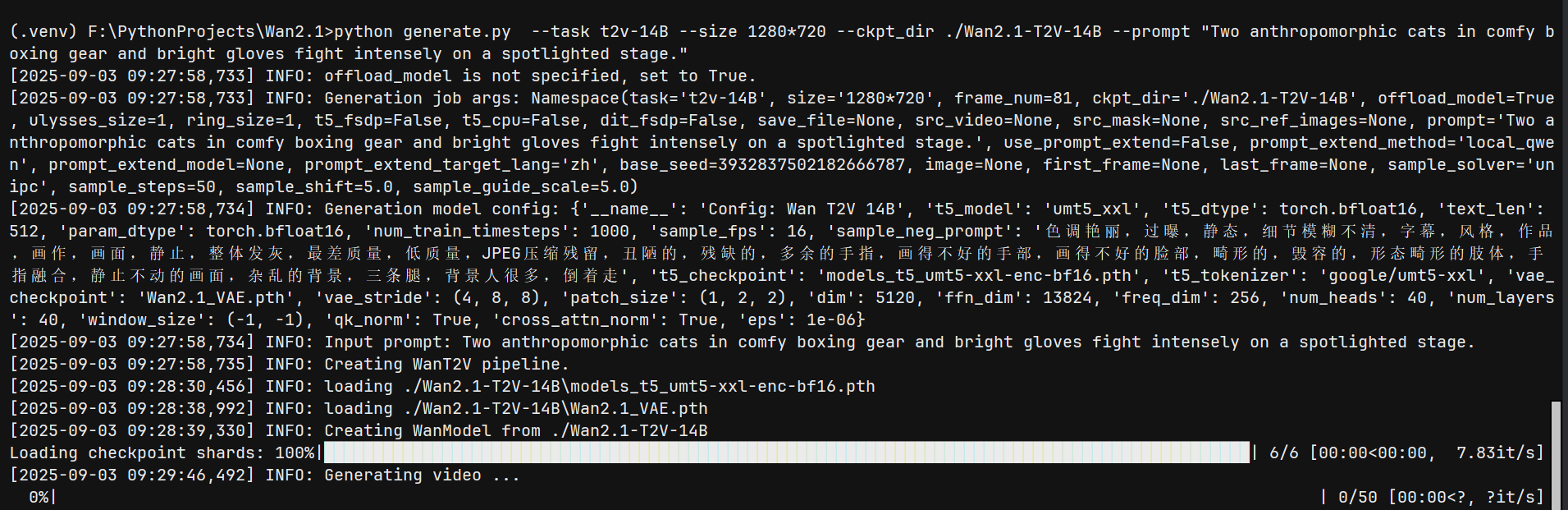

执行文本生成视频测试命令:

python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "Two anthropomorphic cats in comfy boxing gear and bright gloves fight intensely on a spotlighted stage."

注意:根据硬件配置不同,可能需要调整参数(如

--size选择更低分辨率、--offload_model True等)以确保运行流畅。对于 1.3B 模型,建议添加--sample_guide_scale 6参数。