✨作者主页 :IT毕设梦工厂✨

个人简介:曾从事计算机专业培训教学,擅长Java、Python、PHP、.NET、Node.js、GO、微信小程序、安卓Android等项目实战。接项目定制开发、代码讲解、答辩教学、文档编写、降重等。

文章目录

一、前言

系统介绍

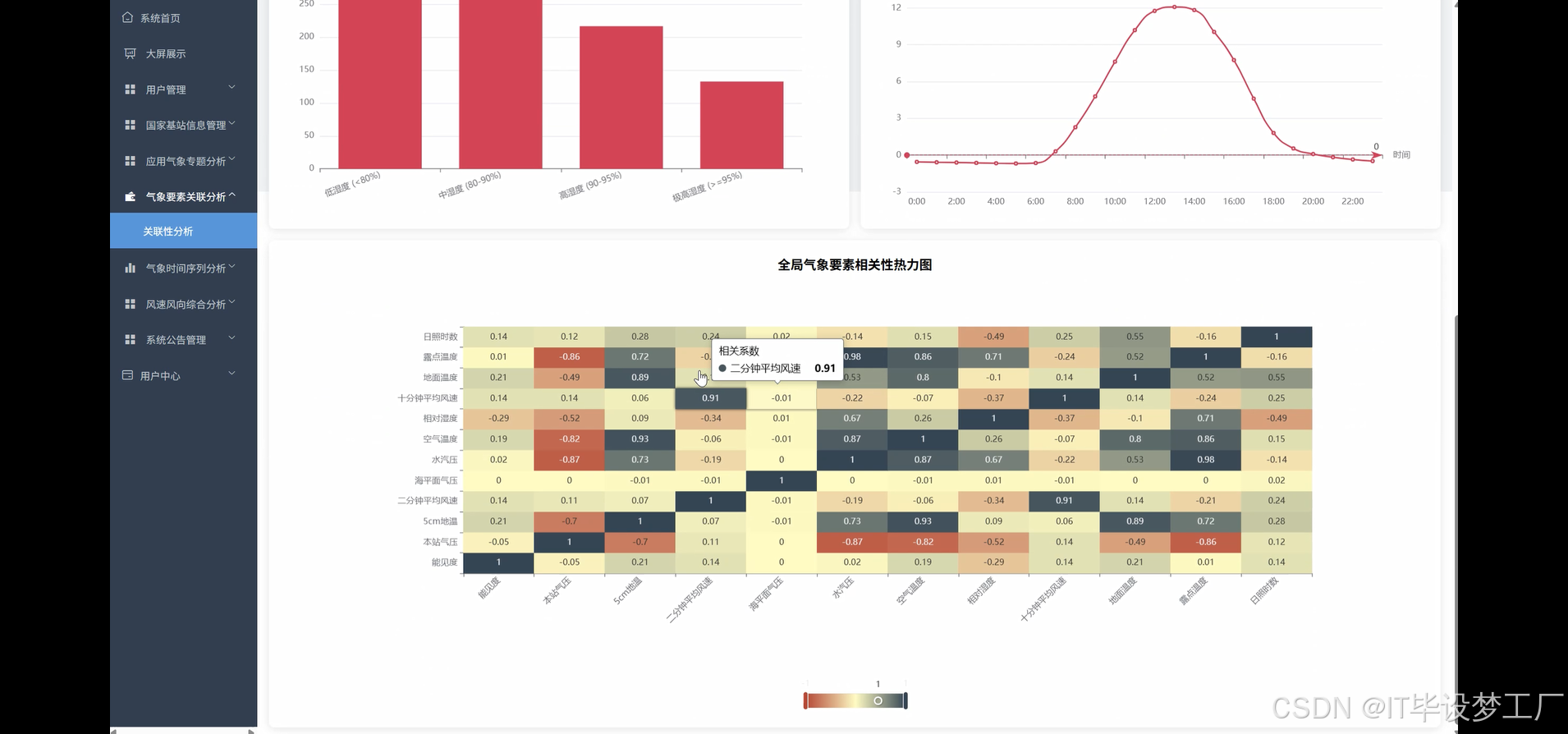

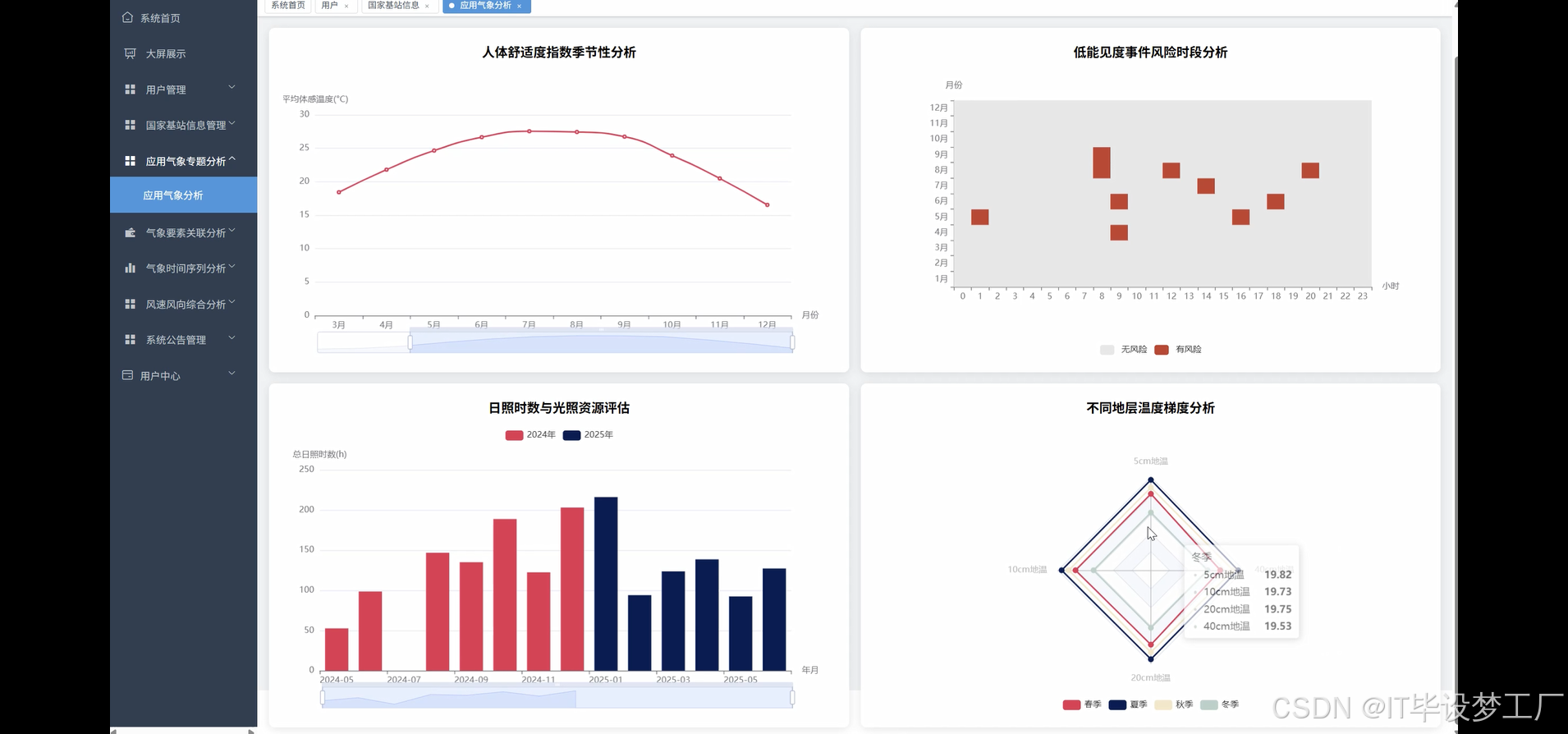

基于大数据的国家基站整点数据分析系统是一个集成了Hadoop、Spark等大数据技术的智能化气象数据处理平台。系统采用前后端分离的架构设计,后端基于Django/Spring Boot框架支持,配合MySQL数据库管理,前端运用Vue、ElementUI和ECharts技术栈构建交互式可视化界面。系统核心功能涵盖气象数据时间序列分析、关键要素关联性挖掘、风况时空分布特征分析以及应用气象专题分析四大维度。通过Spark SQL和Pandas、NumPy等数据处理工具,系统能够对国家基本气象站的整点观测数据进行深度挖掘和分析,实现年度气温变化趋势、季节性差异统计、日变化规律识别等多层次数据处理。系统支持Python/Java语言开发模式,借助HDFS分布式存储和Spark分布式计算框架,具备处理海量气象数据的能力,能够生成温湿相关性分析、风玫瑰图、人体舒适度指数等多维度可视化报表,为气象研究、农业生产、城市规划等领域提供数据支撑和决策参考。

选题背景

当前全球气候变化日益显著,极端天气事件频发,国家对气象数据的精准监测和深度分析需求愈发迫切。国家基本气象站作为气象观测网络的重要组成部分,每天产生大量的温度、湿度、气压、风向、风速等整点观测数据。这些海量数据蕴含着丰富的气象规律和变化趋势信息,但传统的数据处理方式往往局限于简单的统计分析,难以充分挖掘数据背后的深层价值。随着大数据技术的不断成熟,Hadoop、Spark等分布式计算框架为处理大规模气象数据提供了技术支撑。同时,现代气象业务对数据分析的实时性、准确性和可视化程度提出了更高要求,需要建立能够高效处理多维度气象要素、识别时空分布特征、挖掘要素间关联关系的智能化分析平台。在这种背景下,构建基于大数据技术的国家基站整点数据分析系统成为必然趋势。

选题意义

本课题的研究和实现具有一定的理论价值和实际应用价值。从技术角度来看,系统将大数据处理技术与气象数据分析相结合,探索了Hadoop、Spark等分布式计算框架在气象领域的应用模式,为类似数据密集型应用提供了技术参考。通过构建完整的数据处理流水线,包括数据采集、清洗、存储、计算和可视化各个环节,可以验证大数据技术栈在实际业务场景中的可行性和有效性。从应用层面来看,系统能够为气象部门、农业部门、城市规划部门等提供更加精准的数据分析结果。比如农业生产中可以根据温湿度关联分析和季节性变化规律来制定灌溉方案,城市规划中可以利用风向风速分布特征来优化建筑布局和绿化设计,交通运输部门可以基于能见度事件分析来改进预警机制。虽然作为毕业设计项目在规模和复杂度上存在局限性,但系统设计思路和实现方法对于推动气象数据的智能化分析和可视化展示仍然具有一定的参考意义。

二、开发环境

- 大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

- 开发语言:Python+Java(两个版本都支持)

- 后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

- 前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

- 详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

- 数据库:MySQL

三、系统界面展示

- 基于大数据的国家基站整点数据分析系统界面展示:

四、部分代码设计

- 项目实战-代码参考:

java(贴上部分代码)

from pyspark.sql import SparkSession

from pyspark.sql.functions import *

from pyspark.sql.types import *

import pandas as pd

import numpy as np

import json

from datetime import datetime

from django.http import JsonResponse

from django.views.decorators.csrf import csrf_exempt

spark = SparkSession.builder.appName("WeatherDataAnalysis").config("spark.sql.adaptive.enabled", "true").config("spark.sql.adaptive.coalescePartitions.enabled", "true").getOrCreate()

@csrf_exempt

def annual_temperature_trend_analysis(request):

df = spark.read.option("header", "true").option("inferSchema", "true").csv("hdfs://namenode:9000/weather_data/weather_data.csv")

df = df.withColumn("data_time", to_timestamp(col("data_time"), "yyyy-MM-dd HH:mm:ss"))

df = df.withColumn("year", year(col("data_time")))

df = df.filter(col("air_temperature").isNotNull())

yearly_avg_temp = df.groupBy("year").agg(avg("air_temperature").alias("avg_temperature"), max("air_temperature").alias("max_temperature"), min("air_temperature").alias("min_temperature"), count("air_temperature").alias("record_count"))

yearly_avg_temp = yearly_avg_temp.orderBy("year")

result_list = yearly_avg_temp.collect()

response_data = []

for row in result_list:

temp_change = 0

if len(response_data) > 0:

temp_change = round(row['avg_temperature'] - response_data[-1]['avg_temperature'], 2)

response_data.append({

'year': row['year'],

'avg_temperature': round(row['avg_temperature'], 2),

'max_temperature': round(row['max_temperature'], 2),

'min_temperature': round(row['min_temperature'], 2),

'record_count': row['record_count'],

'temp_change': temp_change

})

trend_coefficient = np.polyfit(range(len(response_data)), [item['avg_temperature'] for item in response_data], 1)[0]

trend_description = "升温趋势" if trend_coefficient > 0.1 else "降温趋势" if trend_coefficient < -0.1 else "基本稳定"

return JsonResponse({

'status': 'success',

'data': response_data,

'trend_coefficient': round(trend_coefficient, 4),

'trend_description': trend_description,

'analysis_time': datetime.now().strftime('%Y-%m-%d %H:%M:%S')

})

@csrf_exempt

def meteorological_correlation_analysis(request):

df = spark.read.option("header", "true").option("inferSchema", "true").csv("hdfs://namenode:9000/weather_data/weather_data.csv")

df = df.select("air_temperature", "relative_humidity", "station_pressure", "two_minute_avg_wind_speed", "visibility", "ground_temperature")

df = df.filter(col("air_temperature").isNotNull() & col("relative_humidity").isNotNull() & col("station_pressure").isNotNull() & col("two_minute_avg_wind_speed").isNotNull() & col("visibility").isNotNull() & col("ground_temperature").isNotNull())

pandas_df = df.toPandas()

correlation_matrix = pandas_df.corr()

correlation_data = []

columns = correlation_matrix.columns.tolist()

for i, row_name in enumerate(columns):

row_data = []

for j, col_name in enumerate(columns):

correlation_value = correlation_matrix.iloc[i, j]

correlation_strength = "强正相关" if correlation_value > 0.7 else "中等正相关" if correlation_value > 0.3 else "弱正相关" if correlation_value > 0.1 else "强负相关" if correlation_value < -0.7 else "中等负相关" if correlation_value < -0.3 else "弱负相关" if correlation_value < -0.1 else "无明显相关"

row_data.append({

'row': row_name,

'col': col_name,

'value': round(correlation_value, 3),

'strength': correlation_strength

})

correlation_data.append(row_data)

temperature_humidity_corr = correlation_matrix.loc['air_temperature', 'relative_humidity']

pressure_wind_corr = correlation_matrix.loc['station_pressure', 'two_minute_avg_wind_speed']

visibility_humidity_corr = correlation_matrix.loc['visibility', 'relative_humidity']

ground_air_temp_corr = correlation_matrix.loc['ground_temperature', 'air_temperature']

key_insights = {

'temp_humidity': {'correlation': round(temperature_humidity_corr, 3), 'interpretation': '温度与湿度呈负相关关系,符合气象学规律' if temperature_humidity_corr < -0.3 else '温湿关系不明显'},

'pressure_wind': {'correlation': round(pressure_wind_corr, 3), 'interpretation': '低压系统通常伴随较大风速' if pressure_wind_corr < -0.2 else '气压风速关系较弱'},

'visibility_humidity': {'correlation': round(visibility_humidity_corr, 3), 'interpretation': '高湿度环境下能见度明显降低' if visibility_humidity_corr < -0.4 else '湿度对能见度影响有限'},

'ground_air_temp': {'correlation': round(ground_air_temp_corr, 3), 'interpretation': '地表温度与气温高度一致' if ground_air_temp_corr > 0.8 else '地气温差存在波动'}

}

return JsonResponse({

'status': 'success',

'correlation_matrix': correlation_data,

'key_insights': key_insights,

'sample_size': len(pandas_df),

'analysis_time': datetime.now().strftime('%Y-%m-%d %H:%M:%S')

})

@csrf_exempt

def wind_rose_analysis(request):

df = spark.read.option("header", "true").option("inferSchema", "true").csv("hdfs://namenode:9000/weather_data/weather_data.csv")

df = df.withColumn("data_time", to_timestamp(col("data_time"), "yyyy-MM-dd HH:mm:ss"))

df = df.filter(col("ten_minute_avg_wind_direction_degree").isNotNull() & col("ten_minute_avg_wind_speed").isNotNull())

df = df.withColumn("wind_direction_sector", when(col("ten_minute_avg_wind_direction_degree") >= 0, floor((col("ten_minute_avg_wind_direction_degree") + 22.5) / 45) % 8).otherwise(7))

df = df.withColumn("wind_speed_level", when(col("ten_minute_avg_wind_speed") < 2, "轻风").when(col("ten_minute_avg_wind_speed") < 6, "微风").when(col("ten_minute_avg_wind_speed") < 12, "和风").when(col("ten_minute_avg_wind_speed") < 20, "清劲风").otherwise("强风"))

direction_names = ["北", "东北", "东", "东南", "南", "西南", "西", "西北"]

wind_stats = df.groupBy("wind_direction_sector", "wind_speed_level").agg(count("*").alias("frequency"), avg("ten_minute_avg_wind_speed").alias("avg_speed"))

wind_direction_summary = df.groupBy("wind_direction_sector").agg(count("*").alias("total_frequency"), avg("ten_minute_avg_wind_speed").alias("direction_avg_speed"))

total_records = df.count()

wind_rose_data = []

direction_stats = wind_direction_summary.collect()

speed_level_stats = wind_stats.collect()

for direction_row in direction_stats:

direction_index = int(direction_row['wind_direction_sector'])

direction_name = direction_names[direction_index] if direction_index < len(direction_names) else "未知"

frequency_percentage = round((direction_row['total_frequency'] / total_records) * 100, 2)

speed_distribution = {}

for speed_row in speed_level_stats:

if int(speed_row['wind_direction_sector']) == direction_index:

speed_level = speed_row['wind_speed_level']

speed_frequency = speed_row['frequency']

speed_percentage = round((speed_frequency / direction_row['total_frequency']) * 100, 2)

speed_distribution[speed_level] = {

'frequency': speed_frequency,

'percentage': speed_percentage,

'avg_speed': round(speed_row['avg_speed'], 2)

}

wind_rose_data.append({

'direction': direction_name,

'direction_degree': direction_index * 45,

'frequency': direction_row['total_frequency'],

'frequency_percentage': frequency_percentage,

'avg_speed': round(direction_row['direction_avg_speed'], 2),

'speed_distribution': speed_distribution

})

dominant_direction = max(wind_rose_data, key=lambda x: x['frequency_percentage'])

calm_condition_count = df.filter(col("ten_minute_avg_wind_speed") < 1).count()

calm_percentage = round((calm_condition_count / total_records) * 100, 2)

return JsonResponse({

'status': 'success',

'wind_rose_data': wind_rose_data,

'dominant_direction': dominant_direction,

'calm_percentage': calm_percentage,

'total_records': total_records,

'analysis_time': datetime.now().strftime('%Y-%m-%d %H:%M:%S')

})五、系统视频

- 基于大数据的国家基站整点数据分析系统-项目视频:

大数据毕业设计选题推荐-基于大数据的国家基站整点数据分析系统-Hadoop-Spark-数据可视化-BigData

结语

大数据毕业设计选题推荐-基于大数据的国家基站整点数据分析系统-Hadoop-Spark-数据可视化-BigData

想看其他类型的计算机毕业设计作品也可以和我说~谢谢大家!

有技术这一块问题大家可以评论区交流或者私我~

大家可以帮忙点赞、收藏、关注、评论啦~

源码获取:⬇⬇⬇