1. 核心架构与抽象

Spring AI 的核心是提供一套统一的 API 来与各种 AI 模型和服务交互,其关键抽象是 ChatClient 和 PromptCallback 等。对于 MCP,它需要解决两个问题:

发现(Discovery):如何连接到 MCP 服务器并获取其提供的所有工具(tools)和资源(resources)列表。

适配(Adaptation):如何将这些远程的工具和资源转换成 Spring AI 能够理解和调用的格式,特别是如何将它们作为 FunctionCallback 集成到 AI 对话中。

SpringAiMcpClient 库完美地扮演了这个适配器的角色。

2. 实现原理与关键步骤

整个过程可以分解为以下几个关键步骤:

步骤一:建立连接与传输层

Spring AI MCP 客户端使用 SSE(Server-Sent Events) 或 Stdio 作为传输层与 MCP 服务器通信。你需要在配置中指定 MCP 服务器的地址(对于 SSE)或启动命令(对于 Stdio)。

application.yml

c

spring:

ai:

mcp:

clients:

my-mcp-server: # 自定义客户端实例名

type: sse

url: http://localhost:8000/sse

# 或者使用 stdio

# type: stdio

# command: "npx -y @modelcontextprotocol/server-example"步骤二:初始化与服务器握手

应用启动时,SpringAiMcpClient 会自动执行 MCP 协议规定的初始化流程:

与服务器建立连接。

发送 initialize 请求,交换客户端和服务器的能力信息。

服务器回复 initialized 通知。

客户端发送 tools/list 请求,获取服务器提供的所有工具(函数)的列表及其 JSON Schema 定义。

客户端发送 resources/list 请求,获取服务器提供的所有资源的列表。

步骤三:动态注册为 Function Callback

这是最核心的一步。Spring AI 获取到工具列表后,会为每一个 MCP 工具动态地创建一个 FunctionCallback 实例。

函数定义(Function Definition):使用从服务器获取的 JSON Schema 来构建 Function 对象,包含了函数名、描述和参数schema。

函数执行(Function Execution):当 LLM 决定调用某个函数时,Spring AI 会找到对应的 FunctionCallback。这个回调函数内部会通过 MCP 协议向服务器发送 tools/call 请求,并将 LLM 生成的参数传递过去。

结果返回:MCP 服务器执行工具,返回结果。Spring AI 将该结果返回给 LLM,让 LLM 基于结果生成最终的回复给用户。

步骤四:集成到 AI 对话中

这些动态生成的 FunctionCallback 会被聚合到一个 FunctionCallbackRegistry 中。当你使用 ChatClient 并开启函数调用功能时,这些 MCP 工具就会自动成为可用的选项。

c

@Bean

public ChatClient chatClient(ChatModel chatModel, List<FunctionCallback> toolFunctionCallbacks) {

// 所有 MCP 工具生成的 FunctionCallback 都会被自动注入到这里

return ChatClient.builder(chatModel)

// .defaultFunctions() // 也可以选择默认启用所有函数

.build();

}现在,当你发起一个对话时,如果用户的提问涉及到 MCP 工具(例如:"查看下本地的天气"),LLM 就会自主选择调用相应的 MCP 工具函数,完成服务调用。

3. 代码示例:调用多个服务

假设你的 MCP 服务器提供了两个工具:get_weather(获取天气)和 search_files(搜索文件)。

1. 配置 (application.yml)

c

yaml

spring:

ai:

mcp:

clients:

weather-server:

type: sse

url: http://localhost:8000/sse

file-server:

type: stdio

command: "node /path/to/my-file-server.js"

chat:

model: openai:gpt-4o-mini2. Java 代码使用

你不需要为每个工具手动编写代码。Spring AI 会自动完成所有繁重的工作。

c

@RestController

public class McpController {

private final ChatClient chatClient;

public McpController(ChatClient chatClient) {

this.chatClient = chatClient;

}

@GetMapping("/ask")

public String ask(@RequestParam String question) {

// 用户的问题可能同时涉及天气和文件搜索

// LLM 会自动决定是否需要调用函数,以及调用哪一个或哪几个

Prompt prompt = new Prompt(new UserMessage(question));

ChatResponse response = chatClient.call(prompt);

return response.getResult().getOutput().getContent();

}

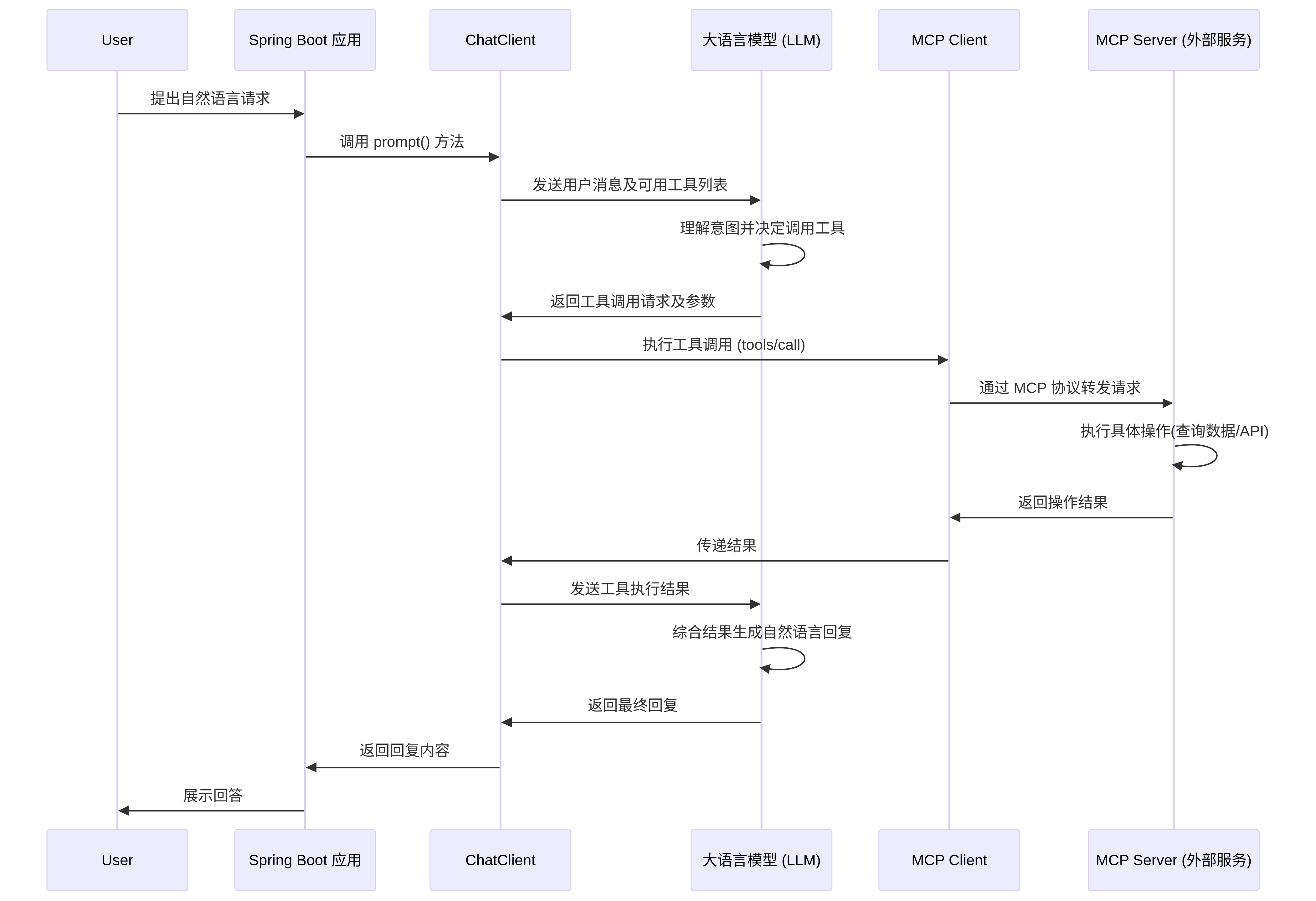

}交互流程示例:

用户输入: "我旧金山今天的天气怎么样?然后再帮我找个文件名包含'季度报告'的文档。"

LLM 推理: 这个问题需要两个步骤:先查天气,再搜文件。

Action 1: LLM 决定调用 get_weather 函数,参数 {"location": "San Francisco"}。

Spring AI 通过 MCP 调用天气服务器的工具。

天气服务器返回 JSON 格式的天气数据。

Action 2: LLM 收到天气结果后,决定调用 search_files 函数,参数 {"query": "季度报告"}。

Spring AI 通过 MCP 调用文件服务器的工具。

文件服务器返回文件列表。

最终回复: LLM 综合天气结果和文件列表,生成一段连贯的自然语言回复给用户:"旧金山今天晴,气温22度。我找到了3个包含'季度报告'的文件:..."

总结

Spring AI 实现 MCP 多服务调用的方式可以概括为:

协议层:基于 MCP 协议(SSE/Stdio)与一个或多个服务器通信。

适配层:在启动时自动发现所有远程工具和资源。

抽象层:将每个远程工具动态封装成一个 Spring AI FunctionCallback。

执行层:在 AI 对话过程中,由 LLM 驱动,通过对应的 FunctionCallback 透明地执行 MCP 函数调用,并将结果返回给 LLM。

多服务:通过配置多个客户端实例,轻松集成多个不同的 MCP 服务器,所有这些服务器的工具都会统一注册到 Spring AI 的上下文中,供 LLM 选择使用。

这种方式极大地简化了集成工作,开发者只需关注配置和业务逻辑,无需编写大量的胶水代码,真正实现了"开箱即用"的多工具AI应用开发。