文章标题

- [一、 FLUX.1-dev、FLUX.1-schnell、FLUX.1-Krea-dev啥啥分不清楚?](#一、 FLUX.1-dev、FLUX.1-schnell、FLUX.1-Krea-dev啥啥分不清楚?)

-

- 1.技术架构与核心优化

-

- [1.1 FLUX.1-dev](#1.1 FLUX.1-dev)

- [1.2 FLUX.1-schnell](#1.2 FLUX.1-schnell)

- [1.3 FLUX.1-Krea-dev](#1.3 FLUX.1-Krea-dev)

- 2.性能对比与核心指标

- 3.适用场景建议

- 4.许可与使用限制

- 5.总结

- [二、Flux.1 Krea Dev](#二、Flux.1 Krea Dev)

-

- [1.Flux.1 Krea Dev ComfyUI 工作流](#1.Flux.1 Krea Dev ComfyUI 工作流)

-

- [1.1 工作流文件](#1.1 工作流文件)

- [1.2 模型链接](#1.2 模型链接)

- [1.3 按步骤检查确保工作流可以正常运行](#1.3 按步骤检查确保工作流可以正常运行)

- [三、Flux.1 Dev & Schnell](#三、Flux.1 Dev & Schnell)

-

- [1.Flux.1 Dev 完整版本工作流](#1.Flux.1 Dev 完整版本工作流)

-

- [1.1 工作流文件](#1.1 工作流文件)

- [1.2 手动安装模型](#1.2 手动安装模型)

- [1.3 按步骤检查确保工作流可以正常运行](#1.3 按步骤检查确保工作流可以正常运行)

- [2.Flux.1 Schnell 完整版本工作流](#2.Flux.1 Schnell 完整版本工作流)

-

- [2.1 工作流文件](#2.1 工作流文件)

- [2.2 手动安装模型](#2.2 手动安装模型)

- [2.3 按步骤检查确保工作流可以正常运行](#2.3 按步骤检查确保工作流可以正常运行)

- [3.Fp8 Checkpoint 版文生图示例](#3.Fp8 Checkpoint 版文生图示例)

-

- [3.1 Flux.1 Dev fp8 Checkpoint 版工作流](#3.1 Flux.1 Dev fp8 Checkpoint 版工作流)

- [3.2 Flux.1 Schnell fp8 Checkpoint 版工作流](#3.2 Flux.1 Schnell fp8 Checkpoint 版工作流)

一、 FLUX.1-dev、FLUX.1-schnell、FLUX.1-Krea-dev啥啥分不清楚?

Black Forest Labs 开发的 FLUX.1 系列模型(FLUX.1-dev、FLUX.1-schnell、FLUX.1-Krea-dev)是针对不同场景优化的文本到图像生成模型,核心区别体现在技术架构、性能侧重点、适用场景 和许可协议上。以下是具体分析:

1.技术架构与核心优化

1.1 FLUX.1-dev

- 技术基础 :基于闭源旗舰版 FLUX.1-pro 进行指引蒸馏(Guidance Distillation),保留了接近 Pro 版的提示词跟随能力和图像质量,但推理效率更高。

- 架构特点 :

- 采用混合架构 (多模态 + 并行扩散 Transformer),参数量达 120 亿,远超主流模型(如 SD3 的 20 亿)。

- 支持复杂提示解析(如多物体空间定位、文本渲染),尤其擅长人体解剖学细节和高分辨率输出(最大 2MP)。

- 适用场景 :

- 开发者研究、学术实验或需要高精度的商业原型开发(需注意 不可商用 限制)。

- 复杂构图、专业设计或对提示词遵从性要求极高的场景。

1.2 FLUX.1-schnell

- 技术基础 :在 FLUX.1-dev 基础上进一步优化,通过**双重蒸馏(指引蒸馏 + 时间步蒸馏)**将生成步骤压缩至 1-4 步,大幅提升速度。

- 架构特点 :

- 精简参数规模,牺牲部分 Classifier-Free Guidance(CFG)强度,以换取速度优势。

- 优化内存占用,可在资源有限的环境(如消费级 GPU)中运行。

- 适用场景 :

- 实时交互应用(如在线生成工具)、快速原型开发或需要频繁迭代的场景。

- 个人开发者或小型团队的商用项目(可商用,遵循 Apache 2.0 协议)。

1.3 FLUX.1-Krea-dev

- 技术基础 :与创意平台 Krea 合作开发的定制版本,针对美学风格 和资源效率进行专项优化。

- 架构特点 :

- 采用 DFloat11 压缩技术 ,模型体积减少 32%,支持在 24GB GPU 甚至 12GB GPU(带 CPU 卸载) 上运行,同时保持与 FLUX.1-dev 的位级一致性。

- 强化自然细节渲染(如避免过曝高光、增强皮肤纹理),生成结果更贴近真实摄影风格。

- 适用场景 :

- 艺术创作、广告设计或需要独特美学输出的项目。

- 资源受限但追求高质量的场景(如移动端或边缘设备部署)。

2.性能对比与核心指标

| 维度 | FLUX.1-dev | FLUX.1-schnell | FLUX.1-Krea-dev |

|---|---|---|---|

| 推理速度 | 中速(需完整生成步骤) | 极快(1-4 步) | 中等(压缩后效率提升) |

| 最大分辨率 | 2MP | 1MP | 2MP(受限于资源时可调低) |

| 提示词遵从性 | 92%(接近 Pro 版) | 85%(牺牲部分 CFG) | 90%(平衡美学与准确性) |

| 内存占用 | 高(需 24GB+ GPU) | 低(可在 12GB GPU 运行) | 低(DFloat11 压缩) |

| 商用许可 | 不可商用 | 可商用(Apache 2.0) | 可商用(需遵循特定协议) |

| 典型输出风格 | 高精度、细节丰富 | 快速、轻量化 | 自然真实、艺术化 |

3.适用场景建议

-

选择 FLUX.1-dev:

- 你需要 学术研究 或 复杂提示处理(如多物体空间布局、精细文本渲染)。

- 愿意为质量牺牲部分速度,且不涉及商用。

-

选择 FLUX.1-schnell:

- 你需要 快速生成 (如实时预览、A/B 测试)或 资源受限环境(如消费级硬件)。

- 项目需 商用,且对图像细节要求不极致。

-

选择 FLUX.1-Krea-dev:

- 你需要 独特美学风格 (如艺术创作、品牌设计)或 资源优化部署(如移动端)。

- 与 Krea 生态(如 ComfyUI 工作流)集成,或追求自然真实感的输出。

4.许可与使用限制

- FLUX.1-dev :开源但 不可商用,仅限非商业用途(如学术、个人项目)。

- FLUX.1-schnell :开源且 可商用,遵循 Apache 2.0 协议,适合商业产品。

- FLUX.1-Krea-dev :采用 flux-1-dev-non-commercial-license,商用需额外授权,具体限制需参考官方文档。

5.总结

- FLUX.1-dev 是开发者友好的高质量研究工具,适合探索前沿技术但无需商用的场景。

- FLUX.1-schnell 是速度与商用平衡的利器,适合快速迭代和资源有限的项目。

- FLUX.1-Krea-dev 是美学与效率的结合体,适合创意行业和特定生态集成。

建议根据具体需求(质量、速度、资源、商用)选择模型,并参考官方文档(如 Black Forest Labs GitHub)获取最新更新和部署指南。

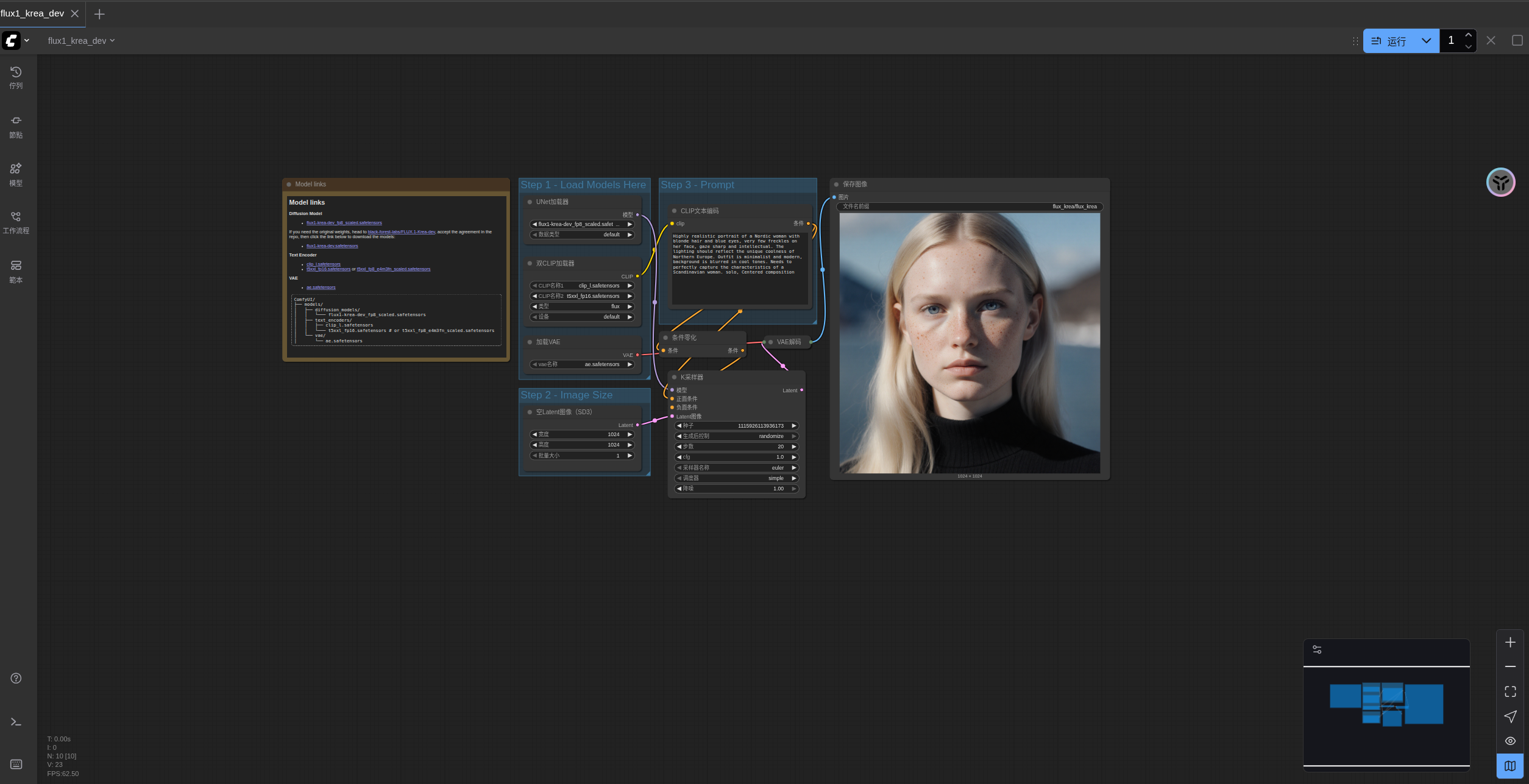

二、Flux.1 Krea Dev

Black Forest Labs 与 Krea 合作开发的最佳开源 FLUX 模型,专注于独特美学风格和自然细节,避免 AI 感,提供卓越的真实感和图像质量。

Flux.1 Krea Dev 是由 Black Forest Labs (BFL) 与 Krea 合作开发的先进文本生成图像模型。这是目前最好的开源权重 FLUX 模型,专为文本到图像生成而设计。

模型特点

- 独特美学风格: 专注于生成具有独特美学的图像,避免常见的"AI感"外观

- 自然细节: 不会产生过曝的高光,保持自然的细节表现

- 卓越的真实感: 提供出色的真实感和图像质量

- 完全兼容架构: 与 FLUX.1 [dev] 完全兼容的架构设计

模型许可

该模型采用 flux-1-dev-non-commercial-license 许可发布

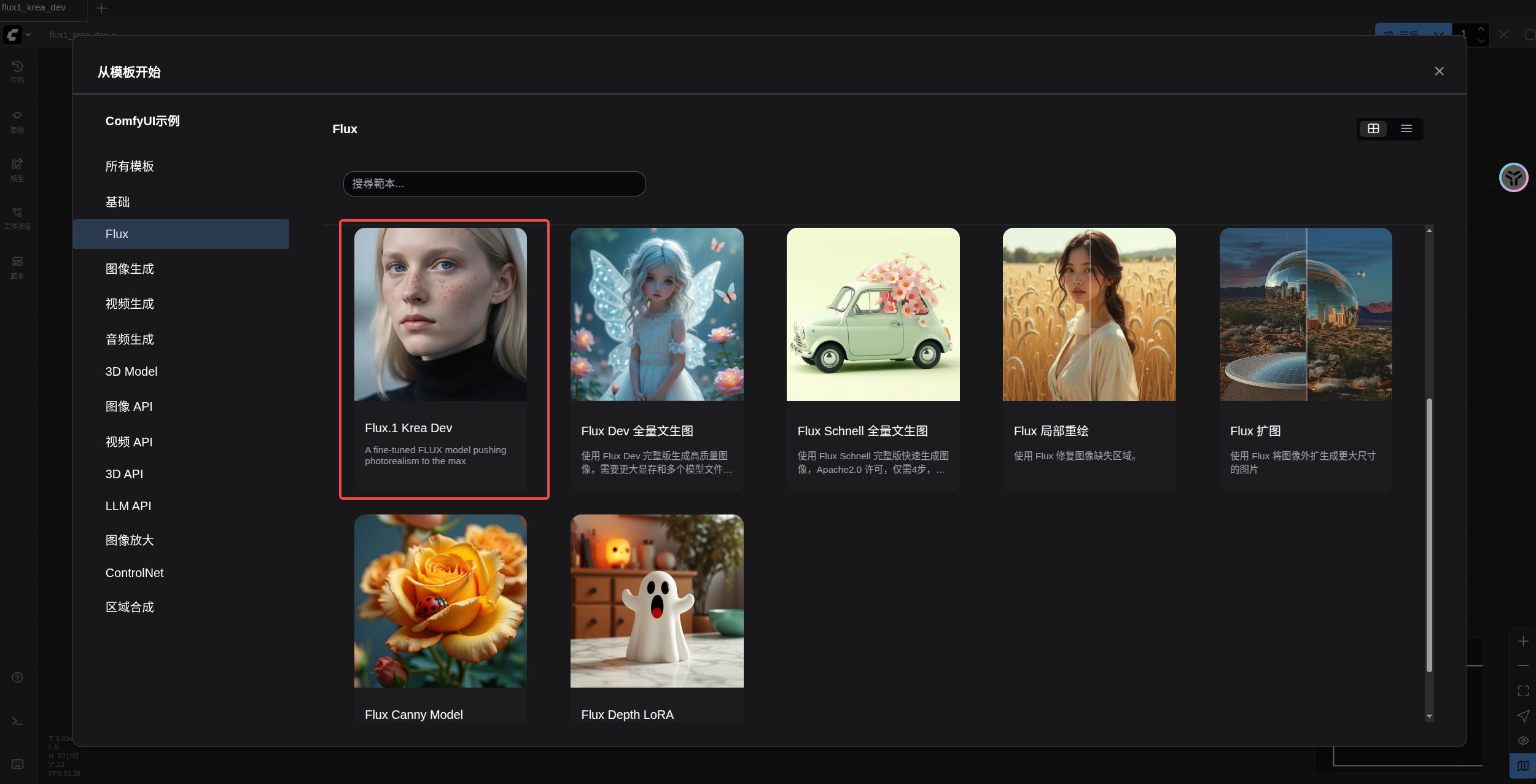

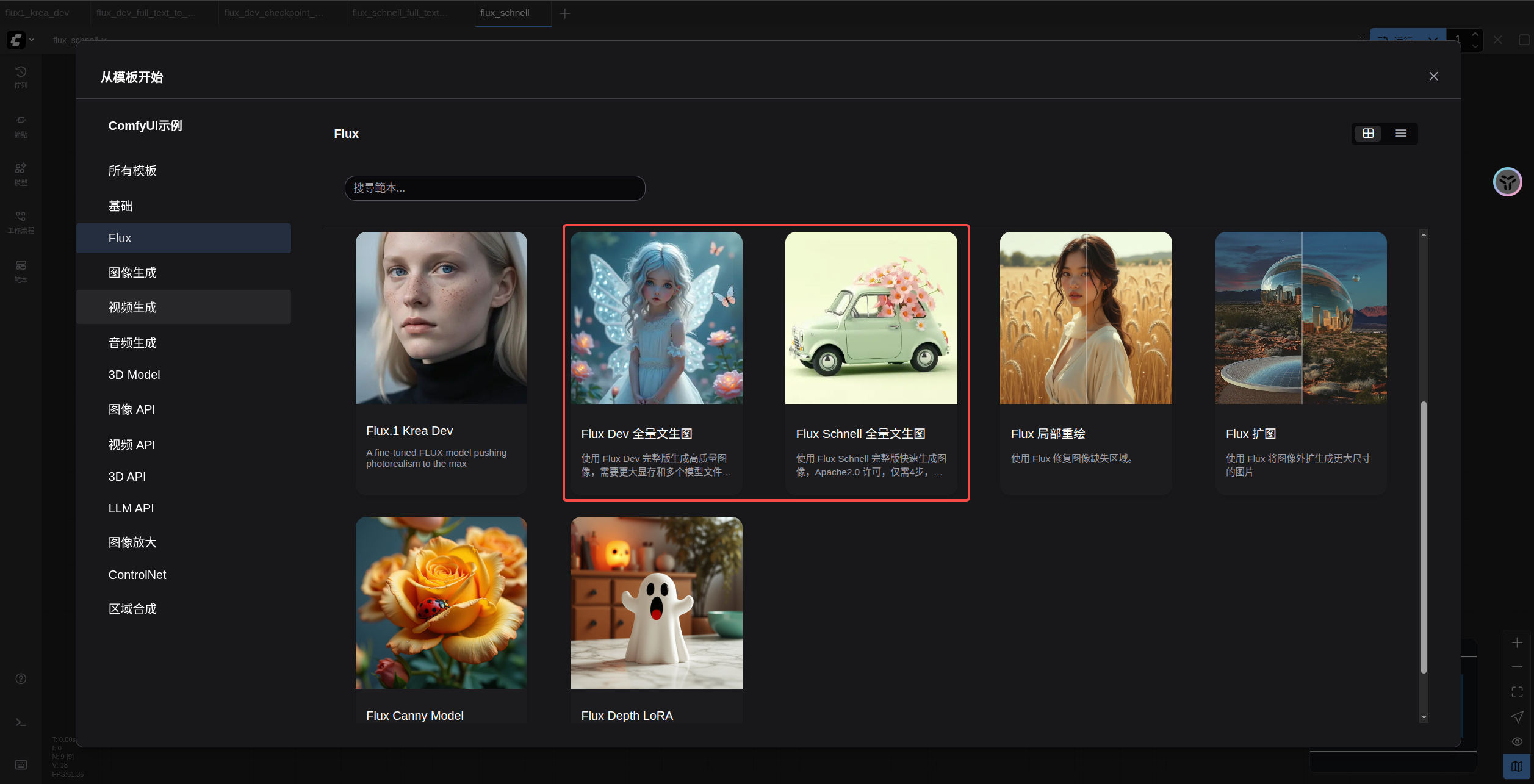

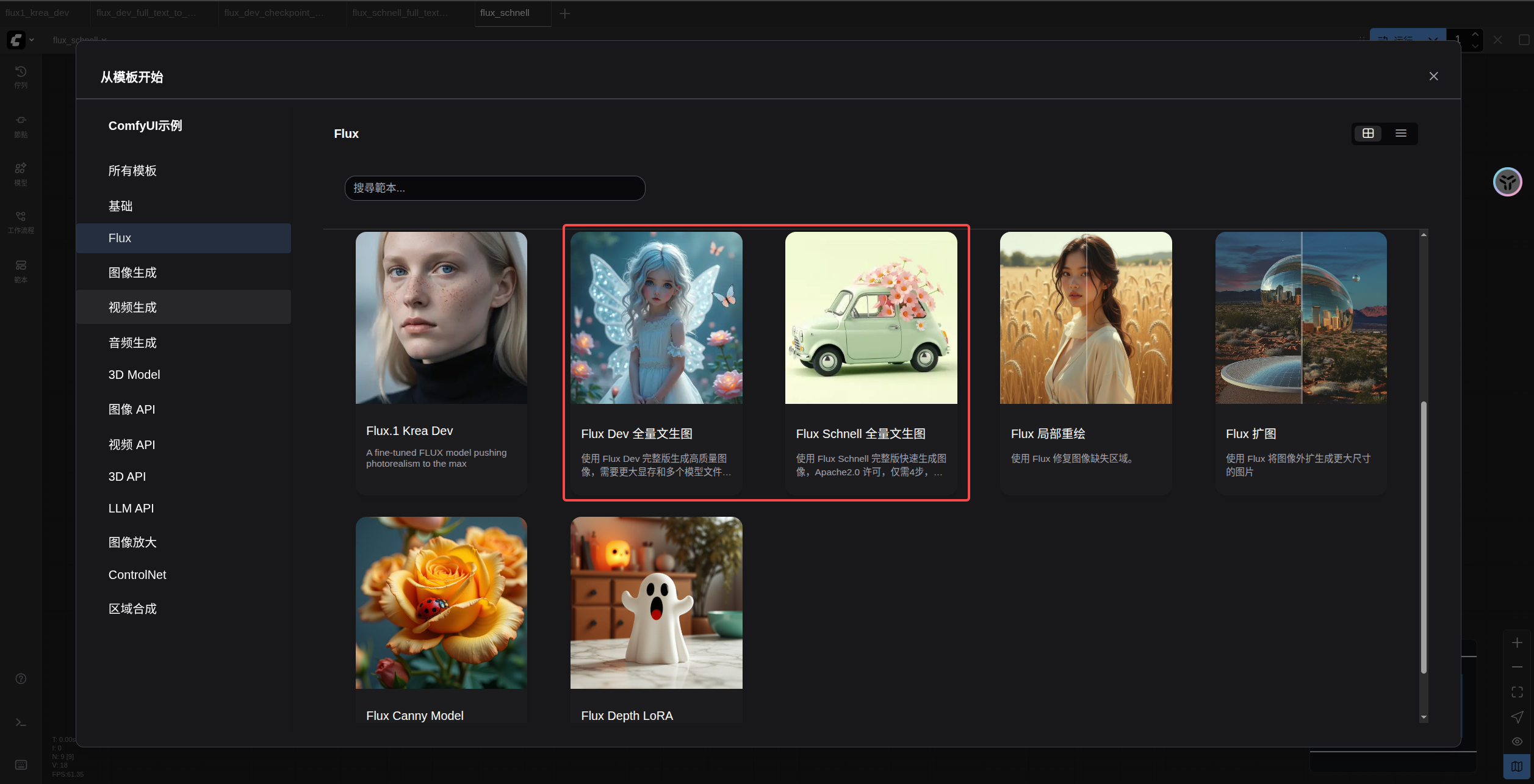

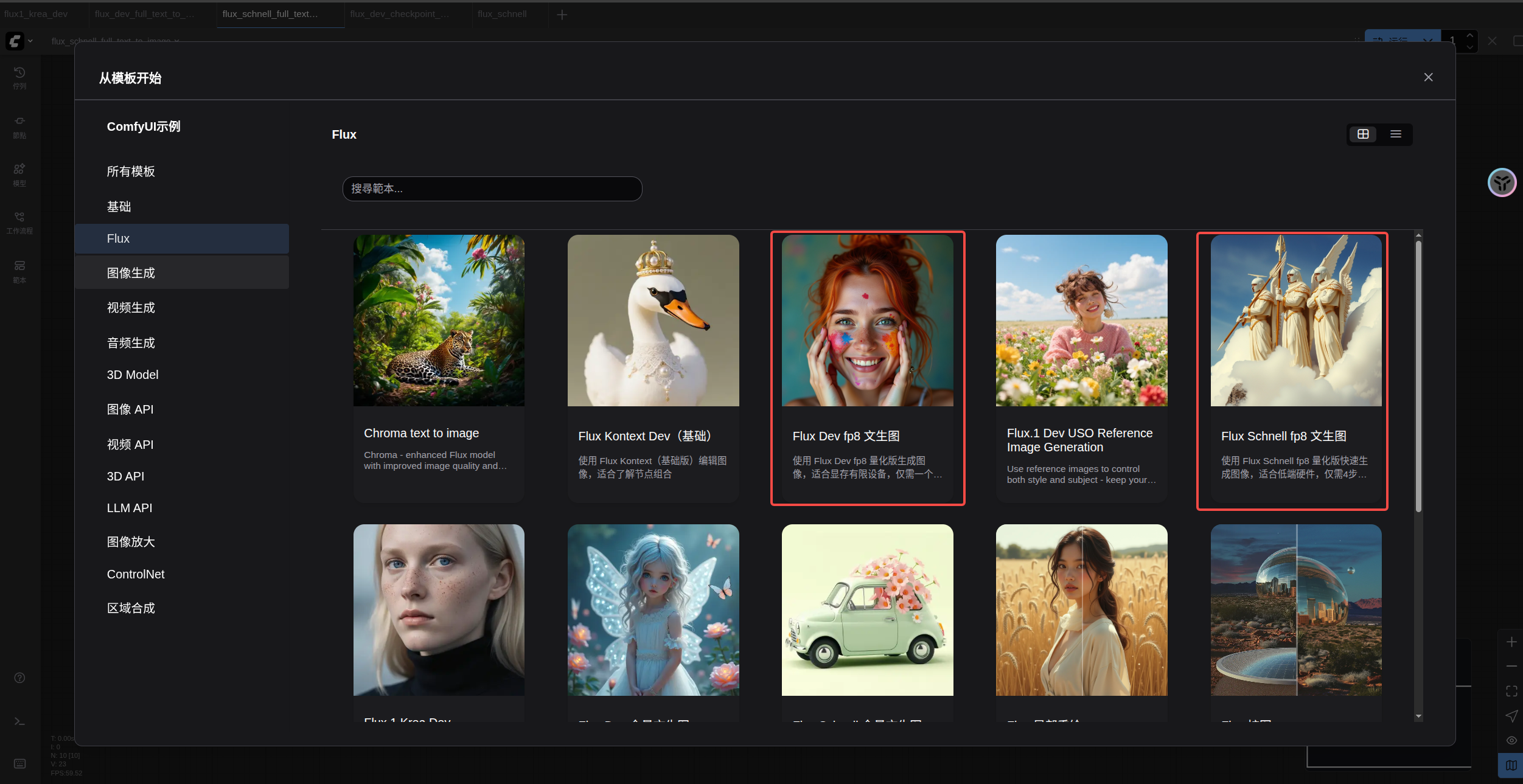

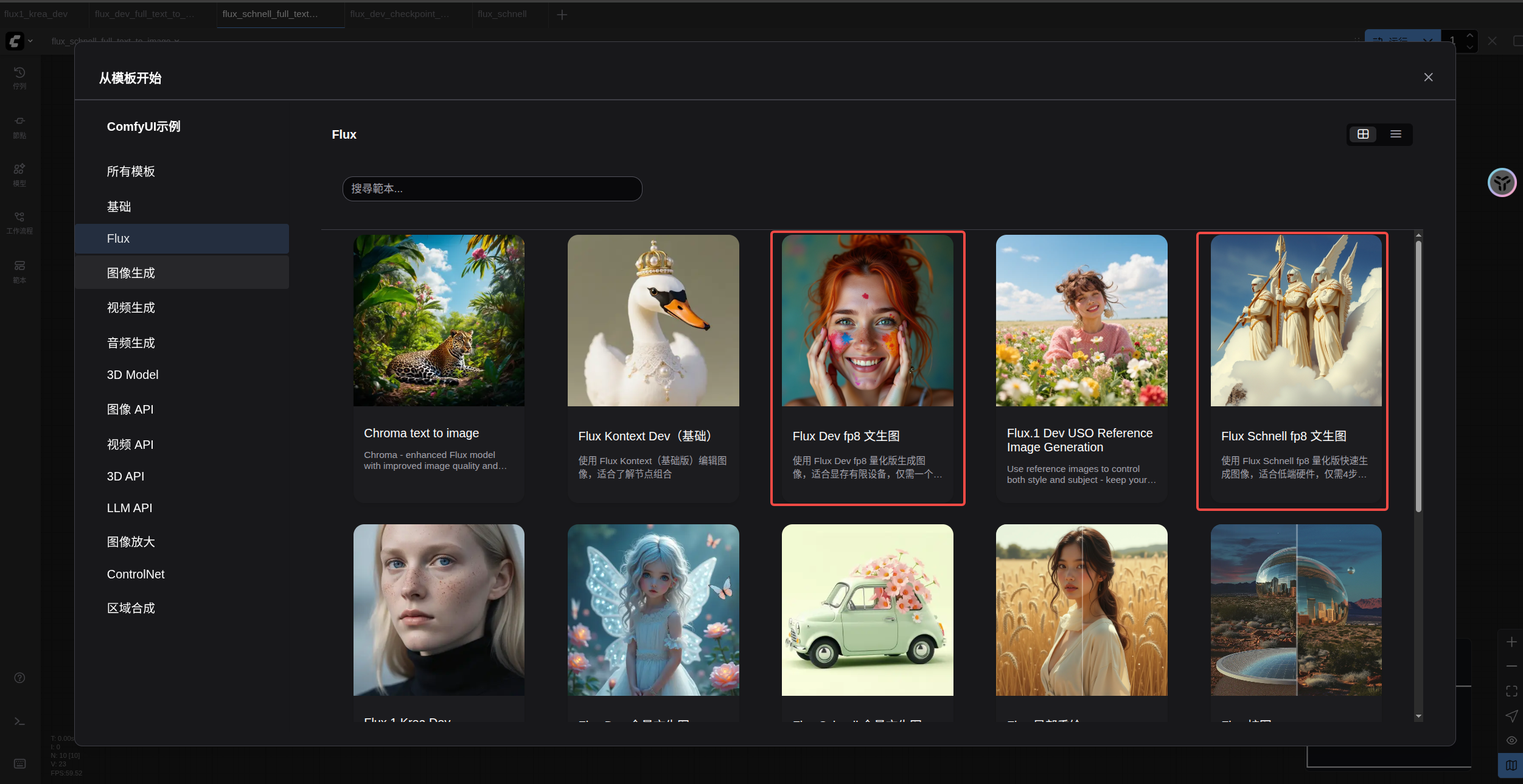

1.Flux.1 Krea Dev ComfyUI 工作流

请确保你的 ComfyUI 已经更新。

本指南里的工作流可以在 ComfyUI 的工作流模板中找到。如果找不到,可能是 ComfyUI 没有更新。

如果加载工作流时有节点缺失,可能原因有:

- 你用的不是最新开发版(nightly)。

- 你用的是稳定版或桌面版(没有包含最新的更新)。

- 启动时有些节点导入失败。

1.1 工作流文件

下载下面的图片或JSON,并拖入 ComfyUI 以加载对应工作流

1.2 模型链接

Diffusion model 下面两个模型选择其中一个版本即可

下面这个版本是原始权重,如果你追求更高质量有足够的显存,可以尝试这个版本

- `flux1-dev.safetensors` 文件需要同意 [black-forest-labs/FLUX.1-Krea-dev](https://huggingface.co/black-forest-labs/FLUX.1-Krea-dev/) 的协议后才能使用浏览器进行下载。

如果你使用过 Flux 相关的工作流,下面的模型是相同的,不需要重复下载

Text encoders

- clip_l.safetensors

- t5xxl_fp16.safetensors 当你的显存大于 32GB 时推荐使用。

- t5xxl_fp8_e4m3fn.safetensors For Low VRAM

VAE

安装aria2快速下载模型,几乎能将我家1000M的宽带跑满,每秒80~90M,接下来的介绍模型都会给出安装命令。

bash

apt install aria2

bash

aria2c https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/clip_l.safetensors -o SourceCode/ComfyUI/models/text_encoders/clip_l.safetensors auto-file-renaming=false --allow-overwrite=false

aria2c https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/t5xxl_fp16.safetensors -o SourceCode/ComfyUI/models/text_encoders/t5xxl_fp16.safetensors auto-file-renaming=false --allow-overwrite=false

aria2c https://huggingface.co/Comfy-Org/Lumina_Image_2.0_Repackaged/resolve/main/split_files/vae/ae.safetensors -o SourceCode/ComfyUI/models/vae/ae.safetensors auto-file-renaming=false --allow-overwrite=false

aria2c https://huggingface.co/Comfy-Org/FLUX.1-Krea-dev_ComfyUI/resolve/main/split_files/diffusion_models/flux1-krea-dev_fp8_scaled.safetensors -o SourceCode/ComfyUI/models/diffusion_models/flux1-krea-dev_fp8_scaled.safetensors auto-file-renaming=false --allow-overwrite=false小技巧:你要是打不开https://huggingface.co,可以将其换成为https://hf-mirror.com/试一试

文件保存位置:

ComfyUI/

├── models/

│ ├── diffusion_models/

│ │ └── flux1-krea-dev_fp8_scaled.safetensors 或 flux1-krea-dev.safetensors

│ ├── text_encoders/

│ │ ├── clip_l.safetensors

│ │ └── t5xxl_fp16.safetensors 或 t5xxl_fp8_e4m3fn.safetensors

│ ├── vae/

│ │ └── ae.safetensors1.3 按步骤检查确保工作流可以正常运行

对于低显存用户, 这个模型可能无法在你的设备上顺利运行,你可以等待社区提供 FP8 或 GGUF 版本

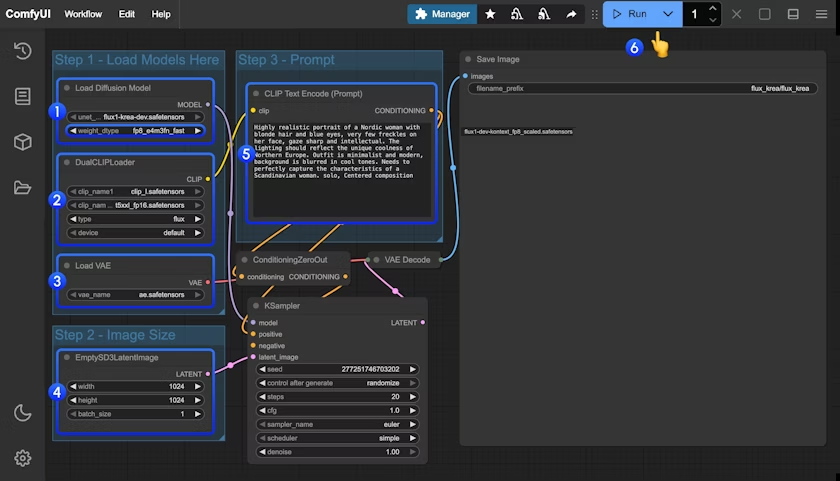

请参照下面的图片,确保各个模型文件都已经加载完成

- 确保在

Load Diffusion Model节点加载了flux1-krea-dev_fp8_scaled.safetensors或flux1-krea-dev.safetensorsflux1-krea-dev_fp8_scaled.safetensors推荐低显存用户使用flux1-krea-dev.safetensors如果你有足够的显存如 24GB, 你可以尝试这个版本以追求更好的质量

- 确保在

DualCLIPLoader节点中下面的模型已加载:- clip_name1: t5xxl_fp16.safetensors 或 t5xxl_fp8_e4m3fn.safetensors

- clip_name2: clip_l.safetensors

- 确保在

Load VAE节点中加载了ae.safetensors - 确保

- 点击

Queue按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来运行工作流

三、Flux.1 Dev & Schnell

本文将简要介绍 Flux 绘图模型,并指导使用 Flux 模型进行文生图的示例包括原始完整版本和 FP8 Checkpoint 版本。

Flux 是目前最大的开源AI绘画模型之一,拥有 12B 参数,原始文件大小约为23GB。它由 Black Forest Labs 开发,该团队由前 Stable Diffusion 团队成员创立。

Flux 以其卓越的画面质量和灵活性而闻名,能够生成高质量、多样化的图像。

目前 Flux.1 模型主要有以下几个版本:

- Flux.1 Pro: 效果最佳模型,闭源模型,仅支持通过 API 调用。

- Flux.1 [dev]: 开源但仅限非商业使用,从 Pro 版本蒸馏而来,效果接近Pro版。

- **Flux.1 [schnell]:**采用 Apache2.0 许可,仅需4步即可生成图像,适合低配置硬件。

Flux.1 模型特点

- 混合架构: 结合了 Transformer 网络和扩散模型的优势,有效整合文本与图像信息,提升生成图像与提示词的对齐精度,对复杂的提示词依旧有非常好的还原能力。

- 参数规模: Flux 拥有 12B 参数,可捕捉更复杂的模式关系,生成更逼真、多样化的图像。

- 支持多种风格: 支持多样化的风格,对各种类型的图像都有非常好的表现能力。

在本篇示例中,我们将介绍使用 Flux.1 Dev 和 Flux.1 Schnell 两个版本进行文生图的示例,包括原始完整版模型和 FP8 Checkpoint 简化版本。

- Flux 完整版本: 效果最佳,但需要较大的显存资源(推荐16GB以上),需要安装多个模型文件。

- Flux FP8 Checkpoint: 仅需一个 fp8 版本的模型,但是质量相对完整版会有所降低。

本篇示例中的所有工作流图片的 Metadata 中已包含对应模型下载信息,使用以下方式来加载工作流:

- 直接拖入 ComfyUI

- 或使用菜单

Workflows->Open(ctrl+o)

如果你使用的不是 Desktop 版本或者部分模型无法顺利下载,请参考手动安装部分保存模型文件到对应的文件夹。

请在开始之前确保你的 ComfyUI 已更新到最新版本。

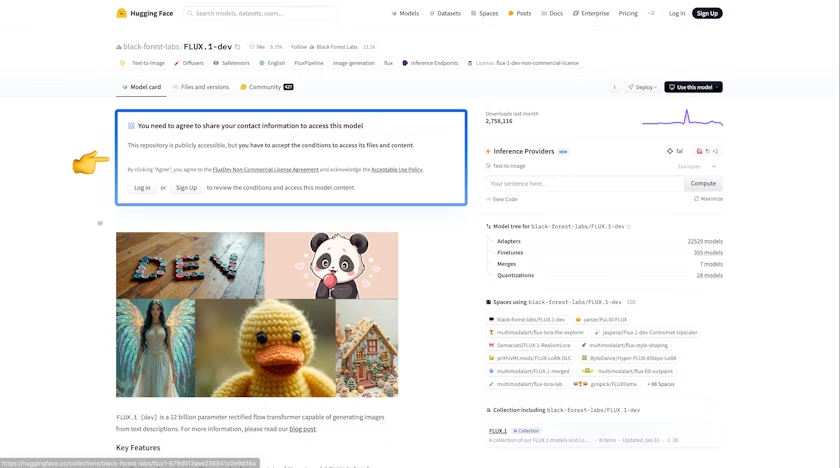

请注意如果你无法下载 black-forest-labs/FLUX.1-dev 中的模型,请确保你已登录 Huggingface 并同意了对应 Repo 的协议。

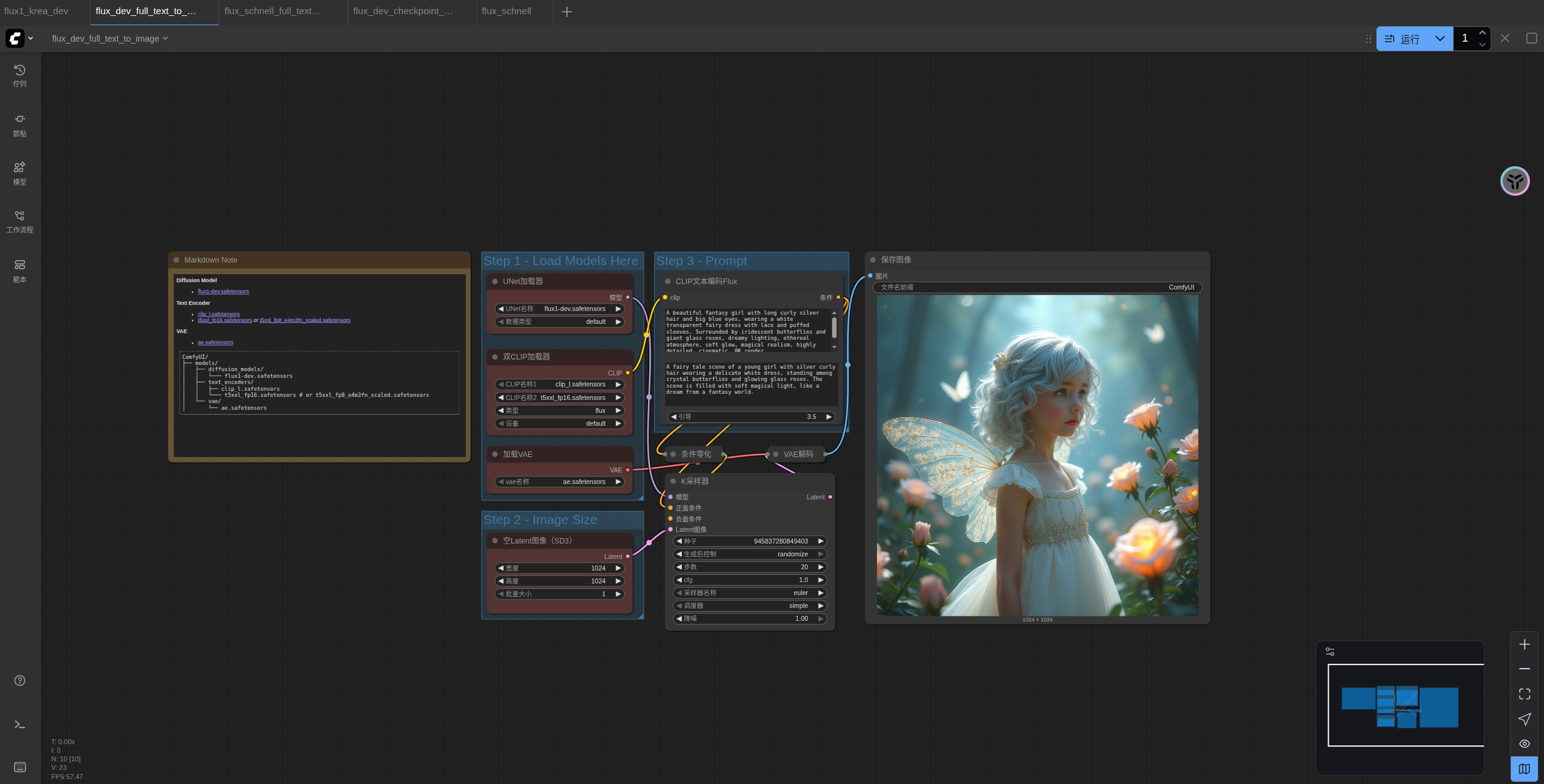

1.Flux.1 Dev 完整版本工作流

1.1 工作流文件

请下载下面的图片,并拖入 ComfyUI 中加载工作流。

1.2 手动安装模型

* `flux1-dev.safetensors` 文件需要同意 [black-forest-labs/FLUX.1-dev](https://huggingface.co/black-forest-labs/FLUX.1-dev) 的协议后才能使用浏览器进行下载。 * 如果你的显存较低,可以尝试使用 [t5xxl\_fp8\_e4m3fn.safetensors](https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/t5xxl_fp8_e4m3fn.safetensors?download=true) 来替换 `t5xxl_fp16.safetensors` 文件。

请下载下面的模型文件:

- clip_l.safetensors

- t5xxl_fp16.safetensors 当你的显存大于 32GB 时推荐使用。

- ae.safetensors

- flux1-dev.safetensors

安装aria2快速下载模型,几乎能将我家1000M的宽带跑满,每秒80~90M,接下来的介绍模型都会给出安装命令。

bash

apt install aria2

bash

aria2c https://huggingface.co/Comfy-Org/flux1-dev/resolve/main/flux1-dev-fp8.safetensors?download=true -o SourceCode/ComfyUI/models/checkpoints/flux1-dev-fp8.safetensors auto-file-renaming=false --allow-overwrite=false

aria2c https://huggingface.co/Comfy-Org/flux1-schnell/resolve/main/flux1-schnell-fp8.safetensors?download=true -o SourceCode/ComfyUI/models/checkpoints/flux1-schnell-fp8.safetensors auto-file-renaming=false --allow-overwrite=false

aria2c https://huggingface.co/Comfy-Org/flux1-dev/resolve/main/flux1-dev.safetensors -o SourceCode/ComfyUI/models/diffusion_models/flux1-dev.safetensors auto-file-renaming=false --allow-overwrite=false

aria2c https://huggingface.co/Comfy-Org/flux1-schnell/resolve/main/flux1-schnell.safetensors -o SourceCode/ComfyUI/models/diffusion_models/flux1-schnell.safetensors auto-file-renaming=false --allow-overwrite=false小技巧:你要是打不开https://huggingface.co,可以将其换成为https://hf-mirror.com/试一试

文件保存位置:

ComfyUI/

├── models/

│ ├── text_encoders/

│ │ ├── clip_l.safetensors

│ │ └── t5xxl_fp16.safetensors

│ ├── vae/

│ │ └── ae.safetensors

│ └── diffusion_models/

│ └── flux1-dev.safetensors1.3 按步骤检查确保工作流可以正常运行

请参照下面的图片,确保各个模型文件都已经加载完成

- 确保在

DualCLIPLoader节点中下面的模型已加载:- clip_name1: t5xxl_fp16.safetensors

- clip_name2: clip_l.safetensors

- 确保在

Load Diffusion Model节点加载了flux1-dev.safetensors - 确保在

Load VAE节点中加载了ae.safetensors - 点击

Queue按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来运行工作流

得益于 Flux 良好的提示词遵循能力,我们并不需要任何的负向提示词

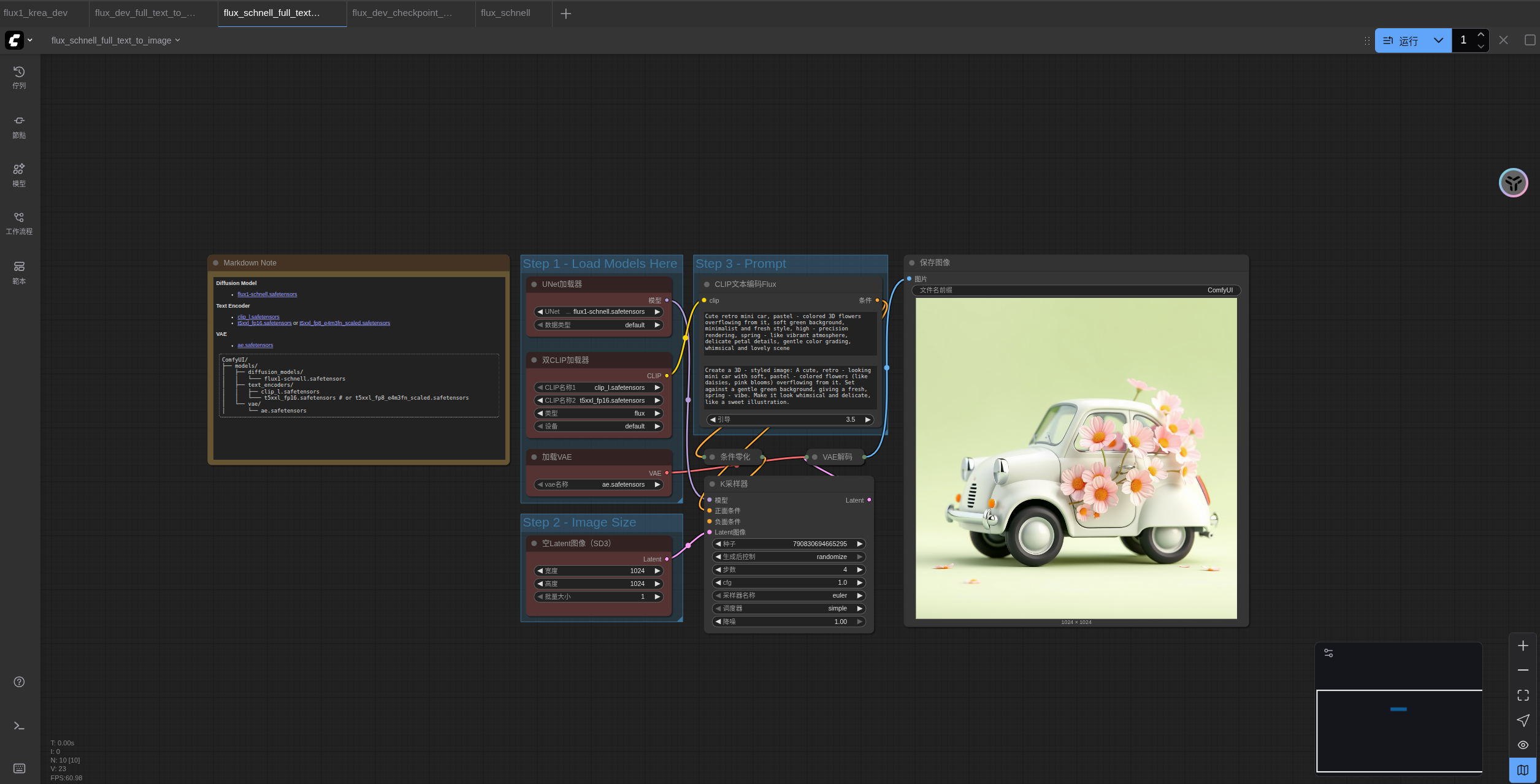

2.Flux.1 Schnell 完整版本工作流

2.1 工作流文件

请下载下面的图片,并拖入 ComfyUI 中加载工作流。

2.2 手动安装模型

在这个工作流中,只有两个模型文件与 Flux1 Dev 版本的工作流不同,对于 t5xxl 你仍可使用 fp16 版本来获得更好的效果。

- t5xxl_fp16.safetensors -> t5xxl_fp8.safetensors

- flux1-dev.safetensors -> flux1-schnell.safetensors

完整模型文件列表:

文件保存位置:

ComfyUI/

├── models/

│ ├── text_encoders/

│ │ ├── clip_l.safetensors

│ │ └── t5xxl_fp8_e4m3fn.safetensors

│ ├── vae/

│ │ └── ae.safetensors

│ └── diffusion_models/

│ └── flux1-schnell.safetensors2.3 按步骤检查确保工作流可以正常运行

- 确保在

DualCLIPLoader节点中下面的模型已加载:- clip_name1: t5xxl_fp8_e4m3fn.safetensors

- clip_name2: clip_l.safetensors

- 确保在

Load Diffusion Model节点加载了flux1-schnell.safetensors - 确保在

Load VAE节点中加载了ae.safetensors - 点击

Queue按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来运行工作流

3.Fp8 Checkpoint 版文生图示例

fp8 版本是对 flux1 原版 fp16 版本的量化版本,在一定程度上这个版本的质量会低于 fp16 版本,但同时它需要的显存也会更少,而且你仅需要安装一个模型文件即可尝试运行。

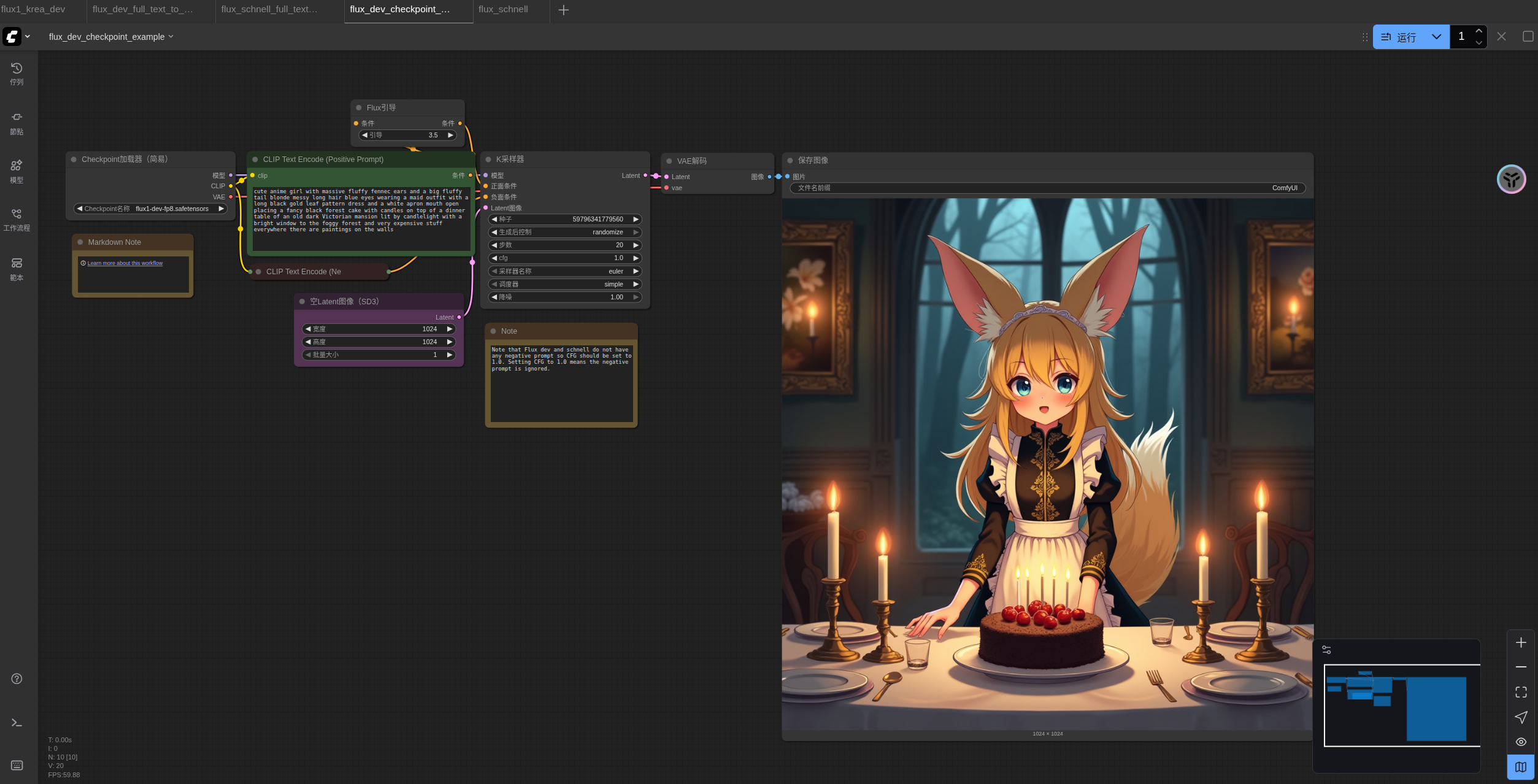

3.1 Flux.1 Dev fp8 Checkpoint 版工作流

请下载下面的图片,并拖入 ComfyUI 中加载工作流。

请下载 flux1-dev-fp8.safetensors并保存至 ComfyUI/models/Checkpoints/ 目录下。

确保对应的 Load Checkpoint 节点加载了 flux1-dev-fp8.safetensors,即可测试运行。

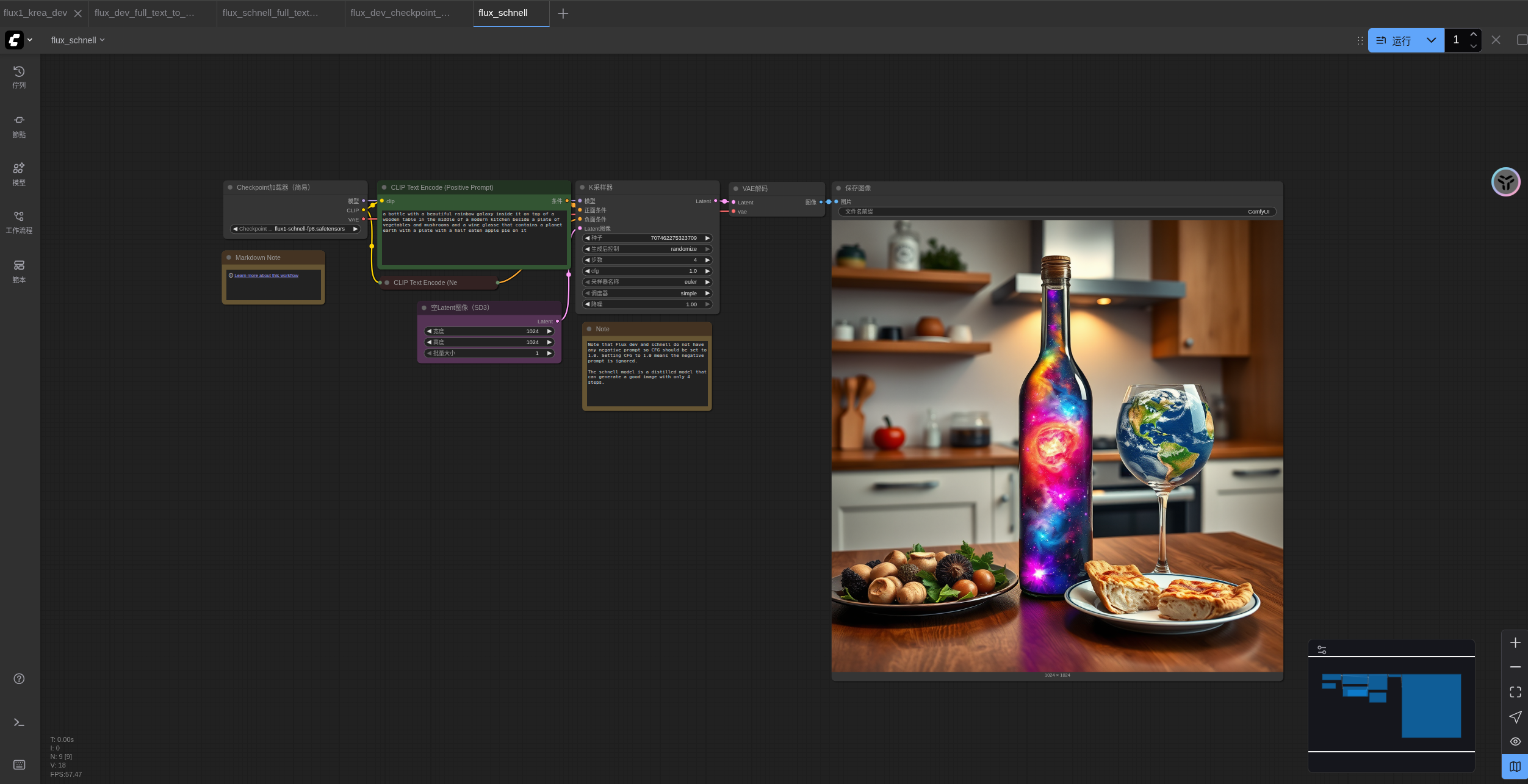

3.2 Flux.1 Schnell fp8 Checkpoint 版工作流

请下载下面的图片,并拖入 ComfyUI 中加载工作流。

请下载flux1-schnell-fp8.safetensors并保存至 ComfyUI/models/Checkpoints/ 目录下。

确保对应的 Load Checkpoint 节点加载了 flux1-schnell-fp8.safetensors,即可测试运行。