前言

又是一年"金九银十"秋招季,大模型相关的技术岗位竞争也到了白热化阶段。为满足大家碎片化时间复习补充面试知识点的需求(泪目,思绪回到前两年自己面试的时候),笔者特开设 《大模型工程面试经典》 专栏,持续更新工作学习中遇到大模型技术与工程方面的面试题及其讲解。每个讲解都由一个必考题和相关热点问题组成,小伙伴们感兴趣可关注笔者掘金账号和专栏,更可关注笔者同名微信公众号: 大模型真好玩,免费分享学习工作中的知识点和资料。

一、面试题:什么时候用微调技术,什么时候用RAG技术?

1.1 问题浅析

这是经常会被问到的一个经典问题,在实际工作中普遍会遇到微调与RAG技术抉择的场景,偏向考察技术认知。

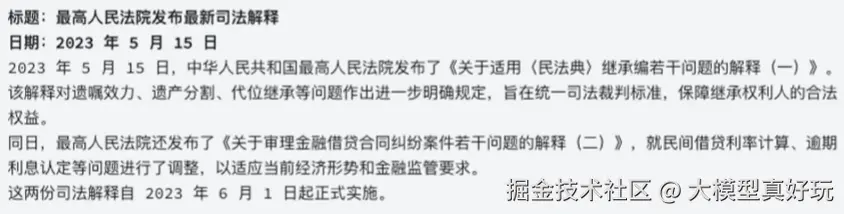

所谓RAG技术是指在每次回答问题前将检索与问题相关联的文档片段作为背景信息进行输入,此时模型会完整的浏览文档片段,更好的把握各项细节信息,进而进行精准的回答。例如对于一些新闻报道:

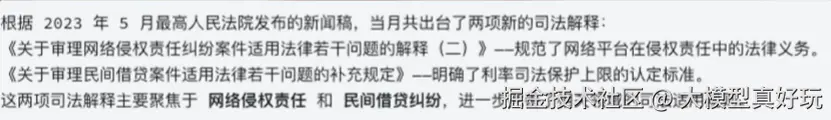

如果用户问到:"2023年5月中国最高人民法院发布了哪些新的司法解释?",借助RAG系统在回答之前模型就能关联这篇5月的新闻稿,并作为背景信息作为输入。然后模型就能做出这样一个精准回答:

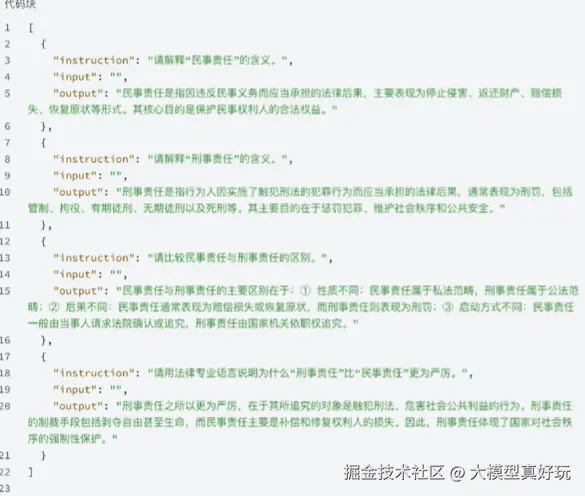

不过RAG系统只能看做是更人文化的知识检索,它缺乏对知识的关联理解,更有自己的局限,不能无限制的增加上下文。如果我们想让模型系统的学习完一整套法律知识并深入理解法律条文背后的基本概念和表述逻辑,那就只能依靠大模型微调了。例如我们可以创建如下这种主题一致但内容多样的数据集代入到模型中进行微调训练。因为微调会改变模型相应的参数,相当于把知识压缩到模型中去(让模型学会),所以微调后的模型就能更加清晰的理解"民事责任"与"刑事责任"的这组概念了。

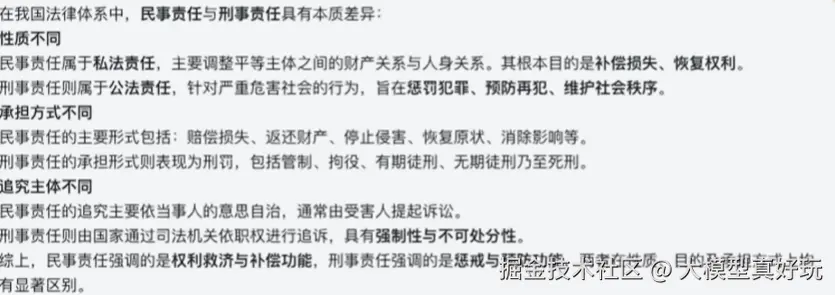

当我们提出"请用法律专业术语解释'民事责任'与'刑事责任'的区别",微调后的模型能做出如下回答:

1.2 标准答案

首先第一段先简明扼要的给出两者的适用场景: 对于精细化、非常细节的问题检索,如查看某年某月发生了什么事情,推荐采用RAG技术对文档进行检索。而对于一些相对固定的领域知识,如一些法律知识、医学知识、行业规范等,则可以采用较多主题一致、但内容多样的文档进行微调,从而实现知识灌注。

更重要的第二段要表明:在实际应用中,微调与RAG技术往往需要结合使用,我们可以先通过微调让模型掌握稳定的核心知识与专业表达风格,然后在必要的场景中,通过RAG技术让模型能够动态的获取最新信息。二者结合可以在保证回答的专业性与一致性的同时,避免知识过时,兼顾长期记忆与实时更新,从而显著提升系统的可靠性与实用性。

二、相关热点问题

2.1 大模型微调能提升模型的哪些能力?

答案: 根据目前业内的实践经验,大模型微调可以用于优化模型问答的语气风格、可以进行知识灌注,可以用于修改模型的自我认知,也可以提升模型指令跟随能力、提升模型工具调用与Agent能力。

2.2 模型微调可能存在哪些风险?

答案: 微调最大的风险是可能会使得模型丧失原有能力,也就是所谓的灾难性遗忘,此外还有可能造成训练数据过拟合,或者在训练数据中带入隐私数据,后期使用不当间接导致模型在回答问题时造成隐私数据泄露等等。

2.3 模型微调与模型蒸馏有什么区别?

答案: 模型蒸馏指的是借助更强大的教师模型产生的数据,来训练小尺寸的学生模型,目前模型蒸馏分为黑箱蒸馏和白箱蒸馏,黑箱蒸馏过程中教师模型不会公开中间输出,学生模型只能学习教师模型的输入和输出,此时学生模型的训练过程本质上就是有监督微调,二者没有区别。

典型例子就是DeepSeek R1模型蒸馏Llama3系列小模型和Qwen2.5系列小模型的过程,其实就是有监督微调。而白箱蒸馏则要求教师模型输出中间预测结果,在透明的情况下,学生模型不仅能模仿最终答案,还能学习教师模型的推理链路、注意力分布隐藏层表示等更丰富的信息。这种方式能更好地提升学生模型的推理能力和对齐果,但同时也依赖于教师模型内部结构的开放程度。

三、 总结

本期分享系统介绍了RAG和模型微调的技术背景和适用场景,帮助大家更好理解模型微调和RAG的本质区别。同时鉴于模型微调的重要性,还补充了三个模型微调有关的面试题,相信大家按如上模板回答一定是加分项!小伙伴们阅读后感兴趣可关注笔者掘金账号和专栏,更可关注笔者同名微信公众号: 大模型真好玩,免费分享学习工作中的知识点和资料。