火山引擎PromptPilot:把提示词从"艺术"变为"工程"

上周在北京参加了 火山引擎PromptPilot 的产品发布会,感触很深,忍不住要跟大家分享一下

引言

人工智能正以惊人的速度重塑世界,大模型的能力边界不断拓宽。但对许多一线团队而言,兴奋之后是普遍的困惑:我们仿佛请来了一个"超级大脑",却发现自己使唤不动它。模型效果时好时坏,难以稳定输出,问题到底出在哪?

答案往往就在那"最后一公里":提示词(Prompt) 。

如何将模糊的业务需求,精准翻译成模型能听懂的指令?这是一个巨大的挑战。长期以来,写Prompt像一门"玄学",依赖个人经验和灵光一闪,过程如同"炼丹",充满不确定性。但当大模型要真正深入产业、解决实际问题时,我们需要的不再是"玄学",而是一套可度量、可复用、可持续优化的工程方法。

火山引擎推出的 PromptPilot,正是为此而生。它提供了一套完整的"工具+流程",旨在将提示词开发从"手工作坊"升级为"自动化流水线",让任何角色都能稳定地将模型效果拉到业务可用线以上。

01|为什么高质量的 Prompt,如此重要又如此难得?

在AI应用落地过程中,提示词工程是绕不开的三大"拦路虎"。

- 拦路虎一:需求天然模糊,难以"翻译"

我们脑中的业务目标,与模型能理解的指令之间,存在一条巨大的鸿沟。比如"筛选出好简历",什么是"好"?不同团队、不同岗位的标准天差地别。如果不能将这些模糊、隐性的需求结构化、量化,模型就永远无法真正与业务对齐。 - 拦路虎二:调优过程像"炼丹",低效且不可靠

"换个说法、调整下结构、多给几个例子......" 这是最常见的调优方式。这种摸索充满了偶然性,往往只能把一个60分的Prompt艰难地优化到70分,一旦遇到瓶颈就陷入盲目试错。更糟糕的是,这些经验难以复用,下一个新任务来了,一切又要从头开始。 - 拦路虎三:上线才是"大考"的开始

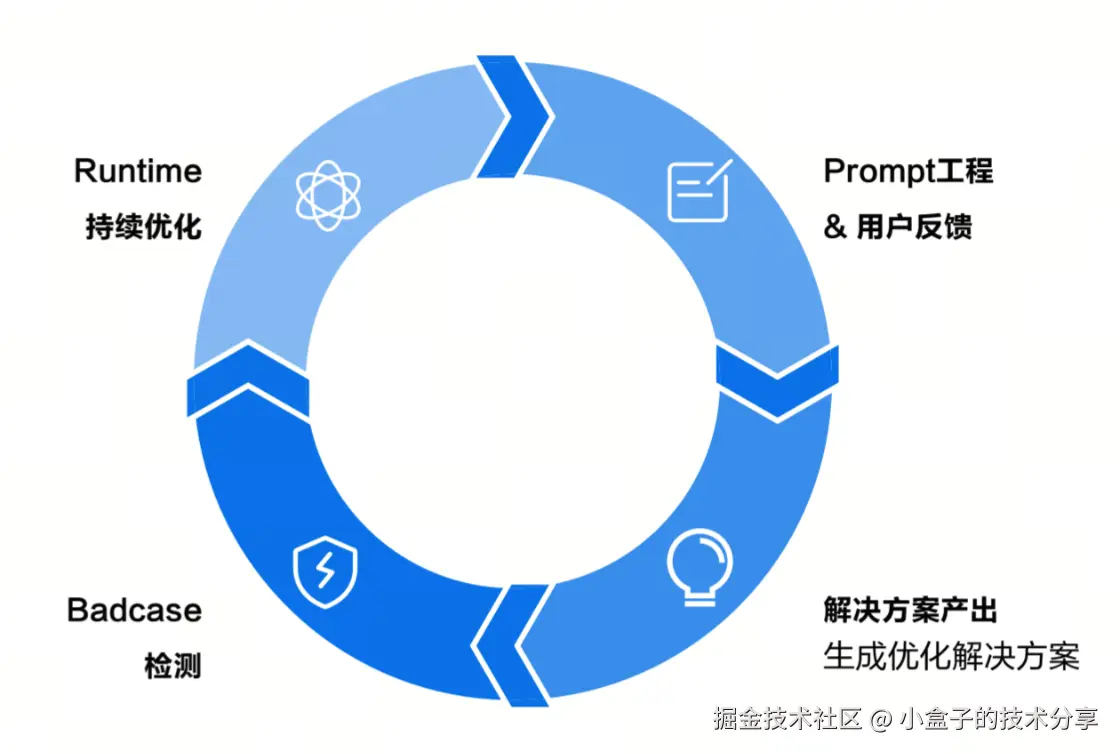

即便在实验室里调出了一个看似完美的Prompt,真实的业务场景也会带来无穷无尽的新Badcase(坏样本)。业务环境在变,用户数据在变,模型表现也会随之波动。如果没有一套"采集---归因---修复---验证"的闭环流程,AI应用的效果只会不断衰减,无法实现"越用越好"的自进化。

本质上,Prompt早已不是"写一句话"那么简单,它是一套完整的工程体系:从业务目标出发,用数据来驱动,以科学评测为锚点,最终形成一个可持续优化的闭环。

02|PromptPilot:把"玄学"变"工程"的解法

一句话概括 :PromptPilot 是一个将提示词开发从手工作坊升级为自动化流水线的全链路优化平台。它帮助你将模糊需求转化为可执行的指令与评测集,通过数据驱动的方式自动探索更优的Prompt,并捕捉线上Badcase,形成持续进化的数据飞轮。

正如 PromptPilot 的技术负责人许老师所说,它的核心价值,就是用工程化的思路,解决提示词的三大难题:

- 从"说不清"到"可执行":引导式需求探索

通过可视化的交互界面,引导用户将复杂的业务场景,精准地拆解为AI模型可理解、可执行的优化目标。即使是非技术背景的业务人员,也能轻松上手。 - 从"凭感觉"到"有标准":动态评估标准生成

你只需对少量代表性样本进行评分反馈,平台就能自动学习并生成贴合业务需求的评估指标(Metric)。这把"尺子"将与你的专业判断持续对齐,最终实现高精度、自动化的数据评估。 - 从"靠蒙猜"到"数据驱动":智能优化与迭代

彻底告别"拍脑袋"式的调优。只要提供一个高质量的评测数据集,平台便会自动探索、测试并筛选出表现最佳的Prompt版本。每一次优化都有据可依、效果可衡量。 - 从"一次性"到"自进化":线上数据闭环

通过SDK,低成本、高质量地实现线上Goodcase和Badcase的自动抓捕与回流。这不仅能帮你快速定位和修复问题,更能建立一个从生产到优化的数据闭环,让你的AI应用具备自进化的能力。

03|实战演练:四步搞定工厂质检难题

让我们以"生产车间安全质检"为例,看看这套工程化的流程是如何在实践中落地的。

- 第一步:生成与调试

从一句简单的任务描述开始:"判断车间图片是否存在违规操作和未佩戴安全防护用具"。PromptPilot会为你生成一个结构化的初始Prompt。随后,你可以上传一张真实的违规图片进行"单Case调试",快速验证并迭代出V1版本,同时将这个"问-答-分"的种子样本存入评测集。

- 第二步:批量评测

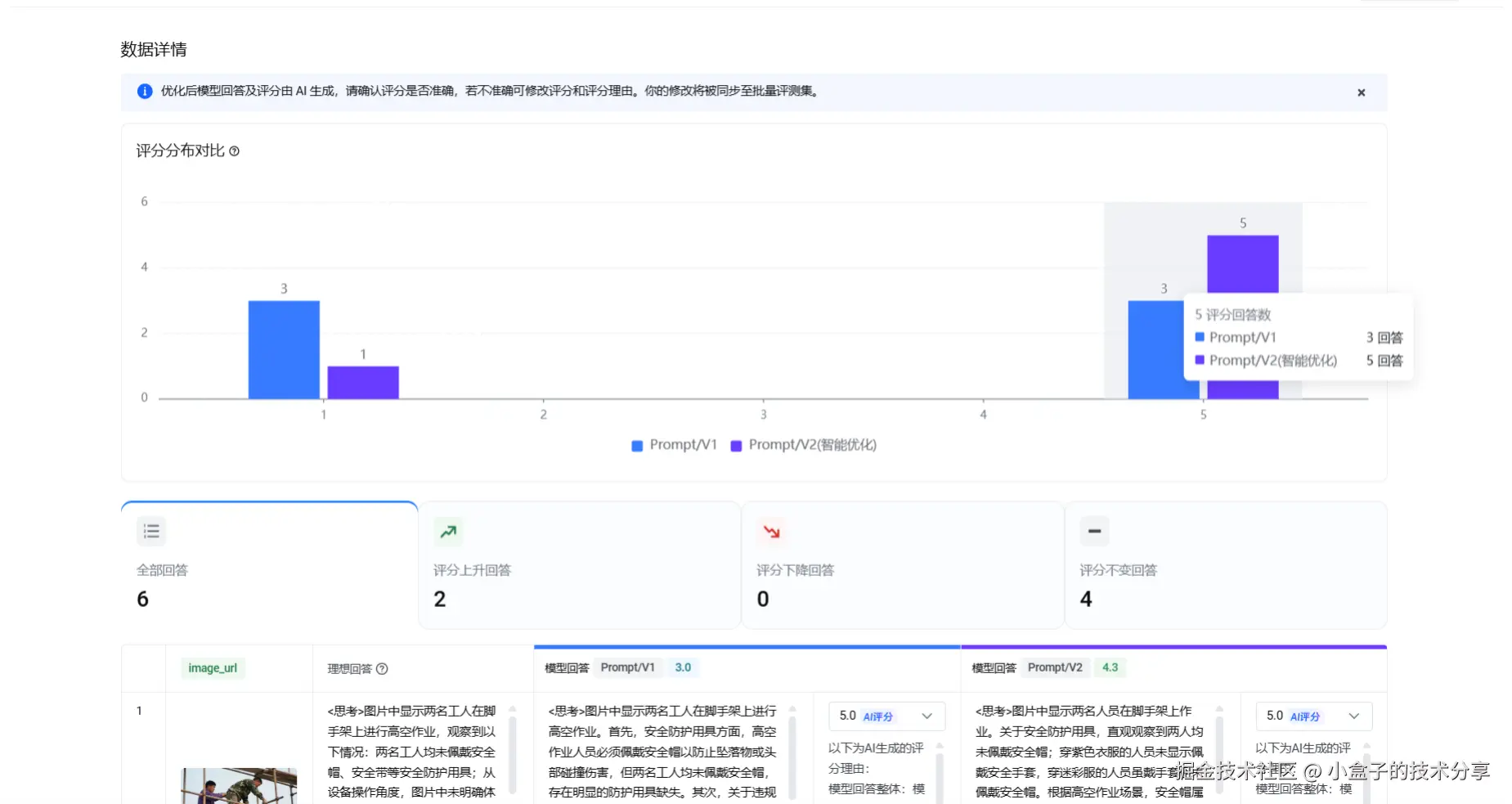

一个样本远不足以评估模型。你需要批量上传图片数据,并为它们标注"理想回答"。对于评分环节,除了手动打分,还可以启用 AI智能评分+人工审核 的模式,快速将你的评测标准固化为一套可执行的规则。一个高质量、正负样本均衡的评测集是后续所有优化的基石。 - 第三步:一键优化

当评测集准备就绪,你只需点击"智能优化"。PromptPilot会启动算法,在后台自动对Prompt进行多维度的探索和迭代,并基于评测集进行打分,整个过程完全自动化,帮你从海量的可能性中找到最优解。 - 第四步:报告与迭代

优化完成后,你会得到一份清晰的报告,直观展示新旧Prompt的对比,以及在你的评测集上模型平均分实实在在的提升。如果对结果满意,可以直接部署新版Prompt;如果不满意,可以带着新的认知,继续下一轮迭代,让效果螺旋式上升。

04|看得见的提升:三大场景效果展示

这套方法论并非纸上谈兵,在多个真实业务场景中,它都带来了显著的效果提升。

- 场景一:电商客服(尺码推荐)

通过将任务拆解为"抽取尺码表→理解历史会话→推荐合适尺码",并细化评分标准,模型回答的满分比例从 60.86% 跃升至 91.80% 。 - 场景二:招聘筛选(人岗匹配)

将"匹配度"这一模糊概念,定义为对"工作经验、专业技能、职责范围"等关键维度的考察,模型判断的满分比例从 72.12% 提升至 81.25% 。 - 场景三:车机助手(指令理解)

通过在Prompt中明确"函数选择、参数边界、输出格式"等约束,模型激活函数的准确率从 50.94% 提升至 75.50% 。

这些数字的背后,是工程化方法论带来的必然结果:稳定、可靠、可复制的性能提升。

05|告别玄学,拥抱工程

当大模型从"技术玩具"走向"生产力工具",我们必须跨越从"能用"到"好用"的鸿沟。Prompt的工程化,正是这其中最关键的一步。

PromptPilot给出的答案是清晰的:用评测集来对齐业务口径,用自动化搜索来提升效果上限,用线上数据回流来加速应用自进化。

这样一来,写Prompt将不再依赖"玄学"和感觉,而是成为一门以数据为尺,以闭环为锚的严谨工程。只有这样,我们才能真正驾驭大模型的力量,让AI在各行各业中创造出实实在在的价值。