设计师们,你们用的画图工具是不是生成一张图要几分钟,想批量生成还有数量限制? 工作效率实在低。

企业开发们,你们调用的APi聚合平台是不是动不动就崩溃、超时还有并发限制?根本无法承接高并发需求,修复拖半天,价格还不便宜!

这些问题对出海开发者和设计师而言,简直是灾难。当你还在单线程请求AI画图任务时,高手早已用Grsai APi实现并发调用,同时跑几十、上百个任务,用最低的画图单价享受最高的速度与稳定行。

本文将深入浅出地讲解并发调用的核心原理,并为你提供一个开箱即用的GrsAI 批量生图工具,助你全面掌握Sora2、Nano banana pro、GPT-Image 1.5等主流模型的批量创作秘籍。

一、如何实现API并发调用接口

并发 是指系统能够同时处理多个任务的能力,但这些任务不一定在同一瞬间执行。关键在于:

-

任务在重叠的时间段内启动、运行和完成

-

系统在多个任务间快速切换,造成"同时进行"的错觉

-

目的是提高资源利用率和系统响应性

实现APi并发主要路径:

异步并发: 在单个线程内通过"事件循环"处理多个网络请求。效率高、资源消耗少 ,可处理大量请求,能够处理大量I/O密集型任务(如批量生成图片/视频)。

对于GrsAI API调用这类I/O密集型 任务(大部分时间在等待网络响应),**异步并发是性能最优的选择。**它通过在单个线程内高效切换任务,避免了多线程的切换开销,能轻松管理成百上千个并发请求。这对于需要大量生成内容的营销、设计、游戏开发等领域,意味着生产力质的飞跃。

更关键的是成本问题,直接使用OpenAI、Google等官方API,访问不方便就算了价格还超贵,同时还有并发频率与地区访问限制。选择便宜的API聚合平台可能还是个中间商赚差价的中转站,非源头APi、稳定性差、不支持高并发、出问题不第一时间修复。那么去哪里找便宜稳定支持高并发的Ai大模型API源头供应商?

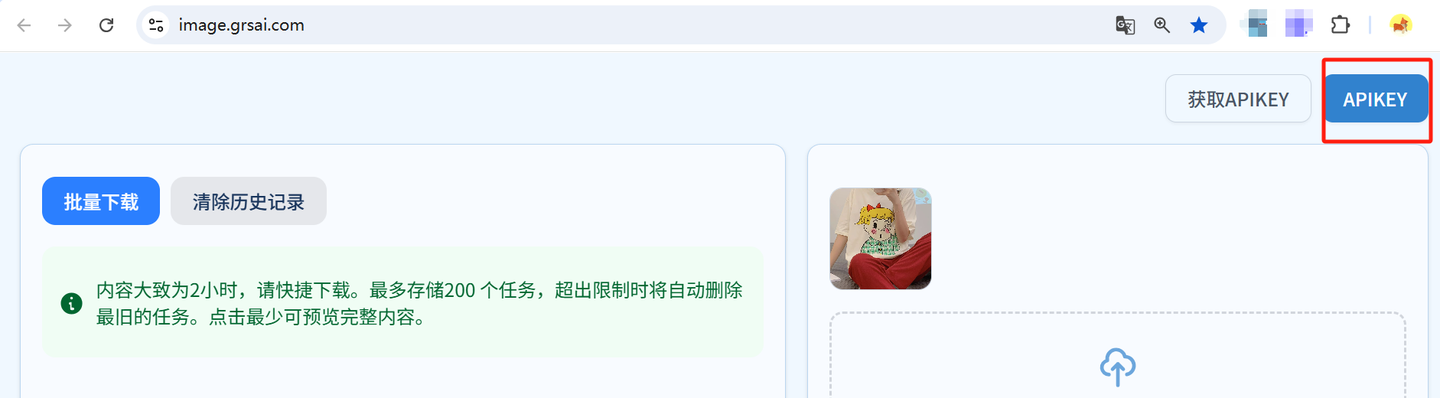

二、免费批量生成站:image.grsai.com(需要魔法,没有则com改成ai)

普通用户可以直接使用Grsai提供的现成批量生图工具,另外开发也可以通过github的开源项目查看代码结构学习怎么实现并发调用Grsai Api的接口。

工具地址:

-

在线使用:https://image.grsai.com(需要魔法,没有则com改成ai)

四步开启无限制批量创作:

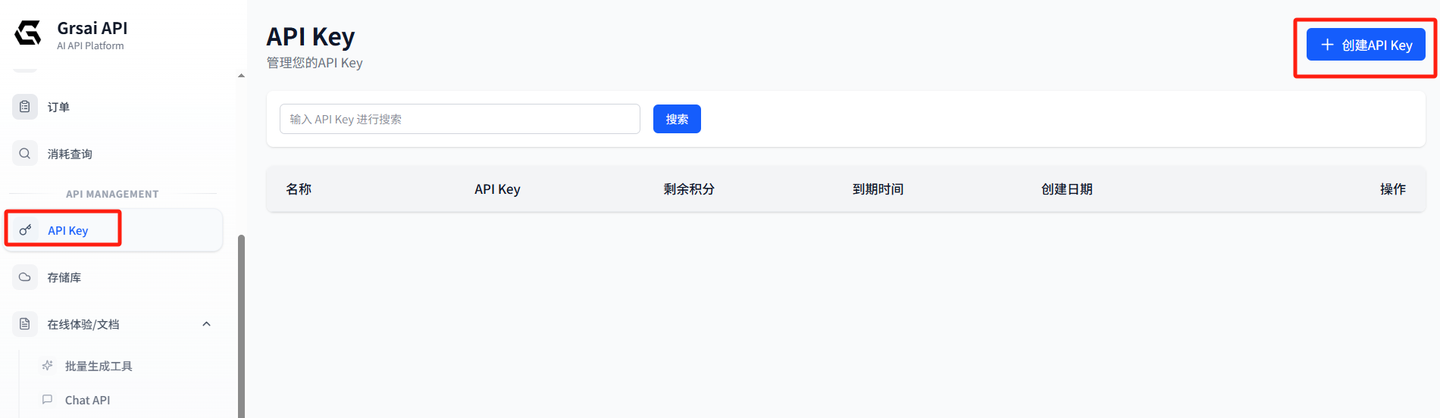

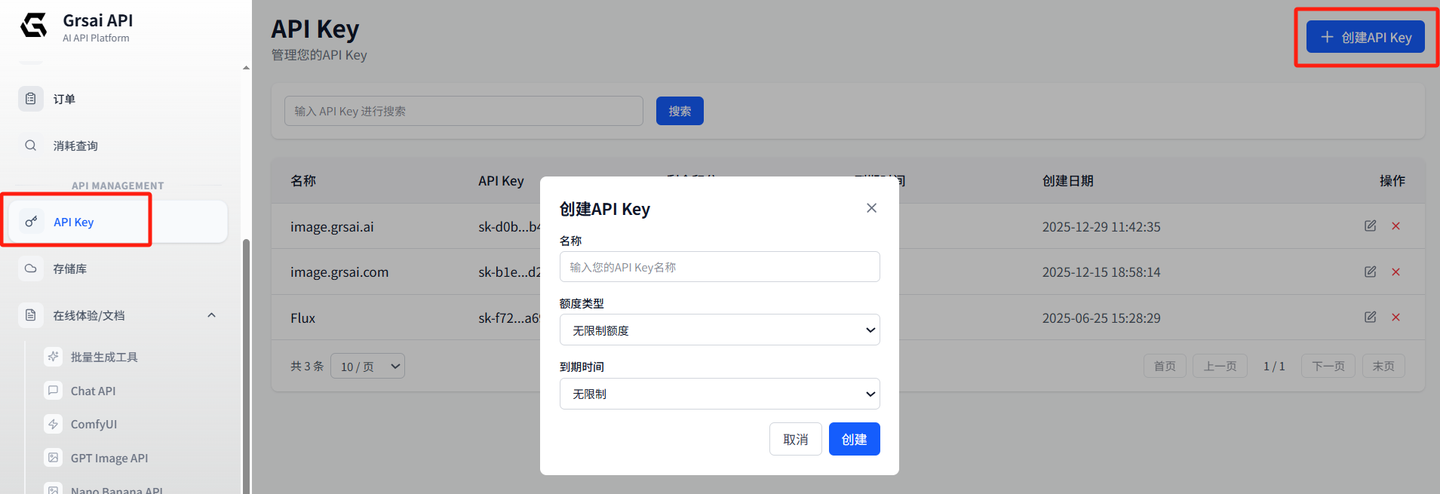

1.获取"批发密钥":在grsai.com控制台创建API Key。

**2.配置密钥:**在image.grsai.com右上角APIKEY中填入。

3.批量提交任务: 在界面中选择模型 (支持Sora2、Nano Banana Pro、gpt image 1.5、Veo等视频画图模型),上传图片,选择图片尺寸,在文本框内输入提示词(例如:根据参考图生成一张上衣正面整体展示,根据参考图还原上衣主体图案全貌,纯色背景,柔和自然,突出产品整体形态与图案呈现效果。)点击生成。

**4.批量下载:**由于系统只会保存两小时,所以生成完的内容尽快下载,支持一键打包下载。

三、Ai大模型APi源头供应站

GrsAI(https://grsai.com 需要魔法,没有com改ai)作为AI大模型API的聚合平台与源头供应商,核心价值在于以极低的成本提供稳定、高并发的调用服务。例如,生成一张Nano Banana Pro图片,官方API成本约0.134-0.24美元(1-2k:0.96,4k:1.37元),而通过GrsAI国内直连接入Nano Banana Pro 1k 2k 4k都是0.09/张,成本降低超过95%。

-

**高性价比多模型:**非中转站,没有一层层中间商,平台直接对接模型资源才能做到最低价。Nano Banana Pro------0.09/张,gpt image 1.5------0.02/张,Nano Banana------0.022/张,Sora2------0.08/条,Veo3.0/Veo3.1------0.4/张,Gemini2.5/3.0....

-

**支持高并发:**多台国内外顶配服务器,支持大量级高并发调用需求。

-

国内外节点:提供国内直连和国际线路,确保全球用户低延迟访问。

-

**平台存储库:**可直接把图片与视频文件上传到存储库中,从而降低服务器流量成本。

-

**失败不扣费:**只要是失败秒退款,日志可查询,将您的试错成本降至零。

-

vt高峰期会生成失败,可以和pro切换用,vt的4k更加高清

注意:图片视频只在平台保存2小时,超过时间则无法查看请尽快保存。

四、Grsai APi高并发调用Nano banana Pro实战

1.获取GrsAI API Key:

登录 GrsAI控制台(https://grsai.com/zh/dashboard/api-keys需要魔法才能访问,没有com改ai),创建并复制您的密钥。

Nano Banana Pro 支持gemini官方接口格式

2.安装必要的Python库:

我们将使用aiohttp进行异步HTTP请求,asyncio作为异步运行时。

python

pip install aiohttp3.高并发调用Api接口生成图片

步骤1:创建客户端类与初始化

首先,我们创建一个类来封装所有逻辑,包括配置API密钥、控制并发数和重试策略。

python

import asyncio

import aiohttp

from typing import List, Dict, Any

import time

class NanoBananaBatchGenerator:

"""Nano Banana Pro 高并发批量生成客户端"""

def __init__(self, api_key: str, max_concurrent: int = 10, retries: int = 3):

"""

初始化客户端

:param api_key: GrSAI API密钥

:param max_concurrent: 最大并发数,控制请求"洪峰"

:param retries: 失败重试次数

"""

self.api_key = api_key

self.max_concurrent = max_concurrent

self.retries = retries

# 注意:此处使用Nano Banana Pro的专用端点

self.endpoint = "https://api.grsai.com/v1/draw/nano-banana"

self.session = None # aiohttp会话对象,稍后创建步骤2:实现异步上下文管理

为了优雅地管理网络连接资源(自动创建和关闭会话),我们实现异步上下文管理器。

python

async def __aenter__(self):

"""异步上下文管理器入口,创建可复用的会话和连接池"""

self.session = aiohttp.ClientSession(

headers={

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json"

},

timeout=aiohttp.ClientTimeout(total=60) # 设置总超时

)

return self

async def __aexit__(self, exc_type, exc_val, exc_tb):

"""异步上下文管理器出口,确保会话被关闭"""

if self.session:

await self.session.close()步骤3:实现带重试的单个请求函数

这是最核心的函数之一,负责调用单次API,并内置了指数退避重试机制来增强鲁棒性。

python

async def _generate_single_with_retry(self, prompt: str, params: Dict) -> Dict[str, Any]:

"""执行单次生成,内置指数退避重试机制"""

payload = {

"model": "nano-banana-Pro", # 指定模型

"prompt": prompt,

**params # 合并其他参数(如尺寸,参考图等)

}

last_error = None

for attempt in range(self.retries):

try:

async with self.session.post(self.endpoint, json=payload) as response:

if response.status == 200:

data = await response.json()

return {"status": "success", "data": data, "prompt": prompt}

else:

error_text = await response.text()

last_error = f"HTTP {response.status}: {error_text[:200]}"

# 429错误代表请求过快,采用指数退避等待

if response.status == 429:

wait_time = 2 ** (attempt + 1)

print(f"提示词 '{prompt[:30]}...' 触发频率限制,{wait_time}秒后重试...")

await asyncio.sleep(wait_time)

continue

elif response.status >= 500:

# 服务器错误,稍后重试

await asyncio.sleep(1)

continue

else:

# 客户端错误(如参数错误)通常无需重试

break

except (asyncio.TimeoutError, aiohttp.ClientError) as e:

last_error = str(e)

await asyncio.sleep(1) # 网络异常,简单等待后重试

# 所有重试均失败

return {"status": "failed", "error": last_error, "prompt": prompt}步骤4:实现批量生成主函数

此函数管理整个批量流程,使用 asyncio.Semaphore(信号量) 来控制最大并发数,并使用 asyncio.gather 来并发执行所有任务。

python

async def generate_batch(self, prompts: List[str], **params) -> List[Dict[str, Any]]:

"""

批量生成主方法

:param prompts: 提示词列表

:param params: 额外API参数,如 aspectRatio="16:9"

:return: 生成结果列表

"""

if not self.session:

raise RuntimeError("请使用异步上下文管理器(async with)来调用此客户端")

# 创建信号量以严格控制最大并发数

semaphore = asyncio.Semaphore(self.max_concurrent)

async def bounded_task(prompt: str) -> Dict[str, Any]:

async with semaphore: # 只有获得"通行证"的任务才能执行

# 在请求间添加微小延迟,平滑流量,避免瞬时峰值

await asyncio.sleep(0.05)

return await self._generate_single_with_retry(prompt, params)

print(f"开始批量生成,总计 {len(prompts)} 个任务,最大并发数 {self.max_concurrent}...")

start_time = time.time()

# 创建所有异步任务对象

tasks = [bounded_task(prompt) for prompt in prompts]

# 并发执行所有任务,并等待它们全部完成

results = await asyncio.gather(*tasks, return_exceptions=True)

elapsed_time = time.time() - start_time

print(f"批量生成完成!总耗时 {elapsed_time:.2f} 秒")

# 统一处理结果,将异常转换为格式化的字典

processed_results = []

for i, result in enumerate(results):

if isinstance(result, Exception):

processed_results.append({

"status": "error",

"error": str(result),

"prompt": prompts[i]

})

else:

processed_results.append(result)

return processed_results四、实战用例:亚马逊电商套图生成

现在,让我们将上面的客户端应用于一个真实场景:为一个产品批量生成亚马逊页面所需的全套图片。

python

# ==================== 实战用例:亚马逊电商套图生成 ====================

async def main():

"""实战案例:为智能咖啡杯生成亚马逊产品套图"""

API_KEY = "your_grsi_api_key_here" # 请替换为Grsai.com提供的APiKey

# 产品核心描述

product_desc = "a modern smart coffee mug with temperature display"

# 构建亚马逊产品页面所需的多样化提示词列表

prompts = [

f"{product_desc}, on a pure white background, professional product photography, Amazon main image",

f"{product_desc}, on a wooden desk in a cozy home office, lifestyle shot",

f"Close-up of {product_desc}'s LED screen showing 65°C, macro photography",

f"A person's hands holding {product_desc} in a modern kitchen, action shot",

f"{product_desc} shown next to a regular coffee mug for size comparison",

]

# API调用参数

generate_params = {

"aspectRatio": "1:1", # 正方形构图,适合电商平台

"imageSize": "2K", # 可选:输出尺寸(1K, 2K, 4K)

"urls": ["https://example.com/example.png"], # 参考图

}

# 执行批量生成:使用async with自动管理客户端生命周期

async with NanoBananaBatchGenerator(API_KEY, max_concurrent=5) as generator:

results = await generator.generate_batch(prompts, **generate_params)

# 分析并打印结果

success_count = 0

for i, result in enumerate(results):

print(f"\n任务 {i+1}: '{result['prompt'][:50]}...'")

if result["status"] == "success":

success_count += 1

image_data = result.get("data", {})

# 图像URL通常位于 data.results[0].url

if "results" in image_data:

print(f"✅ 生成成功!")

else:

print(f"❌ 失败: {result.get('error')}")

# 运行主函数

if __name__ == "__main__":

asyncio.run(main())通过以上拆解,您可以看到,从初始化、资源管理、单个请求重试,到最终的批量调度,每一步都如何设计。

五、使用WebHook回调处理结果方法

适用于解耦的后台任务系统,你需要一个公网可访问的服务器来接收回调。

1.请求参数: 设置**"webHook"**为你服务器的回调地址。可搭配 "shutProgress": true 让回调只发最终结果。

python

payload = {

"model": "nano-banana-pro",

"prompt": "一只猫",

"aspectRatio": "1:1",

"webHook": "https://your-server.com/api/callback", # 你的回调地址

"shutProgress": true # 回调只接收最终结果,可选

}**2.处理回调:**你的服务器需要提供一个能处理POST请求的接口。、

python

# 使用Flask的简单示例

from flask import Flask, request

app = Flask(__name__)

@app.route('/api/callback', methods=['POST'])

def handle_callback():

data = request.json

# 根据ID匹配你的任务

task_id = data['id']

if data['status'] == 'succeeded':

image_url = data['results'][0]['url']

# 保存URL或触发后续操作

print(f"任务 {task_id} 完成,图片: {image_url}")

return 'OK' # 务必返回成功响应3.首次响应:提交任务后,API会立即返回一个JSON,其中包含 data.id(任务ID),你需要保存它,以便在回调中识别对应任务。

你可以通过接入Grsai api用极低成本结合异步并发的高效调度,实现AI图像与视频无限制批量生成,提高创作效率与降低成本。