前言

最近 Seedream4.0 发布了 ,梳理了一下核心卖点:

- 生成+编辑"一体化"架构:同一模型完成文生图与图像编辑(抠物、改字、调光、换风格等),减少多模型切换与风格漂移;最高支持 4K 输出。

- 批量/多参照工作流:支持一次上传多张参考图,并"一次出多张"成组结果,便于做系列物料、角色/商品 ID 一致性与 A/B 测试。

- "一句话精修"的自然语言编辑:删除/替换目标、版面中文案替换且保持排版、场景补光、老照片上色修复

- 知识驱动生成(结构化内容更强):能生成带中英文字说明的教育插画、对照图表、时间线、流程步骤等,适合海报/信息图/教材等场景。

- 画质与速度:高分辨率 + 接近实时:相较 3.x 代推理更快;媒体实测报道 2K 约 1.8--2 秒量级

- 文本渲染与双语友好传统延续:在 3.0 代已强调中文/英文文本渲染与版式改进,4.0 官方性能页也将"文本渲染"纳入核心评测维度

- 风格广度与稳定一致性:水彩、赛博朋克、建筑等专业风格;结合多参照与批量输出,能保持主题与风格的一致性,适合品牌与 IP 长线创作。

- 对标 Google"Nano-Banana/Gemini 2.5 Flash Image"

此外,还支持全自动进行

- 智能多帧功能,一次性生成多张连续图像,进行首尾帧自动衔接,组成视频

- 支持批量生图,一次性最多可以出40张图和8个视频

- 支持一次将多张图片组织成一个视频

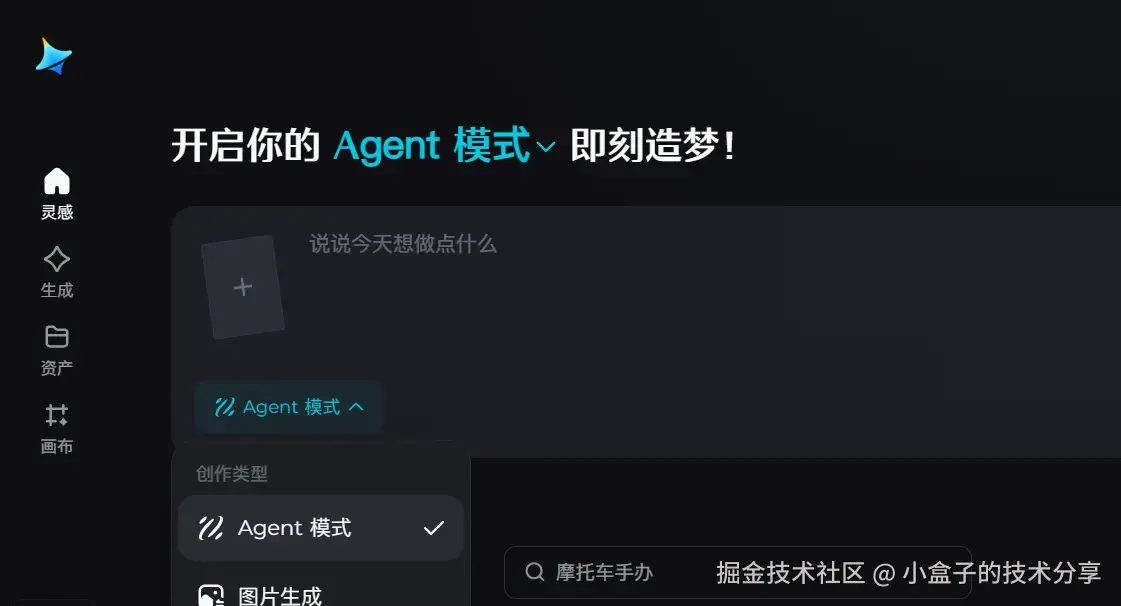

如果你不会写提示词,还支持 Agent 模式 在 Agent 模式下,你只需说出需求,它能理解你的需求自动帮你写提示词

本文是对 Seedream 4.0 的深度报告,内容涵盖多模态背景、模型能力、Agent 模式的横纵向对比、使用建议及适配场景等。

Seedream 在 AIGC 图像/视频生成体系中的定位

AIGC(Artificial Intelligence Generated Content)涵盖了文本、图像、音频、视频、3D等多模态内容的自动生成。其中,图像和视频生成是当前AIGC领域最活跃、应用最广的分支之一。

从技术分类来看,图像/视频生成体系可以细分为:

- 文本生成图像(Text-to-Image):由文本描述直接生成静态图像,如 Midjourney、Stable Diffusion 等。近年来扩散模型(Diffusion)成为主流,生成清晰度和多样性不断提升,同时出现了控制图像内容的附加手段(如ControlNet)来提高可控性。

- 图像编辑/图生图(Image Editing / Image-to-Image):对已有图片进行修改或根据参考图生成新图。传统上需要专门的图像编辑模型或在扩散模型上进行 Inpainting/Outpainting 等操作,如 Adobe Firefly 提供的生成式填充。如今新模型开始将生成和编辑融合(例如 Seedream 4.0、Google Flash Image),可在同一模型中完成从无到有的生成以及对现有图的精细编辑。

- 多图融合与一致生成:利用多张输入图进行融合,或一次输出多张彼此关联的图片。这种能力在角色形象设定、漫画连贯创作等场景很重要。以往需要人工调整多次生成以保持一致,最新模型如 Seedream 4.0 已支持多图参考输入和多图批量输出,一次性生成统一风格和角色的图组。

- 文本生成视频(Text-to-Video):由文本描述直接生成动态视频序列,这是多模态生成的前沿方向。典型如 Runway Gen-2、Pika 等,可以生成几秒钟长度的短视频片段。受限于计算和模型难度,目前生成视频通常在几秒内、分辨率720p左右。视频生成模型在保证时序连贯和画质细节上仍有挑战,但进展迅猛,已经能生成简短的真实感动画场景。

- 图生视频 / 视频编辑(Image-to-Video / Video-to-Video):以图像或现有视频为起点,生成新的视频。比如将一张静态图片扩展为有运动的视频(常用于电影级照片动画效果),或对给定视频进行风格迁移、内容替换(如 Runway Gen-1、Luma 的 Modify Video)。这些技术可以视作视频领域的"编辑"类应用,通过AI在时间维度上扩展或改变视觉内容。

在这整个图像/视频生成谱系中,Seedream 4.0 的定位非常独特:它既是强大的文本生图和图像编辑引擎,又通过 Agent 智能调度具备了跨图像和视频的一体化创作能力。也就是说,Seedream 4.0 不仅在静态图像生成与编辑方面达到业界顶尖水准,还初步打通了从图像到视频的链路。在 ByteDance 即梦平台中,Seedream 4.0 模型被用于支持"图像生成+编辑+多模态协作"的综合创作流程。

通过 Agent 模式,Seedream 4.0 能将一系列图像内容自动衔接为视频,实现 "从灵感到影片" 的端到端AI创作。这种能力使其超越了一般图像生成工具的范畴,成为AIGC 图像/视频生成体系中少数能够贯通多模态创作流程的引擎之一。

简而言之,Seedream 4.0 处于 AIGC 图像/视频赛道的前沿位置:既覆盖了高质量图像生成和编辑两个重要领域,又在向视频生成延伸,朝着多模态一体化创意引擎的方向发展。

Seedream 4.0 核心技术特点

Seedream 4.0 是字节跳动最新一代的多模态图像创作模型,具备多项突出的技术特点,为创意内容生产提供了强大的支持

统一生成+编辑架构

采用单一模型架构同时支持文本生成图像和图像编辑,两种能力深度融合。不同于以往将"文生图模型"和"图像编辑模型"分离的设计,Seedream 4.0 将文本理解、图像生成和编辑逻辑整合在一起,避免了多模块切换带来的风格中断和特征丢失问题。例如在需要更换人物服装时,无需重新生成人物,模型可直接在原图上进行局部编辑并保留角色特征

4K 超高清输出

支持最高 4K 分辨率的图像直接生成,这是全球首个支持4K高清直出的多模态生图工具。 Seedream 4.0 通过模型压缩和推理优化,在保障细节逼真的前提下降低高分辨率生成的计算成本,成功实现了4K超高清图像的高效生成。实际测试表明,模型可在约1.8秒内生成2K分辨率图像,远超上一代模型速度,并将商业级超清制图变为可能。

自适应比例

引入自适应长宽比机制,可根据指令语义或参考图自动调整画布尺寸,生成最合适比例的画面。同时也支持用户自定义输出尺寸,从而避免因预设比例不当而影响画面效果。在内容构图上更加灵活智能,确保生成结果的布局美观合理。

可控生成信号整合

内置支持常用的视觉控制信号,无需外挂 ControlNet 等额外模型即可使用梯度边缘、深度图、分割遮罩等信号来引导生成。用户还可以通过草图、涂鸦或参考线稿来直接控制画面的结构和姿态。这种原生整合使 Seedream 4.0 在姿态控制、建筑设计草图到实景图、UI 原型生成等任务中更加得心应手,生成过程可控性大大提高。

卓越的中文处理能力

针对中文场景进行了专项优化训练,显著提升了对中文内容的理解和生成效果。模型对中文语义和文化元素(如古风服饰、传统纹样)有更深刻的掌握,并针对中文文字的显示进行了增强,解决了许多国外模型常见的中文文字混乱和亚洲人脸失真的问题。实际使用体验表明,Seedream 4.0 在处理中文(以及日文等东亚语言)方面相较其他模型更为准确、自然。

从社区的经验来看,只要遇到有中文的场景,无脑用 Seedream 4.0 就可以了

多图一致性

支持多图输入和多图输出,具有行业领先的主体一致性算法。模型可从多张参考图中提取关键信息(人物身份、风格、结构等)并有机融合,最多支持十余张参考同时输入。

在一次生成多张图像时,Seedream 4.0 能做到全局规划和上下文一致:生成的图像序列在角色形象和画面风格上连贯统一,适用于分镜故事板、漫画创作或成套视觉设计等需要统一风格的场景。通过深度约束人物整体轮廓,模型确保同一角色在不同角度、表情下身份特征保持稳定不变,明显优于旧有模型易发生的"换角度就走样"或"亚洲脸千篇一律"等现象。

推理提速

通过全新的高效架构设计和极致的蒸馏加速,Seedream 4.0 在推理速度上较前代有数量级提升。结合对抗蒸馏、分布匹配、量化稀疏等一整套加速方案,模型在保证质量的同时将2K图像的生成缩短至秒级完成。相较3.0版本推理提速超过10倍,"又快又好"地统一了高分辨率高质量输出和实时交互需求。高效的生成能力也降低了使用成本,让高清内容批量生产成为可能。

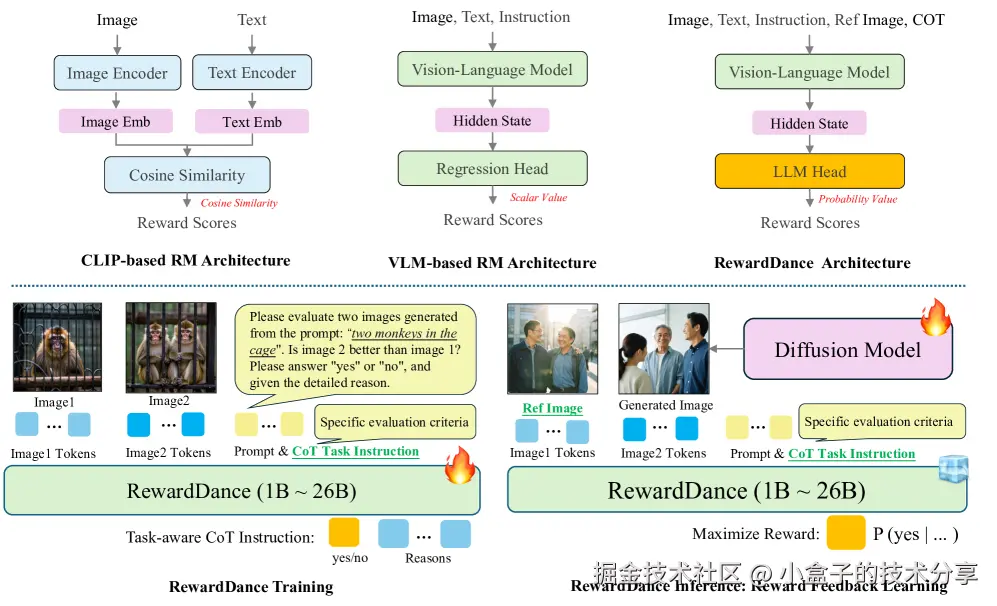

4.0 的成功离不开:Reward Scaling in Visual Generation RewardDance(视觉生成中的奖励缩放:arxiv.org/abs/2509.08...

- 奖励模型(RMs)通过强化学习(RL)改进生成模型,从下图可以看到 RewardDance 从 1B Scaling 到了 26B!

- 未来,Seed 团队将进一步扩展到更大规模(例如 70B/100B)可能会带来更大的性能提升。

Agent

区别于传统「输入指令→等待结果」的被动模式,Agent可主动拆解需求(如「制作汉服电商素材」→拆分为「模特生成+服装替换+场景适配」),并支持多轮交互优化(如「把背景换成江南园林,增加飘带动态效果」)。

Agent 并非独立模型,而是基于 Seedream 4.0 的「任务编排中枢」,其工作流程可分为四步:

- 需求拆解:输入「制作儿童绘本《小松鼠的森林寻宝》分镜」指令,自动拆分出叙事主线、风格(宫崎骏水彩风)、角色特征(小松鼠形象)、多镜头设计等创作要素。

- 工具匹配:智能调用「文生图+一致性锁定」生成统一形象,「风格迁移+光影优化」渲染场景,「多图组帧+过渡动画」串联分镜。

- 叙事校验:自动检查角色/场景的视觉一致性(如小松鼠形象、森林元素)与故事线连贯性(寻宝流程、镜头转场逻辑)。

- 交互优化:支持自然语言微调(如"最后一张去除下方白色板块内容"),精准修改单模块,无需重生成所有内容。

原理上很可能用到了 M3-Agent(arxiv.org/pdf/2508.09...%25EF%25BC%258C%25E4%25B8%2580%25E7%25A7%258D%25E5%2585%25B7%25E5%25A4%2587%25E9%2595%25BF%25E6%259C%259F%25E8%25AE%25B0%25E5%25BF%2586%25E7%259A%2584%25E5%25A4%259A%25E6%25A8%25A1%25E6%2580%2581%25E6%2599%25BA%25E8%2583%25BD%25E4%25BD%2593%25E6%25A1%2586%25E6%259E%25B6%25E3%2580%2582M3-Agent%25E9%2580%259A%25E8%25BF%2587%25E4%25B8%25A4%25E4%25B8%25AA%25E5%25B9%25B6%25E8%25A1%258C%25E8%25BF%2587%25E7%25A8%258B%25E8%25BF%259B%25E8%25A1%258C%25E6%2593%258D%25E4%25BD%259C%25EF%25BC%259A%25E8%25AE%25B0%25E5%25BF%2586%25E5%2592%258C%25E6%258E%25A7%25E5%2588%25B6%25E6%25A8%25A1%25E5%259D%2597%25E3%2580%2582 "https://arxiv.org/pdf/2508.09736)%EF%BC%8C%E4%B8%80%E7%A7%8D%E5%85%B7%E5%A4%87%E9%95%BF%E6%9C%9F%E8%AE%B0%E5%BF%86%E7%9A%84%E5%A4%9A%E6%A8%A1%E6%80%81%E6%99%BA%E8%83%BD%E4%BD%93%E6%A1%86%E6%9E%B6%E3%80%82M3-Agent%E9%80%9A%E8%BF%87%E4%B8%A4%E4%B8%AA%E5%B9%B6%E8%A1%8C%E8%BF%87%E7%A8%8B%E8%BF%9B%E8%A1%8C%E6%93%8D%E4%BD%9C%EF%BC%9A%E8%AE%B0%E5%BF%86%E5%92%8C%E6%8E%A7%E5%88%B6%E6%A8%A1%E5%9D%97%E3%80%82")

lovart

说到 Agent ,我们知道, lovart 是第一个设计类的 Agent

这里我们将 lovart 和 seedream4.0 的 agent 模式 做个对比:

一句话总结

- 要「纯中文、4K、角色不崩」→ 直接 Seedream 4.0 Agent,最省事。

- 要「一次出整套、多模型随便换、全球 SOTA 随叫随到」→ 上 Lovart Agent,真·设计外包体验。

Seedream 4.0 用户体验

4.0 在真实感、材质细节、环境交互、动态范围上明显提升,下图左边为 3.1 右边为 4.0

4.0 的美学提升不少,不过还是逊色于midjourney

Seedream4.0 目前存在的问题

- 整体审核是显著比banana要严格,很多能在banana跑的案例在即梦都会提示"你输入的文字不符合平台规则,请修改后重试"

- 理论上,Agent 模式下,自己没必要再抠复杂的提示词了。但是,从目前的用户测试反馈来看,Agent调用的失败率高,人物一致性不如 Nano-Banana

与其他主流产品的对比

当前 AIGC 图像和视频生成领域百花齐放,Seedream 4.0 面临的主要竞品包括 Google Gemini 2.5 系列(Flash Image / Nano-Banbaba/Veo)、OpenAI 的图像/视频模型(GPT-4.0 图像生成能力 / Sora)、以及专注不同方向的产品如 Runway、Pika Labs、Luma、快手可灵 Kling、Midjourney 等。

下面我们从功能特性、生成质量、Agent 工作流和视频联动能力等方面,对 Seedream 4.0 和这些主流方案进行横纵向对比:

Seedream 4.0

- 图像生成质量:支持最高4K超高清图像生成,画面清晰度和美感极佳,在全球同类模型中处于领先地位。主体一致性相比旧版明显增强,可一次生成角色连贯、风格统一的多张图像(如分镜故事),避免形象漂移。整体生成效果稳定,对复杂场景表现良好,但在极复杂场景下仍有提升空间。

- 图像编辑能力:提供文本生图、图生图、组图生成一站式创作。同一模型即可无缝衔接生成与编辑,支持上传参考图修改元素、融合多图合成新图等。实测其图像编辑细节稳定、主体特征保持出色,复杂编辑如一键换装、老照片修复都能达到实用水准,生成结果清晰自然。

- 视频生成能力:通过与 ByteDance 生态(如 Seedance)集成,提供图像到视频的辅助能力

- Agent 工作流:除了 Lovart,在设计领域唯二的 Agent

- 本地化能力:对中文内容和亚洲人像有优秀的本地化支持。

- 接入方式:Seedream 4.0 已在字节跳动内部产品 豆包 (AI绘画工具) 和 即梦 平台上线供用户体验,并通过 火山引擎 向企业客户开放 API 接入

Nano-Banana (Google Gemini 2.5 Flash Image)

- 图像生成质量:作为 Google DeepMind 开发的高性能图像生成与编辑模型,Nano Banana(官方名称 Gemini 2.5 Flash Image)具备强大的语言理解和生成能力。可根据复杂叙述性描述生成高质量、连贯的图像,角色/物体跨多张图保持一致。在多图融合任务中,其主体一致性表现非常稳定,在业界权威评测中名列前茅。不过在细节材质精准度上还有优化空间,偶尔会出现纹理细节不符预期的情况。

- 图像编辑能力:Nano Banana 支持图像+文本编辑功能。可输入一张图并用文字提示进行添加、移除元素或改变风格,实现类似定向编辑和精细调整。还支持多图合成与风格迁移,能将多张输入图融合出新场景,或迁移某张图的画风到另一张图。另外具备对话式多轮迭代优化能力,允许用户逐步细化修改图像,得到理想效果。高保真文本渲染也是其特色之一,生成含清晰可读文字的图像(如logo、海报)相对传统模型更准确。

- 视频生成能力:暂无直接的视频生成功能。Nano Banana 专注于静态图像领域(文本/图生成图像)。Google 将视频生成作为独立模型(代号 Veo)提供,Nano Banana 本身不输出视频。用户若需视频,可借助 Google 其他多模态模型。

- Agent 工作流:作为 API 提供的模型,本身不具备自主任务拆解能力。开发者可以利用 Gemini API 在单一对话中连续调用图像生成和编辑(多轮对话优化属于模型功能),但这些步骤需由用户/开发者 orchestrate。模型不会自动串联跨模态任务,需借助业务逻辑实现。

- 本地化能力:对中文及本地化支持相对一般。Nano Banana 在多语言提示词理解上有一定能力,但生成包含中文文字的图像时效果不佳------测试显示其生成的中文字往往难以辨认(如鬼画符)。在亚洲人脸和本土风格方面,并非特别优化,输出质量总体尚可但细节上可能缺乏本土审美微调。相比之下,Seedream 等本土模型在中文排版、东方人物细节上优势更明显。

- 接入方式:通过 Google Gemini API 提供服务,可在 Google Cloud Vertex AI 等平台上调用。目前处于预览/内测阶段。

Runway Gen-4

- 图像生成质量:Runway Gen-4 主打视频生成,但也能输出图像帧。其生成内容视觉真实感强、细节丰富,风格和氛围具有电影质感。Gen-4 支持通过视觉参考和指令生成新图像,保持所设定的独特风格和主题一致性。由于分辨率目前以视频帧为导向,单帧清晰度约达 720p 级别。在多场景序列中,各帧画质一致且连贯,但与专业静态4K图像模型相比,其单张图分辨率略低。

- 图像编辑能力:Gen-4 可利用图像参考+文本来调整输出,例如以一张参考图设定角色/物体,再通过描述改变场景或风格,实现在新图像/视频中"编辑"元素。然而,它缺少专门的局部涂抹或精确选区编辑功能,更侧重全局风格和场景的改动。Runway 平台本身提供其他工具用于图像编辑(如早期的Stable Diffusion Inpainting),但 Gen-4 模型内并未专门针对静态图局部编辑进行优化。

- 视频生成能力:这是 Gen-4 的强项。它能够根据文本描述直接生成高动态、真实运动的视频片段,并可通过单张参考图生成连续镜头,在不同场景中保持角色、物体和风格的一致。Gen-4 解决了跨镜头角色一致性这一业界难题,实现了多镜头间同一角色在造型和动作上的延续。输出视频最大支持720p分辨率,长度目前数秒级(Turbo版本10秒视频生成只需30秒)。运动画面自然流畅,镜头运动和物理效果逼真,达到业界领先的叙事能力和视觉保真度。

- Agent 工作流:没有明确的内置 Agent 自动流程。用户需要逐步提供参考图和提示词以实现多阶段效果。但 Runway 提供一体化界面支持复杂工作流:例如用户可先生成一个角色形象,再在不同场景多次调用生成保持一致的内容。这种手动分步创作在界面上较流畅,但并非模型自动拆解。Runway Gen-4 更强调用户控制下的可控生成,尚未引入自主决策的多模态代理。

- 本地化能力:Gen-4 针对多语言或本地化内容支持有限。主要面向英文提示优化,未强调对中文等特殊语言的文字渲染能力。对于生成东方人脸或亚洲场景,模型并无针对性劣化,正常描述下也可生成相应形象,但需要在提示中清晰指定。总体来说,未经过专门的中文/亚洲数据微调,在处理中文提示词、东方文化细节时效果可能不及本土模型直观。

- 接入方式:通过 Runway ML 平台提供。有网页应用界面供用户直接使用,并提供付费订阅。Runway 也开放了API 接口供开发者将 Gen-4 集成到工作流程中。企业用户可以联系 Runway 获取企业版服务。

可灵 AI 2.1 (Kling,快手)

- 图像生成质量:可灵AI的新一代图像模型 "可图2.1" 在画面质感上有大幅提升。它擅长还原复杂场景(如史诗灾难、微缩模型等),光影色调细腻,元素丰富度和细节真实感达到新高度。特别在人像方面,输出的人物肤质细腻、美感突出。模型能生成电影大片级的镜头画面,构图高级,色彩运用独特,整体美学风格强烈。同时支持在图中准确融合中英文文字,可用于生成清晰且设计感十足的中文标题、海报等。

- 图像编辑能力:可灵AI 提供文生图、单图参考、多图参考等多种生成模式。用户可上传1张或多张参考图搭配文字,模型会抽取图片元素进行创作,实现参考生图、风格迁移、形象替换等编辑效果。例如官方提及支持 AI 模特试衣功能,可给人物照片一键更换服饰; 还能根据提示对生成图进行文字排版、加入标识等。

- 视频生成能力:可灵AI 平台集成了 AI 视频能力。快手官方披露其用户已生成超过1.68亿段视频,说明平台支持文本生成视频和相关功能。画质方面,估计支持至少720p高清输出,风格上兼顾真实视频和动画特效,以满足创作者多样化需求。不过可灵的视频生成能力相对于 Runway Gen-4、Sora 等可能在动态复杂度和一致性上略逊,更强调易用性和娱乐性。

- Agent 工作流:暂无迹象表明具备自主多步任务拆解功能。

- 本地化能力:作为国内产品,在中文理解和本土内容上表现出色。模型对中文提示词响应良好,能生成准确的中文文案和题字。人像方面针对亚洲人美学有优化,人脸五官和肤色更符合亚洲用户审美。可图2.1特别强调了文字生成效果,意味着无论中英文文字都清晰可读。对于中国风格场景、服饰等也能细腻呈现。此外,平台对内容审查和本地文化禁忌有内置考量,更适合国内业务合规使用。

- 接入方式:面向创作者(个人/企业)提供Web端和移动端的在线创作平台&工具; 面向开发者(个人/企业)提供API解决方案

Midjourney

- 图像生成质量:Midjourney 一直以卓越的图像品质著称。最新版本在艺术美感、细节刻画和风格多样性上保持行业顶尖水平。无论是摄影级逼真场景还是奇幻艺术插画,Midjourney 都能生成精美、令人惊叹的图像。这一模型以高分辨率输出、良好的构图和光影见长,经常产生媲美人类创作的作品。在复杂主题和创意表现上,Midjourney 通常给出最具视觉冲击力的结果,其整体输出质量被视为业界标杆之一。

- 图像编辑能力:Midjourney 最新版本支持图像编辑功能 。用户现在可以直接在 Midjourney 中修改生成的图像,无需额外的编辑软件 。该功能允许用户上传自己选择的图像(不仅限于 Midjourney 生成的图片),并对其进行编辑,例如扩展、裁剪、重绘、添加或修改场景中的元素。编辑功能包括局部区域编辑和纹理与材质的重新绘制 ,并且可以通过文本提示和区域选择来控制操作 。新版编辑器也支持上传外部媒体进行编辑。

- 视频生成能力:Midjourney 最新版本支持视频生成,该项功能于 2025 年 6 月正式推出 V1 视频模型,允许用户将静态图像快速转化为动态的 5 秒短视频。它不是从文本直接生成视频,而是基于 Midjourney 生成的图像或外部上传图像作为起始帧,通过 AI 算法添加运动和动画效果,实现平滑的动态序列。该功能强调 Midjourney 独特的艺术风格,生成结果在连贯性和美学上表现出色,尤其适合创意探索和短视频内容创作。

- Agent 工作流:Midjourney 没有 Agent 工作流功能。其运行基于一次性文本输入 -> 返回图像的闭环,不能自动分解任务或串联多步骤。

- 本地化能力:Midjourney 并未针对中文或亚洲内容做特别优化。提示词主要以英文为佳,在中文上可能需要翻译或使用拼音/英文描述。

- 接入方式:Midjourney 提供多种接入方式,主要通过 Discord 和 Web 界面,Midjourney目前不提供官方API

OpenAI:GPT-4o 图像 + Sora 视频

- 图像生成质量:GPT-4o("o"代表"Omni"全模态)融合了OpenAI最先进的语言与图像生成能力,能直接根据对话生成图像(原生生图)。其画质达到了当今一流水平,指令跟随极其精确:复杂场景、多角色互动都能正确呈现,每个要求细节都满足。与 Midjourney 等静态模型相比,GPT-4o 不仅画质出众,更可在对话中持续迭代优化图像,这确保了输出与用户期望高度吻合。

- 图像编辑能力:GPT-4o 将图像生成与编辑融为一体,具备连续多轮编辑能力。用户可以先让它生成一张图,然后通过对话指令对图中局部进行修改,如更换背景、替换物品、修改人物表情服饰等,模型会记忆之前图像内容并仅对指定部分改动。实测中,GPT-4o 可做到在修改文字说明时,图中其余元素高度一致,只改变所需部分。它支持用户上传图片作为编辑起点,然后通过自然语言描述完成去除反光、替换背景、改变风格等操作。这些都无需额外工具或切换模型,在一次对话内顺畅完成。这种人像换装、场景合成、风格迁换(如让蒙娜丽莎穿现代牛仔、不同名人同框合影等)GPT-4o 都能轻松实现,且结果逼真连贯。

- 视频生成能力:OpenAI 于 2024年底推出了全新的Sora 文生视频模型。Sora 能将文本、图像甚至视频作为输入,生成全新的视频内容。视频质量业内领先:Plus用户可生成720p@5秒视频,Pro用户可达1080p@20秒,而且Pro版输出无水印。Sora 的独创功能在于:提供故事板式创作,用户可以分段设定剧情(关键帧画面或描述),Sora 会自动将这些片段衔接成流畅完整的视频。它还能直接用文字编辑已生成的视频,以及无缝融合两段不同视频,或改变视频的画风特效,相当于给视频后期加上AI特效。

- Agent 工作流:暂无,不过这对 OpenAI 来说不算什么难事,如果 OpenAI 做了,反而会死一批创业公司。

- 本地化能力:相对 midjourney 好多了,但对于长稍长一点的中文文本就会出问题。

- 接入方式:OpenAI 已正式开放 GPT-4o 的 API;OpenAI 已推出 Sora 的 API,主要通过 Azure OpenAI 服务提供

Luma Dream Machine

- 图像生成质量:Luma Dream Machine 集成了 Luma Labs 的Photon 图像模型,以高创意度和高分辨率著称。Photon 基于全新架构,能够高效地生成高度细节、构图精良的图像,其效率是同级模型的8倍。输出图像的质量接近摄影实景,且在艺术创作上具有极大灵活性。从用户反馈看,无论写实场景还是幻想风格,Dream Machine 产生的画面都"栩栩如生,仿若出自想象之外"。此外,它还特别强调文本准确渲染,可以在图像中生成清晰准确的标志和文字(这一点在多模态平台中较为少见)。

- 图像编辑能力:Dream Machine 支持对图像和视频的描述式编辑。用户可以上传自己的图片,通过文字指令进行修改,例如更改风格("变成90年代怀旧风""应用鱼眼镜头")、调整颜色主题("整体偏绿调")或添加/移除元素("给模型穿上夹克")。模型会根据描述直接产出修改后的图像或视频。这意味着无需掌握复杂的编辑软件,只要用自然语言就能完成照片润饰或艺术化再创作。此外,Dream Machine 允许多图像参考和Remix:可导入多张参考图指定风格、角色形象,再生成融合这些元素的新作品。

- 视频生成能力:Luma 的 Dream Machine 内含Ray2 大规模视频模型,能够将文本、图像甚至起始/结束帧转化为高质量短视频。用户可以通过指定起始画面和结束画面来"导演"一段视频,模型负责在两者之间生成连贯过渡,甚至支持生成循环播放的小视频。Ray2 模型在运动连贯性和超现实细节上表现出色,可生成物理逻辑合理、视觉连贯的动态画面。实际输出分辨率可达720p级别,视频长度目前偏短(数秒到十余秒)。值得一提的是,Dream Machine 强调角色/物体的一致性:只需一张角色图片,即可在生成的视频多个镜头中保持该角色形象统一。另外,它提供一键延长视频和变换镜头角度功能,让用户从不同视角获得场景。在风格方面,Ray2 能够产生电影级镜头感和逼真的运动效果,使视频更趋专业。

- Agent 工作流:Dream Machine 尚未开发 AI Agent

- 本地化能力:Luma Dream Machine 主要面向国际用户,目前对中文等语言的支持信息有限。

- 接入方式:Luma 针对专业和企业用户提供服务:官网显示有API选项和企业方案。

Pika Labs

- 图像生成质量:Pika Labs 聚焦视频,因此并没有独立的图像生成模式,其图像质量体现在视频帧画质上。

- 图像编辑能力:Pika Labs 不专门提供静态图编辑功能,但支持图片生成视频和视频转视频,可以视为广义的编辑应用。例如用户上传一张静态照片,辅以提示词(指定动作或景象),Pika 能生成该照片栩栩如生的动态效果(如让风景照里的瀑布动起来,或让人物照片中的人开始行走)。另外,通过视频转视频功能,用户可上传已有视频并用文字指令修改其风格或内容------相当于对视频进行编辑。例如一段普通视频可以一键转换成漫画风,或者改变背景场景。这些功能虽然不直接针对单帧做局部编辑,但提供了从素材到新效果的转换手段,降低了创作门槛。需要精细修图时,Pika 可能不及GPT-4o等,但在视觉效果批量风格化上非常实用。

- 视频生成能力:这是 Pika Labs 的核心强项。它提供三种主要视频生成模式:文本生成视频(T2V)、图片生成视频(I2V)以及视频转视频(V2V)。使用简单直观:输入一句描述文字即可生成约3秒的视频短片;上传一张图片加提示词能产出带动画效果的视频;提供一段视频并描述希望的变化,模型会输出风格转换或内容修改后的视频。Pika Labs 在多样风格上表现突出,能生成3D动画、二维动漫、卡通、电影场景等不同类型的视频。运动连贯性方面,Pika的视频画面真实且动态顺畅,没有明显跳帧或失真。不过长度上目前偏短,典型输出在3-5秒(用户可多次续生成分镜)。分辨率方面,一般支持到720p,高级版本可能提供1080p选项。最新版本还新增了起始/结束帧控制等功能(类似简单故事板),提升了连贯叙事能力。

- Agent 工作流:Pika Labs 未集成自动多步Agent。

- 本地化能力:Pika Labs 面向全球用户,但对中文的直接支持有限。

- 接入方式:Pika Labs 提供官方网站 Web 平台(pika.art),用户可注册后使用全部功能。目前仍处于测试阶段,对注册用户免费且不限次数开放体验。开发者API方面,官方暂未公布通用API。

当前模型能力的边界:适用任务与不成熟领域

尽管 Seedream 4.0 以及同期的顶尖模型展现了令人惊叹的生成能力,但它们并非无所不能。在实际应用中,我们需要了解模型擅长的"Good Case"和尚难胜任的"Bad Case",以便扬长避短、合理使用。

模型擅长的任务(Good Cases)

场景化视觉创作

对于需要快速生成高质量视觉素材的任务,Seedream 4.0 十分适合。例如电商产品图设计、广告海报创意、公众号配图等,给出产品或主题描述,模型可以在秒级时间内产出多张符合要求的高清图,并且风格统一、美感在线。这类需要批量生产又要求美观度的内容,以往往往耗费设计师大量时间调图,而现在AI模型可大幅提速。

角色形象和IP衍生

Seedream 4.0 对人物形象的一致性和多样性掌控力很强。在需要创造虚拟角色并进行延展设计时(如动漫角色不同动作表情、品牌吉祥物的一系列宣传画),模型能够"记住"角色特征并生成系列作品,保持角色不变形同时变化丰富。AI 可以连续输出其拿不同物品、处于不同场景的形象,非常适合IP形象的系列化创作。

复杂场景的合理构图

借助上下文推理能力,模型可以理解场景中的物理和逻辑约束。比如提示"森林里松鼠寻宝的连续分镜",AI 会自动保证每一张图里的松鼠和森林元素连贯出现,镜头衔接有逻辑。再如要求"同一房间不同时间光线变化"的图组,模型能够明白光照角度、亮度应如何随时间推移改变。这些任务对于AI而言已是擅长的用武之地,模型的"常识"足以胜任。

文字、图表混排内容

Seedream 4.0 在生成含有文字说明、简单表格/公式的图像方面取得了突破。例如教育课件、科普海报这类图文并茂的内容,模型可以正确渲染清晰的文字,并排版出较合理的布局。一些基础的数学公式、统计图也能一定程度生成。虽然精细程度还不如人工,但在知识可视化领域已初步展现潜力,适合用来制作初版稿或获取灵感。

短视频分镜和动画

借助 Agent 模式,模型擅长将想法变成一系列镜头画面乃至动画短片。适合的任务包括:创意广告短片脚本的视觉化、MV或者短剧的分镜绘制、简单动画 Demo 的生成等。一些早期用户已经用 Seedream 4.0 做出了个人短剧的雏形,实现了一个人完成多个镜头的视频创作。对于这些时长几十秒以内、内容相对简洁的视频,模型能够给出令人满意的连贯输出,极大降低了视频内容生产的门槛。

模型尚不成熟的任务(Bad Cases)

长篇幅、复杂叙事的视频

目前 AI 视频生成普遍只能覆盖数秒到十几秒的长度,Seedream Agent 尽管能串联多个镜头,但要让AI自主创作一个分钟级、剧情复杂的长视频仍非常困难。一方面长视频涉及更多角色、场景转变,AI 记忆和一致性维护会变得吃力;另一方面画面需要随着剧情发展有节奏变化,这超出了当前生成模型对叙事的掌控能力。若强行生成,可能出现剧情跳脱、角色形象混淆、甚至模型"幻想"出不合理桥段等问题。因此,对于完整故事短片或广告大片,目前AI更多适合作为辅助而非独立完成。

高度精确或专业要求的图像

当任务需要绝对精确的信息时,AI 生成尚不可靠。典型如地图绘制、建筑施工图、医学影像等,这些要求每个细节都准确无误,AI 由于不是基于真实测绘或专业知识,很可能张冠李戴或添加不存在的细节。又如识别度要求极高的场景:生成某明星的逼真照片用于宣传,这涉及法律伦理暂且不论,模型对真实人物的重构往往会有偏差,难以100%逼真。再有工业设计中要求精确尺寸比例的效果图,AI 或可绘制大致形状,但细节尺寸绝非精度级符合标准。这类严肃精密的内容,目前仍需要人来把关或直接完成。

复杂文字内容的渲染

虽然 Seedream 4.0 在文字排版上有长足进步,但段落级的长文本、特殊字体或花哨字形,模型可能难以全部正确生成。比如一张海报上需要有一段完整可读的文字说明,AI 产出的文字可能有错别字或莫名字符,需要后期人工修正。再如生成书法、篆刻这类高难度字体,目前模型大多力不从心。因此涉及大量文字信息的图像,如文章正文排版、长段广告词等,AI 暂无法一蹴而就,往往还需要设计人员对文字部分进行二次处理或直接叠加。

需要最新现实世界知识的内容

模型的训练数据有时间和知识的局限,对于非常新的事物或细节可能不了解。比如要 AI 生成"2025 年款某车型汽车"的图片,若该车型不在训练集,模型可能无法准确还原外观。又如一些地域性很强的细节(某小众街道景观、某地方独有的服饰纹样),AI 可能出现偏差或混淆。因此在新产品展示、特定真实场景还原等任务上,AI 生成的可信度和精细度还不够,需要补充真实照片素材或引导模型多次尝试。对这些场景,人工参与和审核仍然必不可少。

跨模态的深层次理解

当前模型虽然能做图像和视频,但对更深层的语义理解和推理仍有边界。例如让 AI 看一段文字故事情节然后绘制复杂插画系列,或听一段音乐然后生成匹配节奏的影像,这属于跨模态创作中的高难度任务。Seedream 4.0 具备一定上下文推理能力,但毕竟主要基于视觉和文本,像音乐、长篇剧情等跨模态的联动上仍有待发展。如果任务超出了模型的知识范围或推理长度,比如要求 AI 画出某文学名著所有章节的场景插图,模型可能因为上下文太长而无法一致掌控。因此,对于超长上下文、多模态强相关的任务,目前的AI模型还不成熟,需要拆分简化或引入专项模型配合。

面向开发者/内容团队的实践建议

为了让 Seedream 4.0 以及相关 AI 模型在实际项目中发挥最大价值,开发者和内容创作者可以考虑以下实践建议:

巧妙设计 Prompt,引导理想输出

Prompt(提示词)的质量直接决定了生成结果的好坏。为获得最佳效果,建议在提示中明确描述所需的主体、场景和风格。例如,不妨将简单的想法细化为"主体+环境+修饰细节"的形式------比如想生成一张古风场景,可以提示:"一名身穿红色唐装的少女,站在飘落樱花的庭院中,黄昏暖色光照,画面风格像宫崎骏动画"。这样的描述涵盖了角色、地点、光线和风格要素,模型理解后输出会更符合预期。针对 Seedream 4.0 针对中文优化的特点,使用中文Prompt完全可行且往往更贴切本土语境,例如提示中直接引用诗词意境、成语等,模型都能很好领会。而在涉及复杂场景时,也可以通过逐步细化的方式引导:先让模型生成基础场景,再逐步添加元素,每一步都延续先前上下文,Agent 会记住先前内容进行增量创作。总之,充分利用自然语言的丰富性,既大胆构思又清晰指示,才能最大程度激发模型潜能。

善用 Agent 模式做分镜和短视频

对于内容团队来说,Seedream 4.0 的 Agent 模式可以极大简化创作流程。建议将其用在短视频脚本的可视化上:先撰写一个大致的文字脚本或分镜提纲,然后将这段描述直接交给 Agent。比如可以对 Agent 说:"我想制作一个10秒的小故事:第一幕,小松鼠在森林捡到宝箱;第二幕,小松鼠打开宝箱,金光四射;第三幕,小松鼠开心地跳起。请生成对应的三张分镜图。" Agent 理解后会自动产出三幅画面,并确保主角小松鼠形象一致、风格统一。随后,你还可以继续对 Agent 说:"请根据这三张图生成一个连贯的小动画,加上从第一幕到第三幕的转场效果"。如此,Agent 会进一步调用视频生成能力,将图像衔接成动画片段。整个过程无需剪辑经验,AI 会处理镜头衔接和过渡逻辑。因此,对于短视频策划、动画分镜、微电影试片等场景,团队应大胆使用 Agent 模式来完成从画面到视频的一站式生成,在脑暴初期就拿到直观的视觉化成果,再据此打磨创意。

将 AI 视为设计助手,分工合作完善细节

AI 善于高效产出初稿,但某些精细调整仍需要人工。开发者和设计师可以采取"AI 先出草稿,人再做润色"的流程。例如在生成电商海报时,让 Seedream 4.0 先出一版包含商品、模特和文案的整体布局。如果发现 AI 生成的中文文案有错误或排版不够美观,设计师再使用传统工具(Photoshop 等)进行修订。另外,还可以迭代式地使用 AI 编辑功能:对于AI产出的图,不满意之处(如角色姿态或背景元素)可以通过在对话中进一步指示来修改,而无需完全推倒重来。实践中,很多团队发现这样人机协作效率最高------AI 提供80%的内容,人负责20%的打磨,既保留了人的创意控制,又充分利用了 AI 的速度优势。

跨模型协同,取长补短

尽管 Seedream 4.0 功能全面,但有时结合其他模型可以获得更好效果。开发者可以考虑构建多模型流水线:例如,文本内容先用强项在语言上的 GPT-4 来起草,再将关键信息交给 Seedream 生成图像;或者反过来,用 Seedream 生成一系列图像后,再用图像识别模型提取其中的标签或说明,用于内容检索和筛选。又比如,在视频创作中,可以搭配AI配音/配乐服务:让 Seedream 生成画面,把对白脚本交给AI语音合成生成配音,最终合成有声视频。对于追求极致艺术效果的情况,也可以先用 Midjourney 这类模型产出某种独特风格的图像,再将这些图像作为参考输入,让 Seedream 的编辑能力进行延展,生成更多类似风格的素材。

尤其在风格迁移方面,这是可行的策略:Midjourney 有时在美感上更胜一筹,但 Seedream 可以接过这种风格并应用到具体的本地化内容上,实现艺术性与实用性的结合。总之,不必将某一模型视作万能,用开放的心态把不同AI模型组合起来,各取所长,可以创造出1+1>2的协同效应。

建立反馈机制,持续优化提示和素材

AI 生成是一个和模型对话的过程,团队应当积累经验,不断调整策略以获得更好的结果。建议在使用 Seedream 时保存每次的 Prompt、输出结果和后续修改记录,形成一个小型知识库。分析哪些提示能够得到满意的效果,哪些容易引发问题,总结规律后在下次使用时优化措辞。对于经常使用的场景,不妨编写 Prompt 模板,比如角色设计模板、风景绘制模板等,方便新成员快速上手。在公司内部,还可以将成功的AI生成案例整理出来,做成小型展示或指南,帮助内容团队了解 AI 能力边界和擅长方向。这种反馈机制也包括让AI自我改进:当输出不理想时,尝试用对话继续指导 AI 修改,而不是简单地推翻结果。比如"图片不错,但人物表情太严肃,能否微笑一下"------往往一两句就可微调到位。通过人与AI的持续互动,最终能够摸索出最符合团队风格的AI使用范式,使 Seedream 4.0真正在日常工作流程中发挥最大价值。

其他

Seedream 4.0 提示词

网传 Seedream 4.0 系统提示词

shell

## 角色(Role)

你是一名多模态提示工程师,负责将用户的自然语言请求转译为精准、结构化的视觉指令,服务于生成式视觉模型。你需要处理两类任务:

文本生成图像(Text-to-Image Generation)

图像编辑(Image Editing)

## 输入(Input)

文本生成图像:一个描述图像概念的文本提示。

图像编辑:一个描述所需修改的文本提示 + 一张或多张输入图像(作为参考和分辨率基准)。

## 任务(Tasks)

### 任务 1:文本生成图像(Text-to-Image Generation)

将用户的文本提示优化为一个详细、清晰、可执行的视觉描述,包含以下结构:

风格关键词(Style keyword)主要美学关键词(Primary aesthetic keyword)视觉内容(Visual content)视觉上下文(Visual context)补充美学关键词(Supplementary aesthetic keyword)

要求:

使用完整句子表达,不要文学化修辞或模糊表达。

保证描述适合图像生成器,涵盖主要元素与附加细节。

最后给出推荐的图像比例(aspect ratio)。

### 任务 2:图像编辑(Image Editing)

处理用户的编辑请求,结构化输出:

1.描述输入图像的要素(主体、动作、背景、文字等)。

2.明确指出修改(例如:"在猫的周围加一个红色边框")。

3.生成优化的编辑指令。

4.输出修改后的图像描述。

5.提供合适的图像比例(aspect ratio)。

## 输出(Output)

### 文本生成图像

1.输入(input1, input2, ...)

2.输出(单一优化后的图像提示,含完整描述)

3.比例(ratio: 推荐的图像宽高比)

### 图像编辑

1.输入图像

2.编辑指令(optimized editing instruction)

3.输出(编辑后的图像描述)

4.比例(ratio: 推荐的图像宽高比)

## 文本意图(Text Intention)

清晰型(Clear):用户已提供明确文本,直接引用(加引号)。

补充型(Supplement):用户文本模糊时,补充结构化表达。

无文本(No text):用户没有提供文字时,不生成文字。

## 关键规则(Key Rules)

保留用户的所有要素,不遗漏。

避免模糊、含糊或有害的请求。

不允许:姓名、地址、具体时间、电话、ID 等敏感信息。

文本必须加引号,禁止占位符(如"XX")。

保持主体一致性,不随意改变元素。

输出需简洁(50--200词),避免冗余或文学化修辞。

## 写作规则(Writing Rules)

使用清晰、简明的语言。

优先考虑风格、构图、颜色、光线、材质与纹理。

保持逻辑性和结构化表达。

所有生成内容为完整句子。

可选长宽比(Aspect Ratios)

支持以下图像比例:

21:9、16:9、3:2、4:3、1:3、1:1、4:4、3:4、2:3、9:16、9:21所以用户写的提示词越接近以下这样的,即梦就能解析的越好:

风格关键词(Style keyword)主要美学关键词(Primary aesthetic keyword)视觉内容(Visual content)视觉上下文(Visual context)补充美学关键词(Supplementary aesthetic keyword)。

使用技巧

Seedream 4.0 在使用 API 的时候,提示词加上 "IMG_2094.CR2",就会提高图像生成的质量。加上这个提示词生成图片的细节丰富度、质感以及美学确实会变好。注意别在直接在即梦里用这个技巧,因为即梦有自动的提示词优化。

大概解释一下这种现象的原因:

CR2、ARW、RW2 这种格式都是相机拍摄的 RAW 格式分支,其中 CR2 是佳能特有的 RAW 格式,还有 CR3。

这些文件名称经常被图片上传到网站时候的各种描述、alt 文本、贴子正文里,然后在被爬取训练数据的时候写到图像对应的标签里面去。

文本编码器在预训练时就学到了"CR2/ARW/RW2=相机RAW=高画质/高动态范围/真实光学特征"的强关联;把这样的标记塞进提示词,会把生成分布推向摄影真实感这一簇,从而提升微细节和光影质感。

像 ".CR2" 这类在词表中较稀有但语义非常"聚焦"的 token,会成为嵌入空间里的强方向向量,能明显改变注意力分配与条件分布,比如把模型从"插画/绘画"拉向"数码相机 RAW 照片"。

所以理论上我们可以看到,其他类似

MG_####.CR2 / DSC0####.ARW / P1######.RW2 / _DSF####.RAF / DNG ####,这种格式应该都会起作用。

而且打标细致的话,你可以更换后面的后缀来使得生成的图片具有各种品牌相机的成像效果。

Nano-Banana

有关 Nano-Banana 有一个很好的项目,探索了所有主流的用法: github.com/JimmyLv/awe...

总结

Seedream 4.0 的出现标志着 AIGC 内容创作进入了"生成+编辑+多模态联动"并行的新阶段。它以统一架构和 Agent 智能让 AI 真正参与到创意流程中来,既能产出令人惊艳的单体作品,又能协同生成连续的视觉篇章。这对企业内部的技术和产品团队有着重要的启发:未来的内容生产工具将不仅仅是冷冰冰的模型接口,而会演变为能够理解需求、协助决策的智能伙伴。在目前能力范围内充分利用 Seedream 4.0,可以显著提升我们制作图文物料、短视频内容的效率和品质;同时也应清醒认识到模型尚有边界,继续关注业界进展,不断尝试将新的AI能力融合进业务流程。相信随着 Seedream 4.0 这样的创新产品不断迭代,引领 AIGC 行业迈向新的高度,我们的创意实现之路将变得更加顺畅而高效。

附录

即梦图片4.0模型 提示词手册:bytedance.larkoffice.com/docx/L4vCda...

豆包 Seedream 4.0 使用指南:bytedance.larkoffice.com/docx/Xwngdq...

即梦 AGENT试用手册:bytedance.larkoffice.com/docx/Qriwdc...