💖💖作者:计算机编程小央姐

💙💙个人简介:曾长期从事计算机专业培训教学,本人也热爱上课教学,语言擅长Java、微信小程序、Python、Golang、安卓Android等,开发项目包括大数据、深度学习、网站、小程序、安卓、算法。平常会做一些项目定制化开发、代码讲解、答辩教学、文档编写、也懂一些降重方面的技巧。平常喜欢分享一些自己开发中遇到的问题的解决办法,也喜欢交流技术,大家有技术代码这一块的问题可以问我!

💛💛想说的话:感谢大家的关注与支持! 💜💜

💕💕文末获取源码

目录

-

- 【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统功能介绍

- 【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统技术介绍

- 【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统背景意义

- 【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统演示视频

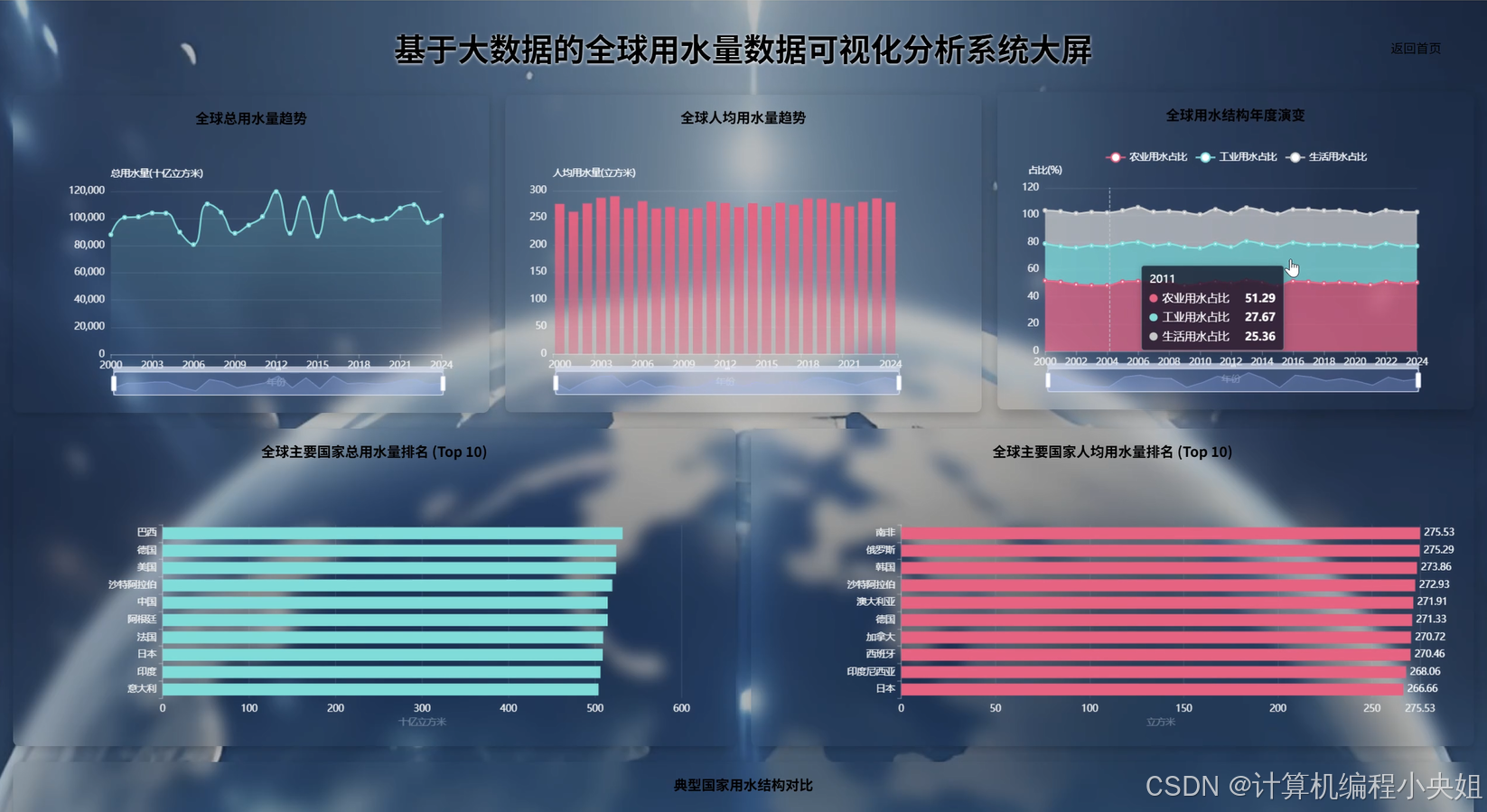

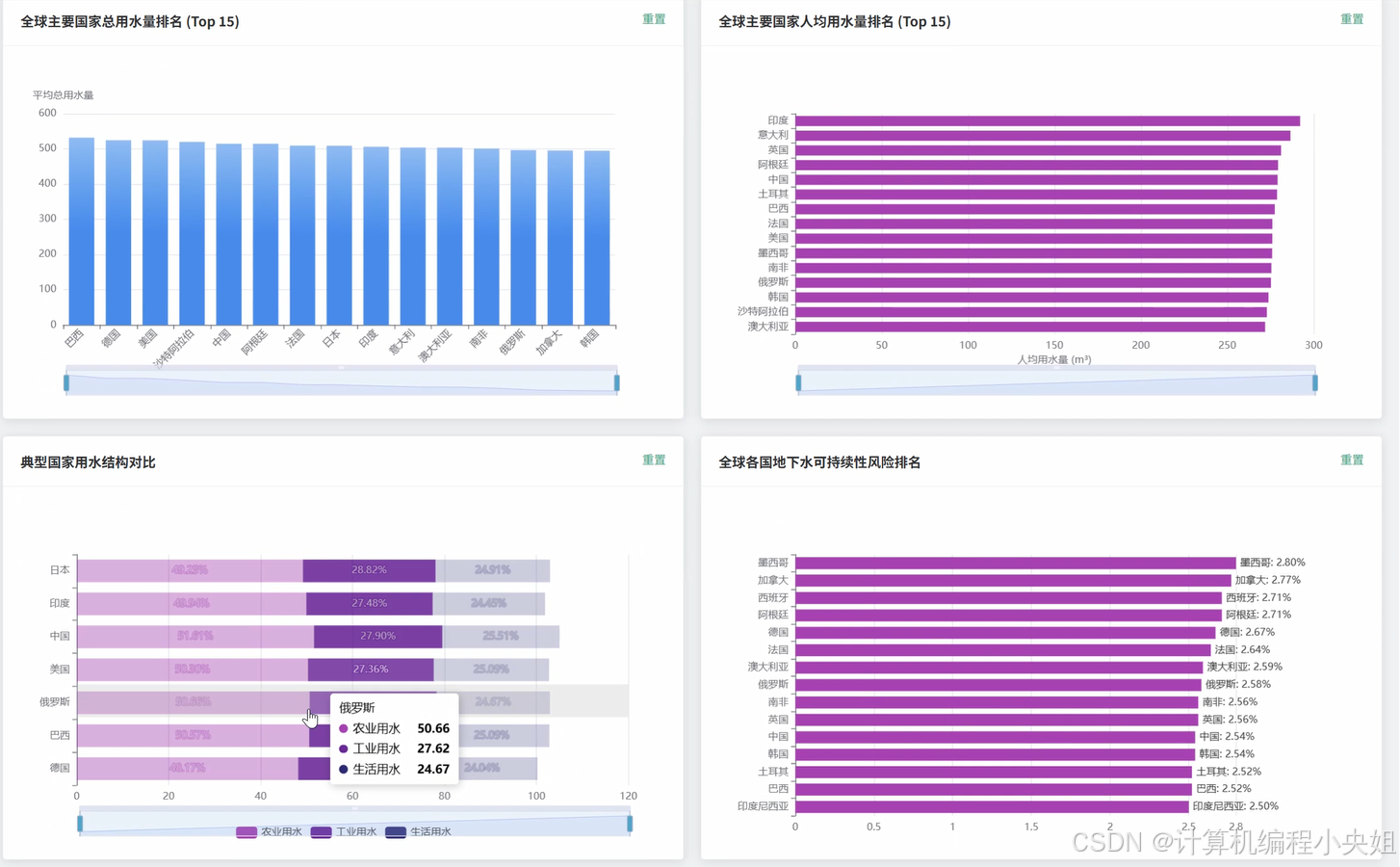

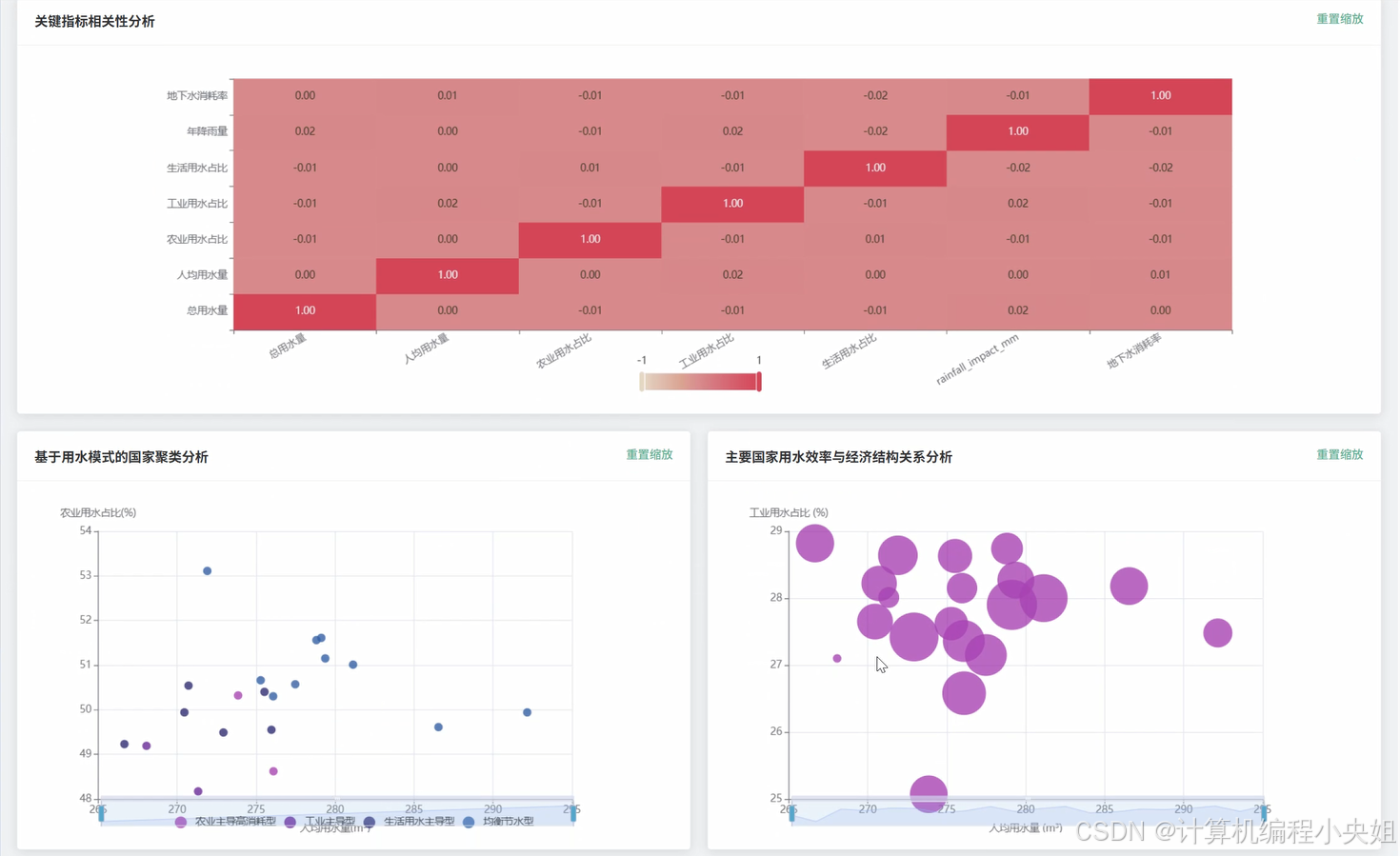

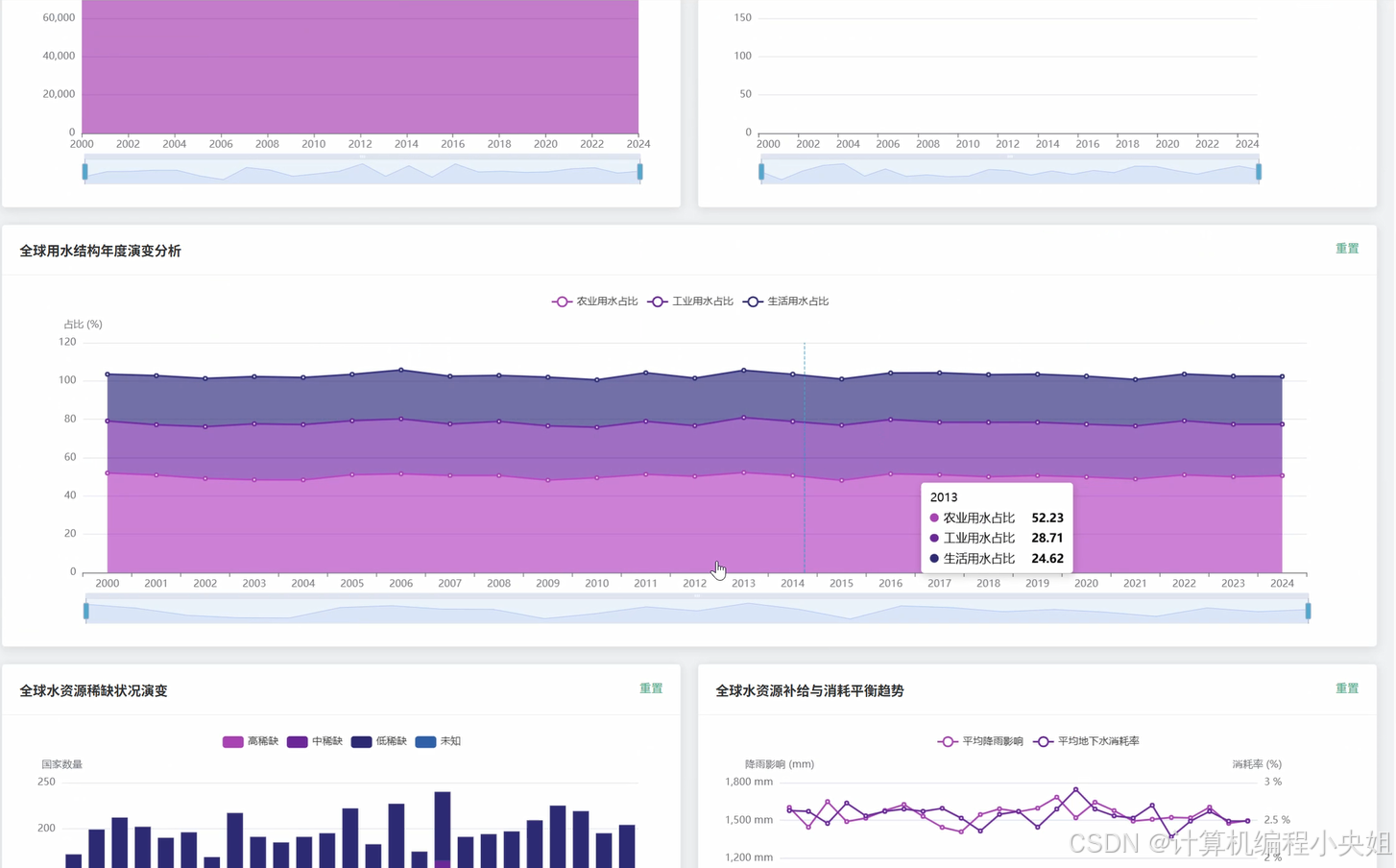

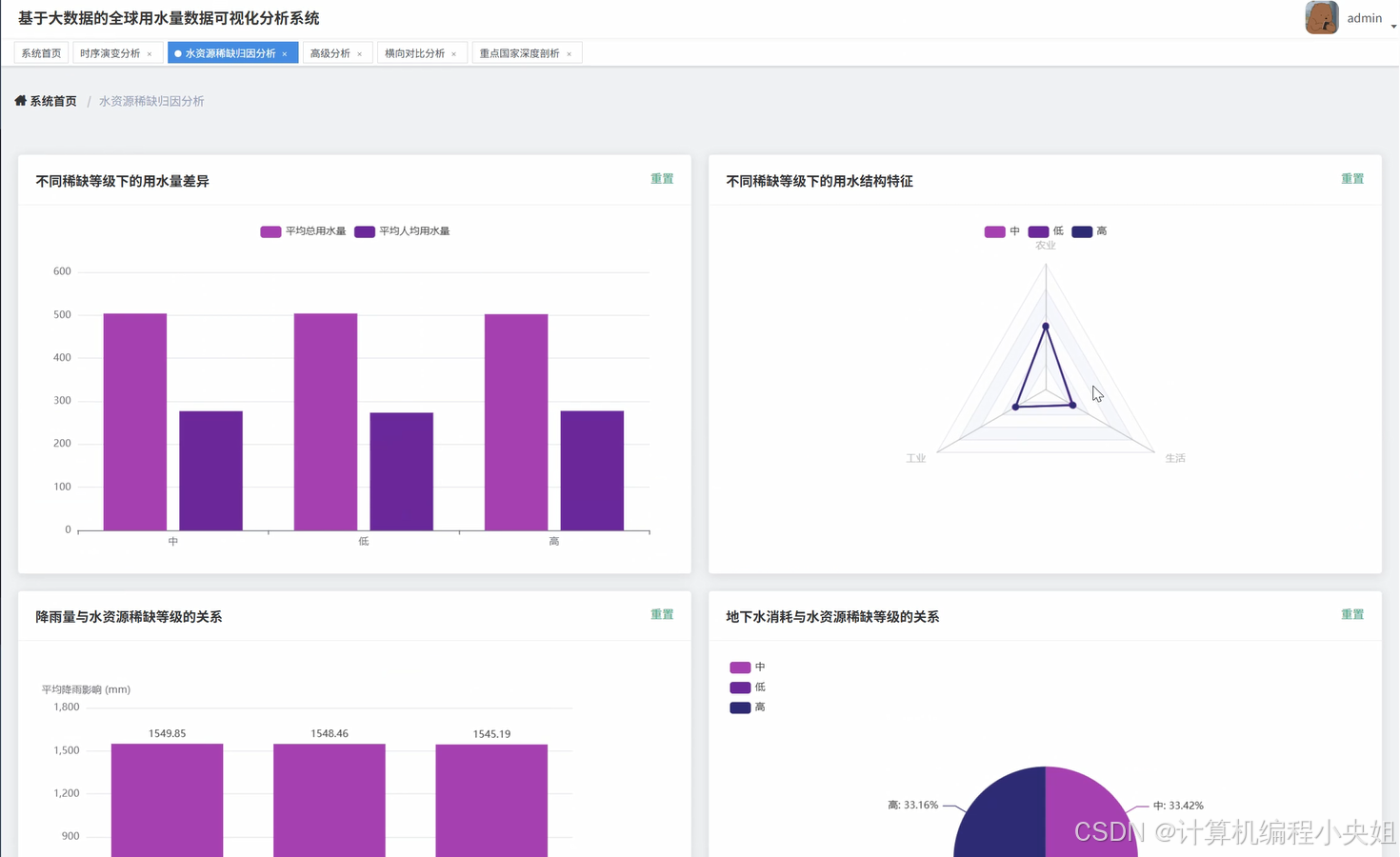

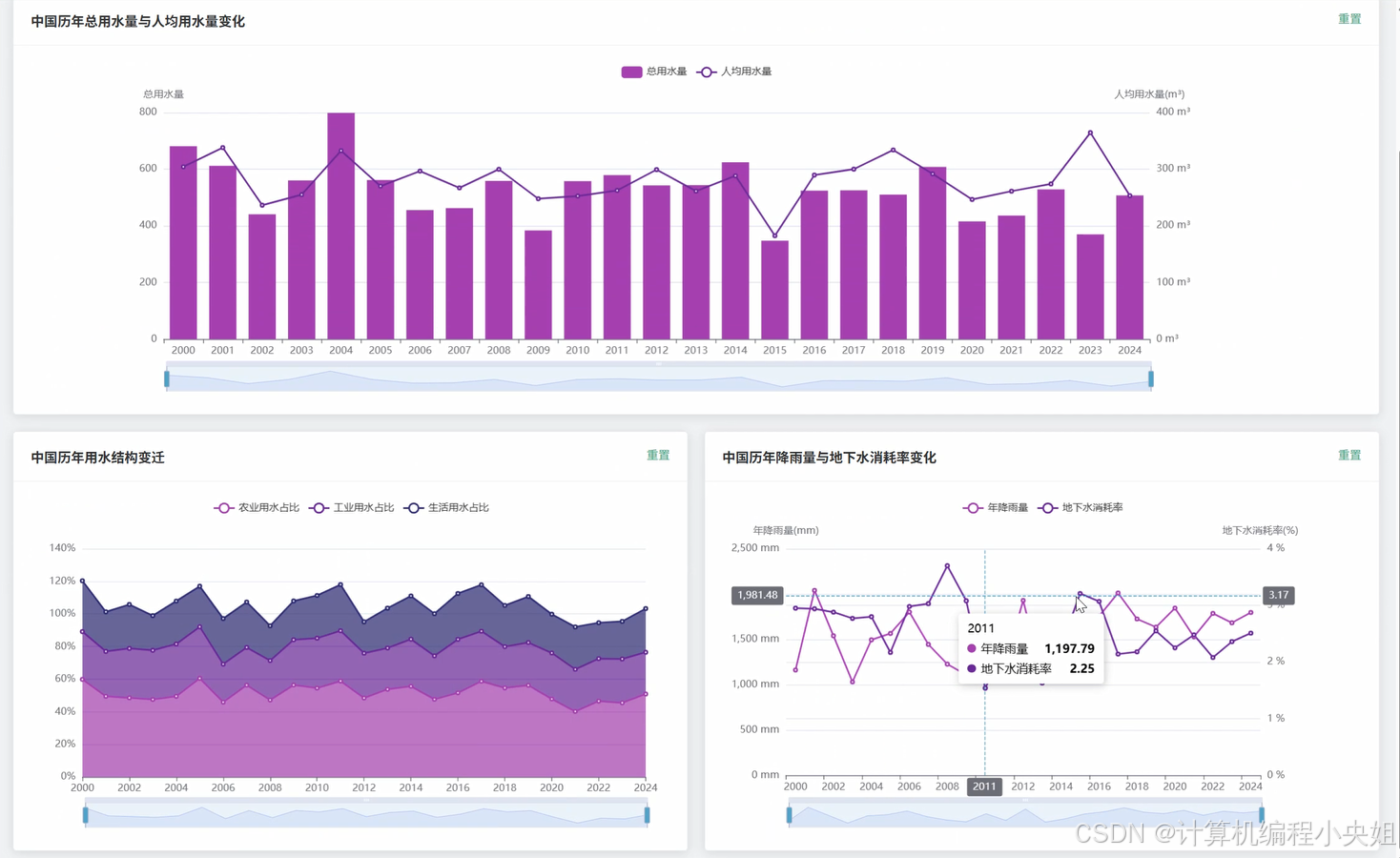

- 【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统演示图片

- 【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统部分代码

- 【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-结语

【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统功能介绍

基于Spark+Hadoop的全球用水量数据可视化分析系统是一个综合运用大数据技术栈的水资源数据分析平台,通过Hadoop分布式文件系统存储海量的全球各国用水数据,利用Spark强大的内存计算能力和Hive数据仓库技术进行高效的数据处理与分析。系统采用Python作为主要开发语言,后端基于Django框架构建RESTful API接口,前端采用Vue+ElementUI+Echarts技术栈实现交互式数据可视化界面。系统核心功能涵盖全球水资源消耗时序演变分析、各国用水特征横向对比、水资源稀缺性专题归因分析、重点国家水资源状况深度剖析以及基于机器学习的多维指标关联与聚类探索等五大分析维度。通过Spark SQL进行复杂的数据查询与统计分析,结合Pandas和NumPy进行数据预处理,最终将分析结果通过Echarts图表库以柱状图、折线图、散点图、热力图等多种可视化形式呈现,为用户提供直观清晰的全球水资源利用状况洞察,支持多维度的数据钻取和交互式探索分析。

【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统技术介绍

大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

开发语言:Python+Java(两个版本都支持)

后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

数据库:MySQL

【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统背景意义

随着全球人口持续增长和经济快速发展,水资源短缺问题日益凸显成为影响人类可持续发展的重大挑战。世界各国在工业化和城镇化进程中对水资源的需求不断攀升,而气候变化导致的极端天气事件又加剧了水资源分配的不均衡性。传统的水资源管理方式主要依靠人工统计和小规模数据分析,面对海量的全球水资源数据往往显得力不从心,无法及时发现用水规律和潜在风险。大数据技术的快速发展为解决这一问题提供了新的思路和工具,通过Hadoop分布式存储和Spark内存计算技术,能够高效处理TB级别的全球水资源数据,深入挖掘各国用水模式、时序变化趋势以及关键影响因素之间的复杂关联关系。当前水资源研究领域迫切需要一个能够整合多维度数据、支持大规模并行计算、提供直观可视化展示的综合分析平台,为政府决策部门、科研机构和国际组织制定科学合理的水资源管理策略提供数据支撑。

从技术角度来看,本系统将Hadoop生态圈的核心组件与现代Web开发技术有机结合,实现了大数据存储、计算、分析和可视化的完整技术链路,为大数据在环境科学领域的应用提供了一个较为完整的实践案例。系统通过Spark的分布式计算能力处理大规模时间序列数据,运用机器学习算法进行国家用水模式聚类分析,展示了大数据技术在复杂数据挖掘任务中的实际应用价值。从实际应用层面来说,系统能够帮助研究人员快速识别全球水资源利用的关键规律和异常模式,为水资源保护政策的制定提供一些参考依据。通过多维度的数据对比分析,可以发现不同国家在用水效率、产业结构调整等方面的差异,为国际水资源合作与技术交流搭建数据平台。虽然作为毕业设计项目在规模和深度上存在一定局限性,但系统所采用的技术架构和分析方法具有良好的可扩展性,未来可以进一步集成更多数据源和分析算法,逐步发展为更加完善的水资源大数据分析平台。

【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统演示视频

【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设

【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统演示图片

【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-系统部分代码

python

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, sum, avg, count, when, collect_list

from pyspark.ml.feature import VectorAssembler

from pyspark.ml.clustering import KMeans

import pandas as pd

import numpy as np

spark = SparkSession.builder.appName("GlobalWaterDataAnalysis").config("spark.sql.adaptive.enabled", "true").config("spark.sql.adaptive.coalescePartitions.enabled", "true").getOrCreate()

def analyze_global_water_consumption_trend():

water_df = spark.sql("SELECT Year, Country, TotalWaterConsumption FROM global_water_data")

yearly_consumption = water_df.groupBy("Year").agg(sum("TotalWaterConsumption").alias("GlobalTotalConsumption"), avg("TotalWaterConsumption").alias("AverageConsumption"), count("Country").alias("CountryCount"))

yearly_trend = yearly_consumption.orderBy("Year")

growth_rate_df = yearly_trend.withColumn("PreviousYearConsumption", lag("GlobalTotalConsumption").over(Window.orderBy("Year")))

growth_rate_df = growth_rate_df.withColumn("GrowthRate", ((col("GlobalTotalConsumption") - col("PreviousYearConsumption")) / col("PreviousYearConsumption") * 100))

consumption_stats = growth_rate_df.select("Year", "GlobalTotalConsumption", "AverageConsumption", "GrowthRate").collect()

trend_analysis = []

for row in consumption_stats:

if row.GrowthRate is not None:

trend_status = "增长" if row.GrowthRate > 0 else "下降"

trend_analysis.append({"year": row.Year, "total_consumption": row.GlobalTotalConsumption, "average_consumption": row.AverageConsumption, "growth_rate": round(row.GrowthRate, 2), "trend_status": trend_status})

peak_consumption_year = yearly_trend.orderBy(col("GlobalTotalConsumption").desc()).first()

min_consumption_year = yearly_trend.orderBy(col("GlobalTotalConsumption").asc()).first()

result_data = {"trend_data": trend_analysis, "peak_year": peak_consumption_year.Year, "peak_consumption": peak_consumption_year.GlobalTotalConsumption, "min_year": min_consumption_year.Year, "min_consumption": min_consumption_year.GlobalTotalConsumption}

return result_data

def compare_countries_water_characteristics():

country_water_df = spark.sql("SELECT Country, AVG(TotalWaterConsumption) as AvgTotalConsumption, AVG(PerCapitaWaterUse) as AvgPerCapitaUse, AVG(AgriculturalWaterUse) as AvgAgricultural, AVG(IndustrialWaterUse) as AvgIndustrial, AVG(HouseholdWaterUse) as AvgHousehold, AVG(GroundwaterDepletionRate) as AvgGroundwaterDepletion FROM global_water_data GROUP BY Country")

top_consumers = country_water_df.orderBy(col("AvgTotalConsumption").desc()).limit(10)

top_per_capita = country_water_df.orderBy(col("AvgPerCapitaUse").desc()).limit(10)

highest_depletion = country_water_df.orderBy(col("AvgGroundwaterDepletion").desc()).limit(10)

water_structure_analysis = country_water_df.withColumn("DominantSector", when(col("AvgAgricultural") > col("AvgIndustrial")) & (col("AvgAgricultural") > col("AvgHousehold")), "农业主导").when((col("AvgIndustrial") > col("AvgAgricultural")) & (col("AvgIndustrial") > col("AvgHousehold")), "工业主导").otherwise("生活主导"))

sector_distribution = water_structure_analysis.groupBy("DominantSector").agg(count("Country").alias("CountryCount"), avg("AvgTotalConsumption").alias("AvgConsumption"))

efficiency_ranking = country_water_df.withColumn("WaterEfficiency", col("AvgTotalConsumption") / col("AvgPerCapitaUse")).orderBy("WaterEfficiency")

top_efficient_countries = efficiency_ranking.limit(15).select("Country", "AvgTotalConsumption", "AvgPerCapitaUse", "WaterEfficiency").collect()

consumption_comparison = []

for country in top_consumers.collect():

consumption_comparison.append({"country": country.Country, "total_consumption": round(country.AvgTotalConsumption, 2), "per_capita_use": round(country.AvgPerCapitaUse, 2), "agricultural_pct": round(country.AvgAgricultural, 2), "industrial_pct": round(country.AvgIndustrial, 2), "household_pct": round(country.AvgHousehold, 2), "groundwater_depletion": round(country.AvgGroundwaterDepletion, 2)})

comparison_result = {"top_consumers": consumption_comparison, "sector_distribution": [{"sector": row.DominantSector, "country_count": row.CountryCount, "avg_consumption": round(row.AvgConsumption, 2)} for row in sector_distribution.collect()], "efficient_countries": [{"country": row.Country, "efficiency_score": round(row.WaterEfficiency, 4)} for row in top_efficient_countries]}

return comparison_result

def perform_country_clustering_analysis():

clustering_features_df = spark.sql("SELECT Country, AVG(PerCapitaWaterUse) as AvgPerCapita, AVG(AgriculturalWaterUse) as AvgAgricultural, AVG(IndustrialWaterUse) as AvgIndustrial, AVG(HouseholdWaterUse) as AvgHousehold, AVG(GroundwaterDepletionRate) as AvgDepletion FROM global_water_data GROUP BY Country")

clean_features_df = clustering_features_df.filter((col("AvgPerCapita").isNotNull()) & (col("AvgAgricultural").isNotNull()) & (col("AvgIndustrial").isNotNull()) & (col("AvgHousehold").isNotNull()) & (col("AvgDepletion").isNotNull()))

feature_assembler = VectorAssembler(inputCols=["AvgPerCapita", "AvgAgricultural", "AvgIndustrial", "AvgHousehold", "AvgDepletion"], outputCol="features")

feature_vector_df = feature_assembler.transform(clean_features_df)

kmeans_model = KMeans(k=4, seed=42, featuresCol="features", predictionCol="cluster")

trained_model = kmeans_model.fit(feature_vector_df)

clustered_df = trained_model.transform(feature_vector_df)

cluster_analysis = clustered_df.groupBy("cluster").agg(count("Country").alias("CountryCount"), avg("AvgPerCapita").alias("ClusterAvgPerCapita"), avg("AvgAgricultural").alias("ClusterAvgAgricultural"), avg("AvgIndustrial").alias("ClusterAvgIndustrial"), avg("AvgHousehold").alias("ClusterAvgHousehold"), avg("AvgDepletion").alias("ClusterAvgDepletion"), collect_list("Country").alias("Countries"))

cluster_centers = trained_model.clusterCenters()

clustering_results = []

for i, row in enumerate(cluster_analysis.collect()):

cluster_profile = {"cluster_id": row.cluster, "country_count": row.CountryCount, "avg_per_capita": round(row.ClusterAvgPerCapita, 2), "avg_agricultural": round(row.ClusterAvgAgricultural, 2), "avg_industrial": round(row.ClusterAvgIndustrial, 2), "avg_household": round(row.ClusterAvgHousehold, 2), "avg_depletion": round(row.ClusterAvgDepletion, 2), "countries": row.Countries[:8], "cluster_center": [round(float(x), 3) for x in cluster_centers[row.cluster]]}

if row.ClusterAvgAgricultural > 60:

cluster_profile["cluster_type"] = "农业用水主导型"

elif row.ClusterAvgIndustrial > 40:

cluster_profile["cluster_type"] = "工业用水主导型"

elif row.ClusterAvgPerCapita > 200:

cluster_profile["cluster_type"] = "高人均用水型"

else:

cluster_profile["cluster_type"] = "均衡用水型"

clustering_results.append(cluster_profile)

model_metrics = {"inertia": float(trained_model.summary.trainingCost), "cluster_count": 4, "feature_importance": ["人均用水量", "农业用水比例", "工业用水比例", "生活用水比例", "地下水消耗率"]}

clustering_output = {"clustering_results": clustering_results, "model_metrics": model_metrics, "total_countries_analyzed": clean_features_df.count()}

return clustering_output【Spark+Hive+hadoop】基于spark+hadoop基于大数据的全球用水量数据可视化分析系统大数据毕设-结语

💟💟如果大家有任何疑虑,欢迎在下方位置详细交流。