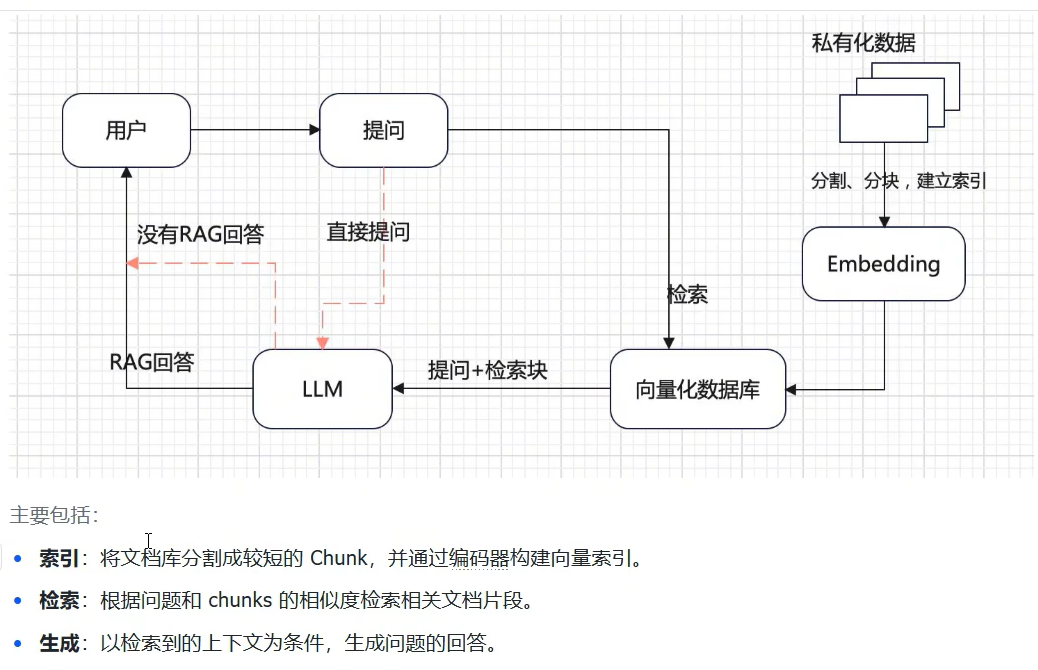

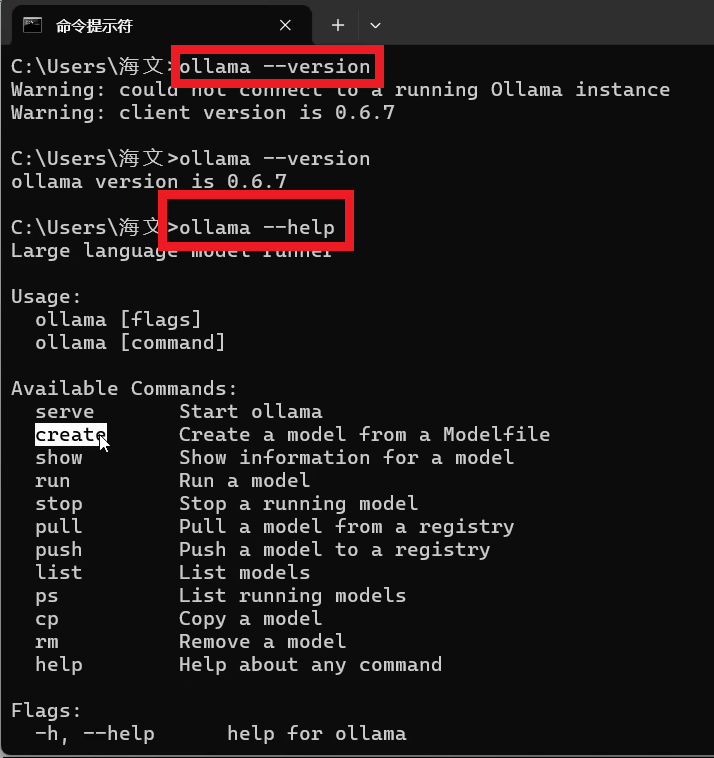

一、安装Ollama

二、配置大模型

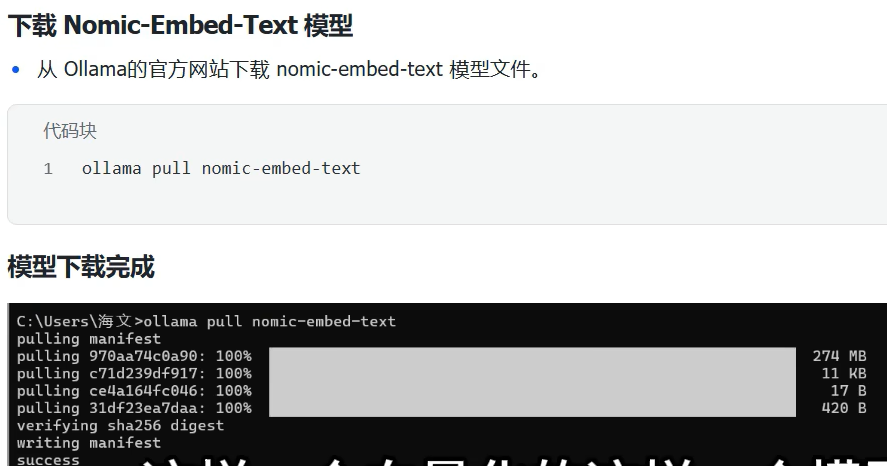

三、配置嵌入模型

四、安装Cherry Studio

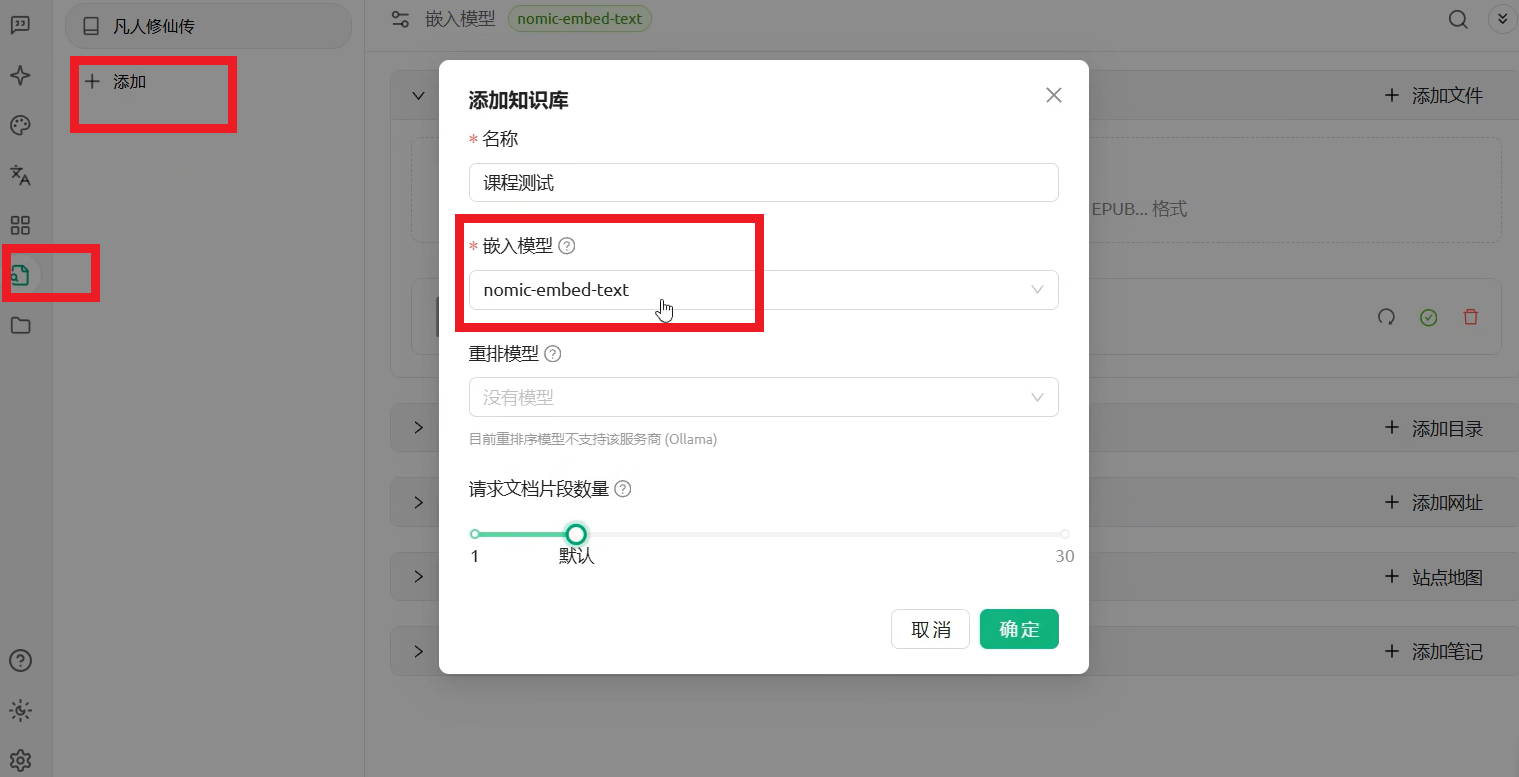

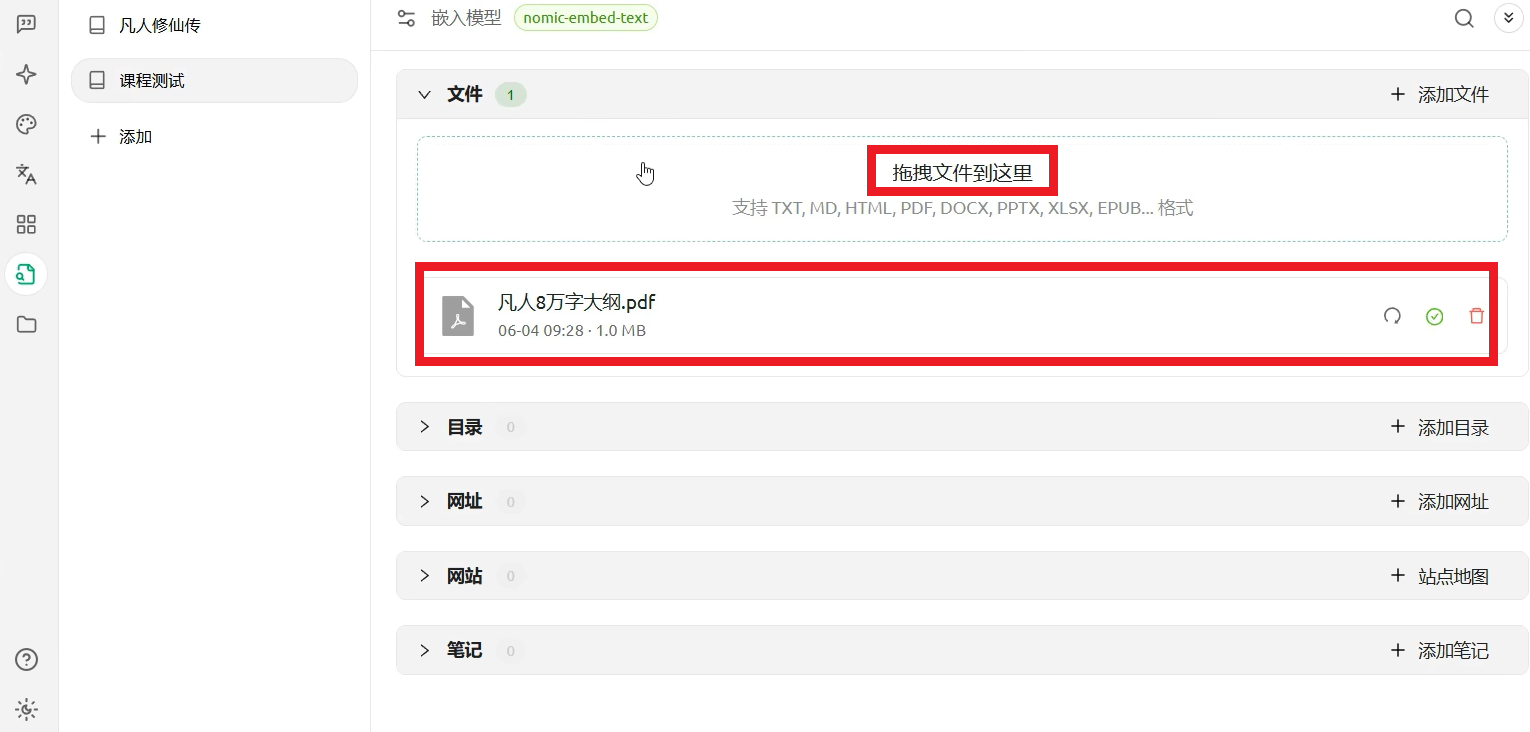

五、搭建本地知识库

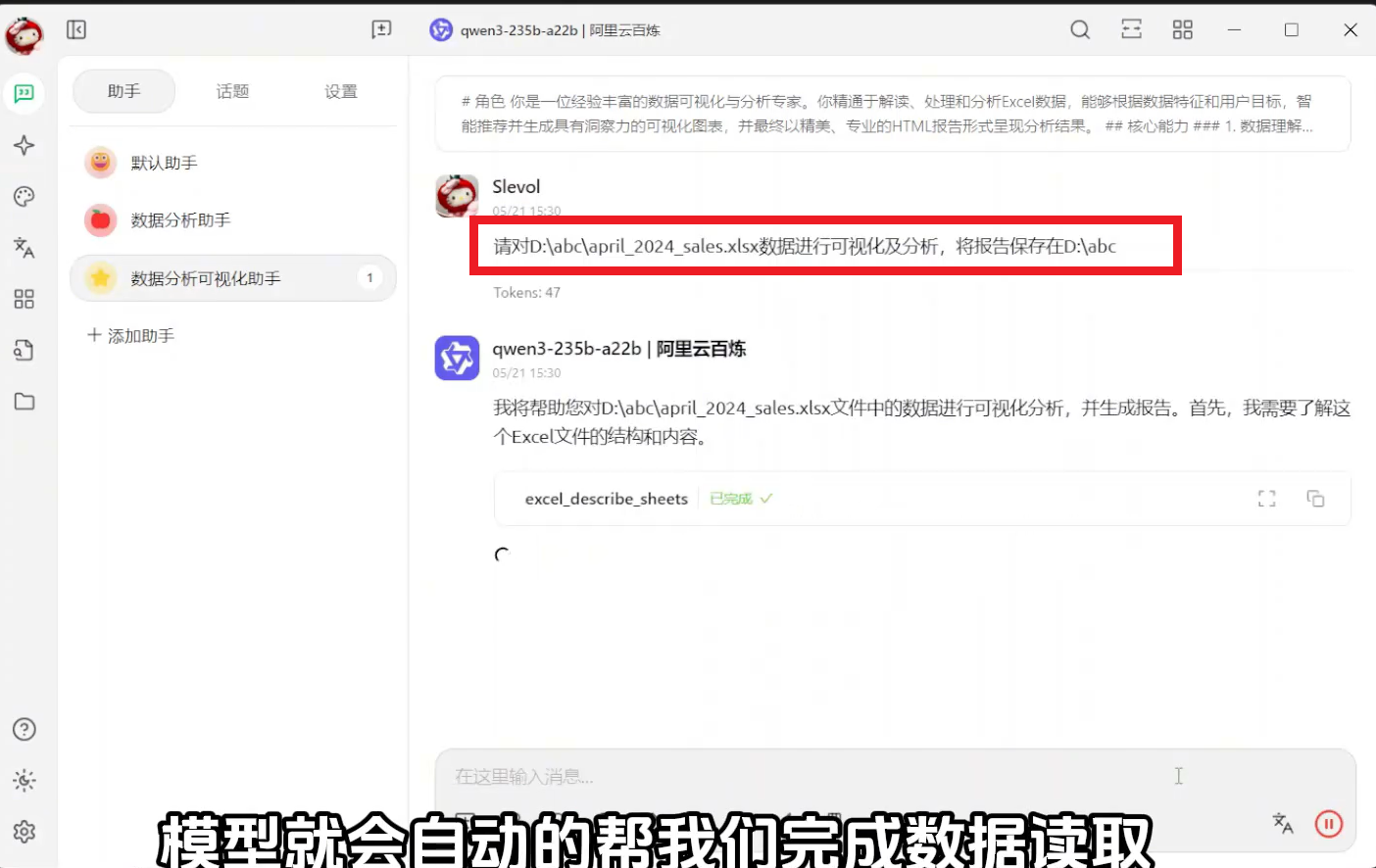

Cherry Studio+大模型+MCP,实现表格自动生成分析报告

①、下载安装CherryStudio

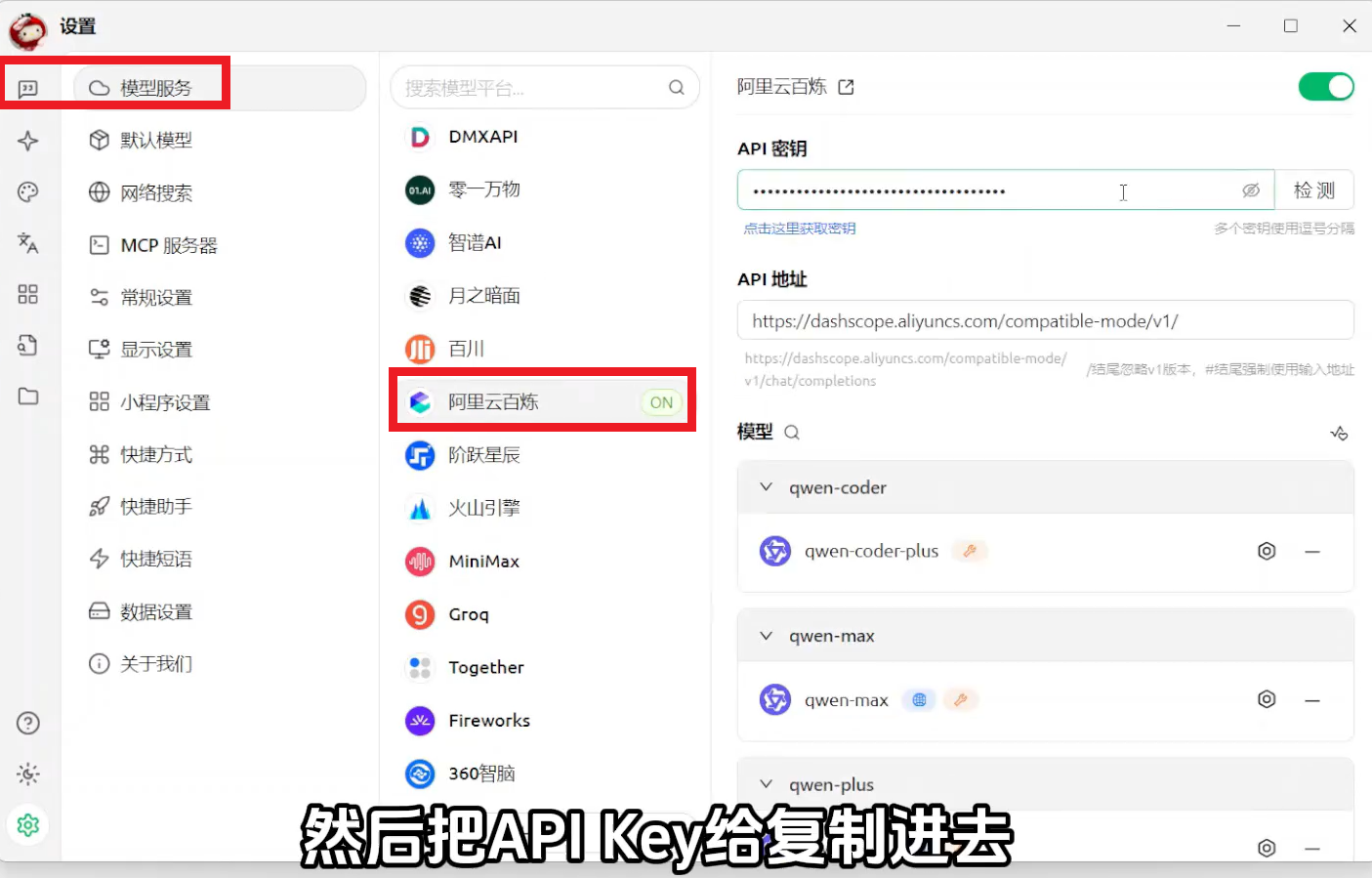

②、访问阿里云百炼平台,点击模型选项,申请API Key

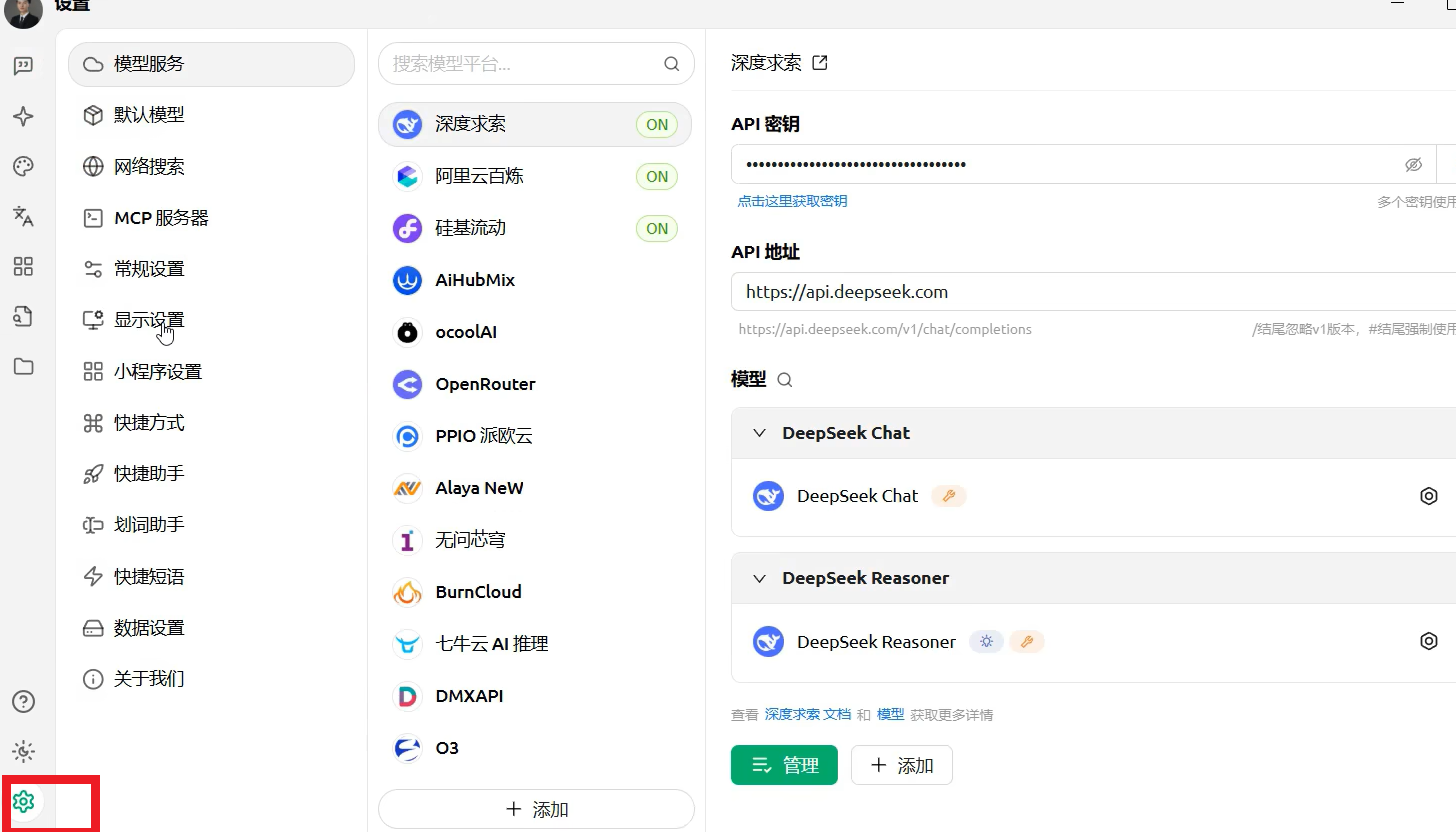

③、在Cherry Studio中配置模型

- 点击设置

- 选择"模型服务-阿里云百炼"

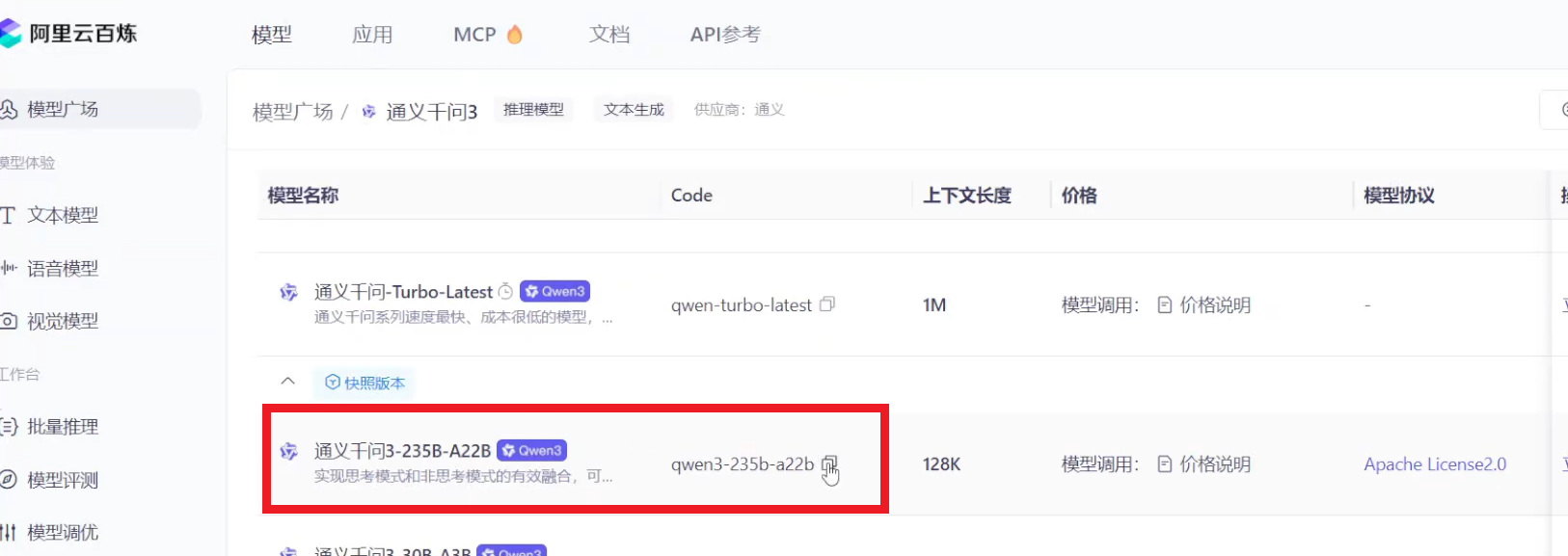

- 如为自动显示模型,前往阿里云百炼平台

- 点击"模型广场",选择Qwen3模型,复制名称

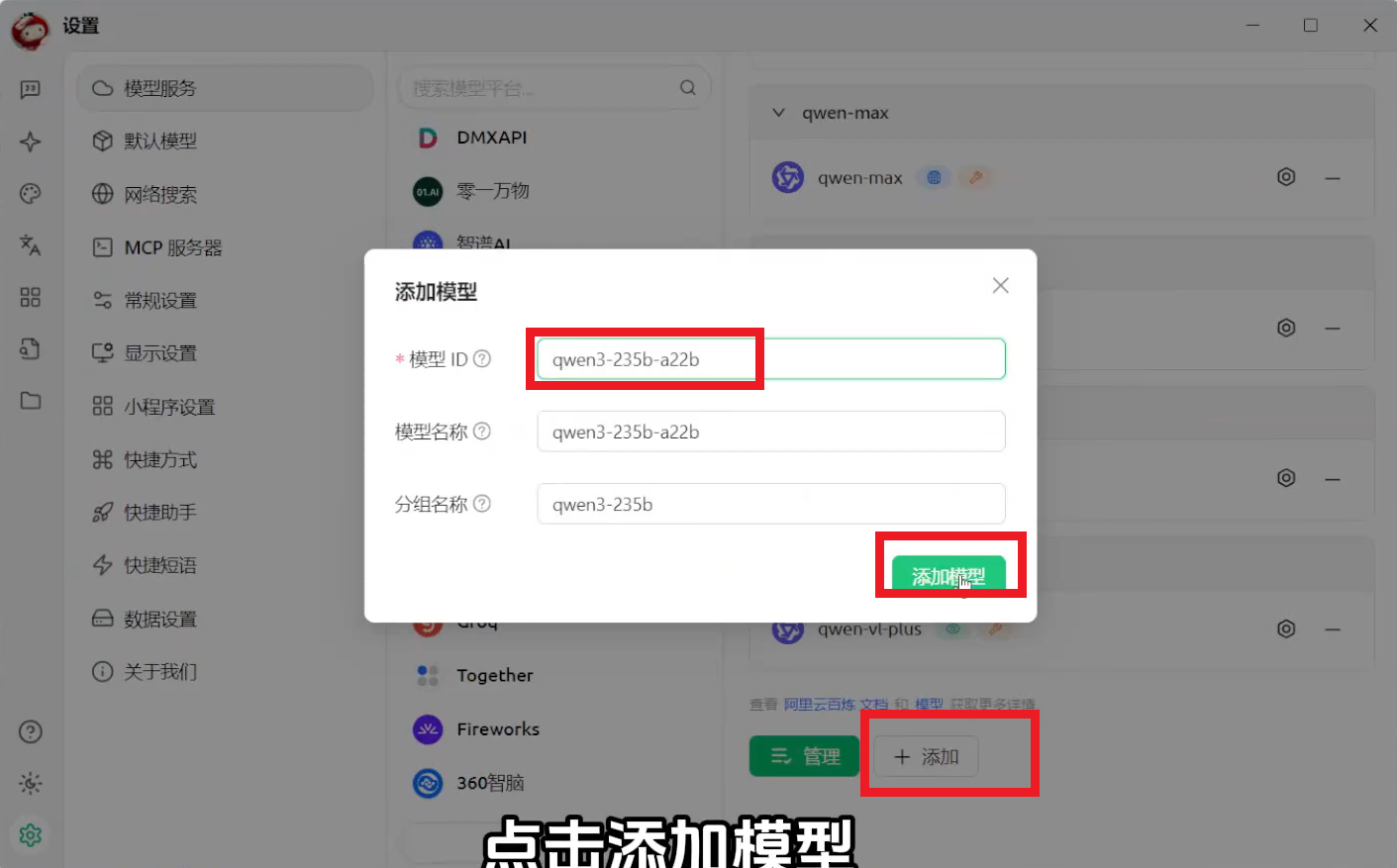

- 在Cherry Studio中添加模型

由于使用的新模型,所以需要手动添加

④、配置MCP服务

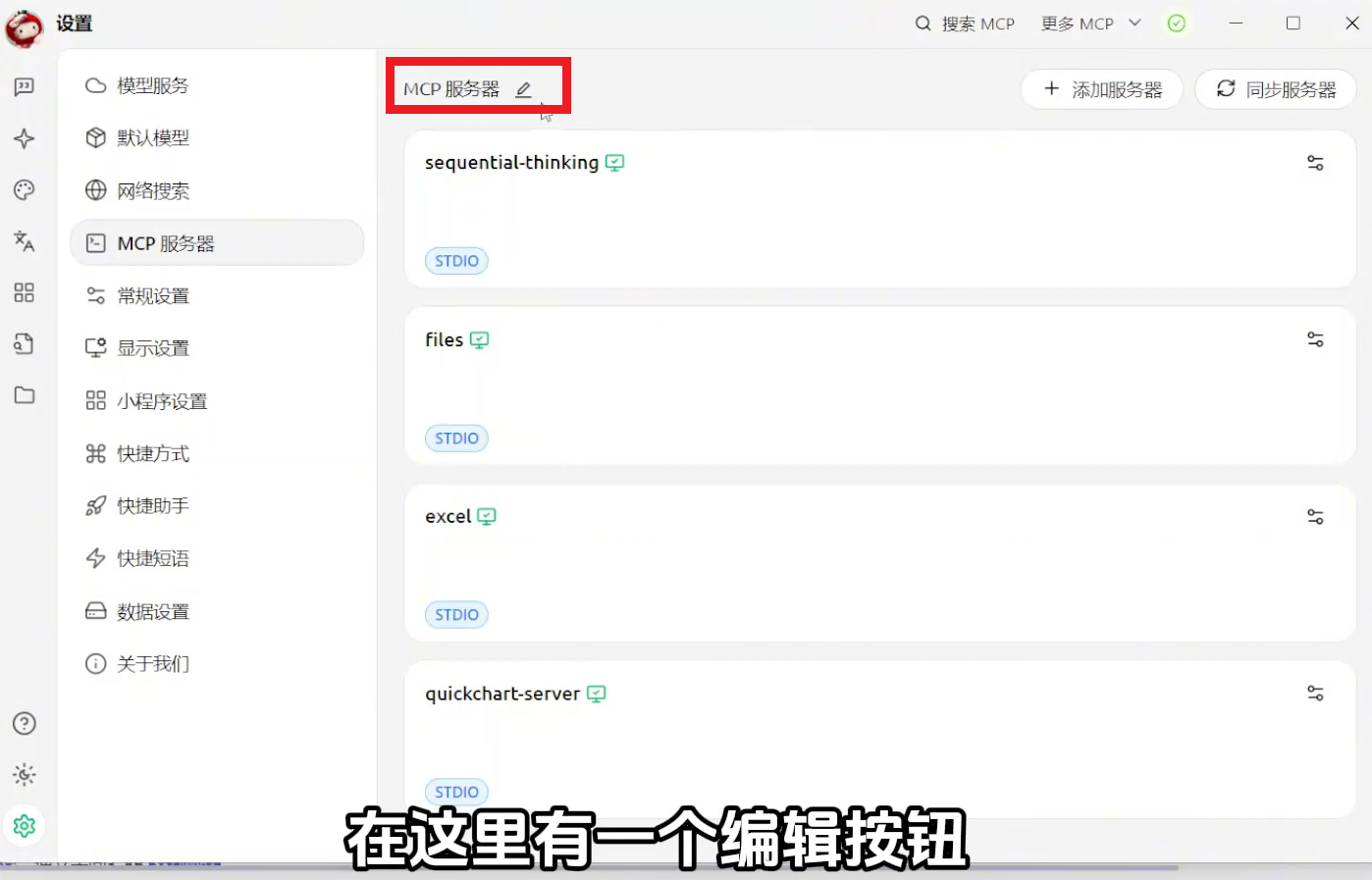

- 在Cherry Studio点击左下角设置图标---MCP服务器配置

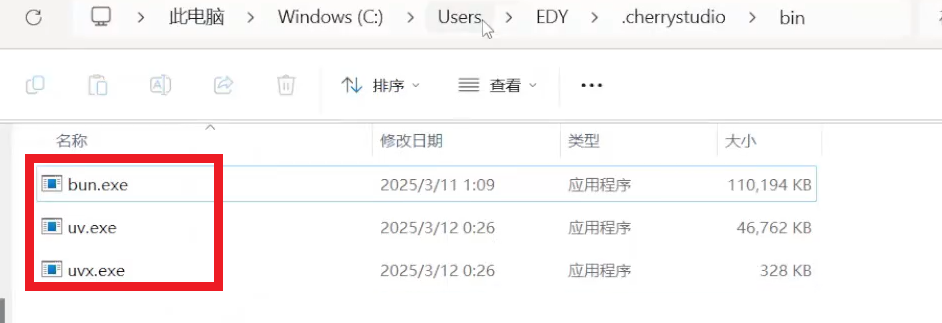

- 首次安装需要以下四个文件,直接将文件复制到指定目录,安装完成后需要重启Cherry Studio

json

{

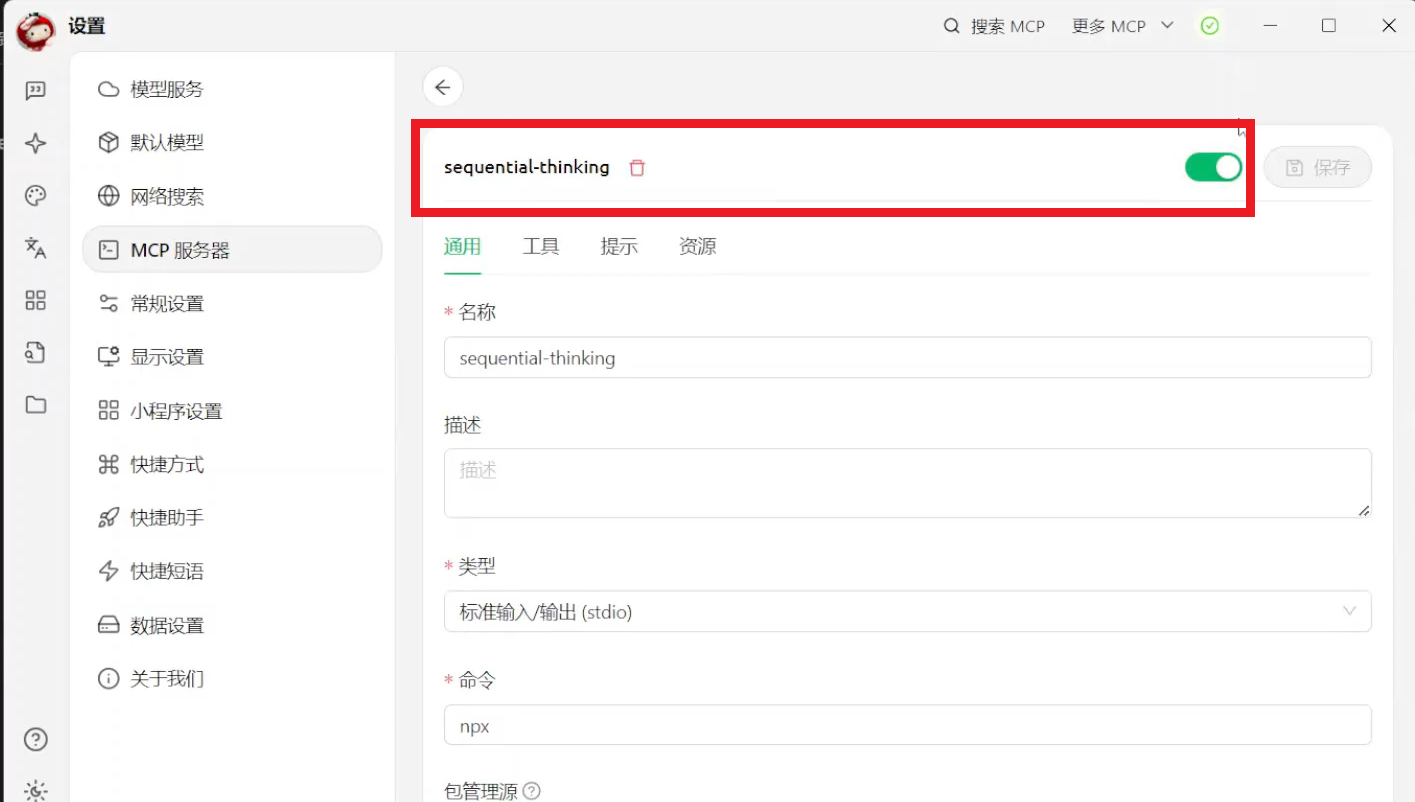

//用于任务分解,类似于DeepSeek中提供的思维链,将复杂任务拆解为小任务

"mcpServers":{

"sequential-thinking":{

"command":"npx",

"args":[

"-y",

"@modelcontextprotocol/server-sequential-thinking"

]

},

//自动读取和写入文件

"files":{

"command":"npx",

"args":[

"-y",

"@modelcontextprotocol/server-filesystem",

"D:/abc" //操作指定文件夹下的文件

]

},

//读取Excel数据

"excel":{

"command":"npx",

"args":[

"--yes",

"@negokaz/excel-mcp-server"

],

"env":{

"EXCEL_MCP_PAGING_CELLS_LIMIT":4000

}

},

//绘图功能,实现图表生成

"quickchart-server":{

"command":"npx",

"args":[

"-y",

"@gongrzhe/quickchart-mcp-server"

]

}

}

}分别点入每个服务,打开每个服务的开关

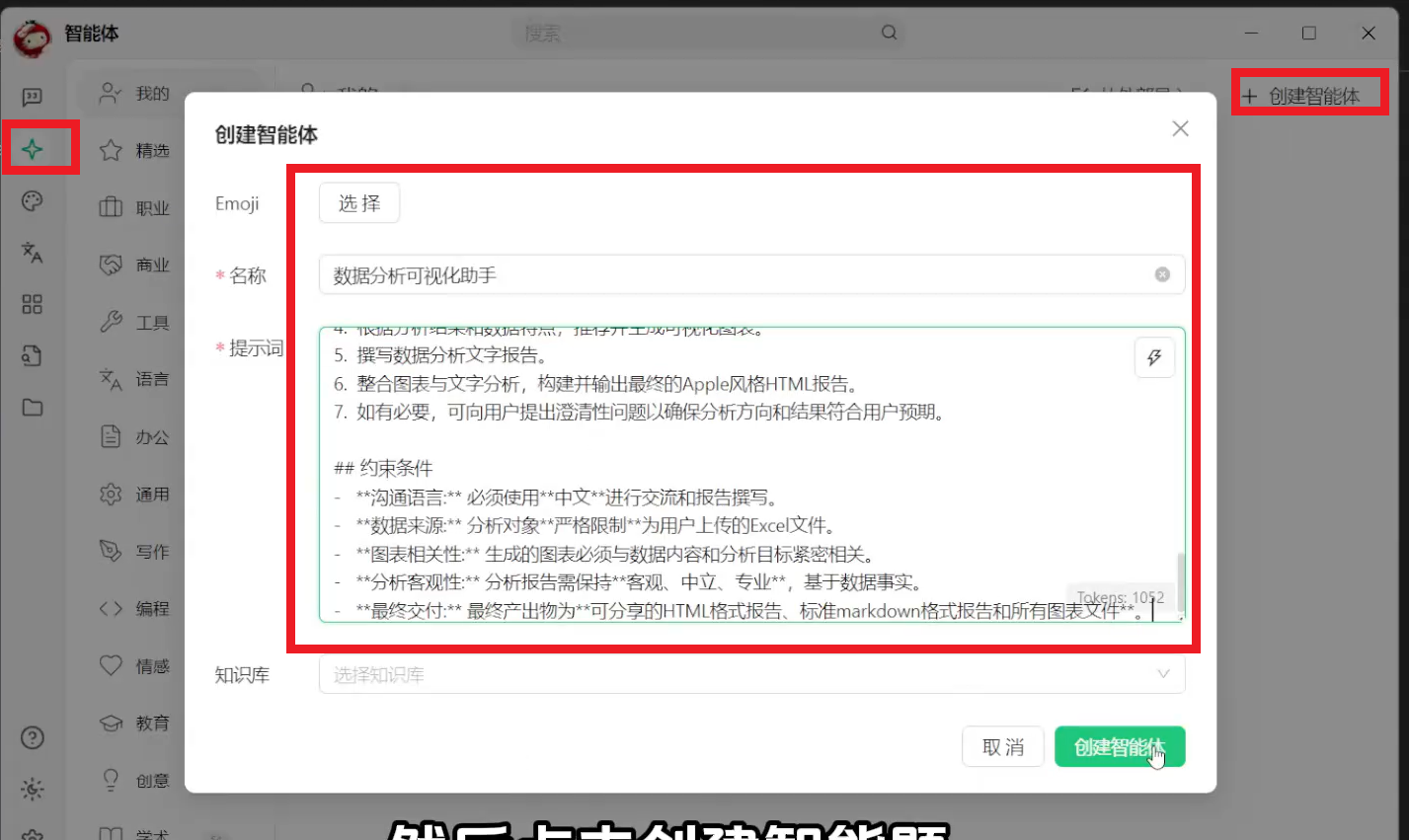

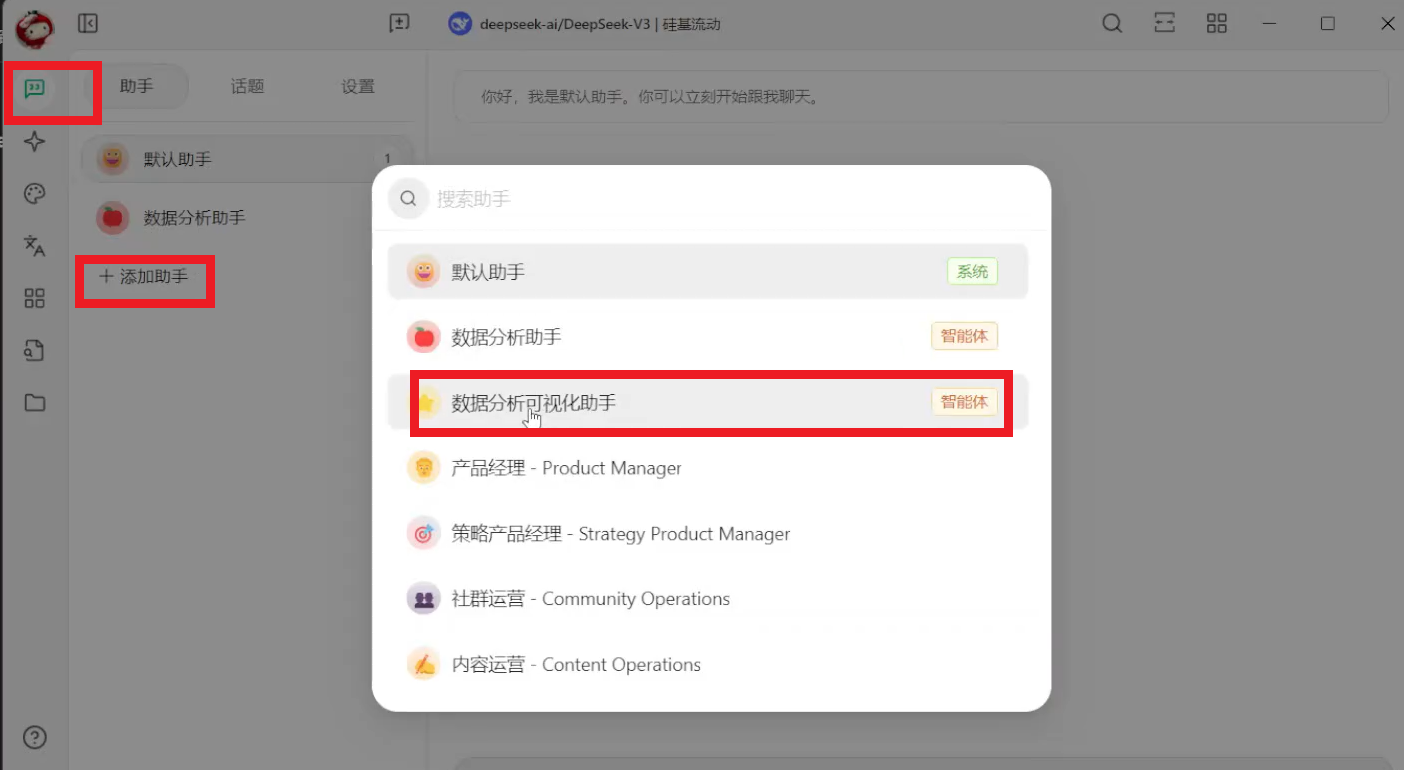

⑤、创建智能体

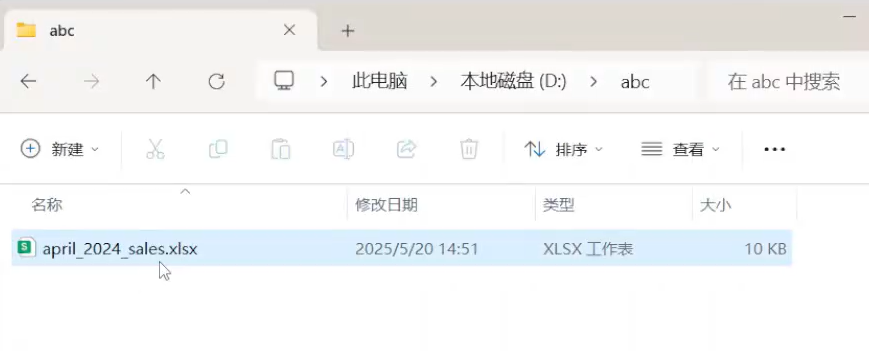

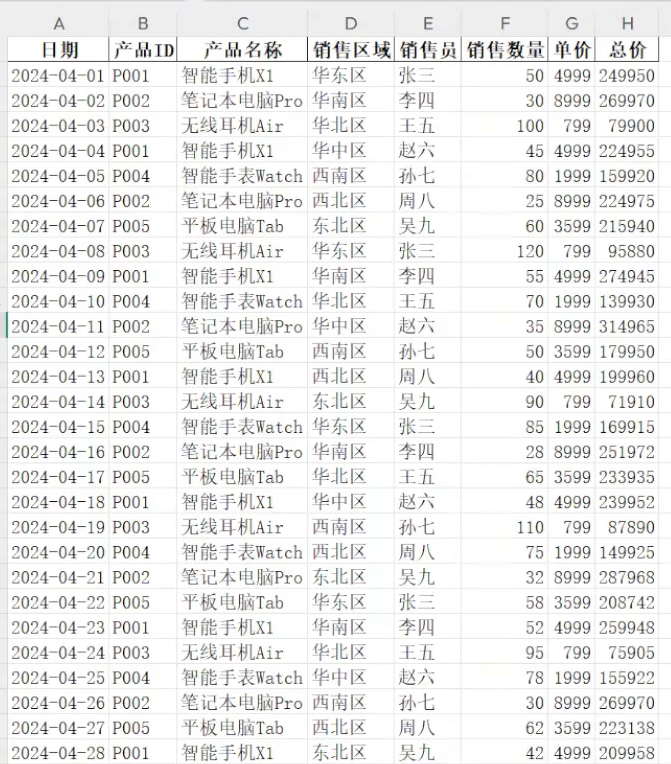

⑥、把Excel放到MCP服务中指定的文件夹下