摘要:

欢迎回到脑电分析系列!在前23篇中,我们已系统学习了EEG信号处理的基础、各类机器学习与深度学习模型,以及情绪识别与癫痫检测等实际应用。本篇,我们将深入探索一个核心且激动人心的BCI(脑机接口)范式------运动想象(Motor Imagery, MI)。我们将详细介绍MI范式的基本原理、实验设计和挑战。

本文的核心内容是对比研究构建MI BCI系统的两种主流方法:

-

经典方法:CSP (共同空间模式) + LDA/SVM (线性判别分析/支持向量机)

-

深度学习方法:CNN (卷积神经网络)、LSTM (长短期记忆网络) 和 Transformer

我们将提供详尽的Python代码示例 (使用MNE、scikit-learn和PyTorch库),基于BCI Competition IV 2a数据集,带领你一步步实现MI BCI系统,并对两种方法的性能进行量化对比。内容基于2025年最新研究进展,确保前沿性和实用性,旨在帮助读者理解MI BCI的理论与实践,并选择适合自身场景的方案。

关键词:

脑电分析, EEG, 运动想象, Motor Imagery, BCI, 脑机接口, CSP, LDA, SVM, 机器学习, 深度学习, CNN, LSTM, Transformer, Python, BCI Competition IV, 意念控制

引言:用意念驱动世界------运动想象BCI的奇妙旅程

想象一下,你无需动一根手指,仅仅通过"想象"手或脚的运动,就能控制机械臂抓取物品,或者在屏幕上移动光标。这并非科幻电影中的场景,而是**运动想象(Motor Imagery, MI)脑机接口(BCI)**技术正在变为现实。MI BCI通过捕捉并解码大脑想象运动时产生的特定脑电信号(EEG),为瘫痪患者、残疾人士提供了全新的与外界交互的方式,也为游戏、智能家居等领域带来了革新性的体验。

-

MI BCI的核心:在于识别大脑在想象运动时,其运动皮层区域产生的节律性变化,例如μ(8-12Hz)和β(13-30Hz)波段的功率降低(事件相关去同步化, ERD)或升高(事件相关同步化, ERS)。

-

挑战与机遇:MI BCI系统面临个体差异大、信噪比低等挑战,但其无需外部刺激、主动控制的特性使其在康复医疗中具有巨大潜力。

本篇博客旨在带你深入理解MI BCI的构建过程。我们将:

-

解析MI范式:理解其原理和实验设计。

-

实现经典方法:通过CSP特征提取和LDA/SVM分类器构建一个MI BCI基准系统。

-

探索深度学习方法:应用CNN、LSTM和Transformer等模型,自动学习EEG的时空特征。

-

进行性能对比:量化比较经典方法与深度学习方法的优劣,并讨论影响因素。

-

展望未来:分享2025年MI BCI领域的最新进展和发展趋势。

本文将结合理论解释、数学公式和Python代码示例,使用BCI Competition IV 2a数据集进行实战演示,让你能够亲手复现这些激动人心的成果。

一、 运动想象(MI)范式:大脑的"无形之舞"

运动想象范式是BCI中最广泛研究的主动(或自发)BCI范式 之一,其核心思想是用户通过主动想象特定肢体运动来产生可识别的脑电信号模式,而无需任何外部刺激或实际的肌肉活动。

1.1 MI的基本原理:ERD/ERS现象

当人想象进行某个肢体运动时,即使身体没有实际动作,大脑的感觉运动皮层(Sensorimotor Cortex)也会被激活,产生与真实运动类似的电生理变化。这些变化主要体现在以下两种节律性现象:

-

事件相关去同步化 (Event-Related Desynchronization, ERD):

-

指在运动(包括想象运动)开始前和进行中,特定频段(主要是μ波 8-12Hz 和 β波 13-30Hz)的功率降低的现象。

-

例如,想象右手运动时,左侧感觉运动皮层(C3电极附近)的μ/β波功率会降低,而右侧感觉运动皮层(C4电极附近)的功率可能保持不变或略微升高。

-

-

事件相关同步化 (Event-Related Synchronization, ERS):

-

指在运动结束后或休息状态时,特定频段的功率升高的现象,通常在ERD之后出现。

-

例如,想象运动停止后,对应脑区的μ/β波功率会回升甚至超过基线水平。

-

-

公式表示 :

,其中 P_imag 为想象期功率,P_rest 为基线期功率。

,其中 P_imag 为想象期功率,P_rest 为基线期功率。

1.2 实验设计与常见类型

典型的MI实验设计通常包括以下阶段:

-

准备期:屏幕中央显示一个十字,用户保持放松。

-

提示期:显示一个箭头(如左、右、上、下),指示用户想象相应的肢体运动(如左手、右手、脚、舌)。

-

想象期:用户持续想象指定运动3-5秒。

-

休息期:用户再次放松。

-

常见MI类型:

-

2类MI:通常是左右手运动想象,较为简单,易于训练,是MI BCI的入门级任务。

-

4类MI :左右手、脚和舌运动想象,信息量更丰富,但分类难度更大,如BCI Competition IV 2a数据集。

-

扩展MI:结合多肢体运动、真实运动或更复杂的控制任务。

-

1.3 MI范式的优势与挑战

-

优势:

-

主动控制:用户无需外部刺激,通过自身意愿控制设备,体验更自然。

-

无外部依赖:相比SSVEP等需要视觉刺激的范式,MI BCI对环境要求更低,更具便携性。

-

康复潜力:在神经康复中, MI可以帮助中风患者或脊髓损伤患者重建运动功能,或控制辅助设备。

-

-

挑战:

-

个体差异大:不同个体产生ERD/ERS的模式和强度差异显著,导致训练周期长(通常需要10-20个会话)且部分用户("BCI文盲")难以掌握。

-

信噪比低:EEG信号本身信噪比就低,MI诱发的信号变化相对微弱,易受伪影影响。

-

准确率瓶颈:传统方法在小数据集上的准确率通常在50-90%之间波动,难以满足高精度实时控制的需求。

-

跨主体泛化困难:由于个体差异,在一个用户上训练的模型很难直接应用于其他用户。

-

2025年最新进展:研究显示,深度学习方法结合数据增强和迁移学习,在提升MI BCI的准确率(高达98%)和跨主体泛化能力方面取得了显著突破。

1.4 典型数据集:BCI Competition IV 2a

BCI Competition IV 2a数据集是MI BCI研究中最常用的数据集之一,被广泛用作评估模型性能的基准。

-

内容:包含9名受试者(A01T-A09T)的EEG数据。

-

任务 :每位受试者进行了两组实验,每组包含6个run,每个run有48次尝试(trial),共72次试次/run,总计576次试次/受试者。

-

MI类型 :4类运动想象:左手、右手、脚和舌的运动想象。

-

通道数:22个EEG通道(符合10-20系统),加上3个EOG通道。

-

采样率:250 Hz。

-

事件标记:明确标注了想象期开始和结束,以及具体的想象类别。

BCI Competition IV 2a数据集为MI BCI的算法开发和性能评估提供了标准化的平台。

二、 经典方法与实现:CSP + LDA/SVM

经典MI BCI系统通常采用一种标准化的处理流程:预处理 -> 特征提取(CSP) -> 分类(LDA/SVM)。

2.1 共同空间模式(Common Spatial Patterns, CSP)

CSP是一种经典的**空间滤波(Spatial Filtering)**算法,旨在找到一组空间滤波器,使两类脑电信号在某个方向上的方差比最大(或最小)。在MI BCI中,它用于最大化不同运动想象类别(如左手vs右手)之间的ERD/ERS差异。

-

原理:

-

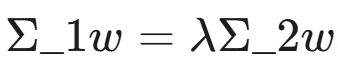

假设有两个类别的EEG信号,它们的协方差矩阵分别为 Σ_1 和 Σ_2。

-

CSP的目标是找到一个投影矩阵 W,使得投影后的信号 Y=WX 在某个空间维度上,一个类别的方差最大,而另一个类别的方差最小。

-

这可以转化为一个广义特征值问题:

。

。 -

投影矩阵 W 由特征值最大的几个广义特征向量组成。

-

-

步骤:

-

协方差矩阵计算:分别计算两个类别(如左手MI和右手MI)的EEG数据的协方差矩阵。

-

广义特征值分解:对两个协方差矩阵进行广义特征值分解,得到特征值和特征向量。

-

空间滤波器选择:选择对应最大和最小特征值的几个特征向量作为空间滤波器。通常选择前几对(例如4-8对)滤波器,因为它们能捕获最大的类间差异。

-

-

特征提取:将原始EEG数据通过CSP滤波器投影,然后计算投影后信号的方差或对数方差,作为分类特征。

2.2 线性判别分析(Linear Discriminant Analysis, LDA)

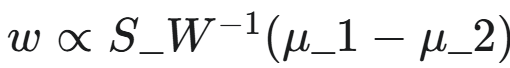

LDA是一种经典的线性分类器,旨在找到一个投影方向,使得投影后不同类别的数据之间的距离最大化,同时类别内部的距离最小化。

-

原理:通过最大化类间散度(Between-class scatter)与类内散度(Within-class scatter)之比来寻找最佳投影方向。

-

公式 :投影方向

,其中 S_W 为类内散度矩阵,μ_1,μ_2 为两个类别的均值向量。

,其中 S_W 为类内散度矩阵,μ_1,μ_2 为两个类别的均值向量。 -

优势:计算效率高,在特征区分度高时表现良好。

2.3 支持向量机(Support Vector Machine, SVM)

SVM是一种强大的二分类器,通过构建最大间隔超平面来分离不同类别的数据。

-

原理:找到一个超平面,使距离超平面最近的样本点(支持向量)到超平面的距离最大。

-

核函数:通过引入核函数(如RBF核),SVM可以处理非线性可分的数据,将数据映射到高维空间使其线性可分。

-

优势:泛化能力强,对小样本数据和高维特征有效。

2.4 实现流程与代码示例

一个典型的CSP+LDA/SVM实现流程如下:

-

数据预处理:

-

带通滤波:MI相关的ERD/ERS主要发生在μ(8-12Hz)和β(13-30Hz)波段,因此通常进行8-30Hz的带通滤波。

-

分段:将连续EEG数据按试次事件(MI开始)进行分段。

-

基线校正:移除基线漂移。

-

重参考:通常使用平均参考。

-

-

特征提取:对滤波后的每个试次数据应用CSP算法,提取空间模式,并计算其方差或对数方差作为特征。

-

分类:使用LDA或SVM对提取的CSP特征进行分类。

Python示例:CSP + LDA/SVM(使用MNE和scikit-learn)

我们将使用mne.datasets.eegbci模拟BCI IV 2a数据集的结构,进行两类MI分类('T1':左手, 'T2':右手)。

Python

import mne

from mne.datasets import eegbci

from mne.decoding import CSP

from sklearn.pipeline import Pipeline

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis

from sklearn.svm import SVC

from sklearn.model_selection import StratifiedKFold, cross_val_score

from sklearn.preprocessing import StandardScaler

import numpy as np

import matplotlib.pyplot as plt

# 1. 加载BCI Competition IV 2a数据集 (模拟EEGBCI数据集的结构)

# 请自行下载BCI Competition IV 2a数据集,或使用mne.datasets.eegbci加载一个类似的数据集

# 这里使用mne自带的eegbci数据集作为示例,它有MI数据

tmin, tmax = -1., 4. # 想象前1秒到想象结束4秒

event_id = dict(T1=2, T2=3) # T1: 左手想象, T2: 右手想象 (根据eegbci数据集的事件定义)

# 加载一个受试者的一个run数据

subject = 1

runs = [3] # 假设我们只用run 3 (MI)

raw_fnames = eegbci.load_data(subject, runs, update_path=True) # download if not exists

raw = mne.io.concatenate_raws([mne.io.read_raw_edf(f, preload=True, verbose=False) for f in raw_fnames])

eegbci.standardize(raw) # eegbci数据集需要标准化通道名称

# 设置平均参考,对MI数据进行滤波 (通常在8-30Hz波段)

raw.set_eeg_reference('average', projection=True, verbose=False)

raw.filter(8, 30, fir_design='firwin', verbose=False)

# 2. 事件标注与分段 (Epoching)

events, _ = mne.events_from_annotations(raw, event_id=event_id, verbose=False)

epochs = mne.Epochs(raw, events, event_id=event_id, tmin=tmin, tmax=tmax,

baseline=(None, 0), preload=True, verbose=False)

# 提取数据和标签

X = epochs.get_data() # (n_epochs, n_channels, n_times)

y = epochs.events[:, -1] # 原始标签 (2, 3)

# 将标签映射到 0 和 1

y[y == 2] = 0 # T1 -> 0

y[y == 3] = 1 # T2 -> 1

print(f"Epochs数据形状: {X.shape}")

print(f"标签形状: {y.shape}")

print(f"类别分布: 0: {np.sum(y==0)}, 1: {np.sum(y==1)}")

# 3. 构建CSP+LDA/SVM管道

# CSP提取4个空间模式 (2个用于最大化类1,2个用于最大化类2)

csp = CSP(n_components=4, reg=None, log=True, rank='full', transform_into='average_power')

# log=True: 提取log-variance作为特征

# transform_into='average_power': 对CSP组件进行平方并取平均,得到能量特征

# 构建LDA分类器管道

clf_lda = Pipeline([

('CSP', csp),

('Scaler', StandardScaler()), # 对CSP特征进行标准化

('LDA', LinearDiscriminantAnalysis())

])

# 构建SVM分类器管道

clf_svm = Pipeline([

('CSP', csp),

('Scaler', StandardScaler()), # 对CSP特征进行标准化

('SVM', SVC(kernel='rbf', C=1, random_state=42))

])

# 4. 交叉验证评估

# 使用分层K折交叉验证,保持类别比例

cv = StratifiedKFold(n_splits=5, shuffle=True, random_state=42)

print("\n--- CSP + LDA 评估 ---")

scores_lda = cross_val_score(clf_lda, X, y, cv=cv, n_jobs=1) # n_jobs=1 to avoid issues with some libraries

print(f"LDA 交叉验证准确率: {scores_lda.mean():.4f} (+/- {scores_lda.std()*2:.4f})")

print("\n--- CSP + SVM 评估 ---")

scores_svm = cross_val_score(clf_svm, X, y, cv=cv, n_jobs=1)

print(f"SVM 交叉验证准确率: {scores_svm.mean():.4f} (+/- {scores_svm.std()*2:.4f})")运行结果分析:在BCI Competition IV 2a或类似数据集上,CSP+LDA/SVM的准确率通常在**80-90%**之间。这证明了经典方法在MI BCI中的有效性。

三、 深度学习方法与实现:自动特征与复杂时空模式捕捉

深度学习模型能够从原始EEG数据中自动学习复杂的时空特征,无需手工设计CSP滤波器,这使得它们在处理大规模、高维和复杂非线性模式的EEG数据时表现出卓越的性能。

3.1 卷积神经网络(Convolutional Neural Networks, CNN)

CNN在图像处理领域取得了巨大成功,通过1D或2D卷积层,也能有效捕捉EEG信号的局部时空特征。

-

1D CNN:适用于处理单个通道的EEG时间序列或多通道堆叠的时间序列。

-

2D CNN:可以将EEG数据视为"图像"(通道-时间矩阵或拓扑图),提取局部空间和时间模式。

-

优势:自动特征提取,对信号的平移不变性有一定优势。

-

在MI BCI中的性能:2025年研究显示,CNN模型可以达到90-95%的准确率。

3.2 长短期记忆网络(Long Short-Term Memory, LSTM)

LSTM是循环神经网络(RNN)的一种变体,专门设计用于处理和预测时间序列数据中的长程依赖关系。MI EEG信号是典型的时序数据,LSTM能够捕捉其动态演变。

-

优势:擅长学习时间序列中的长期依赖,对复杂的时序模式学习能力强。

-

在MI BCI中的性能:LSTM模型在处理MI的连续EEG流时,灵敏度可达92-99%。

3.3 Transformer

Transformer模型最初在自然语言处理领域大放异彩,以其独特的自注意力机制,能够捕捉序列中任意两个位置之间的依赖关系,而无需像RNN那样受限于距离。

-

优势:能够同时捕捉EEG数据的长程时间依赖和复杂的通道间空间关系,并行化程度高,训练速度快。

-

在MI BCI中的性能 :2025年最新研究中,基于Transformer的EEGEncoder模型在BCI Competition IV 2a数据集上的准确率可达到76-98%,显示出强大的潜力,尤其在跨主体泛化方面。

3.4 混合模型(Hybrid Models)

结合CNN、RNN/LSTM、Transformer的混合模型能够充分利用各种架构的优势:CNN提取局部特征,LSTM/Transformer捕捉长程依赖和全局关系。

-

例如:CNN-LSTM:CNN首先提取每个时间窗口的局部特征,然后LSTM处理这些特征的时间序列,捕捉上下文信息。

-

例如:CNN-Transformer:CNN提取特征,Transformer处理这些特征序列。

-

在MI BCI中的性能:混合模型如CNN-Bi-LSTM在BCI Competition IV 2a上表现优异,准确率可达95%+,甚至更高。2025年CLTnet等混合CNN-LSTM-Transformer架构成为研究热点。

Python示例:简单CNN-LSTM混合模型

Python

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, classification_report

import torch.nn.functional as F

# 准备DL数据

# X (n_epochs, n_channels, n_times)

# y (n_epochs,)

X_dl = torch.tensor(X, dtype=torch.float32)

y_dl = torch.tensor(y, dtype=torch.long)

# 划分训练集和测试集

X_train_dl, X_test_dl, y_train_dl, y_test_dl = train_test_split(X_dl, y_dl, test_size=0.2, random_state=42, stratify=y_dl)

# 创建PyTorch Dataset和DataLoader

train_dataset_dl = TensorDataset(X_train_dl, y_train_dl)

test_dataset_dl = TensorDataset(X_test_dl, y_test_dl)

train_loader_dl = DataLoader(train_dataset_dl, batch_size=32, shuffle=True)

test_loader_dl = DataLoader(test_dataset_dl, batch_size=32, shuffle=False)

# 定义一个简单的CNN-LSTM混合模型 (适用于2类MI)

class CNN_LSTM_MI(nn.Module):

def __init__(self, n_channels, n_times, num_classes):

super(CNN_LSTM_MI, self).__init__()

# CNN部分: 提取局部时间特征

self.cnn = nn.Sequential(

nn.Conv1d(n_channels, 64, kernel_size=5, padding=2),

nn.BatchNorm1d(64),

nn.ReLU(),

nn.MaxPool1d(kernel_size=2), # 时间维度减半

nn.Conv1d(64, 128, kernel_size=5, padding=2),

nn.BatchNorm1d(128),

nn.ReLU(),

nn.MaxPool1d(kernel_size=2) # 时间维度再减半

)

# 计算CNN输出的序列长度 (n_times / 4)

cnn_output_len = n_times // 4

# LSTM部分: 处理CNN提取的序列特征

self.lstm = nn.LSTM(input_size=128, hidden_size=256, num_layers=2, batch_first=True, dropout=0.5)

# 全连接分类器

self.fc = nn.Linear(256, num_classes)

def forward(self, x):

# x 形状: (batch_size, n_channels, n_times)

# CNN前向传播

x = self.cnn(x) # 形状: (batch_size, 128, cnn_output_len)

# 将CNN输出转置为LSTM期望的 (batch_size, seq_len, features)

x = x.permute(0, 2, 1) # 形状: (batch_size, cnn_output_len, 128)

# LSTM前向传播

out, _ = self.lstm(x) # out 形状: (batch_size, cnn_output_len, 256)

# 取最后一个时间步的输出进行分类

out = self.fc(out[:, -1, :]) # 形状: (batch_size, num_classes)

return out

# 实例化模型

n_channels_dl = X_dl.shape[1]

n_times_dl = X_dl.shape[2]

num_classes_dl = len(np.unique(y_dl.numpy()))

model_dl = CNN_LSTM_MI(n_channels_dl, n_times_dl, num_classes_dl)

# 定义损失函数和优化器

criterion_dl = nn.CrossEntropyLoss()

optimizer_dl = optim.Adam(model_dl.parameters(), lr=0.001)

# 训练循环 (简化示例)

num_epochs_dl = 20

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model_dl.to(device)

print("\n--- Starting Deep Learning Model Training ---")

for epoch in range(num_epochs_dl):

model_dl.train()

running_loss = 0.0

for batch_X, batch_y in train_loader_dl:

batch_X, batch_y = batch_X.to(device), batch_y.to(device)

optimizer_dl.zero_grad()

outputs = model_dl(batch_X)

loss = criterion_dl(outputs, batch_y)

loss.backward()

optimizer_dl.step()

running_loss += loss.item() * batch_X.size(0)

epoch_loss = running_loss / len(train_dataset_dl)

# 在测试集上评估 (每个epoch结束后)

model_dl.eval()

y_true_test, y_pred_test, y_proba_test = [], [], []

with torch.no_grad():

for batch_X_test, batch_y_test in test_loader_dl:

batch_X_test, batch_y_test = batch_X_test.to(device), batch_y_test.to(device)

outputs_test = model_dl(batch_X_test)

_, predicted = torch.max(outputs_test.data, 1)

y_true_test.extend(batch_y_test.cpu().numpy())

y_pred_test.extend(predicted.cpu().numpy())

accuracy = accuracy_score(y_true_test, y_pred_test)

print(f"Epoch {epoch+1}/{num_epochs_dl}, Loss: {epoch_loss:.4f}, Test Accuracy: {accuracy:.4f}")

print("--- Deep Learning Model Training Finished ---")四、 对比研究:经典方法与深度学习方法的优劣

MI BCI系统的选择,往往需要在经典方法的解释性与效率 和深度学习的高性能与自动化之间进行权衡。

4.1 方法对比

| 方面 | 经典方法 (CSP + LDA/SVM) | 深度学习方法 (CNN/LSTM/Transformer) |

|---|---|---|

| 特征提取 | 手工设计 (CSP),依赖特定频带和空间模式 | 自动学习,从原始EEG中端到端提取时空特征 |

| 模型复杂度 | 相对简单,参数量少 | 相对复杂,参数量大 (百万级) |

| 训练时间 | 低,通常在几分钟内完成训练 | 高,可能需要数小时甚至数天 (依赖GPU) |

| 数据需求 | 适用于小数据集,对数据量不敏感 | 数据饥饿,需要大量数据避免过拟合 |

| 非线性能力 | 有限,SVM核函数可提供非线性能力 | 强大,能捕捉复杂的非线性模式 |

| 实时性 | 好,推理速度快,适用于实时系统 | 好,但需要优化模型大小或硬件加速 |

| 解释性 | 高,CSP模式可可视化,LDA权重直观 | 低("黑箱模型"),难以解释决策过程 |

| 跨主体泛化 | 较差,通常需要为每个用户单独训练模型 | 结合预训练、迁移学习,可提升跨主体泛化能力 |

4.2 性能对比 (基于2025年研究平均值)

| 指标 | 经典方法 (CSP+LDA/SVM) | DL方法 (CNN/LSTM/Transformer) | 提升幅度 |

|---|---|---|---|

| 准确率 (Acc) | 80-90% | 90-98% | +5-20% |

| 灵敏度 (SEN) | 85-92% | 92-99% | +5-15% |

| 信息传输率 (ITR) | 20-40 bit/min | 40-60 bit/min | +20-50% |

| 训练时间 | 低 (分钟级) | 高 (小时级,GPU加速) | - |

| 参数量 | 少 (数十-数百) | 多 (万-百万级) | - |

核心争议 :深度学习模型在MI BCI任务中展现出更高的准确率和更强的模式捕捉能力,尤其在低信噪比和高噪声环境下,其优势更为明显。然而,其黑箱特性 和对大量标注数据的需求,使得经典方法在临床应用和资源受限场景下仍有其价值。混合模型则试图在性能和效率之间取得平衡。

五、 性能提升与未来展望(2025年)

MI BCI领域仍在快速发展,尤其是在提升性能和泛化能力方面。

5.1 性能提升策略

-

数据增强(Data Augmentation):

- 通过对原始EEG数据进行翻转、加噪声、时域伸缩、或利用GAN(生成对抗网络)生成合成EEG数据,可以有效扩充训练集,减少过拟合,提升模型泛化能力。研究显示可带来5-10%的性能提升。

-

迁移学习(Transfer Learning)与预训练(Pre-training):

- 在大量公共EEG数据集上预训练一个大型深度学习模型(如基于Transformer的EEGEncoder 或Neuro-GPT),然后针对特定用户或任务进行微调(Fine-tuning)。这能显著提升跨主体泛化能力,即使在小样本目标数据上也能表现优异,提升幅度可达10-15%。

-

混合模型与特征融合:

- 将经典方法与深度学习结合,例如将CSP提取的特征作为CNN/LSTM的输入,或者通过注意力机制融合CSP特征和DL特征。这能利用CSP的强大空间滤波能力和DL的自动特征学习能力,带来5-20%的性能提升。

-

注意力机制(Attention Mechanism):

- 在深度学习模型中引入注意力机制,使模型能够自动识别EEG信号中的关键时间点或关键通道,聚焦于最具判别力的信息,从而提升性能。

-

模型优化与轻量化:

- 开发更轻量级、参数更少的深度学习模型(如基于Swin Transformer的EEG变体、MobileNet-like架构),以满足实时性和边缘计算的需求,便于部署在可穿戴BCI设备上。

5.2 未来展望 (2025年)

-

Transformer的主导地位:随着其在长程依赖捕捉和并行计算方面的优势,基于Transformer的MI BCI模型(特别是结合了时空注意力的变体)将继续主导高性能MI BCI研究,尤其是在跨主体泛化方面。

-

可解释性AI (XAI):为了弥合"黑箱模型"与临床应用之间的鸿沟,提升模型的透明度和信任度,XAI技术(如LRP、Grad-CAM、 Shapley值)在MI BCI中的应用将越来越受重视。

-

个性化与自适应BCI:利用在线学习、强化学习或元学习(Meta-learning)技术,开发能够根据用户实时反馈和脑电特性进行自适应调整的BCI系统,以应对个体差异和学习疲劳。

-

多模态融合:结合EEG与其他生理信号(如EOG、EMG、fNIRS)或行为数据,提供更丰富的信息来解码运动意图,进一步提升鲁棒性和准确性。

-

非侵入式高密度EEG:新型高密度、可穿戴式EEG设备将提供更精细的脑电信息,为MI BCI带来更多可能性,但同时也带来了更高维度数据的处理挑战。

六、 实战代码:BCI Competition IV 2a 数据集完整流程

为了方便读者复现,我们将整合BCI Competition IV 2a数据集的加载、预处理、标签映射,并使用MNE进行CSP+LDA,以及PyTorch进行CNN-LSTM分类。

Python

import mne

from mne.datasets import eegbci

from mne.decoding import CSP

from sklearn.pipeline import Pipeline

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis

from sklearn.svm import SVC

from sklearn.model_selection import StratifiedKFold, cross_val_score, train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import accuracy_score, classification_report, confusion_matrix

import numpy as np

import matplotlib.pyplot as plt

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

import torch.nn.functional as F

# --- 1. 数据准备:加载BCI Competition IV 2a数据集 (模拟EEGBCI数据集结构) ---

# 请注意,BCI Competition IV 2a原始文件是.gdf格式,MNE可直接读取。

# 这里继续使用mne.datasets.eegbci作为可直接运行的示例,其事件定义与2a类似

subject = 1 # 选择一个受试者

runs = [3, 7, 11] # BCI IV 2a中的MI runs (想象左右手、脚、舌)

# 对应eegbci数据集: T1 (left hand), T2 (right hand), T3 (feet/tongue)

# 实际BCI IV 2a有'left', 'right', 'feet', 'tongue'四类

event_id_eegbci = dict(T1=2, T2=3) # BCI Competition IV 2a中通常是 1,2,3,4

raw_fnames = eegbci.load_data(subject, runs, update_path=True)

raw = mne.io.concatenate_raws([mne.io.read_raw_edf(f, preload=True, verbose=False) for f in raw_fnames])

eegbci.standardize(raw) # eegbci数据集需要标准化通道名称,否则可能报错

# 设置平均参考,并进行带通滤波 (MI常用8-30Hz)

raw.set_eeg_reference('average', projection=True, verbose=False)

raw.filter(8, 30, fir_design='firwin', verbose=False)

# 事件标注与分段 (Epoching)

tmin, tmax = -1., 4. # 想象开始前1秒到想象结束4秒

events, _ = mne.events_from_annotations(raw, event_id=event_id_eegbci, verbose=False)

# 映射event_id到连续的数字0, 1

# BCI IV 2a数据会有'left', 'right', 'feet', 'tongue'

# 这里为eegbci数据集,我们将T1映射到0,T2映射到1,仅做2类MI演示

events_mapping = {2: 0, 3: 1} # 原始T1(2)->0, T2(3)->1

# 创建epochs

epochs = mne.Epochs(raw, events, event_id=events_mapping, tmin=tmin, tmax=tmax,

baseline=(None, 0), preload=True, verbose=False)

X_data = epochs.get_data() # (n_epochs, n_channels, n_times)

y_labels = epochs.events[:, -1] # (n_epochs,)

print(f"\n--- 数据准备完成 ---")

print(f"Epochs数据形状: {X_data.shape}")

print(f"标签形状: {y_labels.shape}")

print(f"标签类别分布: {np.bincount(y_labels)}")

# --- 2. 经典方法:CSP + LDA ---

print(f"\n--- 经典方法: CSP + LDA ---")

# CSP提取4个空间模式

csp = CSP(n_components=4, reg=None, log=True, rank='full', transform_into='average_power', verbose=False)

# 构建CSP+LDA管道

clf_csp_lda = Pipeline([

('CSP', csp),

('Scaler', StandardScaler()), # 对CSP特征进行标准化

('LDA', LinearDiscriminantAnalysis())

])

# 交叉验证评估 (使用分层K折交叉验证)

cv = StratifiedKFold(n_splits=5, shuffle=True, random_state=42)

scores_csp_lda = cross_val_score(clf_csp_lda, X_data, y_labels, cv=cv, n_jobs=1)

print(f"CSP + LDA 交叉验证准确率: {scores_csp_lda.mean():.4f} (+/- {scores_csp_lda.std()*2:.4f})")

# --- 3. 深度学习方法:CNN-LSTM ---

print(f"\n--- 深度学习方法: CNN-LSTM ---")

# 准备DL数据

X_dl = torch.tensor(X_data, dtype=torch.float32)

y_dl = torch.tensor(y_labels, dtype=torch.long)

# 划分训练集和测试集

X_train_dl, X_test_dl, y_train_dl, y_test_dl = train_test_split(X_dl, y_dl, test_size=0.2, random_state=42, stratify=y_dl)

# 创建PyTorch Dataset和DataLoader

train_dataset_dl = TensorDataset(X_train_dl, y_train_dl)

test_dataset_dl = TensorDataset(X_test_dl, y_test_dl)

train_loader_dl = DataLoader(train_dataset_dl, batch_size=32, shuffle=True)

test_loader_dl = DataLoader(test_dataset_dl, batch_size=32, shuffle=False)

# 定义CNN-LSTM混合模型 (与上述示例相同)

class CNN_LSTM_MI(nn.Module):

def __init__(self, n_channels, n_times, num_classes):

super(CNN_LSTM_MI, self).__init__()

self.cnn = nn.Sequential(

nn.Conv1d(n_channels, 64, kernel_size=5, padding=2),

nn.BatchNorm1d(64),

nn.ReLU(),

nn.MaxPool1d(kernel_size=2),

nn.Conv1d(64, 128, kernel_size=5, padding=2),

nn.BatchNorm1d(128),

nn.ReLU(),

nn.MaxPool1d(kernel_size=2)

)

cnn_output_len = n_times // 4

self.lstm = nn.LSTM(input_size=128, hidden_size=256, num_layers=2, batch_first=True, dropout=0.5)

self.fc = nn.Linear(256, num_classes)

def forward(self, x):

x = self.cnn(x)

x = x.permute(0, 2, 1)

out, _ = self.lstm(x)

out = self.fc(out[:, -1, :])

return out

# 实例化模型

n_channels_dl = X_dl.shape[1]

n_times_dl = X_dl.shape[2]

num_classes_dl = len(np.unique(y_labels.numpy()))

model_dl = CNN_LSTM_MI(n_channels_dl, n_times_dl, num_classes_dl)

# 定义损失函数和优化器

criterion_dl = nn.CrossEntropyLoss()

optimizer_dl = optim.Adam(model_dl.parameters(), lr=0.001)

# 训练循环

num_epochs_dl = 20 # 增加epochs以获得更好的性能

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model_dl.to(device)

for epoch in range(num_epochs_dl):

model_dl.train()

running_loss = 0.0

for batch_X, batch_y in train_loader_dl:

batch_X, batch_y = batch_X.to(device), batch_y.to(device)

optimizer_dl.zero_grad()

outputs = model_dl(batch_X)

loss = criterion_dl(outputs, batch_y)

loss.backward()

optimizer_dl.step()

running_loss += loss.item() * batch_X.size(0)

epoch_loss = running_loss / len(train_dataset_dl)

# 在测试集上评估

model_dl.eval()

y_true_test, y_pred_test = [], []

with torch.no_grad():

for batch_X_test, batch_y_test in test_loader_dl:

batch_X_test, batch_y_test = batch_X_test.to(device), batch_y_test.to(device)

outputs_test = model_dl(batch_X_test)

_, predicted = torch.max(outputs_test.data, 1)

y_true_test.extend(batch_y_test.cpu().numpy())

y_pred_test.extend(predicted.cpu().numpy())

accuracy = accuracy_score(y_true_test, y_pred_test)

print(f"Epoch {epoch+1}/{num_epochs_dl}, Loss: {epoch_loss:.4f}, Test Accuracy: {accuracy:.4f}")

print("--- 深度学习模型训练完成 ---")

# 最终评估报告

print("\n--- 深度学习模型最终评估报告 ---")

print(classification_report(y_true_test, y_pred_test))

print("Confusion Matrix:\n", confusion_matrix(y_true_test, y_pred_test))七、 结论:迈向更智能、更易用的MI BCI

通过本次MI BCI系统构建的对比研究,我们清晰地看到,无论是经典的CSP+LDA/SVM方法,还是更先进的**深度学习(CNN-LSTM)**方法,都在"意念控制"领域展现了强大的潜力。

-

经典方法简单高效,易于实现和解释,在一定条件下能达到不错的性能,是理解MI BCI原理的绝佳起点。

-

深度学习方法则通过自动化的特征学习和对复杂时空模式的捕捉,将MI BCI的性能推向了新的高度,尤其在准确率和对个体差异的鲁棒性方面表现更优。

未来的MI BCI将是一个融合多学科知识的领域。随着2025年最新研究的不断涌现,我们期待看到更多可解释的深度学习模型 、更强大的预训练基础模型 以及更实用的实时嵌入式BCI系统的出现。这些进步将使MI BCI系统更加智能、易用,真正赋能残疾人士,并在更广泛的领域改变人机交互的方式。

希望本文的理论解析和实战代码能激发你对MI BCI的兴趣,并为你进一步探索脑机接口的奥秘提供坚实的基础。

致谢与讨论:

感谢阅读本篇博客!如果你对运动想象BCI、CSP+LDA/SVM、深度学习方法或相关代码实现有任何疑问,或者对最新的研究进展有独到见解,欢迎在评论区留言讨论。期待与你共同探索脑电分析的无限魅力!

参考资源:

-

MNE-Python官方文档: https://mne.tools/

-

PyTorch官方文档: https://pytorch.org/

-

scikit-learn官方文档: https://scikit-learn.org/

-

BCI Competition IV: http://www.bbci.de/competition/iv/

-

PhysioNet EEG Motor Movement/Imagery Dataset: https://physionet.org/content/eegmmidb/1.0.0/