文末附下载链接

开发目的

近年来,随着城市化进程的加快和人口老龄化的加剧,公共场所尤其是地铁站、养老院、医院、商场等人流密集区域中,行人跌倒事件频发,已成为威胁公共安全与人身健康的重要隐患。一旦发生跌倒,若未能及时发现并施救,轻则造成身体损伤,重则可能引发严重并发症甚至危及生命,尤其对老年人群体而言风险更为突出。尽管当前多数场所已部署视频监控系统,但传统监控仍依赖人工值守,存在人力成本高、响应滞后、易疲劳漏判等问题,难以实现全天候、实时有效的异常行为识别。为此,亟需一种智能化、自动化的行为检测手段,以提升应急响应效率,降低二次伤害风险。基于此背景,本系统融合YOLOv8目标检测算法、Flask后端框架与Layui前端技术,构建了一套高效、稳定、可落地的行人跌倒行为智能识别系统。YOLOv8凭借其卓越的检测精度、多尺度适应能力以及在复杂场景下的鲁棒性,能够在不同光照、遮挡和姿态变化条件下准确识别行人姿态异常;结合Flask构建的轻量级服务架构,实现了视频流的实时处理与预警推送;通过Layui打造直观友好的可视化界面,提升了系统的可操作性与管理效率。该系统不仅弥补了传统监控在主动防护方面的不足,更实现了从"事后查证"向"事中报警、事前预防"的转变,可广泛应用于智慧养老、智慧医疗、智慧安防等多个领域,对于提升社会公共安全水平、推动人工智能技术在民生保障中的深度应用具有重要意义。

YOLO介绍

YOLOv8:目标检测的最新演进

随着深度学习在计算机视觉领域的持续发展,YOLO(You Only Look Once)系列模型不断迭代,从最初的实时检测理念逐步演变为兼顾精度与速度的工业级解决方案。作为该系列的最新成员,YOLOv8由Ultralytics于2023年发布,在架构设计、训练策略和性能表现上实现了显著提升。本文将从骨干网络(Backbone)、Neck结构以及检测头(Head)三个方面深入解析YOLOv8,并对比其与YOLOv3、YOLOv5、YOLOv7之间的核心改进与创新。

一、YOLOv8 网络架构详解

1. 骨干网络(Backbone)

YOLOv8采用CSPDarknet作为主干特征提取网络,但在结构上进行了多项优化。相较于早期版本中使用的标准CSP结构,YOLOv8引入了更现代化的设计思想:使用梯度流更友好的跨阶段局部网络(CSP)变体,结合SiLU(Swish)激活函数替代Mish或LeakyReLU,增强了非线性表达能力。此外,Backbone中的卷积模块全面采用标准卷积(Conv + BatchNorm + SiLU),去除了冗余操作,提升了推理效率。

特别值得注意的是,YOLOv8不再使用传统的Focus或切片操作进行下采样,而是直接采用步长为2的标准卷积进行特征图压缩,避免信息丢失的同时简化了计算流程,使模型更加稳定且易于部署。

2. Neck 结构

Neck部分负责融合不同尺度的特征,以增强模型对多尺度目标的感知能力。YOLOv8沿用了PANet(Path Aggregation Network)的思想,但对其进行了重构与精简。具体而言,它采用了自底向上与自顶向下相结合的双向特征金字塔结构,并在每一层连接中引入了轻量化的卷积模块。

与之前版本相比,YOLOv8的Neck取消了额外的SPP模块独立设置,而是将其整合到Backbone末端,形成SPPF(Spatial Pyramid Pooling Fast)模块,通过串行最大池化操作实现高效感受野扩展,显著提升了小目标检测能力,同时降低了计算开销。

3. 检测头(Head)

YOLOv8最大的革新之一在于其解耦式检测头(Decoupled Head)设计。不同于YOLOv3和YOLOv5中分类与回归共用同一组卷积的操作,YOLOv8将检测头分为两个独立分支:一个用于边界框回归,另一个用于类别预测。这种解耦结构允许网络分别优化两类任务,缓解了两者之间的优化冲突,从而在高精度场景下表现更优。

此外,YOLOv8摒弃了传统的Anchor-Based机制,转而采用Anchor-Free的检测范式。通过基于关键点或中心点的预测方式,模型直接输出目标中心位置及宽高偏移量,减少了先验框设定带来的超参数依赖,提高了泛化能力。

更重要的是,YOLOv8引入了Task-Aligned Assigner作为正负样本匹配策略,动态对齐分类得分与定位精度,确保高质量的正样本被有效利用;同时配合Distribution Focal Loss(DFL)和CIoU Loss,进一步提升定位准确性。

二、与YOLOv3、YOLOv5、YOLOv7 的对比分析

| 特性 | YOLOv3 | YOLOv5 | YOLOv7 | YOLOv8 |

|---|---|---|---|---|

| Backbone | Darknet-53 | CSPDarknet | E-ELAN | CSPDarknet(优化版) |

| Neck | FPN + PANet | PANet | Extended-PAN | 改进型PAN(轻量化) |

| Head 类型 | Anchor-Based | Anchor-Based | Anchor-Based | Anchor-Free + 解耦头 |

| 激活函数 | LeakyReLU | SiLU | SiLU | SiLU |

| 下采样方式 | Focus | Conv(stride=2) | Conv(stride=2) | Conv(stride=2) |

| 正样本分配 | K-means聚类Anchor | SimOTA / 自动标签分配 | Dynamic Label Assignment | Task-Aligned Assigner |

| 损失函数 | BCE + CIoU | BCE + CIoU | CIOU + 其他辅助损失 | DFL + CIoU + TAL |

| 是否支持分类/分割 | 否 | 是(衍生版本) | 有限支持 | 原生支持多任务 |

1. 相比 YOLOv3 的改进:

YOLOv3是Anchor-Based检测器的经典代表,但其Backbone较深却缺乏有效梯度流动机制,Neck结构简单,且使用逻辑回归进行锚框筛选,效率低下。YOLOv8不仅在整体架构上全面升级,还引入了解耦头、Anchor-Free机制和先进的标签分配策略,大幅提升了检测精度与训练稳定性。

2. 相比 YOLOv5 的进步:

虽然YOLOv5已在工程化方面表现出色,具备良好的可读性和部署便捷性,但其检测头仍为耦合式结构,限制了性能上限。YOLOv8在此基础上引入了解耦头与Task-Aligned Assigner,显著增强了分类与定位的一致性;同时通过更合理的Neck设计和SPPF模块,提升了小目标检测能力。

3. 相比 YOLOv7 的创新:

YOLOv7强调"复合缩放"与"模型重参数化",在特定硬件条件下追求极致速度。然而其结构复杂,训练过程繁琐。YOLOv8则回归简洁高效的设计哲学,在保持高性能的同时大幅简化训练流程,原生支持分类、检测、实例分割等任务,具备更强的通用性与扩展性。

总结

YOLOv8标志着YOLO系列从"快速可用"向"精准智能"的重要跨越。它在骨干网络中强化了特征提取能力,在Neck部分优化了多尺度融合效率,在检测头上实现了解耦与Anchor-Free的深度融合。结合先进的标签分配机制与损失函数设计,YOLOv8在精度、速度与鲁棒性之间达到了新的平衡。

无论是学术研究还是工业应用,YOLOv8都已成为当前目标检测领域最具竞争力的模型之一。它的出现不仅是技术上的迭代,更是设计理念的升华------以简洁架构实现卓越性能,真正做到了"极简而不简单"。

系统设计

数据集

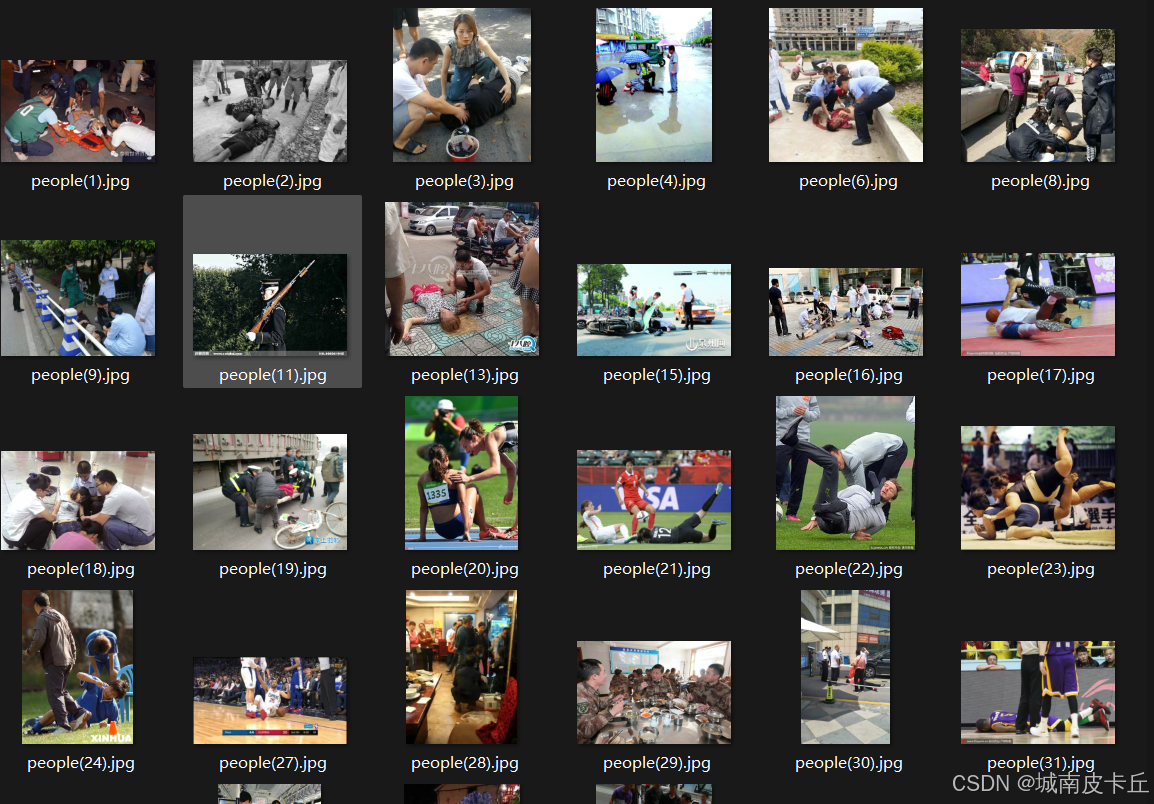

(1) 数据集基本情况

本系统所使用的数据集为专门针对行人跌倒行为构建的目标检测数据集。数据集已划分为训练集和验证集两个部分,其中:

- 训练集包含 6395 张标注图像

- 验证集包含 152 张标注图像

该数据集共包含两个类别:stand person(站立的人)和 fall down(跌倒的人),旨在实现对行人姿态的有效识别与分类。所有图像均已使用LabelMe工具进行精确标注,并转换为标准的YOLO格式 .txt 文件,配合提供完整的 classes.yaml 类别配置文件,可直接用于YOLO系列模型的训练。

经实测,在YOLOv8n模型上训练后,平均mAP@0.5达到81.5%,表明该数据集具有较高的质量和实用性,能够有效支持跌倒行为识别任务。

(2) 数据集处理

在完成图像采集后,我们使用 LabelMe 工具对原始图像进行人工标注。LabelMe 是一个开源的图像标注工具,支持多边形、矩形、点等多种标注方式,适用于目标检测、语义分割等任务。

标注流程如下:

- 使用 LabelMe 打开每张图像;

- 使用矩形框(Bounding Box)标注出"站立"或"跌倒"的行人区域;

- 为每个标注框指定对应的类别标签(

stand person或fall down); - 导出为 JSON 格式的标注文件。

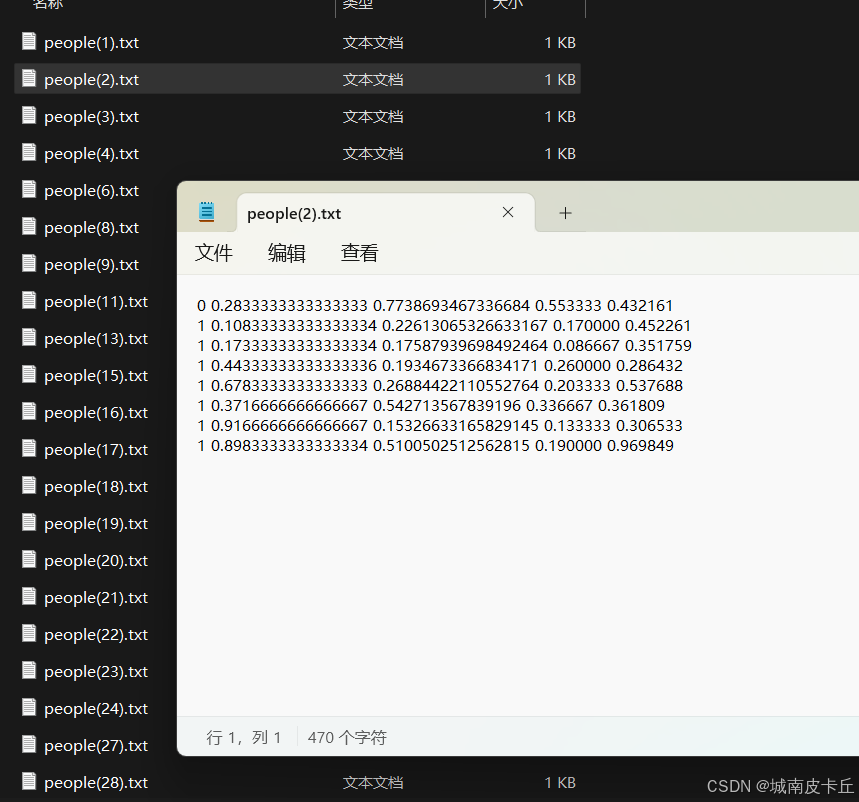

随后,我们将 LabelMe 生成的 JSON 文件批量转换为 YOLO 目标检测所需的格式。YOLO 数据集的标准格式要求如下:

-

每张图像对应一个同名的

.txt标注文件; -

每行表示一个目标对象,格式为:

class_id center_x center_y width height其中坐标均为归一化后的相对值(范围 [0,1]);

-

class_id为类别索引(从0开始); -

图像尺寸信息无需写入文本,由程序读取图像自动获取。

最终目录结构示例如下:

dataset/

├── images/

│ ├── train/

│ └── val/

├── labels/

│ ├── train/

│ └── val/

└── data.yaml其中 data.yaml 包含训练所需的基本信息:

yaml

train: ./images/train

val: ./images/val

nc: 2

names: ['stand person', 'fall down']模型训练

安装 Ultralytics

Ultralytics 是 YOLOv8 的官方实现库,提供了简洁高效的训练接口。安装命令如下:

bash

pip install ultralytics支持 PyTorch 和 CUDA 环境,推荐使用 GPU 加速训练以提升效率。

训练代码编写

使用 Ultralytics 进行模型训练非常简单,只需几行代码即可启动:

python

from ultralytics import YOLO

# 加载预训练模型

model = YOLO('yolov8n.pt') # 可替换为s/m/l/x版本

# 开始训练

results = model.train(

data='data.yaml', # 数据集配置文件路径

epochs=100, # 训练轮数

imgsz=640, # 输入图像大小

batch=16, # 每批次样本数量

name='fall_detection' # 实验名称

)训练参数设置(超参数详解)

在调用 model.train() 时,可通过多种超参数控制训练过程。以下是关键超参数及其含义说明:

| 超参数 | 默认值 | 含义说明 |

|---|---|---|

epochs |

100 | 总训练轮数,控制模型学习时间 |

batch |

16 | 每个批次处理的图像数量,影响内存占用和梯度稳定性 |

imgsz |

640 | 输入图像的尺寸(H×W),越大细节越丰富但计算量增加 |

lr0 |

0.01 | 初始学习率,决定参数更新步长 |

lrf |

0.01 | 最终学习率 = lr0 × lrf,用于学习率衰减 |

momentum |

0.937 | SGD优化器动量项,帮助收敛更稳定 |

weight_decay |

0.0005 | L2正则化系数,防止过拟合 |

warmup_epochs |

3.0 | 学习率预热阶段的epoch数 |

warmup_momentum |

0.8 | 预热阶段的动量值 |

box |

7.5 | 边界框回归损失权重 |

cls |

0.5 | 分类损失权重 |

dfl |

1.5 | 分布式焦点损失(DFL)权重 |

fl_gamma |

0.0 | Focal Loss gamma 参数,设为0则不启用 |

hsv_h |

0.015 | 图像增强:HSV色调抖动幅度 |

hsv_s |

0.7 | 图像增强:HSV饱和度抖动幅度 |

hsv_v |

0.4 | 图像增强:HSV明度抖动幅度 |

degrees |

0.0 | 图像增强:随机旋转角度范围 |

translate |

0.1 | 图像增强:平移比例 |

scale |

0.5 | 图像增强:缩放比例 |

shear |

0.0 | 图像增强:剪切变换角度 |

perspective |

0.0 | 图像增强:透视变换系数 |

flipud |

0.0 | 图像增强:上下翻转概率 |

fliplr |

0.5 | 图像增强:左右翻转概率 |

mosaic |

1.0 | Mosaic数据增强概率(0~1) |

mixup |

0.0 | MixUp增强概率 |

copy_paste |

0.0 | Copy-Paste增强概率 |

这些超参数可根据实际任务需求调整,例如在小数据集上可适当降低 scale、关闭 mosaic 以防过拟合;对于跌倒这类细粒度识别任务,可适当提高 box 权重以强化定位能力。

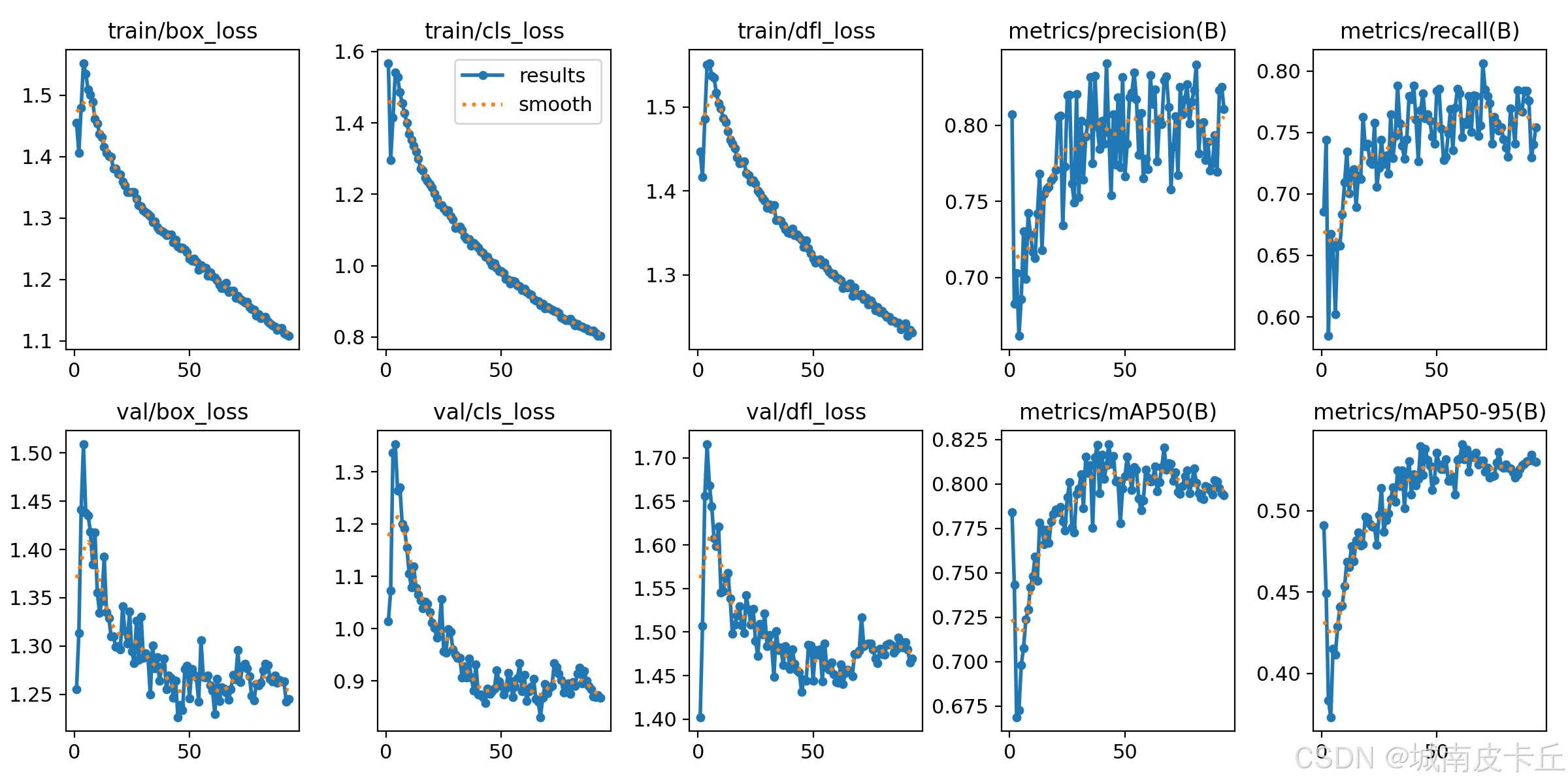

训练后评估

为什么需要模型评价?

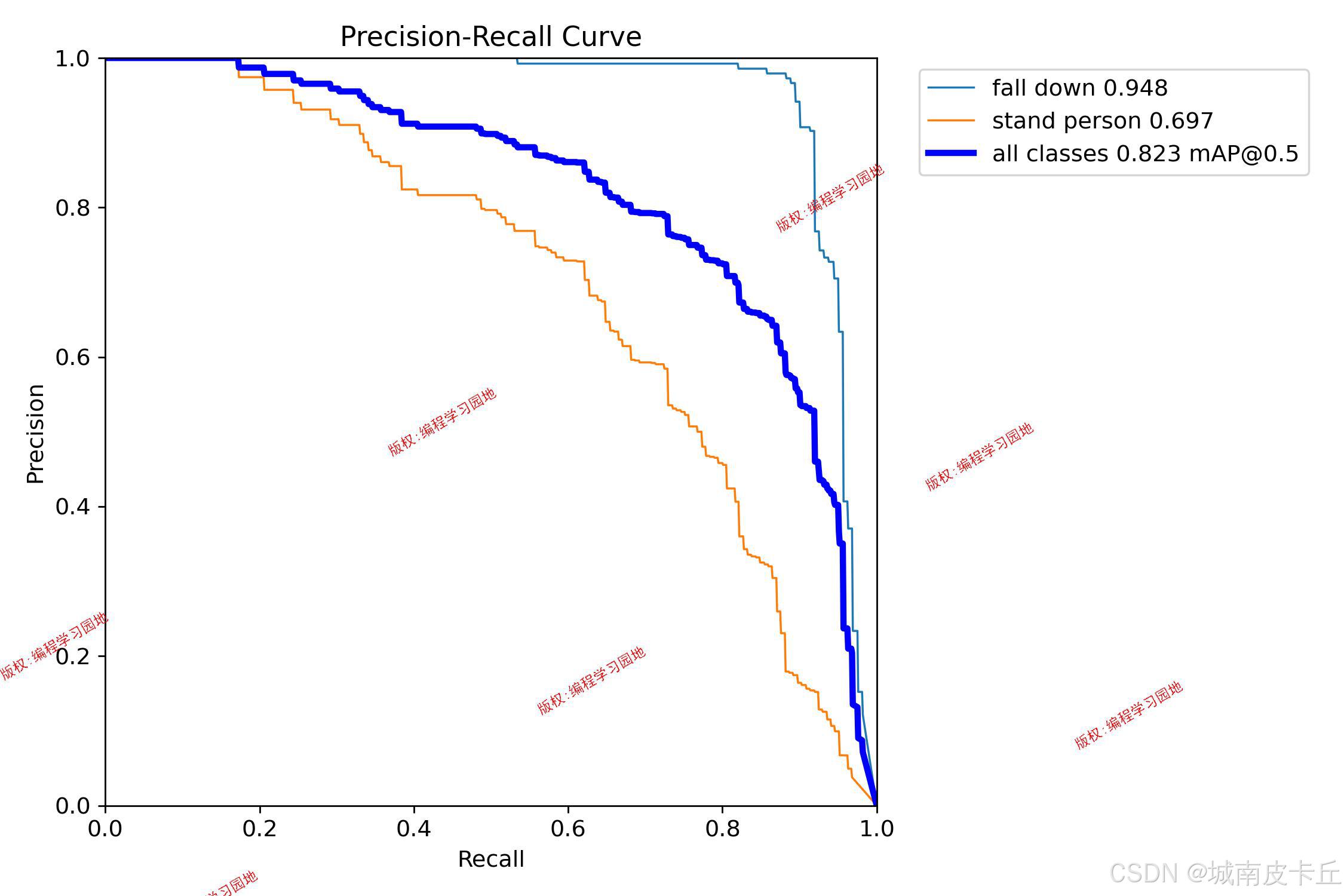

模型训练完成后,必须通过科学的评估指标判断其性能优劣。仅看准确率无法全面反映模型表现,特别是在目标检测任务中,还需考虑定位精度、召回能力、误检率等因素。因此引入 PR 曲线、mAP 等专业指标进行综合评估。

PR曲线(Precision-Recall Curve)

PR曲线是衡量分类器在不同置信度阈值下性能的重要工具。

-

精确率(Precision) :预测为正类的样本中,真实为正类的比例。

P = T P T P + F P P = \frac{TP}{TP + FP} P=TP+FPTP -

召回率(Recall) :真实为正类的样本中,被正确预测为正类的比例。

R = T P T P + F N R = \frac{TP}{TP + FN} R=TP+FNTP

其中:

- TP(True Positive):正确检测到的跌倒人数

- FP(False Positive):将非跌倒误判为跌倒的数量

- FN(False Negative):未能检测到的真实跌倒人数

PR曲线以 Recall 为横轴,Precision 为纵轴绘制。曲线下面积(AUC)越大,说明模型整体性能越好。

mAP(mean Average Precision)

mAP 是目标检测领域的核心评价指标,表示各类别 AP 的平均值。

- AP(Average Precision):PR曲线下面积,常用插值法计算(如11点插值或所有点积分)

- mAP@0.5:IoU阈值为0.5时的mAP

- mAP@0.5:0.95:IoU从0.5到0.95每隔0.05取一次mAP再求平均,更能反映模型鲁棒性

YOLO默认输出 mAP@0.5 和 mAP@0.5:0.95 两项指标,数值越高代表检测性能越强。

本项目中,YOLOv8n 在验证集上达到了 81.5% 的 mAP@0.5 ,表明模型具备较强的跌倒行为识别能力。

模型推理

图片推理代码

利用训练好的模型进行单张图片推理:

python

from ultralytics import YOLO

from PIL import Image

# 加载模型

model = YOLO('weights/best.pt')

# 推理

results = model.predict(source='test.jpg', conf=0.25, iou=0.45, save=True)

# 显示结果

for r in results:

im_array = r.plot() # 绘制带标签的结果图

im = Image.fromarray(im_array[..., ::-1]) # BGR to RGB

im.show()视频推理代码

对视频文件进行逐帧检测并保存结果:

python

results = model.predict(

source='input_video.mp4',

conf=0.25,

iou=0.45,

save=True,

project='runs/detect',

name='fall_video_result'

)

# 实时显示FPS

for result in results:

annotated_frame = result.plot()

cv2.putText(annotated_frame, f"FPS: {fps:.2f}", (20, 50),

cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2)

cv2.imshow("Fall Detection", annotated_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break系统还支持摄像头实时检测(source=0),可用于监控场景下的即时响应。

系统设计

本系统采用前后端分离架构,基于YOLOv8目标检测模型、Flask轻量级Web框架与Layui前端UI库构建完整的行人跌倒行为检测平台。系统整体分为前端展示层、后端服务层与模型推理层三大模块。

后端服务层 由Flask框架驱动,负责处理用户请求、管理文件上传、调用模型进行推理,并通过SocketIO实现实时消息推送。系统支持图片单张检测、批量压缩包识别、本地视频分析及摄像头实时监控四大功能。所有检测结果均保存至SQLite数据库,并提供完整的记录查询与删除接口。关键路由包括/image/infer用于图像检测,/video/infer处理视频流,/webcam_infer实现摄像头实时检测,以及各类数据管理接口。

模型推理层 基于Ultralytics YOLOv8n模型,针对自建的跌倒检测数据集(包含6395张训练图像,验证集152张,mAP50达81.5%)进行训练,识别两类目标:"站立"与"跌倒"。模型通过model.predict()方法完成推理,设置conf=0.25、iou=0.45以平衡精度与召回率。系统利用多线程ThreadPoolExecutor处理批量图像任务,确保主线程不被阻塞。

前端展示层采用Layui构建响应式管理界面,包含登录注册、权限控制、检测模块与信息管理四大板块。通过HTML模板与JavaScript脚本实现交互逻辑,利用Layui Table组件展示检测记录,支持分页、搜索与导出。WebSocket与SocketIO结合实现前端实时接收检测进度与告警信息,当检测到"跌倒"类别时触发弹窗提醒。系统还提供滑动条调节置信度与IOU阈值,并可通过模型管理界面动态加载不同权重文件。

整个系统通过app.py主程序启动,监听5000端口,结合Layui的Tab选项卡实现无刷新页面切换,形成一个集检测、可视化、管理于一体的完整解决方案,具备良好的可扩展性与部署便捷性。

系统UI设计

本系统前端采用 Layui 轻量级Web UI框架,具有以下优势:

- 模块化设计:按需加载组件,提升页面加载速度;

- 风格简洁美观:内置丰富的表单、按钮、表格、弹窗等UI元素,符合现代审美;

- 易于集成:基于原生HTML/CSS/JS开发,无需额外编译环境,便于与Flask后端快速对接;

- 响应式布局:适配PC与移动端访问;

- 文档完善:官方提供详细API文档和示例,降低开发门槛;

- 兼容性强:支持主流浏览器,包括IE9+。

结合 Flask 提供的模板引擎(Jinja2),我们可以轻松实现前后端数据交互与动态渲染。

系统主界面通过 index.html 构建左侧导航栏与顶部标题栏,采用 Layui 的 layui-layout-admin 布局结构:

html

<div class="layui-layout layui-layout-admin">

<div class="layui-header">...</div>

<div class="layui-side">...</div>

<div class="layui-body">

<div class="layui-tab" lay-filter="demo">

<ul class="layui-tab-title"></ul>

<div class="layui-tab-content"></div>

</div>

</div>

</div>通过 JavaScript 动态添加选项卡(Tab)来切换功能页面,如图片检测、视频分析、用户管理等:

js

active.tabAdd = function(url, id, name) {

element.tabAdd('demo', {

title: name,

content: `<iframe src="${url}.html" style="width:100%;height:99%;"></iframe>`,

id: id

});

}各子页面通过 iframe 内嵌独立 HTML 文件(如 image.html, video.html),实现模块解耦。

例如,在 image.html 中使用 Layui 的上传组件实现图片上传:

html

<button type="button" id="upload_image" class="layui-btn">上传图片</button>

<script>

layui.use('upload', function(){

var upload = layui.upload;

upload.render({

elem: '#upload_image',

url: '/image/infer',

done: function(res){

$('#imgae_det').attr("src", 'data:image/png;base64,' + res.det_img);

}

});

});

</script>同时利用 Layui Table 展示检测记录列表,并支持分页、搜索、导出等功能:

js

table.render({

elem: '#userTable',

url: '/image/selectAll',

cols: [[

{field:'id', title:'ID'},

{field:'ori_image', title:'原始图片', templet: toImg},

{field:'date', title:'检测时间'}

]]

});整个系统界面整洁直观,操作流畅,极大提升了用户体验。

系统功能

基于提供的源码分析,该行人跌倒行为检测系统具备以下主要功能:

1. 用户认证模块

- 支持用户注册与登录:系统具备注册登录、权限管理功能,分为普通用户角色和管理员角色。用户通过用户名、密码、验证码注册、登录

- 基于 Session 的权限控制(区分 admin / user)

- 用户信息增删改查(管理员专属)

- 管理员:管理所有用户的图片、视频、摄像头记录,包含查看与删除所有用户检测记录;管理所有用户的账号密码;调整模型的参数

- 普通用户:仅能访问自身检测记录,禁止操作他人数据;修改自己账号密码

2.支持多种检测方式

系统支持图片检测、批量图片检测、视频检测、本地摄像头检测

- 图片检测:上传单张图片,返回检测结果(类别、置信度、边界框),识别到异常类目时触发弹窗提示。结果可视化:原始图与检测图双栏对比。识别后结果数据库保存、本地目录保存。

- 批量图片检测:支持ZIP格式图片压缩包上传检测(单包最大100MB),上传后显示实时检测进度条(0%-100%)。批量检测完成后可下载检测结果,同时本地目录冗余备份保存

- 视频检测: 上传视频文件(最大100MB),前端显示带检测框的标注视频,连续检测到异常时弹窗报警,数据库保存对应检测信息,本地目录保存检测后的结果视频

- 本地摄像头检测:一键打开本地电脑的摄像头,实时显示带检测框的检测画面,连续检测到异常时弹窗报警,数据库保存检测结果信息,本地目录保存检测后的结果视频

3.模型参数配置

- 动态调整检测参数:置信度阈值(默认25%)、IOU阈值(默认45%)。

- 支持模型热更新,无需重启服务。

4.检测数据管理

- 可以历史图片、视频、摄像头检测记录进行管理。支持检测记录查询,支持按时间、类别、用户角色筛选检测记录,记录包含:检测时间、耗时、类别、置信度、操作用户等字段。

- 在视频、摄像头检测记录中可点击链接弹窗播放原始视频和检测后的视频。

- 用户可删除自身检测记录(图片、视频、摄像头等检测记录)。

总结

本文围绕基于YOLOv8 + Flask + Layui的行人跌倒行为检测系统,全面阐述了系统的开发背景、核心技术选型与整体架构设计。该系统立足于应对城市化与老龄化背景下公共场所跌倒事件频发的社会痛点,突破传统监控依赖人工值守的局限,构建了一套集智能化识别、可视化管理和实时化预警于一体的综合性解决方案。

在技术层面,系统充分发挥YOLOv8模型在目标检测领域的先进优势,通过其优化的C2f骨干网络、高效PANet融合结构与解耦检测头设计,实现了对"跌倒"与"站立"两类行为的高精度、低延迟识别。结合Flask构建稳定可靠的后端服务,支撑图片、视频及摄像头等多种数据源的并发处理,并借助Layui打造简洁直观的前端界面,实现检测过程的全流程可视化与用户友好的交互体验。

系统不仅完成了从数据输入、模型推理到结果输出的闭环设计,还集成了用户权限管理、检测记录存储、告警提示与参数配置等实用功能,具备较强的工程落地能力。未来可进一步拓展多目标跟踪、跌倒风险预测、自动报警联动等高级功能,推动系统在智慧养老、平安校园、医疗监护等更多场景中的深度应用,真正实现人工智能技术服务于民、造福社会的价值目标。

另外,限于本篇文章的篇幅,无法一一细致讲解系统原理、项目代码、模型训练等细节,需要数据集、整套项目源码、训练代码的小伙伴可以从下面的链接中下载:

yolo+falsk跌倒检测系统 跌倒数据集 行人跌倒检测管理系统