【大模型】深入理解大模型输出的Temperature、Top-k与Top-p采样

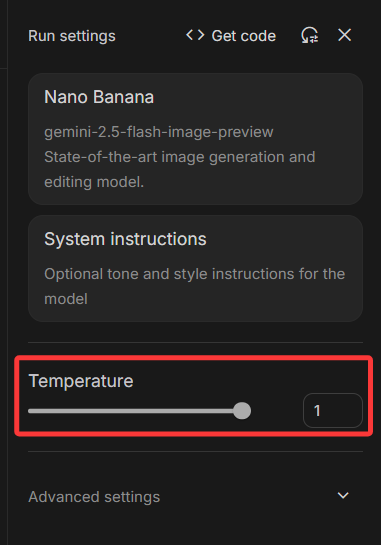

在与大型语言模型(LLM)如GPT系列、Llama等交互时,我们常常惊叹于它们生成文本的多样性和创造力。但你是否想过,这些模型是如何在"一本正经"地回答事实性问题和"天马行空"地进行文学创作之间自由切换的?这背后的"魔法"其实源于一系列精妙的参数控制,其中最核心的便是Temperature 、Top-k 和Top-p 等。现在有的大模型可视化API调用程序(如 Google AI Studio 等)已经支持用户自主调控这些参数。

本文将以通俗易懂的方式,带你深入理解这些参数的原理、作用以及它们之间的关系,并提供在Hugging Face Transformers库中应用的实战代码,帮助你精准地"调教"属于自己的大模型。

文章目录

-

- 【大模型】深入理解大模型输出的Temperature、Top-k与Top-p采样

-

- 一、为何需要采样策略?

- 二、"创意旋钮":Temperature

-

- [1. 原理](#1. 原理)

- [2. 应用场景](#2. 应用场景)

- [三、限定选择范围的策略:Top-k 与 Top-p](#三、限定选择范围的策略:Top-k 与 Top-p)

-

- [1. Top-k Sampling:固定的候选菜单](#1. Top-k Sampling:固定的候选菜单)

- [2. Top-p (Nucleus) Sampling:动态的候选圈子](#2. Top-p (Nucleus) Sampling:动态的候选圈子)

- 四、参数组合与实战建议

-

- [Hugging Face Transformers 实战代码](#Hugging Face Transformers 实战代码)

- 五、其他值得关注的采样概念

- 总结

一、为何需要采样策略?

首先,我们需要明白大模型生成文本的基本原理。在接收到输入 (Prompt)后,模型会在每一步预测词汇表中所有可能出现的下一个词(Token)的概率分布。

例如,对于输入"今天天气真不错,我们一起去",模型可能会预测出:

- "公园":概率 0.5

- "散步":概率 0.3

- "吃饭": 概率 0.15

- "学习":概率 0.04

- ... (以及其他成千上万个词的极低概率)

如果模型每次都选择概率最高的词(即"贪心搜索",Greedy Search),那么对于同一个输入,输出将永远是固定不变的。这虽然保证了结果的确定性和一致性,但也扼杀了模型的所有创造力,使其变得机械和乏味。

为了让模型的输出更富有多样性和趣味性,我们需要引入一些"随机性",这就是**采样(Sampling)**策略的用武之地。

二、"创意旋钮":Temperature

Temperature(温度)是最常见也是最重要的采样参数,它可以被看作是控制模型输出创造力 和随机性的"总开关"。

1. 原理

Temperature的核心思想是调整原始的概率分布。它通过一个名为Softmax的函数作用于模型预测的原始概率(Logits)。

- 低温 (如 0.1, 0.2) :当

temperature值小于1时,它会"锐化"概率分布,使得高概率的词语的概率变得更高,低概率词语的概率变得更低。当温度趋近于0时,采样就几乎等同于贪心搜索,模型会坚定地选择最可能的那个词。 - 高温 (如 0.8, 1.0, 1.5) :当

temperature值大于1时,它会"平滑"概率分布,拉近高概率词语和低概率词语之间的差距,使得原本不太可能的词也有机会被选中。这会增加输出的随机性、多样性和新颖性,但过高的温度也可能导致输出内容偏离主题、出现事实错误甚至变得胡言乱语。 - 默认温度 (通常为1.0):此时不对原始概率做任何改变。

可以形象地理解为:低温让模型"三思而后行",更倾向于安全、常见的表达;而高温则鼓励模型"大胆想象",进行更具探索性的创作。

2. 应用场景

- 低Temperature (0.1 ~ 0.4) :适用于需要事实准确、逻辑严谨 的场景,如:

- 知识问答

- 代码生成

- 数学解题

- 文本摘要

- 高Temperature (0.7 ~ 1.2) :适用于需要创造力、多样性 的场景,如:

- 创意写作(诗歌、小说)

- 市场营销文案

- 角色扮演对话

- 头脑风暴

三、限定选择范围的策略:Top-k 与 Top-p

虽然Temperature可以控制输出的随机性,但有时我们希望在保持一定创造力的同时,避免模型选到那些极其不靠谱的词 。这时,就需要Top-k 和Top-p这样的截断(Truncation)策略来限定采样的候选范围。

1. Top-k Sampling:固定的候选菜单

Top-k 的原理非常简单直接:在每一步生成时,模型会先选出概率最高的k个词,然后仅在这k个词中进行采样(通常会结合Temperature)。其他所有词都会被忽略。

举例来说:

假设k=3,对于上面的例子("公园": 0.5, "散步": 0.3, "吃饭": 0.15, "学习": 0.04...),模型只会从"公园"、"散步"、"吃饭"这三个词中选择下一个词,而"学习"等其他词则完全没有机会。

优点:

- 简单高效,能有效防止模型选到概率极低的"垃圾"词汇。

缺点:

- 不够灵活。在某些情况下,概率分布可能非常"尖锐"(如模型对下一个词非常确定),此时可能只有1-2个合适的选项,但Top-k仍会强制凑齐k个。而在另一些情况下,概率分布可能非常"平坦"(多个词的概率都很接近),此时合适的选项可能远多于k个,Top-k则会过早地截断,限制了多样性。

注:Top-k操作也常常用于模型训练过程中,但是由于其"分段"的特性,使得其不可微,从而给模型训练中的梯度下降等步骤造成困难。有一种

SOFT Top-k技术常常用于使其可微化,从而能够用于模型训练之中。可以参见我的这一篇文章:【深度学习】SOFT Top-k:用最优传输解锁可微的 Top-k 操作 。

2. Top-p (Nucleus) Sampling:动态的候选圈子

为了解决Top-k的"一刀切"问题,Top-p(又称Nucleus Sampling,核心采样)应运而生。它不限制候选词的数量,而是根据累积概率来动态地确定候选集。

Top-p 的原理是:设定一个概率阈值p(如0.9),然后将所有词按概率从高到低排序,并逐个累加它们的概率,直到总和超过p为止。这个由累加构成的词汇子集就是"核心(Nucleus)",模型将在下一步仅从这个核心子集中进行采样。

举例来说:

假设p=0.85,对于上面的例子:

- 选择"公园"(概率0.5),累积概率为0.5。 (0.5 < 0.85)

- 选择"散步"(概率0.3),累积概率为 0.5 + 0.3 = 0.8。 (0.8 < 0.85)

- 选择"吃饭"(概率0.15),累积概率为 0.8 + 0.15 = 0.95。 (0.95 > 0.85)

此时,累积概率超过了0.85,于是采样的候选集就是{"公园", "散步", "吃饭"}。

优点:

- 自适应和灵活。当模型非常确定时(某个词概率很高),核心集会很小;当模型不太确定时(多个词概率接近),核心集会相应变大。这使得它在保持文本质量和多样性之间取得了更好的平衡。

缺点:

- 理解起来比Top-k稍微复杂一些。

四、参数组合与实战建议

在实际应用中,这些参数通常组合使用,以达到最佳效果。

- Temperature是基础,几乎总是需要调整。

- Top-p是目前更主流的选择 ,因为它比Top-k更智能。通常建议只使用Top-p或Top-k中的一个。如果你同时设置了两者,Hugging Face等库会先应用Top-k,再在其结果上应用Top-p,这可能会导致意想不到的结果。

- 一个常见的组合是同时设置

temperature和top_p。例如,temperature=0.7,top_p=0.9。这表示先用温度调整概率分布,然后从累积概率达到90%的核心词汇中进行采样。

Hugging Face Transformers 实战代码

以下是如何在Hugging Face transformers库中使用generate()函数来应用这些参数的示例:

python

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载模型和分词器

model_name = "gpt2" # 可以替换为其他模型,如 "Llama-2-7b-chat-hf"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 准备输入

prompt = "The future of artificial intelligence is"

inputs = tokenizer(prompt, return_tensors="pt")

# --- 示例 1: 偏向确定性的生成 (类似问答) ---

output_deterministic = model.generate(

**inputs,

max_new_tokens=50,

temperature=0.2,

top_k=5, # 限制在最可能的5个词中

do_sample=True, # 必须开启采样

pad_token_id=tokenizer.eos_token_id

)

print("--- Deterministic Output ---")

print(tokenizer.decode(output_deterministic[0], skip_special_tokens=True))

# --- 示例 2: 富有创造力的生成 (类似写作) ---

output_creative = model.generate(

**inputs,

max_new_tokens=50,

temperature=0.8,

top_p=0.9, # 使用Top-p,更灵活

do_sample=True,

pad_token_id=tokenizer.eos_token_id

)

print("\n--- Creative Output ---")

print(tokenizer.decode(output_creative[0], skip_special_tokens=True))

# --- 示例 3: 高度随机的生成 (可能不连贯) ---

output_random = model.generate(

**inputs,

max_new_tokens=50,

temperature=1.5, # 高温

do_sample=True,

pad_token_id=tokenizer.eos_token_id

)

print("\n--- Highly Random Output ---")

print(tokenizer.decode(output_random[0], skip_special_tokens=True))注意 :要使temperature, top_k, top_p生效,必须将do_sample参数设置为True。

五、其他值得关注的采样概念

除了上述三个核心参数,还有一些其他的采样技术:

- Typical Sampling (

typical_p):一种更新的采样方法,它试图选择"典型"的词,而不是仅仅概率最高的词,旨在生成更自然、更符合人类语言习惯的文本。 - Mirostat Sampling: 一种更复杂的采样算法,它试图将生成文本的"困惑度(Perplexity)"维持在一个目标范围内,从而在多样性和连贯性之间取得动态平衡。

总结

掌握Temperature, Top-k和Top-p是有效利用大型语言模型的关键一步。它们共同构成了控制模型输出行为的强大工具箱。

| 参数 | 控制方式 | 效果 | 适用场景 |

|---|---|---|---|

| Temperature | 调整概率分布的平滑度 | 控制随机性/创造力 | 通用,低值求稳,高值求新 |

| Top-k | 选取概率最高的k个词 | 限制候选集大小(固定) | 简单场景,快速过滤低概率词 |

| Top-p | 选取累积概率超过p的词集 | 限制候选集大小(动态) | 推荐,在多样性和连贯性间取得更好平衡 |

通过不断实验和调整这些参数的组合,你将能更好地引导模型,让它在不同任务下都能生成符合你预期的、高质量的文本。

希望这篇博客能为你揭开大模型生成文本的神秘面纱,助你成为一名更出色的AI应用者!