当AI看懂交通摄像头:多模态大模型零样本检测的实战报告

论文信息

- 论文原标题:Investigating Traffic Accident Detection Using Multimodal Large Language Models

- 来源:https://arxiv.org/abs/2509.19096. Accepted for presentation at the 2025 IEEE International Automated Vehicle Validation Conference (IAVVC 2025). Final version to appear in IEEE Xplore

一段话总结

本研究聚焦基础设施视角的交通事故检测难题,针对该场景标注数据稀缺的痛点,采用CARLA模拟器生成的DeepAccident数据集,对比了Gemini 1.5、Gemini 2.0、Gemma 3、Pixtral四种多模态大语言模型(MLLMs)的零样本检测能力,并整合YOLO、Deep SORT、SAM构建增强提示。实验发现Pixtral检测性能最优(F1=71%、召回率=83%),Gemma 3性能最均衡;增强提示虽提升部分模型精度但降低召回率,而Word2Vec和Sentence Transformers余弦相似度是评估事故描述语义一致性的最优指标,为实时交通监控系统的模型选型与优化提供了关键参考。

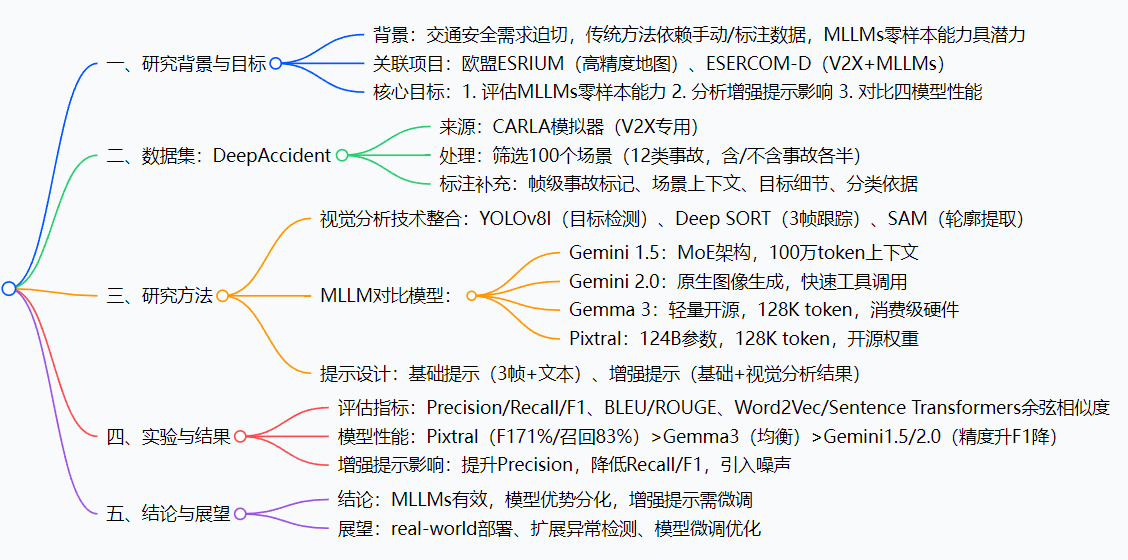

思维导图

研究背景

想象一下:城市路口的监控摄像头24小时运转,能"看"到车辆闯红灯、行人横穿马路,却像"近视眼"一样,看不懂这些行为是否会引发事故------这就是当前交通监控的核心痛点。

传统事故检测方法要么依赖人工盯屏(效率低、易疲劳),要么靠计算机视觉模型(如YOLO)+标注数据训练,但基础设施视角的事故标注数据特别稀缺:真实事故难抓拍,标注成本极高,就像让AI学做数学题却只有10道例题,根本应付不了复杂路况。

同时,随着自动驾驶和智能交通发展,欧盟推出ESRIUM(高精度地图)、ESERCOM-D(V2X+AI)等项目,迫切需要能"理解场景"的AI。而多模态大语言模型(MLLMs)如Gemini、Gemma的出现,带来了"零样本能力"------不用专门训练,给点提示就能处理新任务。于是,研究团队提出:让MLLMs当交通"安全员",直接用监控图像+简单提示检测事故,突破数据瓶颈。

创新点

- 场景聚焦独特:首次专门针对"基础设施固定视角"做MLLMs零样本事故检测,填补了传统动态视角(如行车记录仪)研究的空白,更贴合真实交通监控需求。

- 多模型横向对比:同时测试Google Gemini 1.5/2.0、Gemma 3和Mistral Pixtral四大主流模型,而非单一模型验证,结果更具参考性。

- 增强提示实验:创新性地将YOLO、Deep SORT、SAM的视觉结果融入提示,量化分析"额外信息"对模型性能的影响,为提示工程提供了实战经验。

- 语义评估升级:跳出传统的BLEU/ROUGE指标,证明Word2Vec和Sentence Transformers余弦相似度更适合评估事故描述的语义一致性,让结果分析更精准。

研究方法和思路

研究团队像搭积木一样,分四步构建了完整方案,每一步都瞄准"解决实际问题":

步骤1:搞定"数据积木"------处理DeepAccident数据集

- 从CARLA模拟器生成的DeepAccident数据中,筛选出100个"基础设施视角"场景(12类事故,正常/事故场景各50个),剔除用不上的车辆视角、LiDAR数据。

- 手动给数据"补标签":标注事故发生的具体帧、天气(晴/雨)、时段(昼/夜)、涉事车辆/行人细节,让MLLMs有更清晰的"参考信息"。

步骤2:搭"视觉感知积木"------整合检测/跟踪/分割工具

- YOLOv8l:先"扫一眼"图像,标出车辆、行人等目标的位置(比如"此处有一辆红色轿车")。

- Deep SORT:再"追着看"3帧,给目标分配唯一ID(比如"红色轿车ID=5,连续3帧都在路口"),避免漏判瞬时行为。

- SAM:最后"画轮廓",用绿色标行人、蓝色标车辆,让MLLMs更直观区分目标。

步骤3:选"AI选手"------确定对比模型

挑了4个有代表性的MLLMs:

- Gemini 1.5:大上下文窗口(100万token),适合处理长序列信息;

- Gemini 2.0:擅长图像生成,工具调用快;

- Gemma 3:轻量开源,普通电脑也能跑;

- Pixtral:124B大参数,文档/图像理解能力强。

步骤4:设计"指令积木"------两种提示方案

- 基础提示:给模型3帧连续图像+问题"这是事故吗?描述场景和原因";

- 增强提示:在基础提示里加YOLO检测框、Deep SORT ID、SAM轮廓标记,相当于"给AI画了重点"。

主要成果和贡献

核心成果表格

| 研究问题(RQ) | 实验内容 | 关键结论 |

|---|---|---|

| RQ1:MLLMs零样本能力如何? | 4模型+基础提示检测事故 | Pixtral最优(F1=71%、召回率=83%),Gemma 3最均衡 |

| RQ2:增强提示有用吗? | 对比基础/增强提示性能 | 提精度(如Gemini 1.5达90%)但降召回率(漏检变多),引入噪声 |

| RQ3:哪种指标评估描述更准? | 对比BLEU/ROUGE/语义相似度 | Word2Vec和Sentence Transformers余弦相似度最优 |

实际价值

- 给交通部门"选模型指南":如果怕漏检事故(如高速路口),选Pixtral;如果要稳定运行(如城市次干道),选Gemma 3;如果怕误报(如居民区),可试试增强提示下的Gemini 1.5。

- 提示工程避坑:别盲目给MLLMs加"视觉重点",未经微调的增强提示会帮倒忙,未来需针对性优化。

- 降低落地门槛:零样本能力意味着不用花几百万标注数据,小成本就能让现有监控摄像头"变聪明",加速智能交通落地。

关键问题

-

为什么选DeepAccident数据集,而不是真实事故数据?

答:真实事故数据稀缺且难标注,DeepAccident是CARLA模拟器生成的V2X专用数据,有12类事故场景和基础设施视角图像,能批量提供"可控、多样"的实验素材,解决数据不足问题。

-

Pixtral和Gemma 3各有什么优势,怎么选?

答:Pixtral召回率83%(漏检最少),适合"不能放过任何事故"的核心路段;Gemma 3所有指标波动最小,且开源轻量,适合预算有限、需要稳定运行的场景。

-

增强提示为什么会降低召回率?

答:因为视觉结果里有"噪声"(如正常车辆的检测框),MLLMs没经过专项训练,分不清哪些信息有用,反而被干扰,导致漏判事故。

-

这个研究对普通车主有什么意义?

答:未来交通监控用这些模型,能更快检测事故并自动报警,缩短救援时间;同时也能为自动驾驶车辆提供"路侧AI视角",提升行车安全。

总结

本研究首次系统验证了多模态大语言模型在基础设施视角的零样本交通事故检测能力。通过DeepAccident数据集和四大模型对比实验,发现Pixtral检测性能最优、Gemma 3最均衡,同时揭示了增强提示的"双刃剑"效应------提升精度但降低召回率。研究不仅突破了传统方法依赖标注数据的瓶颈,还为交通监控系统的模型选型、提示优化提供了实战依据,让AI从"能看"交通场景迈向"能懂"事故风险,为智能交通的落地迈出了关键一步。