循环神经网络(RNN):时序数据的深度学习模型

🌟 你好,我是 励志成为糕手 !

🌌 在代码的宇宙中,我是那个追逐优雅与性能的星际旅人。

✨ 每一行代码都是我种下的星光,在逻辑的土壤里生长成璀璨的银河;

🛠️ 每一个算法都是我绘制的星图,指引着数据流动的最短路径;

🔍 每一次调试都是星际对话,用耐心和智慧解开宇宙的谜题。

🚀 准备好开始我们的星际编码之旅了吗?

目录

- 循环神经网络(RNN):时序数据的深度学习模型

-

- 摘要

- RNN的基本原理

- RNN的实现与代码示例

- RNN的挑战与解决方案

-

- 梯度消失与梯度爆炸

- 长短期记忆网络(LSTM)

- 门控循环单元(GRU)

- 其他RNN变体

-

- [1. 双向RNN (BiRNN)](#1. 双向RNN (BiRNN))

- [2. 深度RNN (Deep RNN)](#2. 深度RNN (Deep RNN))

- [3. 神经网络图灵机 (NTM)](#3. 神经网络图灵机 (NTM))

- RNN变体选择指南

- RNN与其他模型的对比

-

- 各种序列模型的对比

-

- [1. 模型架构与性能对比表](#1. 模型架构与性能对比表)

- [2. 不同任务下的模型推荐](#2. 不同任务下的模型推荐)

- GRU的PyTorch实现

- 其他RNN变体与改进

- RNN的应用场景

- RNN与其他模型的对比

- 未来发展趋势

- 总结

- 参考链接

- 关键词标签

摘要

循环神经网络(Recurrent Neural Network,RNN)是一种专为处理时序数据设计的深度学习架构,它通过独特的内部记忆机制,能够捕捉数据中的时间依赖关系,这使得RNN在自然语言处理、语音识别、时间序列预测等领域展现出强大的能力。本文将深入探讨RNN的基本原理、数学模型、常见变体以及实际应用案例。我们将从RNN的基本结构入手,解析其前向传播和反向传播过程,探讨梯度消失问题及其解决方案,并通过实际代码示例演示如何构建和训练RNN模型。此外,我们还将对比RNN与其他深度学习模型的性能差异,分析其优势与局限性,并展望未来发展趋势。无论你是深度学习新手还是有经验的从业者,通过本文的学习,都能对RNN有更深入的理解和应用能力。

RNN的基本原理

什么是循环神经网络

循环神经网络是一种能够处理序列数据的神经网络架构,与传统的前馈神经网络不同,RNN在处理数据时会保留之前的信息,并将其用于当前的计算。这种特性使得RNN特别适合处理具有时间依赖性的数据,如语言、音频和金融时间序列等。

RNN的核心思想是在网络中引入循环连接,使得网络能够在处理序列的每个元素时,不仅仅考虑当前输入,还能考虑之前处理过的信息。

下面的Mermaid图展示了RNN的基本结构:

RNN_单元 隐藏层计算 输入x_t 隐藏状态h_t-1 隐藏状态h_t 输出y_t

图1:RNN基本结构图 - 这个流程图展示了RNN的核心结构,包括输入层、隐藏层和输出层之间的连接关系,以及隐藏状态的循环连接。

RNN的数学模型

RNN的数学模型是理解其工作原理的关键。在每个时间步t,RNN通过以下公式计算隐藏状态和输出:

h t = tanh ( W x h ⋅ x t + W h h ⋅ h t − 1 + b h ) h_t = \tanh(W_{xh} \cdot x_t + W_{hh} \cdot h_{t-1} + b_h) ht=tanh(Wxh⋅xt+Whh⋅ht−1+bh)

y t = W h y ⋅ h t + b y y_t = W_{hy} \cdot h_t + b_y yt=Why⋅ht+by

让我们详细解释这些公式中的各个组件:

-

输入向量 x t x_t xt :在时间步t的输入数据,可以是单词嵌入、音频特征或时间序列值等。假设输入向量的维度为 d i n d_{in} din。

-

隐藏状态 h t h_t ht :RNN的核心组件,它编码了截至时间步t的所有历史信息。隐藏状态的维度通常用 d h d_h dh 表示,这是一个超参数,可以根据任务复杂度调整。

-

输出向量 y t y_t yt :在时间步t产生的输出,维度为 d o u t d_{out} dout。输出可以是分类预测、下一个单词的概率分布或时间序列的预测值等。

-

权重矩阵:

- W x h W_{xh} Wxh:输入到隐藏层的权重矩阵,维度为 d h × d i n d_h \times d_{in} dh×din

- W h h W_{hh} Whh:隐藏层到自身的递归权重矩阵,维度为 d h × d h d_h \times d_h dh×dh

- W h y W_{hy} Why:隐藏层到输出层的权重矩阵,维度为 d o u t × d h d_{out} \times d_h dout×dh

-

偏置项:

- b h b_h bh:隐藏层的偏置向量,维度为 d h × 1 d_h \times 1 dh×1

- b y b_y by:输出层的偏置向量,维度为 d o u t × 1 d_{out} \times 1 dout×1

-

激活函数 anh:引入非线性变换,将线性组合的结果映射到[-1, 1]区间。

隐藏状态 h t h_t ht 是RNN的核心创新,它通过递归连接 W h h ⋅ h t − 1 W_{hh} \cdot h_{t-1} Whh⋅ht−1 实现了对历史信息的记忆。这意味着在计算当前时间步的输出时,RNN不仅考虑了当前输入 x t x_t xt,还考虑了所有之前的输入 x 1 , x 2 , . . . , x t − 1 x_1, x_2, ..., x_{t-1} x1,x2,...,xt−1。

计算过程 权重和偏置 输入层 矩阵乘法

W_{xh} · x_t 矩阵乘法

W_{hh} · h_{t-1} 加法

(W_{xh} · x_t) + (W_{hh} · h_{t-1}) + b_h tanh激活函数

tanh(...) h_t

当前隐藏状态 矩阵乘法

W_{hy} · h_t 加法

(W_{hy} · h_t) + b_y y_t

输出向量 W_{xh}

输入权重矩阵 W_{hh}

循环权重矩阵 W_{hy}

输出权重矩阵 b_h

隐藏层偏置 b_y

输出层偏置 x_t

输入向量 h_{t-1}

上一时刻隐藏状态

图2.1 RNN单个时间步计算过程可视化

矩阵维度分析

为了更清晰地理解RNN的计算过程,让我们分析各组件的维度:

假设:

- 输入向量维度: x t ∈ R d i n × 1 x_t \in \mathbb{R}^{d_{in} \times 1} xt∈Rdin×1

- 隐藏状态维度: h t ∈ R d h × 1 h_t \in \mathbb{R}^{d_h \times 1} ht∈Rdh×1

- 输出向量维度: y t ∈ R d o u t × 1 y_t \in \mathbb{R}^{d_{out} \times 1} yt∈Rdout×1

那么权重矩阵的维度应该是:

- W x h ∈ R d h × d i n W_{xh} \in \mathbb{R}^{d_h \times d_{in}} Wxh∈Rdh×din:将输入映射到隐藏空间

- W h h ∈ R d h × d h W_{hh} \in \mathbb{R}^{d_h \times d_h} Whh∈Rdh×dh:处理隐藏状态的递归连接

- W h y ∈ R d o u t × d h W_{hy} \in \mathbb{R}^{d_{out} \times d_h} Why∈Rdout×dh:将隐藏状态映射到输出空间

时间步t+1 时间步t 时间步t-1 x_{t+1} h_{t+1} y_{t+1} x_t h_t y_t x_{t-1} h_{t-1} y_{t-1} 共享权重

W_{xh}, W_{hh}, W_{hy}

图2.2 RNN多个时间步展开图

通过这些维度设计,我们可以验证矩阵乘法的合法性:

- W x h ⋅ x t ∈ R d h × 1 W_{xh} \cdot x_t \in \mathbb{R}^{d_h \times 1} Wxh⋅xt∈Rdh×1

- W h h ⋅ h t − 1 ∈ R d h × 1 W_{hh} \cdot h_{t-1} \in \mathbb{R}^{d_h \times 1} Whh⋅ht−1∈Rdh×1

- 两者相加再加上 b h ∈ R d h × 1 b_h \in \mathbb{R}^{d_h \times 1} bh∈Rdh×1 后,经过 anh 函数得到 h t ∈ R d h × 1 h_t \in \mathbb{R}^{d_h \times 1} ht∈Rdh×1

- 最后 W h y ⋅ h t + b y ∈ R d o u t × 1 W_{hy} \cdot h_t + b_y \in \mathbb{R}^{d_{out} \times 1} Why⋅ht+by∈Rdout×1 产生输出 y t y_t yt

前向传播的计算过程

RNN的前向传播过程可以概括为以下步骤:

- 初始化隐藏状态 h 0 h_0 h0(通常初始化为零向量)

- 对于每个时间步 t = 1 到 T:

a. 计算当前隐藏状态: h t = tanh ( W x h ⋅ x t + W h h ⋅ h t − 1 + b h ) h_t = \tanh(W_{xh} \cdot x_t + W_{hh} \cdot h_{t-1} + b_h) ht=tanh(Wxh⋅xt+Whh⋅ht−1+bh)

b. 计算当前输出: y t = W h y ⋅ h t + b y y_t = W_{hy} \cdot h_t + b_y yt=Why⋅ht+by - 返回所有时间步的输出和隐藏状态

这种递归计算机制使得RNN能够处理任意长度的序列数据,并且在每个时间步都能够利用历史信息。

从时间维度展开来看,RNN的结构如下所示:

时间步t=3 时间步t=2 时间步t=1 隐藏状态h3 输入x3 输出y3 隐藏状态h2 输入x2 输出y2 隐藏状态h1 输入x1 输出y1

图2.3:RNN时间序列展开图 - 这个图展示了RNN在时间维度上的展开形式,每个时间步都有独立的输入、隐藏状态和输出,并且隐藏状态在时间步之间传递

RNN计算流程图(带内部细节)

输出 输出层计算 隐藏层计算 输入 h_t

当前隐藏状态 y_t

当前输出 W_{hy} · h_t G + b_y W_{xh} · x_t W_{hh} · h_{t-1} C + D + b_h tanh(E) x_t

当前输入 h_{t-1}

前一隐藏状态 h_{t-1} 传递到下一时间步 用于计算 h_{t+1}

RNN的实现与代码示例

Python实现基本RNN

使用NumPy实现RNN可以帮助我们清晰地理解RNN的内部计算机制,而不依赖于深度学习框架的抽象。下面是一个更详细的RNN实现,包括前向传播和反向传播:

python

import numpy as np

class BasicRNN:

def __init__(self, input_size, hidden_size, output_size):

"""

初始化基本RNN模型

参数:

- input_size: 输入特征维度

- hidden_size: 隐藏状态维度

- output_size: 输出维度

"""

# 初始化权重矩阵(使用小随机数初始化)

self.Wxh = np.random.randn(hidden_size, input_size) * 0.01 # 输入到隐藏层的权重

self.Whh = np.random.randn(hidden_size, hidden_size) * 0.01 # 隐藏层到自身的权重

self.Why = np.random.randn(output_size, hidden_size) * 0.01 # 隐藏层到输出层的权重

# 初始化偏置项

self.bh = np.zeros((hidden_size, 1)) # 隐藏层偏置

self.by = np.zeros((output_size, 1)) # 输出层偏置

# 存储模型参数

self.params = [self.Wxh, self.Whh, self.Why, self.bh, self.by]

def forward(self, inputs, h_prev=None):

"""

RNN前向传播

参数:

- inputs: 输入序列,形状为 [时间步数, 输入特征数]

- h_prev: 初始隐藏状态,如果为None则初始化为零

返回:

- outputs: 所有时间步的输出列表

- hiddens: 所有时间步的隐藏状态列表

- final_h: 最终隐藏状态

"""

# 获取隐藏层维度

hidden_size = self.Whh.shape[0]

# 初始化隐藏状态(如果未提供)

if h_prev is None:

h_prev = np.zeros((hidden_size, 1))

# 存储所有时间步的隐藏状态和输出

hiddens = []

outputs = []

# 当前隐藏状态

current_h = h_prev.copy()

# 对每个时间步进行前向计算

for t in range(len(inputs)):

# 获取当前时间步的输入

x = inputs[t].reshape(-1, 1) # 确保输入是列向量

# 计算隐藏状态: h_t = tanh(Wxh·x_t + Whh·h_{t-1} + bh)

current_h = np.tanh(

np.dot(self.Wxh, x) + # 输入到隐藏的变换

np.dot(self.Whh, current_h) + # 隐藏状态的递归连接

self.bh # 隐藏层偏置

)

# 计算输出: y_t = Why·h_t + by

y = np.dot(self.Why, current_h) + self.by

# 保存当前时间步的隐藏状态和输出

hiddens.append(current_h)

outputs.append(y)

return outputs, hiddens, current_h # 返回输出、隐藏状态和最终隐藏状态

def backward(self, inputs, targets, hiddens, outputs):

"""

RNN反向传播(BPTT - Backpropagation Through Time)

参数:

- inputs: 输入序列

- targets: 目标输出序列

- hiddens: 前向传播得到的隐藏状态列表

- outputs: 前向传播得到的输出列表

返回:

- grads: 各参数的梯度列表

"""

# 初始化梯度为零

dWxh = np.zeros_like(self.Wxh)

dWhh = np.zeros_like(self.Whh)

dWhy = np.zeros_like(self.Why)

dbh = np.zeros_like(self.bh)

dby = np.zeros_like(self.by)

# 初始化解码器部分的梯度

dhnext = np.zeros_like(hiddens[0])

# 从最后一个时间步开始反向传播

for t in reversed(range(len(inputs))):

# 计算输出误差(简化版的均方误差梯度)

dy = outputs[t] - targets[t].reshape(-1, 1)

# 计算Why和by的梯度

dWhy += np.dot(dy, hiddens[t].T)

dby += dy

# 计算隐藏状态的梯度(包括来自输出层和下一时间步的梯度)

dh = np.dot(self.Why.T, dy) + dhnext

# 计算tanh的导数: d/dx tanh(x) = 1 - tanh²(x)

dtanh = (1 - hiddens[t] * hiddens[t]) * dh

# 计算bh的梯度

dbh += dtanh

# 计算Wxh的梯度

dWxh += np.dot(dtanh, inputs[t].reshape(1, -1))

# 计算Whh的梯度

if t > 0:

dWhh += np.dot(dtanh, hiddens[t-1].T)

# 传递梯度到前一时间步

dhnext = np.dot(self.Whh.T, dtanh)

# 梯度裁剪,防止梯度爆炸

for dparam in [dWxh, dWhh, dWhy, dbh, dby]:

np.clip(dparam, -5, 5, out=dparam)

return [dWxh, dWhh, dWhy, dbh, dby]

# 示例使用代码

if __name__ == "__main__":

# 创建一个简单的测试序列

input_size = 3

hidden_size = 5

output_size = 2

# 创建RNN模型

rnn = BasicRNN(input_size, hidden_size, output_size)

# 创建一个长度为4的输入序列

inputs = [np.random.randn(input_size) for _ in range(4)]

targets = [np.random.randn(output_size) for _ in range(4)]

# 前向传播

outputs, hiddens, final_h = rnn.forward(inputs)

print("输入序列长度:", len(inputs))

print("每个输入的形状:", inputs[0].shape)

print("隐藏状态数量:", len(hiddens))

print("每个隐藏状态的形状:", hiddens[0].shape)

print("输出数量:", len(outputs))

print("每个输出的形状:", outputs[0].shape)

# 反向传播

grads = rnn.backward(inputs, targets, hiddens, outputs)

print("\n梯度计算完成:")

print("Wxh梯度形状:", grads[0].shape)

print("Whh梯度形状:", grads[1].shape)

print("Why梯度形状:", grads[2].shape)这个实现比之前的版本更加详细,包含了以下改进:

- 详细的函数文档字符串,说明每个参数和返回值

- 更清晰的变量命名和注释

- 添加了可选的初始隐藏状态参数

- 实现了完整的反向传播算法(BPTT),用于计算梯度

- 添加了梯度裁剪,防止梯度爆炸问题

- 增加了示例使用代码,展示如何创建和使用这个RNN模型

通过这个实现,我们可以更清楚地看到RNN的工作原理:它如何通过前向传播处理序列数据,以及如何通过反向传播更新模型参数。在实际应用中,我们通常会使用PyTorch或TensorFlow等深度学习框架来实现RNN,因为它们提供了更高效的自动微分功能和GPU加速支持。

这段代码实现了一个简单的RNN类,包含权重初始化和前向传播方法。我们可以看到,在每个时间步,隐藏状态都会更新,并且输出是基于当前隐藏状态计算的。

PyTorch实现RNN

在实际应用中,我们通常使用PyTorch等深度学习框架来实现RNN,因为它们提供了高效的GPU加速和自动微分功能。下面是一个使用PyTorch实现RNN的详细示例,包括模型定义、训练和评估:

python

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

import matplotlib.pyplot as plt

# 1. 定义RNN模型类

class PyTorchRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers=1):

"""

使用PyTorch实现的RNN模型

参数:

- input_size: 输入特征维度

- hidden_size: 隐藏状态维度

- output_size: 输出维度

- num_layers: RNN层数,默认为1

"""

super(PyTorchRNN, self).__init__()

# 保存参数

self.input_size = input_size

self.hidden_size = hidden_size

self.output_size = output_size

self.num_layers = num_layers

# 使用PyTorch内置的RNN层

self.rnn = nn.RNN(

input_size=input_size,

hidden_size=hidden_size,

num_layers=num_layers,

batch_first=True, # 输入形状为 [batch_size, seq_len, input_size]

nonlinearity='tanh' # 使用tanh激活函数

)

# 输出层,将隐藏状态映射到输出空间

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x, h_0=None):

"""

前向传播

参数:

- x: 输入张量,形状为 [batch_size, seq_len, input_size]

- h_0: 初始隐藏状态,如果为None则自动初始化

返回:

- output: 所有时间步的输出,形状为 [batch_size, seq_len, output_size]

- h_n: 最终隐藏状态,形状为 [num_layers, batch_size, hidden_size]

"""

# 获取批次大小

batch_size = x.size(0)

# 初始化隐藏状态(如果未提供)

if h_0 is None:

h_0 = torch.zeros(self.num_layers, batch_size, self.hidden_size).to(x.device)

# RNN前向计算

# out形状: [batch_size, seq_len, hidden_size]

# h_n形状: [num_layers, batch_size, hidden_size]

out, h_n = self.rnn(x, h_0)

# 通过全连接层映射到输出空间

# out形状变为: [batch_size, seq_len, output_size]

out = self.fc(out)

return out, h_n

# 2. 创建一个简单的序列预测任务

# 例如:预测正弦波的下一个值

def generate_sine_data(seq_length, num_samples, noise=0.01):

"""

生成带噪声的正弦波序列数据

参数:

- seq_length: 序列长度

- num_samples: 样本数量

- noise: 噪声强度

返回:

- X: 输入序列,形状为 [num_samples, seq_length, 1]

- y: 目标值,形状为 [num_samples, seq_length, 1]

"""

X = []

y = []

for _ in range(num_samples):

# 随机起始相位

phase = np.random.rand() * 2 * np.pi

# 生成时间步

t = np.linspace(phase, phase + 3 * np.pi, seq_length + 1)

# 生成正弦波数据并添加噪声

data = np.sin(t) + np.random.normal(0, noise, t.shape)

# 输入序列和目标序列

X.append(data[:-1].reshape(-1, 1))

y.append(data[1:].reshape(-1, 1))

return np.array(X), np.array(y)

# 3. 准备训练和测试数据

seq_length = 20

num_samples = 1000

train_size = 800

# 生成数据

X, y = generate_sine_data(seq_length, num_samples)

# 分割训练集和测试集

X_train, X_test = X[:train_size], X[train_size:]

y_train, y_test = y[:train_size], y[train_size:]

# 转换为PyTorch张量

X_train = torch.FloatTensor(X_train)

y_train = torch.FloatTensor(y_train)

X_test = torch.FloatTensor(X_test)

y_test = torch.FloatTensor(y_test)

# 4. 初始化模型、损失函数和优化器

input_size = 1

hidden_size = 32

output_size = 1

num_layers = 2

learning_rate = 0.01

epochs = 20

# 创建模型

model = PyTorchRNN(input_size, hidden_size, output_size, num_layers)

# 定义损失函数(均方误差)

criterion = nn.MSELoss()

# 定义优化器

optimizer = optim.Adam(model.parameters(), lr=learning_rate)

# 5. 训练模型

train_losses = []

test_losses = []

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model = model.to(device)

X_train = X_train.to(device)

y_train = y_train.to(device)

X_test = X_test.to(device)

y_test = y_test.to(device)

print("开始训练...")

for epoch in range(epochs):

# 训练模式

model.train()

optimizer.zero_grad()

# 前向传播

outputs, _ = model(X_train)

loss = criterion(outputs, y_train)

# 反向传播和优化

loss.backward()

optimizer.step()

# 记录训练损失

train_loss = loss.item()

train_losses.append(train_loss)

# 测试模式

model.eval()

with torch.no_grad():

test_outputs, _ = model(X_test)

test_loss = criterion(test_outputs, y_test).item()

test_losses.append(test_loss)

# 打印训练进度

if (epoch + 1) % 2 == 0:

print(f'Epoch [{epoch+1}/{epochs}], Train Loss: {train_loss:.6f}, Test Loss: {test_loss:.6f}')

# 6. 评估模型

model.eval()

with torch.no_grad():

# 在测试集上进行预测

predictions, _ = model(X_test)

# 计算最终测试损失

final_test_loss = criterion(predictions, y_test).item()

print(f'\nFinal Test Loss: {final_test_loss:.6f}')

# 7. 可视化预测结果

plt.figure(figsize=(15, 6))

# 绘制损失曲线

plt.subplot(1, 2, 1)

plt.plot(train_losses, label='Training Loss')

plt.plot(test_losses, label='Test Loss')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.title('Training and Test Loss')

plt.legend()

# 绘制一个序列的预测结果

plt.subplot(1, 2, 2)

sample_idx = 0

plt.plot(y_test[sample_idx].cpu().numpy(), label='True Values')

plt.plot(predictions[sample_idx].cpu().numpy(), label='Predictions')

plt.xlabel('Time Step')

plt.ylabel('Value')

plt.title('True Values vs Predictions')

plt.legend()

plt.tight_layout()

plt.show()这个PyTorch实现比简单版本更加完善,包括以下特点:

- 使用PyTorch内置的

nn.RNN层,支持多层RNN结构 - 实现了完整的训练和评估流程

- 创建了一个实际的序列预测任务(预测正弦波)

- 支持GPU加速(自动检测并使用CUDA)

- 包含损失可视化和预测结果可视化

除了上述实现,我们也可以针对不同任务调整模型结构。例如,对于文本分类任务,我们可以使用更复杂的RNN变体和注意力机制:

python

import torch

import torch.nn as nn

import torch.optim as optim

class AdvancedRNNClassifier(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim, n_layers,

bidirectional=False, dropout=0.5):

super(AdvancedRNNClassifier, self).__init__()

# 词嵌入层

self.embedding = nn.Embedding(vocab_size, embedding_dim)

# 可以选择使用LSTM或GRU代替基本RNN

self.rnn = nn.LSTM(

embedding_dim,

hidden_dim,

num_layers=n_layers,

bidirectional=bidirectional,

batch_first=True,

dropout=dropout if n_layers > 1 else 0

)

# 全连接层 - 根据是否双向调整输入维度

self.fc = nn.Linear(hidden_dim * 2 if bidirectional else hidden_dim, output_dim)

# Dropout层用于正则化

self.dropout = nn.Dropout(dropout)

def forward(self, text, text_lengths):

# text形状: [batch_size, seq_len]

# 嵌入层处理

embedded = self.dropout(self.embedding(text))

# embedded形状: [batch_size, seq_len, embedding_dim]

# 使用PackedSequence优化变长序列处理

packed_embedded = nn.utils.rnn.pack_padded_sequence(

embedded, text_lengths, batch_first=True, enforce_sorted=False

)

# RNN处理

packed_output, (hidden, cell) = self.rnn(packed_embedded)

# 对于双向RNN,我们拼接两个方向的最终隐藏状态

if self.rnn.bidirectional:

hidden = self.dropout(torch.cat((hidden[-2,:,:], hidden[-1,:,:]), dim=1))

else:

hidden = self.dropout(hidden[-1,:,:])

# 输出层

return self.fc(hidden)在实际项目中,我们通常会根据具体任务调整模型结构和超参数,例如使用更先进的RNN变体(LSTM、GRU)、注意力机制或预训练语言模型来提高性能。PyTorch提供了丰富的工具和接口,使得实现这些复杂模型变得简单高效。

RNN的挑战与解决方案

虽然RNN在处理序列数据方面表现出色,但在实际应用中仍然面临几个关键挑战。理解这些挑战及其解决方案对于有效地使用RNN至关重要。

梯度消失与梯度爆炸

在训练RNN时,最主要的挑战是梯度消失和梯度爆炸问题。这是由于反向传播通过时间(BPTT, Backpropagation Through Time)算法的特性所导致的。

梯度问题的数学解释

当我们训练RNN时,需要计算损失函数对各个参数的梯度。对于隐藏到隐藏的权重矩阵 W h h W_{hh} Whh,其梯度计算涉及到时间步的连乘:

∂ L ∂ W h h = ∑ t = 1 T ∂ L ∂ y T ⋅ ∂ y T ∂ h T ⋅ ( ∏ k = t + 1 T ∂ h k ∂ h k − 1 ) ⋅ ∂ h t ∂ W h h \frac{\partial L}{\partial W_{hh}} = \sum_{t=1}^{T} \frac{\partial L}{\partial y_T} \cdot \frac{\partial y_T}{\partial h_T} \cdot \left( \prod_{k=t+1}^{T} \frac{\partial h_k}{\partial h_{k-1}} \right) \cdot \frac{\partial h_t}{\partial W_{hh}} ∂Whh∂L=t=1∑T∂yT∂L⋅∂hT∂yT⋅(k=t+1∏T∂hk−1∂hk)⋅∂Whh∂ht

其中, ∂ h k ∂ h k − 1 = W h h T ⋅ diag ( 1 − tanh 2 ( h k − 1 ) ) \frac{\partial h_k}{\partial h_{k-1}} = W_{hh}^T \cdot \text{diag}(1 - \tanh^2(h_{k-1})) ∂hk−1∂hk=WhhT⋅diag(1−tanh2(hk−1)) 是隐藏状态对前一时刻隐藏状态的导数。

当序列长度 T 较大时,这个连乘项可能会导致:

- 梯度消失 :如果 W h h W_{hh} Whh 的谱半径小于1,连乘项会指数级减小到接近零

- 梯度爆炸 :如果 W h h W_{hh} Whh 的谱半径大于1,连乘项会指数级增长到非常大的值

梯度问题的影响

- 梯度消失:模型难以学习长期依赖关系,通常只能记住近期的几个时间步的信息

- 梯度爆炸:导致参数更新幅度过大,模型训练不稳定,可能出现NaN值

- 训练速度慢:由于梯度问题,RNN通常需要很长时间才能收敛

解决方案

-

梯度裁剪(Gradient Clipping)

- 限制梯度的范数不超过某个阈值

- 有效防止梯度爆炸,对梯度消失也有一定缓解作用

- 在PyTorch中可以通过

torch.nn.utils.clip_grad_norm_实现

-

权重初始化策略

- 使用Xavier/Glorot初始化或Kaiming/He初始化

- 确保权重矩阵的谱半径接近1,减少梯度消失/爆炸的可能性

-

使用ReLU类激活函数

- ReLU的导数在正值区域为常数1,有助于缓解梯度消失

- 但需要注意死亡ReLU问题

- 变种包括Leaky ReLU、ELU、GELU等

-

批量归一化(Batch Normalization)

- 规范化层的输入,稳定训练过程

- 在RNN中可以使用Layer Normalization,更适合序列数据

长短期记忆网络(LSTM)

为了解决梯度消失问题,研究者提出了长短期记忆网络(Long Short-Term Memory,LSTM)。LSTM通过门控机制来控制信息的流动,能够有效地捕捉长距离依赖关系。

LSTM是RNN最重要的变体之一,由Hochreiter和Schmidhuber在1997年提出,专门设计用于解决长期依赖问题。

LSTM的核心思想

LSTM通过引入记忆单元 (Memory Cell)和门控机制(Gates)来控制信息的流动和存储,从而有效缓解梯度消失问题。

LSTM的核心组件

LSTM包含三个关键的门:

-

遗忘门(Forget Gate) :决定哪些信息应该被遗忘

f t = σ ( W f ⋅ [ h t − 1 , x t ] + b f ) f_t = \sigma(W_f \cdot [h_{t-1}, x_t] + b_f) ft=σ(Wf⋅[ht−1,xt]+bf) -

输入门(Input Gate) :决定哪些新信息应该被存储

i t = σ ( W i ⋅ [ h t − 1 , x t ] + b i ) i_t = \sigma(W_i \cdot [h_{t-1}, x_t] + b_i) it=σ(Wi⋅[ht−1,xt]+bi)

C ~ t = tanh ( W C ⋅ [ h t − 1 , x t ] + b C ) \tilde{C}t = \tanh(W_C \cdot [h{t-1}, x_t] + b_C) C~t=tanh(WC⋅[ht−1,xt]+bC) -

输出门(Output Gate) :决定当前隐藏状态应该输出什么信息

o t = σ ( W o ⋅ [ h t − 1 , x t ] + b o ) o_t = \sigma(W_o \cdot [h_{t-1}, x_t] + b_o) ot=σ(Wo⋅[ht−1,xt]+bo)

LSTM的计算流程

-

更新记忆单元:

C t = f t ⊙ C t − 1 + i t ⊙ C ~ t C_t = f_t \odot C_{t-1} + i_t \odot \tilde{C}_t Ct=ft⊙Ct−1+it⊙C~t -

计算隐藏状态:

h t = o t ⊙ tanh ( C t ) h_t = o_t \odot \tanh(C_t) ht=ot⊙tanh(Ct)

其中, σ \sigma σ是sigmoid激活函数(输出范围[0,1]), ⊙ \odot ⊙表示元素级乘法。

LSTM如何解决梯度消失问题

LSTM通过以下机制缓解梯度消失:

- 记忆单元的线性自连接:记忆单元C_t与C_{t-1}之间存在直接的线性连接,使梯度可以直接流动

- 门控机制:门的输出接近1时,允许梯度几乎无衰减地反向传播

- 反向传播路径:梯度可以通过多个路径流动,增加了梯度的稳定性

LSTM的PyTorch实现

python

import torch

import torch.nn as nn

class LSTMModel(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers=1, dropout=0.0):

super(LSTMModel, self).__init__()

# LSTM层

self.lstm = nn.LSTM(

input_size=input_size,

hidden_size=hidden_size,

num_layers=num_layers,

batch_first=True,

dropout=dropout if num_layers > 1 else 0,

bidirectional=False

)

# 输出层

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x, hidden=None):

# x形状: [batch_size, seq_len, input_size]

# LSTM前向传播

lstm_out, (hn, cn) = self.lstm(x, hidden)

# lstm_out形状: [batch_size, seq_len, hidden_size]

# hn形状: [num_layers, batch_size, hidden_size]

# 全连接层映射

output = self.fc(lstm_out)

# output形状: [batch_size, seq_len, output_size]

return output, (hn, cn)门控循环单元(GRU)

GRU(Gated Recurrent Unit)是2014年由Cho等人提出的另一种门控RNN变体,它是LSTM的简化版本,但在许多任务上表现相当。

GRU的核心思想

GRU将LSTM的三个门简化为两个门:重置门和更新门,同时合并了细胞状态和隐藏状态。

GRU的核心组件

-

重置门(Reset Gate) :控制前一时刻的隐藏状态对当前候选隐藏状态的影响

r t = σ ( W r ⋅ [ h t − 1 , x t ] + b r ) r_t = \sigma(W_r \cdot [h_{t-1}, x_t] + b_r) rt=σ(Wr⋅[ht−1,xt]+br) -

更新门(Update Gate) :同时控制遗忘和输入,决定保留多少旧信息和添加多少新信息

z t = σ ( W z ⋅ [ h t − 1 , x t ] + b z ) z_t = \sigma(W_z \cdot [h_{t-1}, x_t] + b_z) zt=σ(Wz⋅[ht−1,xt]+bz)

GRU的计算流程

-

计算候选隐藏状态:

h ~ t = tanh ( W h ⋅ [ r t ⊙ h t − 1 , x t ] + b h ) \tilde{h}t = \tanh(W_h \cdot [r_t \odot h{t-1}, x_t] + b_h) h~t=tanh(Wh⋅[rt⊙ht−1,xt]+bh) -

更新隐藏状态:

h t = ( 1 − z t ) ⊙ h t − 1 + z t ⊙ h ~ t h_t = (1 - z_t) \odot h_{t-1} + z_t \odot \tilde{h}_t ht=(1−zt)⊙ht−1+zt⊙h~t

GRU与LSTM的比较

| 特性 | LSTM | GRU |

|---|---|---|

| 参数数量 | 更多 | 更少 |

| 计算效率 | 较低 | 较高 |

| 控制机制 | 三个门,显式细胞状态 | 两个门,合并的状态表示 |

| 记忆能力 | 通常更强 | 稍弱但足够 |

| 训练难度 | 更容易过拟合 | 训练更快 |

GRU的PyTorch实现

python

import torch

import torch.nn as nn

class GRUModel(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers=1, dropout=0.0):

super(GRUModel, self).__init__()

# GRU层

self.gru = nn.GRU(

input_size=input_size,

hidden_size=hidden_size,

num_layers=num_layers,

batch_first=True,

dropout=dropout if num_layers > 1 else 0,

bidirectional=False

)

# 输出层

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x, hidden=None):

# x形状: [batch_size, seq_len, input_size]

# GRU前向传播

gru_out, hn = self.gru(x, hidden)

# gru_out形状: [batch_size, seq_len, hidden_size]

# hn形状: [num_layers, batch_size, hidden_size]

# 全连接层映射

output = self.fc(gru_out)

# output形状: [batch_size, seq_len, output_size]

return output, hn其他RNN变体

除了LSTM和GRU,还有一些其他重要的RNN变体:

1. 双向RNN (BiRNN)

双向RNN同时从序列的开始和结束两个方向处理数据,能够捕获过去和未来的上下文信息。

工作原理:

- 前向RNN:按照时间顺序处理序列

- 后向RNN:按照时间逆序处理序列

- 合并两个方向的隐藏状态

应用场景:需要考虑完整上下文的任务,如命名实体识别、语音识别

PyTorch实现示例:

python

class BiRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers=1):

super(BiRNN, self).__init__()

self.lstm = nn.LSTM(input_size, hidden_size, num_layers,

bidirectional=True, batch_first=True)

self.fc = nn.Linear(hidden_size * 2, output_size) # 双向需要乘以2

def forward(self, x):

out, _ = self.lstm(x)

out = self.fc(out)

return out2. 深度RNN (Deep RNN)

深度RNN通过堆叠多层RNN单元,增加网络的深度和表达能力。

工作原理:

- 多层RNN单元堆叠

- 下层的输出作为上层的输入

- 每一层都有自己的隐藏状态

优点:

- 更强的表示学习能力

- 可以捕获不同层次的特征

PyTorch实现 :只需设置num_layers > 1

python

class DeepRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers=3, dropout=0.3):

super(DeepRNN, self).__init__()

self.lstm = nn.LSTM(input_size, hidden_size, num_layers,

batch_first=True, dropout=dropout)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

out, _ = self.lstm(x)

out = self.fc(out[:, -1, :]) # 使用最后一个时间步的输出

return out3. 神经网络图灵机 (NTM)

神经网络图灵机是一种增强型RNN,具有外部记忆能力。

核心组件:

- 控制器(通常是RNN)

- 外部记忆矩阵

- 读写头机制

特点:能够学习存储和检索信息,适用于需要长期记忆的复杂任务

RNN变体选择指南

选择合适的RNN变体取决于具体任务需求:

-

数据长度和复杂度:

- 长序列、复杂模式:选择LSTM

- 中等长度序列:GRU足够且更高效

-

计算资源限制:

- 计算资源有限:GRU或简化模型

- 充足计算资源:LSTM或深度变体

-

上下文需求:

- 需要双向上下文:BiRNN

- 仅需单向信息:标准RNN变体

-

任务类型:

- 序列到序列转换:注意力机制+LSTM/GRU

- 分类任务:可以使用更简单的模型

-

过拟合风险:

- 小数据集:使用更简单的GRU

- 大数据集:LSTM或深度RNN更适合

RNN与其他模型的对比

为了更好地理解RNN的优势和局限性,我们可以将其与其他类型的神经网络模型进行对比。

各种序列模型的对比

1. 模型架构与性能对比表

| 模型 | 优点 | 缺点 | 适用场景 | 计算复杂度 | 训练难度 | 内存需求 |

|---|---|---|---|---|---|---|

| 基本RNN | 简单直观,参数少 | 难以捕获长距离依赖,容易梯度消失 | 短序列处理,简单模式识别 | O(seq_len × hidden_size²) | 较低 | 低 |

| LSTM | 有效解决梯度消失,长期记忆能力强 | 参数多,计算开销大 | 长序列处理,复杂依赖建模 | O(seq_len × hidden_size²) | 中等 | 中高 |

| GRU | 比LSTM参数少,训练更快 | 记忆能力略弱于LSTM | 平衡性能和效率的场景 | O(seq_len × hidden_size²) | 中等 | 中 |

| Transformer | 并行计算能力强,捕获长距离依赖,自注意力机制强大 | 计算资源需求高,位置编码固定,不适用于极长序列 | 自然语言处理,机器翻译,语言建模 | O(seq_len² × hidden_size) | 高 | 高 |

| CNN | 并行计算,参数共享,特征提取能力强 | 难以建模时序依赖,感受野有限,不擅长长距离依赖 | 固定长度窗口的特征提取,音频处理 | O(seq_len × kernel_size × hidden_size) | 较低 | 低中 |

2. 不同任务下的模型推荐

| 任务类型 | 推荐模型 | 理由 |

|---|---|---|

| 短序列分类(< 50步) | CNN + 池化 | 计算效率高,特征提取能力强 |

| 中等长度序列(50-500步) | GRU | 平衡了性能和效率 |

| 长序列建模(> 500步) | LSTM, Transformer | 长期记忆能力强 |

| 自然语言处理(翻译、摘要) | Transformer | 注意力机制强大,并行能力强 |

| 实时序列预测 | GRU | 推理速度快,适合在线应用 |

| 异常检测 | LSTM, Autoencoder | 能够学习正常模式,检测偏离 |

| 多模态序列(视频+音频) | 混合模型(CNN + RNN) | 组合时空特征 |

模型选择不应该是一成不变的,而应该根据具体问题、数据特点和计算资源进行灵活调整。------ Yann LeCun,Facebook AI研究院主任

| 长序列表现 | 通常略好 | 在许多任务上相当 |

| 实现复杂度 | 更复杂 | 更简单 |

GRU的PyTorch实现

python

import torch

import torch.nn as nn

class GRUModel(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers=1, dropout=0.0):

super(GRUModel, self).__init__()

# GRU层

self.gru = nn.GRU(

input_size=input_size,

hidden_size=hidden_size,

num_layers=num_layers,

batch_first=True,

dropout=dropout if num_layers > 1 else 0,

bidirectional=False

)

# 输出层

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x, hidden=None):

# x形状: [batch_size, seq_len, input_size]

# GRU前向传播

gru_out, hn = self.gru(x, hidden)

# gru_out形状: [batch_size, seq_len, hidden_size]

# hn形状: [num_layers, batch_size, hidden_size]

# 全连接层映射

output = self.fc(gru_out)

# output形状: [batch_size, seq_len, output_size]

return output, hn其他RNN变体与改进

除了LSTM和GRU,还有许多其他RNN变体和改进技术:

-

双向RNN(Bidirectional RNN)

- 同时从序列的开始和结束两个方向处理数据

- 可以捕获上下文信息,常用于自然语言处理任务

- 在PyTorch中通过设置

bidirectional=True实现

-

深度RNN(Deep RNN)

- 堆叠多个RNN层,增加模型深度和表达能力

- 前一层的隐藏状态作为后一层的输入

- 通过增加

num_layers参数实现

-

注意力机制(Attention Mechanism)

- 允许模型动态关注序列中不同位置的信息

- 显著提升长序列建模能力

- 是现代序列模型(如Transformer)的核心组件

RNN的应用场景

自然语言处理

RNN在自然语言处理领域有着广泛的应用,包括:

- 文本分类

- 情感分析

- 机器翻译

- 语言建模

- 语音识别

时间序列预测

RNN也广泛应用于时间序列预测任务,如:

- 股票价格预测

- 天气预报

- 电力负荷预测

- 交通流量预测

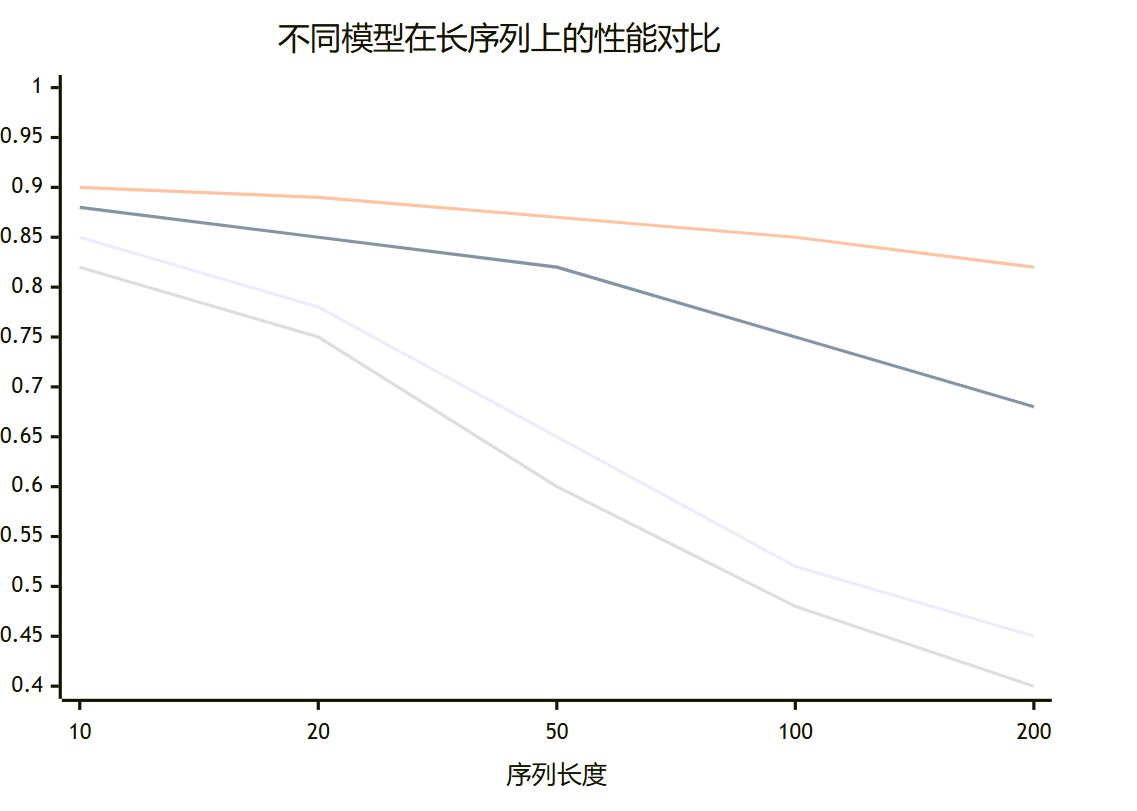

下面的图表展示了RNN与其他序列模型在不同序列长度上的性能对比:

图3:不同模型性能对比图 - 这个XY图表展示了RNN、LSTM、Transformer和CNN在不同序列长度下的准确率表现。可以看出,随着序列长度的增加,RNN的性能下降较快,而Transformer在长序列上表现最佳。

几个点的数据依次为:

line "RNN" [0.85, 0.78, 0.65, 0.52, 0.45]

line "LSTM" [0.88, 0.85, 0.82, 0.75, 0.68]

line "Transformer" [0.90, 0.89, 0.87, 0.85, 0.82]

line "CNN" [0.82, 0.75, 0.60, 0.48, 0.40]

RNN与其他模型的对比

不同的序列模型各有优缺点,下面的表格对RNN及其主要变体和替代模型进行了详细对比:

| 模型 | 优点 | 缺点 | 适用场景 | 计算复杂度 |

|---|---|---|---|---|

| 基本RNN | 结构简单,易于理解 | 梯度消失问题严重,难以捕捉长距离依赖 | 短序列任务,简单模式识别 | O(n),n为序列长度 |

| LSTM | 有效解决梯度消失,能捕捉长距离依赖 | 结构复杂,训练速度较慢 | 长序列建模,机器翻译,语音识别 | O(n) |

| GRU | 比LSTM更简单,训练更快 | 长距离依赖捕捉能力略弱于LSTM | 资源受限场景,中等长度序列 | O(n) |

| Transformer | 并行计算能力强,长距离依赖捕捉优秀 | 需要大量数据和计算资源 | 大型语言模型,机器翻译 | O(n²),但可并行化 |

| CNN | 并行计算能力强,训练速度快 | 难以捕捉长距离依赖,需要堆叠多层 | 局部模式识别,图像-序列任务 | O(n) |

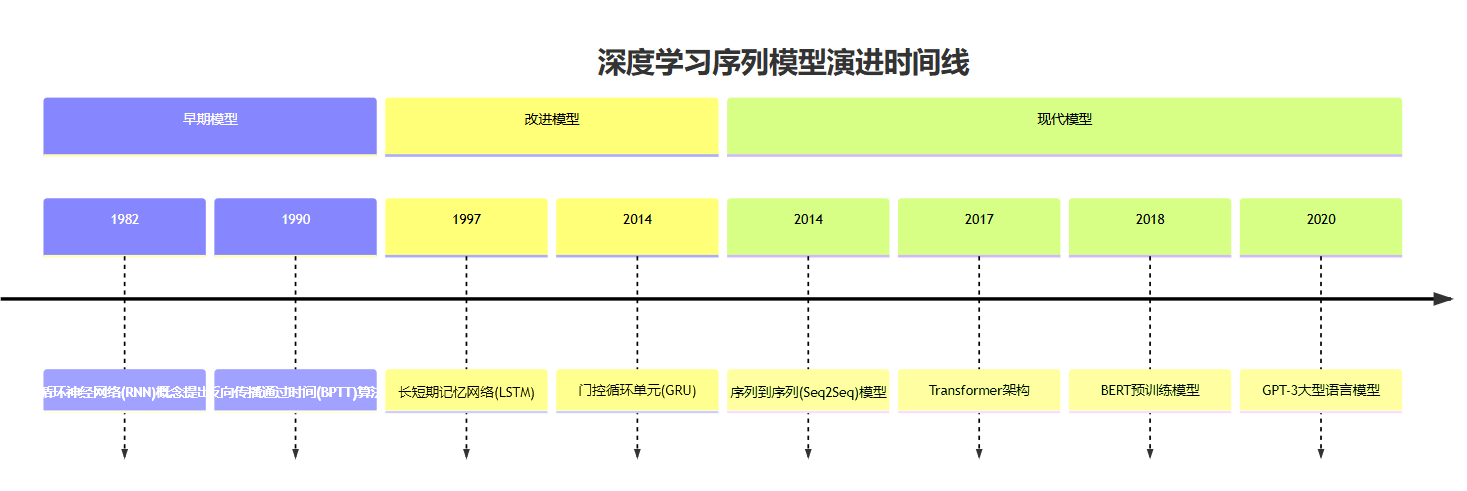

深度学习序列模型的发展经历了从基本RNN到LSTM,再到Transformer的演进过程。下面的时间线展示了这一发展历程:

图4:深度学习序列模型演进时间线 - 这个时间线展示了从RNN到现代大型语言模型的发展历程,反映了序列建模技术的快速进步。

未来发展趋势

尽管Transformer架构在许多序列建模任务上已经超越了传统的RNN,但RNN仍然在某些领域保持着独特的优势和应用价值。未来,RNN的发展可能会朝以下几个方向演进:

-

混合架构:将RNN的时序处理能力与Transformer的并行计算能力相结合,创建更强大的混合模型。

-

轻量级RNN变体:为边缘设备和移动应用开发更高效的RNN变体,降低计算复杂度和内存需求。

-

自监督学习与RNN:结合自监督学习技术,让RNN能够从未标记数据中学习,提高模型性能和泛化能力。

-

注意力机制增强的RNN:在RNN中引入注意力机制,使其能够更好地捕捉长距离依赖关系,同时保持较低的计算复杂度。

-

神经符号推理与RNN:将RNN与符号推理相结合,增强模型的可解释性和推理能力。

总结

循环神经网络(RNN)作为深度学习中处理序列数据的核心架构,通过独特的循环连接设计解决了传统神经网络无法处理时序依赖关系的局限性,本文从基本原理、数学模型、代码实现到高级变体(如LSTM、GRU)和实际应用,全面阐述了RNN的理论基础和实践价值,并通过可视化图表和详细对比,帮助读者深入理解RNN技术体系及其在自然语言处理、时间序列预测等领域的应用前景。

参考链接

-

循环神经网络详解 - 知乎专栏,详细介绍了RNN的基本原理和变体

-

Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling - GRU原论文,详细介绍GRU的设计思想

-

Long Short-Term Memory - LSTM原论文,由Hochreiter和Schmidhuber提出

-

PyTorch RNN官方文档 - PyTorch框架中RNN模块的详细文档

-

TensorFlow RNN教程 - TensorFlow框架中使用RNN的官方指南

-

GitHub: Practical RNN Implementation - Andrej Karpathy实现的字符级RNN,代码简洁易懂

关键词标签

- RNN

- 循环神经网络

- 深度学习

- LSTM , GRU

- PyTorch