地址:The Stanford Natural Language Processing Group

一、数据集概况

| 属性 | 描述 |

|---|---|

| 正式名称 | WebQuestions (sometimes "WebQuestions" 或 "WebQuestions dataset") |

| 发表 / 引入 | Berant et al., Semantic Parsing on Freebase from Question-Answer Pairs (EMNLP 2013) |

| 语义解析支撑版本 | WebQuestionsSP(带 SPARQL 语义解析标注的版本) |

| 问答对数 | 5810个问答对 (Papers with Code) |

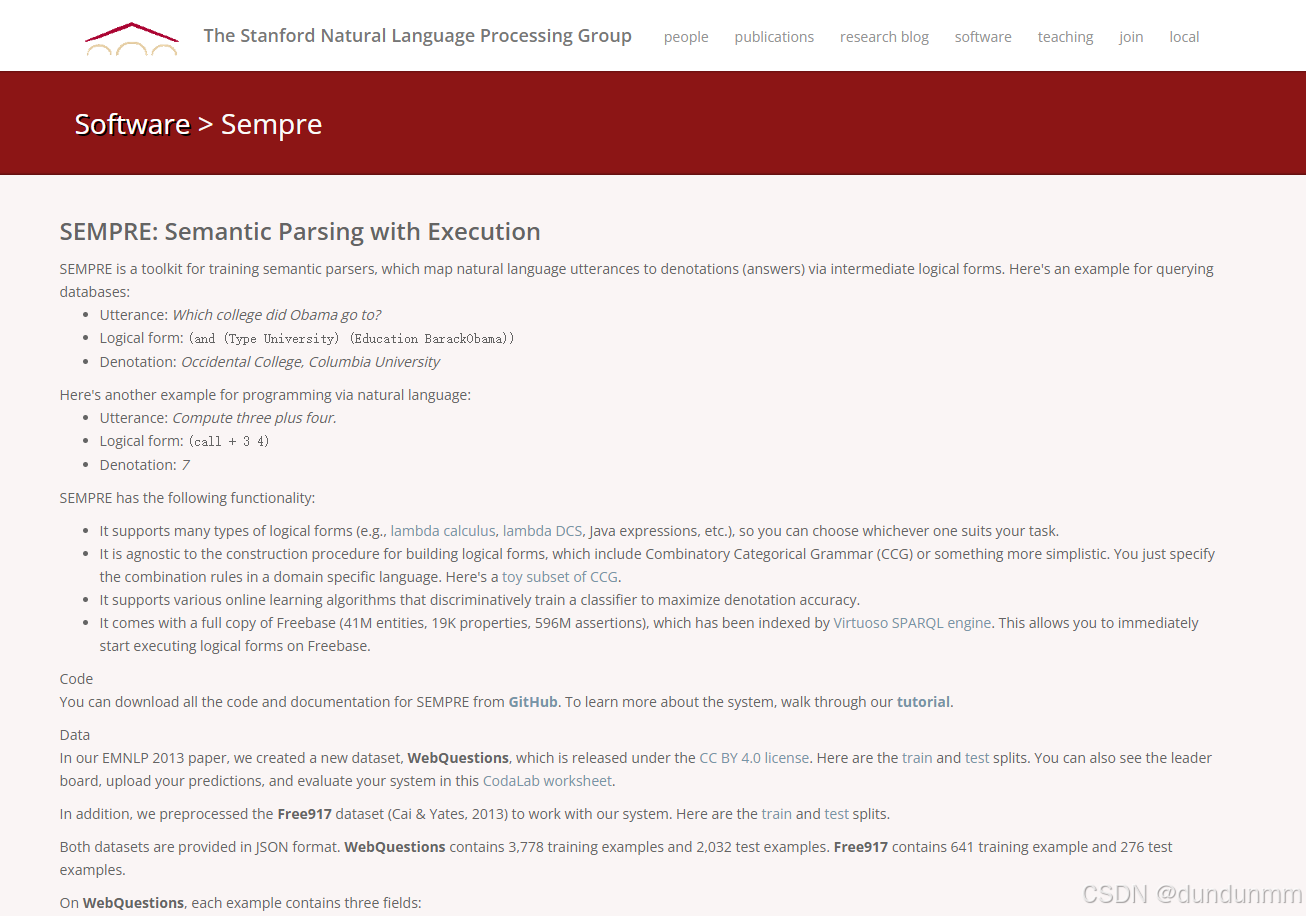

| 划分 | 训练集:3,778;测试集:2,032 (TensorFlow) |

| 知识库 / 背景知识 | 基于 Freebase(一个大的知识图谱 / 知识库) (GitHub) |

| 问题特点 | 自然语言问句,多为围绕一个实体(或一个实体 + 属性 / 关系)提问,答案是 Freebase 上的实体 (或实体列表) (Hugging Face) |

| 示例问题 | "Where did Edgar Allan Poe die?" → 答案 "Baltimore" (Papers with Code) "What degrees did Barack Obama get?" → 答案 "Bachelor of Arts", "Juris Doctor" (Papers with Code) |

WebQuestionsSP (语义解析版本)

为了提高对语义解析模型训练与评估的支持,后来有学者从 WebQuestions 演化出 WebQuestionsSP 版本,其中对部分问题给出了可执行的 SPARQL 查询作为标注。 (Papers with Code)

-

在 WebQuestionsSP 中,共有 4,737 个问题有完整的 SPARQL 标注,其余的 ~1,073 个因为无法精确定义或不符合严格可执行要求,标为 "部分标注" 或"不可解析" (微软)

-

这个版本允许研究者不只是评估最终答案的准确度(answer accuracy),还可以评估语义解析器在构建中间结构(如 SPARQL 查询)上的表现。 (ACL Anthology)

-

在论文 "The Value of Semantic Parse Labeling for Knowledge Base Question Answering" 中,作者证明带有语义解析标注(即 WebQuestionsSP)在训练上能带来显著提升(相比只用答案标注)。 (ACL Anthology)

二、为什么 WebQuestions 是 KB-QA 经典基准

WebQuestions 成为 KBQA 领域的经典基准,有以下几点原因:

-

可连接知识库

它的问题都假设可以通过 Freebase 知识库查到答案,这使得它成为典型的 KBQA(知识库问答)场景。它不像阅读理解那样依赖大段上下文文本,而是考察从自然语言到知识库结构(实体 + 关系路径)的映射能力。

-

自然语言、真实问句

问题是爬取 Google Suggest 或网络用户问句改写得到的,具有自然性,不是人工构造的模板问句。 (GitHub)

这提升了模型在真实场景下的泛化挑战性。

-

适中规模、可实验性强

6,642 这个规模足以训练模型,同时不至于过大到训练难以实现。许多早期的 KBQA / 语义解析模型都是以 WebQuestions 为起点进行设计与对比的。

-

便于语义解析 / 图搜索 / 路径模型研究

WebQuestions 往往涉及路径长度为 1 或 2 的关系路径问题(例如 "实体 → 属性" 或 "实体 → 中间节点 → 属性"),是对关系路径模型、图搜索策略的良好测试集。

-

可扩展到语义解析版本

WebQuestionsSP 的存在让研究者能不仅关注"问 → 答案",还能评估"问 → 查询语句 / 路径"的中间表示,这对理解模型推理过程非常有帮助。

三、WebQuestions 的挑战与局限

虽然 WebQuestions 是经典数据集,但它也有一些被研究社区所指出的局限或挑战:

-

偏向一跳 / 两跳问题

大部分问题可以通过一条或两条关系路径在知识库中得到答案,推理深度不大,不太具备复杂多跳推理挑战。相比之下,后来的数据集(如 ComplexWebQuestions、KQA Pro、LC-QuAD 等)会包含更深的推理路径。 (OpenReview)

-

覆盖与缺失关系 / 架构漂移

在实际问答中,一些问题涉及的谓词关系在知识库中不被支持或者知识库不完全。比如有文献指出,在 WebQuestions 的测试集中,有约 5.5 % 的问题,其谓词在知识库中并未出现。 (denxx.github.io)

-

语义歧义与问句模糊性

自然问句有歧义(例如 "who is the wife of Barack Obama" vs "who is the spouse of Barack Obama")以及修饰、复合结构,给实体识别、关系识别带来困难。

-

仅实体 / 关系型答案,不支持描述型或复杂答案

WebQuestions 假设答案是知识库实体(或实体列表),不考虑对自然语言答案或长文本答案的生成。这在某些真实场景下是不够的。

-

知识库版本 & 时效性

Freebase 在过去几年中逐步退役或停止更新,新的实体 / 关系未必被覆盖。模型训练和评估过程中要注意知识库版本差异带来的偏差。

四、在 KBQA / 语义解析研究中的作用 & 使用方式

-

对比基线

在很多 KBQA / 语义解析 / 路径检索 / 图神经网络问答模型的论文中,WebQuestions 是几乎必设的对比基准之一。如果一个方法在 WebQuestions 上表现不好,通常就难以进入主流讨论行列。

-

预训练 / 微调 + 迁移

有些现代模型会先在 WebQuestions 上微调,然后再向更复杂、多跳数据集迁移训练。

-

错误分析与路径策略研究

研究者会对错题(模型回答错误的问题)进行路径、实体、关系的错误模式分析,以反馈改进检索策略或聚类/路径选择策略。

-

组合使用

WebQuestions 常常与 SimpleQuestions、ComplexWebQuestions、LC-QuAD、FreebaseQA 等数据集一起用于综合评测不同模型在不同复杂度问题上的能力。

-

使用语义解析版本

当使用 WebQuestionsSP 时,模型除了预测答案实体外,还需要预测对应的 SPARQL 查询或中间结构,从而可以评估模型结构化推理能力。