我需要在win10安装spark和Hadoop,在网上找了很多教材,发现不适用于自己。所以根据自己的情况,做笔记如下。

1、具体版本信息

java 1.8

scala 2.12 (注意,spark3.1.2不支持scala2.13)

hadoop 3.2.1

spark 3.1.3

可以在这里直接下载

链接: https://pan.baidu.com/s/16EC8BYHSDmBiYswxuIkCEg 提取码: 2025

注意:把网盘里的文件都下载了,其中的winutils.exe是针对hadoop 3.2.1版本的,也就是网盘里hadoop的版本

2、安装流程

我们需要依次安装 java/scala/hadoop/spark.

2.1 java

-

双击

jdk-8u271-windows-x64.exe进行JDK1.8的安装。 -

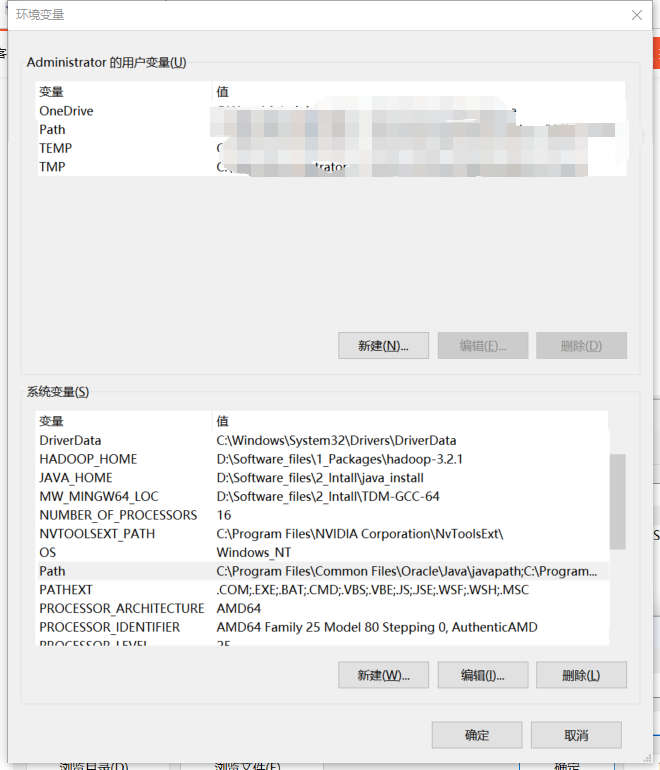

在系统环境变量中添加JAVA_HOME,变量值输入Java安装路径。

我的电脑 -> 属性 -> 高级系统配置 -> 环境变量,进入高级系统设置,进入环境变量

-

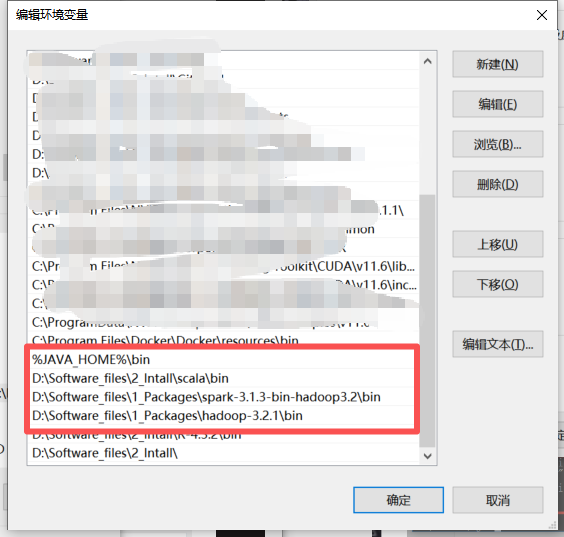

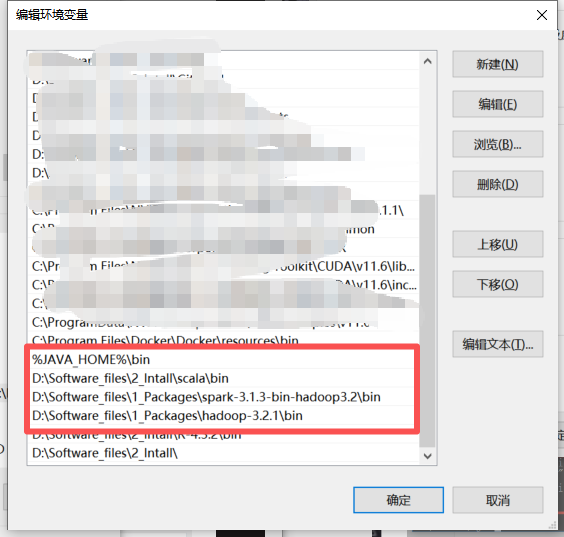

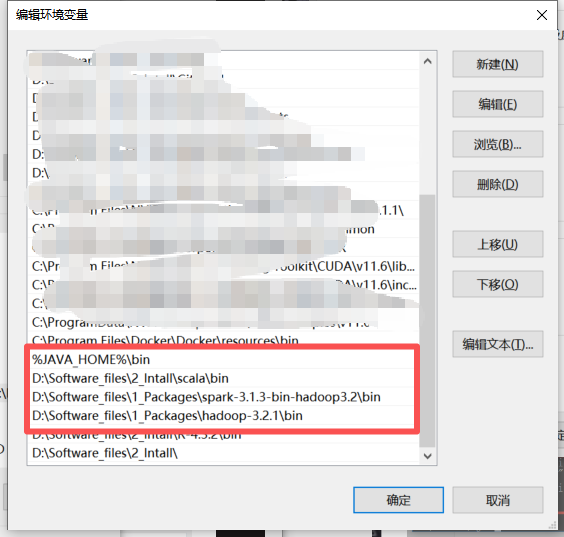

将JAVA_HOME添加到系统环境变量的Path中。

-

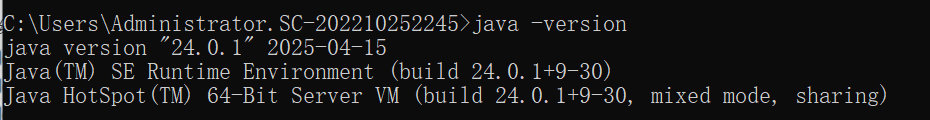

验证JDK是否安装正确了

点击开始键,然后输入

cmd, 在框内输入java -version(后面的验证同理)

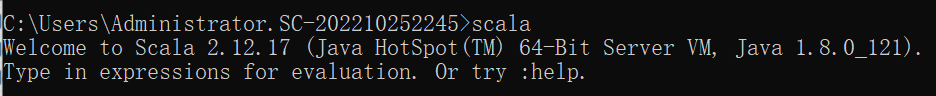

2.2 scala

- 解压scala-2.12.zip到D:\XXX\scala-2.12

- 在系统环境变量中添加SCALA_HOME

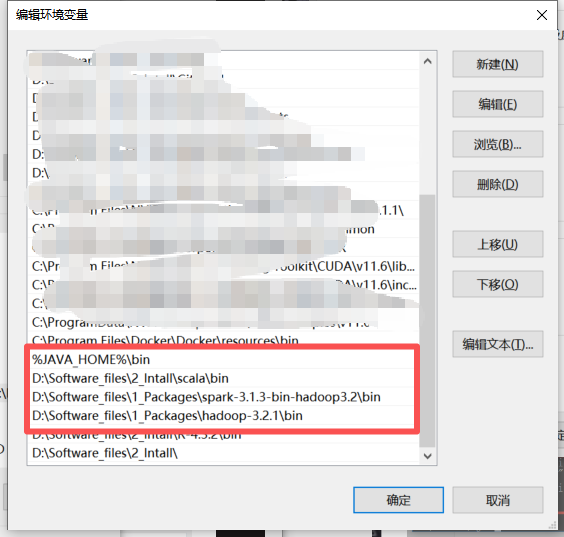

- 将SCALA_HOME添加到系统环境变量的Path中。

- 验证下scala是否安装和配置正确了

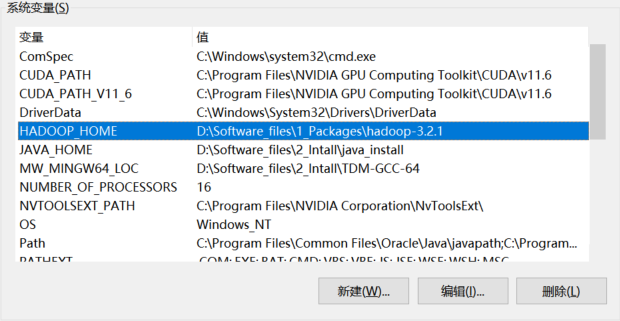

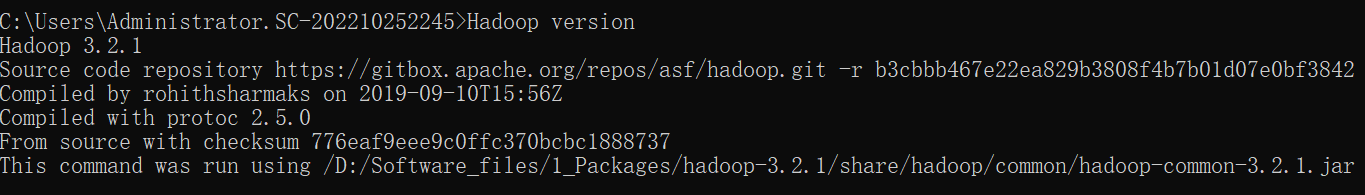

2.3 hadoop

- 解压Hadoop安装包,解压到D:XXX

- 在系统环境变量中添加HADOOP_HOME

- 将HADOOP_HOME添加到系统环境变量的Path中

- 验证Hadoop的环境变量是否配置好了。输入

hadoop version

2.4 spark

-

解压spark安装包,解压到D:\XX\spark-3.1.3

-

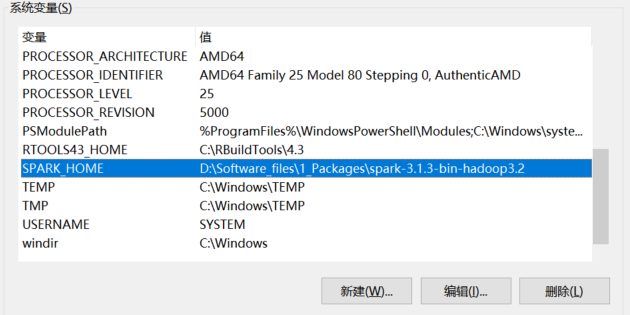

在系统环境变量中添加SPARK_HOME

-

将SPARK_HOME添加到系统环境变量的Path中

-

将hadoop对应版本的winutils.exe,放到hadoop的bin目录下。例如:

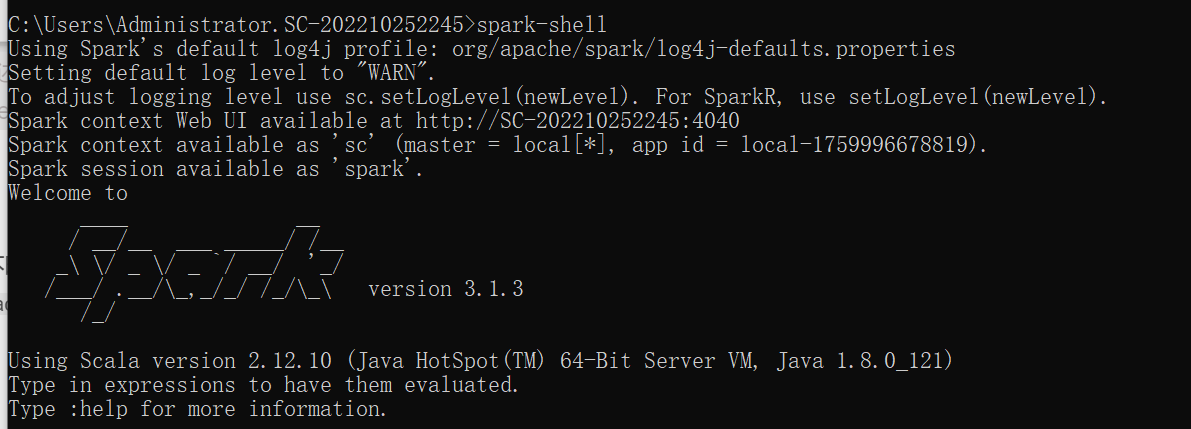

D:\Software_files\1_Packages\hadoop-3.2.1\bin。然后再在黑色窗口中运行spark-shell

3、参考

1\] https://blog.csdn.net/besmarterbestronger/article/details/128780730