📋 介绍

LMArenaBridge 是一个创新的桥接工具,它将LMArena(大型语言模型竞技场)平台转换为标准的 OpenAI API 兼容接口。通过这个工具,用户可以使用任何支持 OpenAI API 的客户端应用程序来访问 LMArena 上的众多先进 AI 模型,实现了"一个接口,访问所有模型"的愿景。

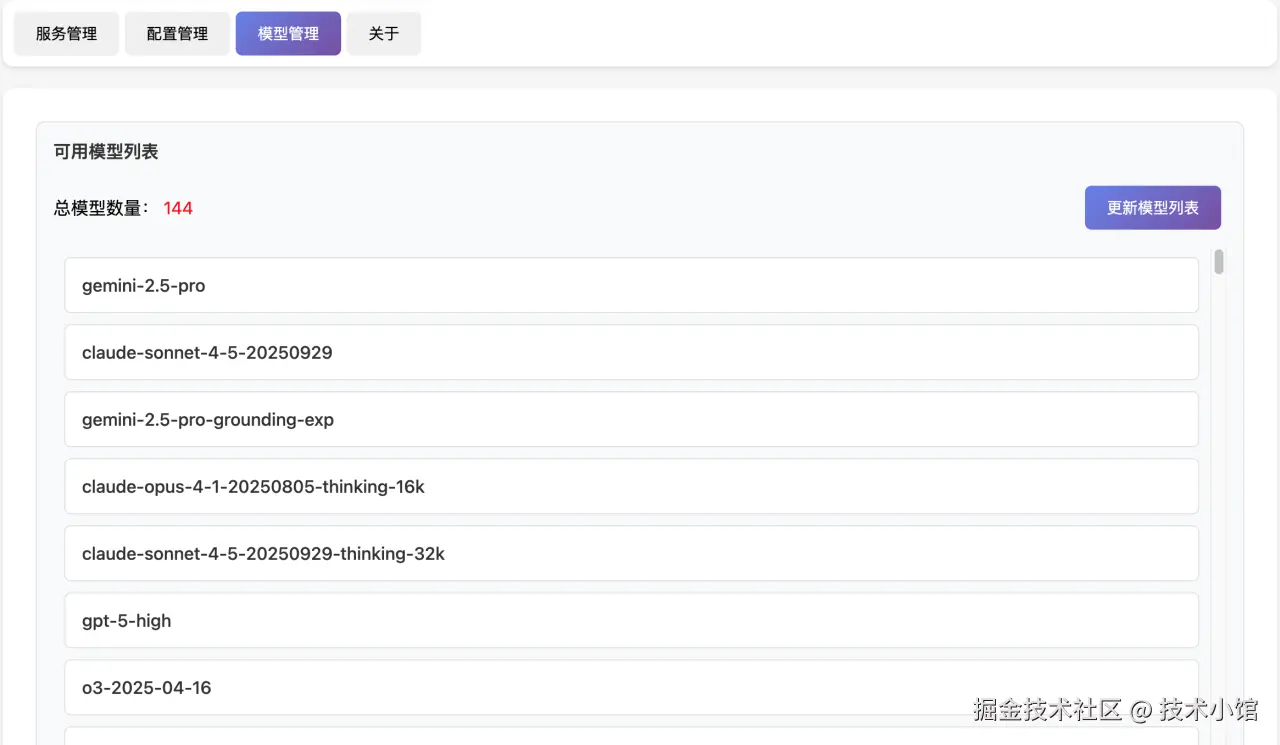

✏️支持模型数量(140+)

下面模型都可免费调用

markdown

## OpenAI

**最新/热门模型:**

- gpt-5-chat

- gpt-5-high

- gpt-5-mini-high

- gpt-5-nano-high

- gpt-5-search

- gpt-5-high-new-system-prompt

- o3-2025-04-16

- o3-mini

- o3-search

- o4-mini-2025-04-16

- chatgpt-4o-latest-20250326

- gpt-4.1-2025-04-14

- gpt-4.1-mini-2025-04-14

- sora

**其他模型:**

- dall-e-3

- gpt-oss-20b

- gpt-oss-120b

- gpt-image-1

- gpt-image-1-high-fidelity

## Google

**最新/热门模型:**

- gemini-2.5-pro

- gemini-2.5-flash

- gemini-2.5-flash-image-preview (nano-banana)

- gemini-2.5-flash-lite-preview-06-17-thinking

- gemini-2.5-pro-grounding

- gemini-2.5-pro-grounding-exp

- gemini-2.0-flash-001

- gemini-2.0-flash-preview-image-generation

**图像/视频模型:**

- imagen-4.0-generate-preview-06-06

- imagen-4.0-fast-generate-001

- imagen-4.0-ultra-generate-preview-06-06

- imagen-3.0-generate-002

- veo3

- veo3-fast

- veo3-audio

- veo3-fast-audio

- veo2

**其他模型:**

- gemma-3-27b-it

## Anthropic

**最新模型(2025/2024):**

- claude-opus-4-20250514

- claude-opus-4-1-20250805

- claude-opus-4-1-20250805-thinking-16k

- claude-opus-4-20250514-thinking-16k

- claude-opus-4-search

- claude-opus-4-1-search

- claude-sonnet-4-20250514

- claude-sonnet-4-20250514-thinking-32k

- claude-3-7-sonnet-20250219

- claude-3-7-sonnet-20250219-thinking-32k

- claude-3-5-sonnet-20241022

- claude-3-5-haiku-20241022

## DeepSeek

**最新模型:**

- deepseek-v3.1-terminus

- deepseek-v3.1-terminus-thinking

- deepseek-v3-0324

## Alibaba (阿里巴巴)

**最新/热门模型:**

- qwen3-max-preview

- qwen3-max-2025-09-23

- qwen3-235b-a22b

- qwen3-235b-a22b-no-thinking

- qwen3-235b-a22b-thinking-2507

- qwen3-235b-a22b-instruct-2507

- qwen3-next-80b-a3b-instruct

- qwen3-next-80b-a3b-thinking

- qwen3-coder-480b-a35b-instruct

- qwq-32b

**视觉模型:**

- qwen-vl-max-2025-08-13

- qwen3-vl-235b-a22b-thinking

- qwen3-vl-235b-a22b-instruct

**图像模型:**

- qwen-image-prompt-extend

- qwen-image-edit

**其他模型:**

- qwen3-30b-a3b

- qwen3-30b-a3b-instruct-2507

- wan-v2.2-a14b

## xAI (Grok)

**最新模型:**

- grok-4-0709

- grok-4-search

- grok-4-fast

- grok-4-fast-search

- grok-4-fast-reasoning

- grok-3-mini-beta

- grok-3-mini-high

## Meta

**Llama 4系列:**

- llama-4-scout-17b-16e-instruct

- llama-4-maverick-03-26-experimental

- llama-4-maverick-17b-128e-instruct

- llama-3.3-70b-instruct

## Mistral

- mistral-small-3.1-24b-instruct-2503

- mistral-medium-2505

- mistral-medium-2508

- mistral-small-2506

- magistral-medium-2506

## Moonshot (月之暗面)

- kimi-k2-0905-preview

- kimi-k2-0711-preview

## Microsoft AI

- mai-1-preview

## Amazon

- amazon.nova-pro-v1:0

- amazon-nova-experimental-chat-05-14

## Cohere

- command-a-03-2025

## MiniMax

- minimax-m1

- hailuo-02-standard

- hailuo-02-pro

- hailuo-02-fast

## ByteDance (字节跳动)

- seedance-v1-pro

- seedance-v1-lite

- seedream-3

- seedream-4-2k

## 其他提供商

**Black Forest Labs (BFL):**

- flux-1-kontext-dev

- flux-1-kontext-pro

- flux-1-kontext-max

**Perplexity:**

- ppl-sonar-pro-high

- ppl-sonar-reasoning-pro-high

**智谱AI (Zhipu):**

- glm-4.5

- glm-4.5-air

- glm-4.5v

**StepFun:**

- step-3

**Luma AI:**

- photon

- ray2

**Recraft:**

- recraft-v3

**Leonardo AI:**

- lucid-origin

**Ideogram:**

- ideogram-v3-quality

**Kling:**

- kling-v2.1-master

- kling-v2.1-standard

**Pika:**

- pika-v2.2

**Runway:**

- runway-gen4-turbo

**Genmo:**

- mochi-v1

**Tencent (腾讯):**

- hunyuan-image-2.1

**Meituan (美团):**

- longcat-flash-chat

**Diffbot:**

- diffbot-small-xl

## 未知/内部测试模型

- phantom-0908-1

- phantom-0908-2

- x1-1-preview-0915

- x1-turbo-0906

- stephen-v2

- stephen-vision-csfix

- EB45-turbo-vl-0906

- EB45-turbo

- EB45-vision

- nightride-on

- nightride-on-v2

- redwood

- sorting-hat

- leepwal

- route66

- Ring-flash-2.0

- Ling-flash-2.0

- anonymous-915

- anonymous-925

- raptor

- "humuhumu" nukunukuapua'a

- hidream-e1.1

- seededit-3.0

- lmarena-internal-test-only

- not-a-new-model😆AI客户端调用

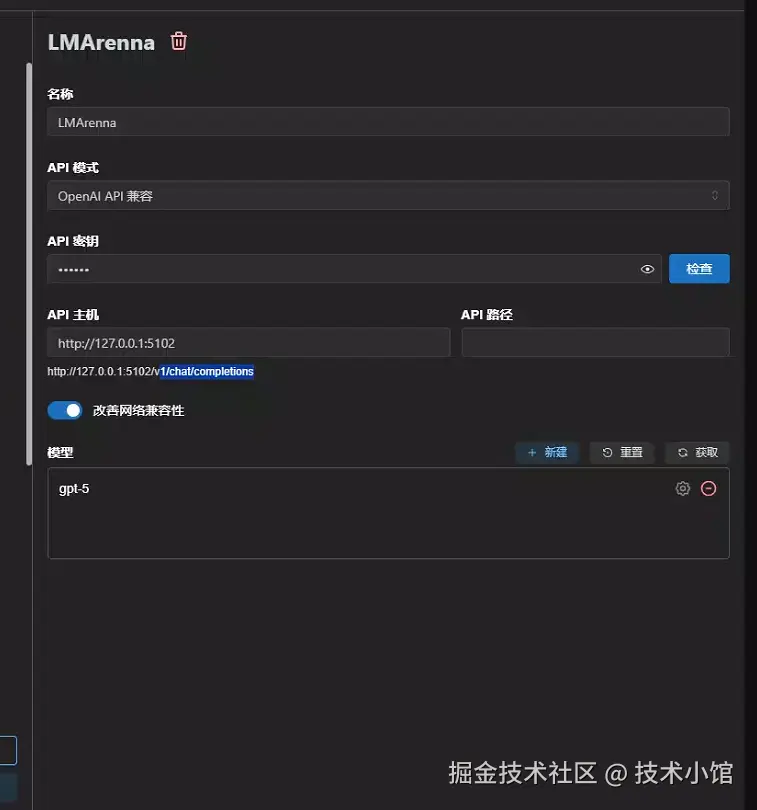

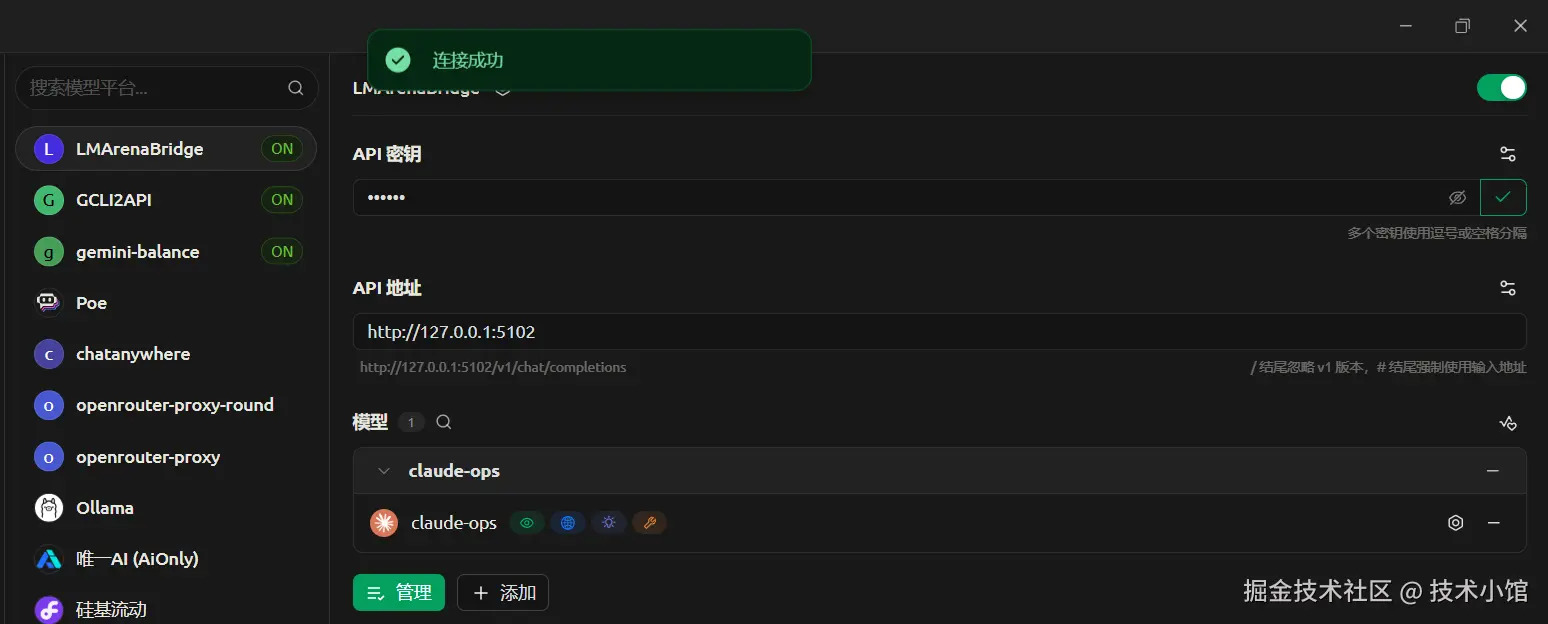

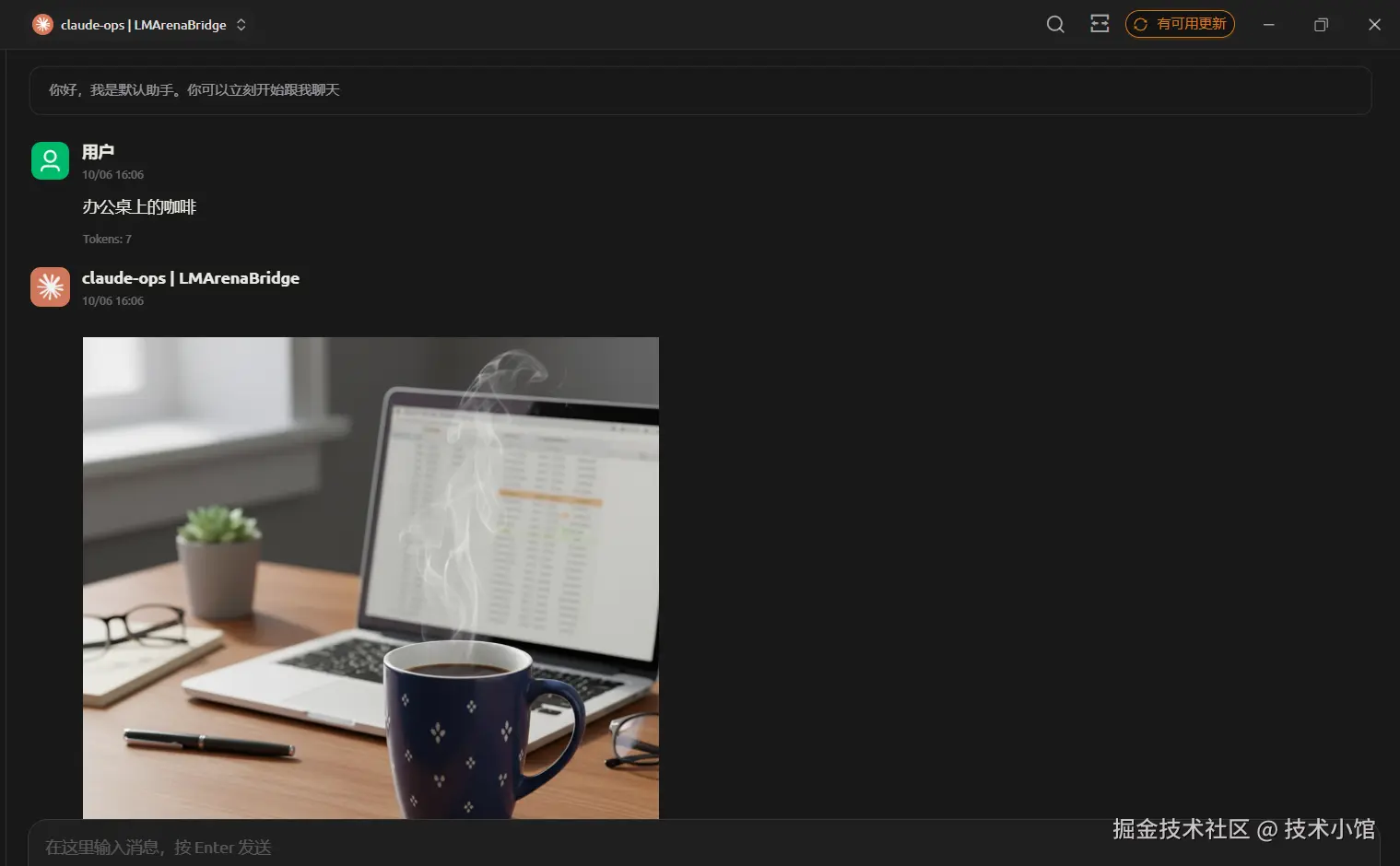

Cheery Studio

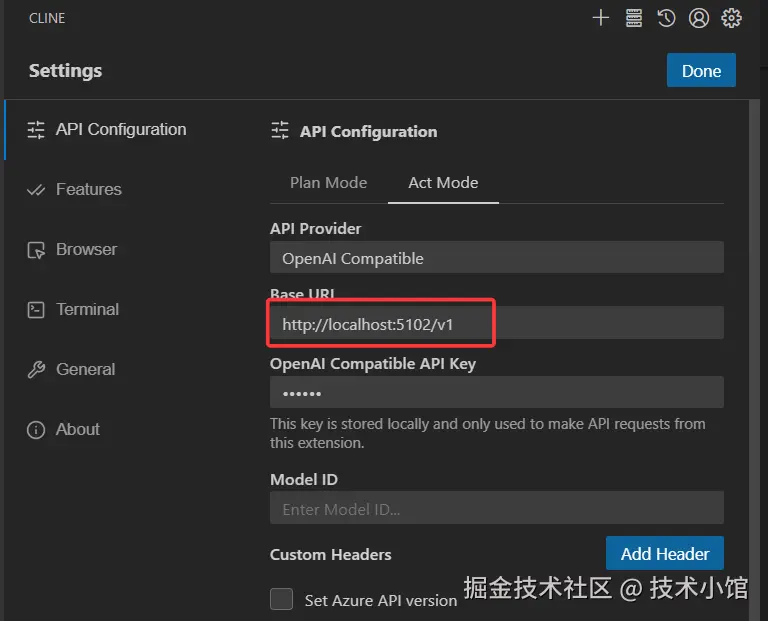

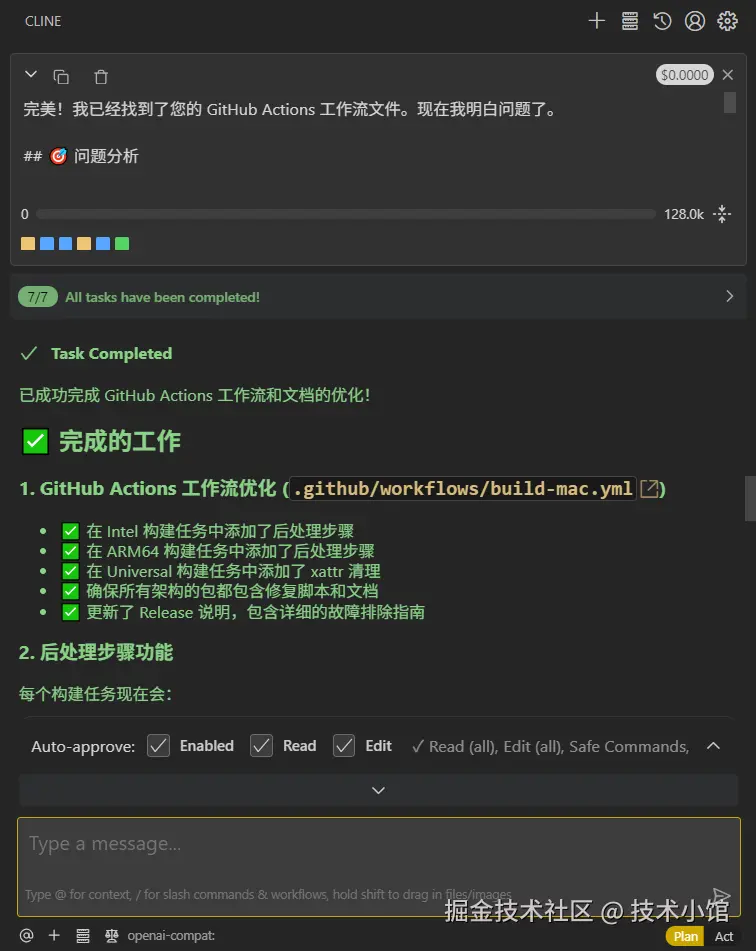

Cline

沉浸式翻译

chatbox

API调用

支持流式和非流式

python

import requests

import json

import time

# API 的 URL

url = "http://127.0.0.1:5102/v1/chat/completions"# 请求头,与 curl 命令中的 -H 参数对应

## 建议将 API Key 抽取为变量,避免硬编码

API_KEY = "123456"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

# 请求体,与 curl 命令中的 -d 参数对应

payload = {

"model": "claude-sonnet-4-20250514",

"messages": [

{

"role": "user",

"content": "你是哪个模型?"

}

],

"n": 1

}

def make_request():

"""发起API请求并在控制台输出响应内容"""

try:

# 发起 POST 请求(非流式)

response = requests.post(url, headers=headers, json=payload, timeout=180)

# 检查响应状态码

response.raise_for_status()

print("--- 开始处理响应 ---")

# 获取完整的 JSON 响应

response_data = response.json()

# 格式化输出响应内容

formatted_response = json.dumps(response_data, indent=2, ensure_ascii=False)

print(f"响应内容:\n{formatted_response}")

except requests.exceptions.RequestException as e:

print(f"[网络错误] 请求失败: {e}")

except json.JSONDecodeError as e:

print(f"[JSON解析错误] 响应格式错误: {e}")

except Exception as e:

print(f"[未知错误] 请求发生错误: {e}")

def main():

"""主函数:执行API请求"""

print("开始执行API请求...")

print(f"\n{'='*50}")

# 发起请求并在控制台输出响应

make_request()

print(f"\n{'='*50}")

print("API请求已完成!")

if __name__ == "__main__":

main()

swift

响应内容:

{

"id": "chatcmpl-d1bba0bb-6bf8-4614-8905-03cf7a51e1f0",

"object": "chat.completion",

"created": 1758941327,

"model": "claude-sonnet-4-20250514",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "我是Claude Opus 4,来自Claude 4模型系列。这是Anthropic目前最强大的模型,专门用于处理复杂的任务和挑战。\n\nClaude 4系列目前包括Claude Opus 4和Claude Sonnet 4两个模型。如果你想了解更多关于Claude模型或Anthropic产品的信息,可以访问Anthropic的官方网站。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 0,

"completion_tokens": 42,

"total_tokens": 42

}

}🎯 解决的核心问题

1. API 标准化问题

- 问题:LMArena 平台使用自己的专有接口格式,与主流的 OpenAI API 标准不兼容

- 解决方案:通过协议转换,让所有支持 OpenAI API 的应用都能无缝接入 LMArena

2. 多模型访问复杂性

- 问题:访问不同的 AI 模型需要不同的API密钥、端点和认证方式

- 解决方案:提供统一的接口,通过模型名称即可切换使用不同的 AI 模型(Claude、GPT、Gemini 等)

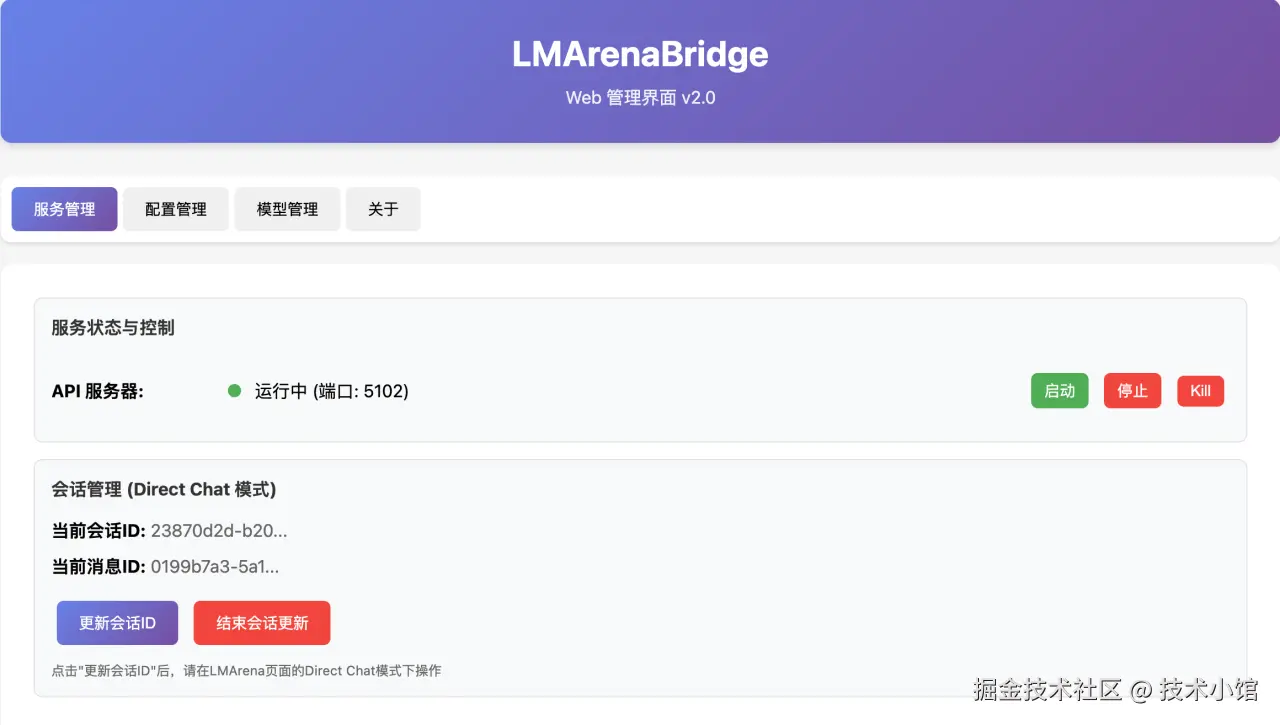

3. 会话管理困难

- 问题:LMArena 需要复杂的会话ID和消息ID管理

- 解决方案:自动化会话管理,提供简单的Web界面进行ID更新和维护

4. 浏览器依赖限制

- 问题:LMArena 只能通过网页访问,无法集成到开发工具和自动化流程中

- 解决方案:通过油猴脚本+本地API服务器,将浏览器页面转换为可编程接口

5. 批量处理和自动化

- 问题:在网页上只能进行单次对话,无法批量处理或自动化

- 解决方案:提供标准API接口,支持批量请求、流式响应和程序化调用

🚀 核心功能特性

1. OpenAI API 完全兼容

- 支持

/v1/chat/completions端点 - 兼容流式(stream)和非流式响应

- 支持多模态输入(文本、图片)

- 完整的错误处理和状态码

2. 智能会话管理

- Direct Chat 模式:直接对话模式

- 自动会话ID捕获和更新

- 支持多会话并发管理

3. 模型动态切换

- 支持 144+ 主流 AI 模型

- 文本生成模型(Claude、GPT、Gemini、Llama等)

- 图像生成模型(Nanobanana、DALL-E、Stable Diffusion等)

5. 完整的管理界面

- Web GUI 控制面板

- 实时日志监控

- 一键启停服务

- 可视化配置管理

💡 典型使用场景

开发者场景

- 将 LMArena 模型集成到 VS Code、Cursor、Cherry Studio 等 IDE

- 在 Python、Node.js 项目中调用各种 AI 模型

- 构建基于多模型的 AI 应用

内容创作者

- 使用 AI客户端访问 AI 模型

- 在写作软件中集成多种 AI 助手

- 批量生成和处理内容

🎨 独特优势

- 零成本访问顶级模型:通过 LMArena 免费使用多种付费模型

- 统一接口标准:一套代码,访问所有模型

- 完全本地化:数据不经过第三方服务器

- 活跃维护:持续更新,快速响应新模型

🤝安装教程

此处为语雀内容卡片,点击链接查看:www.yuque.com/jtostring/q...

此处为语雀内容卡片,点击链接查看:www.yuque.com/jtostring/q...