本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

在大模型时代,越来越多的企业和个人开发者都在尝试构建属于自己的智能体(AI Agent)。但当你真的开始动手,就会发现"一个能跑起来的Agent"与"一个能稳定落地、可持续演化的Agent系统",完全是两个层级的事情。

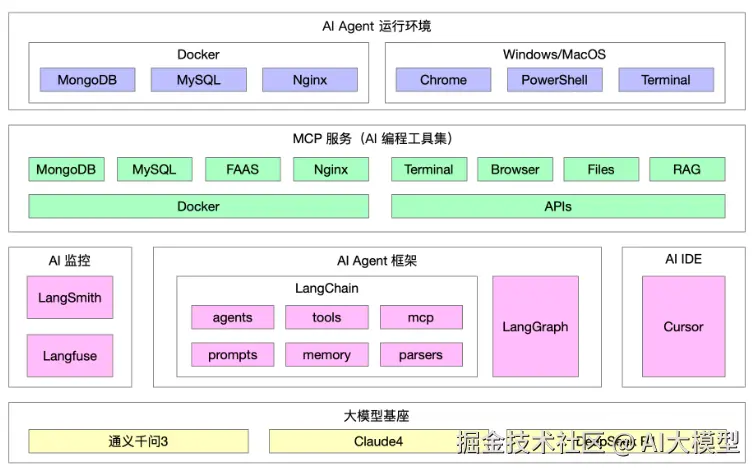

要打造一套工程化、可维护的AI Agent系统,我们需要的不只是模型,而是一整套"生态系统":运行环境、编程工具集(MCP 服务)、框架体系、监控体系、开发IDE以及底层模型基座。

今天,我们就基于一套完整的架构图,来系统拆解这六大模块,告诉你------一套真正可落地的AI Agent架构,究竟该怎么搭。

一、AI Agent运行环境:让智能体有一个稳定的"家"

任何AI系统的第一步,都是搭建可靠的运行环境。运行环境决定了整个系统的稳定性、可扩展性以及跨平台能力。

在这套架构中,AI Agent的运行环境主要由两部分组成:

1. Docker 环境:统一部署与隔离保障

在生产或测试环境中,使用 Docker 来封装服务是当前最主流、也是最高效的方式。

我们通常会把核心依赖容器化,例如:

- MongoDB:用于存储非结构化数据,如上下文记忆、日志记录。

- MySQL:用于存储结构化数据,如任务状态、用户信息。

- Nginx:用于反向代理与API网关,统一管理流量与安全。

好处是什么?

- 一致性:本地、测试、生产环境完全一致。

- 快速部署:通过

docker-compose就能启动整套环境。 - 可扩展:不同组件可以独立升级、扩展。

示例:

vbnet

version: '3.8'

services:

mysql:

image: mysql:8

environment:

MYSQL_ROOT_PASSWORD: example

mongo:

image: mongo:6

nginx:

image: nginx:stable2. 本地环境:灵活调试与快速验证

开发者本地一般使用 Windows 或 MacOS 系统,搭配:

- Chrome:调试Web UI与API。

- PowerShell / Terminal:运行Agent脚本或容器命令。 这种组合能让开发者在本地快速验证功能,再一键迁移到容器环境中,极大提高了迭代效率。

二、MCP服务(AI编程工具集):智能体的"工具腰带"

MCP,全称 Model Context Protocol,在这里它扮演的是"AI编程工具集"的角色。它不是一个单纯的中间层,而是一套智能体调用外部系统、数据与环境的通用接口集合。

在这个层面,MCP 服务包括:

- MongoDB / MySQL:数据的存储与检索。

- FAAS(函数即服务) :按需执行计算任务。

- Nginx / Docker:支撑底层服务与网络通信。

- Terminal / Browser / Files:操作系统与文件能力。

- RAG 模块:为Agent提供"检索增强生成"能力。

换句话说,MCP 就是让智能体"能动手"的一层。

如果说大模型是大脑,那MCP就是肌肉和手脚------它把抽象的模型能力转化为可执行的现实动作。

✅ 落地要点:

- 接口模块化 每一个能力(例如文件读写、网页抓取、数据库查询)都应做成独立API。 比如

/mcp/file/read、/mcp/browser/open、/mcp/sql/query等。 - 统一接口协议 通过 JSON Schema 描述输入输出格式,方便AI Agent自动推理调用方式,确保调用安全。

- 安全与审计机制 所有调用经过统一的网关(Nginx + Auth),并在日志中记录操作详情,以备监控与回溯。

- 可扩展的RAG体系 通过RAG(Retrieval-Augmented Generation)模块,将知识库检索与大模型生成结合,使Agent具备"记忆"和"事实回答"能力。

三、AI Agent框架:LangChain 与 LangGraph 的双引擎

在这一层,系统的主角是 LangChain 框架与 LangGraph 组件。

LangChain 负责定义智能体的逻辑骨架,而 LangGraph 则让整个流程变得可视化与可调度。

1. LangChain 的核心模块

LangChain 是当前最成熟的智能体开发框架之一,它将复杂的AI逻辑分解为多个模块:

| 模块 | 功能 |

|---|---|

| agents | 负责决策与任务分配 |

| tools | 对接 MCP 服务的具体工具 |

| prompts | 统一管理提示词模板 |

| memory | 存储上下文与长期记忆 |

| parsers | 解析并验证模型输出格式 |

| mcp | 管理与外部API的交互 |

这套体系解决了智能体开发中最大的两个痛点:

- 逻辑混乱:每个能力模块独立。

- Prompt 失控:提示词可配置、可版本化。

2. LangGraph:让复杂流程更直观

LangGraph 则是 LangChain 的流程编排与可视化层。

它允许我们像画工作流一样绘制Agent的调用逻辑,清晰地看到"决策 → 调用 → 返回 → 二次判断"的全链路。

应用场景:

- 多工具调用流程(如先检索再执行)。

- 并行任务编排。

- 任务失败后的重试逻辑。

✅ 实战建议:

- 将常用的Tool(如搜索、数据查询)封装成模块,集中管理。

- 使用JSON Schema对LLM输出进行强校验。

- 建立Prompt仓库,统一版本管理,避免"提示词漂移"。

四、AI监控:LangSmith 与 Langfuse 的可观测体系

AI系统的监控,不再是传统意义上的CPU与内存监控,而是要关注"智能行为"的正确性。

在这套架构中,监控体系由 LangSmith 与 Langfuse 组成。

1. LangSmith:对话级追踪与链路回放

LangSmith 能精确记录每一次Agent的对话过程:

- 哪个Prompt被调用了?

- 哪个Tool被执行了?

- 模型返回了什么结果?

这就像给AI系统安装了一套"黑匣子",方便后续复盘和优化。

2. Langfuse:质量与性能监控

Langfuse 主要用于:

- 请求延迟、Token消耗监控;

- 模型响应质量指标(例如RAG命中率、语义相似度);

- 自动告警机制(低置信度输出自动上报人工复核)。

✅ 落地建议:

- 对关键任务引入Trace ID,全链路可追踪;

- 为重要输出(如系统操作类Action)添加二次确认;

- 监控指标应覆盖"模型表现"与"系统健康"两部分。

五、AI IDE:让开发与调试更高效

在AI开发领域,传统IDE已经不足以满足复杂智能体的开发需求。

新的趋势是:AI原生IDE,例如 Cursor。

Cursor 不仅是代码编辑器,更是集成了:

- Prompt调试;

- 工具链测试;

- 生成式代码辅助;

- 实时模型反馈。

它能让开发者在一个界面中完成Prompt迭代、API测试与Agent行为验证,大大提升研发速度。

应用建议:

- 把Cursor与LangSmith的日志系统打通,实现"本地调试---线上复盘"的闭环;

- 利用Cursor的Prompt版本控制功能,记录不同版本下的模型表现。

六、大模型基座:多模型并存的智能底座

在架构的最底层,是整个系统的"大脑"------模型基座。

在这套架构中包含:

- 通义千问3:中文语义与任务理解能力强;

- Claude 4:擅长逻辑推理与英文任务;

- DeepSeek R1:具备推理优化与成本优势。

✅ 核心思想:多模型协同与智能路由

不同任务调用不同模型,避免"一模型包打天下":

- 事实型问题 → 通义 + RAG;

- 逻辑型任务 → Claude;

- 大批量计算类 → DeepSeek。

系统可以通过"模型路由策略"动态分配任务,甚至在高价值场景下使用"双模型比对",取最优答案。

七、工程落地全清单

要把整套AI Agent架构真正落地,你可以按以下清单执行:

- 启动阶段:

- 搭建Docker环境

- 实现一个最小可用Agent(LangChain + 一个Tool + 一个模型)

- 扩展阶段:

- 接入MCP服务(RAG / Browser / FAAS等)

- 加入LangSmith监控与Langfuse日志

- 优化阶段:

- 引入LangGraph编排复杂流程

- 建立Prompt与Schema版本库

- 加入安全控制与人工复核机制

- 稳定阶段:

- 模型多路由(Claude + DeepSeek)

- 成本与性能监控

- 自动评测与A/B测试

八、总结

如今,AI Agent已不再是"玩具项目",而是企业智能化的关键入口。

真正的挑战,不在模型,而在体系。

这套架构提供了一种工程化思维:

让运行环境、工具集、框架、监控、IDE和模型基座形成"六层闭环",让智能体具备持续学习、可控演化的能力。

当一个Agent拥有了标准化的环境、可靠的调用链、清晰的监控与多模型支撑,它就不再是"一个Demo",而是一个真正能落地、能带来业务价值的智能系统。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。