从客户端到数据库的全链路性能瓶颈系统性排查指南

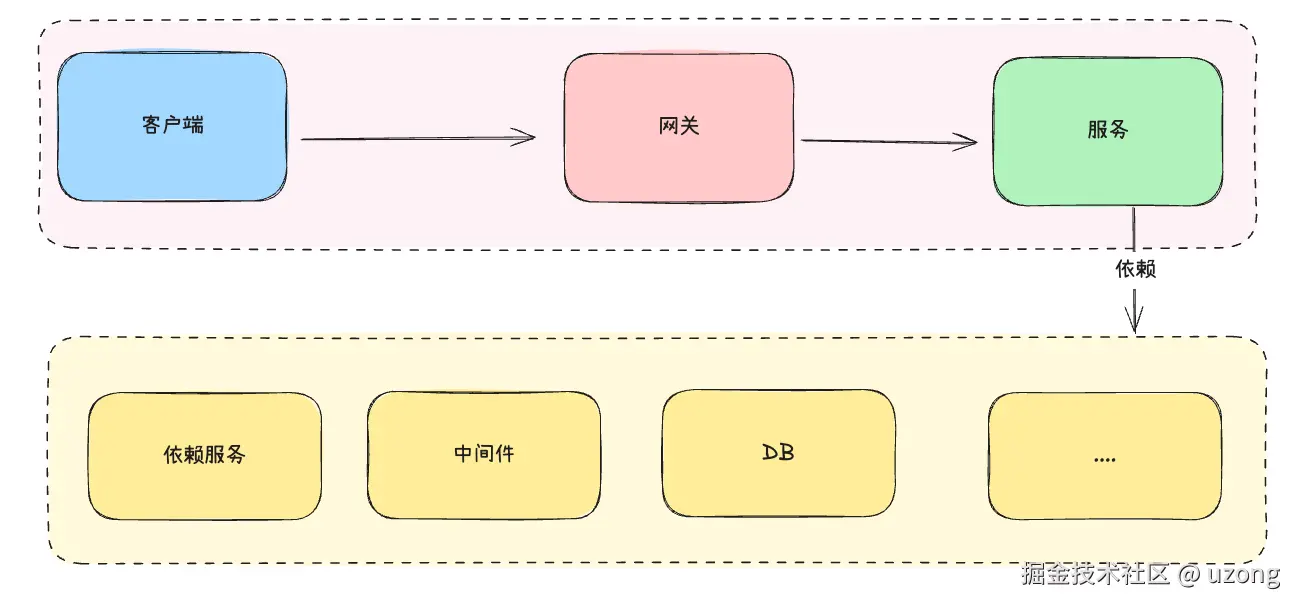

本文系统梳理了导致接口响应缓慢的40余种潜在原因,涵盖网络、网关、JVM、数据库、中间件等多个层面,旨在帮助开发者建立完整的性能问题排查思维模型,适用于线上故障定位与技术面试准备

- 作者:面汤放盐(公众号) || uzong

- 时间:2025-10-15

- 转载请备注声明

为什么会问这个问题

问题:现在生产上有一个慢接口,请分析一下这个慢接口,可能是系统中哪些环节导致的,大致原因是什么,可以是一些很细的案例,系统性的分析一下,越多越好,注意仅从理论分析

这是我作为技术面试官比较喜欢的一个问题,它比较客观真实的反映候选人过往经历遇到过疑难杂症的丰富度以及技术的广度。通过这些点,也能很好的反映出候选人解决实际问题的综合能力。只有知道这些可能会导致的节点,才能在排查问题的过程中,通过猜想论证,而不至于对问题束手无策。

因此它是非常具有技术深度和广度的综合性问题。针对复杂的分布式架构而言,任何一个小点做的不好,都可能引发灾难性问题。

一些回答的加分项

- 能够系统性、有层次的分析。例如从网络、网关、代码、中间件、数据库等逐层分析。

- 案例清晰:比如数据库连接池设置过小,或沿用默认配置,在高并发场景下,无法获取连接的线程将被迫等待。(反例:数据库资源不够)

系统性总结

今天我就来盘一盘,哪些导致接口慢的可能性。

1. 客户端

- js 渲染,复杂的前端逻辑、未优化的算法、频繁的DOM操作

- 前端 JavaScript 存在死循环或递归无终止条件,导致主线程阻塞

- 社交媒体插件、分析工具等第三方脚本加载缓慢等拖慢页面加载

- 本地各种代理等

- 广告、统计、埋点JS加载或执行缓慢

2. 网络

这是很多候选人没有接触过或者容易忽视的地方, 对于网络也踩过不少坑。

2.1. 带宽不足

这是很多年前了,跟客户对接开放接口,他们初期购买了阿里云的服务器,网络带宽 1 M,开放阶段还没有问题,等上线后,客户使用按照组合逐步开通使用后,慢慢出现问题,开始慢,后来直接超时。反馈到我们,让我们看一下到底什么问题,经过一轮排除下来,最终确定是带宽不足。

小带宽在高并发下成为瓶颈是常见问题

2.2. DNS

DNS解析失败或缓慢会导致整个HTTP请求卡在初始阶段

2.3. CDN 问题

CDN节点缓存失效或缓存命中率低、回源慢或节点故障会导致延迟。

2.4. TCP 连接未正确关闭

也是很多年前,有一个哥们,自己封装了一个 http 的客户端,属于定时任务,会定期去创建 http 请求,最后 TIME_WAIT 状态越来越多。

短连接场景下,客户端或服务端未正确关闭连接,导致系统产生大量TIME_WAIT或CLOSE_WAIT状态的连接。导致短时间内建立大量短连接,产生大量处于 TIME_WAIT 状态的 socket,消耗端口资源和 fd,最终引发连接失败或请求阻塞

3.网关层面

3.1. nginx worker 线程耗尽

worker_processes(工作进程数)或 worker_connections(单个进程最大连接数)配置不足,导致高并发下连接被占满,新请求需要等待。

3.2 网关

- 网关节点异常宕机,导致部分请求阻塞等待 (表现为请求失败或超时,而非响应延迟)

- 网关节点CPU负载过高

4.服务层面

4.1. 最大HTTP连接数限制

比如 tomcat 能够处理的http连接数,大量并发请求过来时。

4.2 线程池处理任务

- 并发任务,任务在连接池队列里面等待,未能及时处理请求。

- 若队列过长或使用无界队列,可能引发OOM或响应延迟

4.3. JVM

- Full GC 频繁,出现 STW 问题。(STW(Stop-The-World):JVM执行GC时暂停所有应用线程的现象)

- 当 Metaspace 发生 OOM 时,会触发频繁 GC

4.4. 分布式锁问题

- 分布式锁的力度太大或者设计的不合理,导致后续请求长时间等待

- 分布式锁未能及时释放,比如遇到错误未能正常关闭,导致请求需等待至锁的超时时间到期才能继续执行。

锁的超时时间设置过长。当某个实例持有锁后发生GC或宕机,锁需要等到超时后才能释放,这段时间内所有其他请求都在等待。当然除了分布式锁,还有 Java 层面的各种锁竞争问题,以及数据库的悲观锁等串行化。

4.5. 外部依赖服务

在微服务架构中,我们会拆分很多服务,可能我们依赖的服务比较慢,导致我们的服务也变的很慢。常见的一些现象就是服务雪崩。因为其中一个环节出现问题,导致整个集群都出现问题。

4.6. 长事务

事务过长,事务设计不合理,或过大,比如一些不需要事务的查询也放在此事务中,长时间未提交的事务持有锁

4.7. 缓存问题

- 缓存击穿:某个热点Key在过期瞬间,大量请求击穿到数据库。

- 缓存穿透:请求数据库中根本不存在的数据(如不存在的用户ID),导致请求每次都落到数据库。

- 缓存雪崩:在某一时刻,大量缓存Key同时过期,导致所有请求都落到数据库

- 缺乏缓存预热机制,导致首次访问需加载大量数据,首次加载过慢

4.8 debug 阻塞

- 有人在进行 debug,导致请求阻塞(在线下环节常见,一般线上禁止)

- arthas 监控高频方法(线上误操作:如通过 Arthas 对高频方法添加 trace,导致方法执行时间显著增加;或执行

thread --all导致JVM暂停) - 对线上资源进行 dump

4.9 其他

- 大而全的复合接口。比如树状类的结构,部门树等

- 串行的大接口:一个接口内部需要调用多个其他服务或查询多次数据库,并且这些调用是串行的,总延迟等于各步骤延迟之和。

5.资源类

5.1. 资源分配太小了

我们在使用 K8s 初始化资源的时候,资源分配过小,比如只分配了 1 G内存,或者1核CPU。同理我们的硬件资源不够。比如物理节点太小也是可能的。

- CPU资源不足或过载

- 磁盘性能差,比如采用机械硬盘。(好一点的磁盘,用闪存)。

5.2. 负载过高

同一个服务集成的功能过多,导致一些占用CPU、IO的任务持续时间过长,导致其他任务请求不能有效响应。

内存不足(OOM)。不仅会触发频繁的Full GC,极端情况下操作系统会使用Swap空间,导致磁盘I/O成为瓶颈,整个系统响应变得极慢

5.3. 磁盘

- 磁盘性能低

- 磁盘不足

5.4. 操作系统限制

操作系统层面,达到系统最大文件打开数限制

6.中间件

6.1. Redis

6.1.1. 存在大Key

由于大Key存在,导致这一次请求,变的很慢。

6.1.2. Redis服务和后端服务不在同一机房

有一次申请 Redis 资源扩容,Redis 与后端不在同一个机房,导致一个 Redis 的请求,因为网络问题达到1s。该接口频繁访问Redis,跨机房调用延迟叠加,造成整体性能下降

高频调用服务部署在不同可用区,跨机房延迟高

6.1.3. 耗时命令

Redis 执行耗时命令,阻塞线程 ( KEYS * 等操作),因为单线程,所有线程被阻塞

6.2. 限流

依赖的服务限流、只能执行等待。

6.3. Redis连接未正确关闭

这也是很久以前的故事了,写了一个调度分布式,每天执行一次,Redis连接未释放,最终导致连接用完,导致页面加载很慢到最后无法加载。

6.4 MQ

- MQ 消息消费堆积,触发限流等,生产者发送同步阻塞

7.DB 层面

7.1. 过多字段输出

这是我在大厂的时候修复的第一个bug,是流程实例列表,但是页面使用的字段不多,由于返回数据量过大,导致接口比较慢,页面加载达到5-8s。去除冗余字段后,接口响应时间从5--8秒降至1秒以内。

7.2. 连接池配置采用默认

连接池设置过小,如HikariCP默认maxPoolSize=10。虽然线上有5台节点,但是当慢接口遇上并发,加上该服务属于用户中心核心服务,导致整个集群应用都开始集体变慢。

后来优化了一个版本。由于读写分离,在主库(master)调整了连接池大小,但是从库(slave)没有调整,最后效果还是不理想。因为系统存在更多的读操作,所以通过观察,对slave连接池进行了调整,大大缓解了压力。

7.3. 锁等待

对于大表增加索引、删除、修改类型,导致表被锁,所有新的请求被阻塞,导致部分请求慢、部分请求超时。

锁表时长取决于表数据量大小及数据库版本(如 MySQL 5.7 vs 8.0 DDL 优化差异)。

包括行锁、表锁、的等待,都可能导致此问题,缓冲区大小、并发连接数等参数不合理等

7.4. 死锁(超时 hang住)

如果遇到死锁,就直接超时了。死锁导致事务长时间等待,虽最终会被数据库自动解决,但在检测前表现为接口超时或延迟升高

7.5. 分布式事务

分布式事务慢时比较常见的。因为整个过程复杂,当一定并发量上来后,分布式事务会非常慢。

7.6. 其他常见问题(慢sql引发的慢接口)

- 数据量过大,导致DB性能下降。

- 未命中索引(未使用索引会很多)、全面扫描。(可能因为执行计划选择不合理)的慢查询。

- 排序使用 file sort

8.安全类

DDoS 攻击, 导致资源被大量耗尽

9.后记

还有太多太多导致接口慢,甚至直接hang住的场景。

以上只是冰山一角,技术的复杂性决定了问题的多样性。欢迎你在评论区分享你遇到过的那些'奇葩'的性能瓶颈案例,我们一起完善这份'避坑指南'。

转载注明出处。