在智能创作和视频生成的实践中,工作流不仅仅是节点的堆叠,而是一个围绕业务目标、数据流转和模型能力的有机整体。通过对工作流的抽象与模块化设计,我们可以在复杂的生成任务中实现高效的可复用性与灵活性。本篇文章将围绕某实际业务场景展开,介绍完整的工作流结构,并重点解析核心模型与节点配置方式,帮助读者从整体视角理解其逻辑与实现。

文章目录

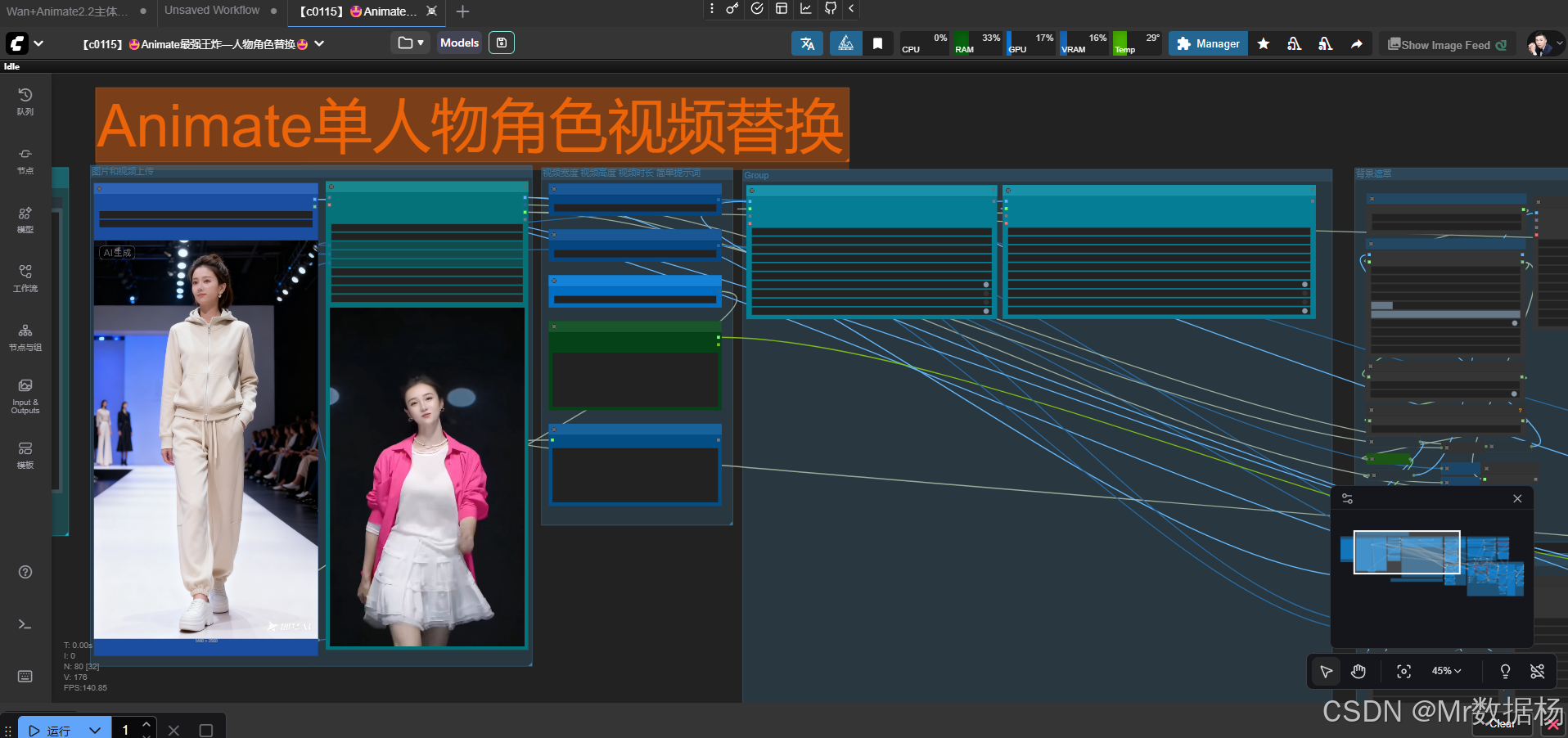

工作流

一个完整的工作流是由数据输入、模型处理、结果合成和输出展示构成的有机链路。它的价值在于把不同的模型能力(如图像生成、视频生成、分割、融合等)通过节点化的方式连接起来,形成可复用和可扩展的执行逻辑。

核心模型

在整个工作流的实现中,核心模型是最重要的智能算力来源。它们直接决定了生成的质量和表现力,同时也是工作流差异化的根本所在。不同类型的模型承担着不同的职责:有的负责特征提取,有的专注于生成,还有的则进行解码或优化。理解这些模型的角色,就能更好地把控工作流的整体效果。

| 模型类型 | 代表节点 / 模块 | 功能说明 | 在工作流中的作用 |

|---|---|---|---|

| 图像理解模型 | CLIP Vision | 提取输入图像的语义特征,理解内容与上下文 | 为生成环节提供特征向量,帮助模型保持内容一致性 |

| 生成模型 | WanVideo、图像生成模型 | 根据文本、图像或多模态输入生成新的视频帧或图像 | 承担主要的合成与替换任务,决定最终输出的画面质量与风格 |

| 编解码模型 | VAE (Variational Autoencoder) | 负责数据的压缩与解压缩,提高生成效率,同时保证图像的保真度 | 在图像/视频合成过程中实现高效推理与解码,避免细节丢失 |

| 辅助模型 | 分割模型、Mask 模型 | 对输入数据进行区域划分与遮罩生成 | 提供精准的局部控制能力,让生成过程更可控 |

| 调优与扩展模型 | LoRA、BlockSwap 等 | 在基础模型的能力之上叠加特定的风格、动作或角色控制 | 提供灵活扩展,使得工作流能根据业务需要快速定制不同效果 |

这些核心模型不是孤立工作的,而是以流水线的方式衔接在一起。比如:输入视频先由分割模型处理生成掩码,再送入 WanVideo 生成模型进行合成,最终通过 VAE 解码输出。在这个过程中,CLIP Vision 保证特征一致性,而 LoRA 模块则帮助叠加个性化风格。

工作 Node 节点

如果说核心模型是"引擎",那么 Node 节点就是"零部件"。每一个节点都承担了明确的功能,而这些功能组合在一起,就能驱动整个工作流顺利运行。节点分为输入节点、处理节点、控制节点和输出节点,它们像拼图一样相互连接,构成了一条闭环链路。

| 节点类型 | 示例节点 | 功能说明 | 在工作流中的价值 |

|---|---|---|---|

| 输入节点 | Get_reference_image、Get_face_images、Get_input_video | 接收外部数据,如参考图像、人脸素材、输入视频 | 相当于表单的"数据采集",为后续流程准备输入 |

| 处理节点 | ImageCropByMaskAndResize、DrawMaskOnImage | 对输入数据进行裁剪、遮罩绘制、尺寸调整 | 确保输入符合模型需求,相当于表单中的"字段校验与预处理" |

| 模型节点 | WanVideoSetLoRAs、WanVideoSetBlockSwap、CLIP Vision | 调用核心模型进行推理和生成 | 承担主要的智能计算,是工作流的"业务逻辑执行层" |

| 控制节点 | SimpleMath+、ImpactInt、Set_INT | 对参数进行运算或修改,灵活控制流程中的关键变量 | 保证流程可调优、可定制,相当于业务中的"逻辑控制器" |

| 输出节点 | VHS_VideoCombine、Set_AUDIO、Set_IMAGE | 将生成的图像序列、音频流合成为视频或导出图像 | 提供最终成果,相当于业务流程的"结果交付" |

这些 Node 节点构成了实际的执行层。以 VHS_VideoCombine 为例,它把前面所有的帧图像、音频流和元数据汇总到一起,生成最终的视频结果;而 ImageCropByMaskAndResize 则通过裁剪和调整分辨率,确保输入符合生成模型的需求。正是因为这些节点层层衔接,才让复杂的工作流既可复用,又能灵活调整。

工作流程

整个工作流的运转可以理解为一条清晰的数据链路,从输入到输出,每一步都承担着不同的职责。它并不是简单的节点堆叠,而是一个围绕核心模型展开的多层次协作过程。通过合理的流程设计,可以在保持生成质量的同时兼顾效率与可控性。

| 流程阶段 | 核心操作 | 关键节点示例 | 作用价值 |

|---|---|---|---|

| 输入准备 | 收集外部资源,包括参考图像、人脸素材、输入视频 | Get_reference_image、Get_face_images、Get_input_video | 为工作流提供数据基础,相当于业务表单中的数据采集环节 |

| 数据预处理 | 裁剪、分割、遮罩、尺寸调整 | ImageCropByMaskAndResize、DrawMaskOnImage | 确保输入数据符合模型需求,过滤冗余信息,提升后续生成的稳定性与精度 |

| 核心生成 | 调用主干模型进行图像/视频合成与角色替换 | WanVideo、CLIP Vision、VAE、LoRA | 承担最核心的业务逻辑,直接决定生成结果的质量与表现力 |

| 参数控制 | 灵活调节关键参数,决定最终输出的风格与细节 | ImpactInt、SimpleMath+、Set_INT | 提供可调优能力,让生成结果更符合业务需求或个性化目标 |

| 结果合成 | 将多路输出整合为最终的视频或图像 | VHS_VideoCombine、Set_AUDIO、Set_IMAGE | 汇总所有生成资源,形成完整交付成果,相当于业务流程的结果落地与交付阶段 |

从表格可以看出,整个流程是分层次展开的:数据准备解决"原料"问题,预处理保证"食材"合格,核心生成承担"烹饪"任务,参数控制相当于调味,最终的结果合成则是上菜。这种环环相扣的逻辑使得工作流既具备稳定性,也能在不同场景下快速调整。

应用场景

该工作流的设计不仅局限于单一任务,而是可以灵活扩展到多种实际业务场景中。其核心优势在于模块化和可复用性:通过替换不同的输入或调整参数设置,就能快速适配不同需求。

| 应用场景 | 实际需求 | 工作流价值 |

|---|---|---|

| 视频角色替换 | 将视频中原有角色替换为目标人物,保持动作与场景一致 | 提供自动化替换方案,减少手工逐帧修改成本 |

| 虚拟试衣 / 换装 | 在固定动作视频中替换人物服装,实现快速的服饰展示 | 为电商、时尚行业提供低成本的内容生成方式 |

| 宣传短片制作 | 使用统一的模板,快速替换人脸、动作、背景,实现定制化宣传内容 | 帮助品牌在短时间内批量生成个性化视频 |

| 教学 / 培训场景 | 替换人物角色,实现虚拟讲师或特定身份的角色演绎 | 提供互动性更强的教学内容,提升学习体验 |

| 内容创意与娱乐化创作 | 结合不同的参考图像与视频片段,生成风格多变、趣味性强的娱乐短视频 | 扩展创作边界,为短视频平台、社交媒体提供更多素材与创意空间 |

综上所述,这类工作流不仅解决了特定的技术问题,还在实际应用中展现了极强的适配性与商业价值。通过模块化设计,用户能够用同一套逻辑服务于不同的场景需求,从而大幅度提升效率与创造力。

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用