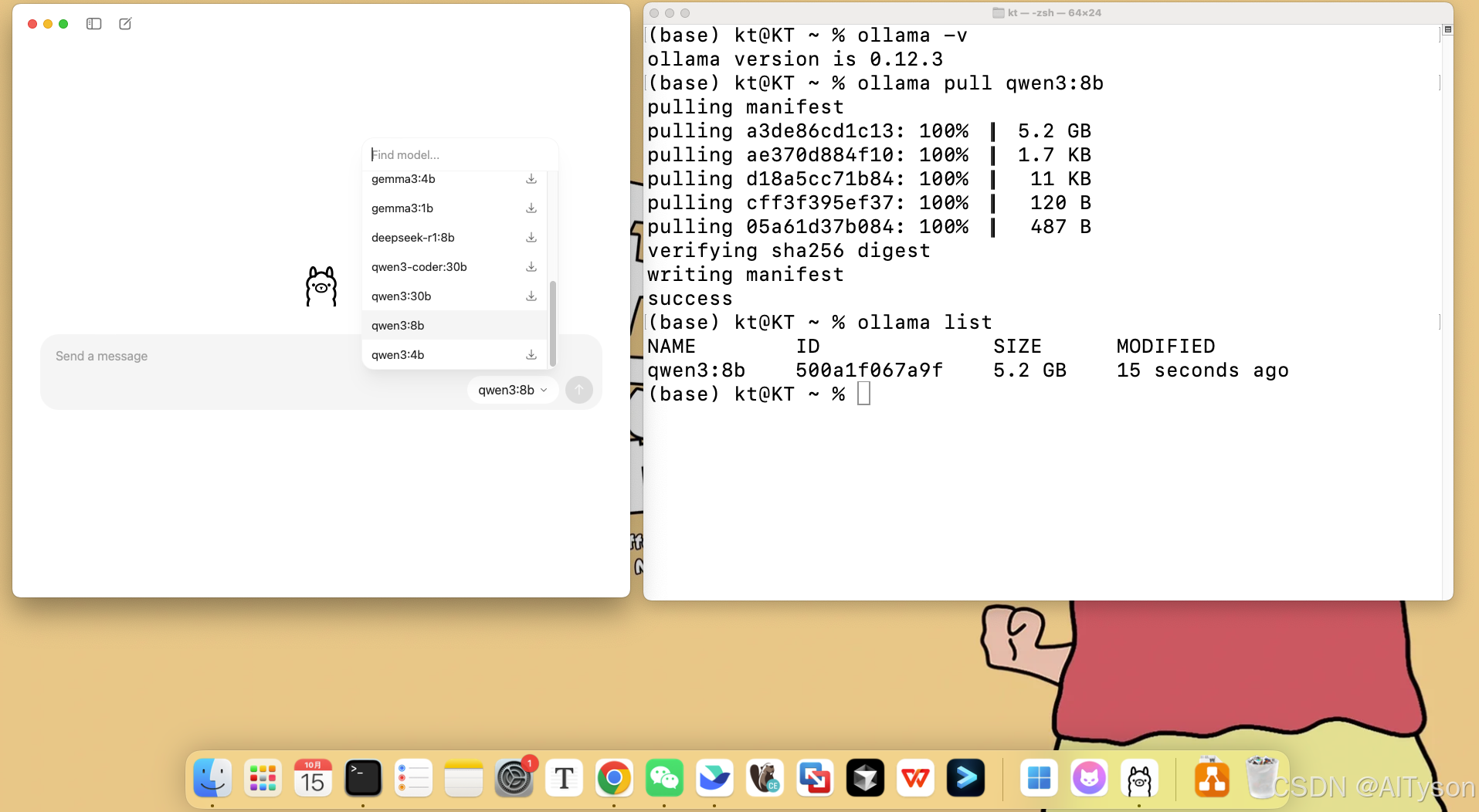

Langchain使用Ollama pull的大模型集成LLM的DEMO

1. 演示预备环境信息

MacOS

python3.12.*

ollama

2. 安装Python包

bash

pip install --pre -U langchain

pip install -qU langchain-ollama3. 安装Ollama

shell

# 测试Ollama是否成功安装

(py312) kt@KT ~ % ollama -v

ollama version is 0.12.3

# 获取qwen3:8b llm模型

ollama pull qwen3:8b

# 检测是否获取成功

ollama list

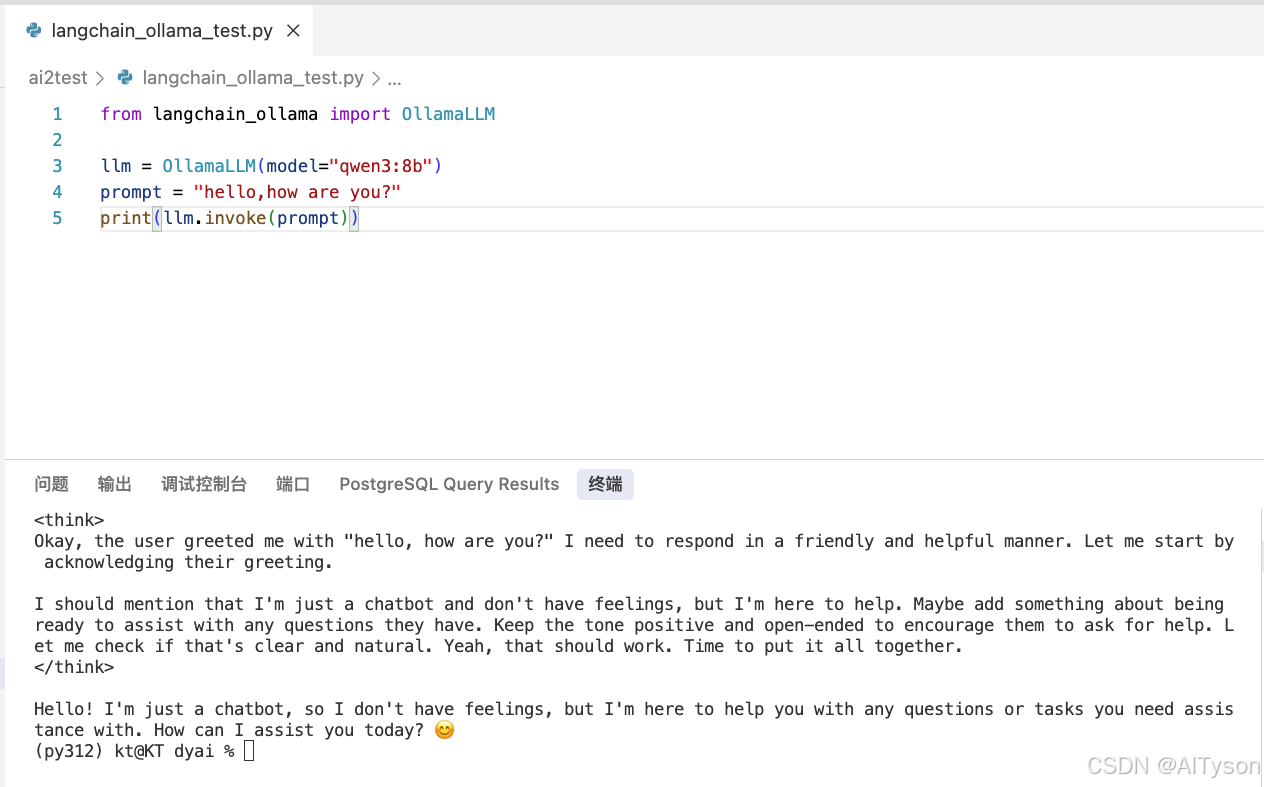

4. 测试DEMO

python3

from langchain_ollama import OllamaLLM

llm = OllamaLLM(model="qwen3:8b")

prompt = "hello,how are you?"

print(llm.invoke(prompt))

# 稍等片刻 便会输出答案

langchain-ollama有三种集成模式,chat_models、embeddings、llms,可通简单阅读文档,获取使用方式。