编者按: 你是否也曾认为,AI 推理服务注定是一场烧钱的无底洞?

我们今天为大家带来的这篇文章,作者的核心观点是:OpenAI 和 Anthropic 等公司在推理环节的实际成本远低于外界普遍认知,甚至在某些场景下已具备大幅盈利能力。

文章通过第一性原理,以 H100 GPU 集群为例,详细拆解了输入与输出 token 的成本结构,指出输入处理成本极低(每百万 token 约 0.001 美元),而输出生成成本较高(每百万 token 约 3 美元)。作者进一步分析了不同用户场景(如消费者套餐、开发者工具、API 服务)的经济模型,揭示了为何像 Claude Code 这样的编程助手能够实现高利润率,而视频生成类应用则面临更大的成本压力。

阅读时请注意:文中计算基于理想化的硬件利用率和简化模型假设,现实世界的推理成本可能更高。可以把它当作"启发性的估算框架",而非精确的经济结论~

作者 | Martin Alderson

编译 | 岳扬

我总听人说 AI(尤其是推理环节)是台烧钱机器[1-3]。表面上看这种说法似乎有道理,但我一直对这类论断持保留态度,因此决定深入探究一番。

目前还没见到有人真正系统性地剖析过大范围运行推理任务的实际成本,其中的经济账确实让我深感好奇。

以下内容完全是粗略估算。虽然我没有亲自大规模部署过最顶尖的 AI 模型,但我对如何在云上运营高并发、大流量的服务及其成本效益有着深入的了解,也深知那些云巨头的报价和他们自家硬件成本之间存在着多么惊人的利润空间。我说的不一定全对,非常欢迎大家来指正和讨论。

01 几点前提假设

本文仅探讨原始计算成本。这种处理方式显然过于简化,但考虑到当前模型的实用价值,即便假定技术毫无进步,我仍想重点验证一个观点:是否所有企业在推理环节的亏损都已严重到根本难以为继的程度。

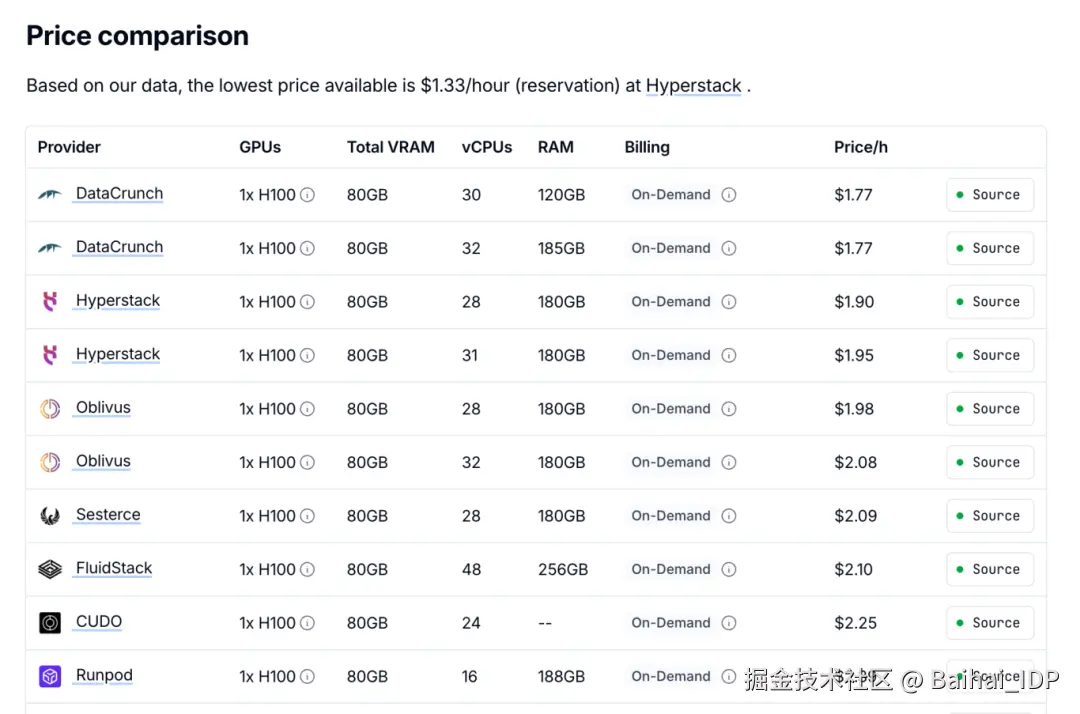

我设定单颗 H100 芯片的成本为每小时 2 美元。这实际上已高于当前市场零售的按需租赁价,而我(推测)大型 AI 企业实际采购成本应该远低于这个数额。

其次,我将以 DeepSeek R1 的架构为基准,该模型采用混合专家模型架构,总参数量 671B,激活参数量 37B。鉴于其性能与 Claude Sonnet 4 和 GPT-5 大致相当,我认为这个假设是合理的。

02 逆向推导:基于第一性原理的、针对 H100 的分析

2.1 生产环境配置

首先设定一个现实的生产环境:假设采用 72 张 H100 组成的集群,单卡每小时 2 美元,总成本为每小时 144 美元。

为满足生产环境的延迟要求,我们设定每个模型实例的批处理量(batch size)为 32 个并发请求,这比基准测试中可能出现的大批量处理更符合实际。通过对每个模型实例采用 8 路 GPU 进行张量并行,我们可在 72 颗 GPU 上同时运行 9 个模型实例。

2.2 预填充阶段(处理输入)

每张 H100 GPU 的显存(HBM)带宽约 3.35 TB/s,这将成为大多数工作负载的瓶颈。由于 37B 激活参数以 FP16 的精度存储需占用 74 GB 空间,每个实例每秒可完成约 3,350GB/s ÷ 74GB = 45 次前向传播(译者注:实际每秒能完成的前向传播次数不仅取决于显存带宽,还受到其他因素影响)。

关键在于:每次前向传播会同时处理所有序列中的所有词元(tokens)。当我们批量处理 32 条序列且每条序列平均包含 1000 个词元时,单次前向传播即可处理 32,000 个词元。这意味着每个实例每秒可处理 45 次前向传播 × 32k tokens = 144 万个 input tokens。9 个实例合计每秒处理 1300 万 input tokens,即每小时 468 亿 input tokens。

实际情况中,混合专家模型(MoE)可能需要为当前批次中不同词元加载不同的专家组合,若这些词元被路由到多样化的专家组合,可能使吞吐量降低 2-3 倍。然而在实际应用中,路由模式通常呈现围绕热门专家的聚集现象,且现代实现方案采用专家并行与容量因子等技术来维持效率,因此实际影响更可能接近 30%-50% 的降幅,而非最坏情况下的数值。

2.3 解码阶段(生成输出)

输出生成阶段则呈现完全不同的图景。此阶段需顺序生成词元 ------ 每次前向传播每个序列仅产生一个词元。因此每秒 45 次前向传播仅使每个实例每秒产生 45×32=1440 个 output tokens。9 个实例合计每秒 12,960 个output tokens,即每小时 4670 万个 output tokens。

2.4 每个词元的原始成本

成本不对称性非常显著:input tokens 成本为 144 美元 ÷ 468 亿 = 每百万词元 0.003 美元,而 output tokens 成本为 144 美元 ÷ 4670 万 = 每百万词元 3.08 美元,存在千倍的差异!

2.5 当计算能力成为瓶颈

上述计算假设内存带宽是主要限制因素 ------ 这对典型工作负载确实成立。但在某些特定场景下,计算能力反而会成为系统瓶颈。当处理长上下文序列时,注意力计算量会随序列长度呈平方级增长。采用超大批处理数量并增加并行注意力头数,也会使系统从内存瓶颈转为计算瓶颈。

当上下文长度超过 128k 时,注意力矩阵会变得极其庞大,系统将从内存受限模式转为计算受限模式。对于超长上下文场景,这可能导致成本增长 2 到 10 倍。

这解释了某些有趣的产品决策:Claude Code 将上下文长度人为限制在 20 万词元 ------ 不仅是出于性能考量,更是为了将推理运算维持在低成本的内存受限状态,避免陷入高成本的计算受限长上下文场景。这也是为何服务商对 20万+ 词元的上下文窗口会额外收费 ------ 因为其经济模型已发生本质变化。

03 终端用户行为模式如 何影响 AI 服务提供商盈利结构

根据成本逆向推导的结果(再次强调,此处基于 H100 的零售租赁价格),我推测实际情况如下:

- 处理输入几乎零成本(约每百万 token 0.001 美元)

- 生成输出存在必须支付的实质性成本(约每百万 token 3 美元)

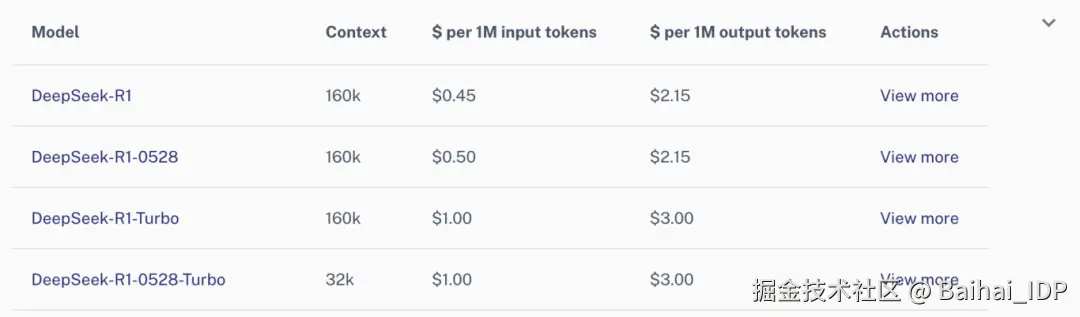

这些成本恰好与 DeepInfra 平台对 R1 模型的定价策略基本吻合,不过 input tokens 的加价幅度明显更高。

3.1 A. 消费者套餐

- 每月支付 20 美元的 ChatGPT Pro 用户:不限制日使用次数但限制 token 使用量

- 每日限制 10 万 token 使用量

- 按 70% 输入 token / 30% 输出 token 的比例:实际成本约 3 美元 / 月

- OpenAI 实现了 5-6 倍的加价

这类用户属于典型的重度使用者,他们每天运用模型进行写作、编程和常规查询。此场景下的经济模型非常健康。

3.2 B. 开发者使用场景

(译者注:开发者场景的长 prompt 成本非常高昂,前文有提到,但此处计算可能没有考虑这种情况)

-

Claude Code Max 5 用户(100 美元/月):若每日重度编程 2 小时

- 约 200 万 input tokens,3 万 output tokens /日

- 大量消耗 input token(低成本并行处理) + 极小量 output tokens

- 实际成本:约 4.92 美元/月 → 20.3 倍加价

-

Claude Code Max 10 用户(200 美元/月):若每日极重度使用 6 小时

- 约 1000 万 input tokens,10 万 output tokens/日

- 海量的 input tokens 与相对少量的生成 tokens

- 实际成本:约 16.89 美元/月 → 11.8 倍加价

开发者使用场景的经济效益最为显著。 像 Claude Code 这样的编程助手天然存在极度不对称的使用模式 ------ 它们输入整个代码库、相关文档、堆栈跟踪、多个文件及扩展上下文(低成本的 input tokens),仅需输出代码片段或对代码的解释说明等少量内容。这种模式完美契合了"输入近乎免费,输出成本高昂"的底层经济结构。

3.3 C. API 利润空间

- 现行 API 定价:每百万 tokens 3/15(译者注:分别代表输入和输出,后同) 美元 vs 实际成本约 0.01/3 美元。

- 利润率:毛利润率达 80-95% 以上

API 业务本质上就像一台印钞机。其毛利率水平更接近软件业务模式,而非传统基础设施服务。

04 Conclusion

本文分析基于大量假设,其中部分可能并不准确。但即便假设误差高达三倍,其经济模型仍显示出极高的盈利潜力。即便采用 H100 的公开市场零售价计算,原始计算成本也表明 AI 推理并非如许多人宣称的那样是不可持续的烧钱无底洞。

大多数人忽略了这样一个事实:处理输入信息的成本,比起生成输出结果来,要低廉得多。这意味着成本存在高达千倍的差距 ------ 处理每百万个 input tokens 仅需约 0.005 美元,而生成每百万个 output tokens 的成本却要 3 美元以上。

正是这种成本上的不对称性,解释了为何某些应用场景利润惊人,而另一些却可能难以为继。 重度读取型应用(那些消耗海量上下文信息却只生成极小量输出的程序)的算力成本几乎可忽略不计。对话智能体、处理完整代码库的编程助手、文档分析工具和研究应用,正是这种成本模式的最大受益者。

视频生成则处于这一成本结构的另一个极端。一个视频模型可能只需接收一句简单的文本提示词(约 50 个词元)作为输入,却需要生成代表每一帧画面的数百万个词元。当你需要从极少的输入生成海量的输出时,其经济模型会变得异常残酷。这正好解释了为何视频生成的成本始终居高不下,也解释了为何相关服务要么收取高昂价格,要么严格限制使用次数。

"AI这玩意贵得离谱,谁也玩不起"这种说法,与其说反映了经济现实,不如说更符合行业巨头的利益。现有的行业主导者不断强调其巨额投入和技术壁垒,可能是在吓阻潜在的竞争者,并阻止资本投向那些可能挑战他们的后来者。但只要我们的计算大致准确(尤其是对于输入密集型任务的处理),那么实现盈利的 AI 推理服务的实际门槛,很可能远低于人们普遍认知的水平。

我们不应过度炒作成本而让人忽视了最基本的经济规律。感觉就像一二十年前,所有人都被超大规模云厂商关于云计算成本的说辞所迷惑,最终放任它们变成了利润惊人的印钞机。若此时不够警惕,我们必将在 AI 推理领域重蹈覆辙。

END

本期互动内容 🍻

❓您在使用 AI 服务时,感觉哪个环节的成本对服务商挑战最大?是生成长文本、处理超长上下文,还是高并发请求?您的直观感受和文中分析的成本结构(输入廉价/输出昂贵)一致吗?

文中链接

1\][www.datacenterdynamics.com/en/news/ope...](https://link.juejin.cn?target=https%3A%2F%2Fwww.datacenterdynamics.com%2Fen%2Fnews%2Fopenai-training-and-inference-costs-could-reach-7bn-for-2024-ai-startup-set-to-lose-5bn-report%2F "https://www.datacenterdynamics.com/en/news/openai-training-and-inference-costs-could-reach-7bn-for-2024-ai-startup-set-to-lose-5bn-report/") \[2\][www.wheresyoured.at/wheres-the-...](https://link.juejin.cn?target=https%3A%2F%2Fwww.wheresyoured.at%2Fwheres-the-money%2F "https://www.wheresyoured.at/wheres-the-money/") \[3\][futurism.com/the-byte/op...](https://link.juejin.cn?target=https%3A%2F%2Ffuturism.com%2Fthe-byte%2Fopenai-chatgpt-pro-subscription-losing-money "https://futurism.com/the-byte/openai-chatgpt-pro-subscription-losing-money") **原文链接:** [martinalderson.com/posts/are-o...](https://link.juejin.cn?target=https%3A%2F%2Fmartinalderson.com%2Fposts%2Fare-openai-and-anthropic-really-losing-money-on-inference%2F "https://martinalderson.com/posts/are-openai-and-anthropic-really-losing-money-on-inference/")