本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

当检索增强生成(RAG)技术从"检索+生成"的简单拼接,进化到需要融合自适应知识组织、多轮推理和动态检索的复杂系统时,科研人员却常常陷入冗长的工程实现泥潭。

清华大学THUNLP实验室、东北大学NEUIR实验室、OpenBMB与AI9stars联合推出的UltraRAG 2.0,正试图改变这一现状------这个基于Model Context Protocol(MCP)架构的开源框架,让开发者只需编写YAML文件,就能实现串行、循环、条件分支等复杂逻辑,用几十行代码搭建出媲美DeepResearch、Search-o1的高性能RAG系统。

为什么需要UltraRAG 2.0?

现代RAG系统的复杂度飙升,给研究者带来两大痛点:

- 复现现有方法时,要面对不同项目的异构接口和冗余代码

- 验证新想法时,80%精力消耗在工程实现而非算法创新

UltraRAG 2.0的核心解决方案是组件化封装+灵活编排:

- 将检索、生成等核心功能封装为标准化MCP Server

- 通过函数级Tool接口实现模块"热插拔"

- 用YAML文件声明式定义复杂推理流程

三大核心亮点,重新定义RAG开发体验

1. 低代码构建复杂Pipeline

无需深入编程细节,只需编写YAML配置文件,就能实现:

- 多轮迭代检索(如Search-o1的思维链+检索模式)

- 基于条件判断的动态流程切换

- 复杂推理链路的串行/并行调度

csharp

# 示例:简单的迭代检索生成流程

pipeline:

- step: retriever.retrieve # 调用检索服务

params:

query: "{{input.query}}"

top_k: 5

output: context

- loop: 3 # 迭代3轮

steps:

- step: generator.reflect # 生成反思

params: context "{{context}}"

output: reflection

- step: retriever.retrieve # 基于反思二次检索

params: query "{{reflection}}"

output: new_context2. 开箱即用的生态支持

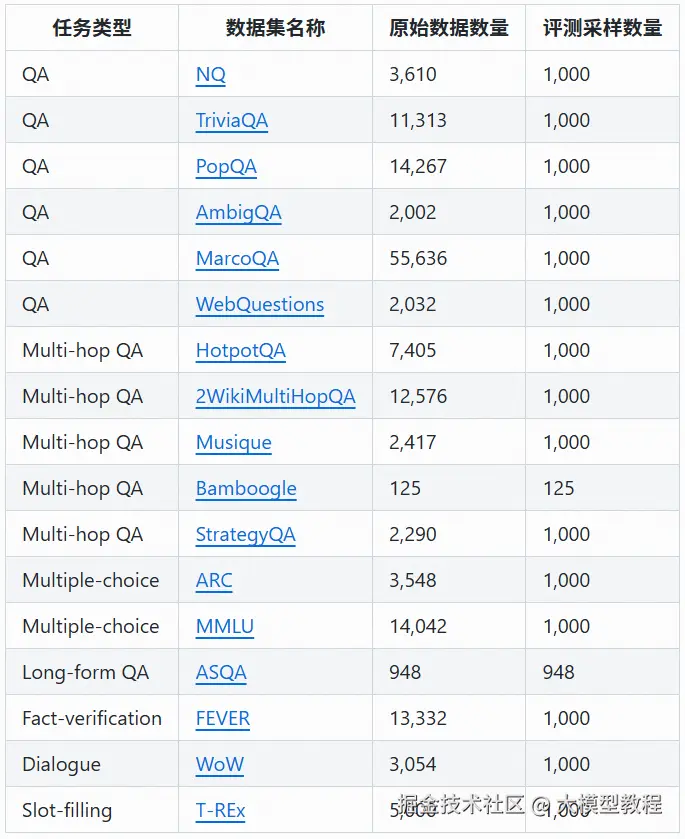

框架内置17个主流科研Benchmark,包括:

- 问答任务:NaturalQuestions、HotpotQA等

- 知识密集型任务:FEVER、TriviaQA等

- 长文本理解:Qasper、NarrativeQA等

同时提供大规模语料库支持:

- wiki-2018(2100万文档)

- 即将上线的wiki-2024版本

3. 无缝扩展与部署

通过模块化设计实现:

- 支持vLLM部署的大模型服务

- 兼容FAISS、LanceDB等向量数据库

- 自定义Server只需实现标准接口

部署LLM服务仅需一行命令:

shell

# 启动vLLM服务bash script/vllm_serve.sh --model lmsys/vicuna-7b-v1.55分钟快速上手

1. 环境搭建

bash

# 创建虚拟环境

conda create -n ultrarag python=3.11

conda activate ultrarag

# 克隆仓库

git clone https://github.com/OpenBMB/UltraRAG.git --depth 1

cd UltraRAG

# 安装依赖

pip install uv

uv pip install -e ".[all]"2. 验证安装

bash

# 运行hello world示例

ultrarag run examples/sayhello.yaml

# 成功输出:Hello, UltraRAG 2.0!3. 开始构建第一个RAG系统

参考官方教程实现:

- 语料库编码与索引建立

- 检索服务部署与调用

- 推理Pipeline配置与优化

谁适合用UltraRAG 2.0?

- 科研人员:快速复现SOTA方法,验证新想法

- 算法工程师:低成本搭建生产级RAG系统

- 学生:降低RAG技术学习门槛,聚焦核心逻辑

项目已在GitHub开源,包含详细文档、示例代码和视频教程。社区还提供每日更新的RAG前沿论文解读,助力研究者紧跟领域进展。

👉 项目地址:github.com/OpenBMB/Ult...

📚 教程文档:ultrarag.openbmb.cn

UltraRAG 2.0正在重构RAG系统的开发范式------当工程复杂度被大幅降低,研究者终于可以将精力集中在真正重要的地方:算法创新与科学发现。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。