想象一下,仅用一张GPU,就能实时生成永不消失的3D世界------这不再是科幻小说,而是李飞飞团队带给我们的现实。

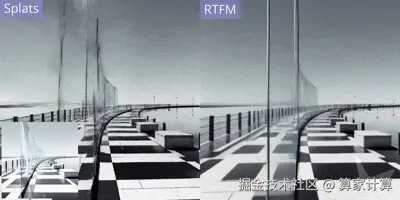

今天,李飞飞及其团队正式发布了全新的世界模型RTFM(A Real-Time Frame Model),凭借其实时运行、持久性和3D一致性三大特性,成功实现了仅靠单张H100 GPU即可流畅运行的技术突破。

这不仅解决了长期困扰世界模型发展的算力瓶颈问题,更意味着曾经只属于科技巨头的世界模型技术,即将进入更广阔的应用场景,对游戏、影视、零售、家居设计等消费领域产生深远影响。

世界模型的算力困境与RTFM的突破

世界模型作为一种能够理解物理环境动态特征的生成式AI模型,可以通过文字、图像、视频及动作数据生成影片,并实现对现实世界的自主导航与模拟。与当前主流的大语言模型不同,世界模型通过学习视频和机器人数据来理解现实世界,致力于将AI能力拓展至实体产品。

然而,世界模型的发展一直面临着巨大的算力挑战。据李飞飞团队分析,如果直接将现有视频架构应用于世界模型,生成一个60帧的4K交互视频流,每秒需要处理超过10万个token------这相当于《哈利·波特》第一本书的文字量。而要维持一小时以上的持续交互,需要处理的上下文token数量将超过1亿,基于当前的计算基础设施,这既不可行,也不具备经济效益。

RTFM模型的革命性在于它成功突破了这一瓶颈。该模型采用自回归扩散Transformer架构,在大型视频数据上进行端到端训练,通过优化架构设计显著降低了计算负担。团队精细优化了推理堆栈的每一个环节,应用了架构设计、模型蒸馏和推理优化等领域的最新进展,最终实现了在单张H100 GPU上以交互帧率进行实时推理的目标。

技术核心

RTFM模型的技术路径与传统方法有本质区别。传统的3D图形管线使用显式的3D表征来构建世界模型,然后通过渲染生成2D图像。这些方法依赖人工设计的算法和数据结构来模拟3D几何、材质、光照、阴影、反射等效果。

而RTFM则走上了一条全新的道路。它不构建世界的显式3D表征,而是接收一张或多张2D图像作为输入,然后直接从不同视点生成同一场景的全新2D图像。简单来说,RTFM可以被视为一个"学会了渲染的AI------它仅通过在训练中观察视频,便学会了对三维几何、反射、阴影等复杂物理现象进行建模。

这种"学习型渲染器"的方法使RTFM能够打破重建(在现有视图之间进行插值)与生成(创造输入视图中未见的新内容)之间的界限。当提供大量输入视图时,由于任务约束更强,它更倾向于重建;而当输入视图较少时,它则必须进行外推和想象。

消费级应用场景的颠覆性变革

随着RTFM模型将世界模型的硬件门槛降至单张GPU,未来一系列消费级应用场景可能会迎来颠覆性变革。

首当其冲的便是游戏行业。传统的游戏场景搭建需要大量人工建模和渲染,而RTFM的技术仅需一张图片即可构建持久存在的3D环境,可大幅降低虚拟场景的搭建成本,并支持实时交互式体验的持续扩展。

不仅如此,玩家除了能享受由AI动态生成的游戏世界,还可以根据行为实时变化,大大提升游戏的自由度和真实感。

同样,RTFM的持久性特性允许用户与模型进行无休止的交互,而这个世界将永不消逝。这意味着在影视制作行业,导演和设计师可以构建持续存在的虚拟场景,在不同时间、从不同角度进行拍摄和创作,大幅降低外景拍摄和场地搭建成本。

涉足3D空间设计的家居设计、房产领域也能受益匪浅。

尽管RTFM已经取得了突破性进展,但世界模型的发展旅程才刚刚开始。目前的模型主要专注于静态世界的建模,而团队的下一步目标是增强其模拟动态世界的能力,并允许用户与生成的世界进行实时互动。

从市场前景看,空间智能相关模型的需求正在爆发性增长。2024年12月,Omdia最新研究报告《空间计算:云端和边缘应用》表明,全球空间计算市场预计在2029年突破100亿美元,年增速高达18%。而中国元宇宙市场预计2030年规模达8500亿元人民币,其中与空间智能紧密相关的部分占比将高达40%。

【图片来源于网络,侵删】

李飞飞团队对RTFM的扩展潜力充满信心。他们期待,面向更大推理预算的更大型号模型将持续带来性能提升。随着算力成本的持续下降和算法的不断优化,世界模型有望在未来五年内成为企业数字化转型的核心工具之一,重塑多个行业的生产力边界。

RTFM的发布不仅仅是技术上的突破,更是世界模型从实验室走向广泛应用的重要里程碑。它将曾经高不可攀的世界模型技术,变得触手可及。

那个曾经只存在于科幻作品中的赛博朋克世界,或许真的离我们不远了。